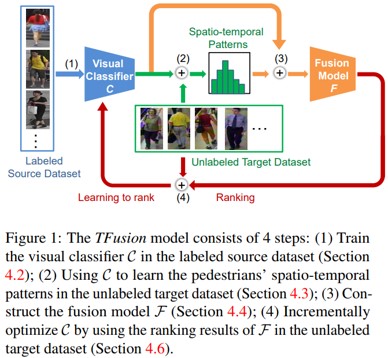

概要

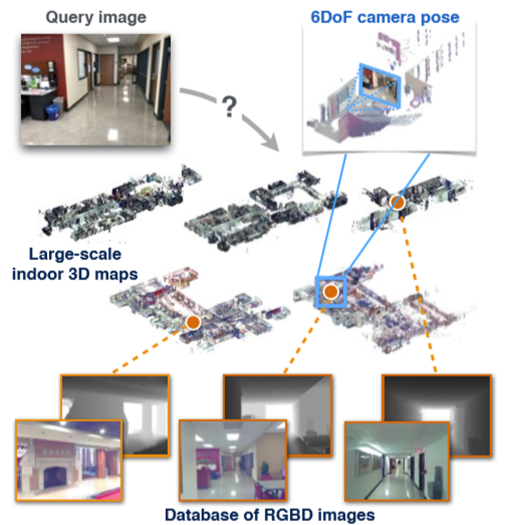

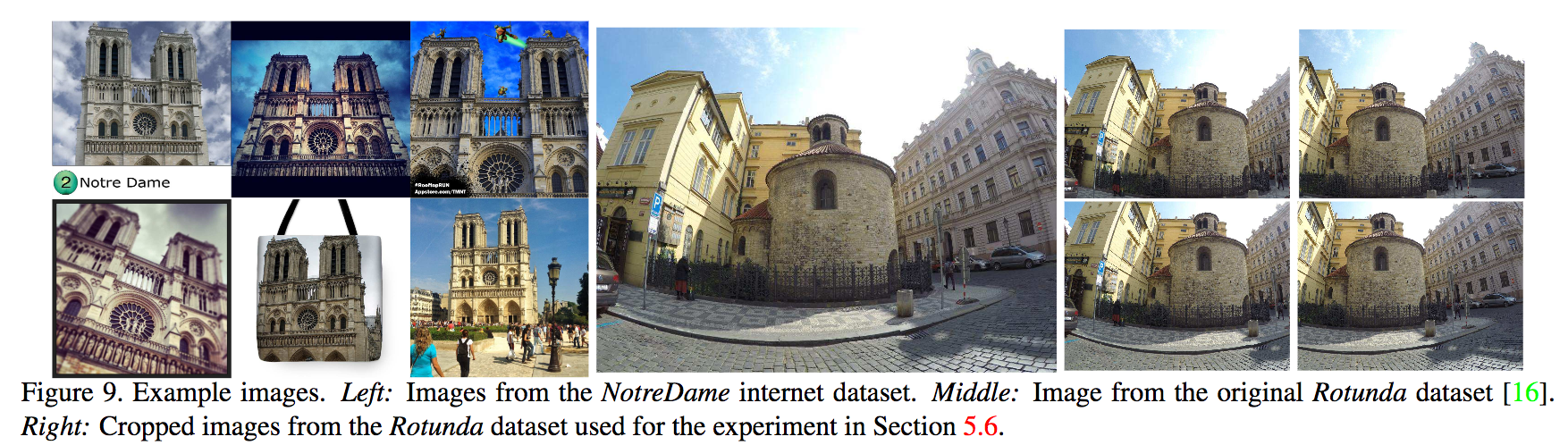

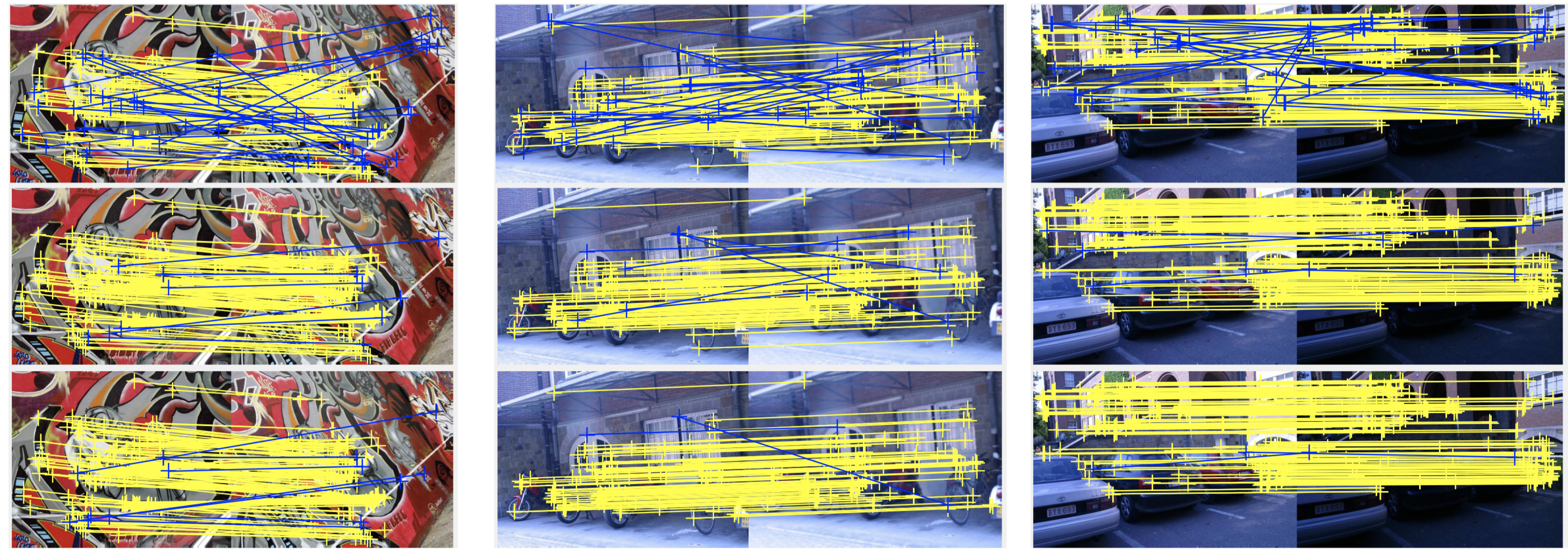

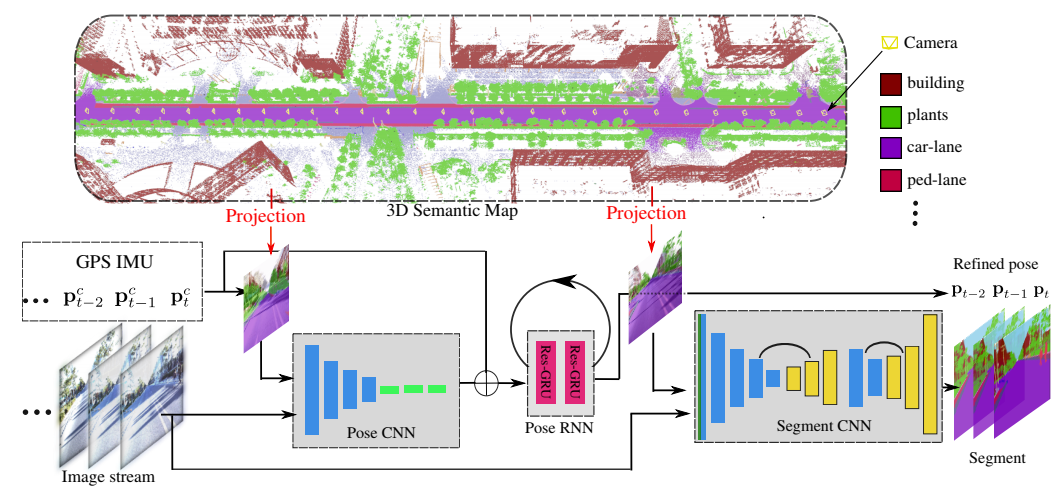

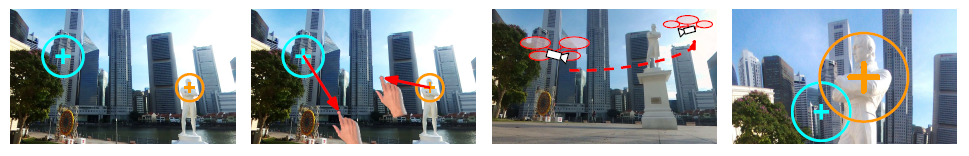

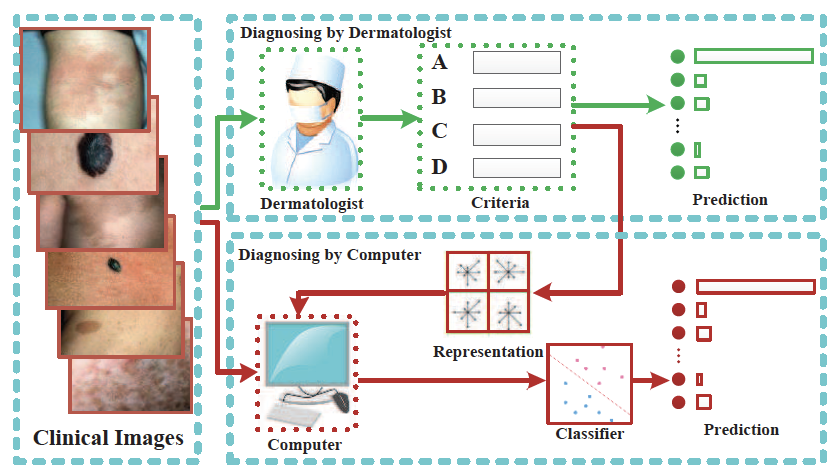

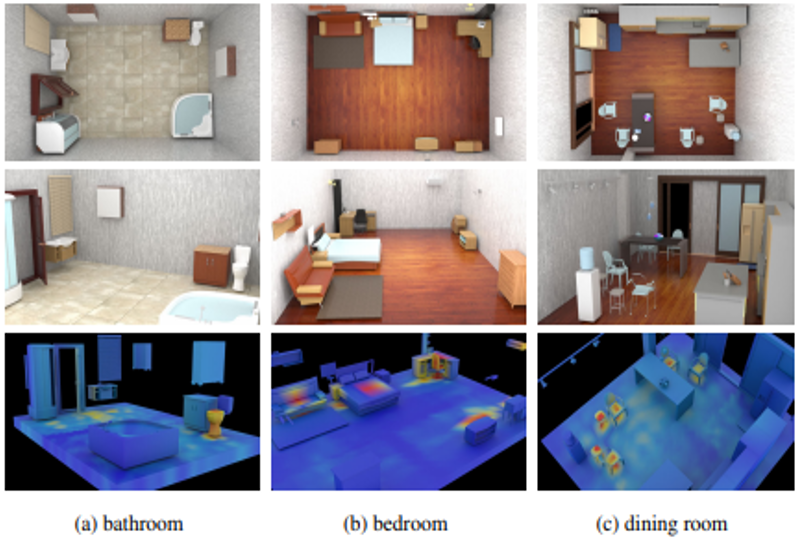

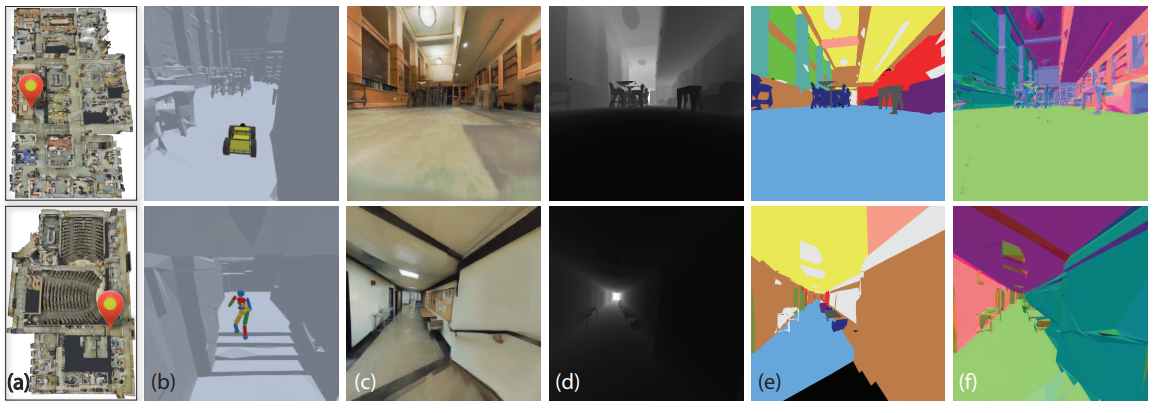

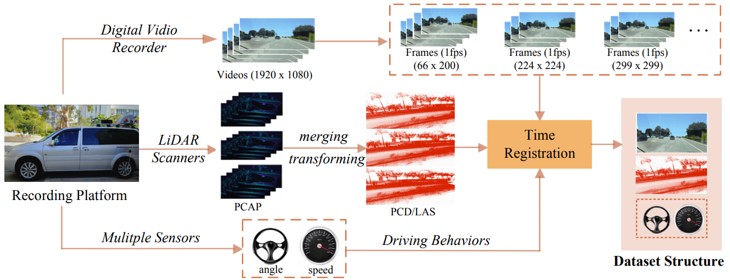

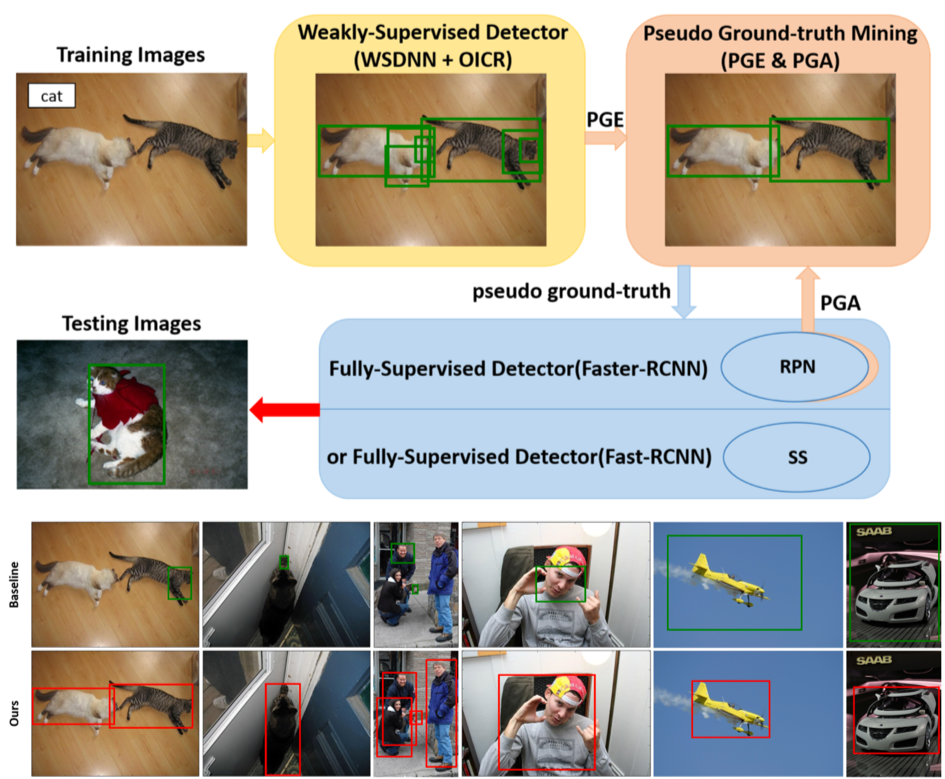

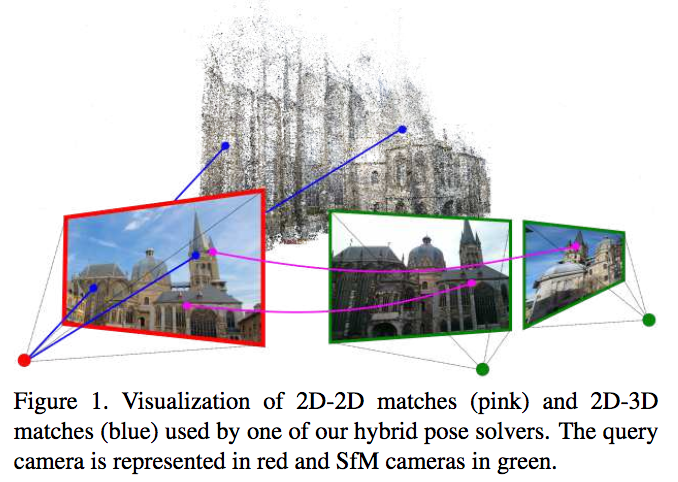

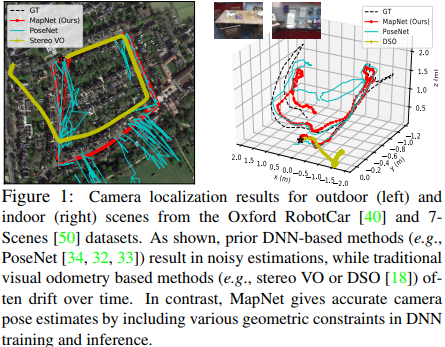

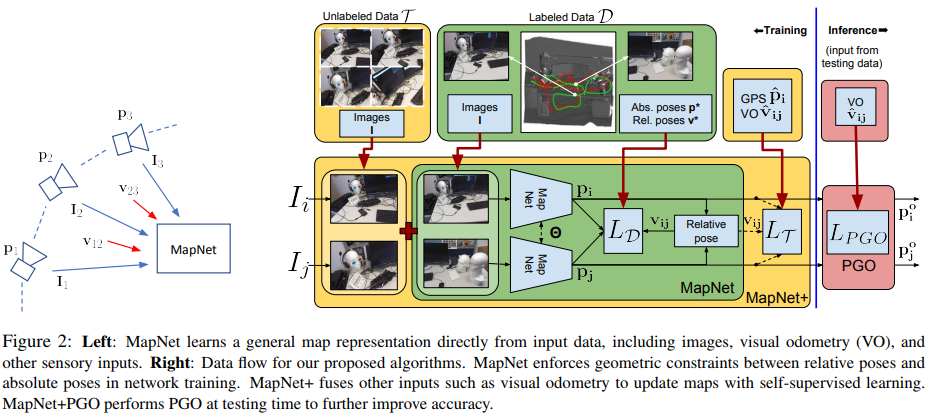

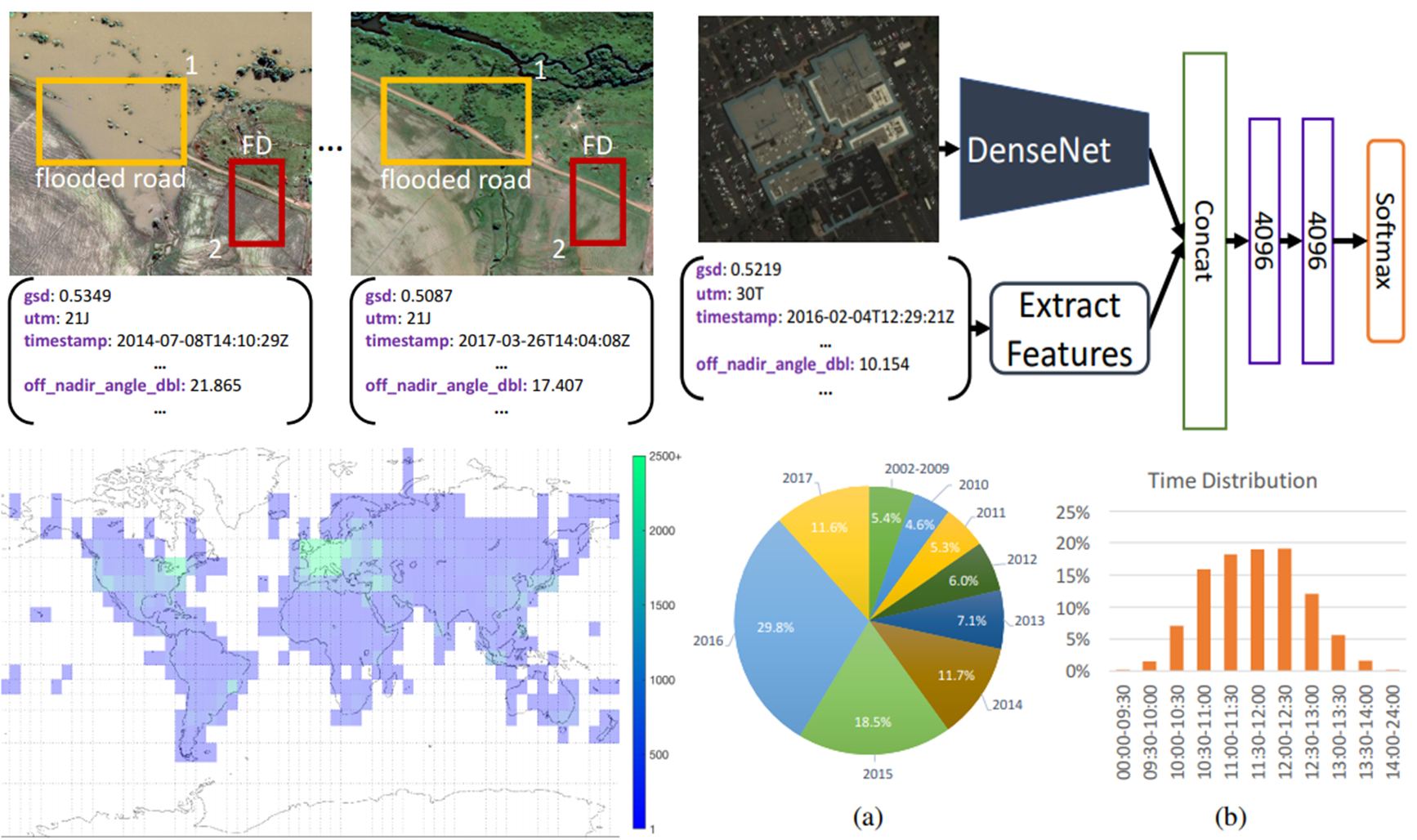

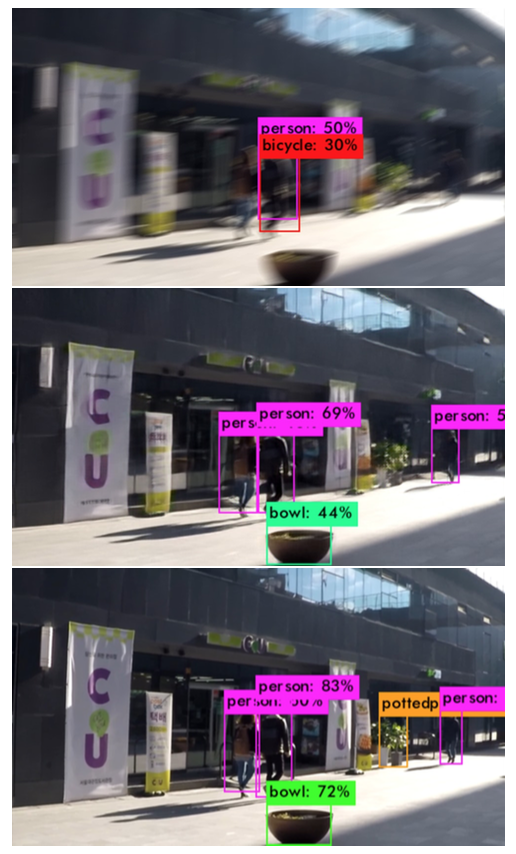

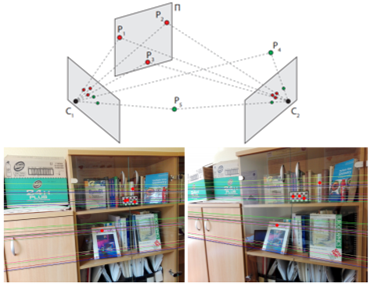

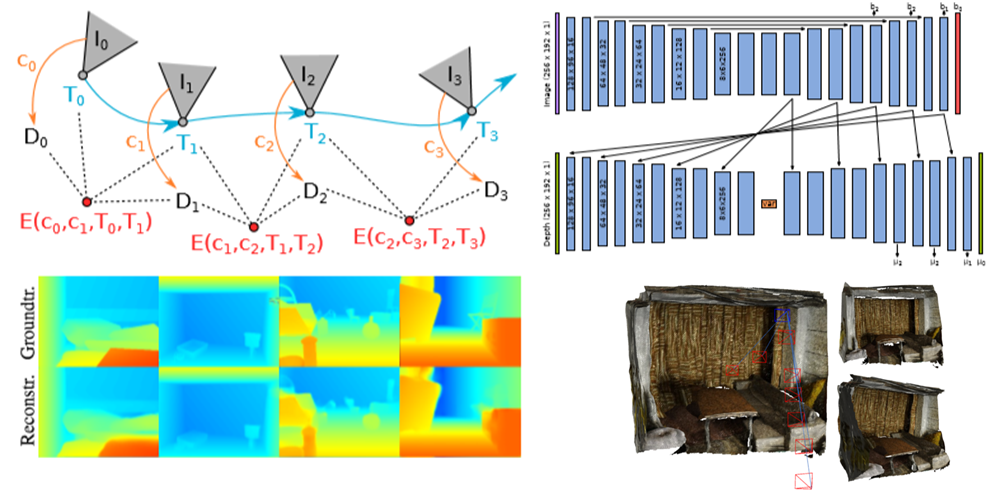

本稿では,環境が視覚的定位に及ぼす影響を分析するために特別に設計されたベンチマークデータセットを紹介.幅広い条件で撮影されたクエリ画像に対して慎重に作成されたグラウンドトゥースポーズを使用して,最先端のローカリゼーション手法を使用した広範な実験を通じて,様々な要因が6DOFカメラの姿勢推定精度に及ぼす影響を評価.

本稿では,環境が視覚的定位に及ぼす影響を分析するために特別に設計されたベンチマークデータセットを紹介.幅広い条件で撮影されたクエリ画像に対して慎重に作成されたグラウンドトゥースポーズを使用して,最先端のローカリゼーション手法を使用した広範な実験を通じて,様々な要因が6DOFカメラの姿勢推定精度に及ぼす影響を評価.

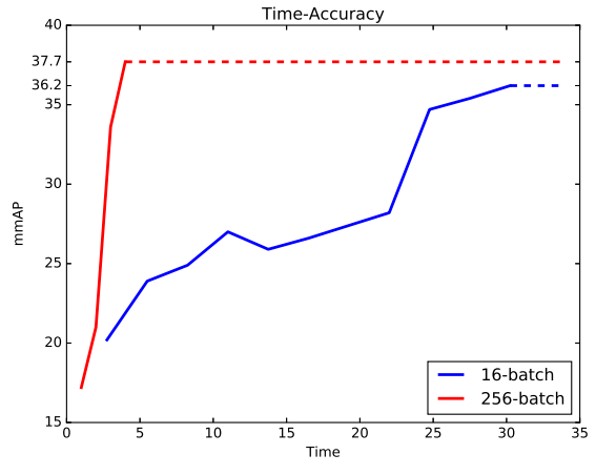

・3つのあたらしいベンチマークデータセットを紹介・Active SearchやCSLなどの構造ベースの方法は,都市環境でのほとんどの条件に対して堅牢.しかし,精度の高い領域でのパフォーマンスは,依然として大幅に改善する必要あり. ・昼間の写真から構築されたデータベースに対して,夜間の画像をローカライズすることは,事前の情報が与えられても非常に困難 ・過去の情報が与えられている場合でも,多量の植生がある場面は困難 ・SfMは上2つの問題を完全に処理しないが,提案したデータセットは解決する機能のベンチマークを容易に提供. ・DenseVLADなどは,自律運転状況で粗いレベルのポーズ推定値を提供が可能. ・姿勢推定に複数の画像を使用することは明確な利点がある.

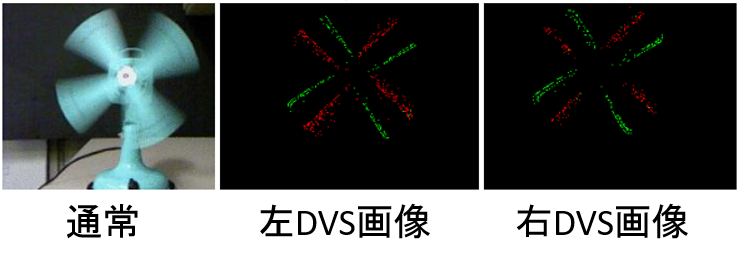

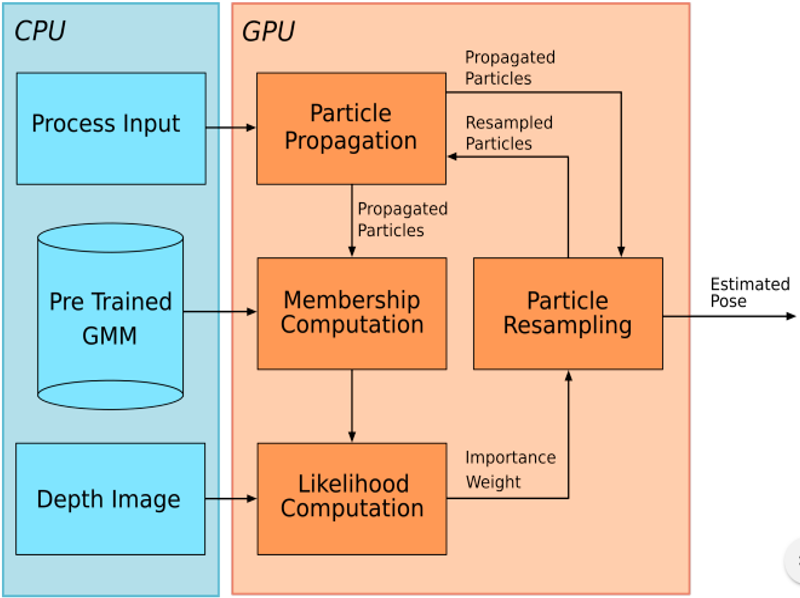

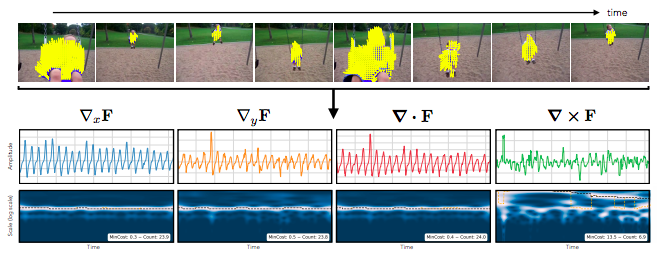

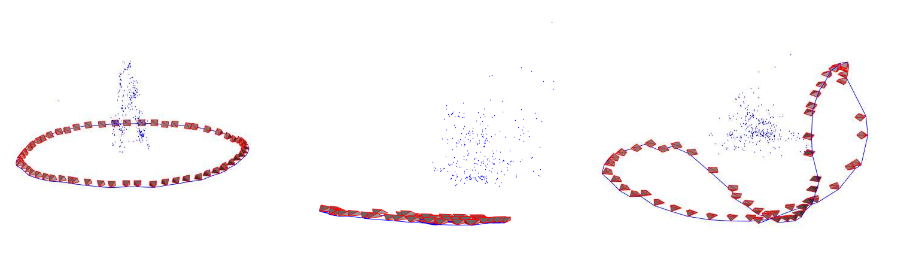

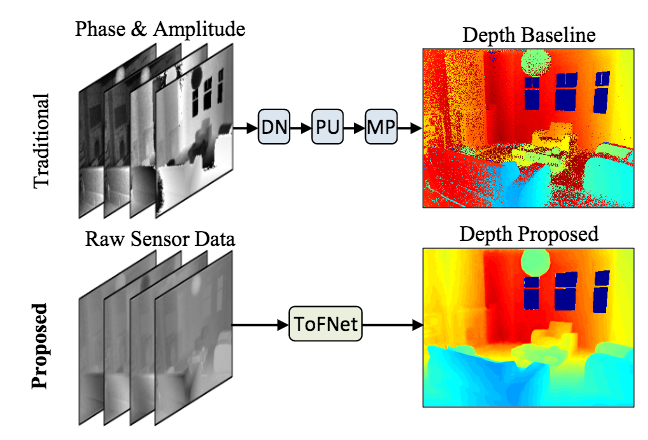

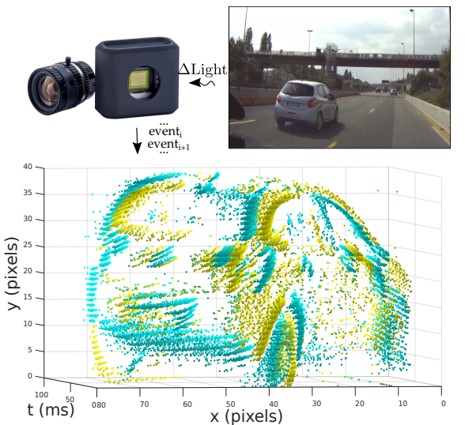

リンク集に記載している“Event-based, 6-DOF Pose Tracking for High-Speed Maneuvers using a Dynamic Vision Sensor(DVS)”を用いてオプティカルフロー推定,デプス推定,ローテーション推定,モーション推定などの問題に取り組んだ論文.本論文ではDVSを用いて,ピクセルごとに急激な変化を起こした点とその軌道を認識する(論文内では“event”と定義). その点軌道の速さや動いた距離からデプスやオプティカルフローなどの,様々な問題におけるアルゴリズムを提案して評価している.

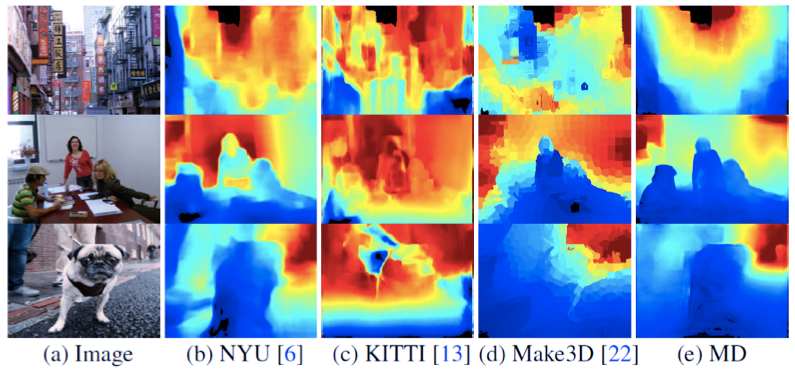

デプス推定において,従来手法であるコントラストからの推定のほうが精度が高いが,1.1~1.8mの距離においては提案手法の方が精度が高いなど,それぞれの問題において提案手法の得意な所を説明し,提案手法のフレームワークの優位性を説明している.

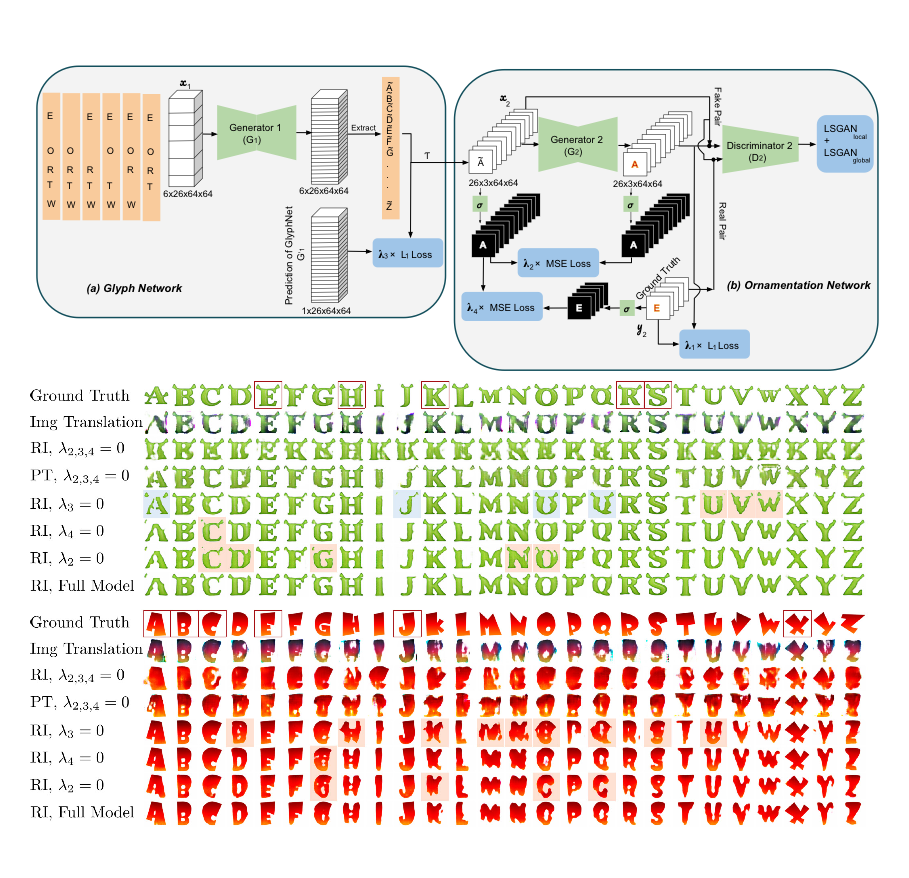

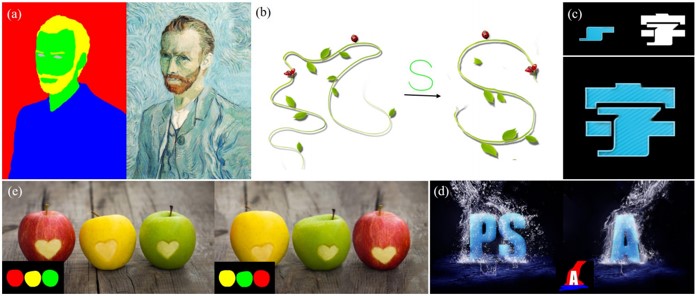

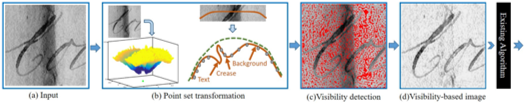

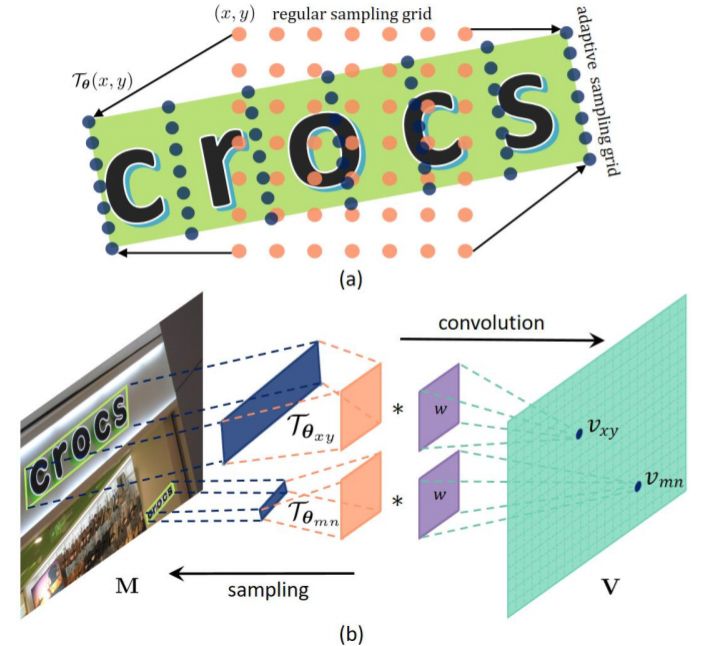

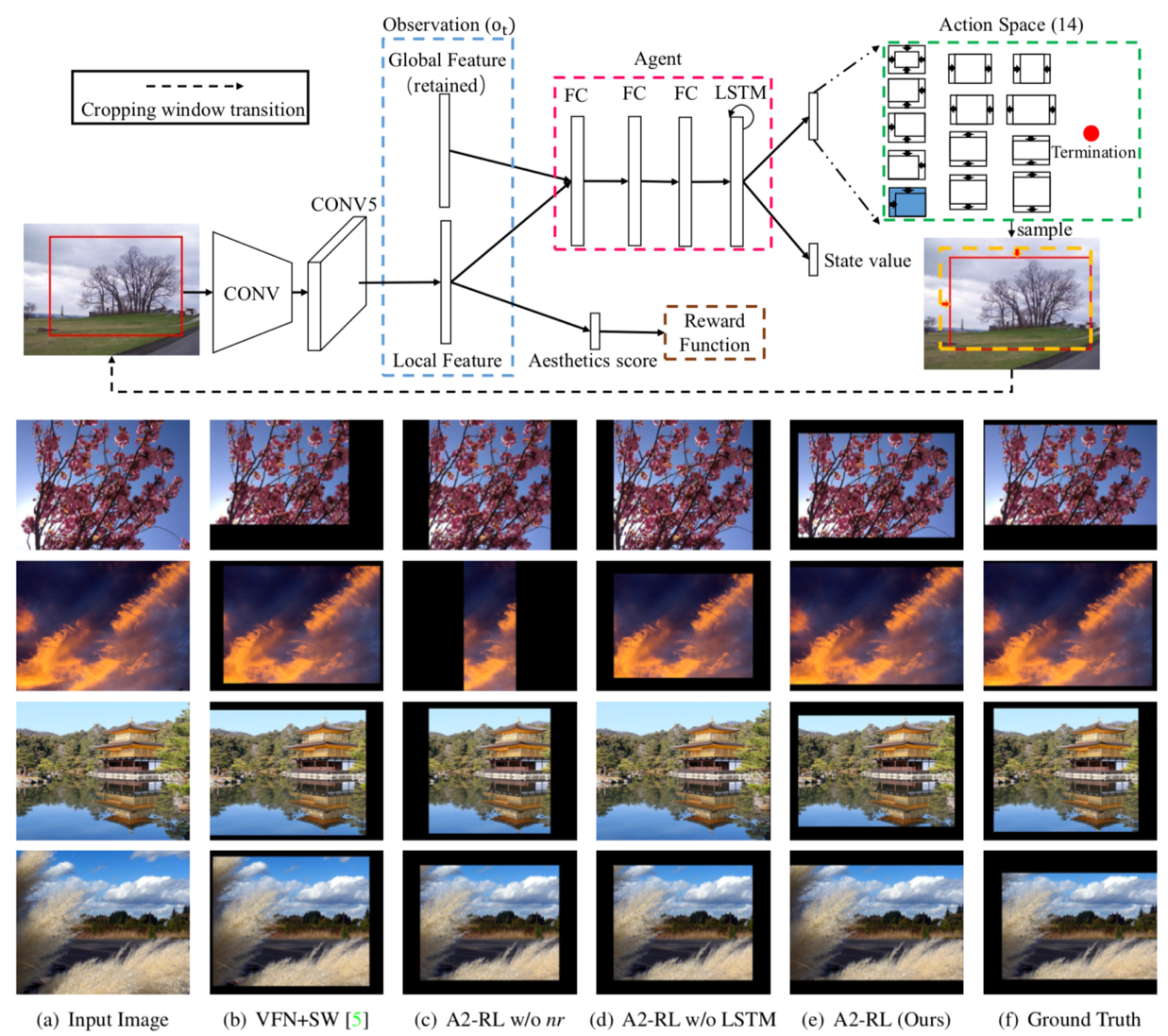

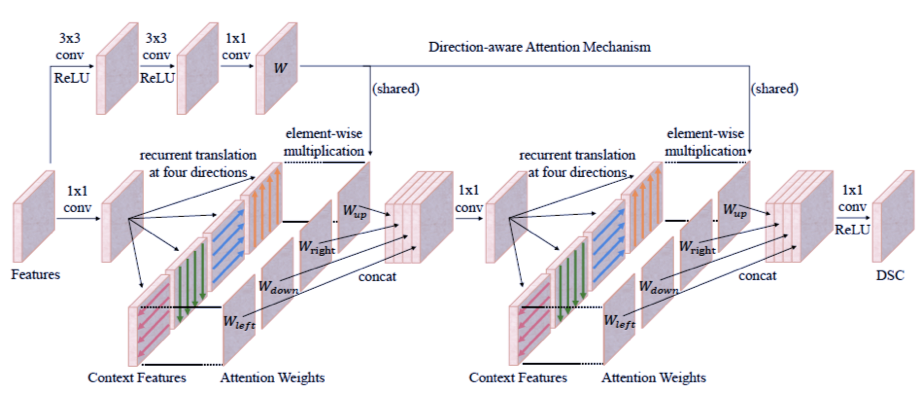

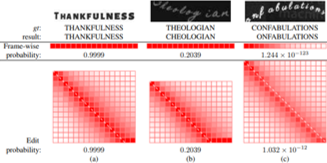

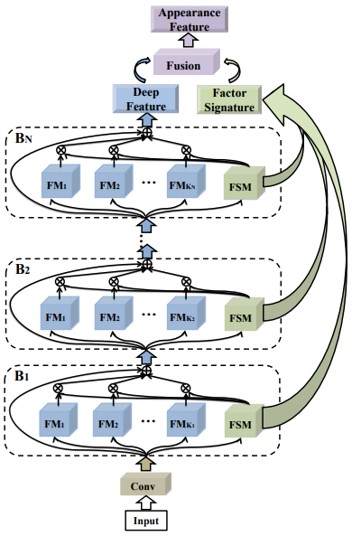

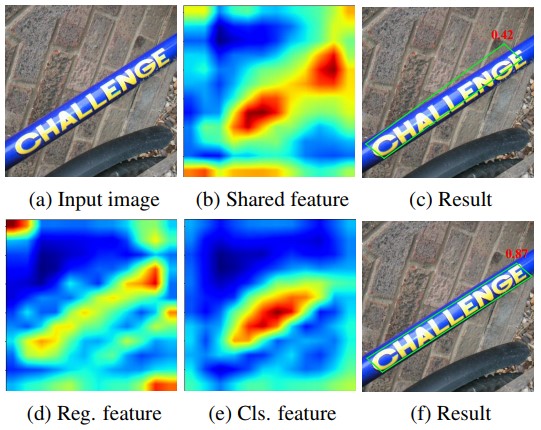

イレギュラー文字の深い特徴を取得するためにarbitrary orientation network(AON)を開発.このネットワークの全体は,画像と単語レベルのみを使用してエンドtoエンドで訓練することができる.様々なベンチマークの実験では,提案されたAONベースの方法が不規則なデータセットでは最先端の性能を達成し,通常のデータセットの主要な既存の方法に匹敵することを示している.

・文字の四角特徴を4方向に抽出するための任意の方向つけネットワークと,文字配置の手がかり・フィルタゲート機構を用いて4方向特徴シーケンス ・文字シーケンスを生成するための注意べ―スのデコーダ の3つを使用 既存研究と異なり,画像からイレギュラー/レギュラーのテキスト両方を効果的に認識できる 通常のベンチマークと不規則なベンチマークの両方を用いた実験では,提案手法の優位性が検証された 将来的には,提案手法を他関連に関するタスクまで拡張する予定

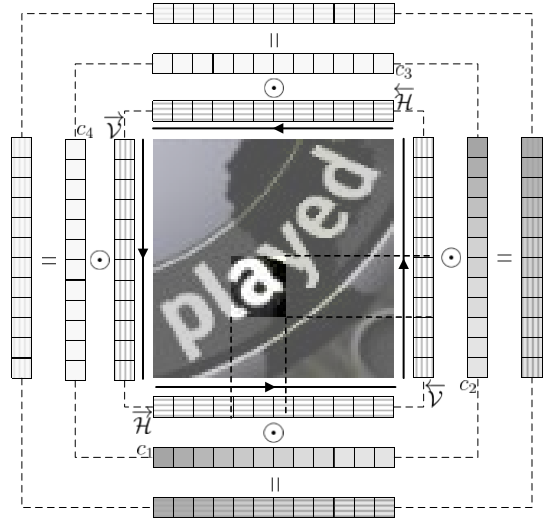

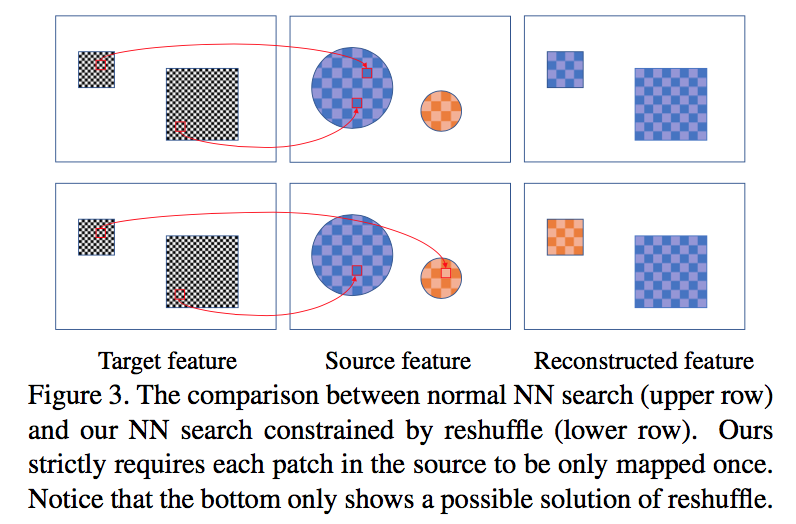

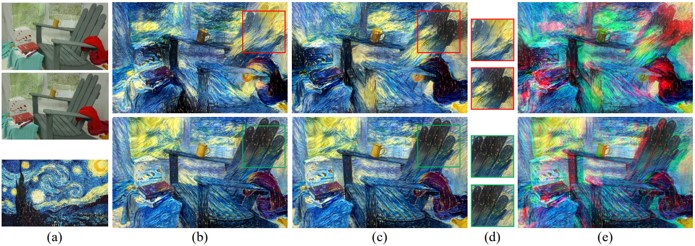

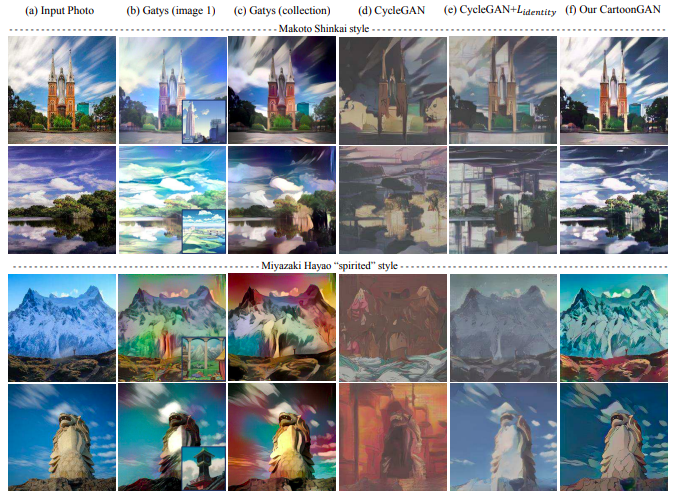

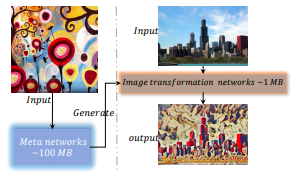

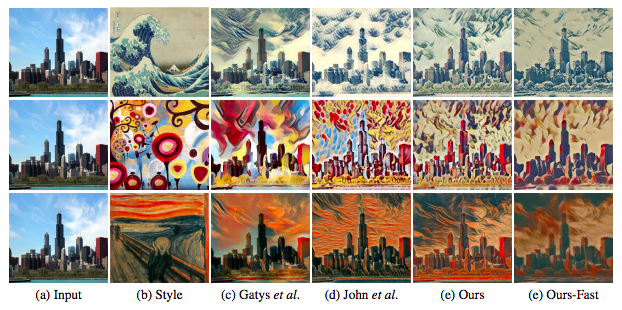

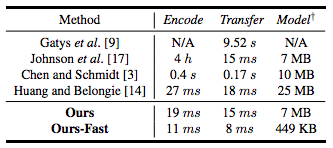

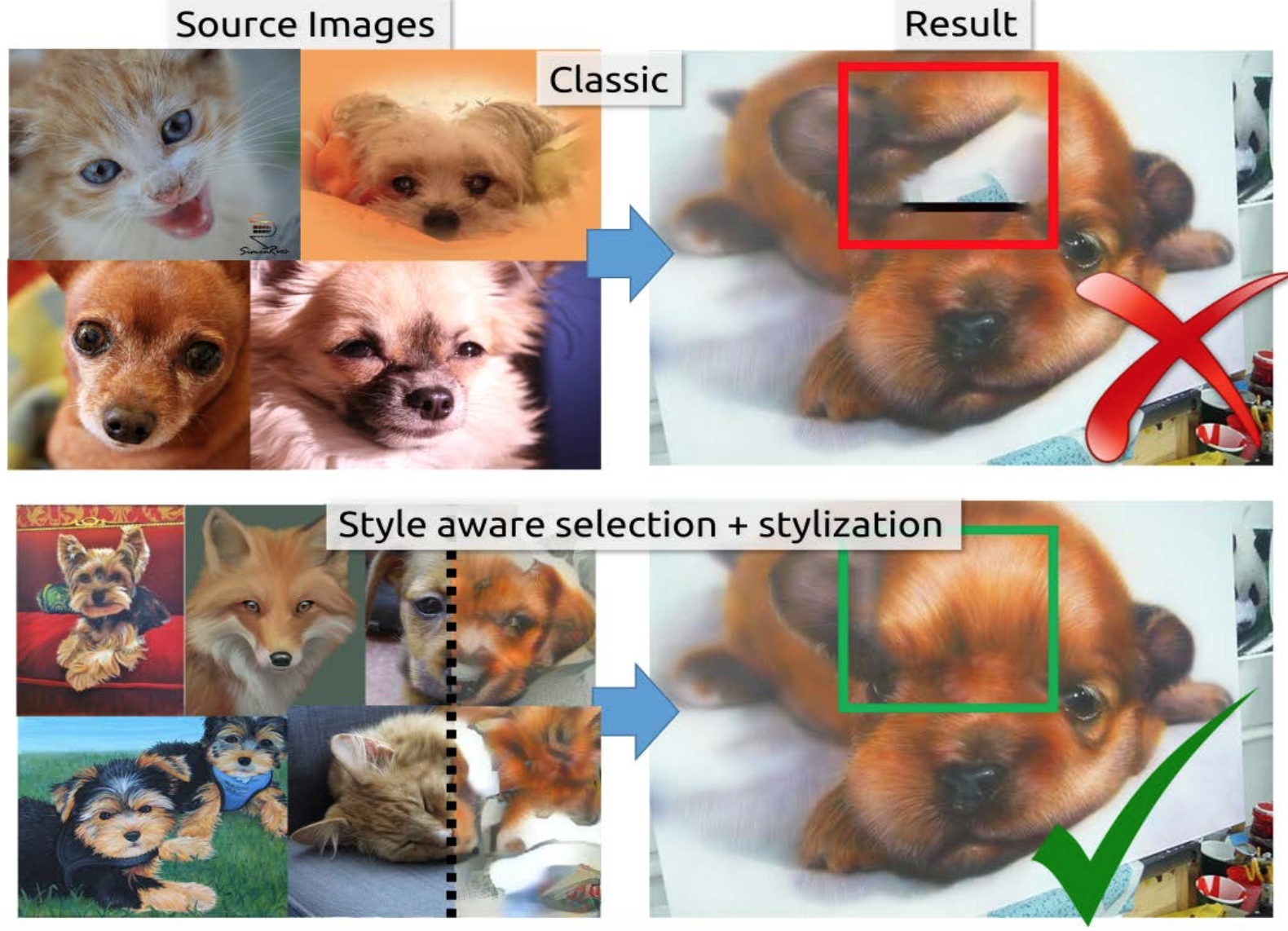

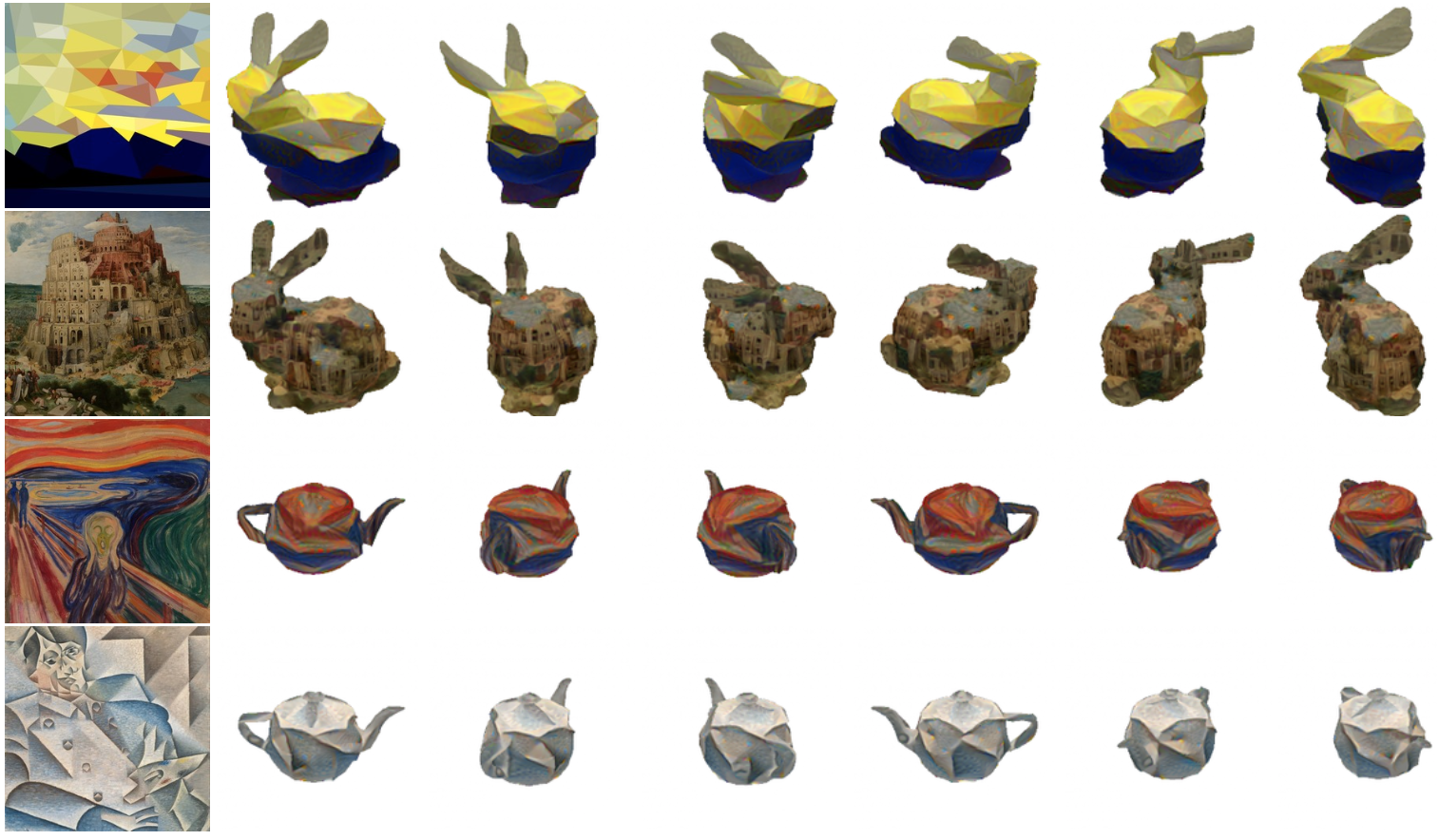

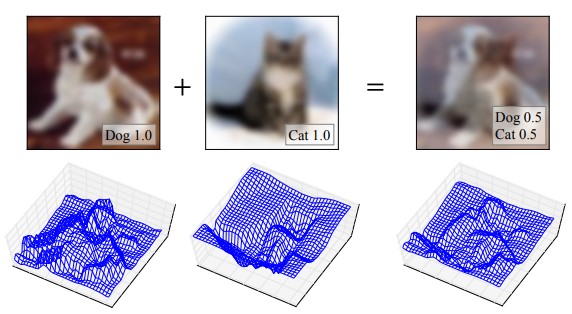

style画像のdeep特徴マップをシャッフルすることにより,任意のstyle transferを行う手法の提案.従来の様々なstyle-transfer手法に対して新しい切り口で分析し,deep feature reshuffleの提案を行なっている.feature domainに於いて逐次的な最適化を行なう.提案手法では,様々な種類の入力画像に対応することができ,質も他手法を超えると主張する.

・neural parametricモデルと neural non-parametricモデルはdeep feature reshuffleというアイデアによって統合される.

・deep feature reshuffleに基づく新しいエネルギー関数を定義.これは,他の手法よりもシンプルで柔軟.

・ピラミッド法で feature-domainエネルギー関数を最適化するために新しく,レベルごとのデコーダを学習する

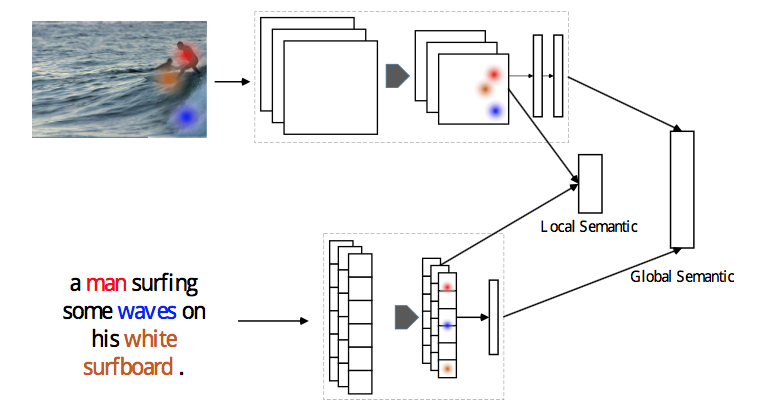

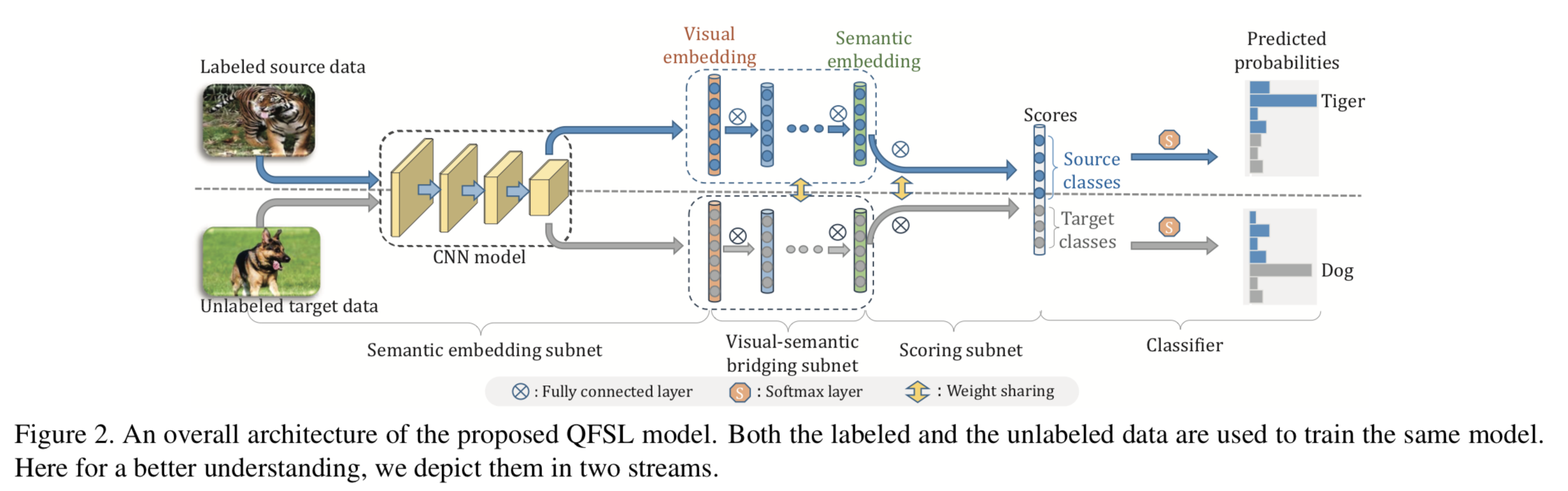

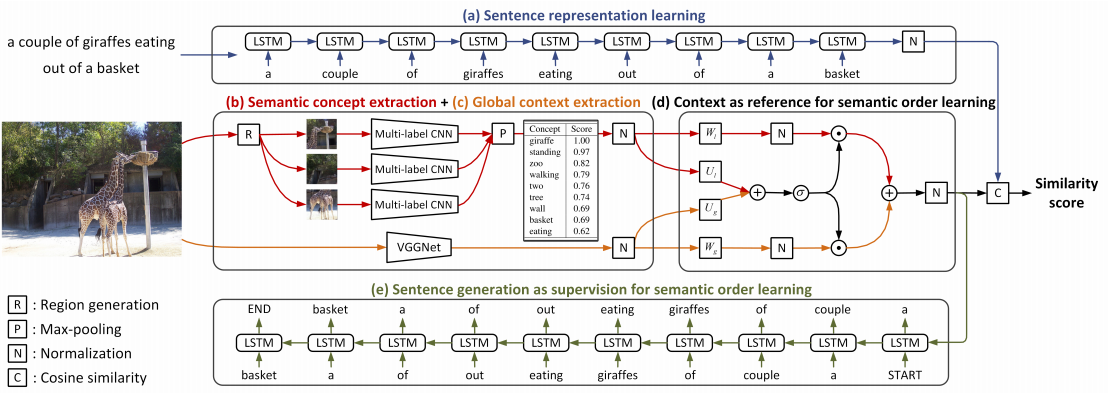

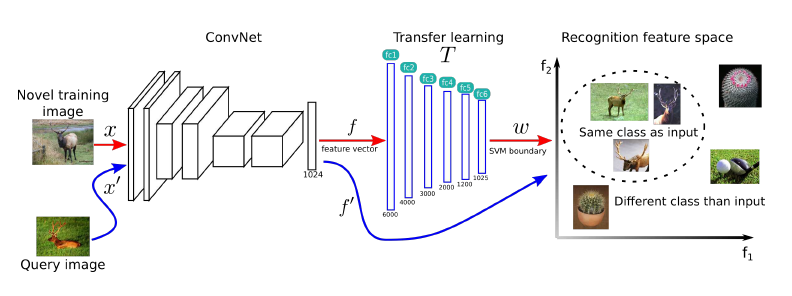

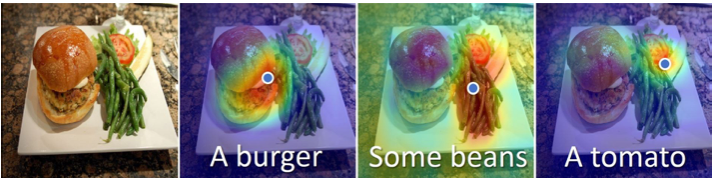

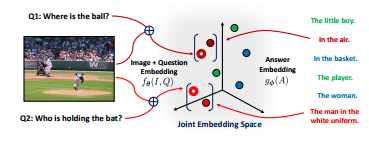

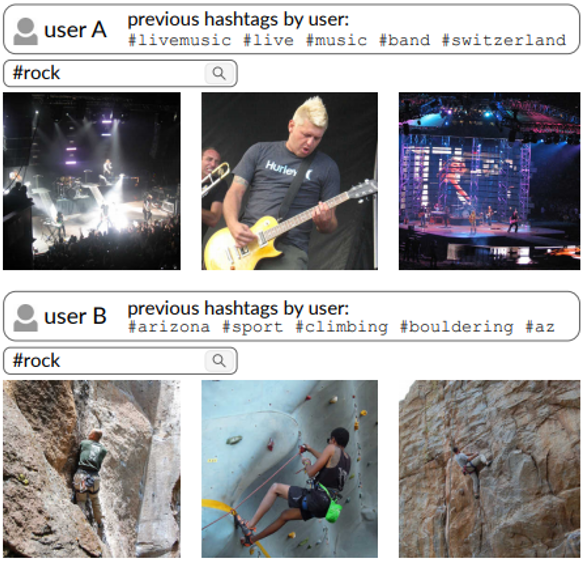

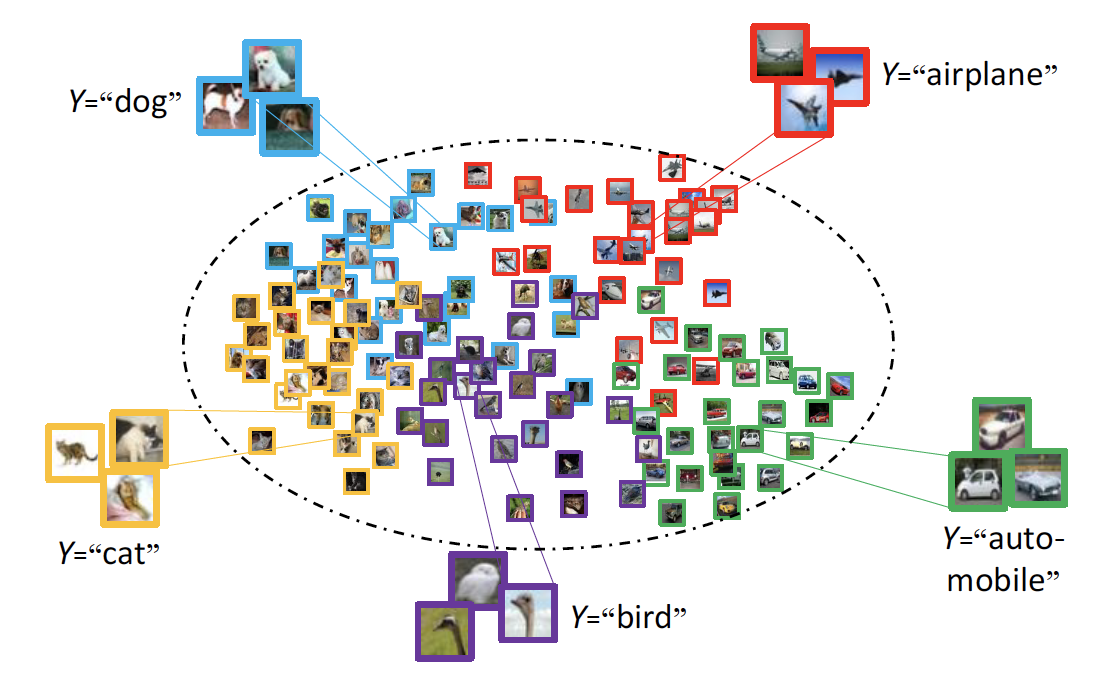

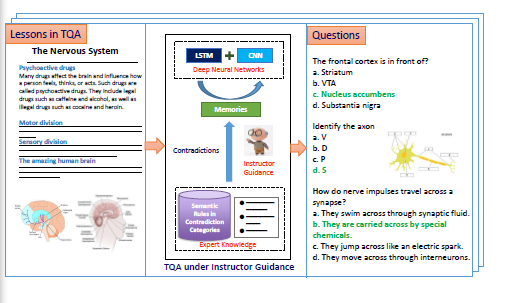

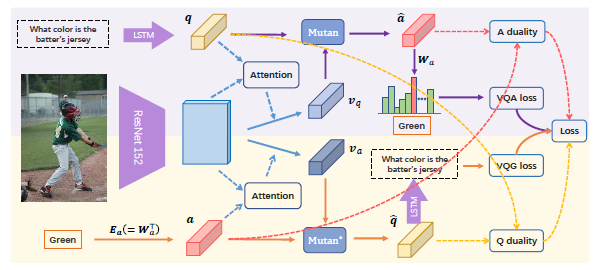

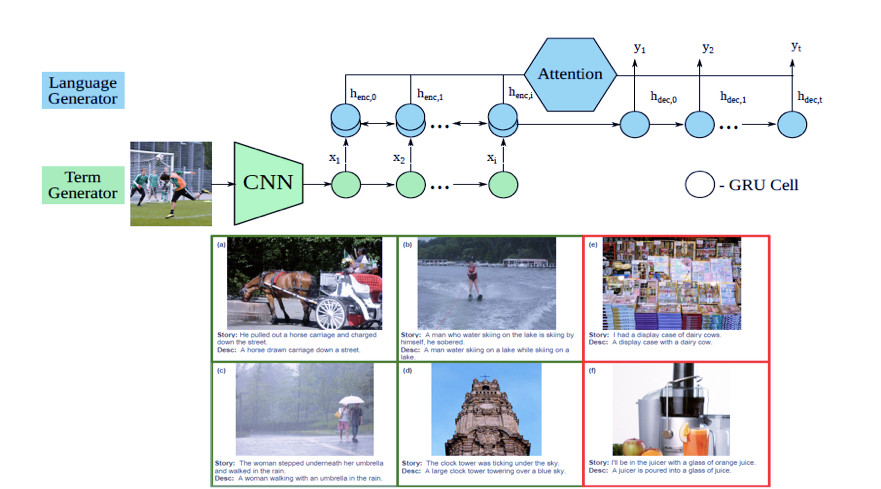

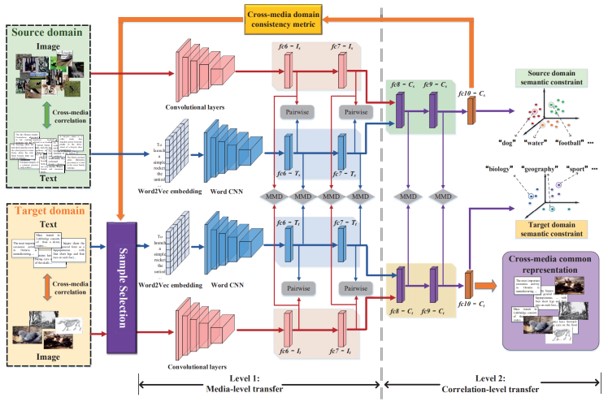

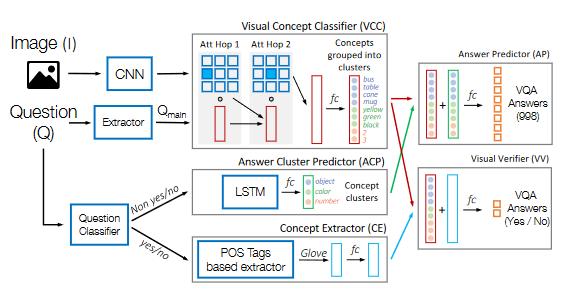

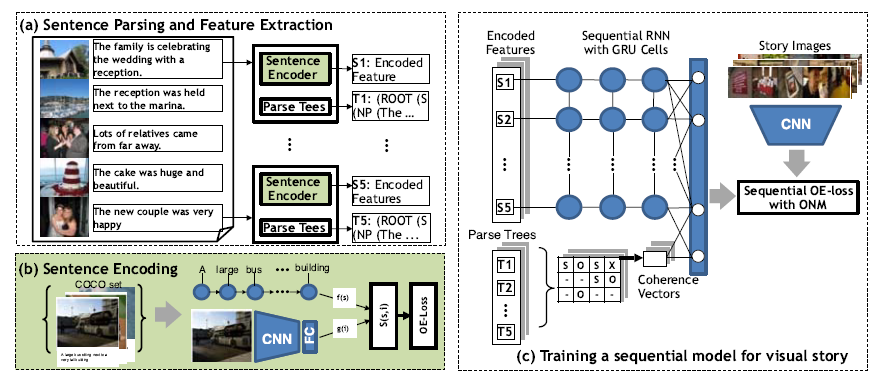

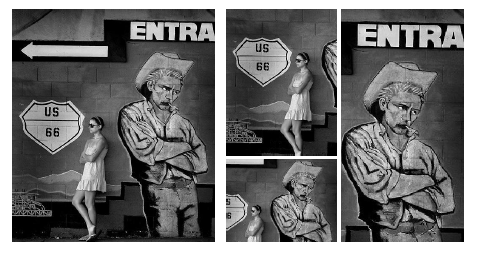

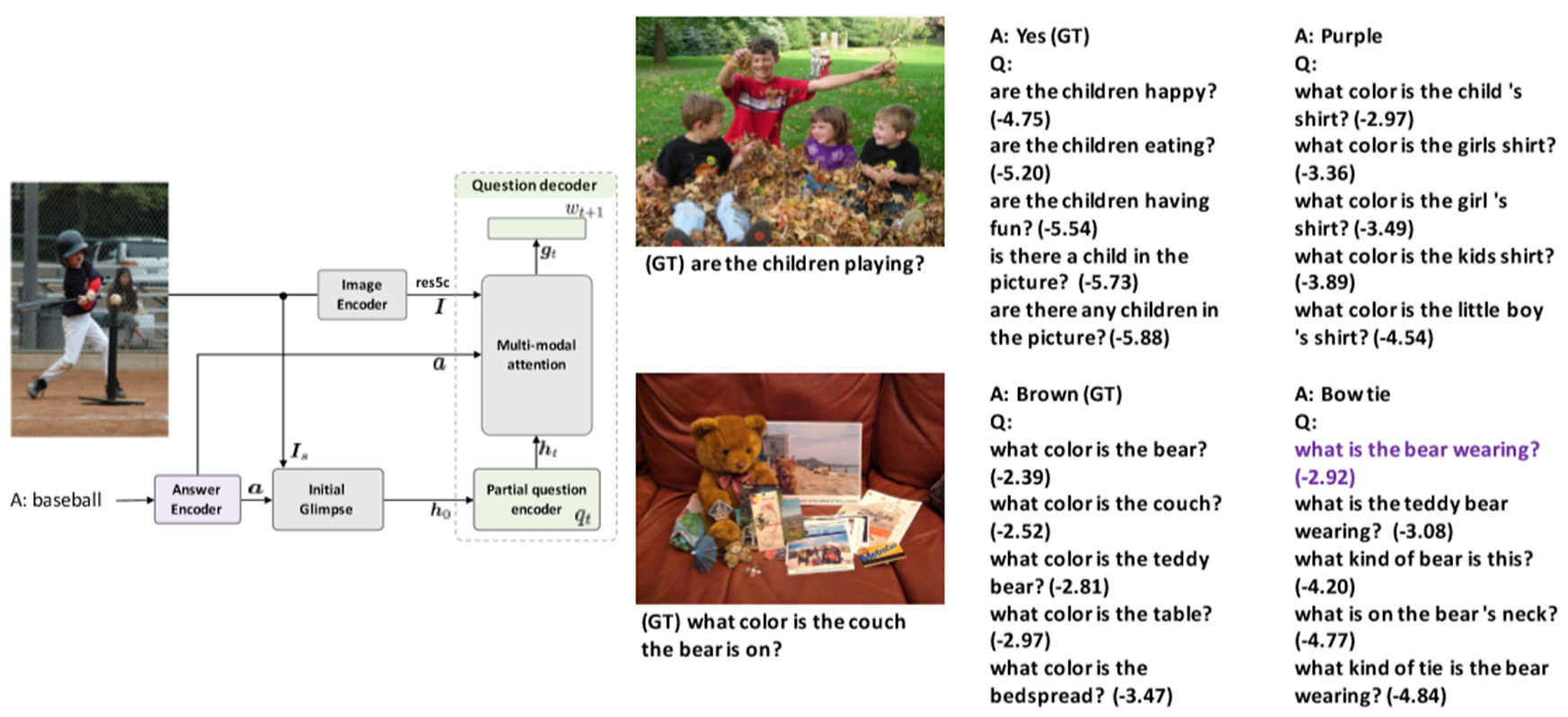

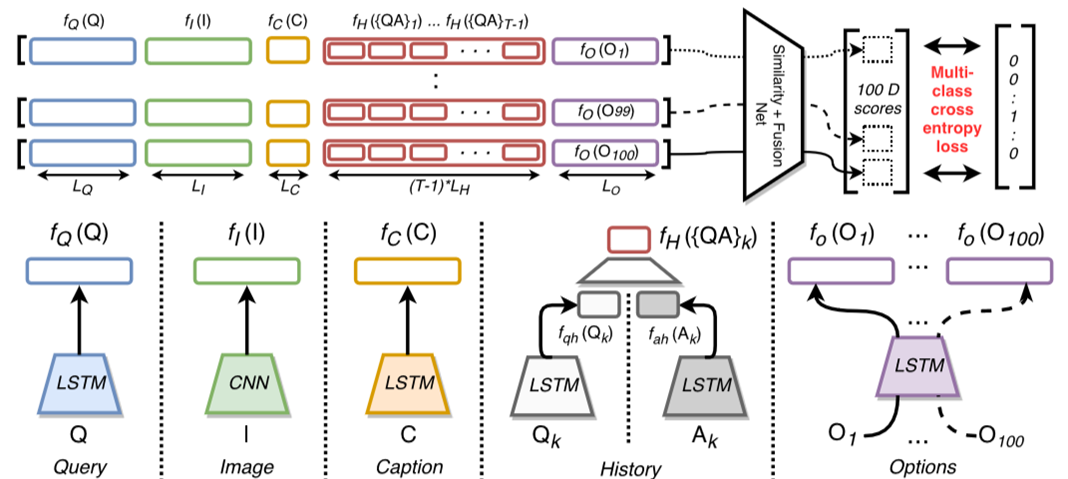

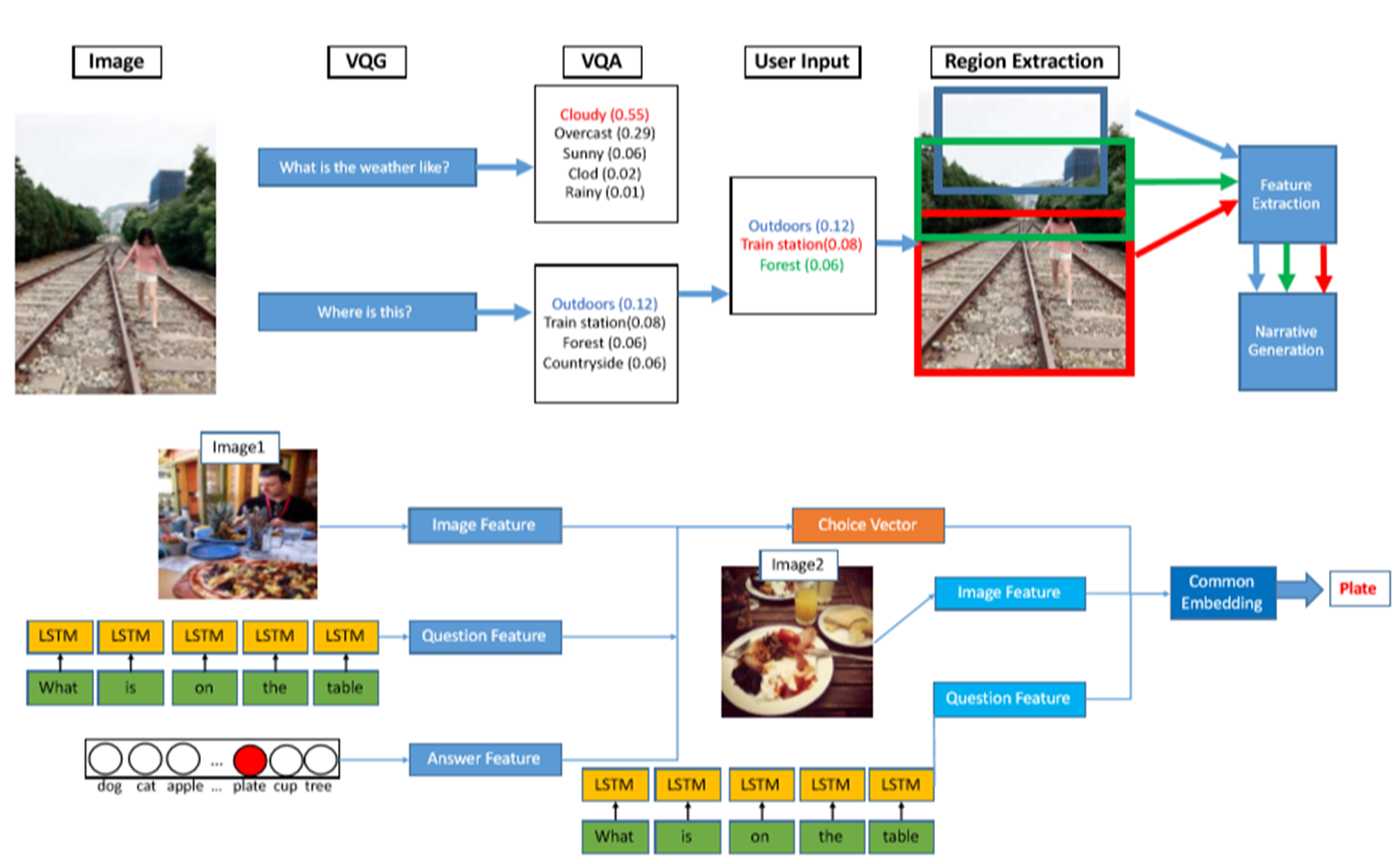

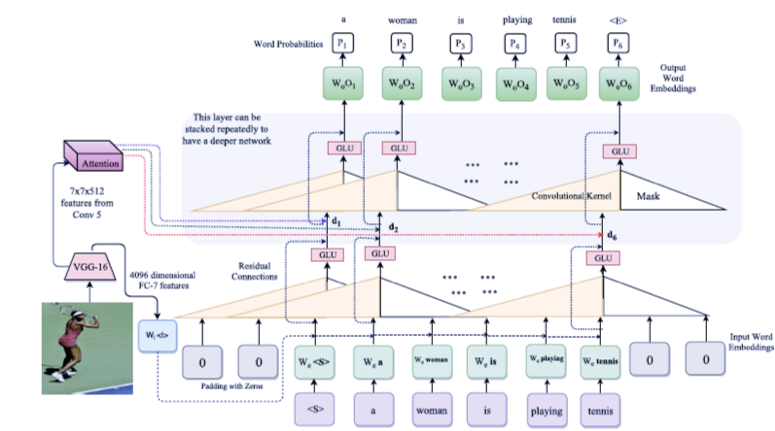

・textual CNNを使って、画像とセンテンス両方にCNNを適用する

・中間表現を使ってglobal semanticの学習をアシストする

・semantic embeddingがうまくいくことを確認した

・CNNをvisual and textual semantic embeddingに利用した。このネットワークはend-to-endで学習することができる

・中間の畳み込み特徴と大域的なsemantics特徴を局所的なコンテキスト特徴の学習のために利用する

・Flickr30kとMS-COCOデータセットを使って提案するモデルが効果的であることを実験で示した

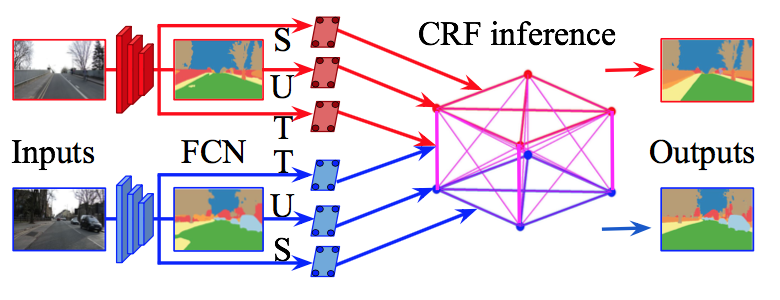

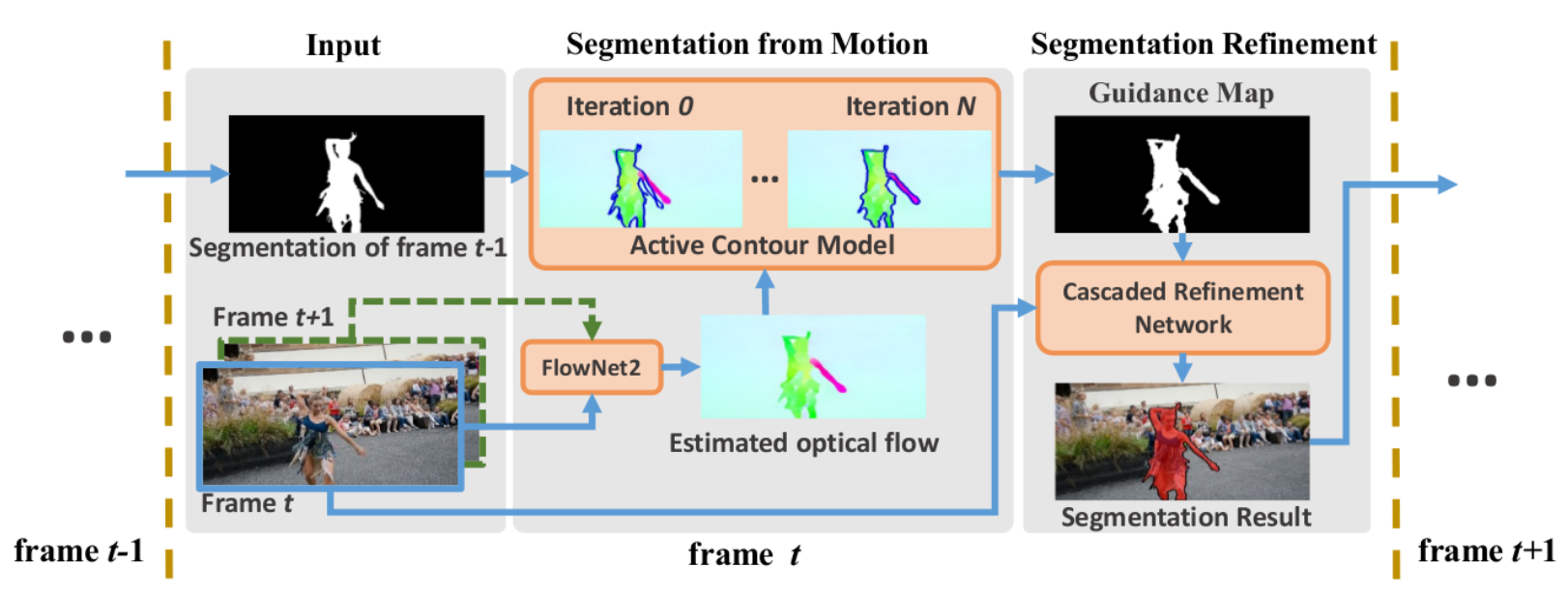

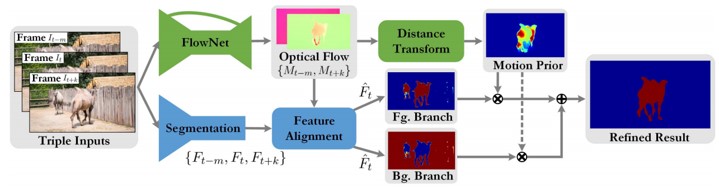

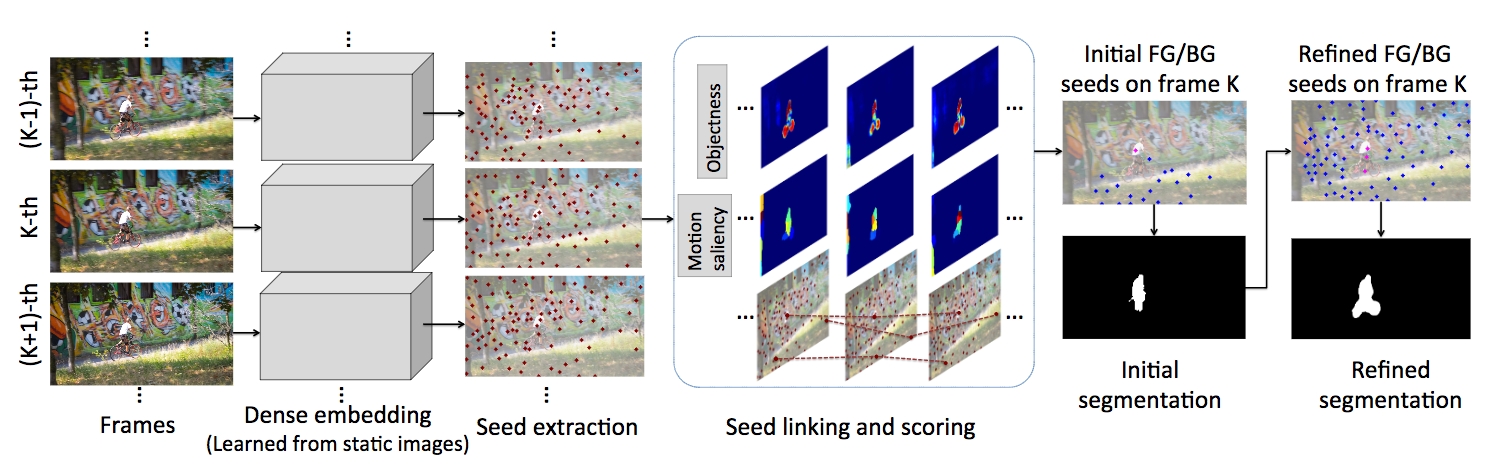

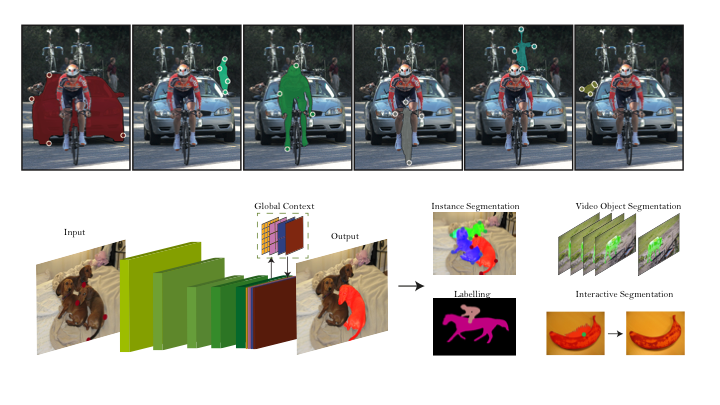

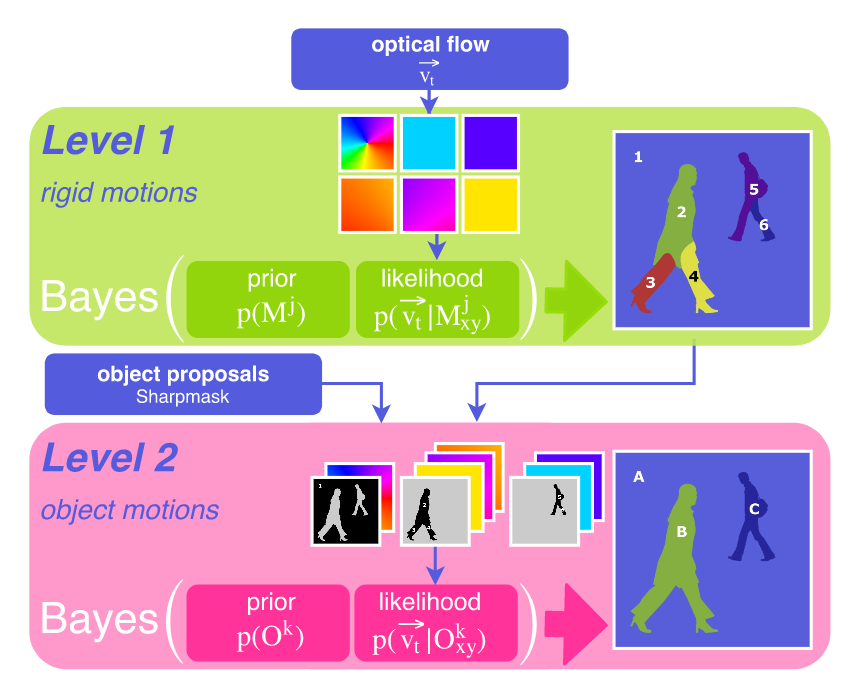

ビデオでの領域分割のためのdeep Random Fieldを用いた手法(VideoGCRF)を提案.Deep Gaussian Conditional Random Fields(GCRFs)を利用し,密接に関係する時空間グラフの推論が時間効率・メモリ効率に優れた手法を提案する.

・計算効率,メモリ効率

・固有の大域的最小値を持つ

・end-to-endで学習が可能

・はじめに,複数枚の入力画像からFCNでピクセルごとのクラスラベルを予測する.同時に空間的な埋め込みベクトルと,時間的な埋め込みベクトルをそれぞれ獲得する

・埋め込みの内積から,時間的な埋め込みと区間的な埋め込みの位置を結合する

・最後に線形システムを解く事で,最終的な予測結果を得る

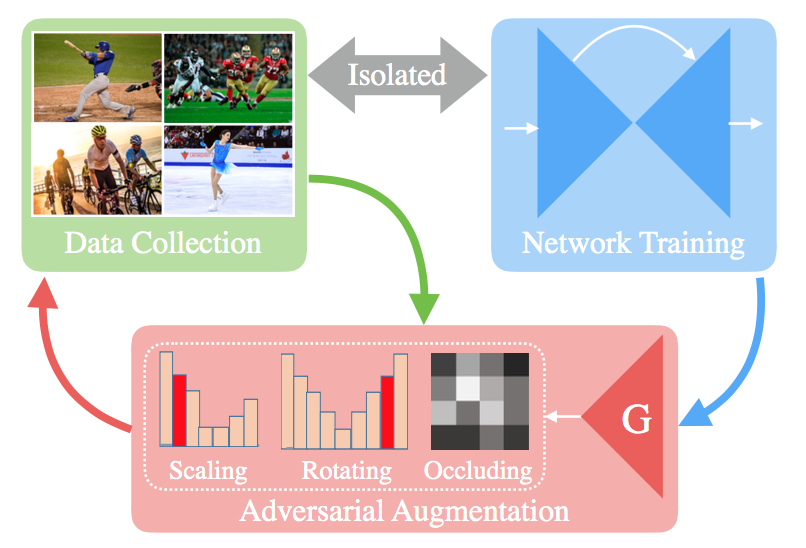

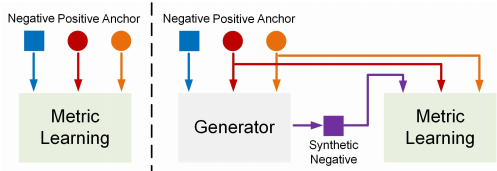

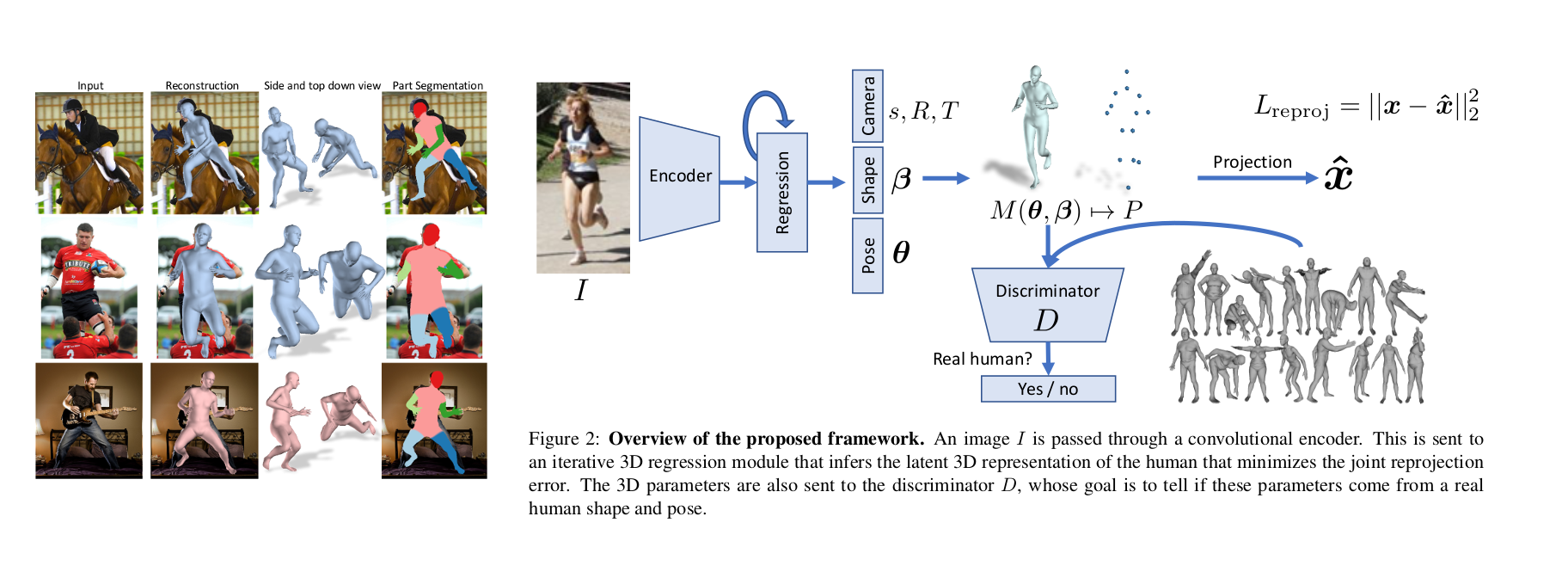

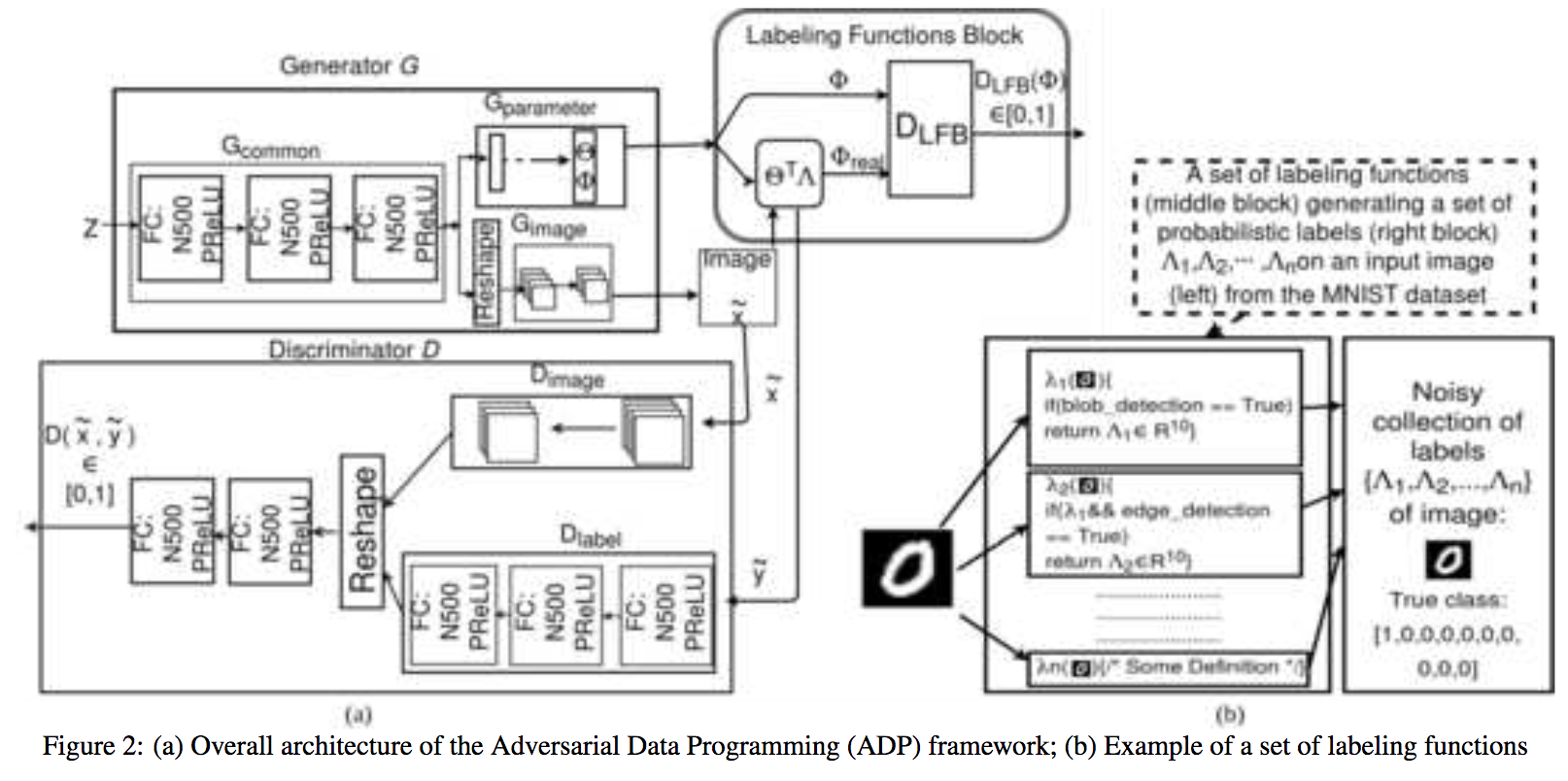

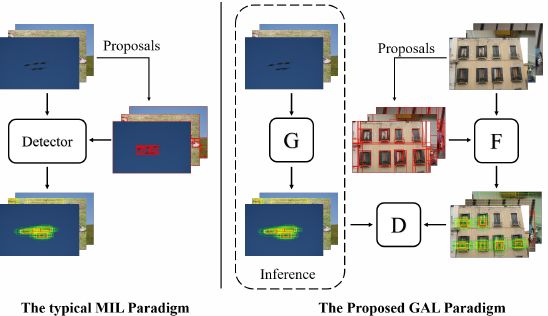

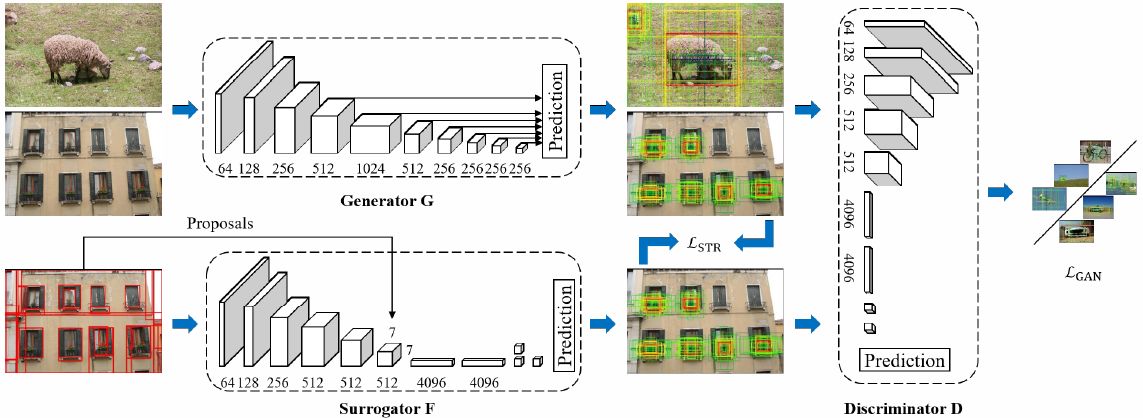

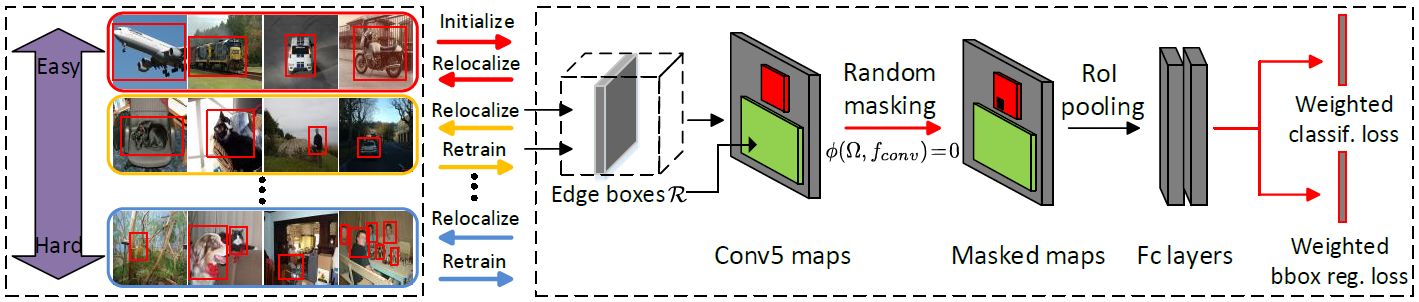

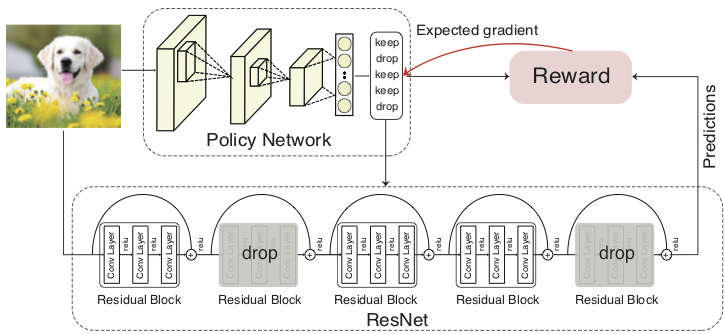

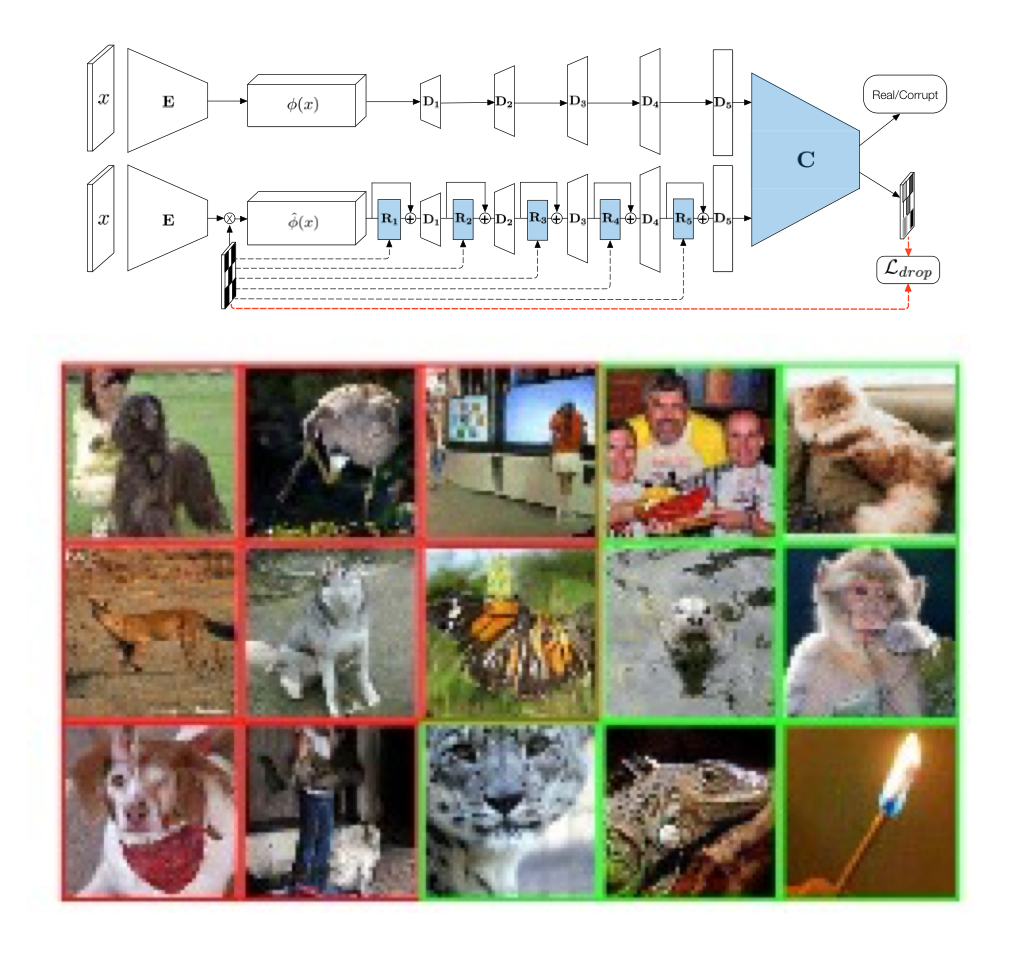

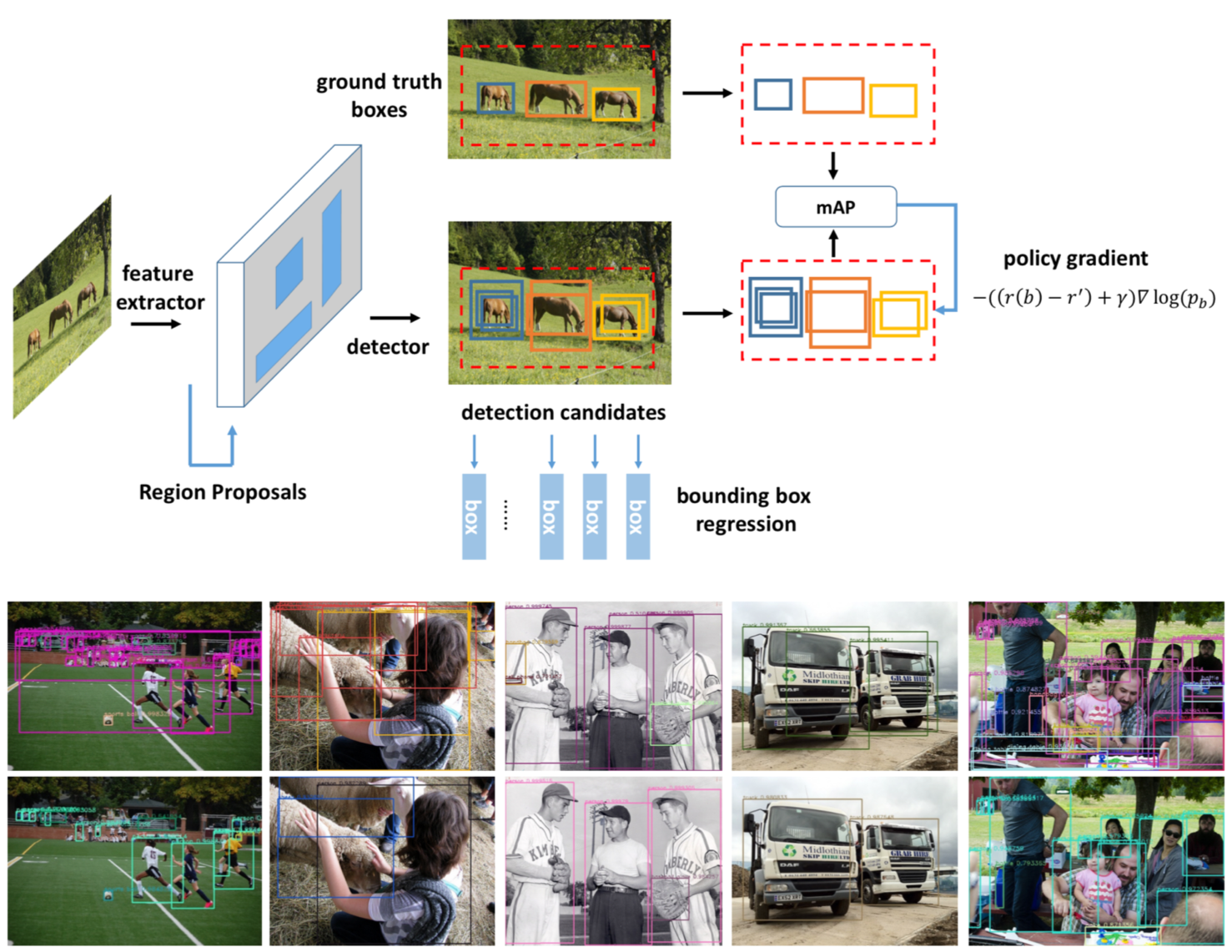

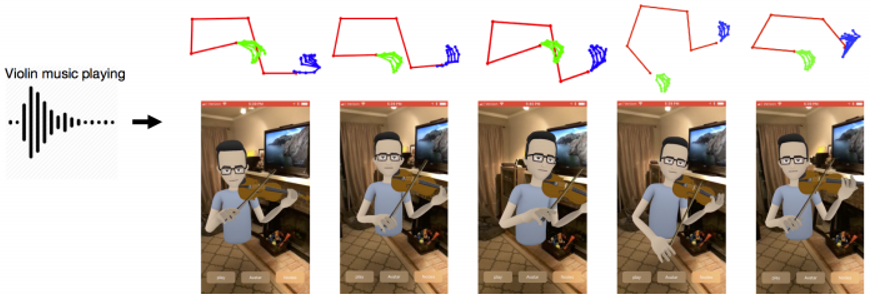

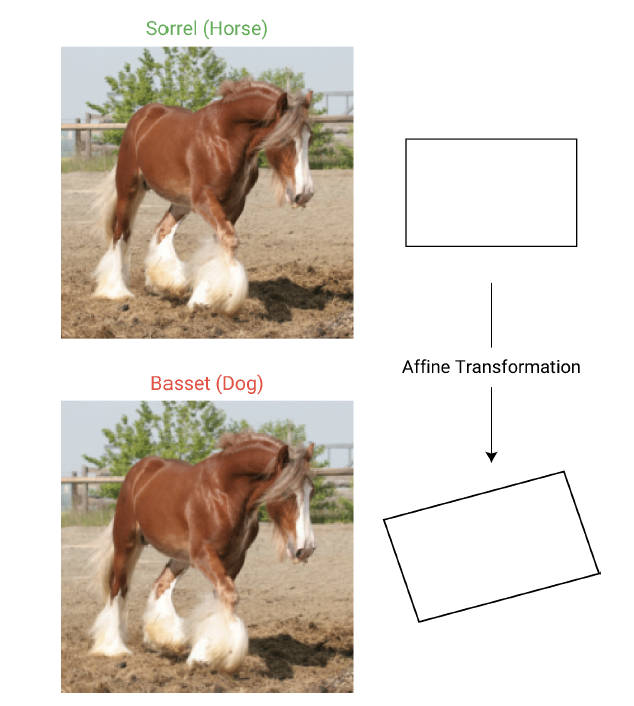

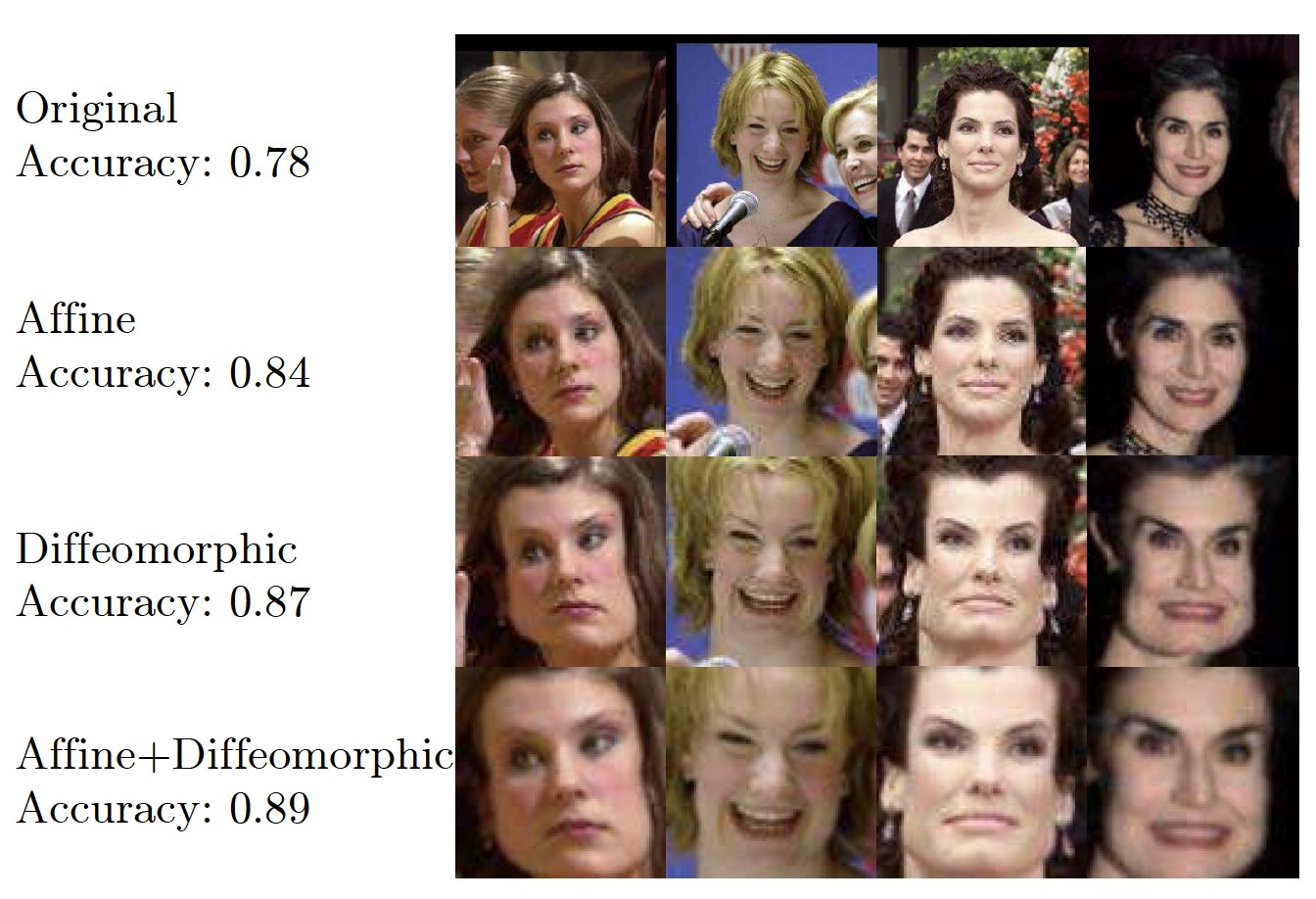

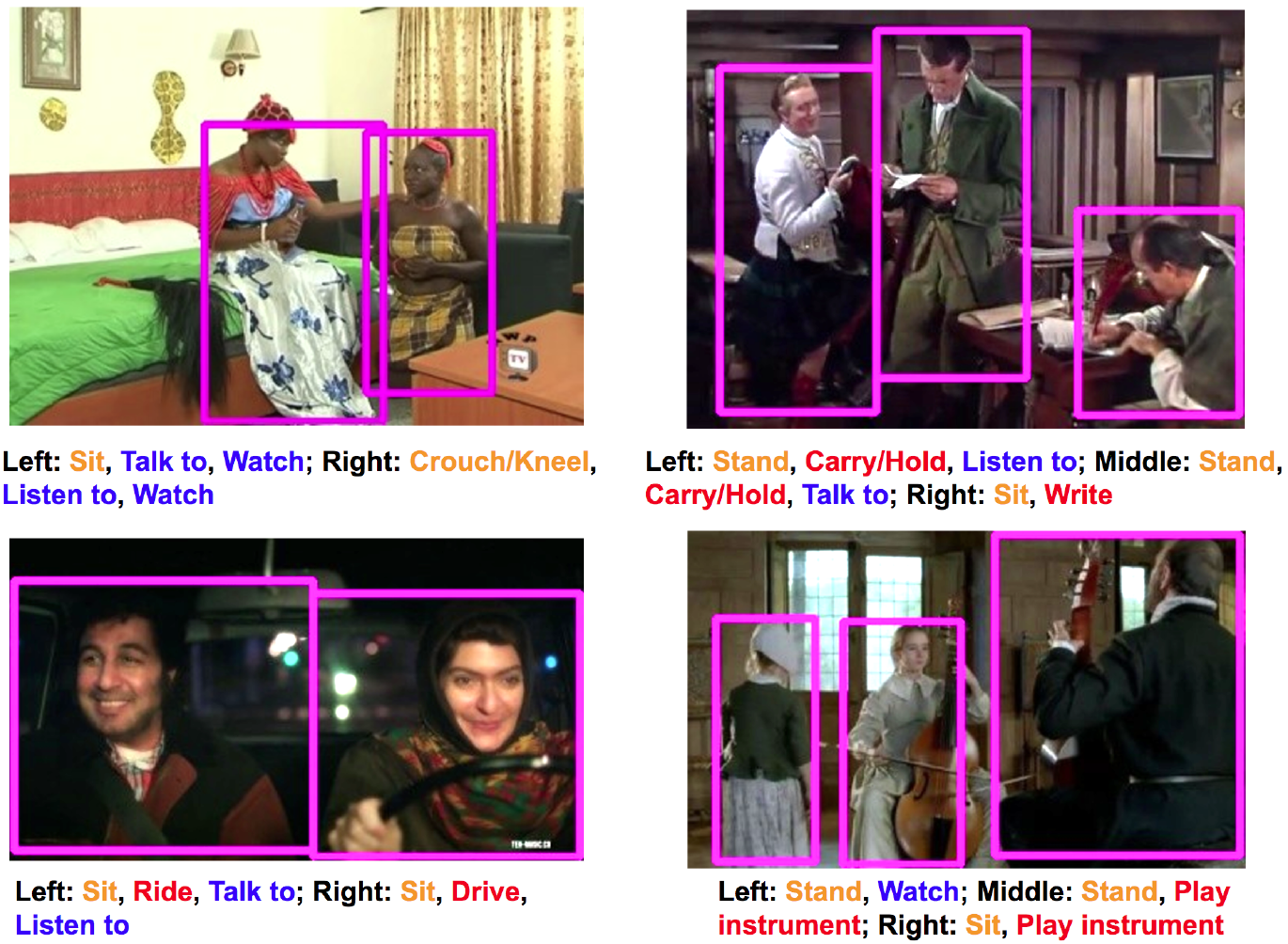

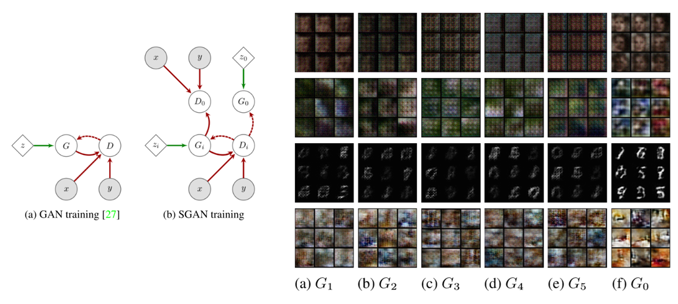

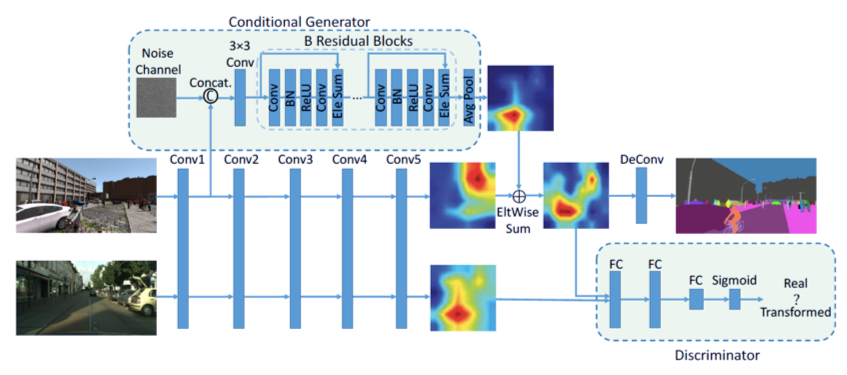

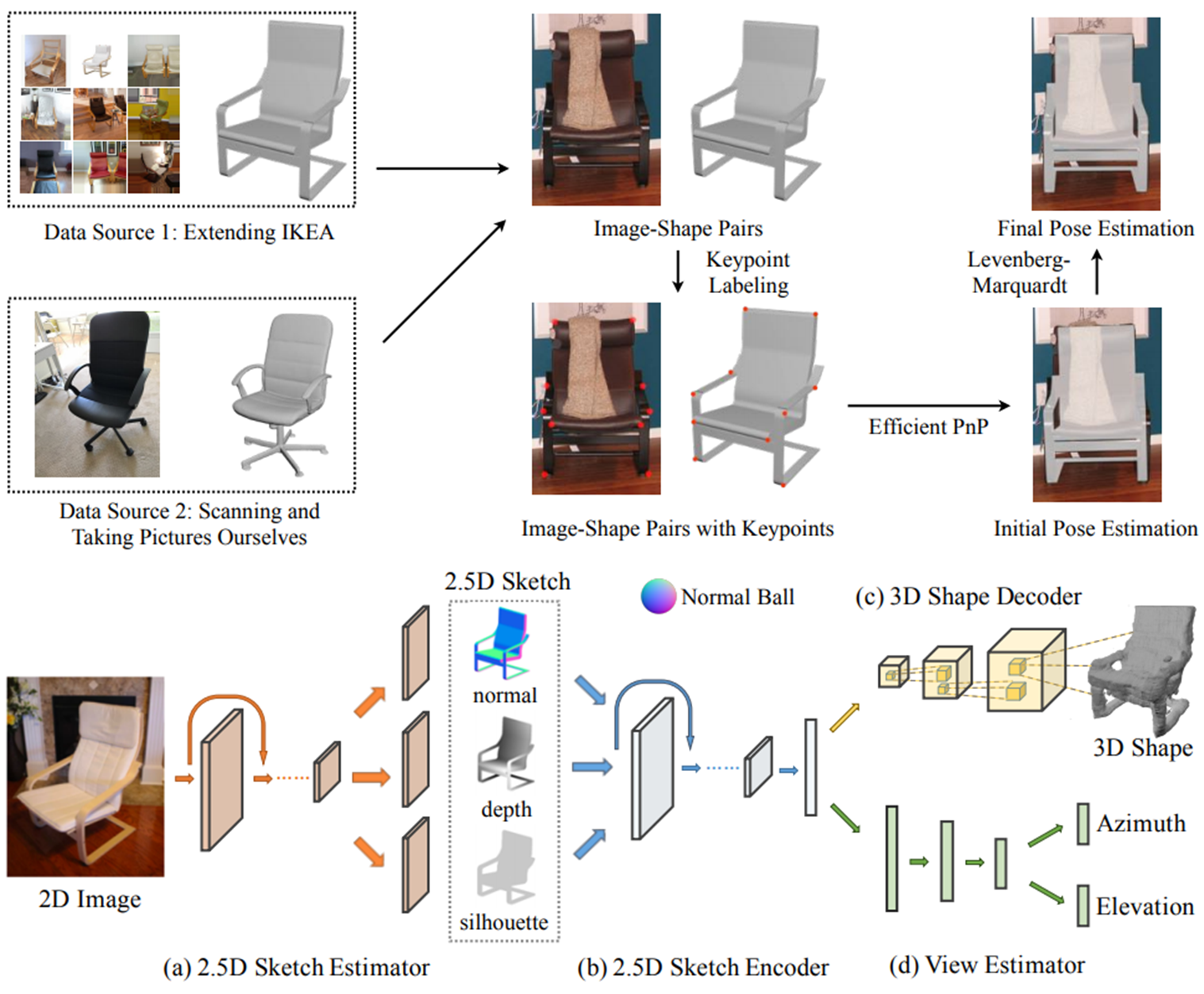

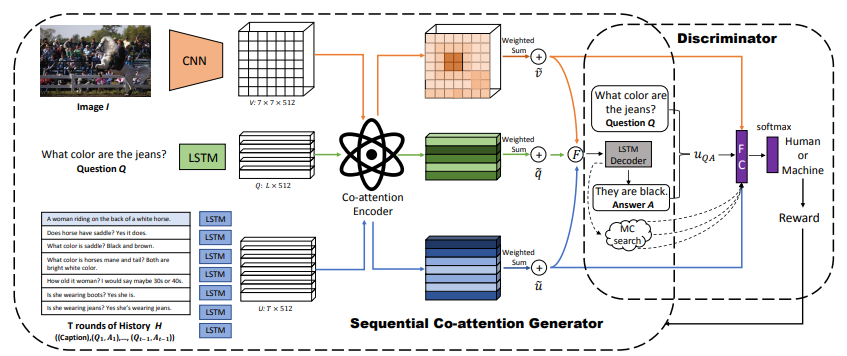

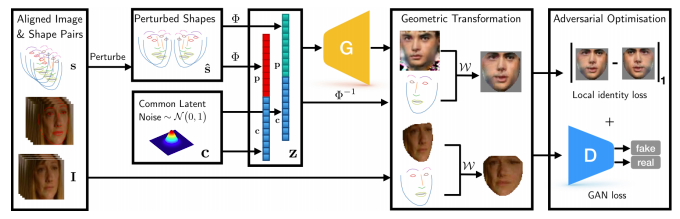

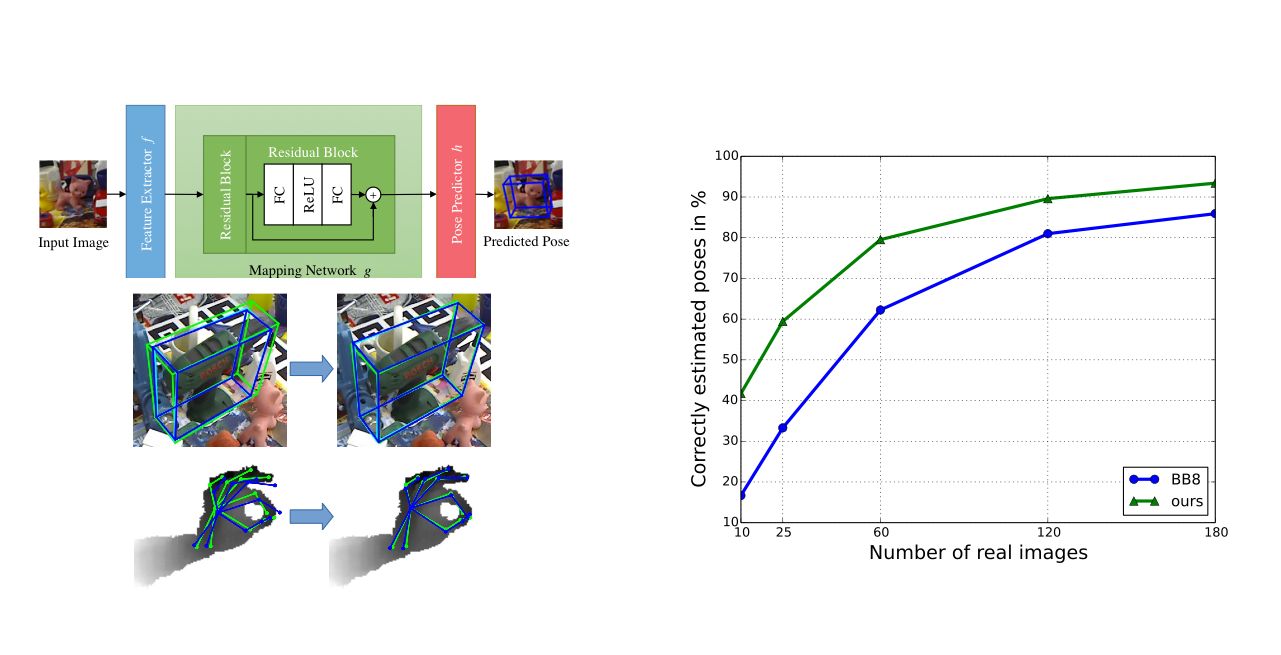

データ拡張とネットワークの学習を敵対的学習の枠組み取り入れ同時に行う.キーとなるアイデアは,Generator(データ拡張ネットワーク)がDiscriminator(学習対象のネットワーク)にとってのhard exampleをオンラインで生成すること.これによって,GeneratorはDiscriminatorの弱みを探し,よりDiscriminatorの性能を伸ばすことができるようになる.

同時学習を効率的に行うための報酬や罰則のストラテジーも提案する.

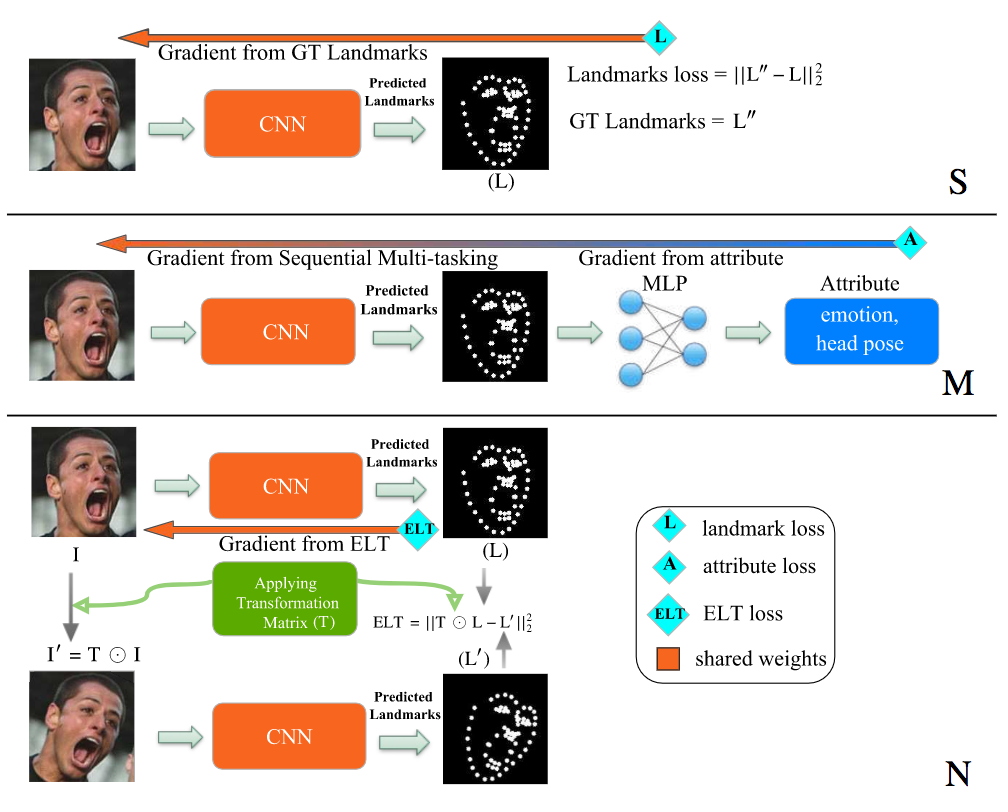

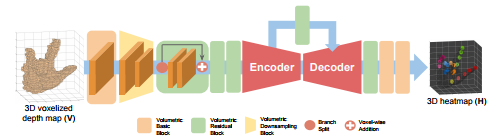

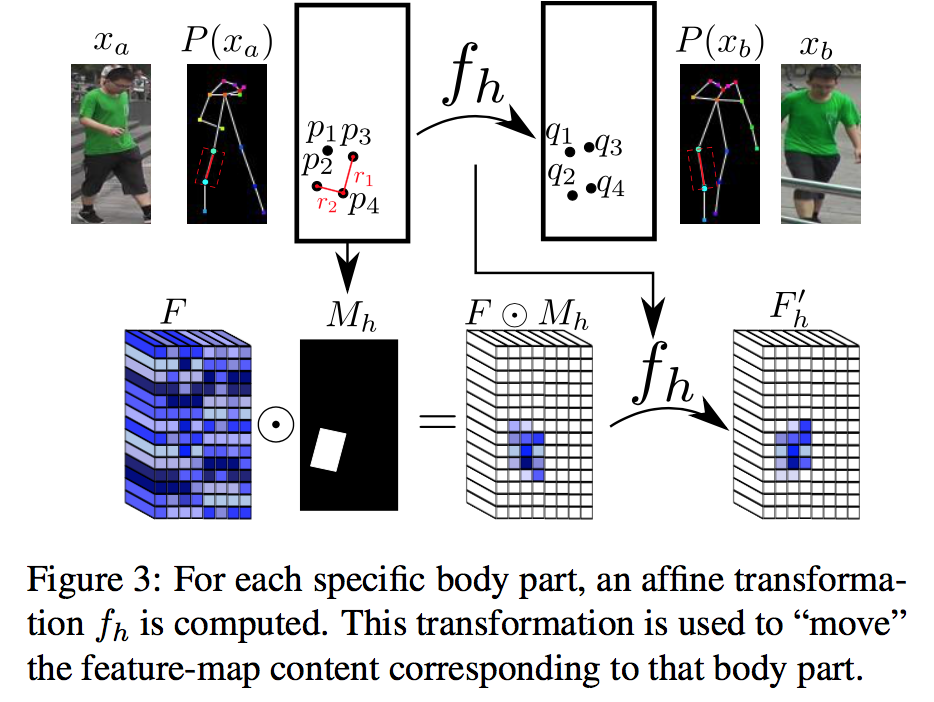

この論文では,pose estimationのタスクに適用し,state-of-the-artを超えるデータ拡張ができたことを確認した.

・データ拡張とネットワークの学習は通常切り離されているのに対して,この論文ではこの二つを同時に行うことが新しい.

・敵対的にデータ拡張を行うことが,オンラインでやられていること

・同時学習用の報酬や罰則のストラテジーの提案

・pose-estimationタスクでいいスコア

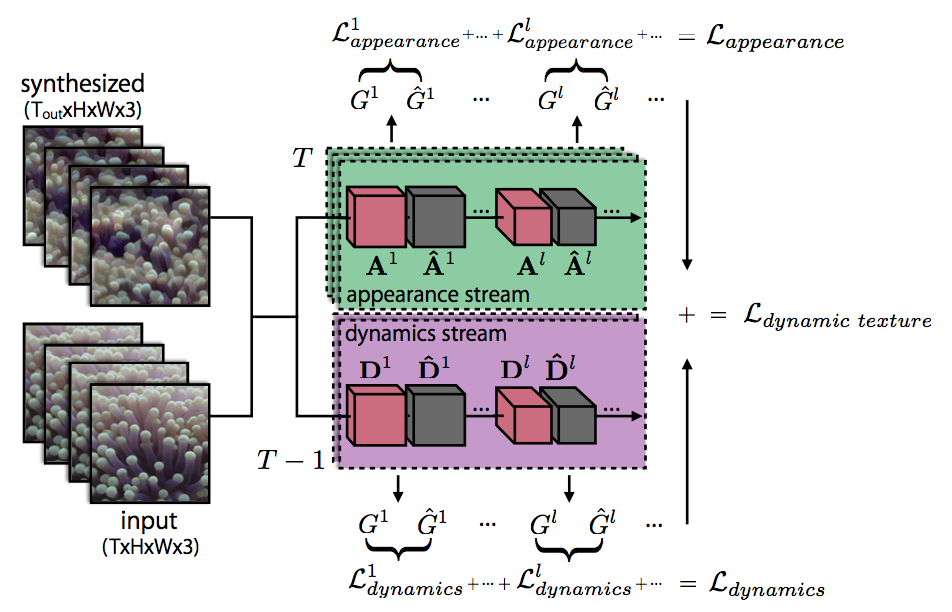

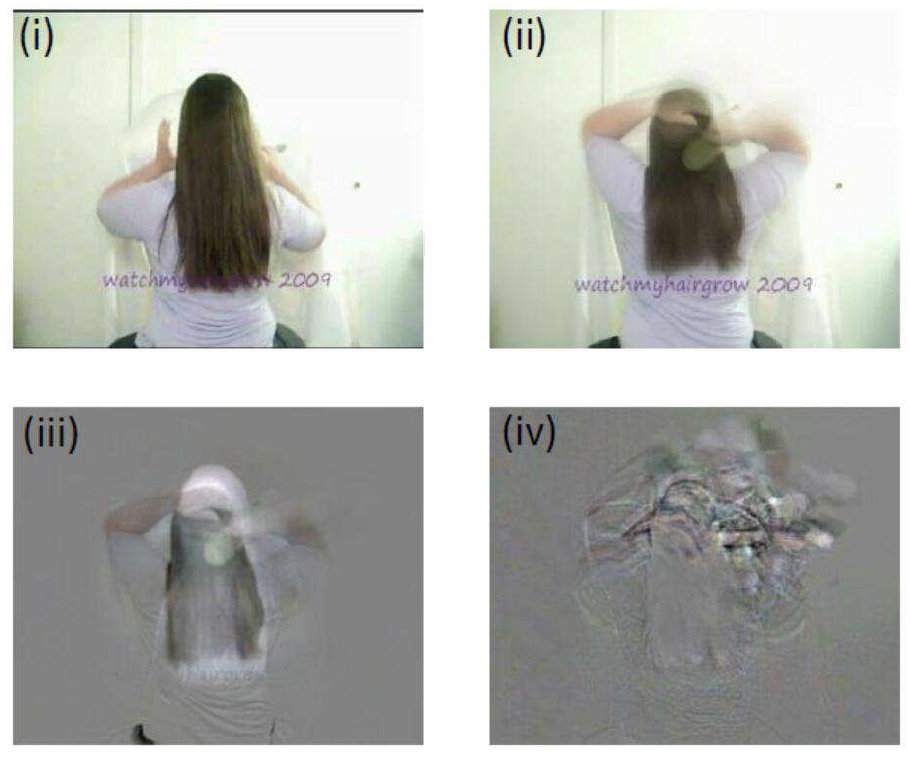

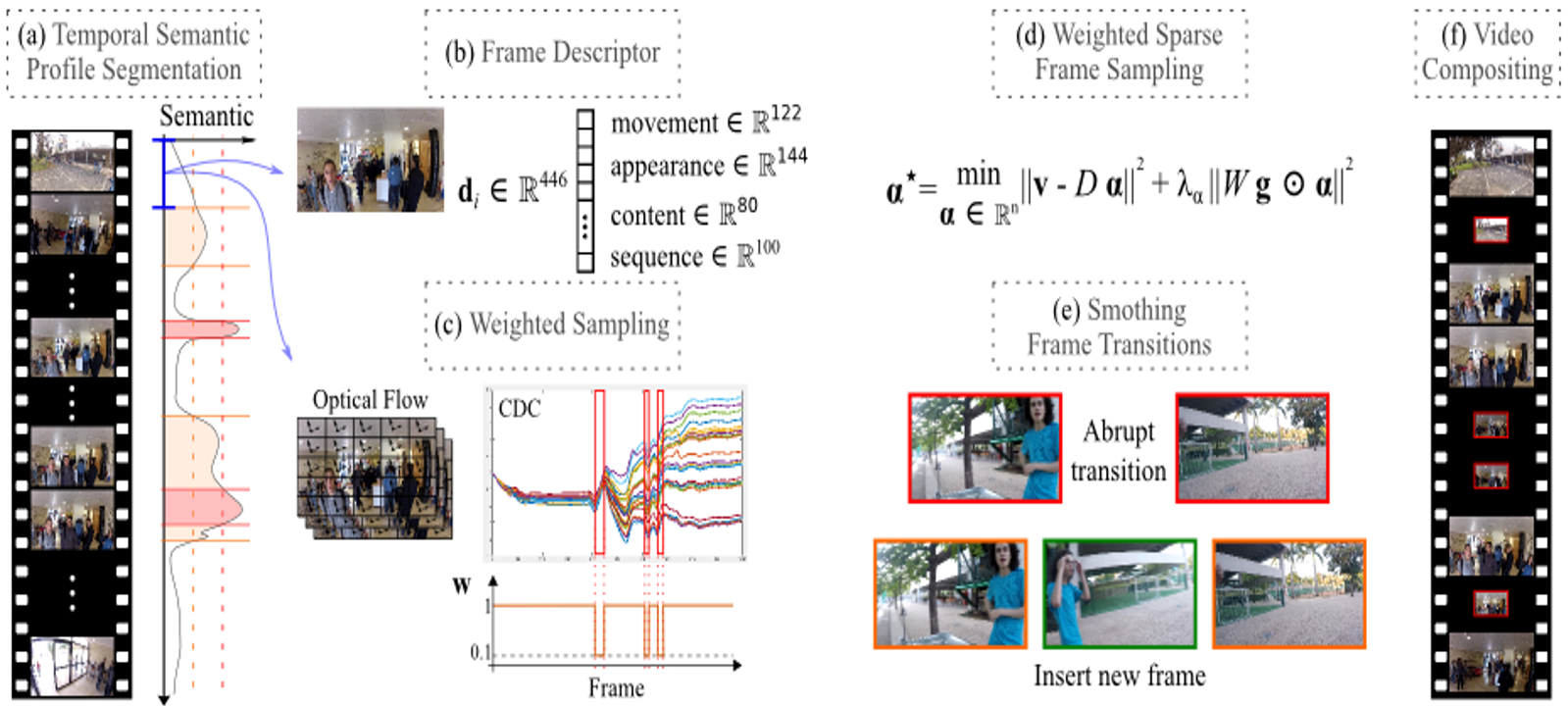

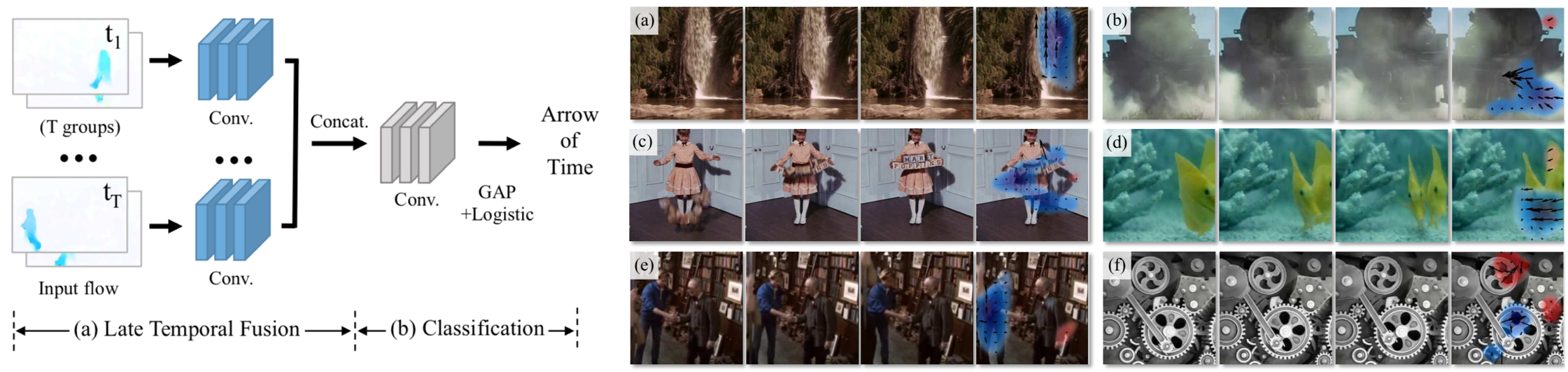

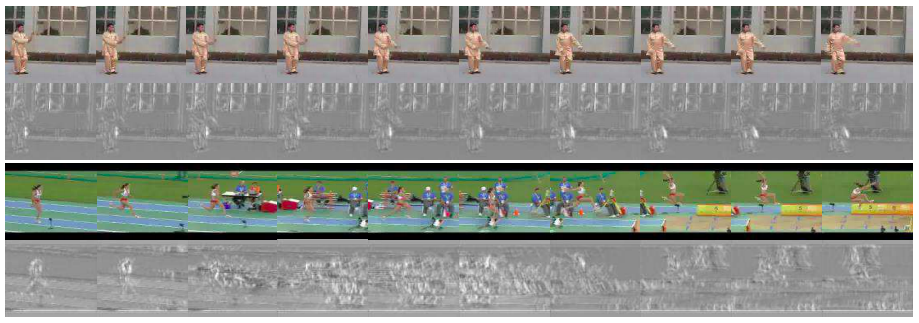

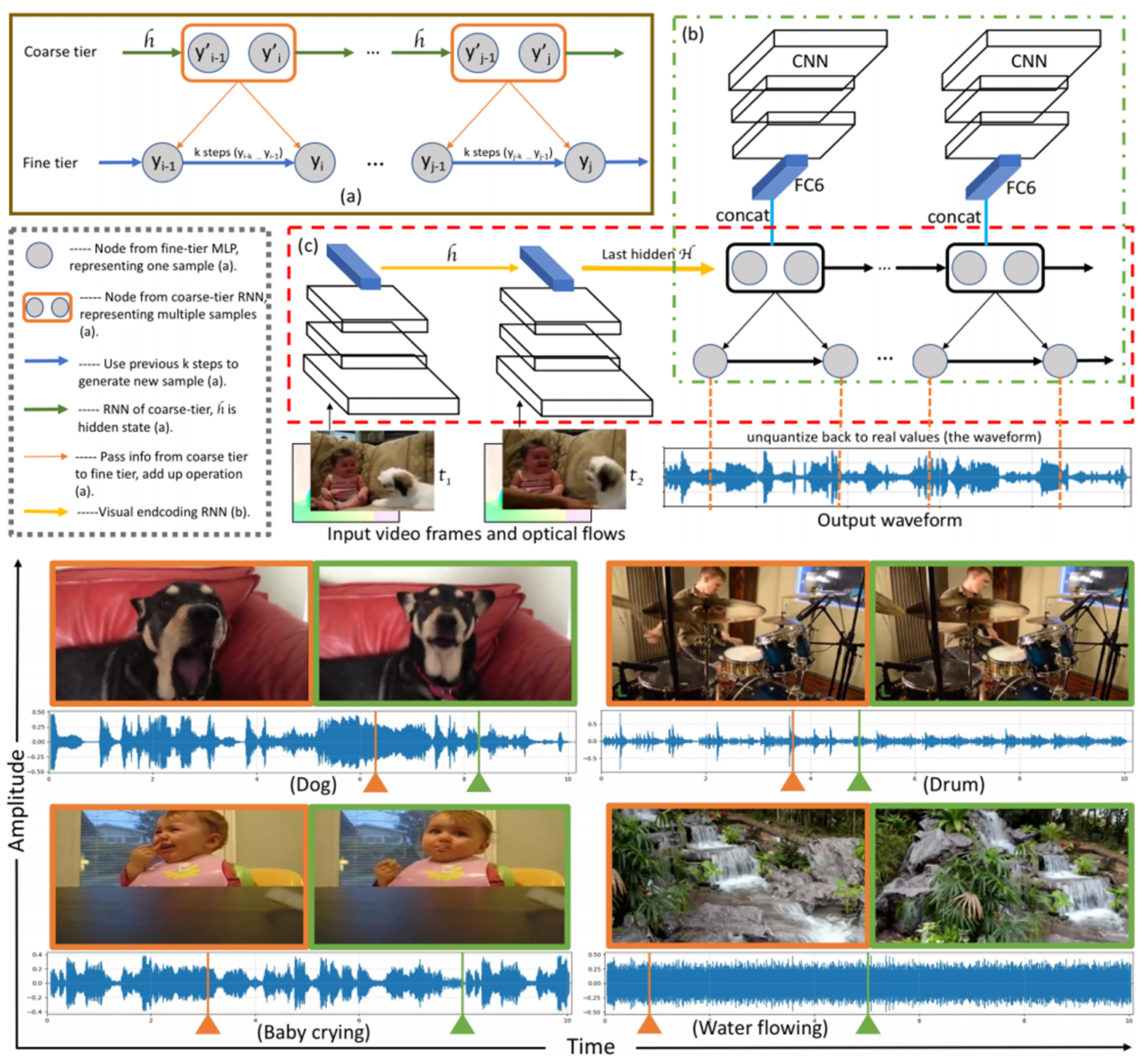

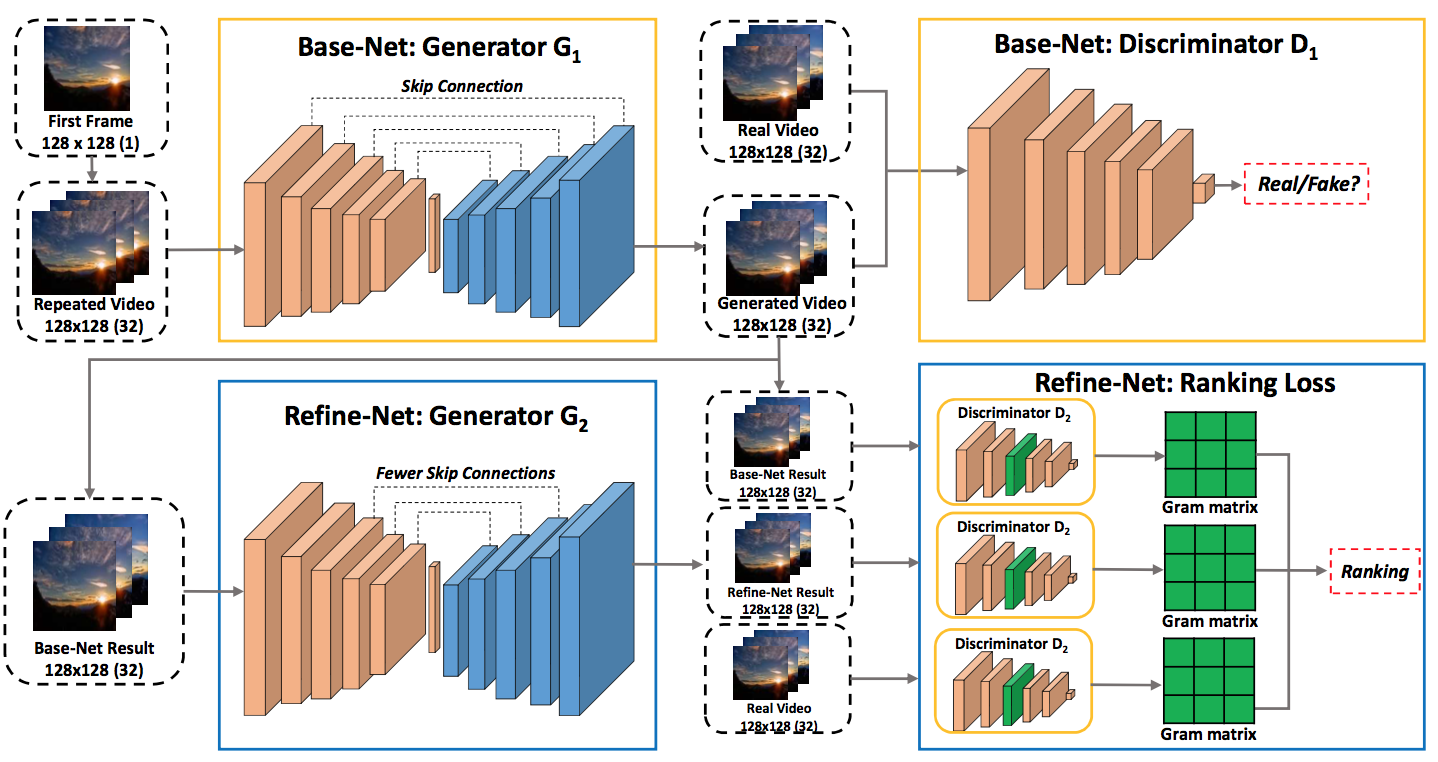

動的なテクスチャー生成のために two-streemのモデルを導入した.生成される結果は3〜5秒程度の動画で,結果例はプロジェクトサイトに詳しく載っているので参考にされたい. 定量評価として,200人によるUserStudyを行なっている.59組の生成結果と正解動画を見せ,どちらがリアルかの回答を得た.

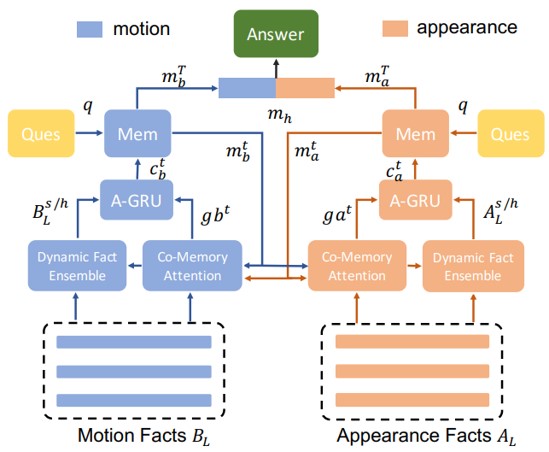

・学習済みモデルを利用し,これを(1)物体認識,(2)オプティカルフロー推定の二つのタスクのために利用.

・物体認識のストリームで入力テクスチャーのアピアレンスの統計的特徴を獲得し,オプティカルフロー推定のストリームで動きの特徴を獲得する.

・入力の動的テクスチャーと生成する動的テクスチャーの二つをスタイルトランスファーと同じようにグラム行列をベースとし,最適化問題として解くことで,動的なテクスチャーを生成する.

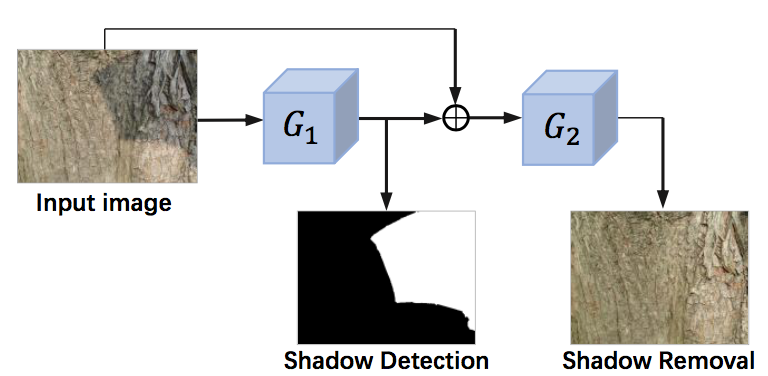

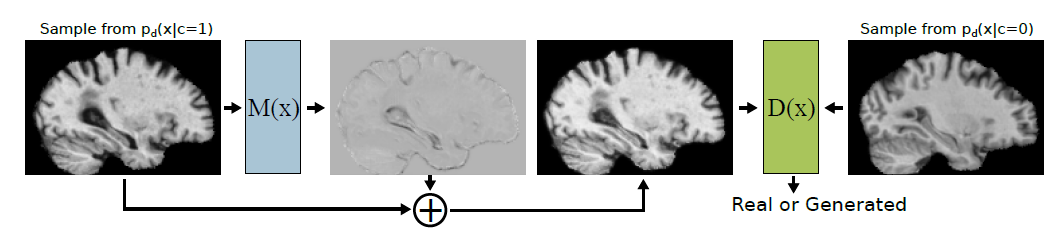

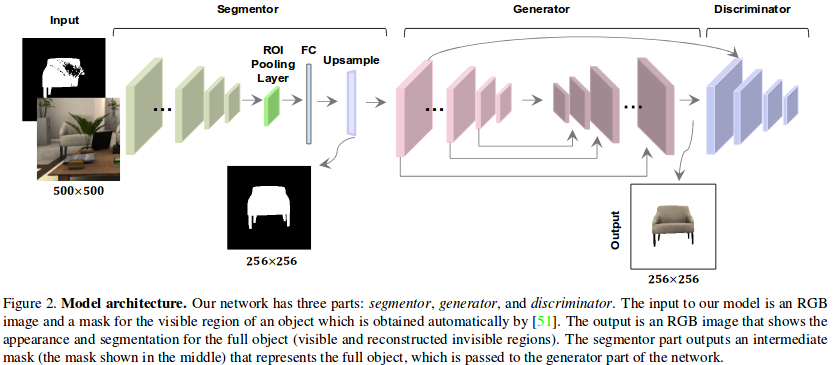

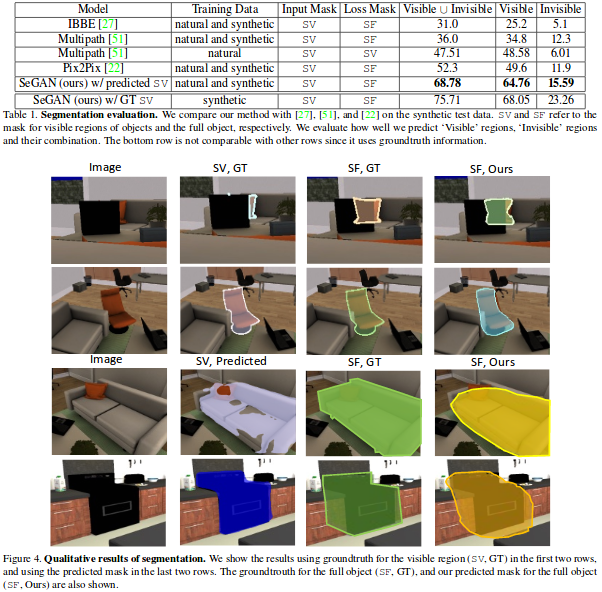

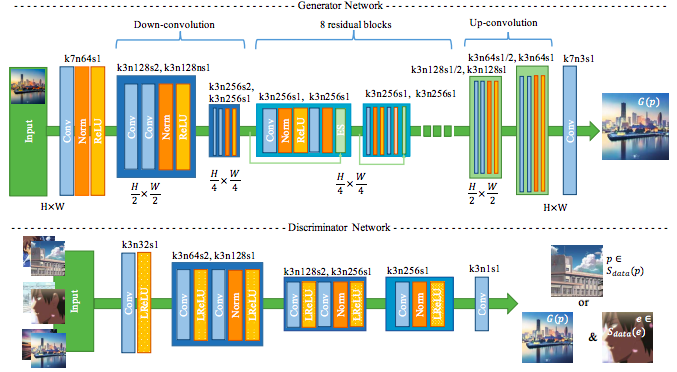

影の検出と除去という二つのタスクを同時に学習するend-to-endのフレームワークを提案.提案するST-CGAN は,2つのcGANがスタック構造になっている.一つ目のcGANで影を検出し,二つ目のcGANで影の除去を行う.影の検出と除去の両方に対応したデータセットも公開.

・二つのGeneratorはU-net構造.一つ目のGeneratorは影領域を示すマスクを出力とする.二つ目のGeneratorの入力は影付きの画像と出力されたマスクであり,出力は影を取り除いた予測画像である

・影あり画像,影マスク,影なし画像の3つのペアを持った1870組のデータセットを作成.元々影のない場所で,板や傘を使って自分たちで影を入れて撮影している.そうして上の3つのペアを作成した.

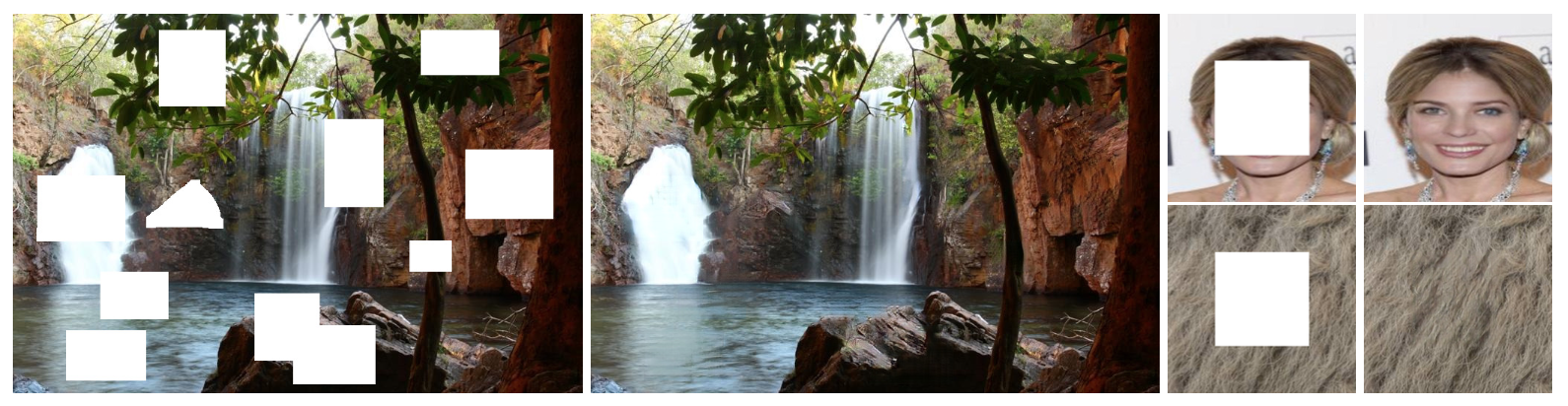

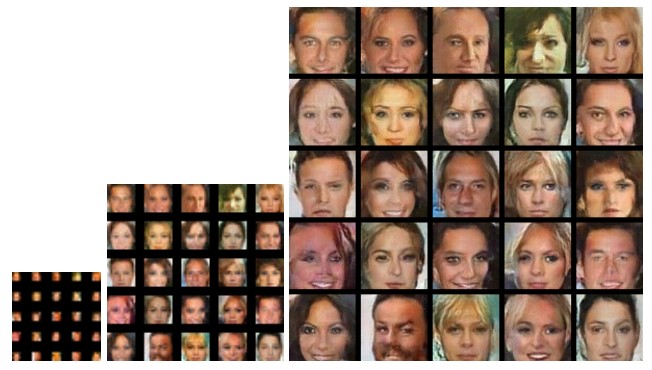

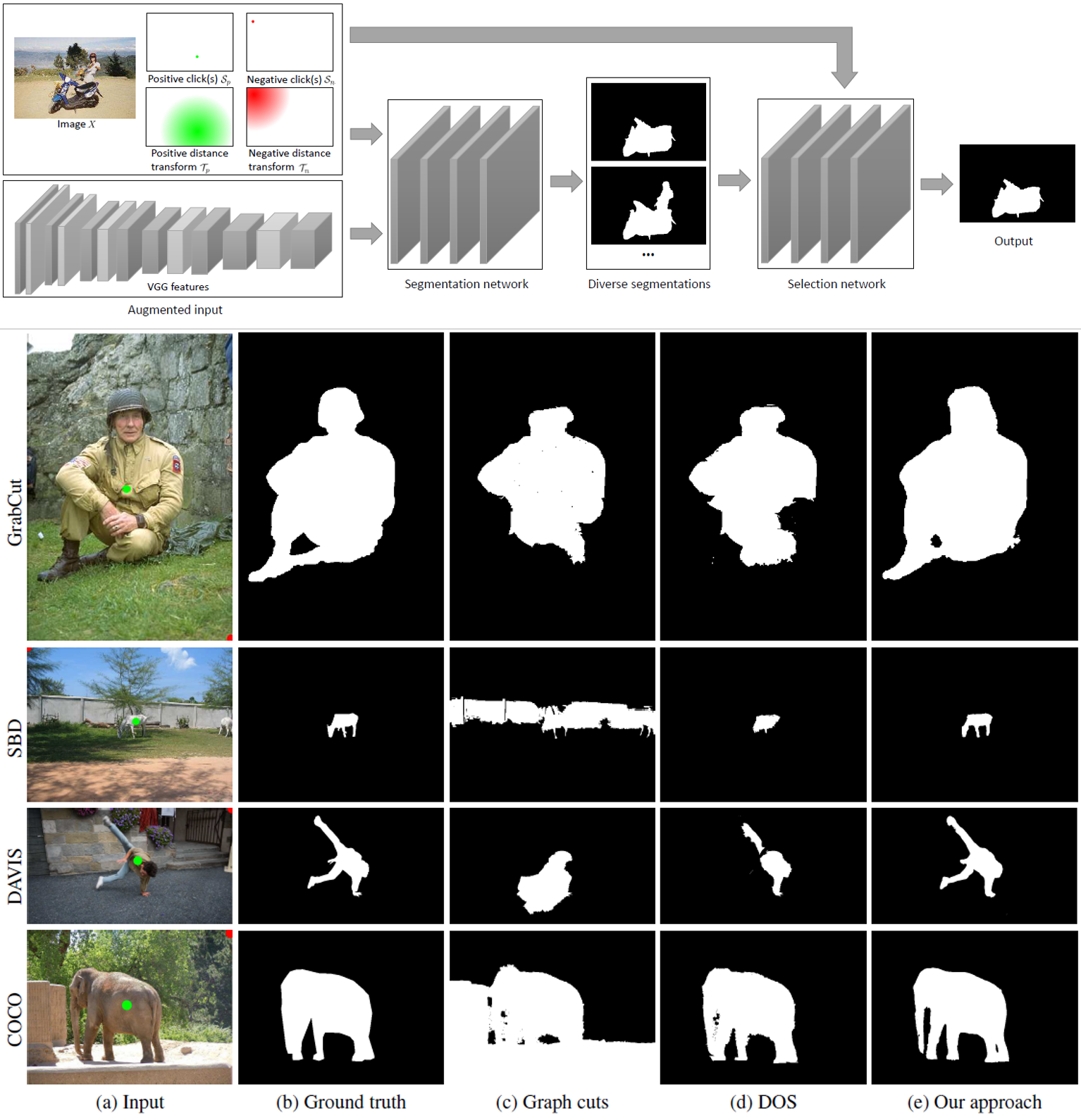

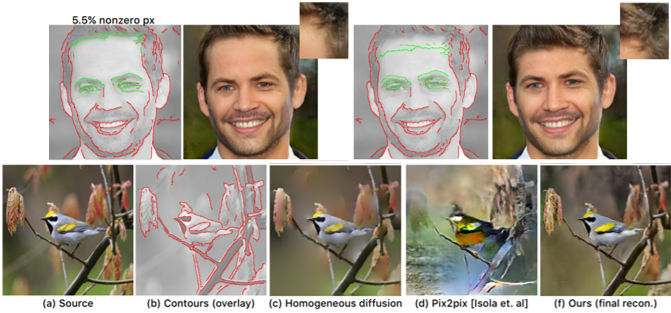

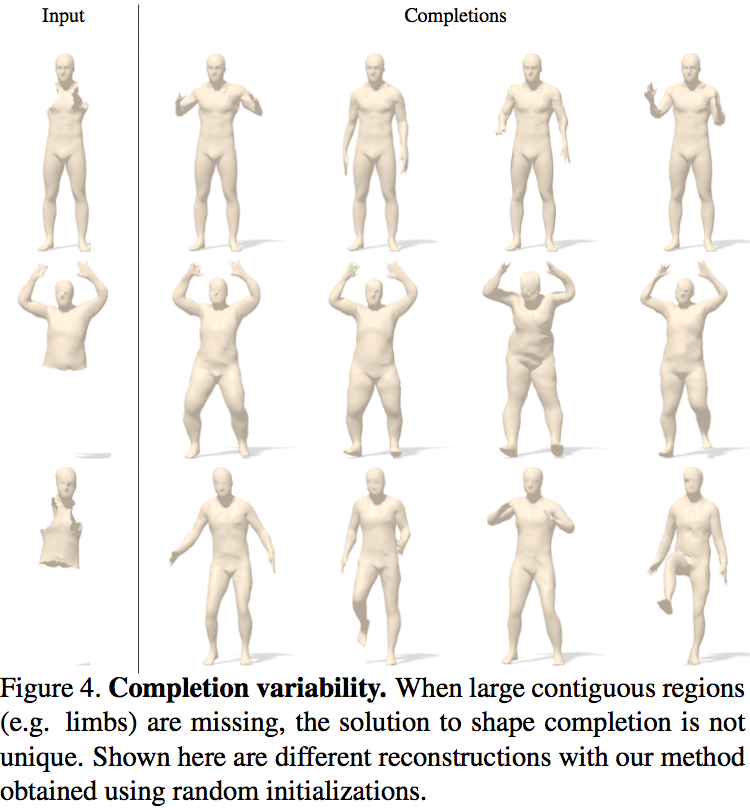

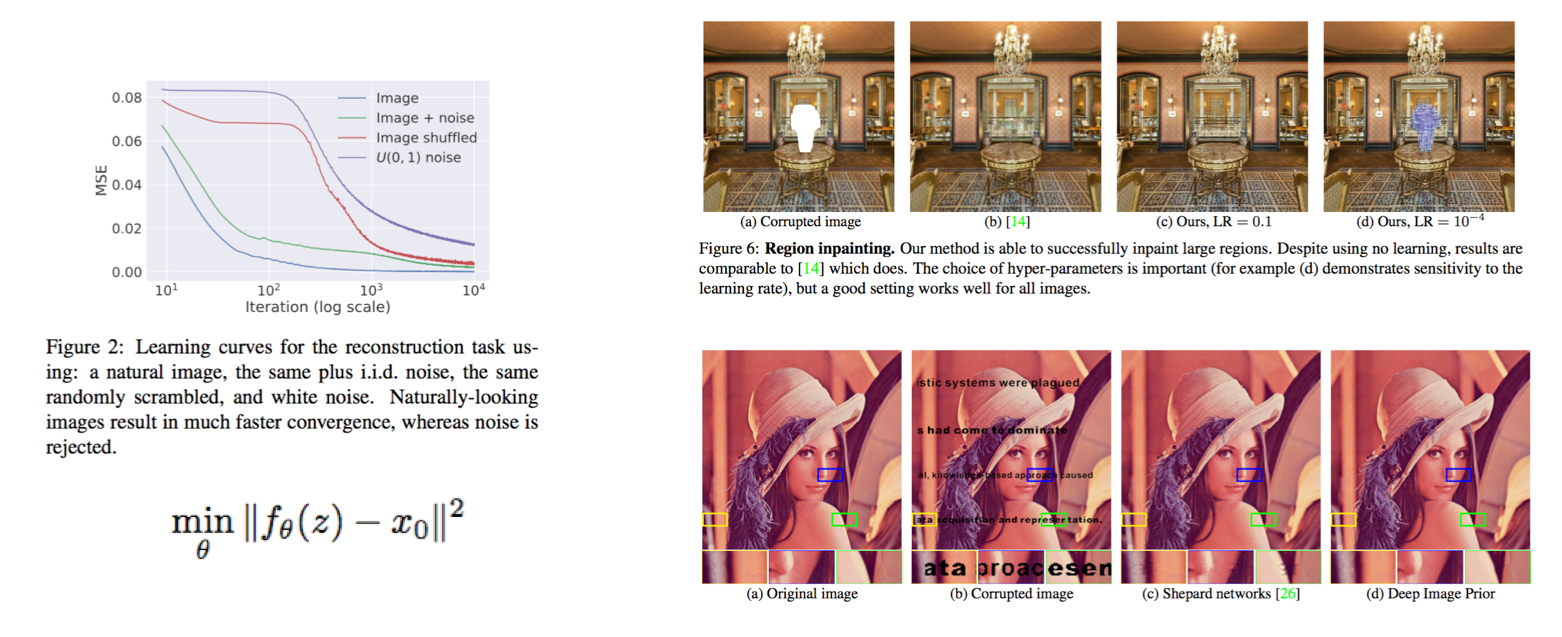

アテンションにより周囲の適切な箇所の画像特徴を利用する生成モデルベースの画像補完手法の提案.大きな領域を補完できるgenerative model-baseのアプローチと,周囲との整合性を取りやすい従来のパッチベースのアプローチのいいとこ取りをする.アテンション機構が,背景側のどの領域を参考にして補完領域を生成すべきか予測する.提案するモデル2つあり,アテンション機構を含まないベースラインモデルとアテンション機構を含むモデルである.モデルはfeed-forwardのFCNであるのでテスト時には任意の場所の複数の穴を補完でき,画像のサイズも任意となる.CelebA-HQの顔写真やテクスチャー,風景写真での実験で高い質の補完が行えることを示している.

各セットの左側が入力画像で,欠損領域が白塗りされている.右側の結果では,木の幹などの構造が崩壊せずに補完できている.

coarse-to-fineの段階的な構造を採用.学習時は,入力,coarse出力,fine出力ともに256x256のサイズの画像である.

従来手法のようにGlobalとLocalのDiscriminatorを持つ.Global Criticが出力画像全体の整合性を評価し,Local Criticが補完領域を中心として局所的な領域の整合性を評価する.Discriminatorが,WGAN-GP adversarial lossを算出するようにしたところが差分.

contextual attention layerの導入.conv層とdeconv層から成る. 前景のパッチと背景のパッチのマッチングスコアを計算するユニットになっている.

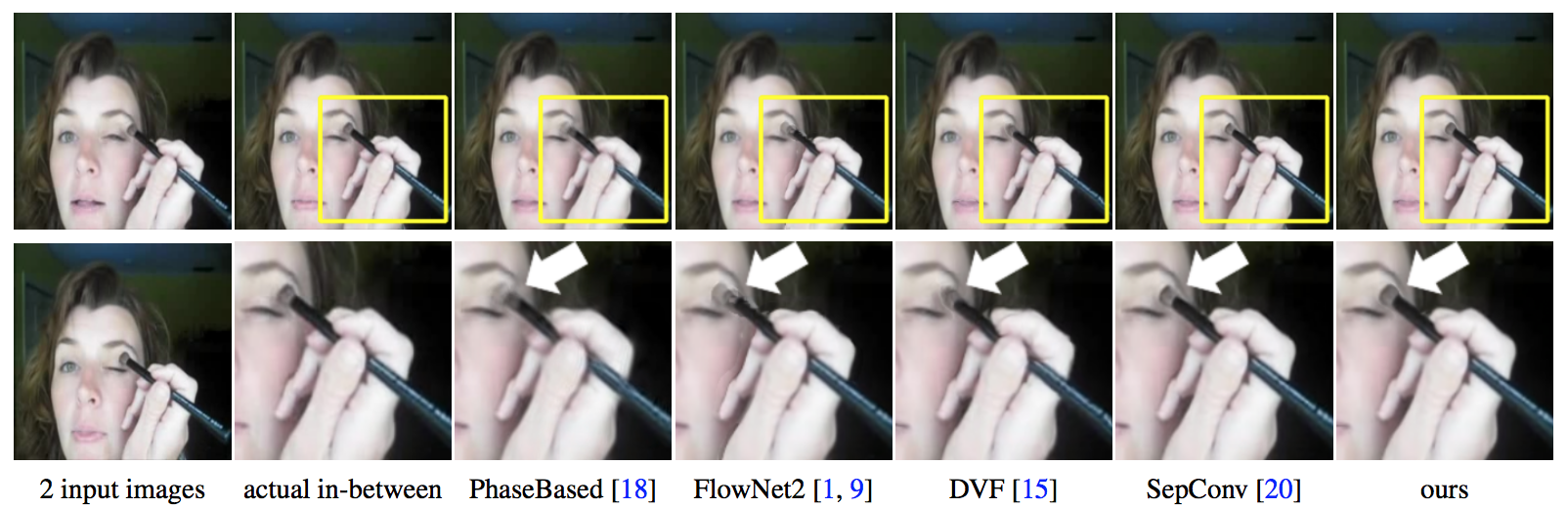

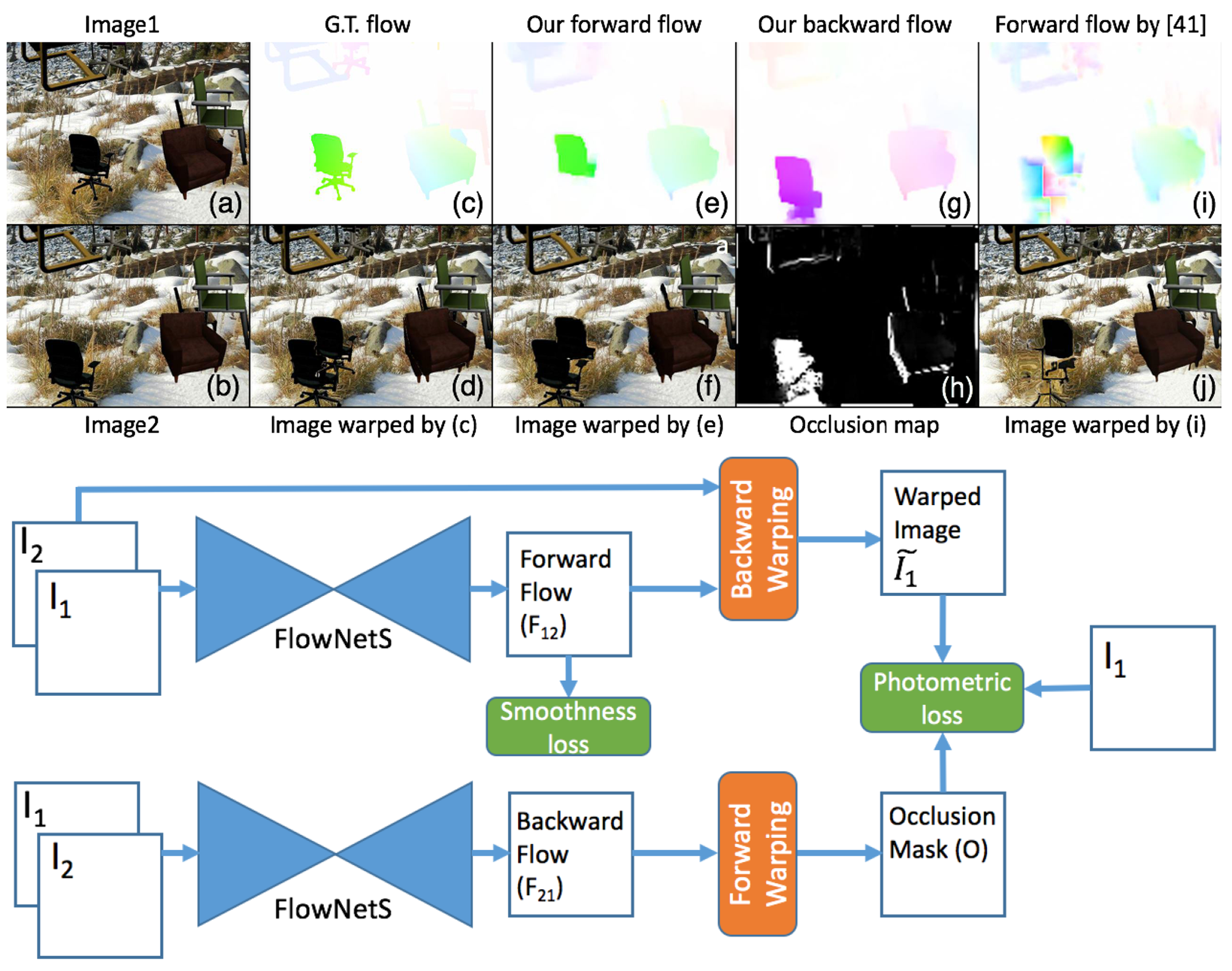

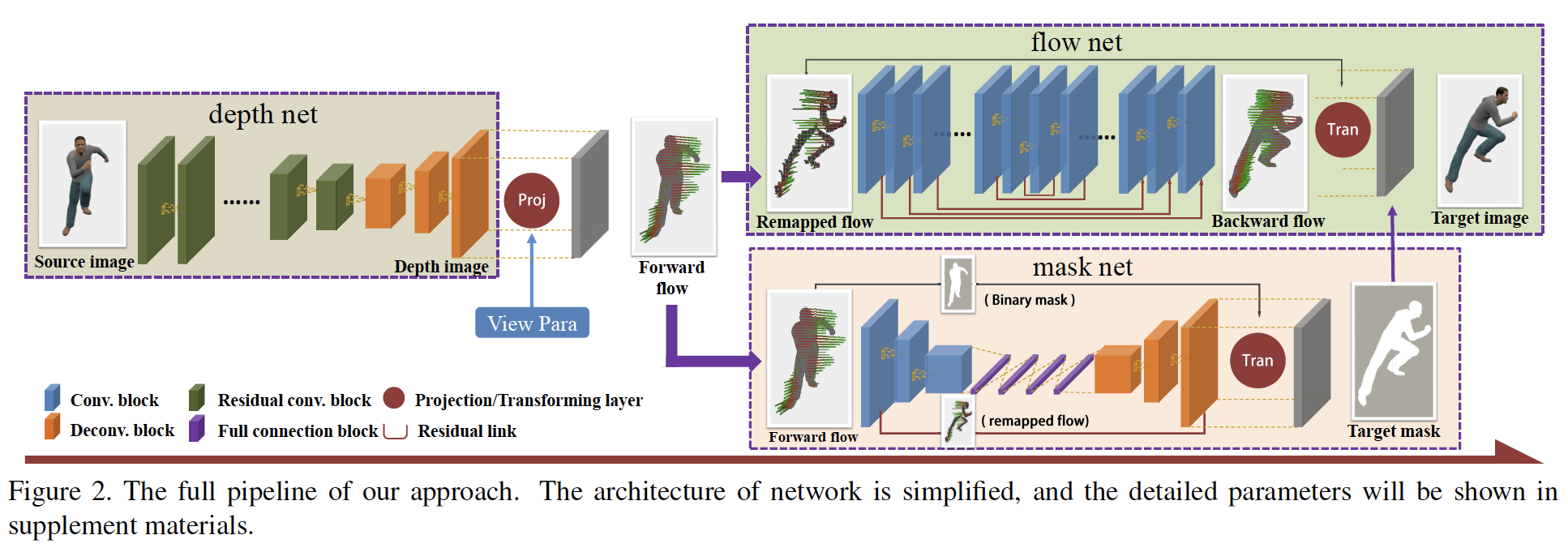

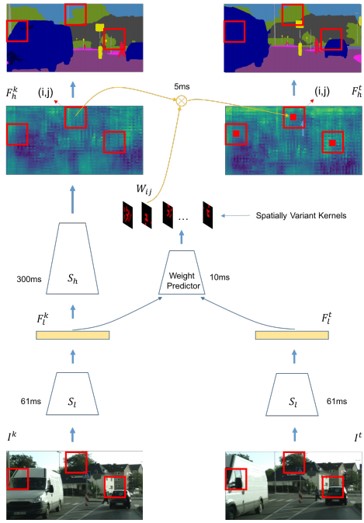

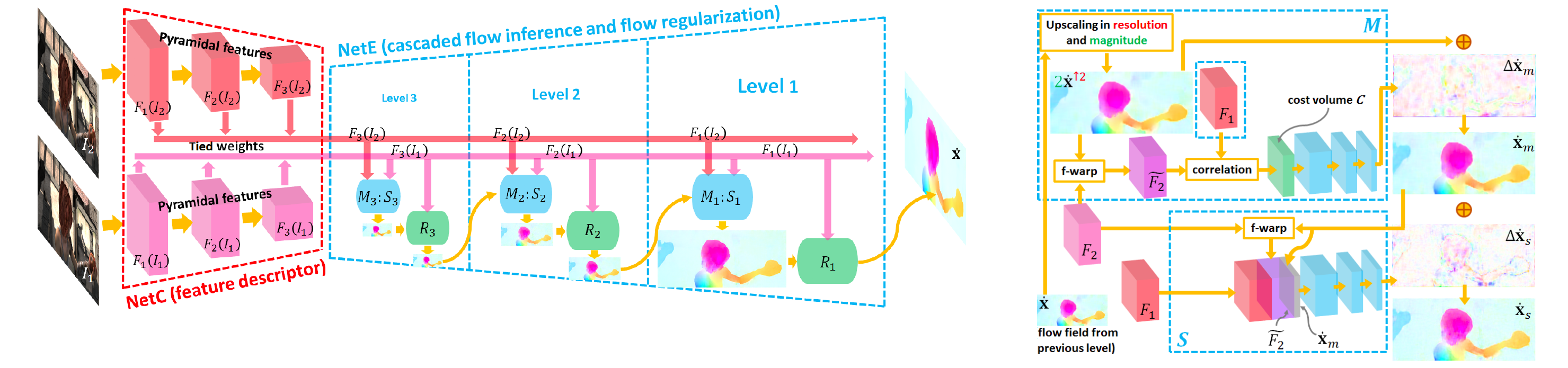

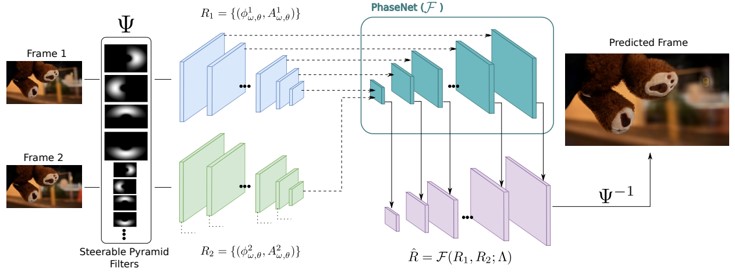

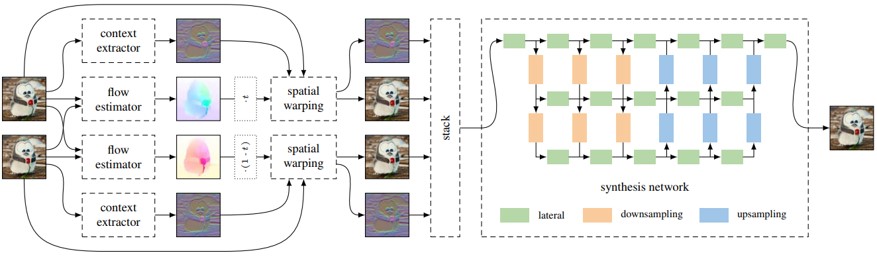

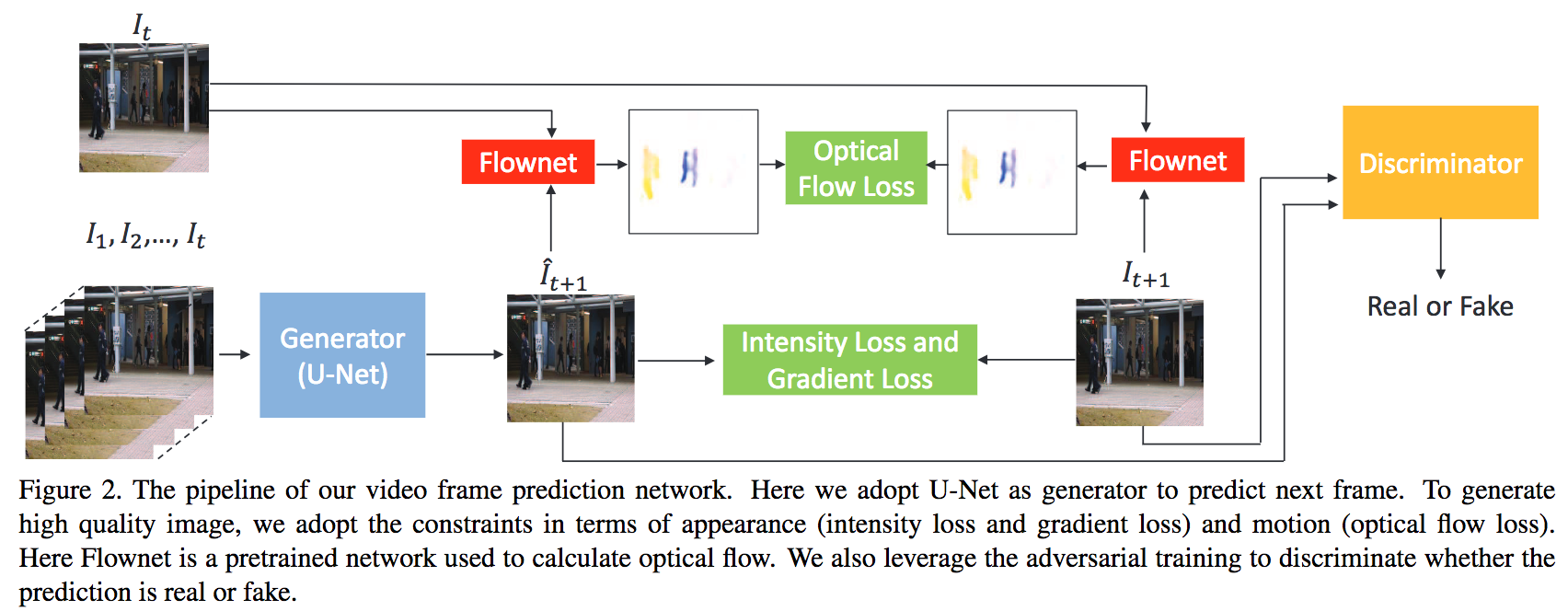

2枚の入力画像の中間フレームを必要な数だけ生成することが可能なend-to-end CNNの提案.双方向のオプティカルフローの推定とそれを元にしたフレーム補間のCNNから成る.モーションの補間とオクルージョン領域の推定を同時にモデル化することができる.これらのCNNは時間情報に依存しないので,間のフレームをいくつも作成することができることが特徴.

2つの入力フレーム間の双方向オプティカルフローの推定をCNNで行い,その2つのオプティカルフロー場から中間のオプティカルフロー場を近似的に求める.フロー補間のCNNでその近似の質をさらに高め,中間補間のためのsoft visibility mapを予測する.双方向オプティカルフローの推定のCNNも,フロー補間のCNNもどちらもU-net構造をしている. それぞれ30万フレームを含む1132本のビデオクリップ(240fps)を使って学習させている.

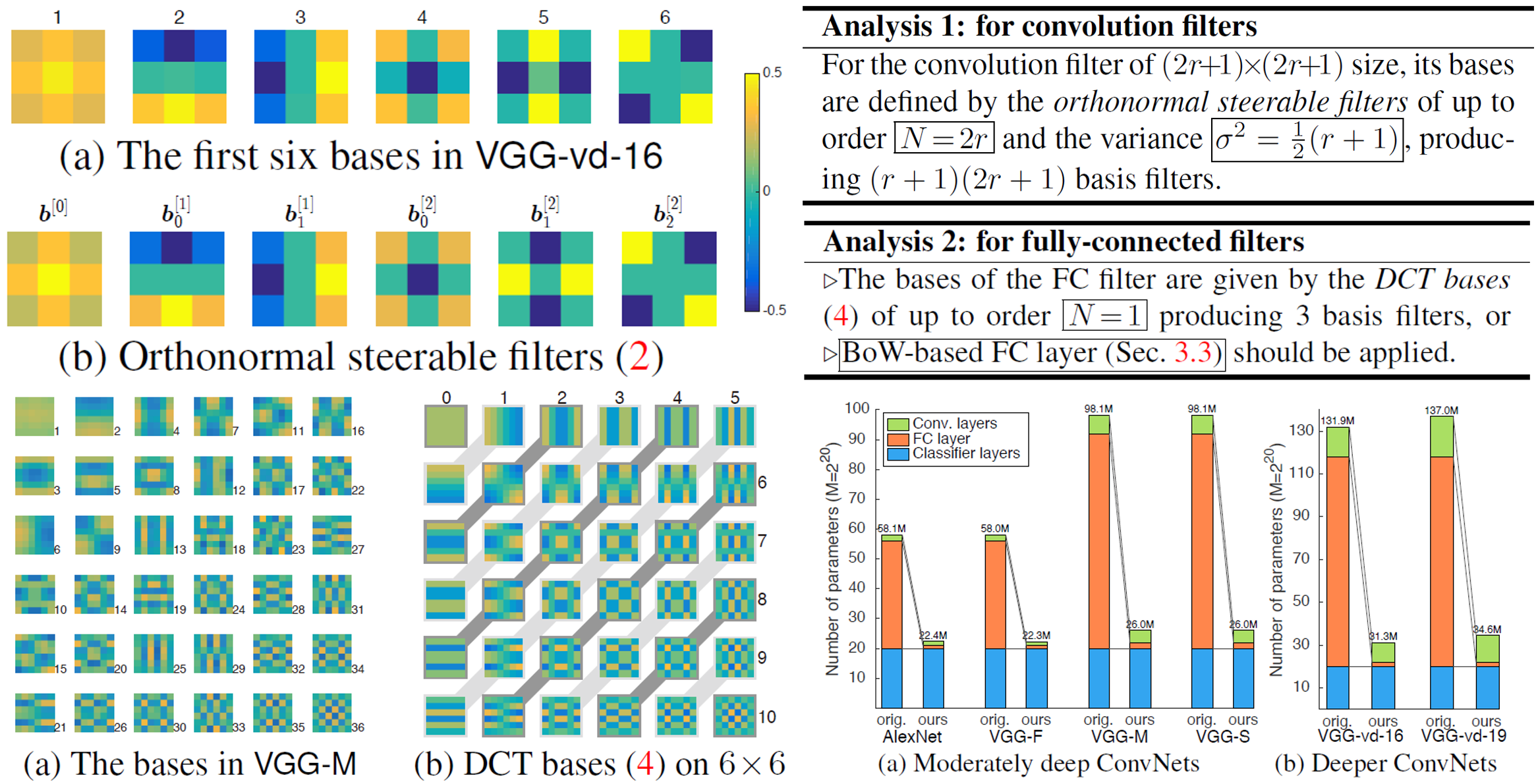

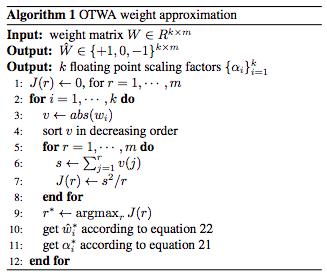

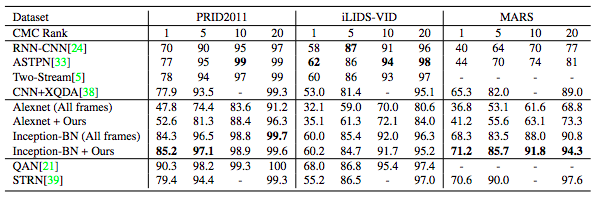

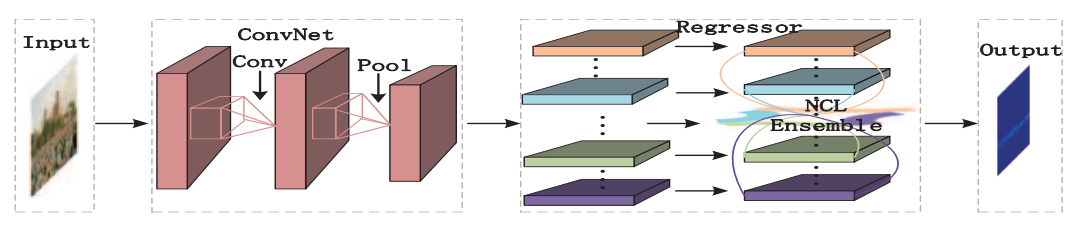

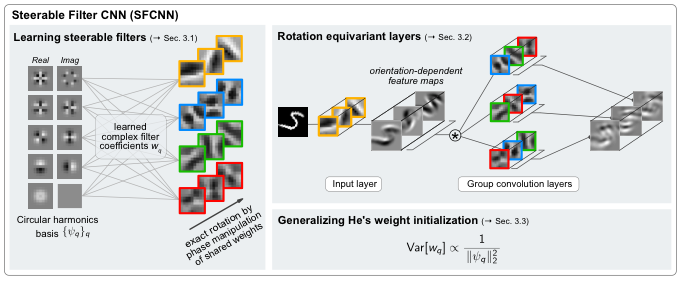

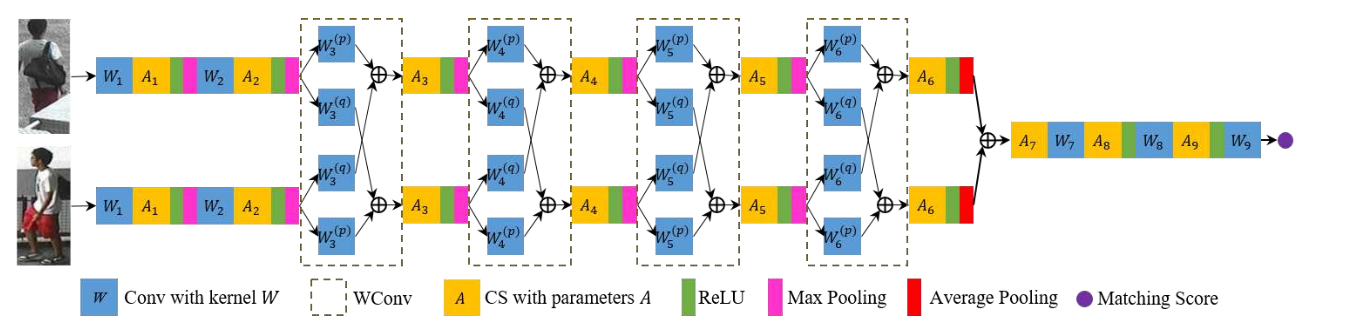

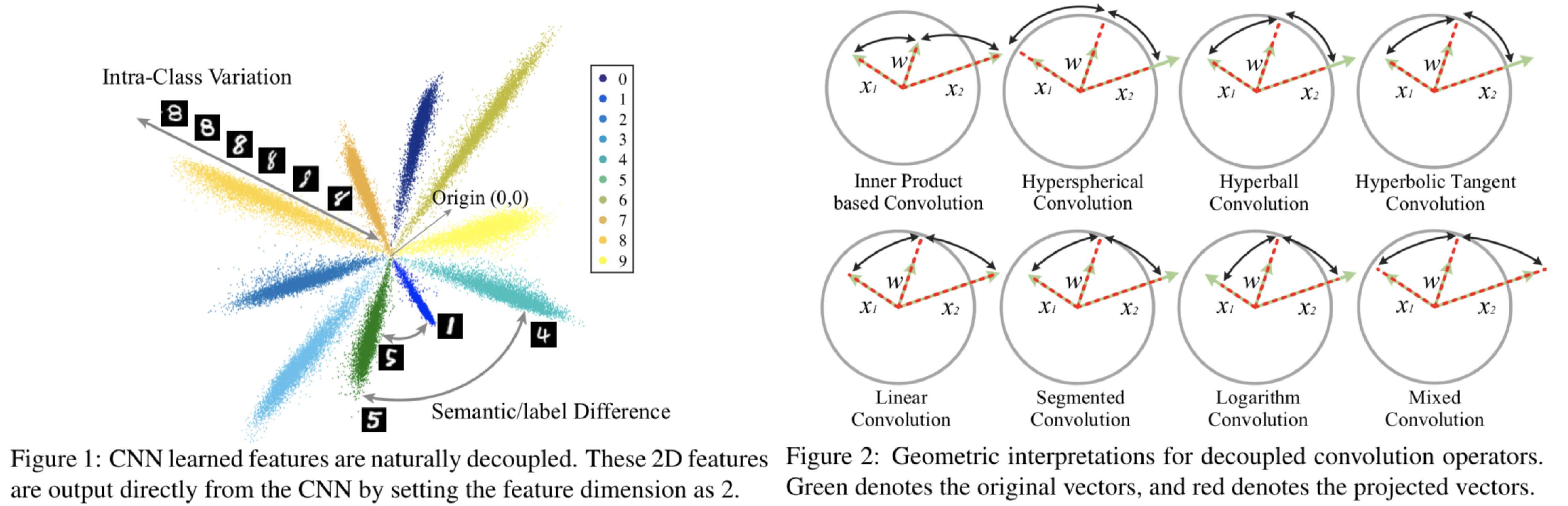

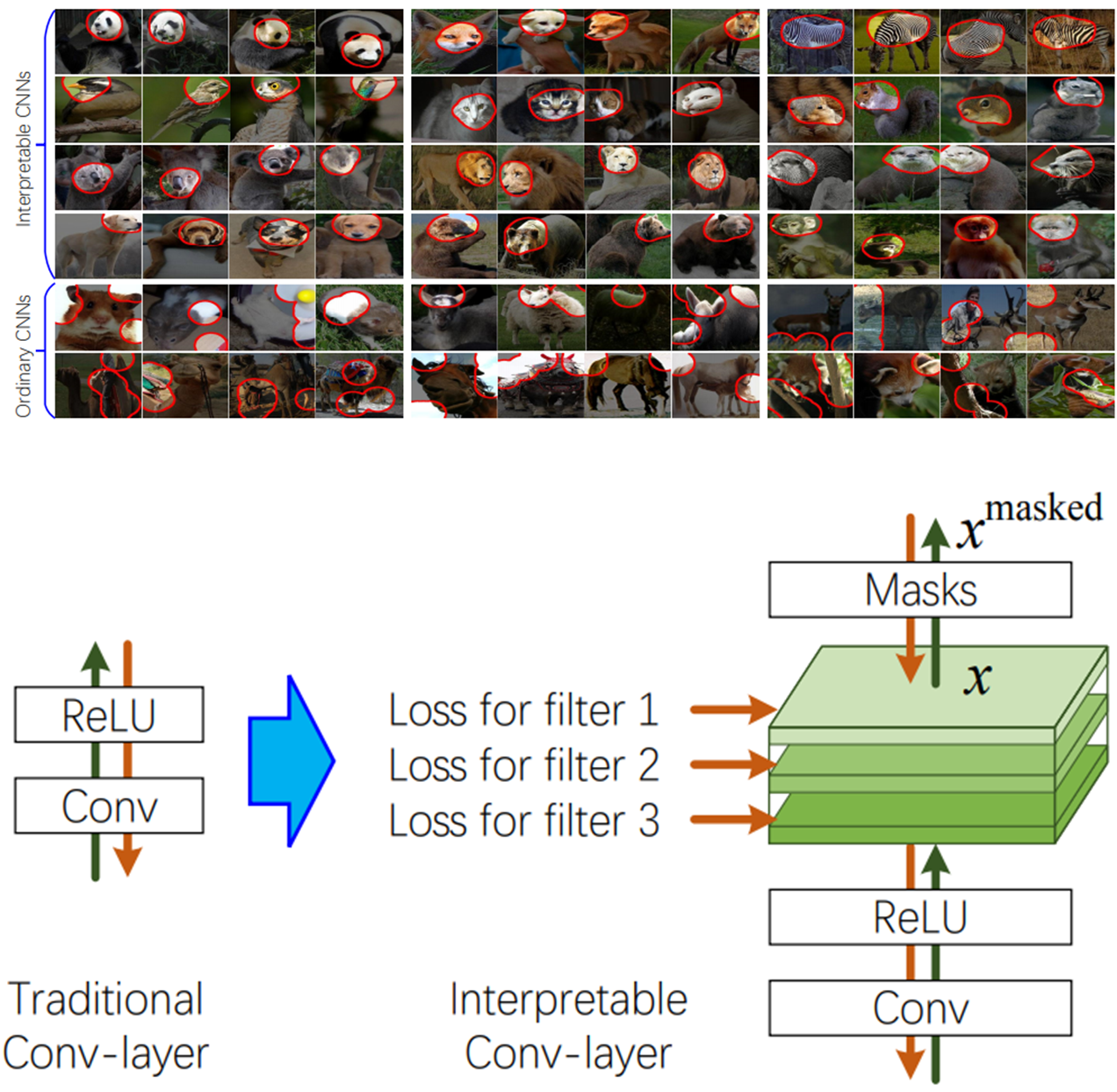

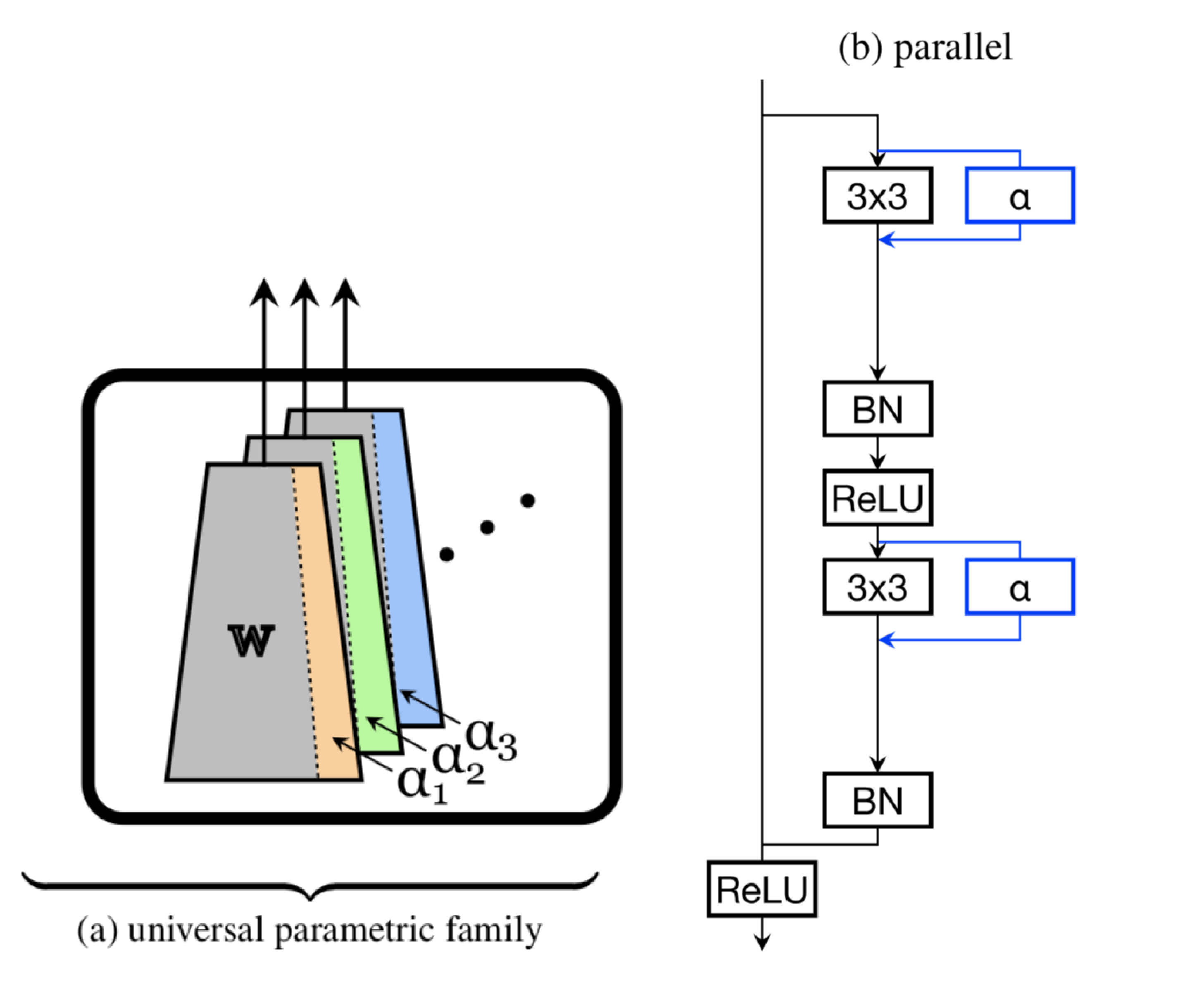

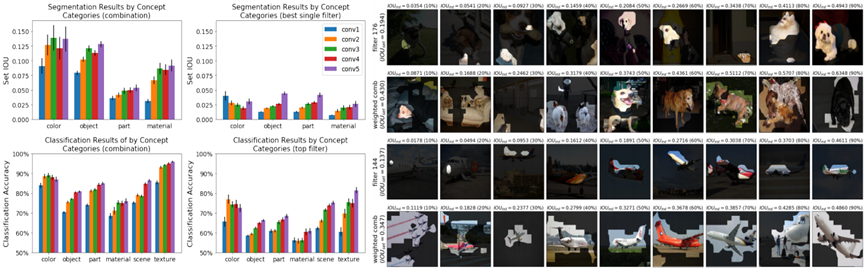

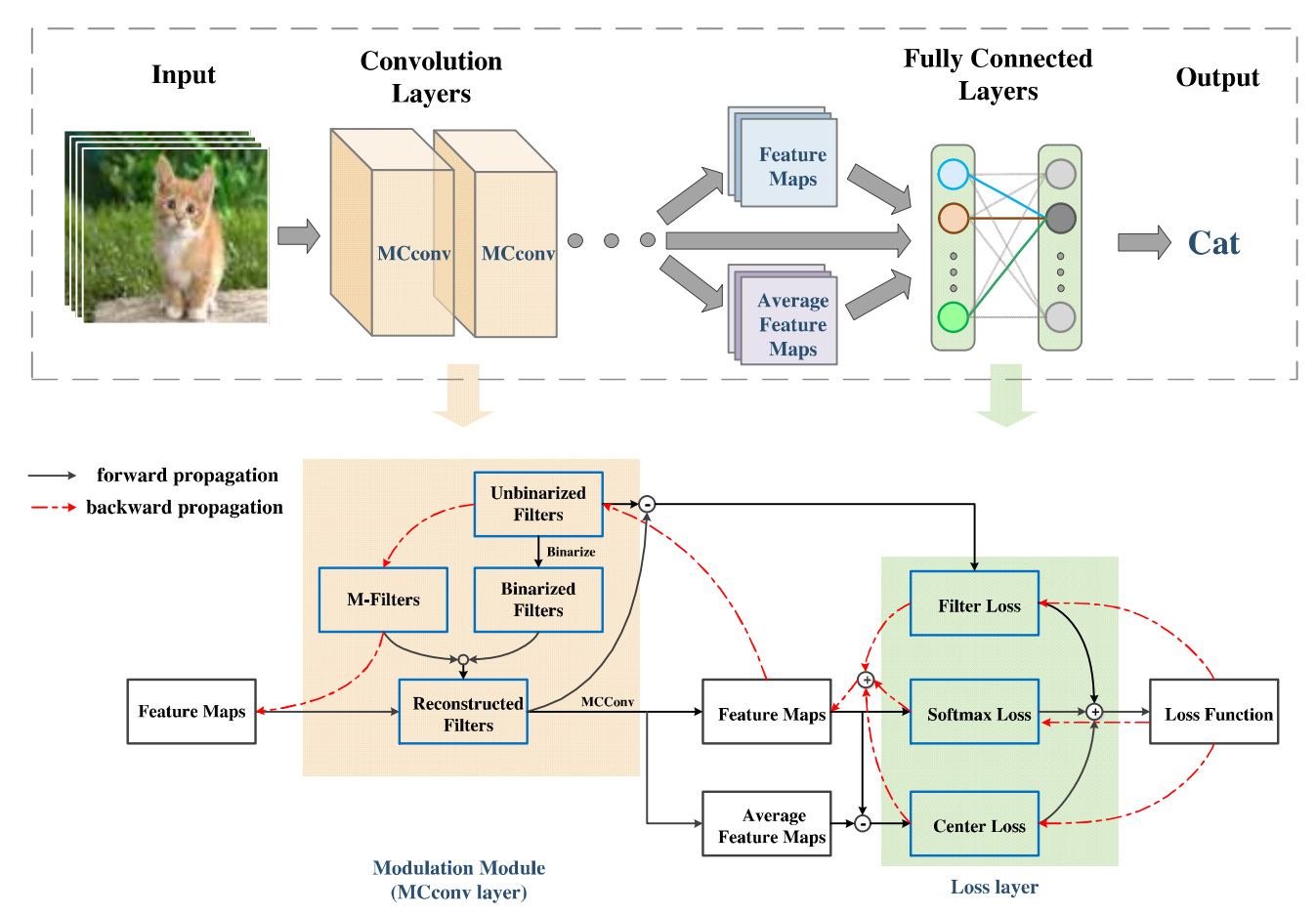

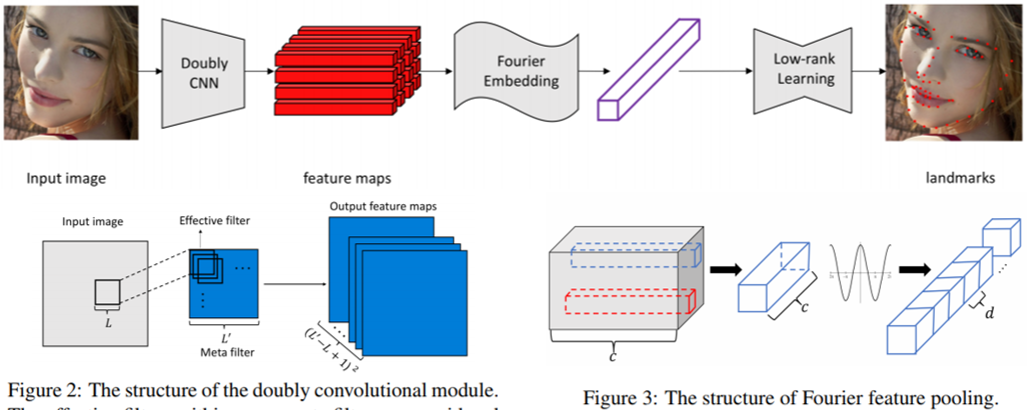

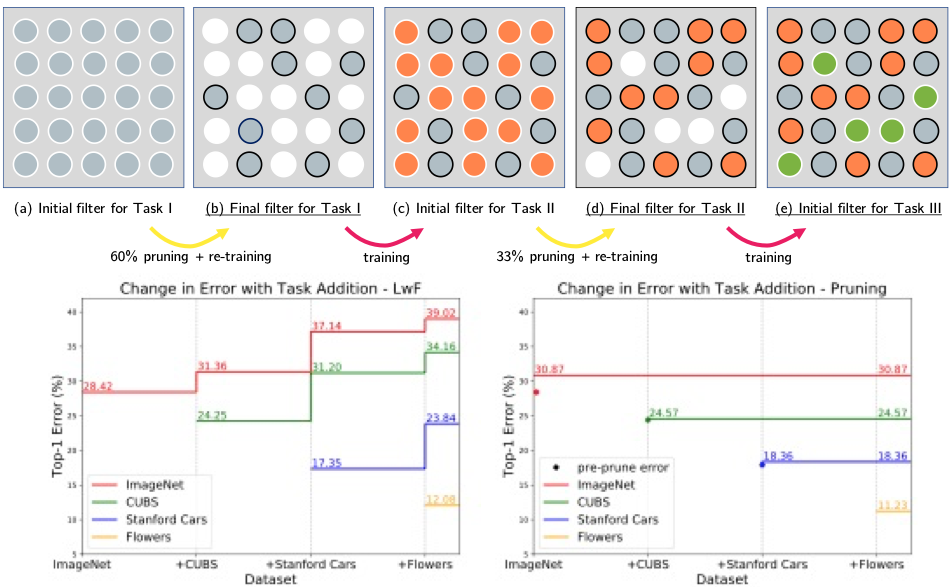

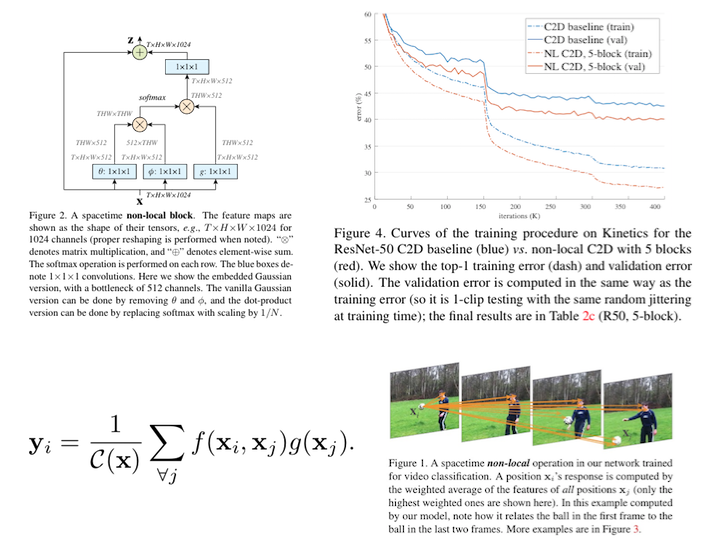

CNNの振る舞いに関する分析は、従来手法のほとんどが入力に対する活性化に対して行っていたのに対して、本論文はフィルタ自体に着目して分析を行った。畳み込み層と全結合層に対して分析を行い、それぞれに対して基底となるフィルタを作ることで、学習に必要なパラメータ数を減らし、また提案手法を適用することでImageNetで学習させたVGG-vd-16の精度を向上させることに成功した。

VGG-vd-16の畳み込み層のフィルタに対してSVDを行い主成分を抽出すると、Orthonormal Steerable Filtersと呼ばれる既存の直交するフィルタと非常に類似したフィルタとなっていることがわかった。同様にVGG-Mの全結合層に対してSVDを行い主成分を抽出すると、離散コサイン変換の基底関数と類似していることがわかった。したがって、これらの基底関数の線形和で畳み込み層のフィルタや全結合層の重みが決定できるとすると、従来のおよそ半分の学習パラメータ数に抑えることができる。

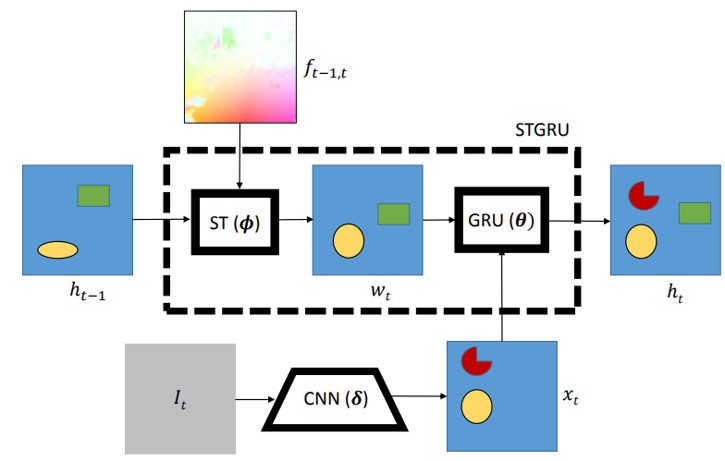

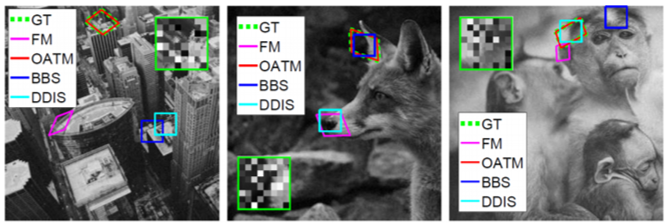

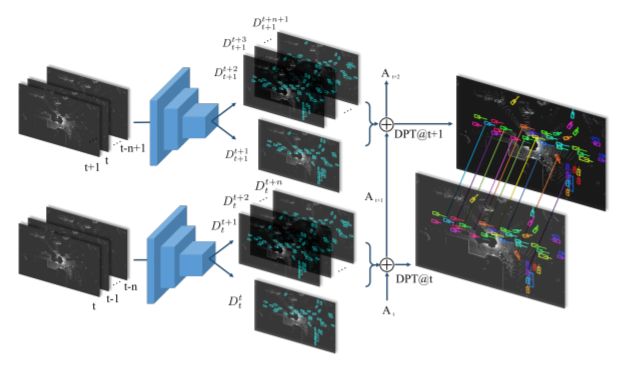

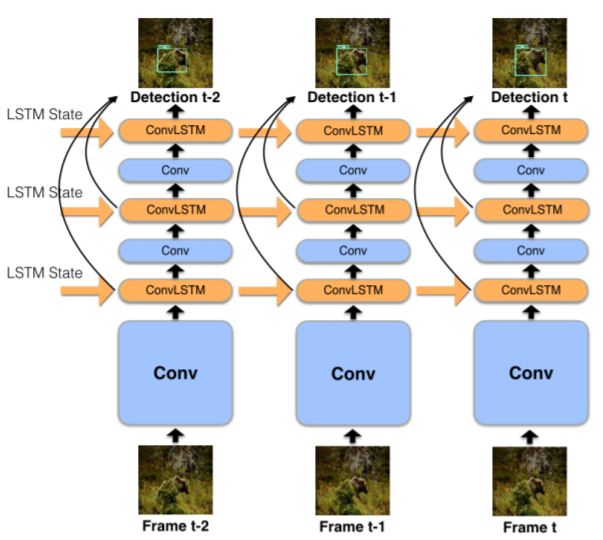

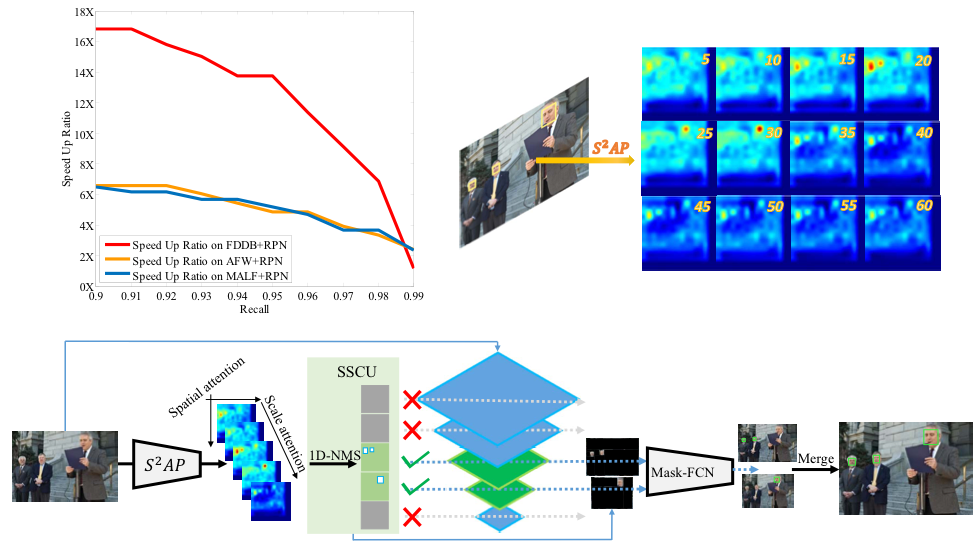

本論文は複数の異なる種類の特徴量を効率的に利用するため、DCFを使った複数のexpertを構築し、各フレームごとに適切なexpertを選択することで頑健な物体追跡手法(MCCT:Multi-Cue Correlation filter based Tracking)を提案した。深層学習から得た特徴量を用いた場合においてSoTAを達成し、従来のHandcraftedな特徴量を用いた場合において、最新の深層学習ベースの手法と同等の精度かつCPUで45fpsの速度を実現した。

![]()

HCFがfeature-levelの統合のみを考慮していたのに対して、MCCTはそれぞれ得られた特徴量の強みを効率よく利用するために、decision-levelの統合も考慮する。MCCTはそれぞれの特徴量が分散を持った異なる視点の特徴量を抽出するようにし、また複数のexpertを各フレームごとに評価し選択することで、良い推定結果を得る。expertの評価にはpair-evaluationとself-evaluationを提案し、これらを統合する過程がdecision-levelの統合に当たる。

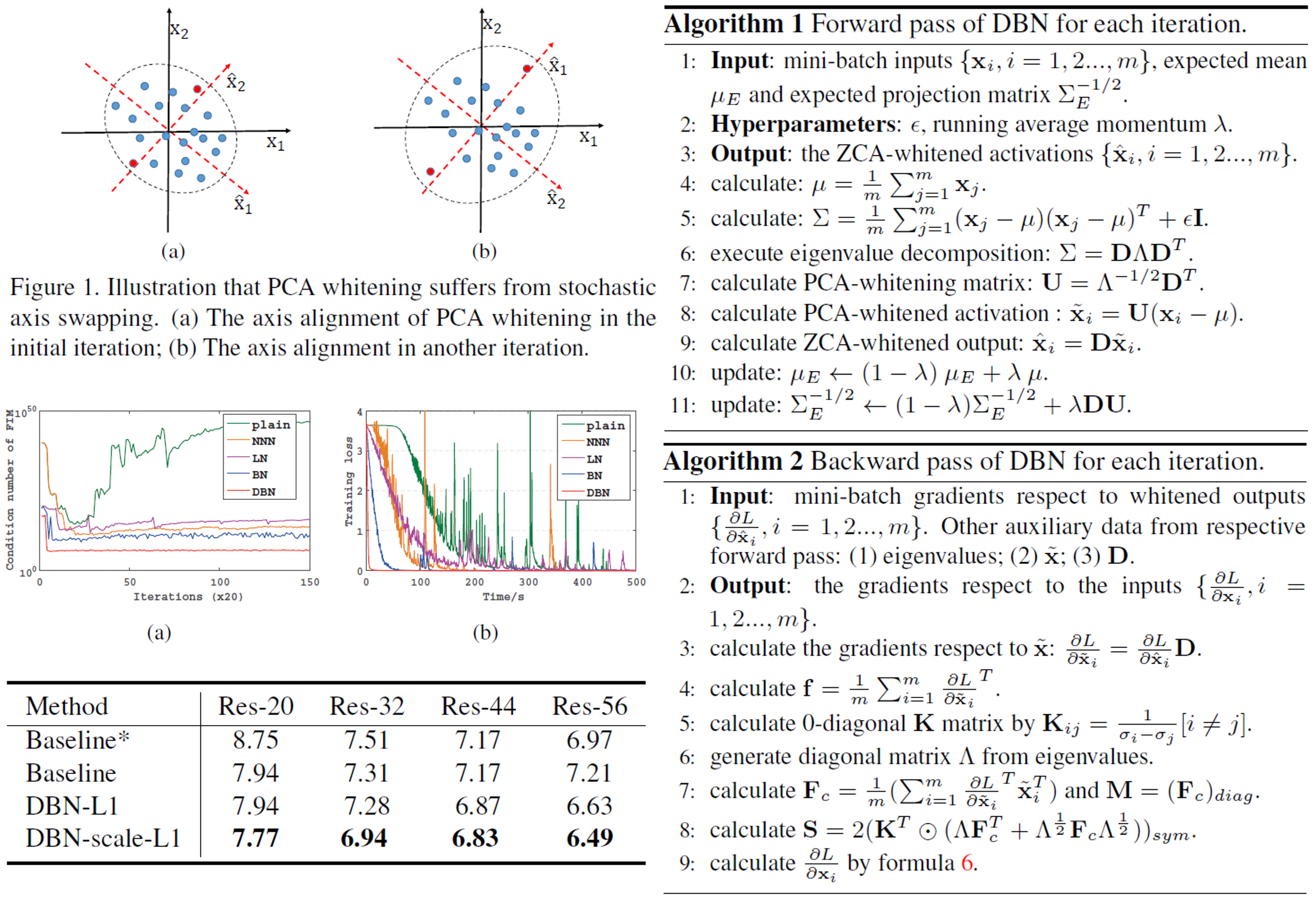

本論文は、Batch Normalizationに白色化を導入したDecorrelated Batch Normalizationを提案した。通常のBatch Normalizationは標準化を行っているが、白色化を行っていない。したがって、白色化を導入することにより、Batch Normalizationよりさらに早く学習を収束させることが可能になった。

PCAを用いた白色化を行うとstochastic axis swappingという問題が発生する。データxが与えられたとき、それに対する正規直交基底をDとすると、異なるイテレーションから得られたデータx1とx2に対する正規直交基底D1とD2において、D1=D2とならない現象のことをいう。この現象を避けるため、Decorrelated Batch NormalizationではZCAを用いた白色化を行う。

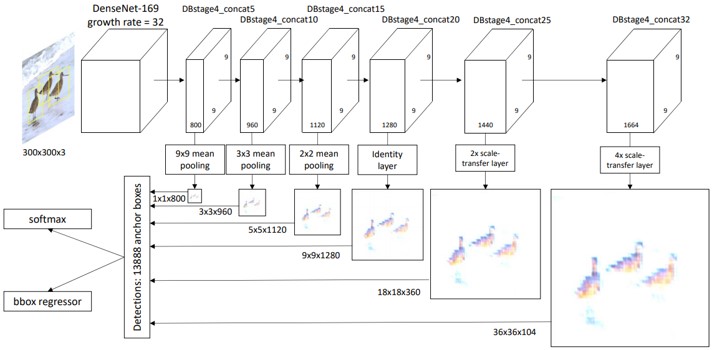

空中画像(aerial image)からオートマッピングするRoadTracerを提案.従来のセグメンテーション手法ではノイジーなCNNの出力では正確なマッピングが難しいことから高いエラーレートの問題があることを述べている. 提案手法ではセグメンテーション手法ではなく, CNNを使った決定関数による探索アルゴリズムで道路をマッピングする. 探索はよく知られている道(大きい道?)のある一ヶ所をスタートポイントとして道に沿って探索していき,各ステップごとにCNNによってネットワークにエッジを追加するか1つ前のツリーに戻るか選択を繰り返しさせて探索していく. 提案手法によりセグメンテーション手法より分岐点などにおいて正しくマッピングできるようになり, DeepRoadMapperやセグメンテーション手法より精度が上昇した.

15都市の空中画像を用いて実験した結果,DeepRoadMapperでは21%,セグメンテーション手法では58%正しく道をキャプチャできた一方,RoadTracerは72%正しくキャプチャできた.また,エラー率を5%に抑え,都市に存在する分岐点の45%以上をキャプチャすることが可能となった.

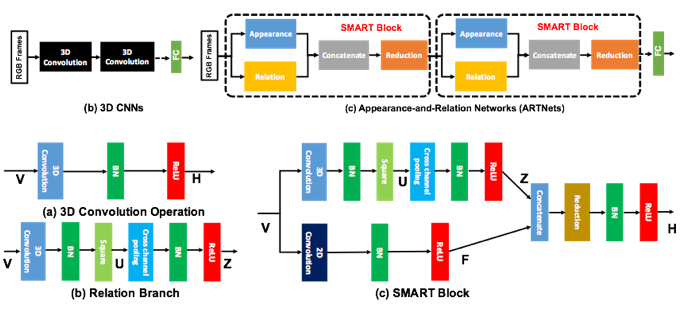

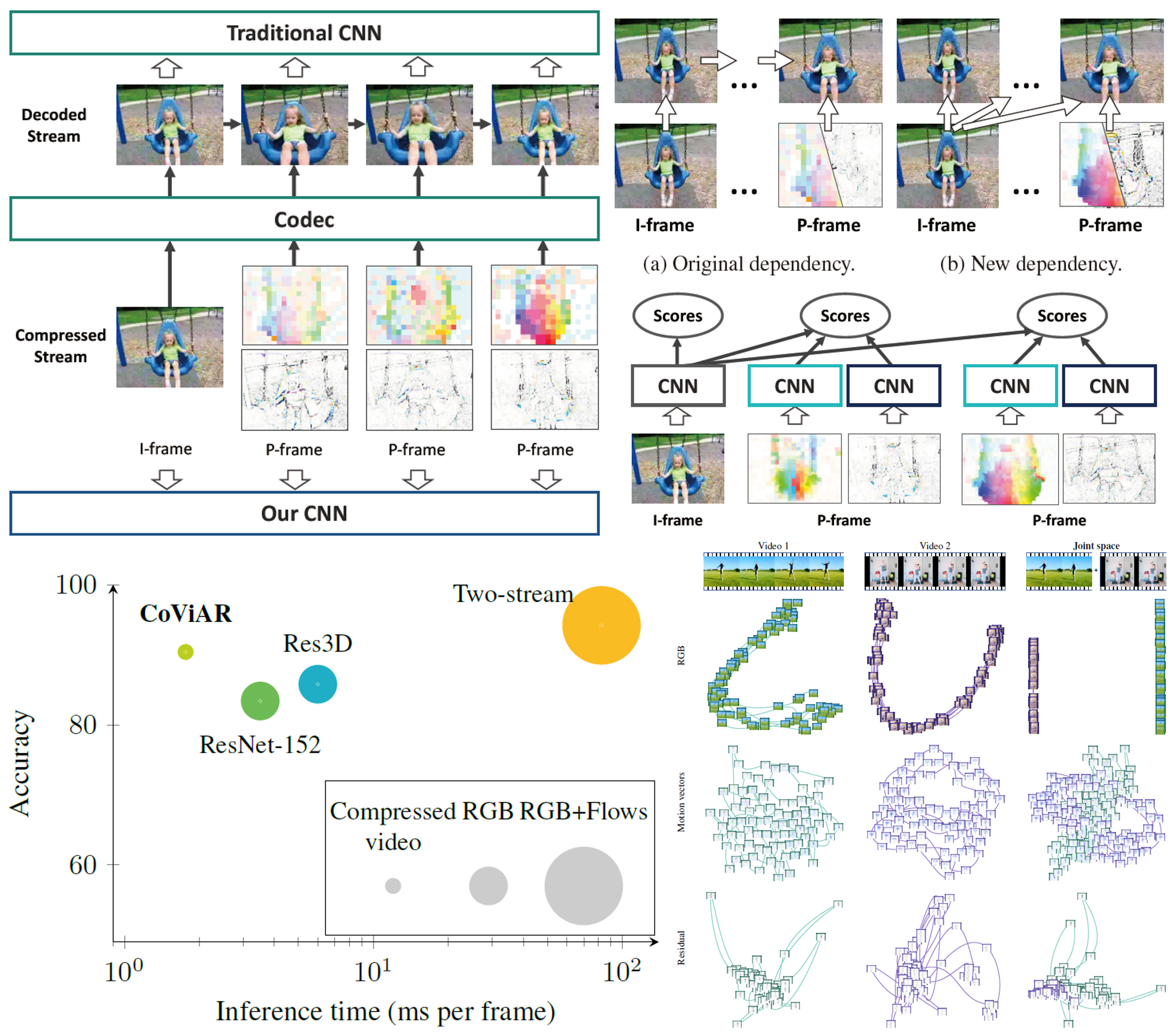

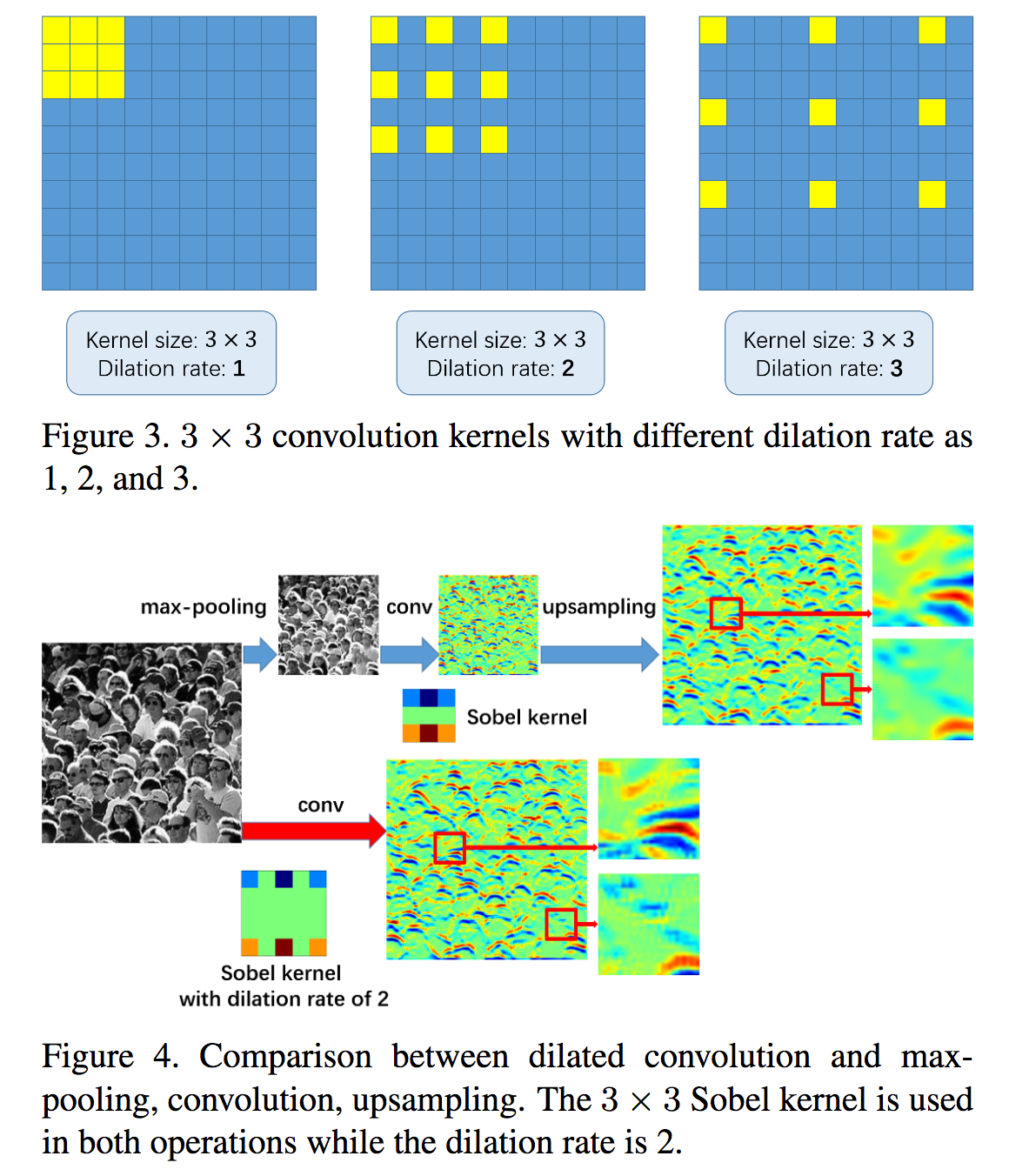

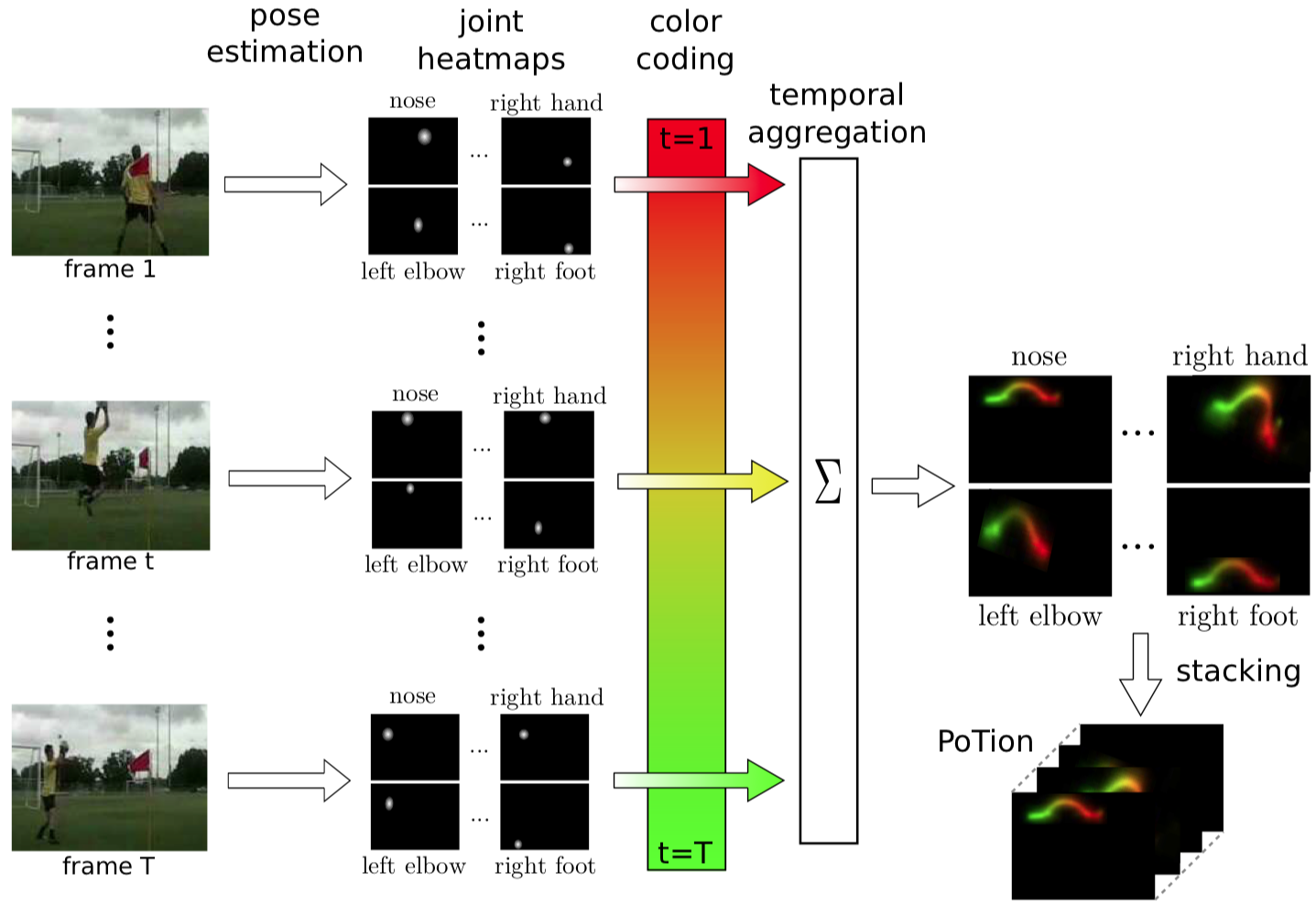

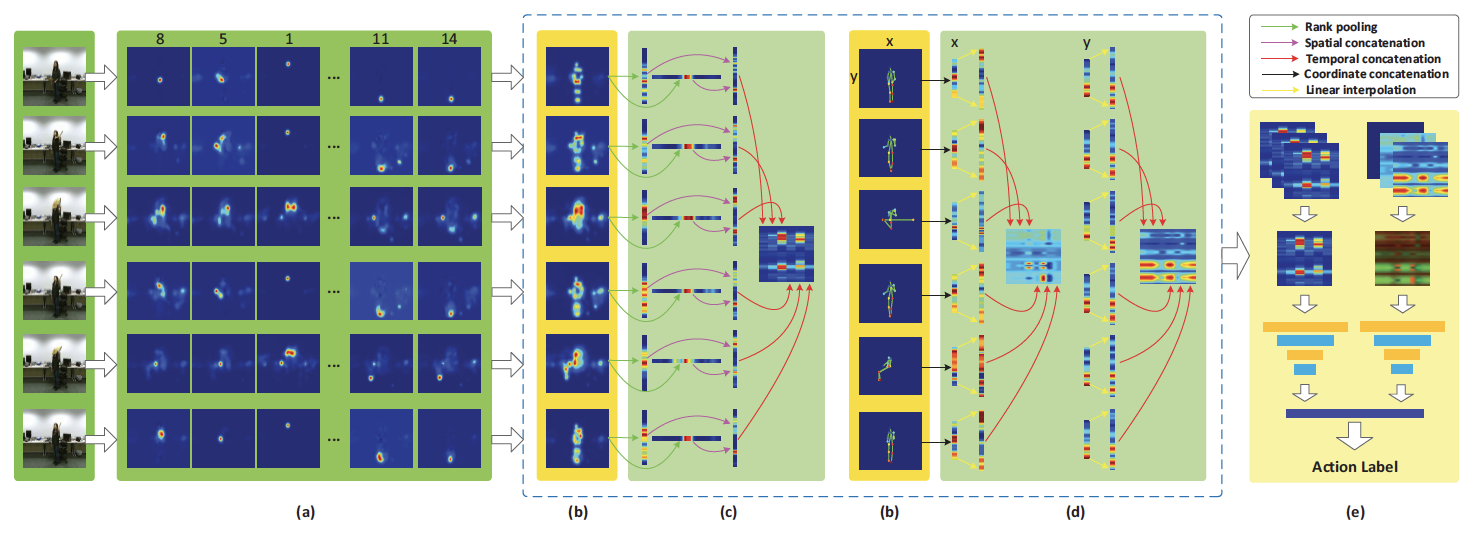

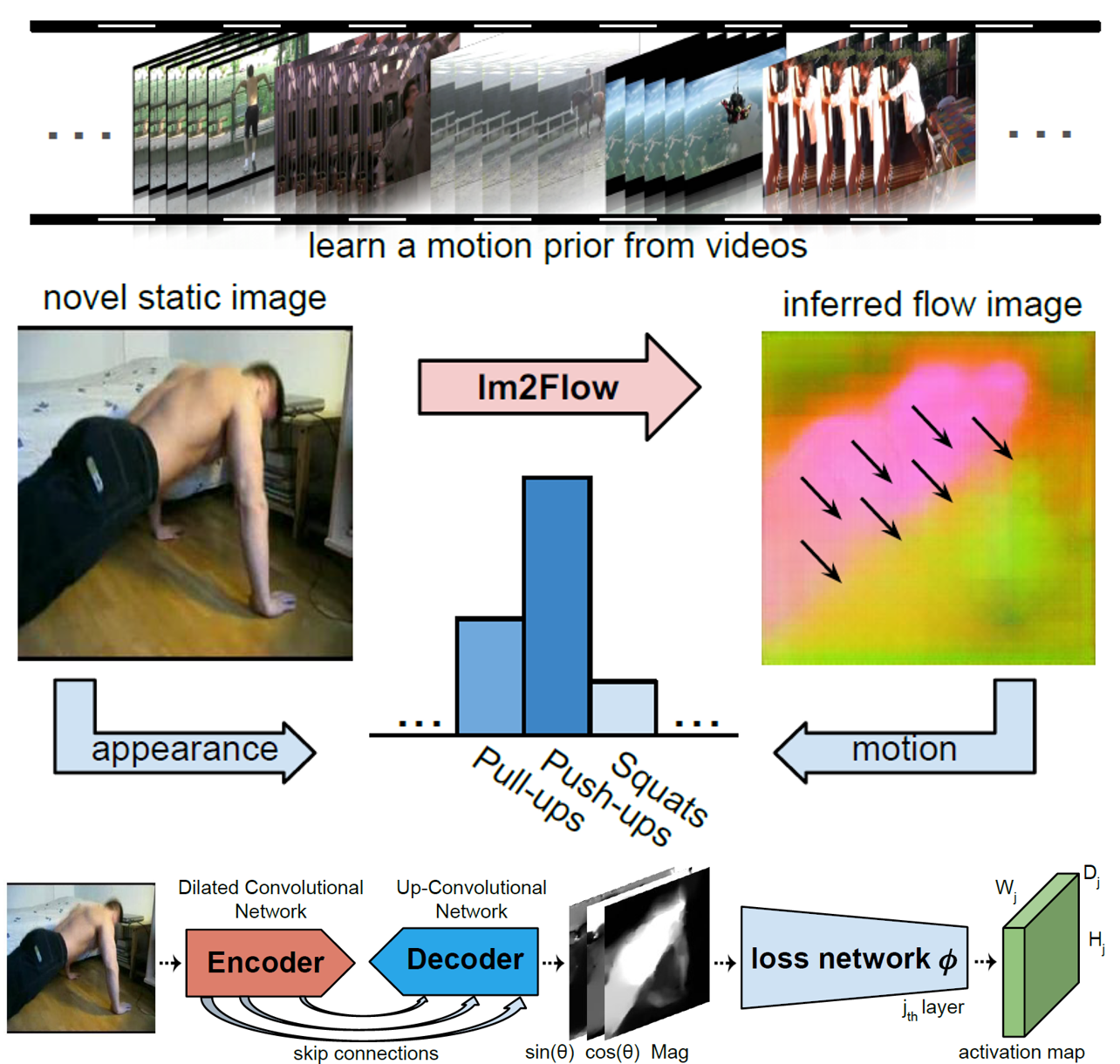

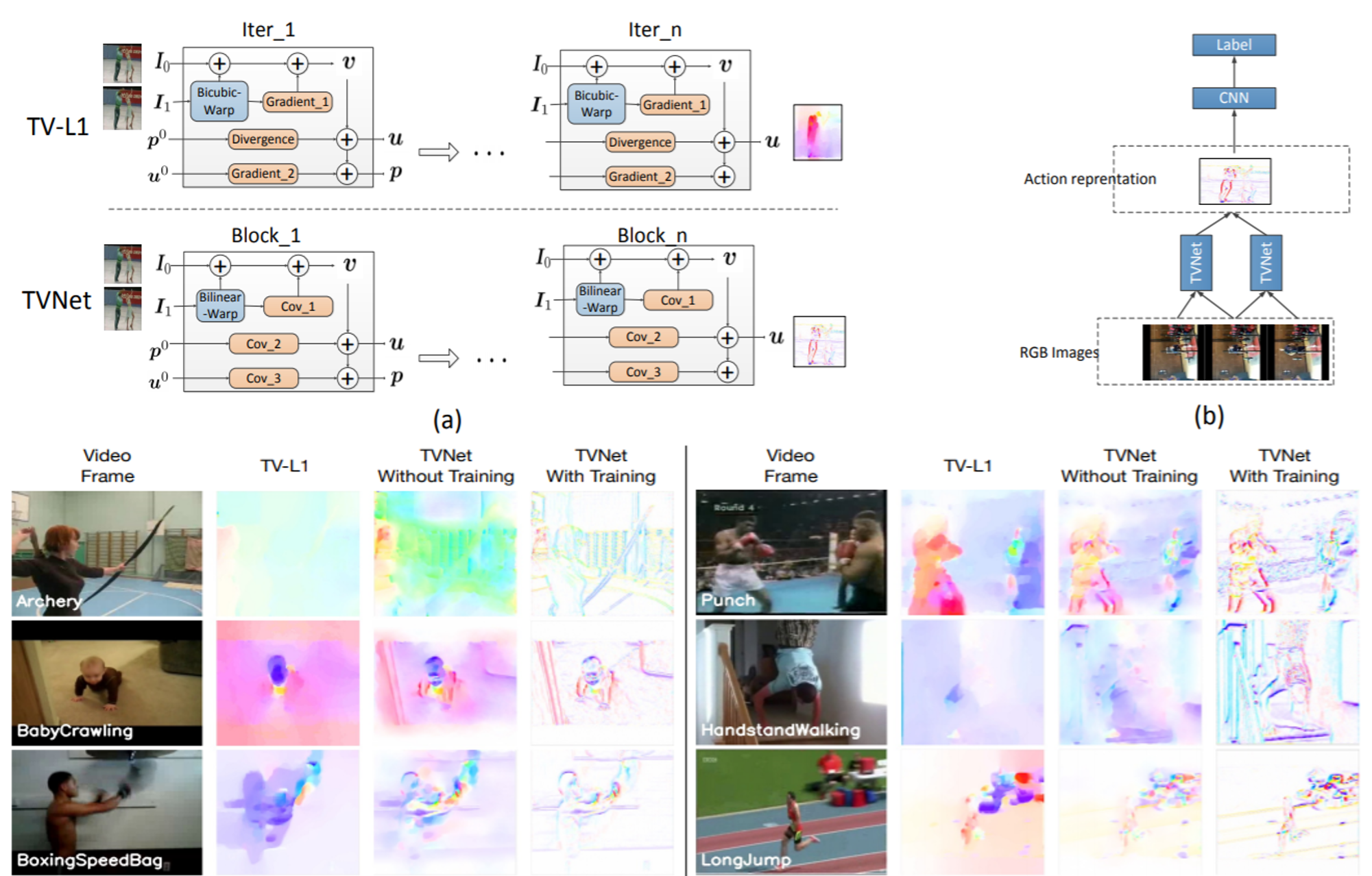

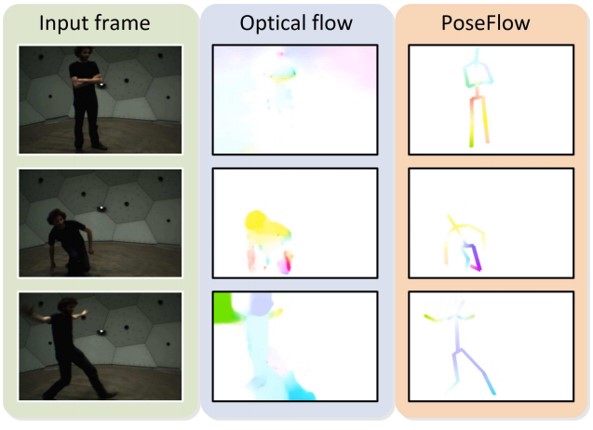

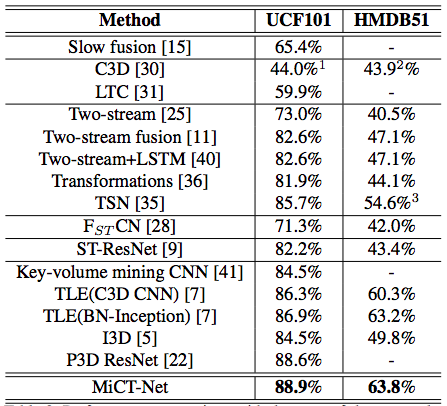

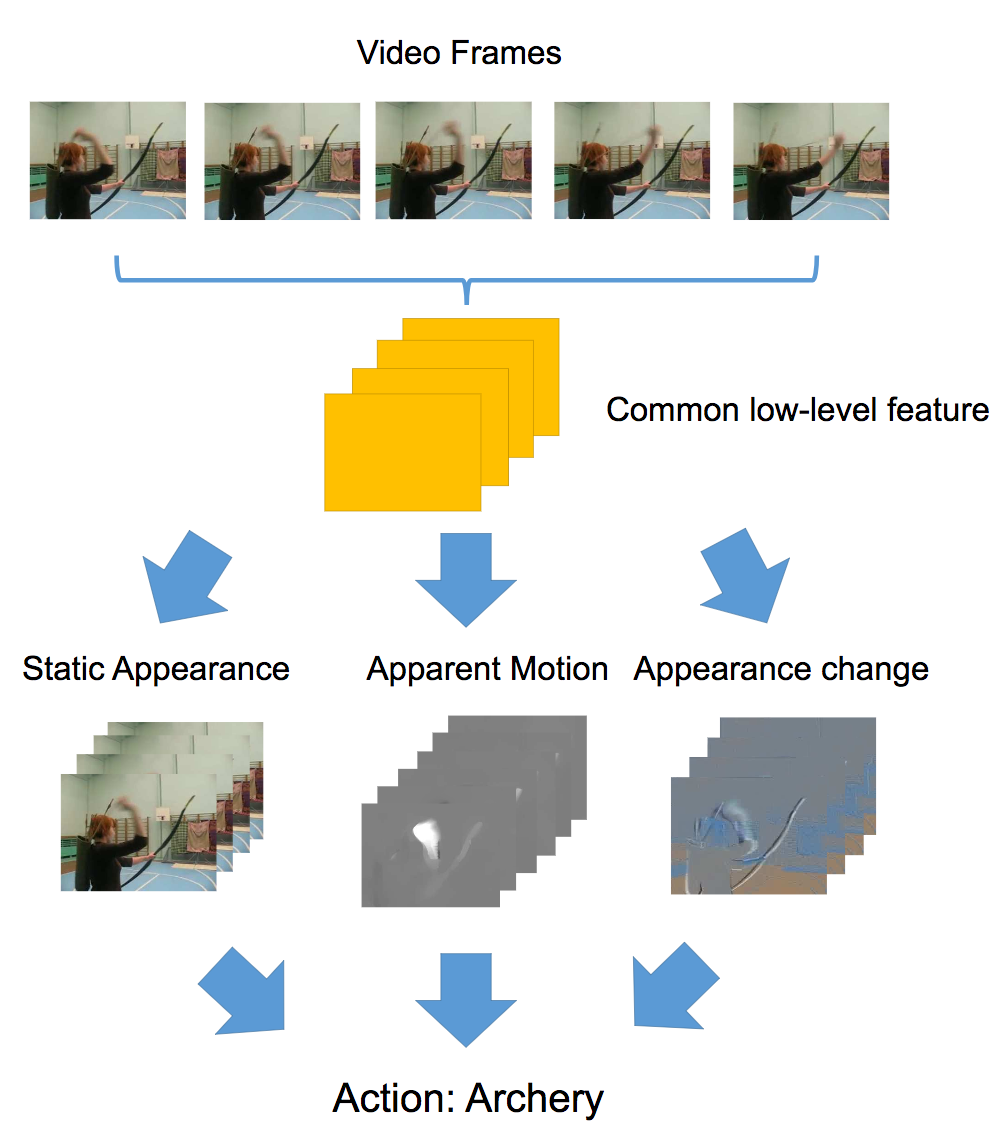

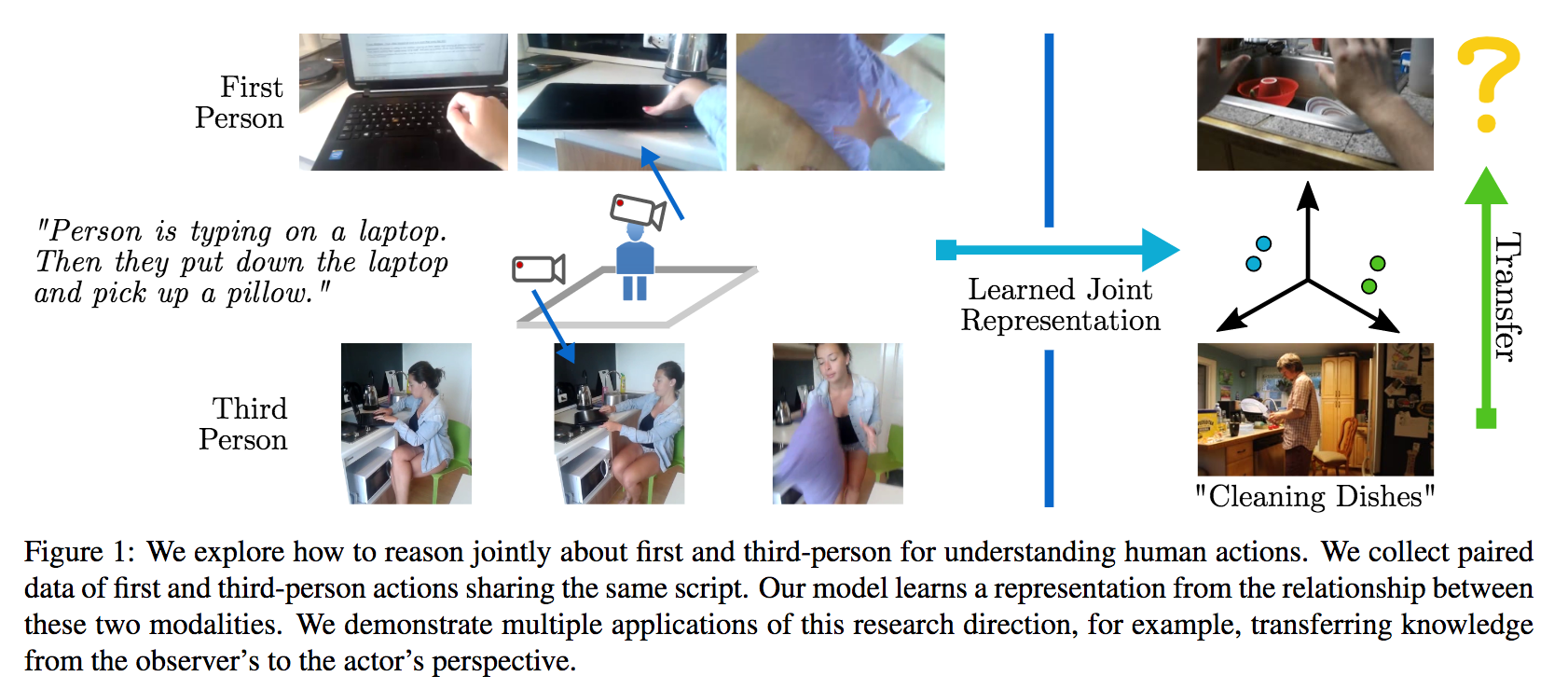

Optical Flow guided Feature(OFF)という動画の行動認識のための運動表現を提案.OFFはオプティカルフローの定義を基に導出され,オプティカルフローに直交している.deepな特徴マップのピクセル単位の時空勾配を計算することで,わずかな追加コストで既存のCNNベースの動画行動認識のフレームワークに埋め込むことができ,CNNの時空情報を抜き取ることが可能になった.

・速くロバストな動作表現であり,RGBのみの入力で200fps以上の速度が出る・OFFを使用したネットワークはend-to-endで訓練させることができる ・UTF-101においてRGB入力のみのOFFを含んだネットワークで93.3%,SoTAな動画認識のフレームワークに埋め込むことで96.0%の精度を達成

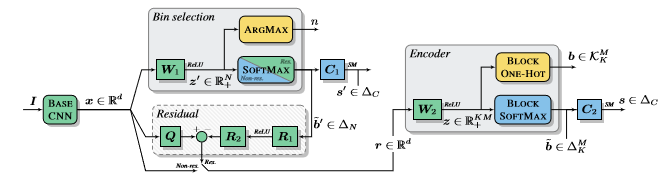

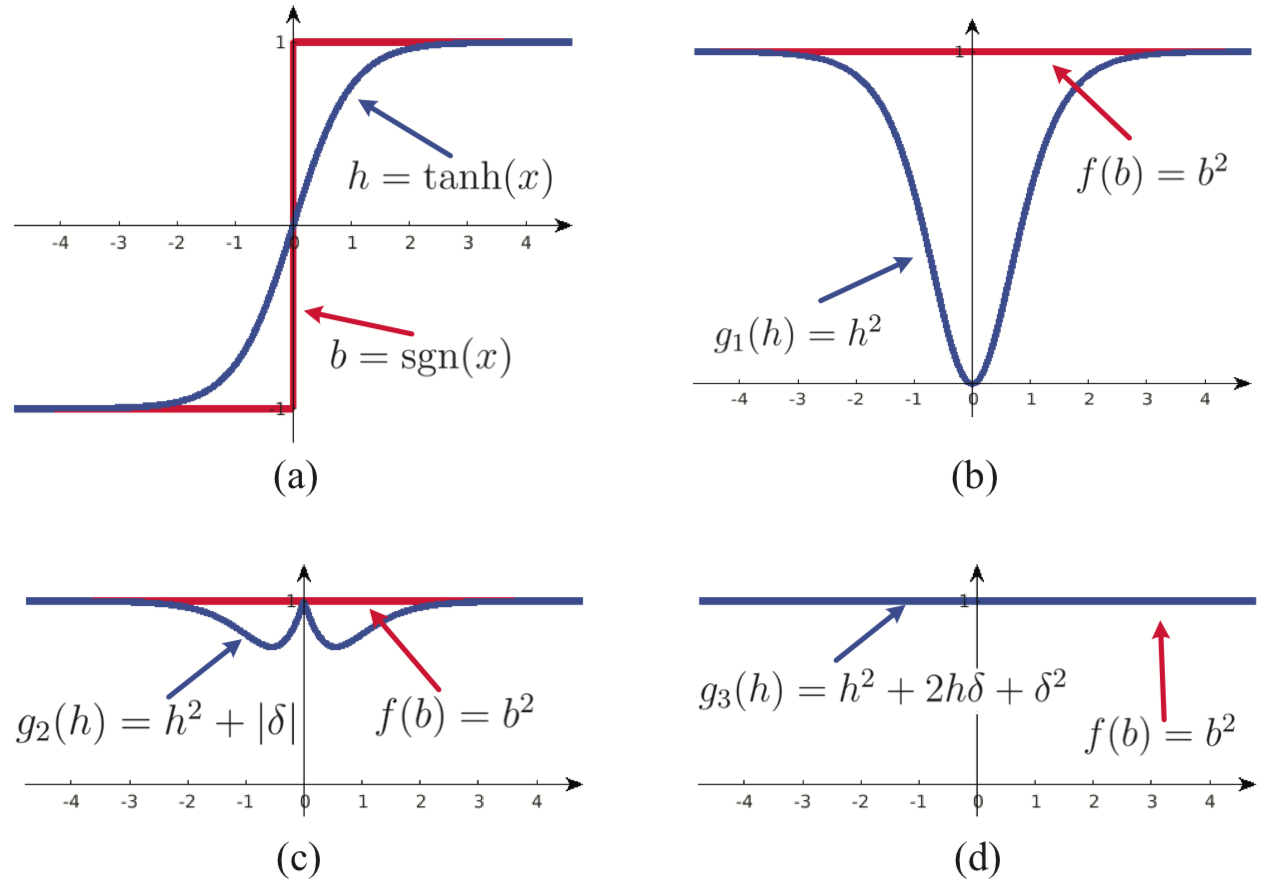

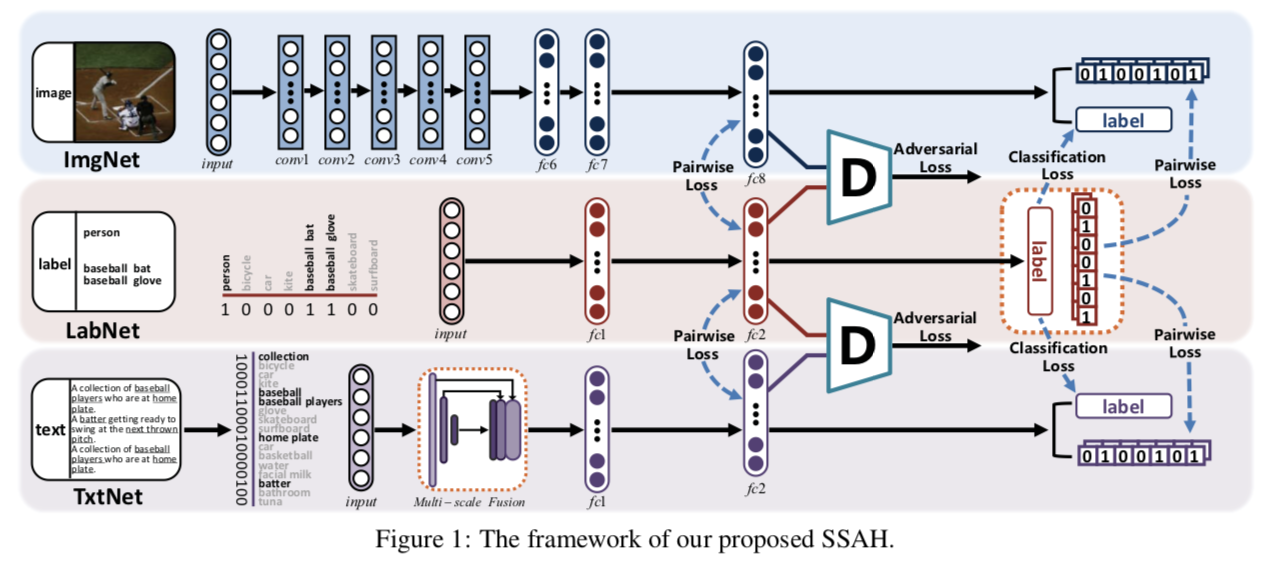

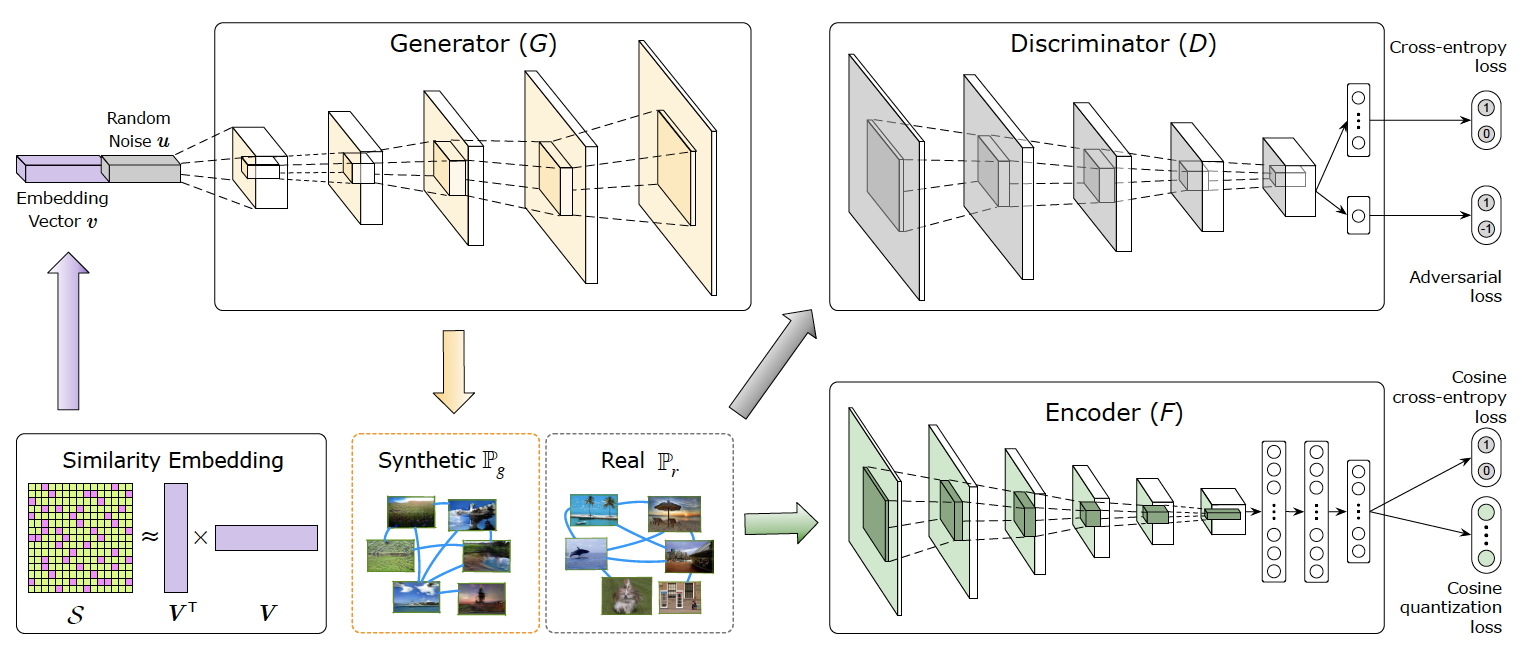

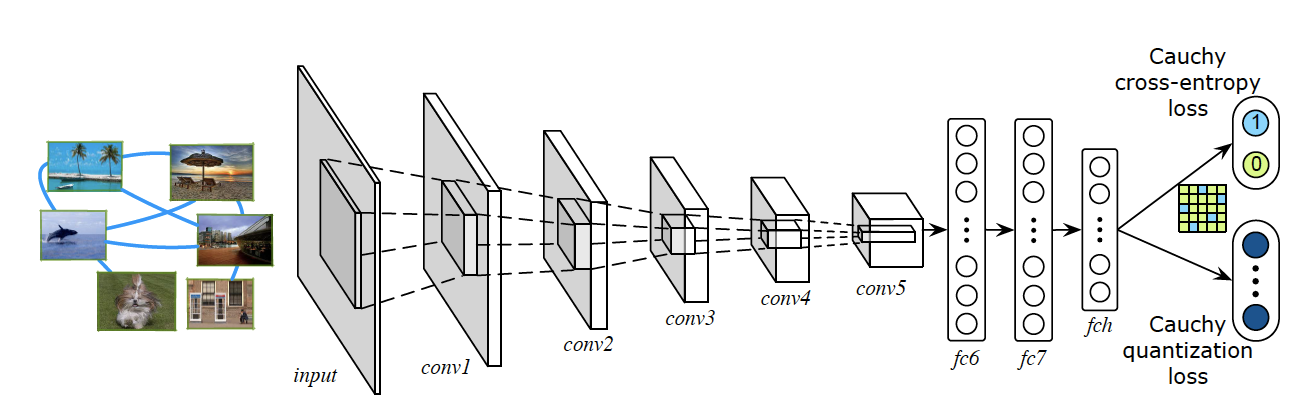

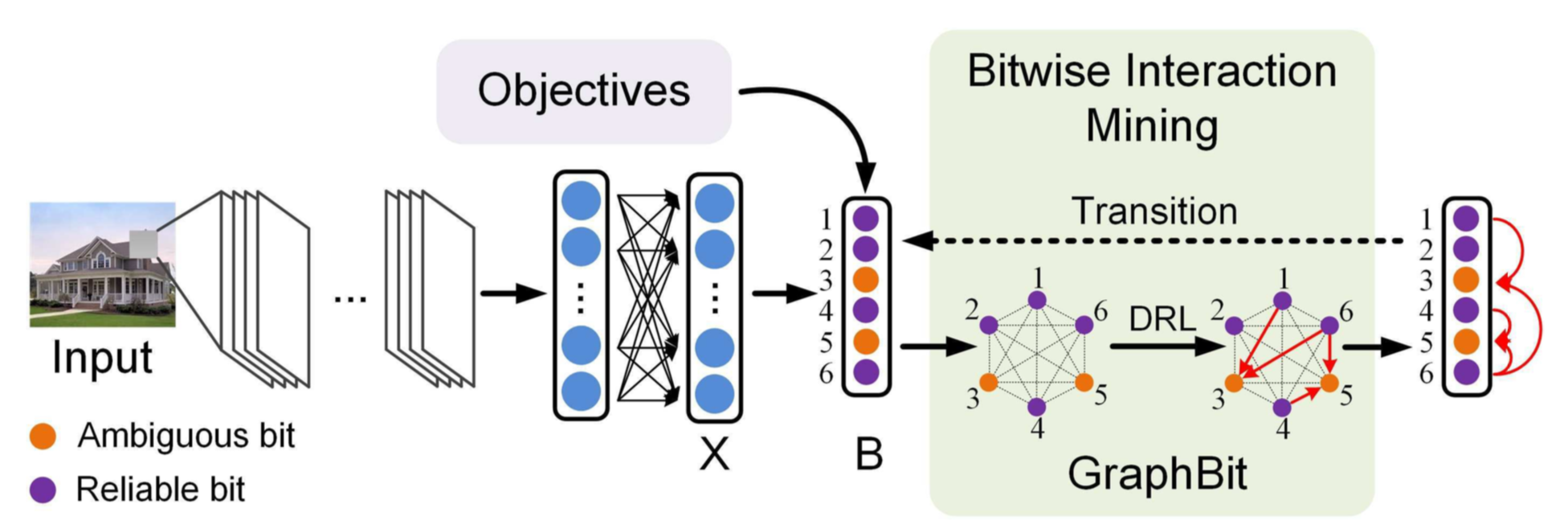

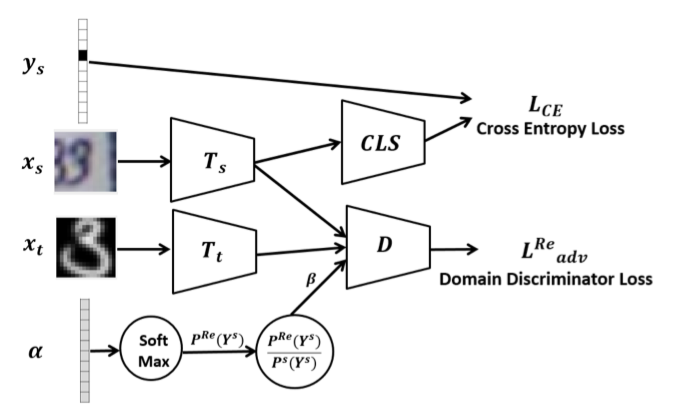

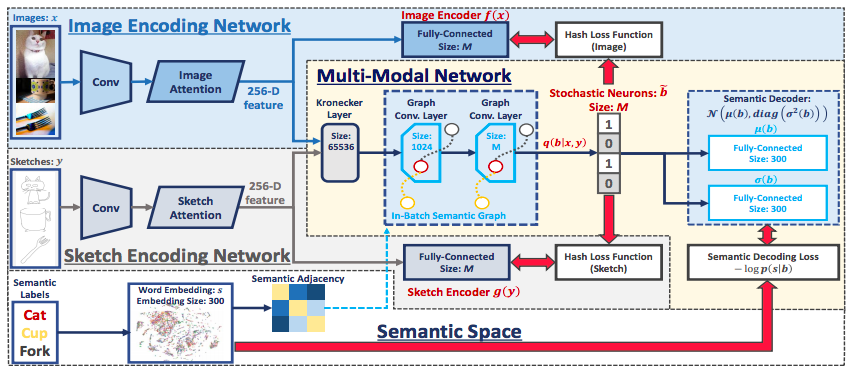

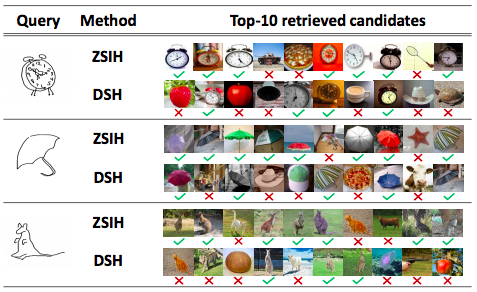

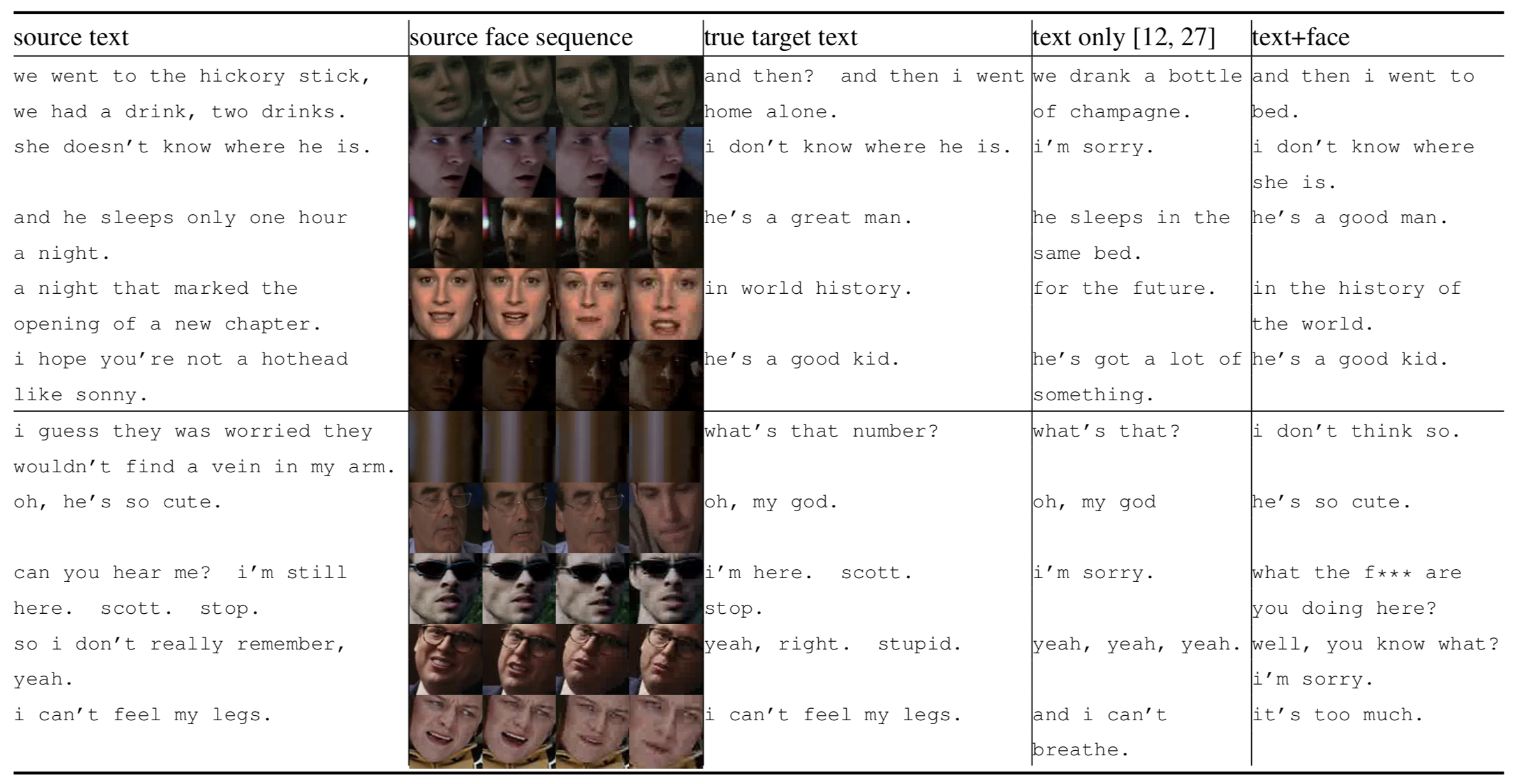

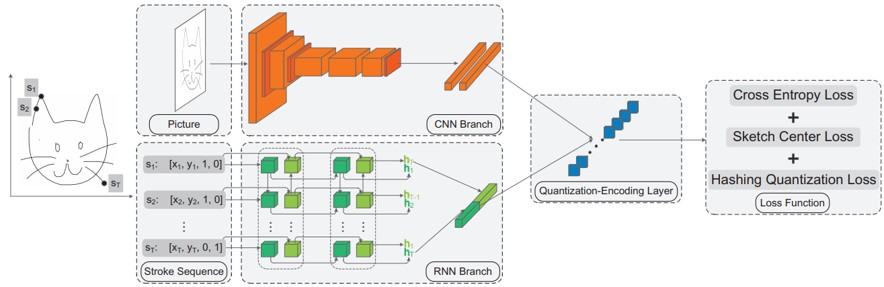

構造化されたバイナリエンコーディングの統一的なニューラルフレームワーク内の両方のコンポーネントを学習する1番目のシステムを提案する.

反転されたファイルおよびコンパクトな特徴エンコーダを構築するために教師ありディープラーニング方法を利用する完全な画像索引付けパイプラインを提示する.以前の方法は,教師なし逆ファイルメカニズムを使用したか,または特徴エンコーダを導出するためにのみ教師ありを採用していた. 提案手法が大規模な画像検索において最先端の結果を達成することを実験的に確立した.

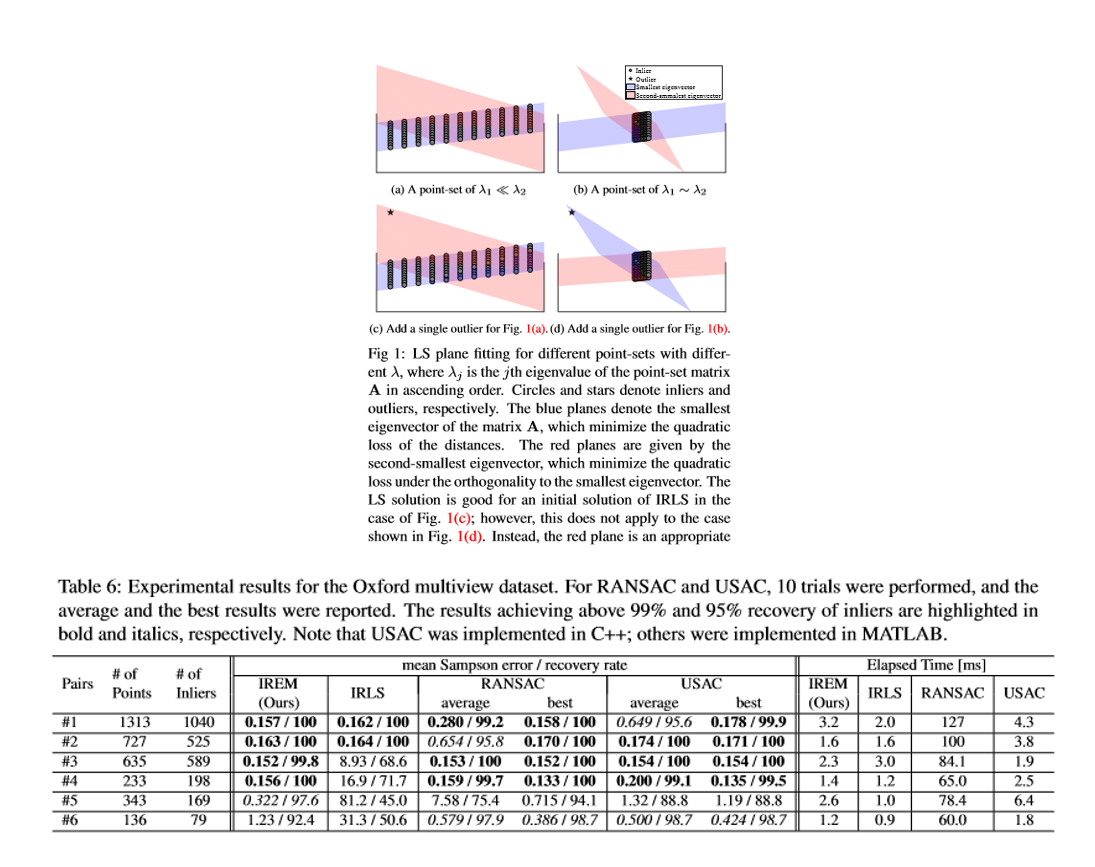

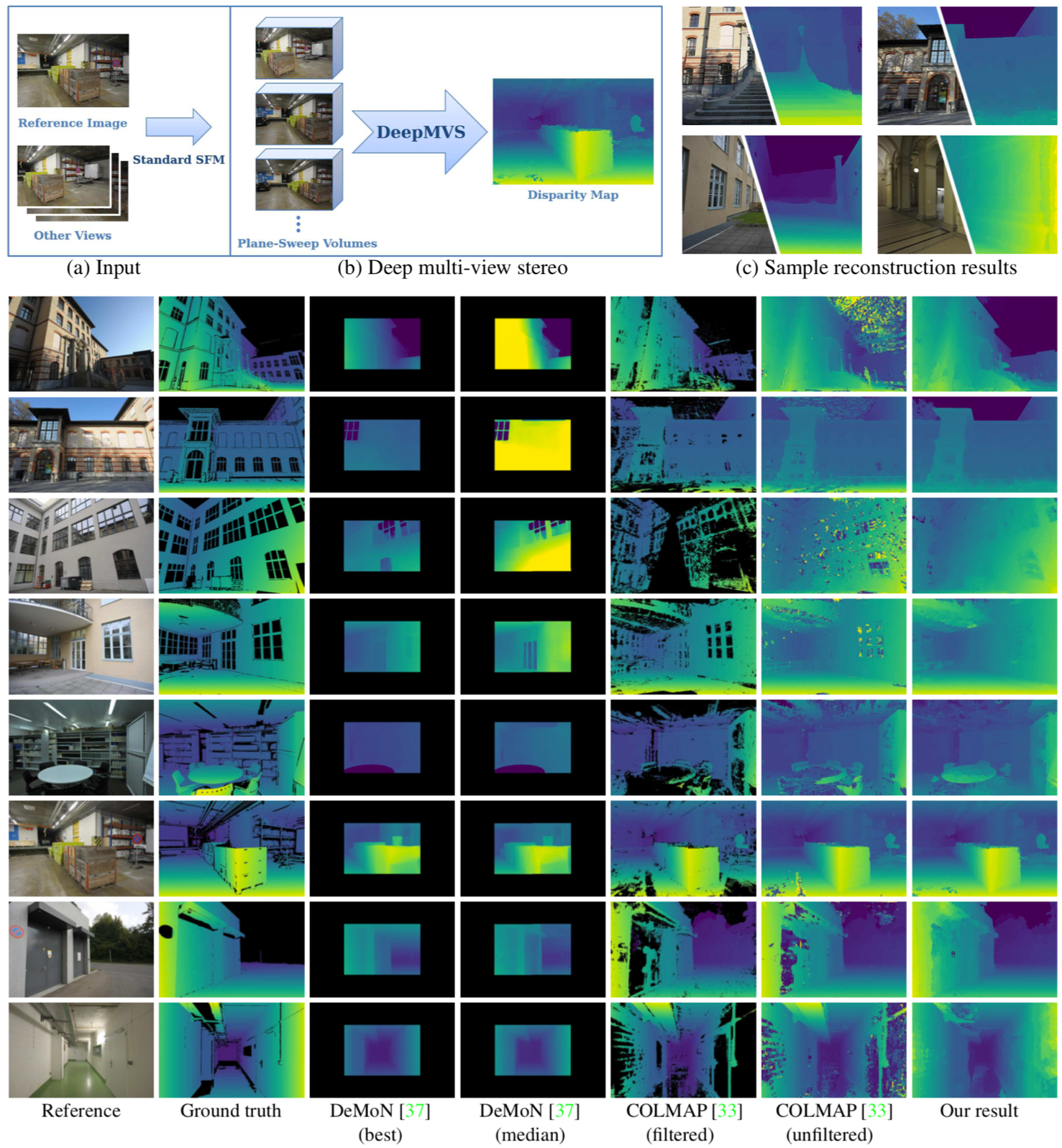

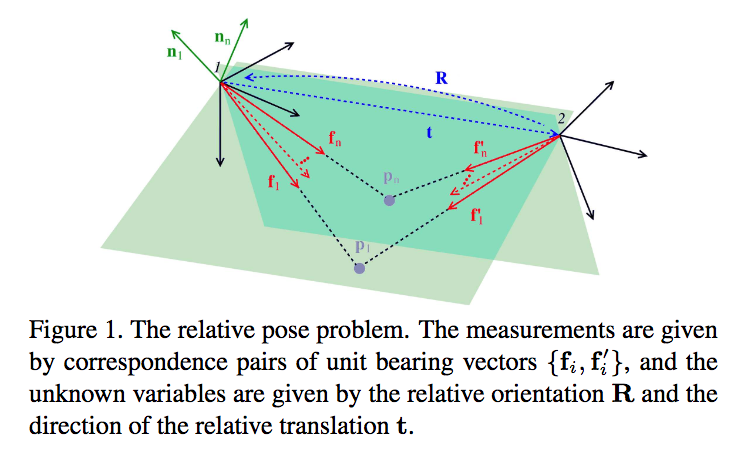

本稿では特に,ステレオ問題や3D再構成などのコンピュータビジョンアプリケーションで重要なタスクであるロバストな基本行列推定に焦点を当てている。反復的に再重み付けされた最小二乗(IRLS)を使用するM推定器は,ロバスト推定のための最もよく知られた方法の1つである。しかしながら,IRLSは,初期解が不十分であるために基本行列推定などの頑強な単位ノルム制約付き線形フィッティング(UCLF)問題には効果がない。本稿では,反復的に再重み付けされた固有値最小化(IREM)と名づけられた新しい目的関数およびその最適化を開発することによって,この問題を克服する。

IRLSが強固なUCLF問題ではうまく機能しない理由を明らかにし,IRLSの問題点を解決するためにIREMという名前の新しいアルゴリズムを提案している。

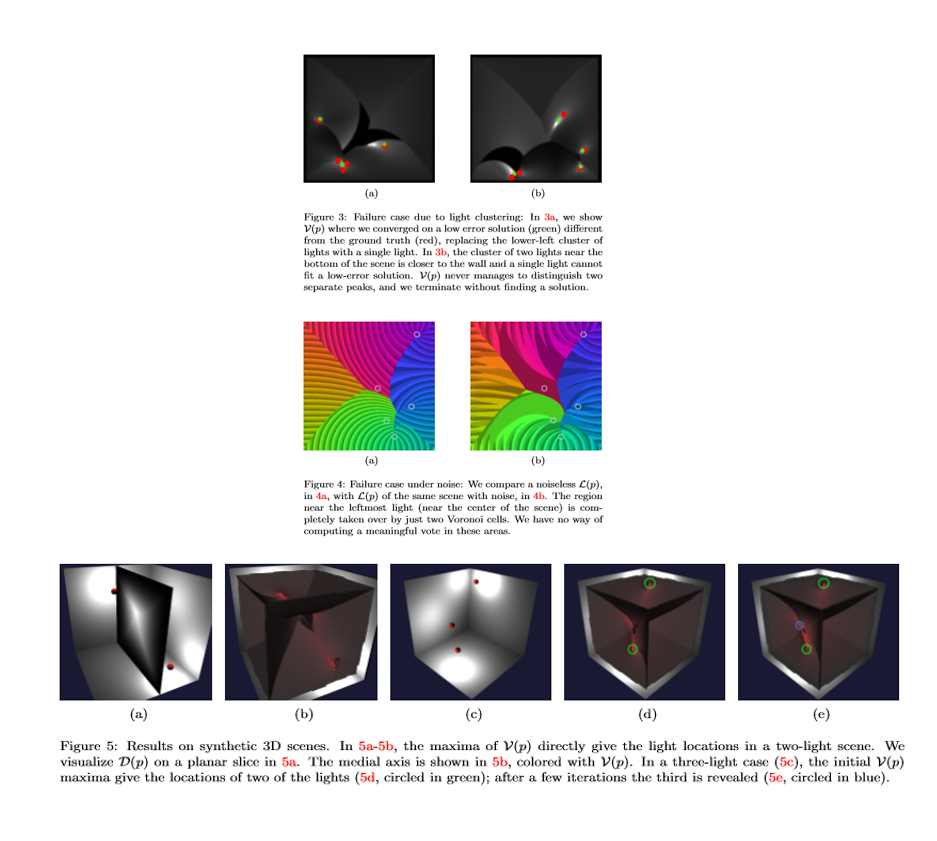

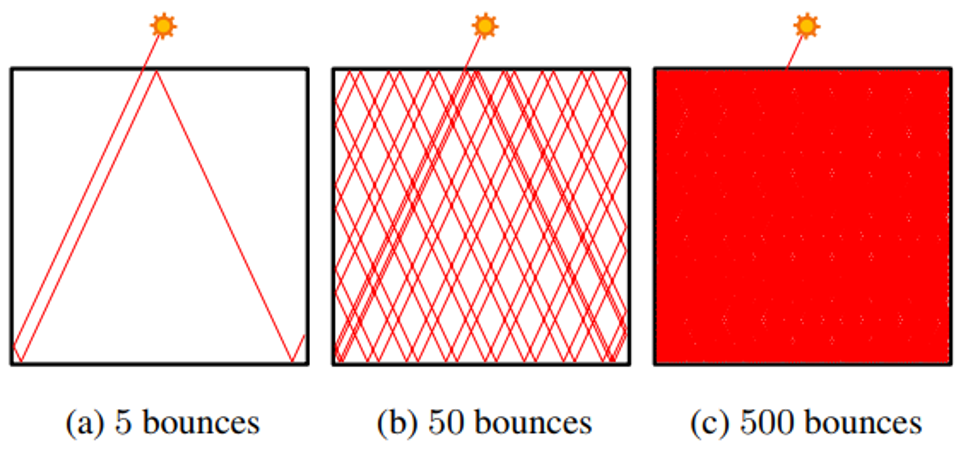

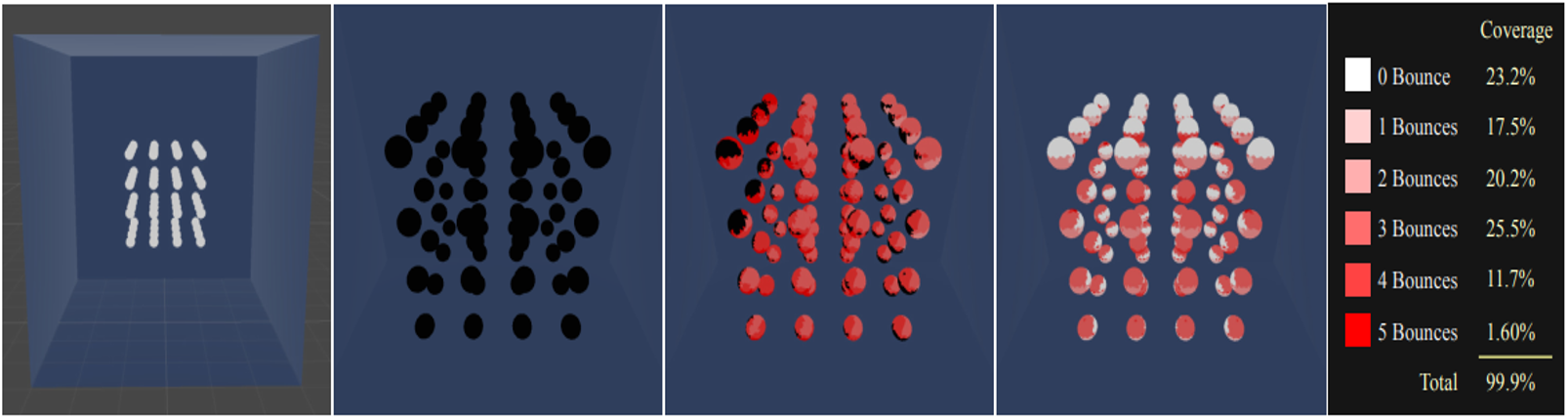

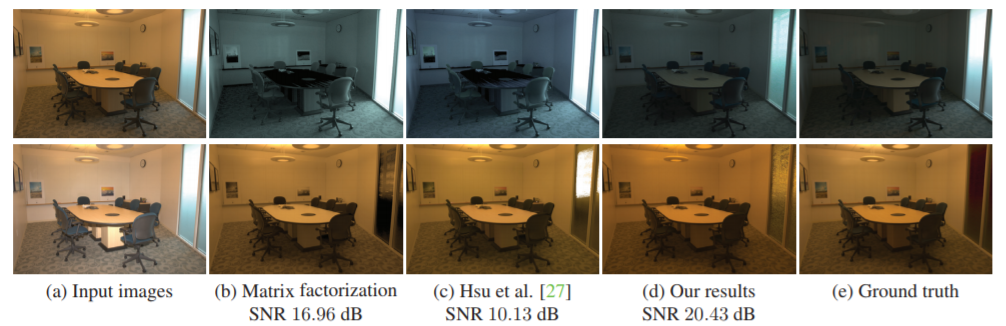

本稿では,光の定位問題について考える。シーンは,観測されていない等方点灯のセットによって照らされる。幾何学,材料,およびシーンの照明された外観を考えると,光の局在化の問題は,光の数,位置,および強度を完全に回復することである。最初に,光の可能性が高いシーン変換を提示する。この変換に基づいて,残りのライトを特定してすべての光強度を決定する反復アルゴリズムを開発する。著者らは,2D合成シーンの大きなセットでこの方法の成功を実証し,合成シーンと現実のシーンの両方で3Dにまで拡大することを示している。

未知数のローカルな離散エミッタの問題の定式化をしている。 シーン内の反射光に基づいて複数の候補光位置を提示する画像変換をしている。位置および強度を含むシーン照明の完全なセットを回復するために光提案を使用する反復アルゴリズムを提案している。

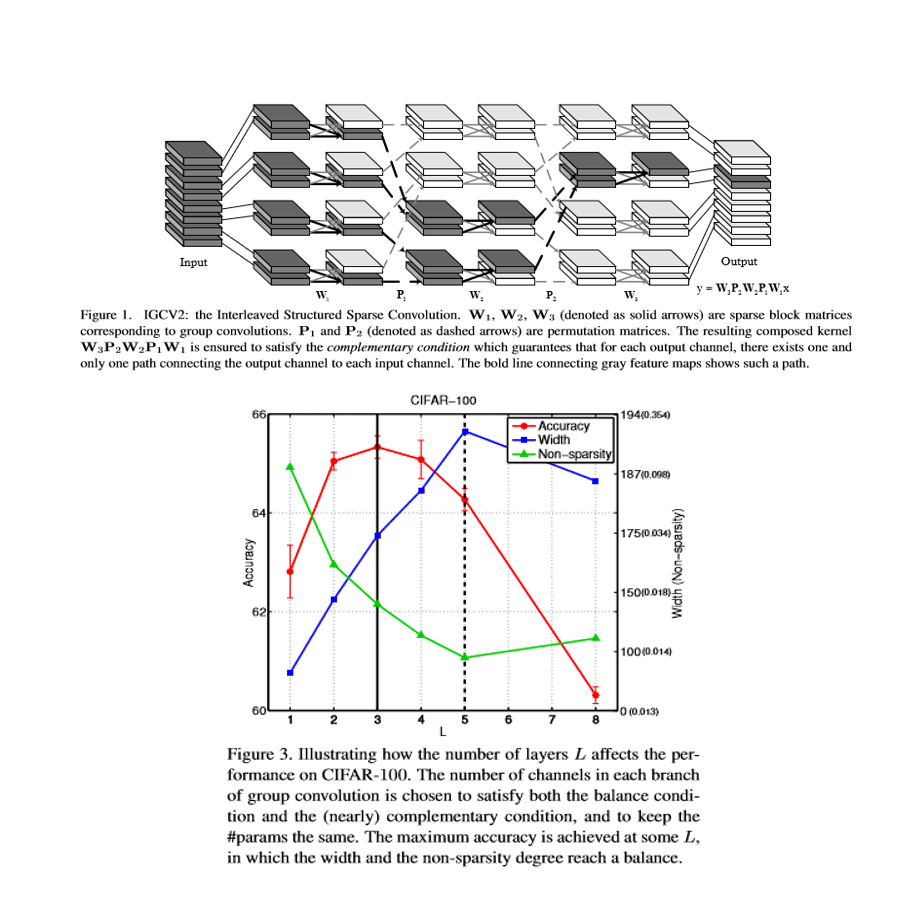

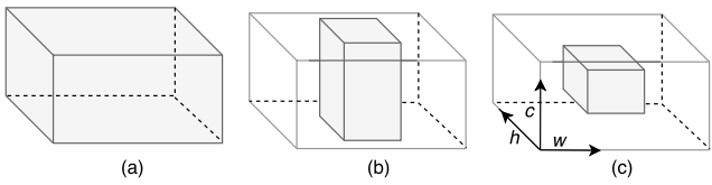

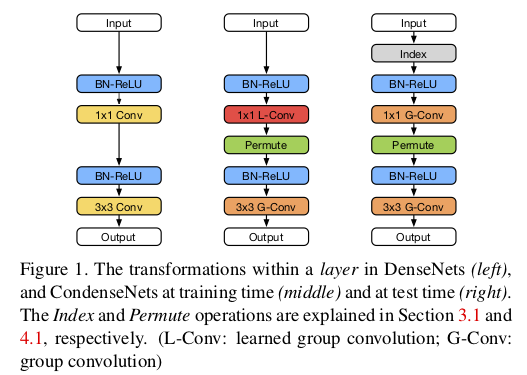

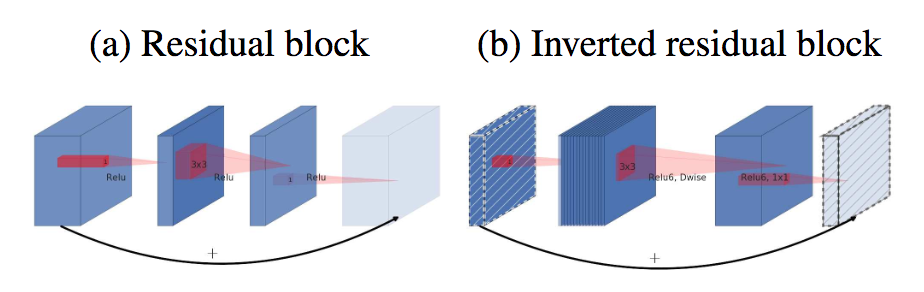

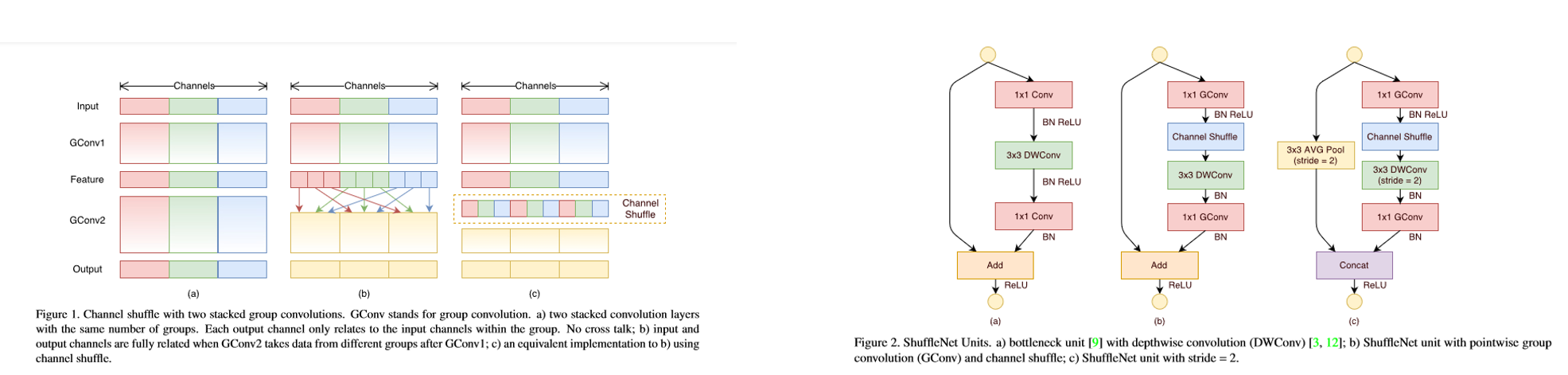

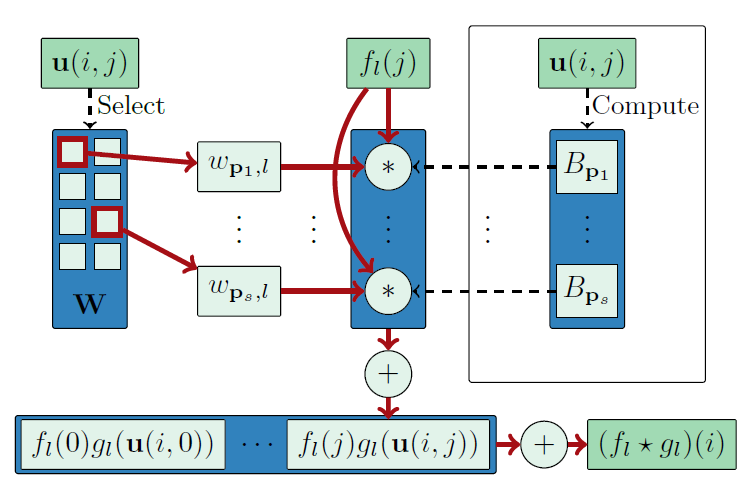

本論文では,畳み込みカーネルの冗長性を排除した効率的な畳み込みニューラルネットワークアーキテクチャの設計問題を検討する。著者らは,IGCV2:Interleaved Structured Sparse Convolutionと呼ばれる連続したグループコンボリューションで構成されるブロックを設計した.このブロックは,構造化スパースカーネルを乗算することとして数学的に定式化されており,それぞれがグループコンボルーションに対応している。相補条件と平衡条件を導入することで,畳み込みカーネルが密集し,モデルサイズ,計算複雑性,分類性能の3つの側面のバランスが良好になる。実験結果は,インターリーブドグループコンボリューションおよびXceptionと比較して,これらの3つの側面のバランス上の利点,および他の最先端のアーキテクチャ設計方法と比較した競合性能を実証している。

畳み込みカーネルの冗長性を排除し,密集したカーネルを構成している。また密集したカーネルを構成することにより,モデルサイズ,計算複雑性,分類性能の3つの側面のバランスが良好になる。

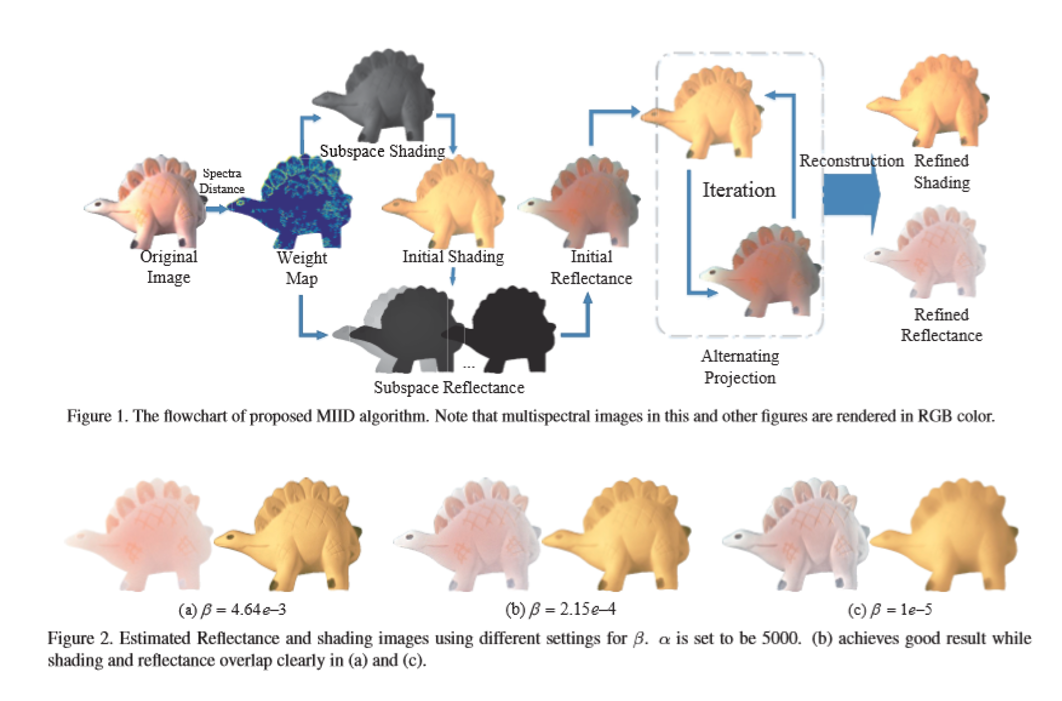

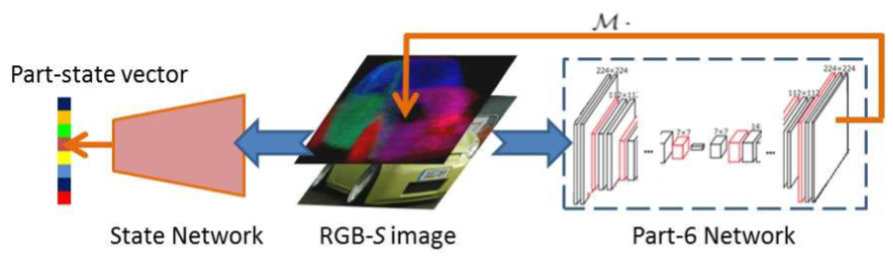

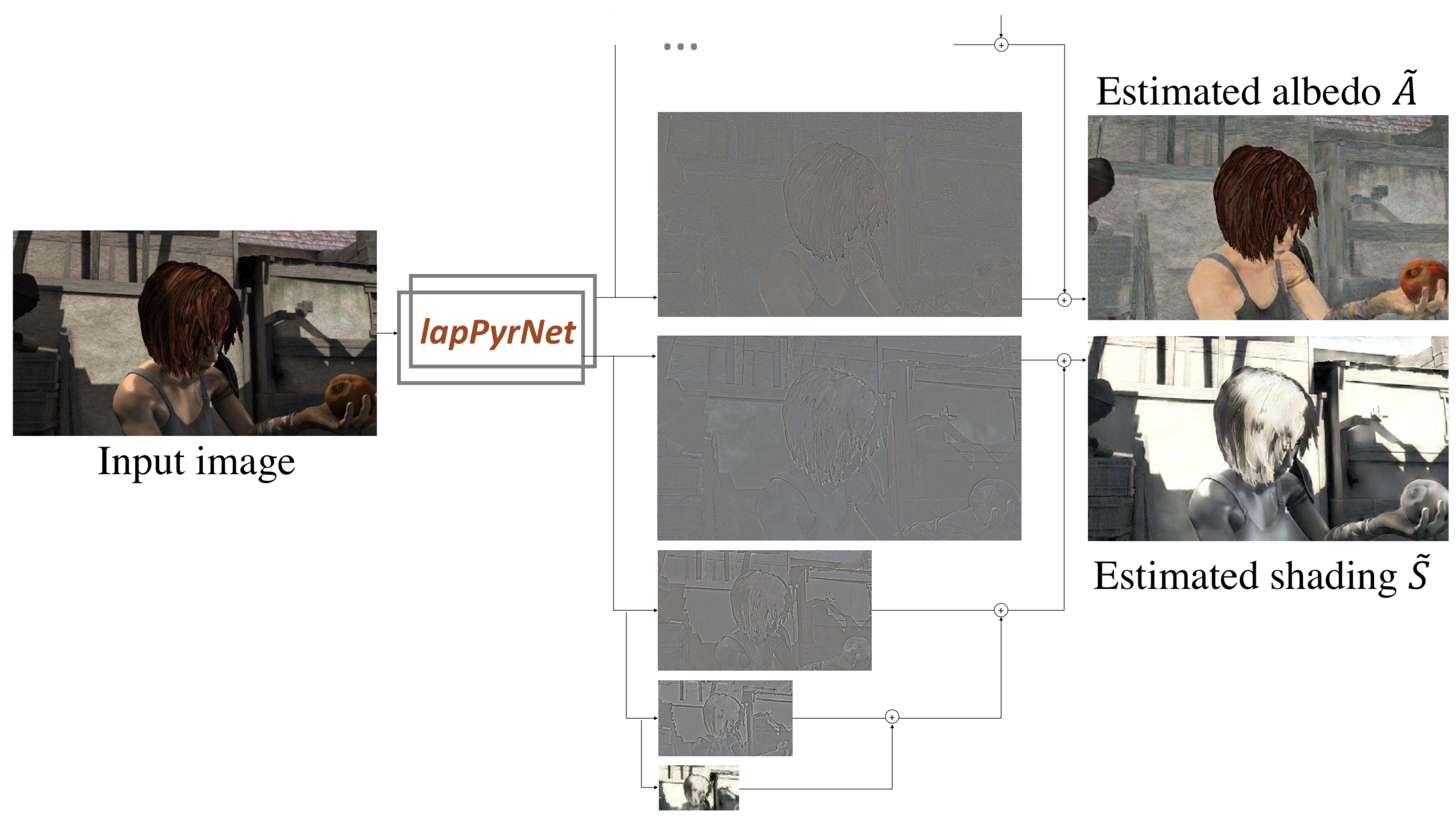

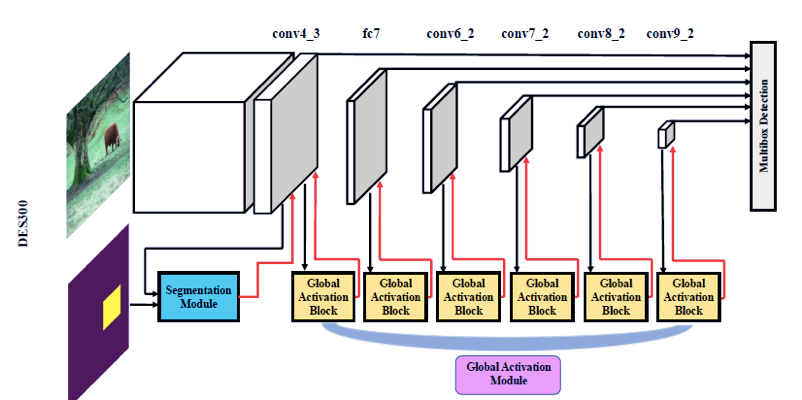

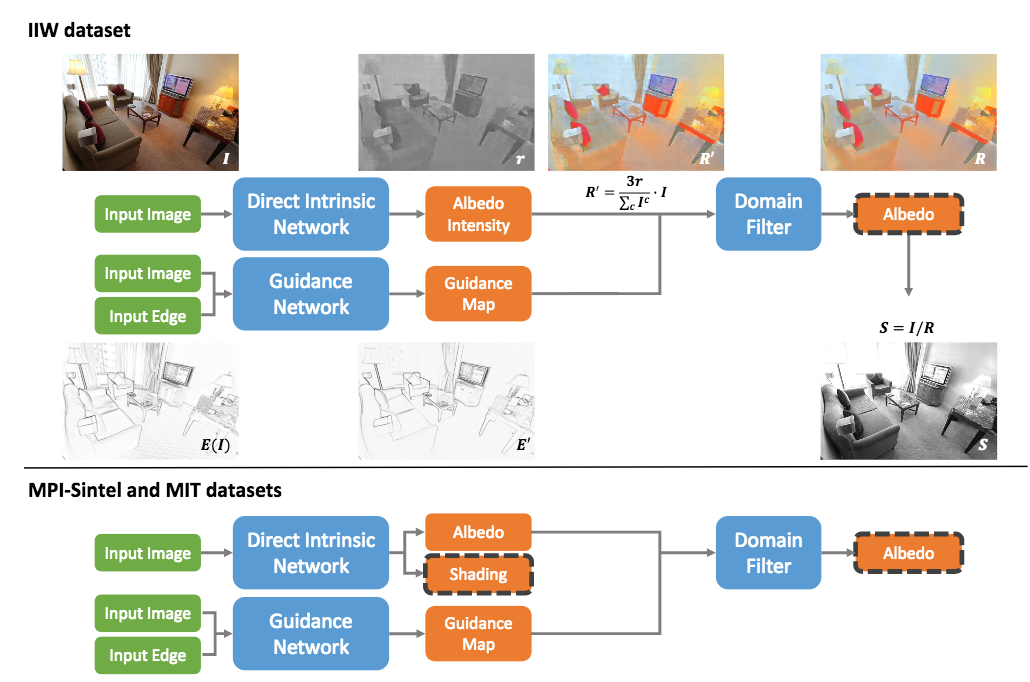

マルチスペクトル画像は,物体の表面特性の多くの手がかりを含んでおり,したがって,再カラー化およびセグメント化などの多くのコンピュータビジョンタスクで使用することができる。しかしながら,自然なシーンにおける複雑な幾何学的構造のために,同じ表面のスペクトル曲線は,異なる照明および異なる角度のもとで非常に異なって見える可能性がある。本稿では,単一のマルチスペクトル画像からシェーディングと反射を分解する新しいマルチスペクトル画像固有分解モデル(MIID)を提示する。

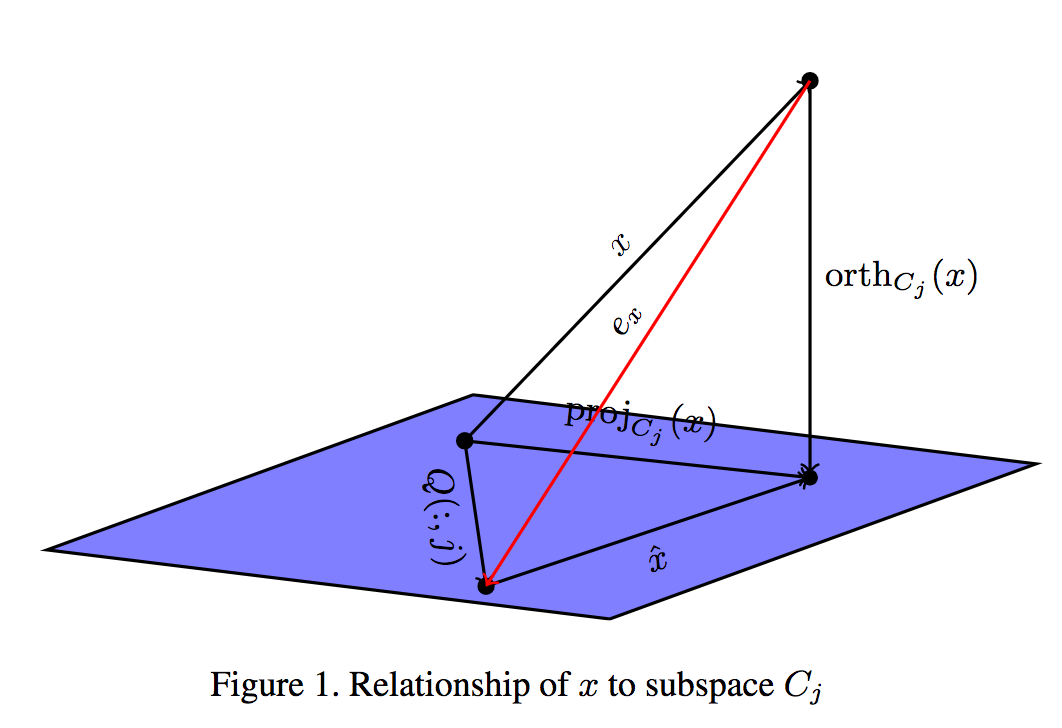

マルチスペクトル画像固有分解モデル(MIID)を提示する。著者らは,マルチスペクトル領域に対して,RGB画像固有分解のために提案されているRetinexモデルを拡張する。これに基づいて,部分空間制約が,シェーディングおよび反射スペクトル空間の両方に導入している。

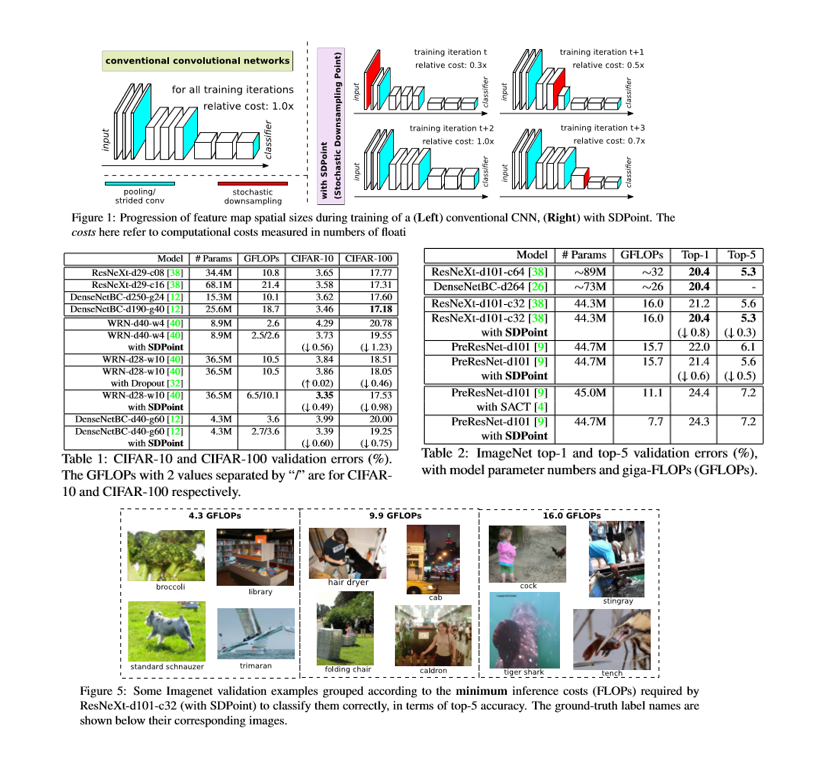

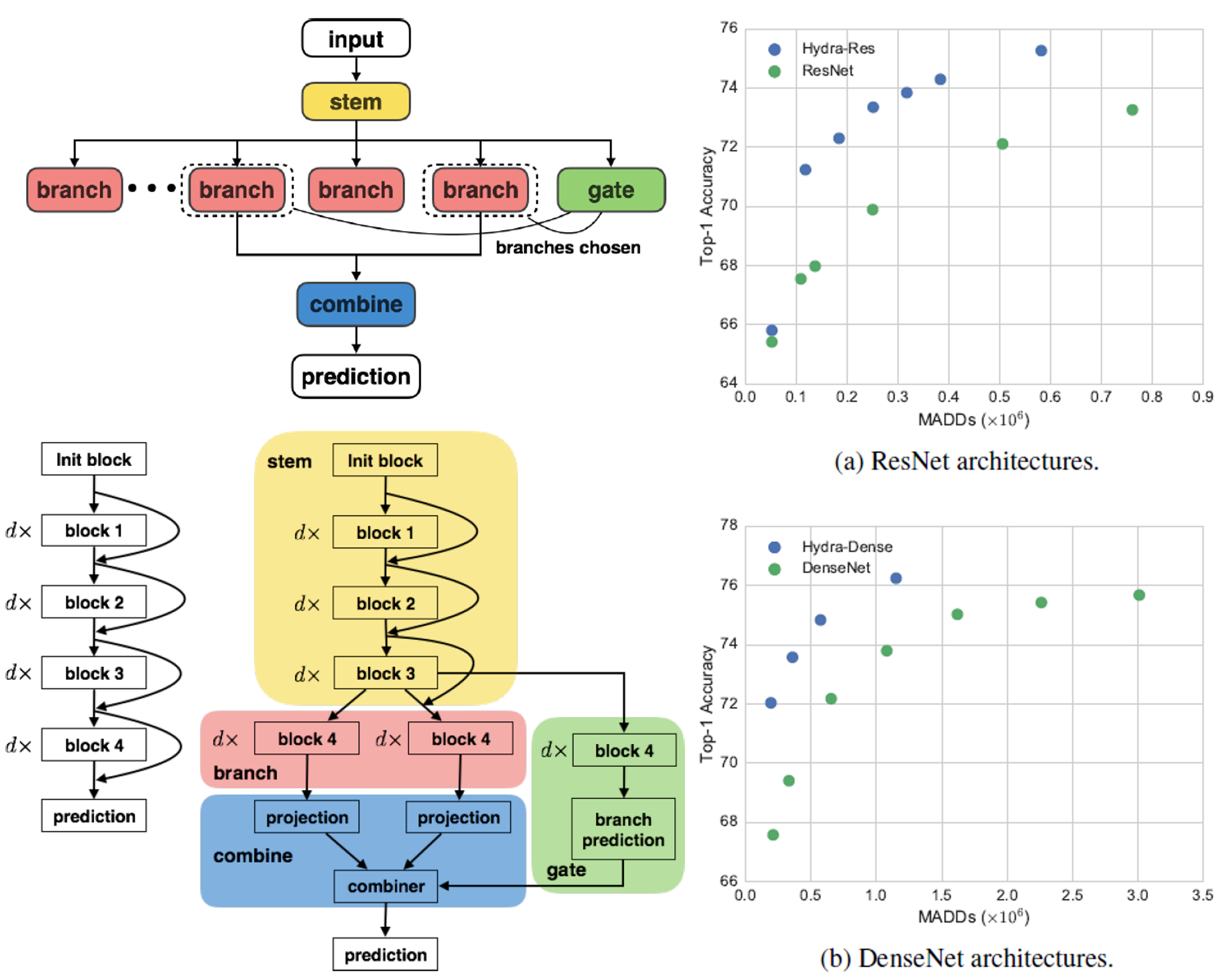

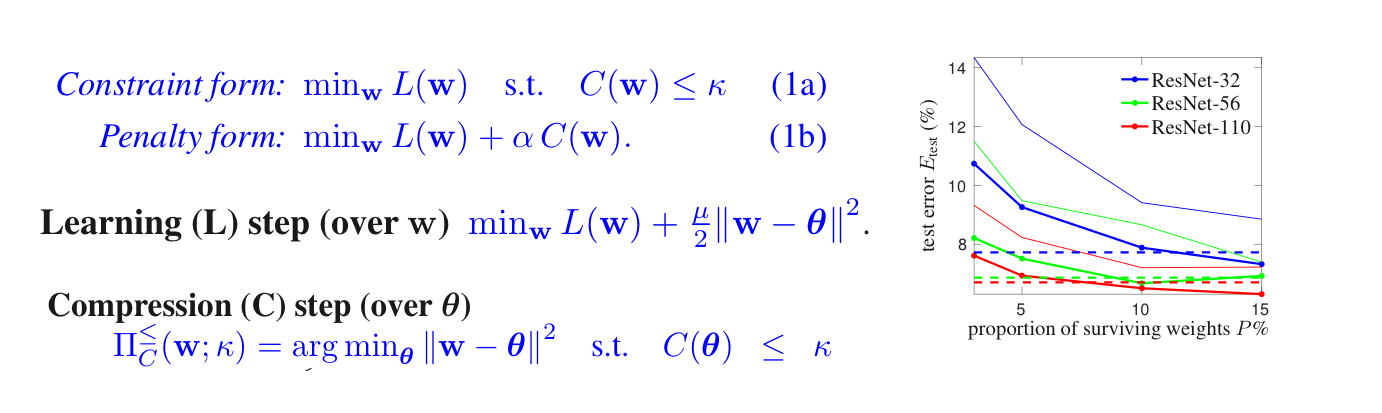

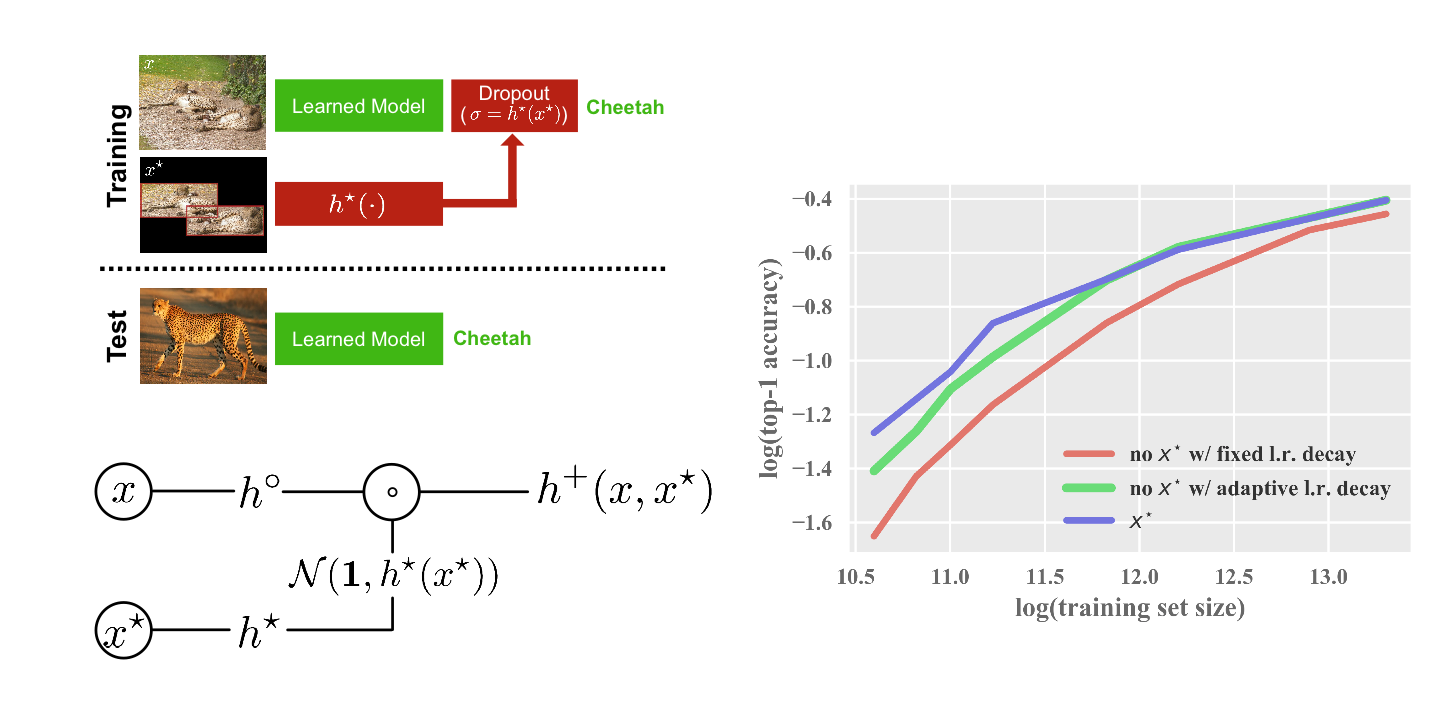

推論の間により効率的に動作するように畳み込みネットワーク(CNN)を訓練することが望ましい。しかし,多くの場合,推論のためにシステムが持っている計算予算は,トレーニング中に事前に知ることができないか,または推論予算は,変化するリアルタイムリソースの利用可能性に依存する。したがって,推論コストが調整できず,様々な推論予算に適応できない,単なる推論効率の良いCNNを訓練することは不十分である。確率的ダウンサンプリング点(SDPoint)であるCNNにおけるコスト調整可能な推論のための新しいアプローチを提案する。

余分なパラメータとトレーニングコストがかからないため,SDPointは効果的なコスト調整可能な推測を容易にし,ネットワークの正則化(したがって正確なパフォーマンス)を大幅に改善する。

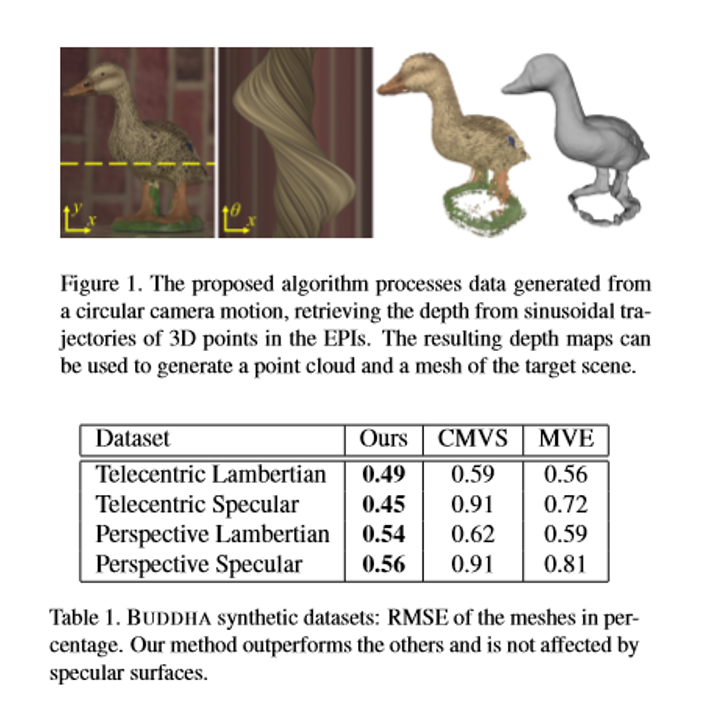

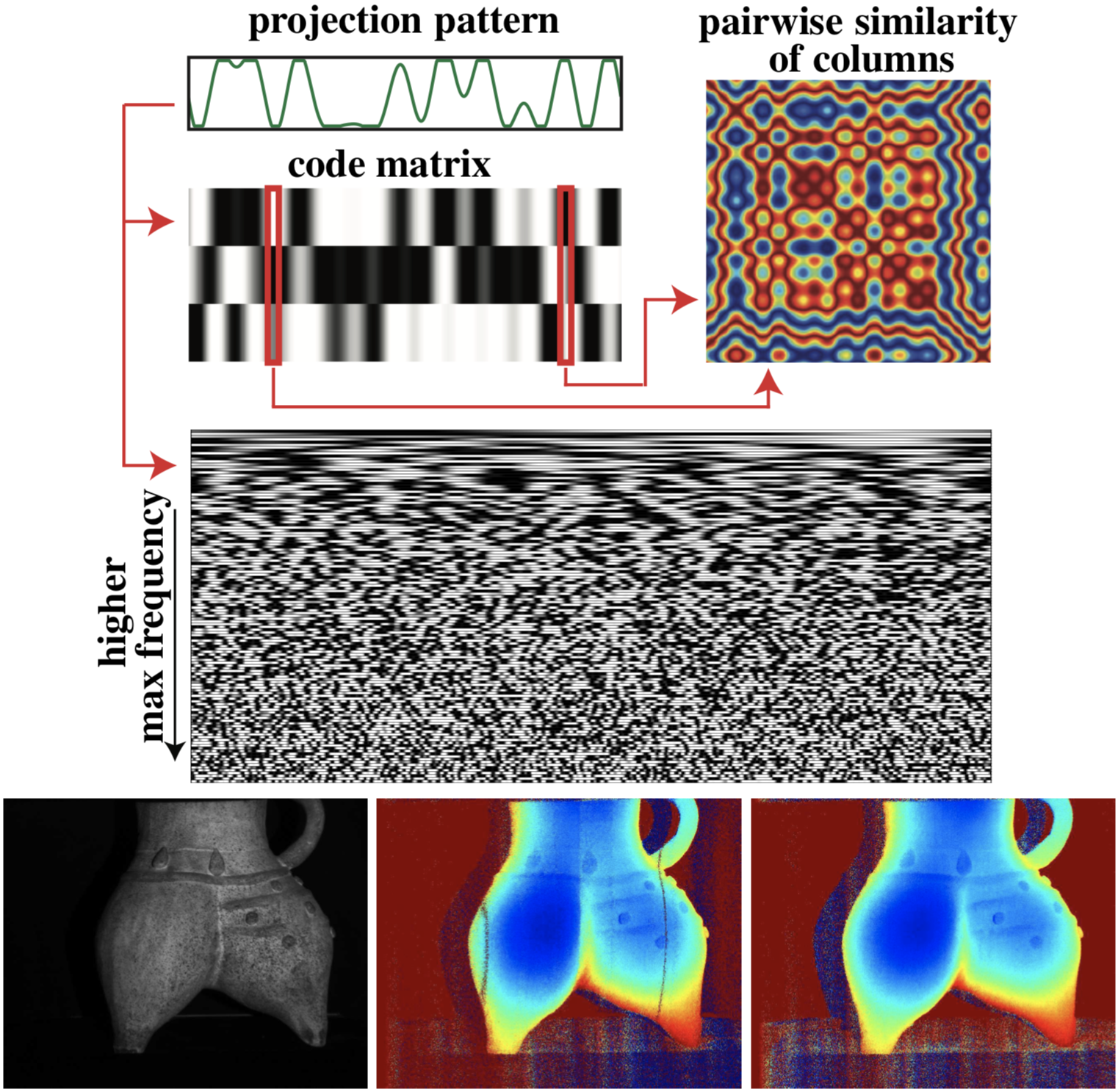

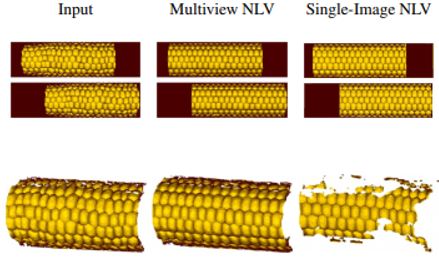

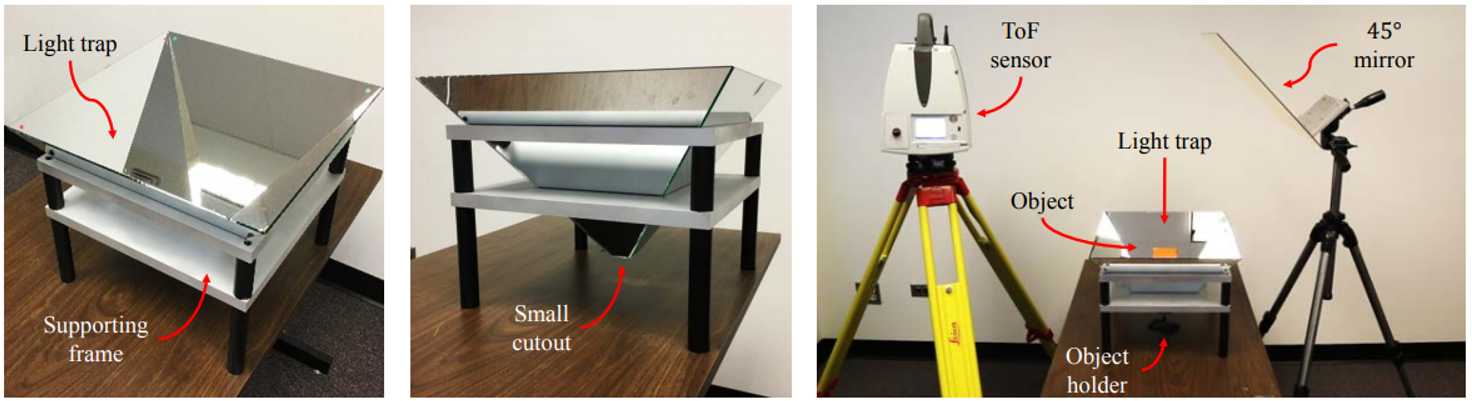

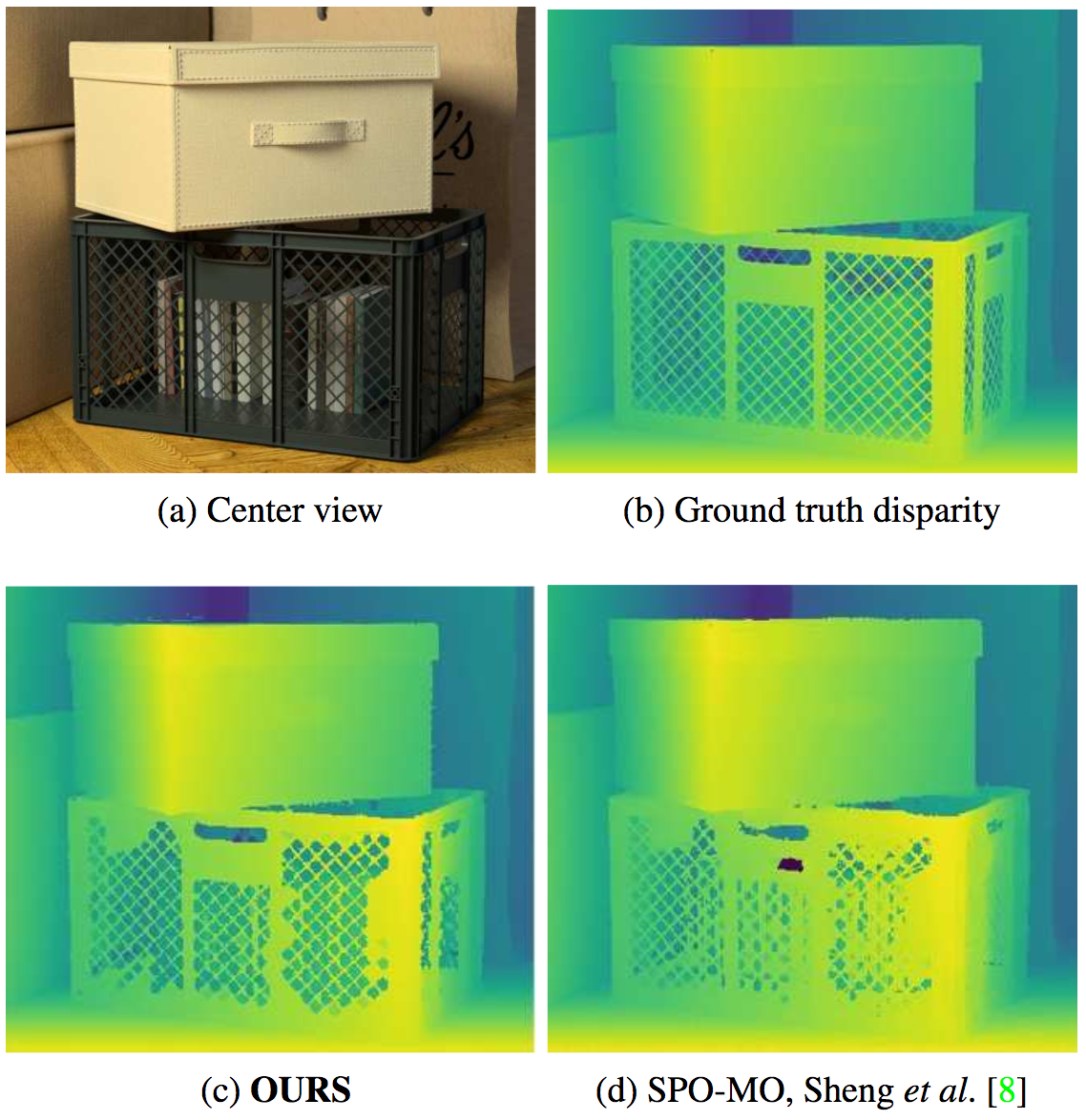

ライトフィールド画像は,通常のグリッドで撮影された画像に基づいています。したがって,高品質3D再構成は,エピポーラ平面画像(EPI)の方向を分析することによって得ることができる。しかし,そのようなデータは,オブジェクトの片面のみを評価することを可能にする。さらに,各方位に沿った一定の強度は,ほとんどのアプローチにおいて必須である。本論文では,円環状のフィールドと呼ばれる円形のカメラモーションで得られたデータから奥行き情報を再構築することを可能にする新規な方法を提示する。この手法を使用することで,対象物の全360度のビューを決定することを実現する。

使用する画像は,テレセントリックカメラで撮影した画像と標準の遠近両用レンズで撮影した画像の2種類である。従来の線形ライトフィールドとは異なり,円形のライトフィールドを使用している。

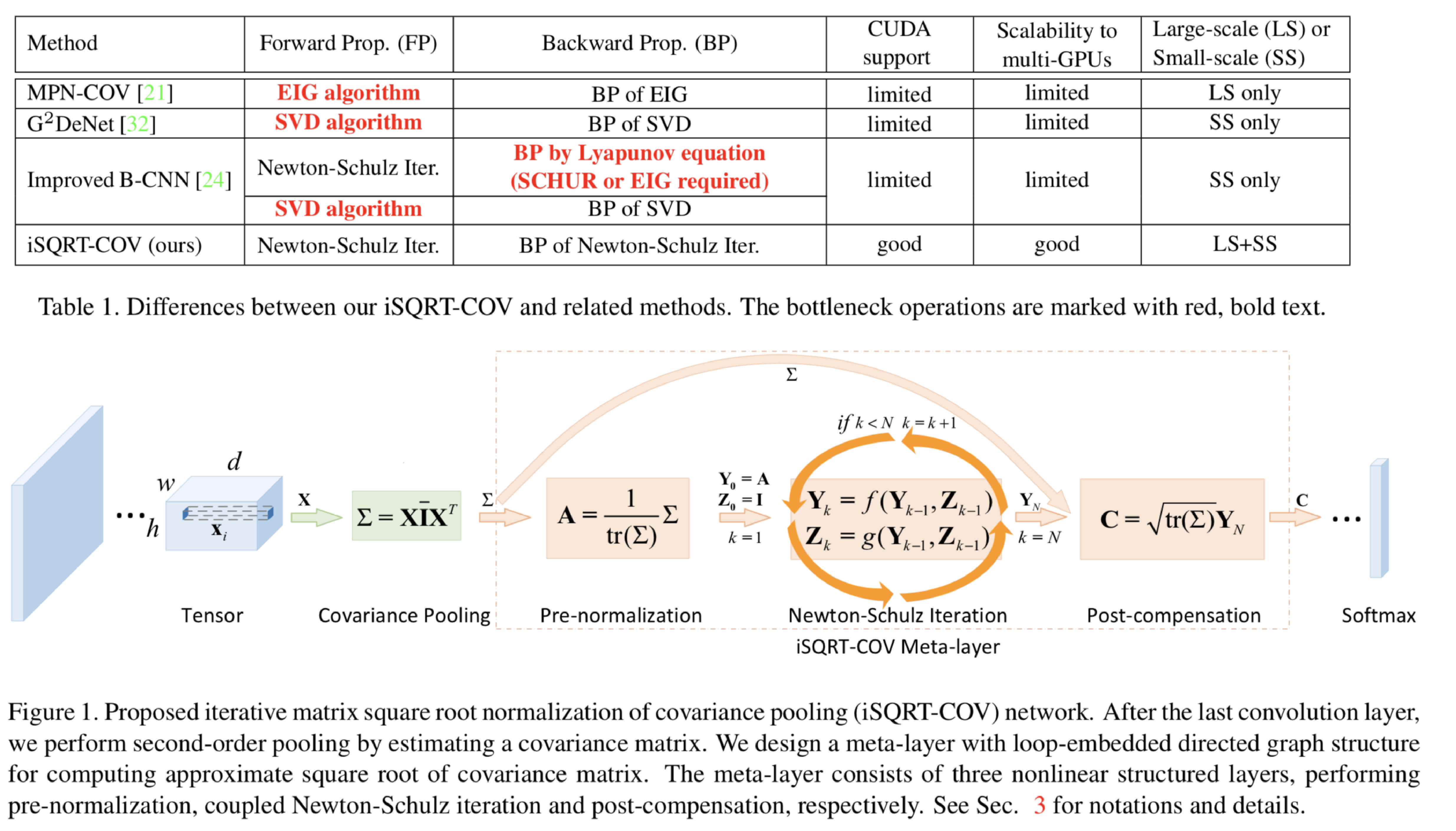

covariance poolingをNewton-Schulz iterationを用いて高速に行う手法を提案。covariance poolingを行う既存手法の多くでは行列の平方根を行う際に固有値分解と特異値分解を行っているが、これらはGPUで十分にサポートされておらずトレーニング時間を効率的に行うことができなかった。提案手法ではcovariance poolingにおける行列の平方根の計算をGPUでサポートされいているpre-normalization、Newton-Schulz iteration、post-compensationで行う手法を提案。Newton-Schulz iterationでは二つの式の最適化を行い、post-compensationはデータの規模に依存する処理であるpre-normalizationの影響をを緩和するために行う。

多くのCV分野では、2枚の画像間におけるk-NNFの計算を必要とし、クエリ画像内の各パッチについて、データベース内のk個の最も類似したパッチの位置を決定する。PatchMatchアルゴリズムは、この検索問題を画像パッチの局所的一貫性を利用する共同検索手法によって効率的に近似し、解決した。本論文はこのPatchMatchやその亜種(改良版)について調査している。

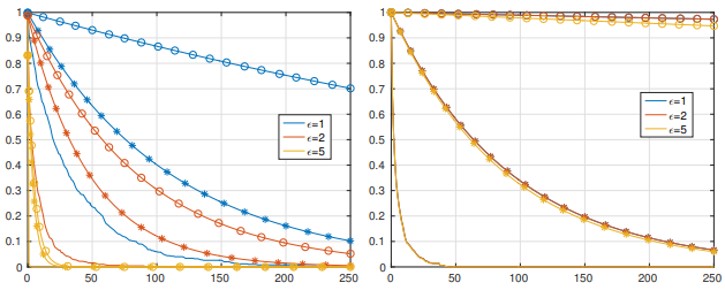

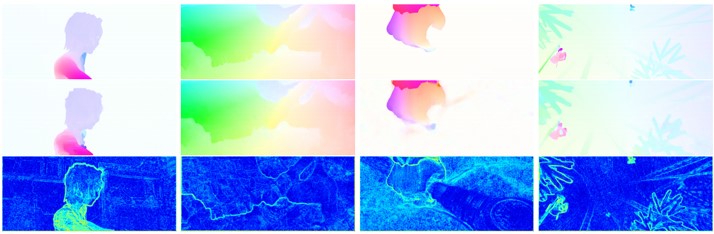

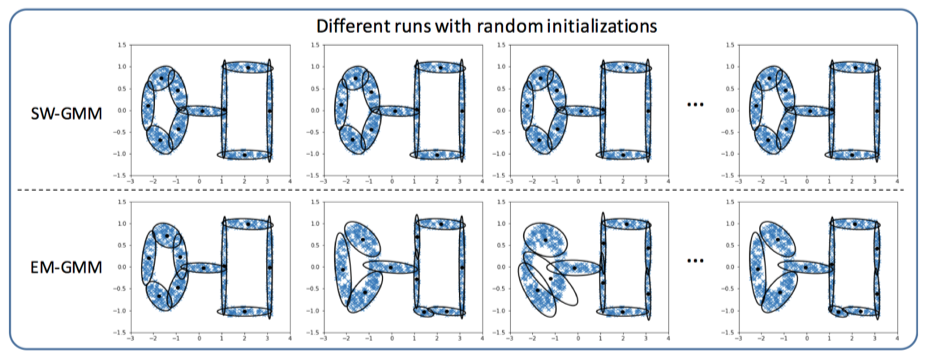

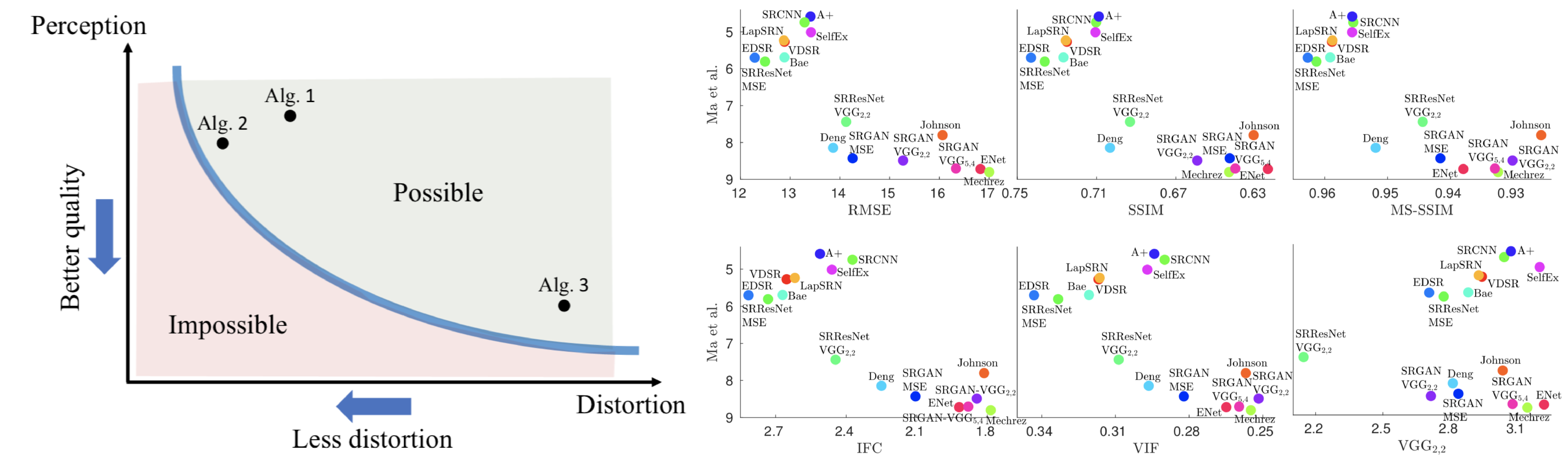

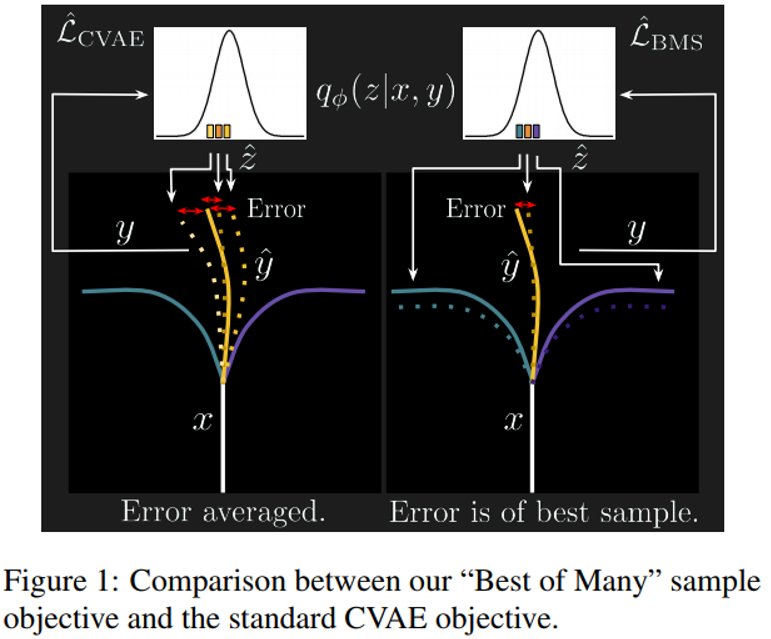

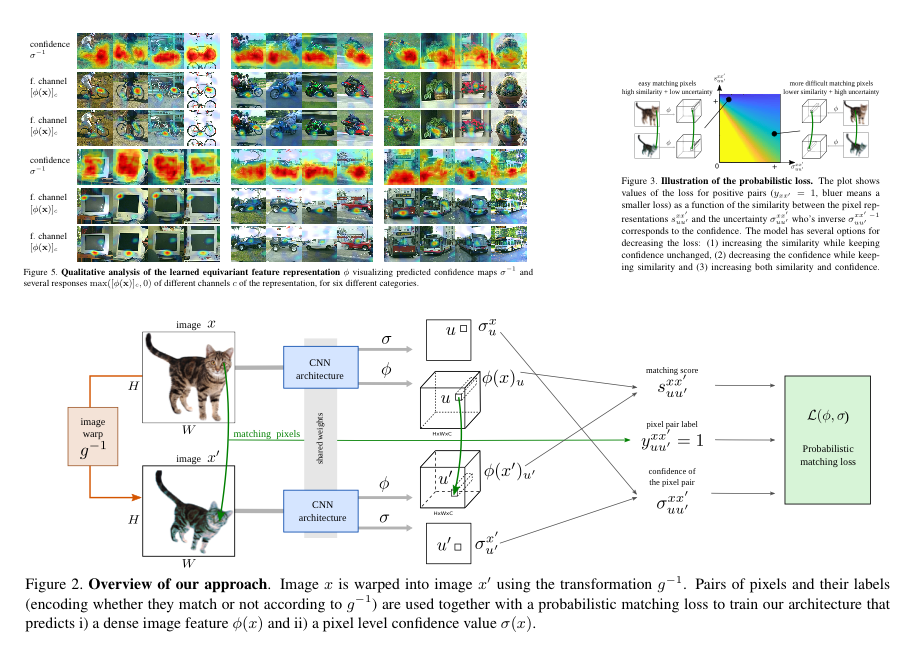

確率論的アプローチの変分近似は、閉形式変数更新の分析式を導出するというプロセスを排除し、代わりに対数の勾配を計算するだけでよく、人気が高まっている。しかし、ログ勾配において、標準的な勾配法を用いて最適化することは困難な場合がある。図は、オプティカルフローに応用した結果。 Ground truth (上)、フロー予測(中)、不確実性推定(下)。

オプティカルフロー推定、ポアソンガウスノイズ除去、3D表面再構成の3つのアプリケーションで改善を実証。

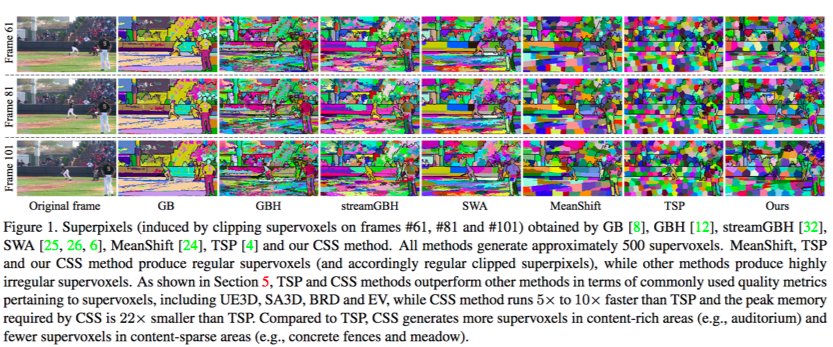

・動画の領域分割手法のContent-Sensitive Supervoxels(CSS)の提案・空間次元と同じ方法で動画を単に扱うだけではなくオプティカルフローを使用して、隣接フレーム間のボクセルの接続ブラフを構成し、規則的な3次元格子構造を、高次元の色と時系列空間にマッピングすることによって歪める。 ・K-means++のストリーミングバージョンを適用することにより、一度にメモリにロードすることが出来ない長いビデオを処理可能。

・7つの代表的なスーパーボクセル手法を4つのビデオデータセットで比較し、既存のスーパーボクセル手法より優れている。

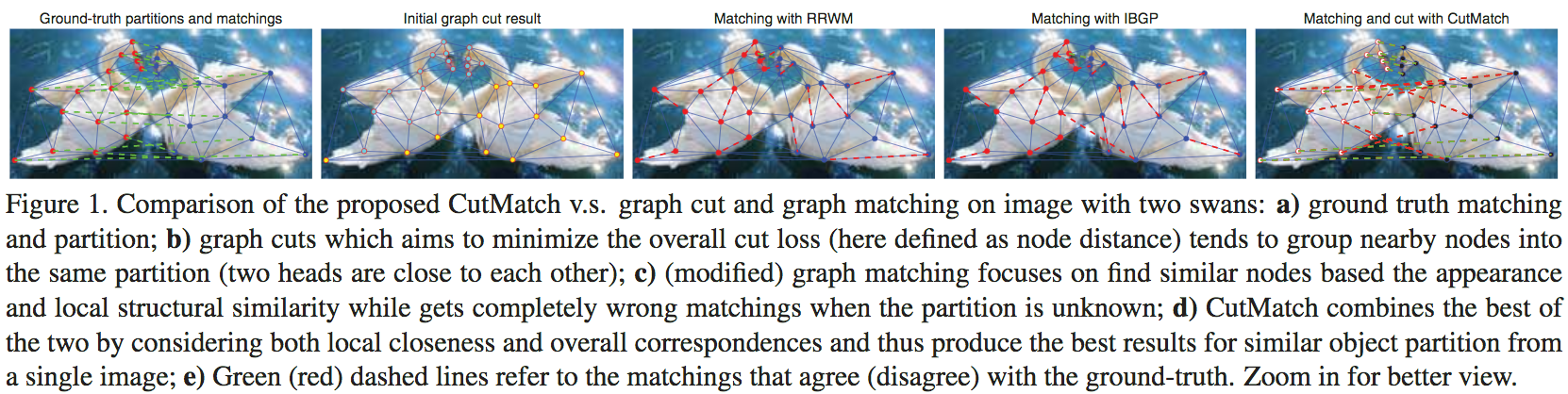

グラフカットとグラフマッチングを同時に最適化する問題を定式化し,解決する手法Iterative Bregman Gradient Projection(IBGP)の提案

・実世界の画像と合成データセットの両方で検証し, IBGPは外れ値には脆弱だが,様々な外乱に頑健

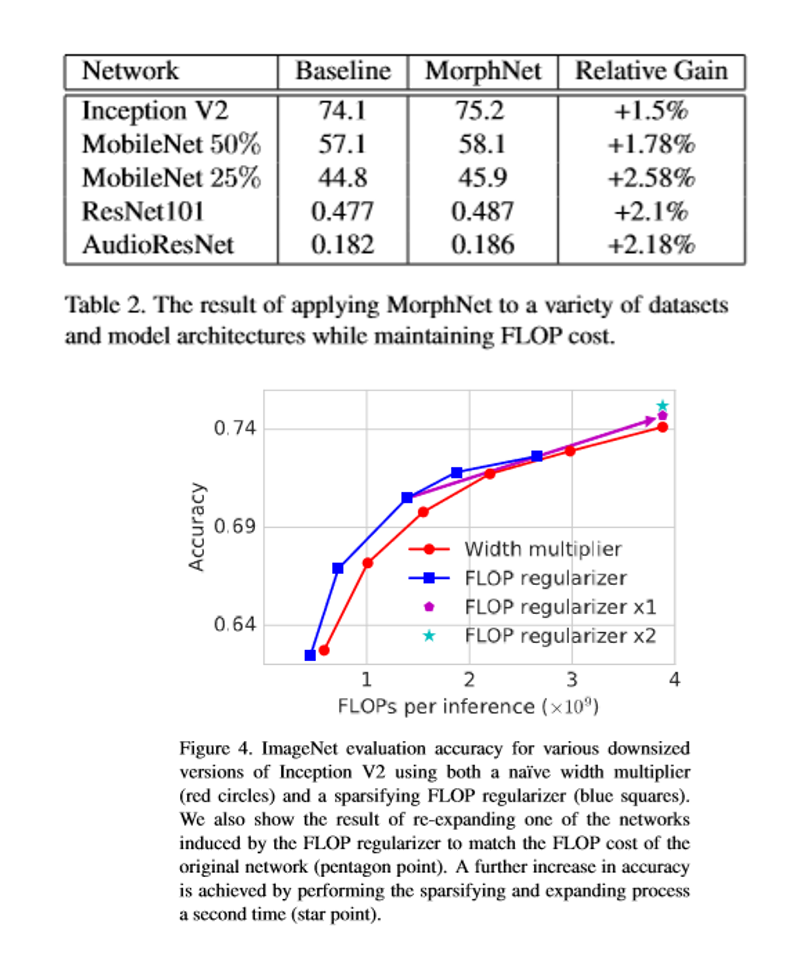

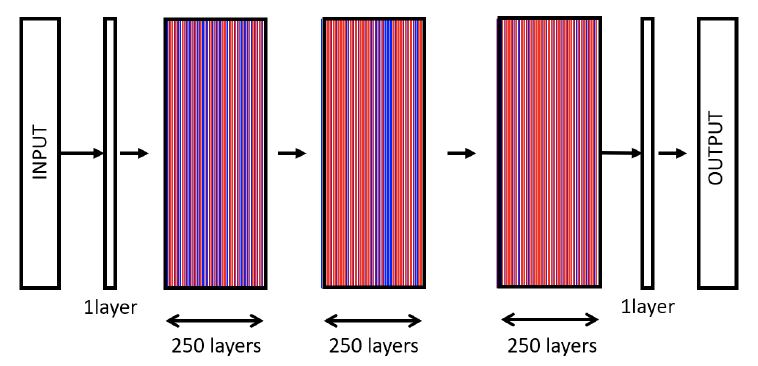

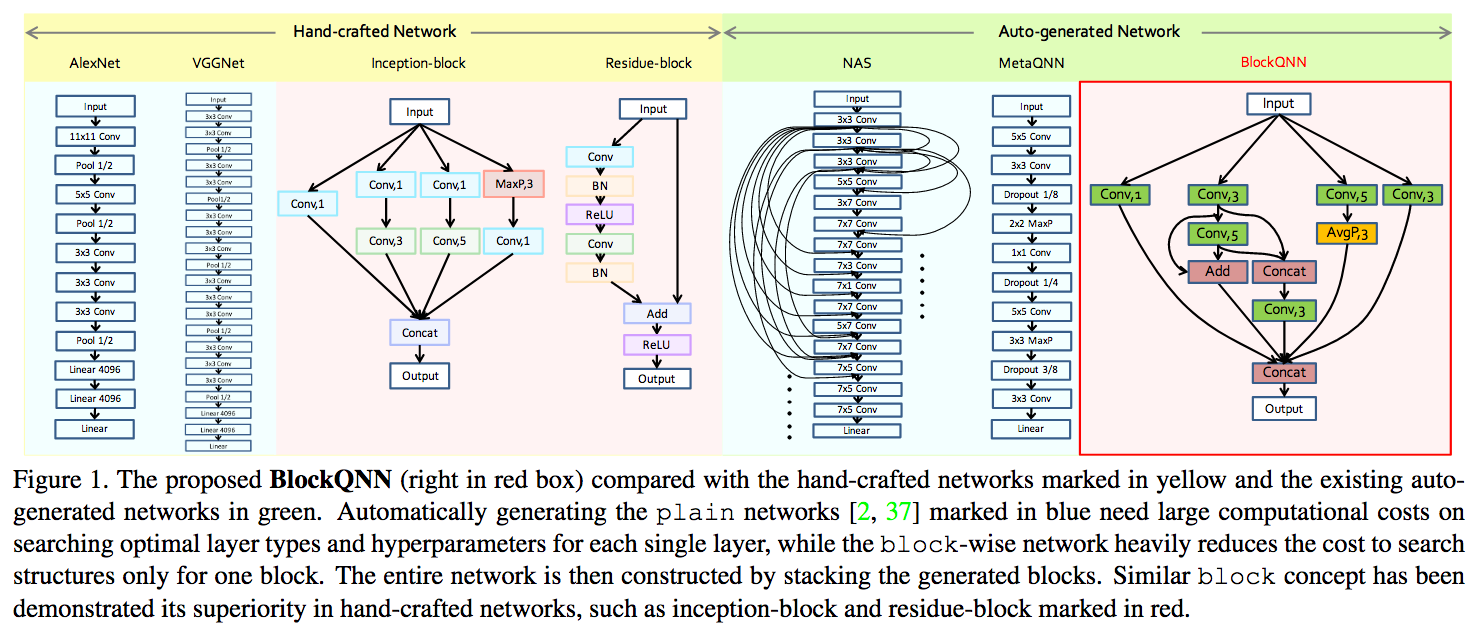

この論文では,MorphNetと呼ばれるニューラルネットワーク構造の設計を自動化する手法を提案している。 MorphNetはネットワークを繰り返し縮小して拡張し,アクティベーション時にリソースの重み付けされたスパース化レギュラーを介して縮小し,すべてのレイヤーで均一な乗法係数を使用して拡張する。従来のアプローチとは対照的に,本発明の方法は,特定のリソース制約(例えば推論ごとの浮動小数点演算の数)に適合し,ネットワークの性能を高めることができる大規模ネットワークにスケーラブルである。評価実験では,さまざまなデータセットとシードネットワーク設計での自動構造学習のMorphNetアルゴリズムを評価している。FLOPとモデルサイズの制約の分析では,制約と精度との間のトレードオフの形式は特定のリソースに大きく依存し,MorphNetはFLOPまたはモデルサイズのいずれかを対象とするときにこのトレードオフをうまく乗り越えることができることを示した。

ニューラルネットワーク構造の設計を自動化にしている。またリソース制約をすることにより大規模ネットワークに拡張可能になっている。

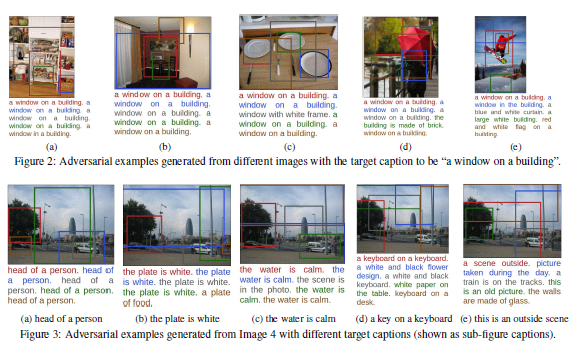

DNNにおいて,システムを混乱させるような攻撃にロバストとなるには,それらの攻撃された画像を学習する必要がある.そこで本稿では,識別する画像に細工を加えることで従来のDNNの識別を間違えさせるアルゴリズムを提案.今回は道路標識の画像に対し環境情報,空間的制約を分析して画像上に細工を加える.作成した画像をLISA-CNNやGTSRB-CNNに識別させ,その間違えた結果を評価している.

実際に”STOP”の標識を"Speed Limit 45"などに誤認識させており,さらにその識別結果が80%を越えている.この事からかなりの精度で攻撃できていることがわかる.

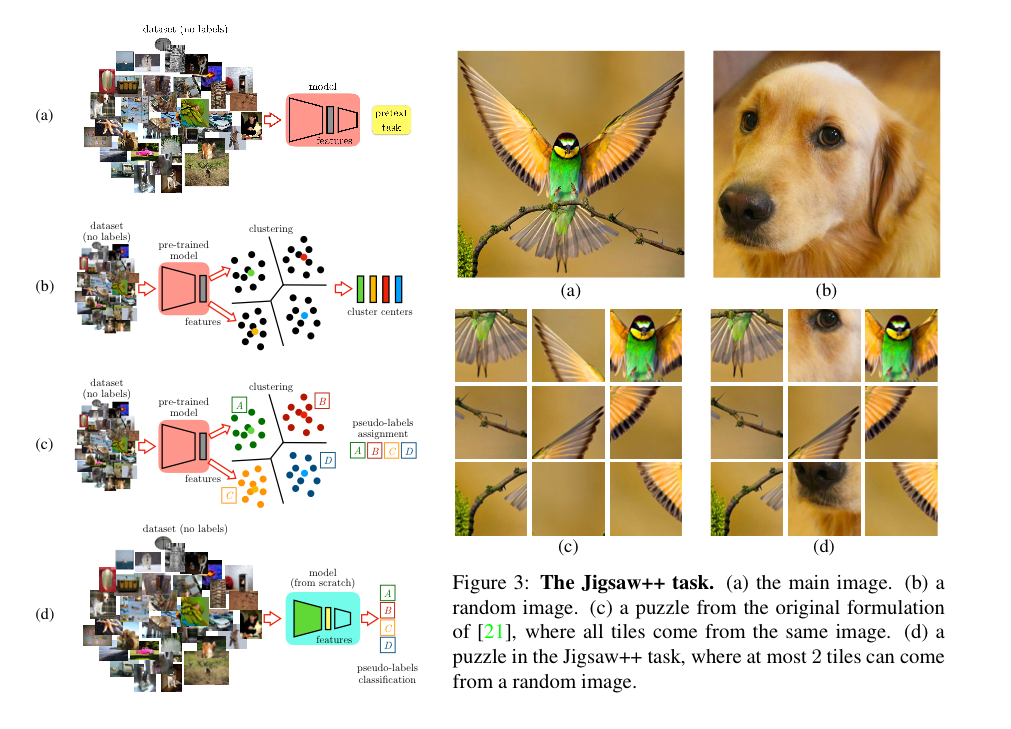

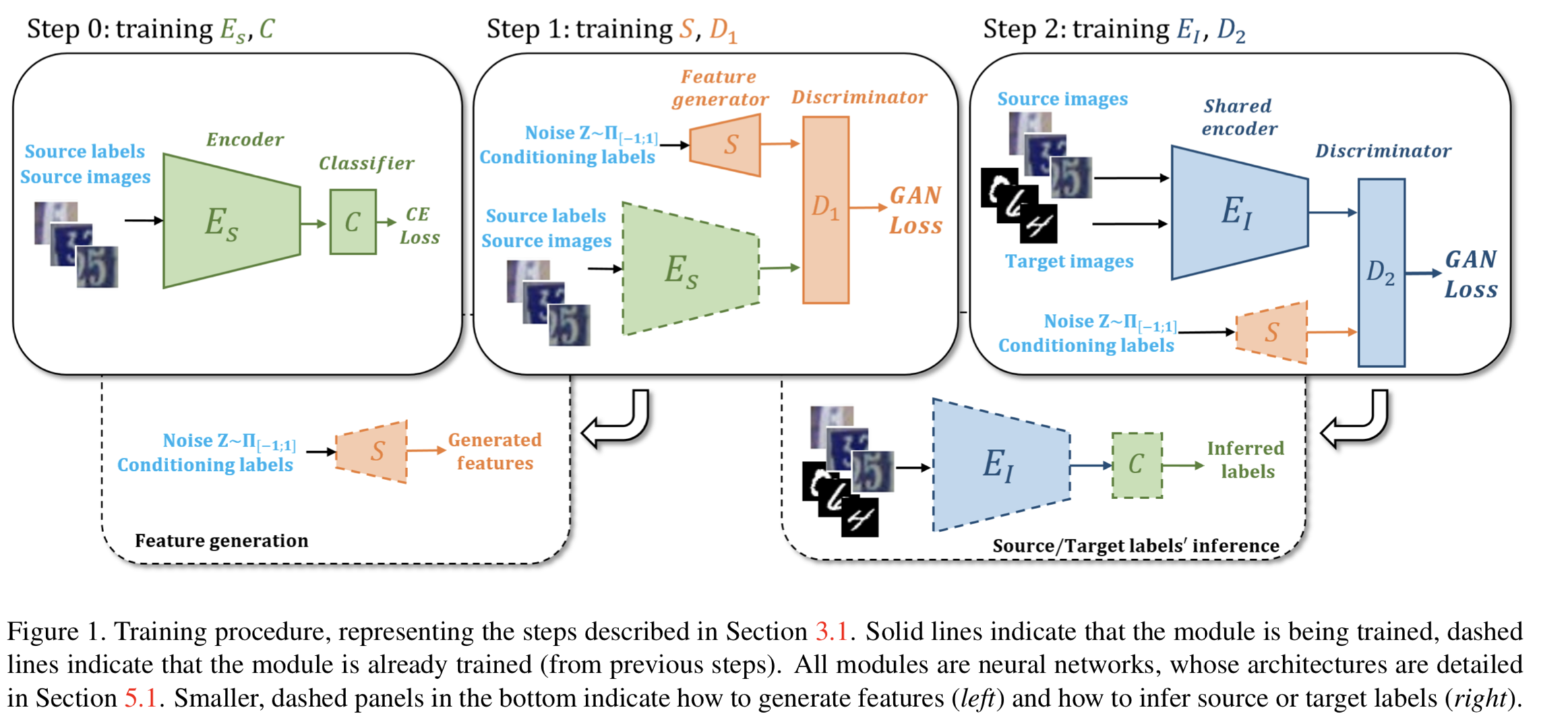

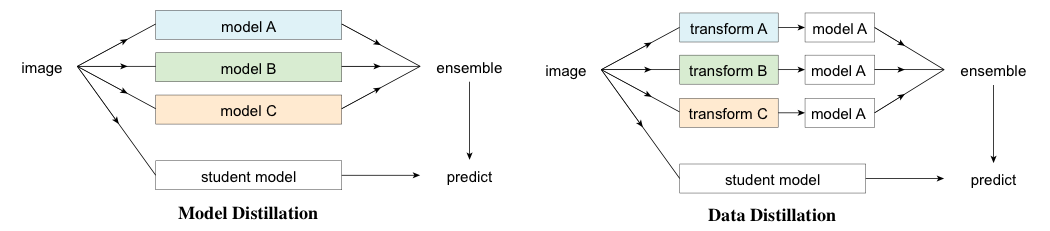

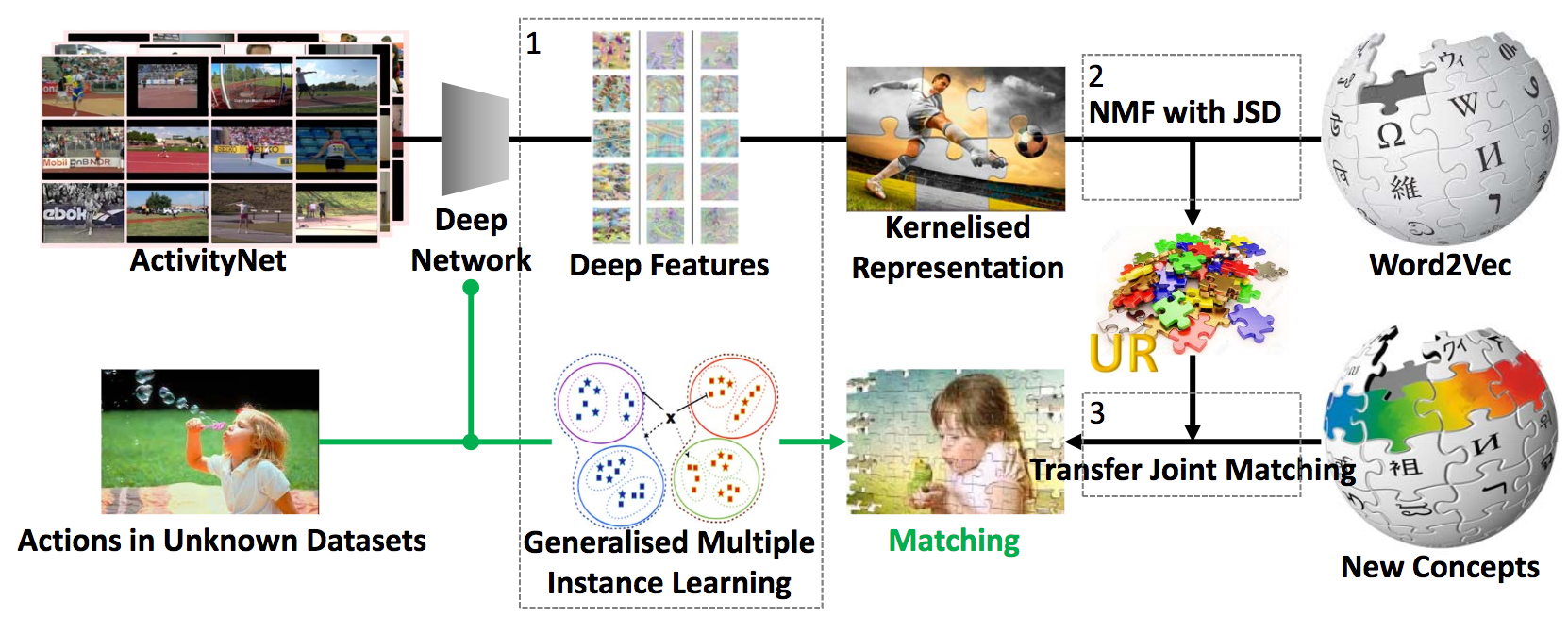

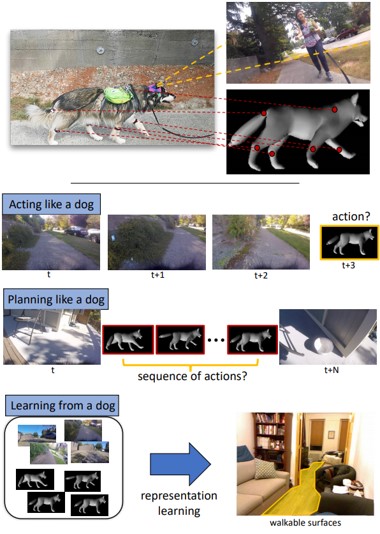

Pretext taskに特化したNNでのSelf-supervised学習(SSL)により獲得した特徴表現をtarget task用のNNに蒸留する手法。従来まではpretext taskに使用したモデルをそのままfine-tuningしていたのでモデル構造の制約が存在したが、二つのtaskそれぞれに適したモデルを選択することができる。さらにjigsawに対して、tailの一つを他の画像に置き換えることによりさらに難度を上げるjigsaw++を提案。

(a)従来通り何かしらのラベルなし表現学習。(b)ラベルなし特徴抽出&クラスタリング。(c)target taskモデルでクラスタ(pseudo labeling)識別。(d)target taskモデルで本学習。VggからAlexに蒸留した場合は精度向上。 同一モデル同士の蒸留はあまり効果がない。通常の蒸留よりもクラスタ識別させた方が効果がある。

Self-supervisedに獲得した特徴表現ではなくても(HOGでの実験が論文内にあるように)可能なアルゴリズム。単純に蒸留するよりもクラスタ識別にしたほうが良い精度以外での裏付けもみたかった。

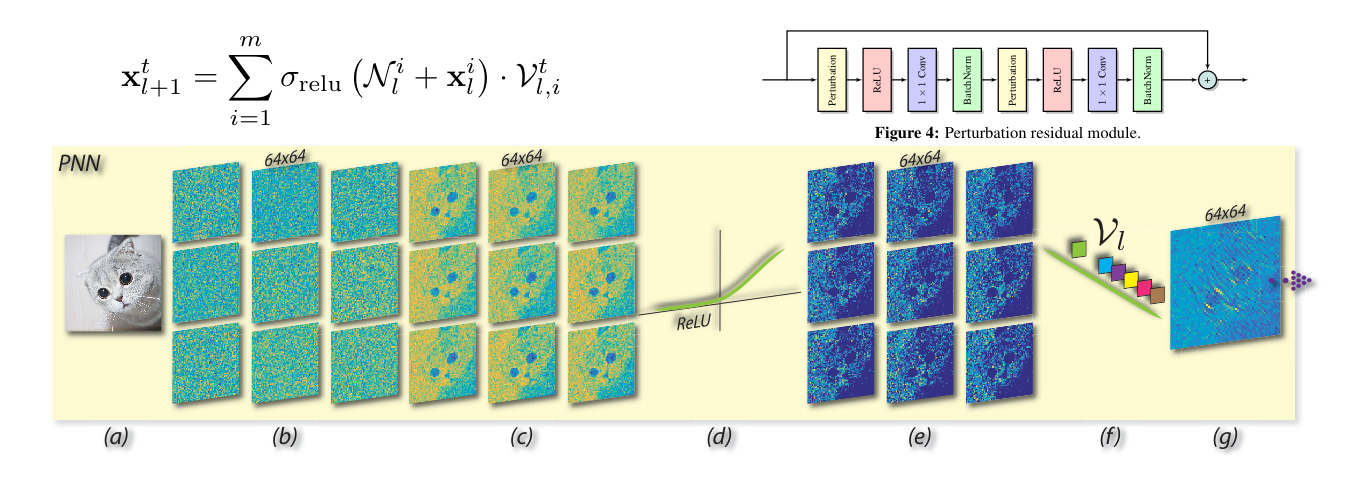

Pixel-wiseでの固定ノイズの加算=>ReLU=>1×1convというPerturbative layerを使用したPNNの提案。実験ではPerturbative residual moduleを用いたPNN-Resnetを使用してImageNet, Cifar-10のclassification、Pascal VOCのobject detectionによる評価でそこそこ良い性能を示した。結論としては、今回の実験結果から最適な画像認識用のNNはConvが必要であるとは限らないと言っている。

通常のconvの代わりに固定のhand-craftなカーネルを1×1convによる重み付けで近似し、計算コスト・学習パラメータの削減を行うLBCNNを元の発想としている。(固定カーネルがPixel-wiseでの固定ノイズの加算に変わっている)実質、 Perturbative layerでの受容野は1×1領域になるので論文中では(Convは使用しないため)Pooling層などで受容野を拡大すると述べられている。

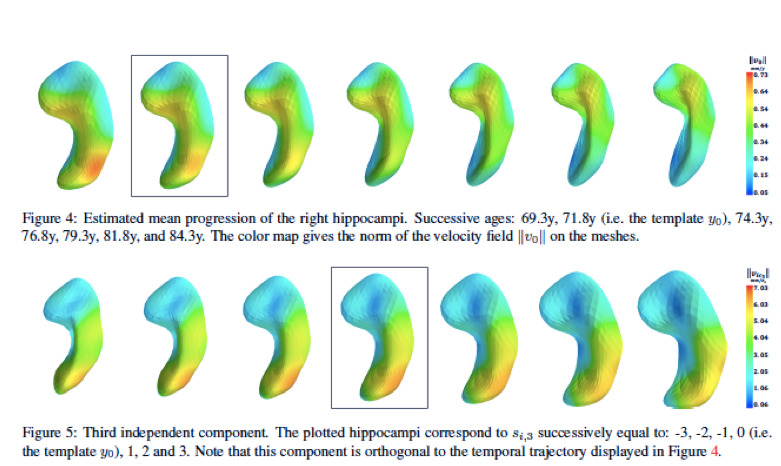

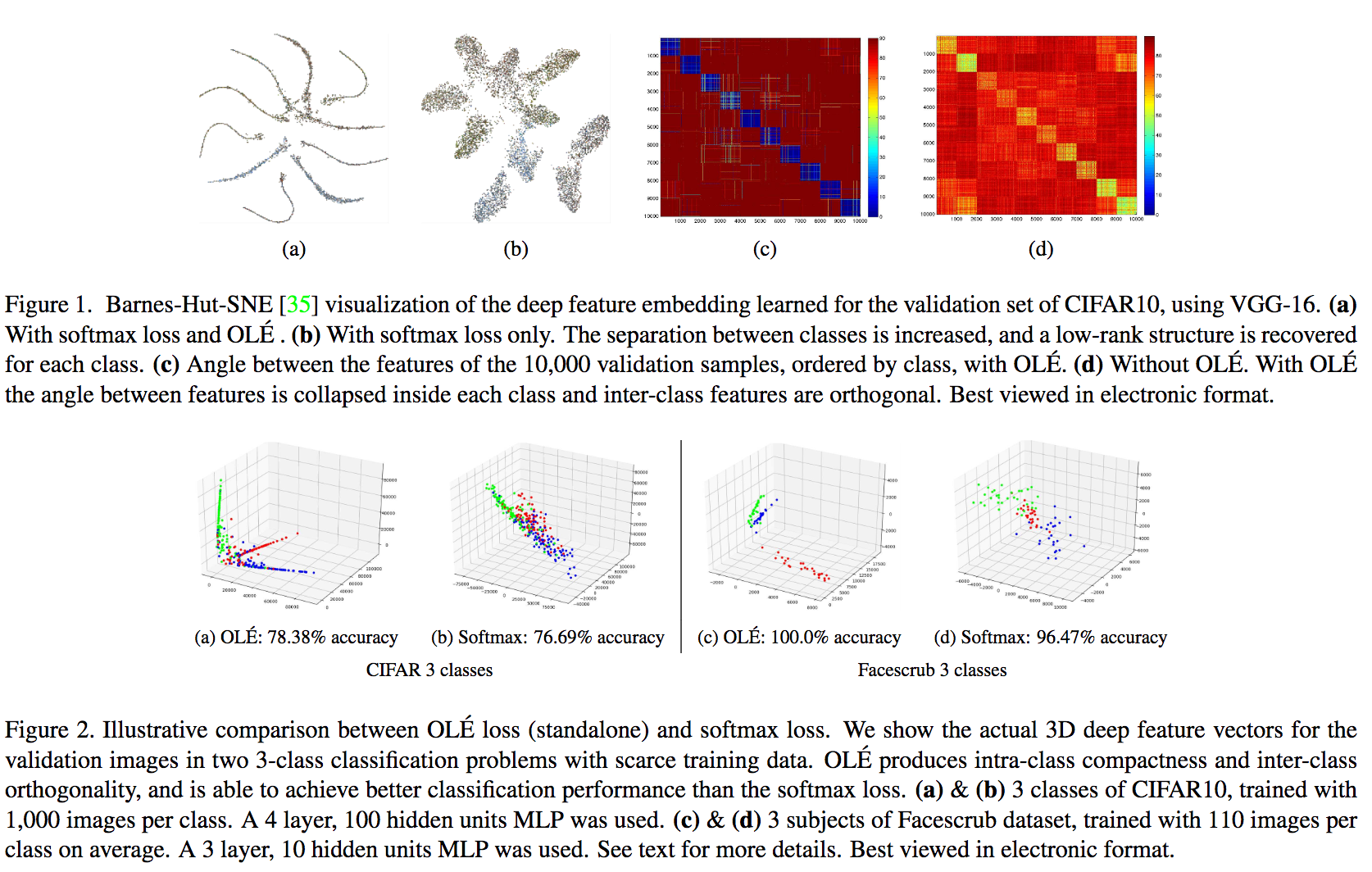

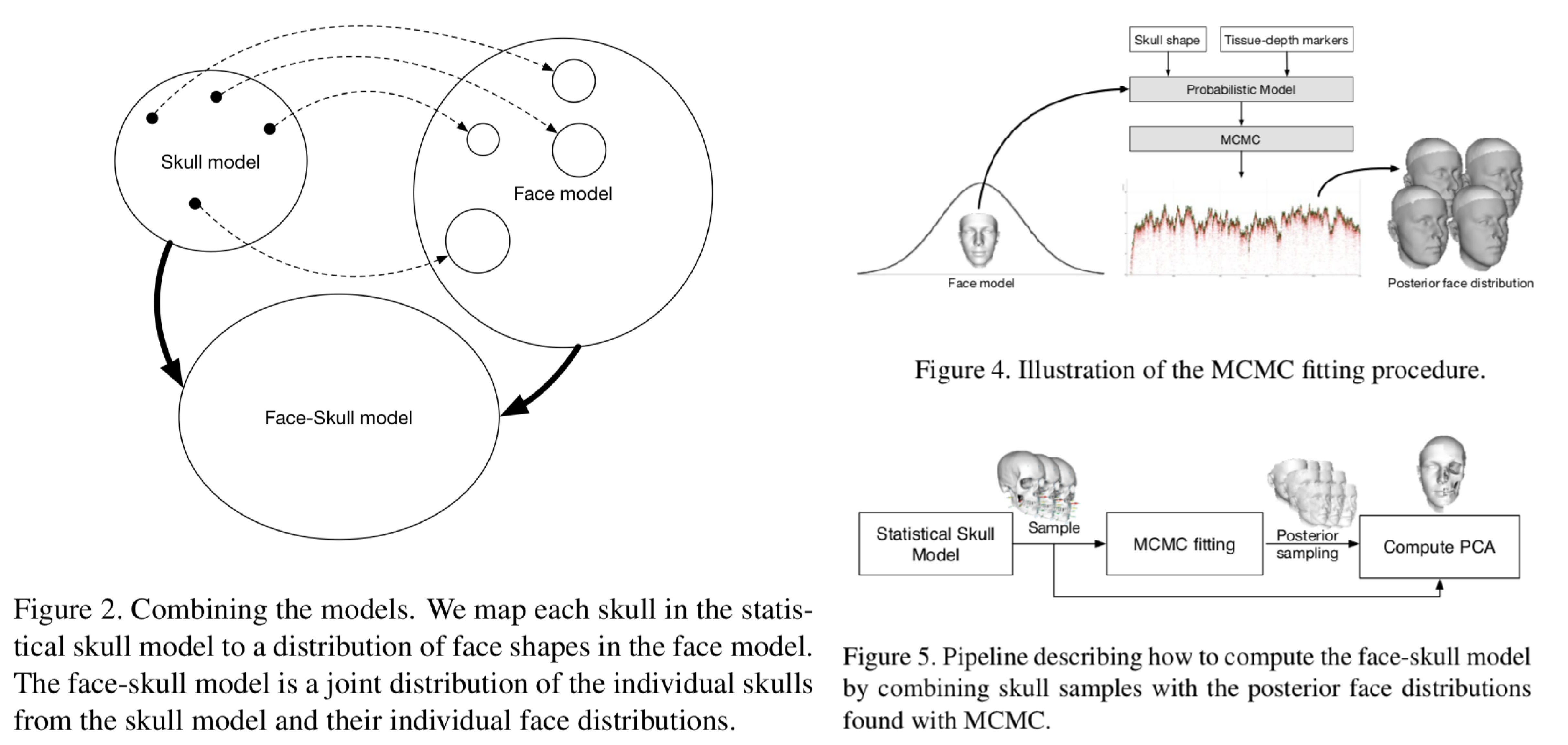

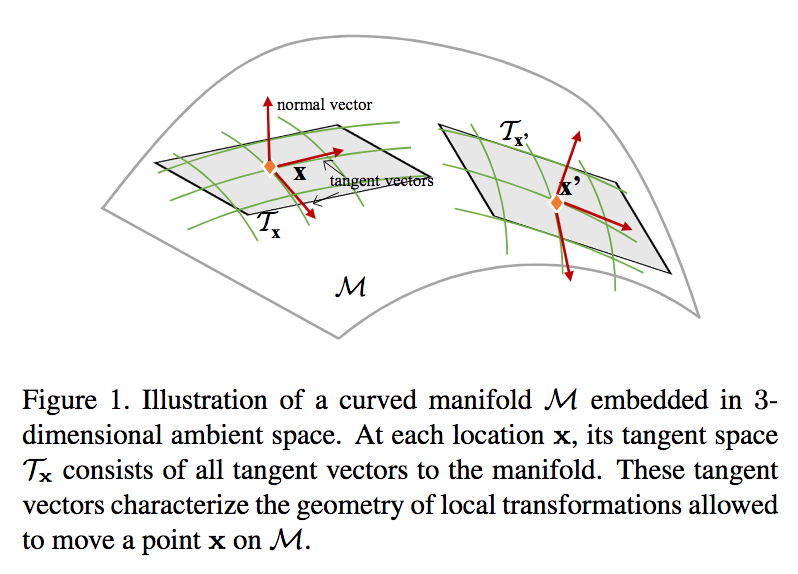

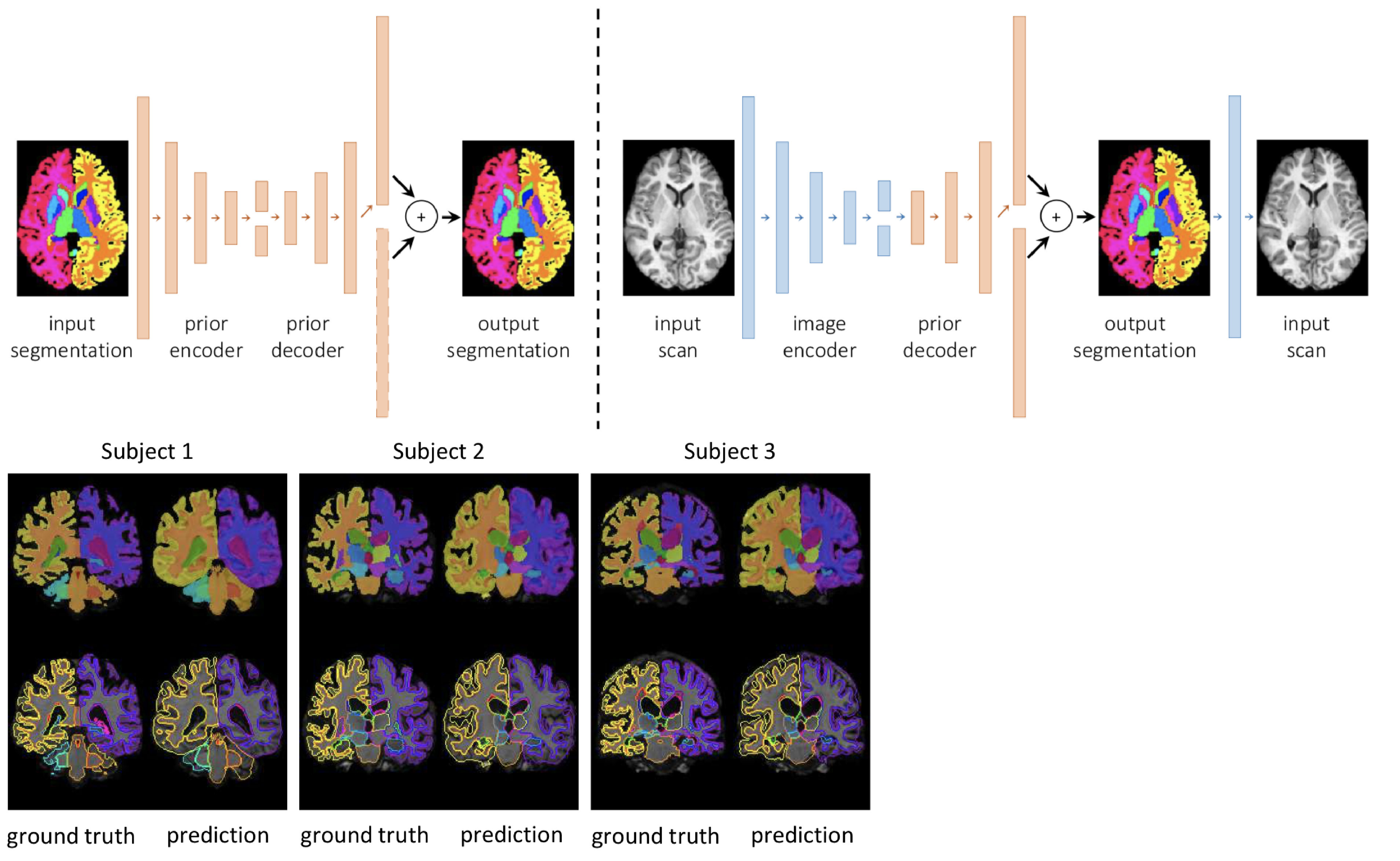

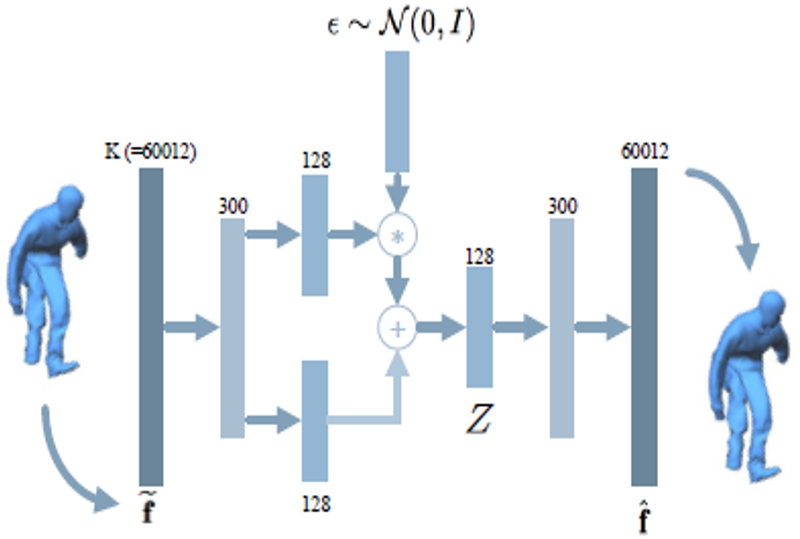

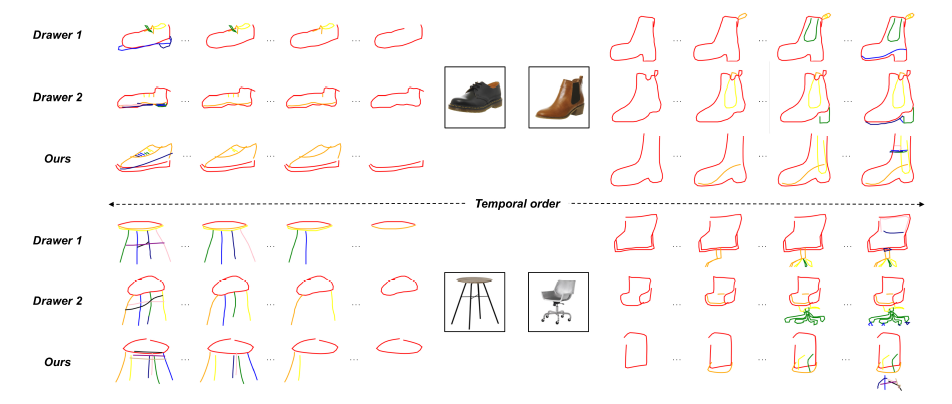

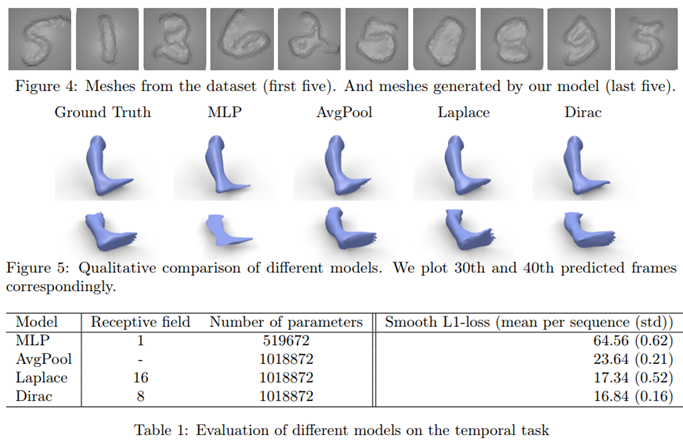

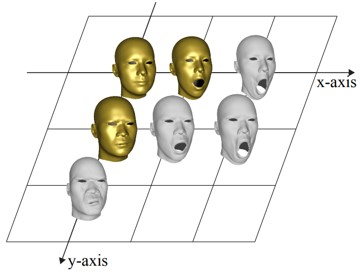

複数の時点で繰り返し観測される個々のオブジェクトの集合から形状軌道の分布を学習する方法を提案.非線形混合効果統計モデルを,マニフォールド値の縦方向データの一般統計モデル,マニホールド構造を持つ有限次元の微分同相写像を用いた形状軌道を定義する.評価実験では,アルツハイマー病の進行に関連した2Dシミュレーションデータおよび3D脳構造の大きなデータセットに関する我々の方法を検証し,時空間パターンを分類する.

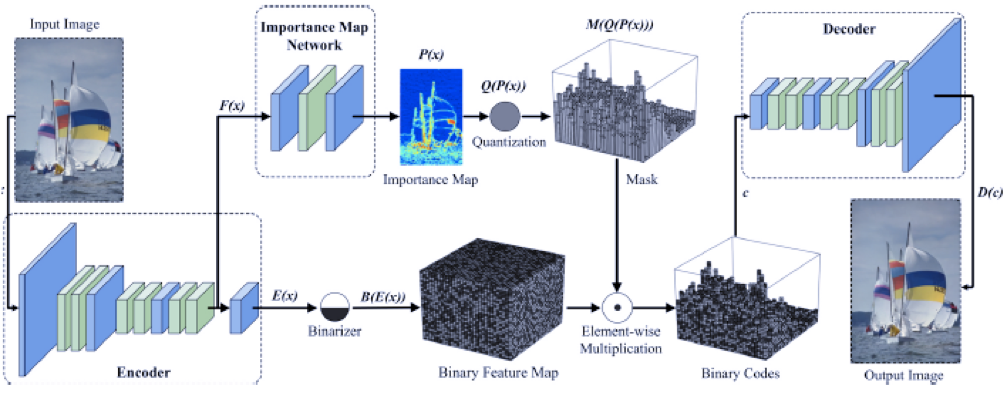

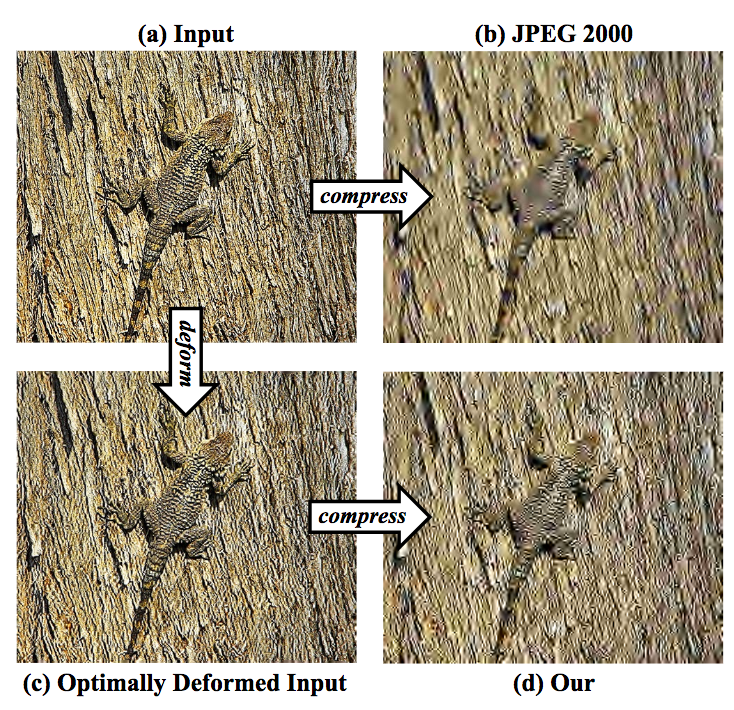

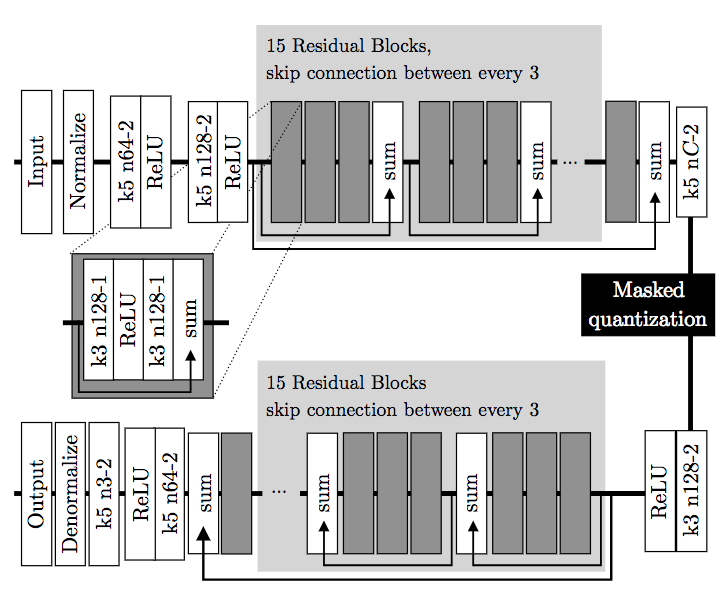

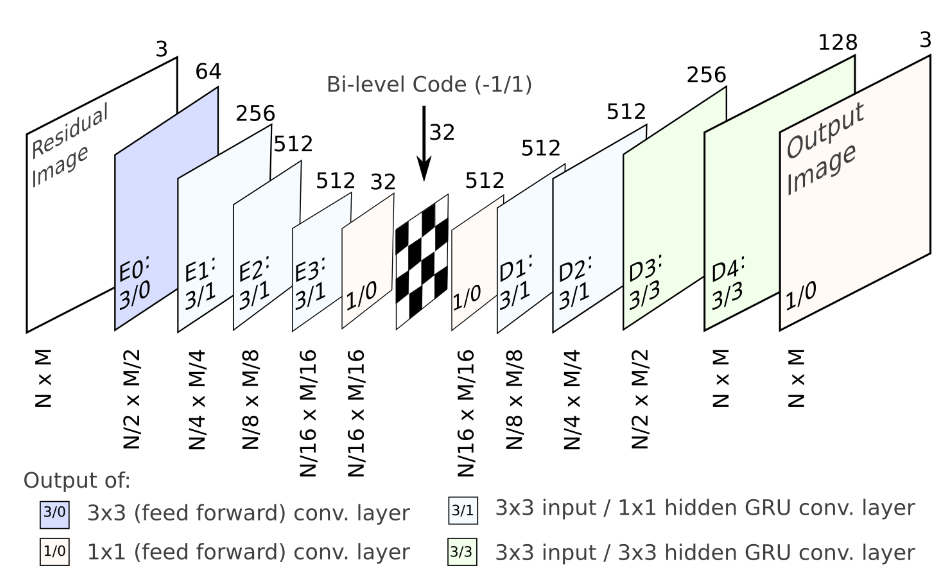

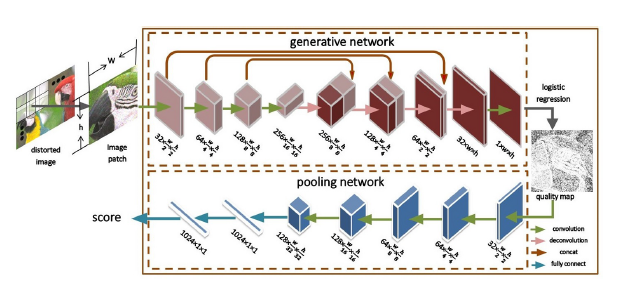

画像圧縮はエンコーダー,デコーダー,量子化器を学習することによるジョイントレート –と歪みとの間の最適化問題として定式化される.CNNベースでの画像圧縮システムを開発することは困難とされているが本論文では,情報コンテンツが画像内で空間的に変わっているという動機づけによって画像空間の重要度マップを作成した,これらの合計を圧縮率を制御するための離散エントロピー推定の連続的代替とした.造類似性(SSIM)における評価としてJPEGおよびJPEG2000よりも著しく優れており,鮮明なエッジ,豊かな質感,および人工っぽさの少ない非常に優れた視覚的結果が得られることが実験によって示されている.

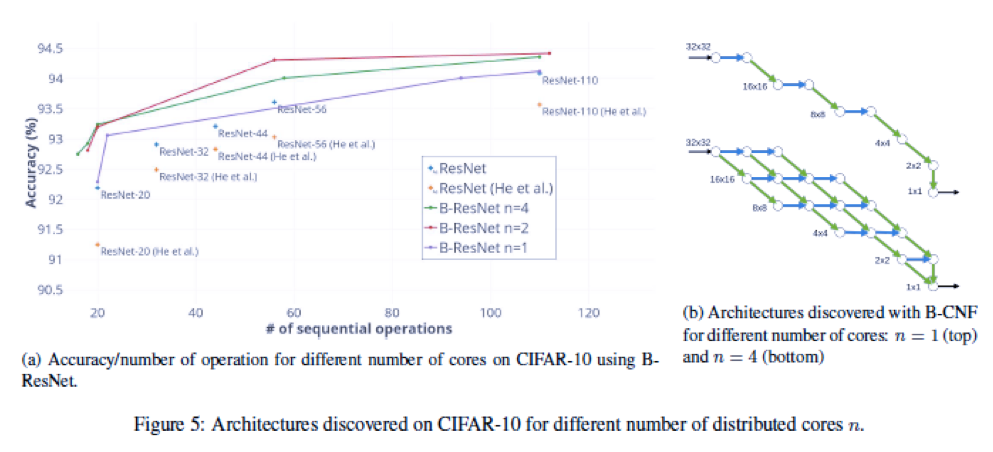

研究指針の1つとして予測の質に加えて推論コストを考慮に入れることがある.本研究では,予測品質とコストの両方に関して効率的なニューラルネットワークアーキテクチャを発見する問題に焦点を当てるためにBudgeted Super Networks(BSN)と呼ばれるモデルを提案.計算コスト,メモリ消費コスト,および分散コストの3つのコストに対応する技術の能力を分析.

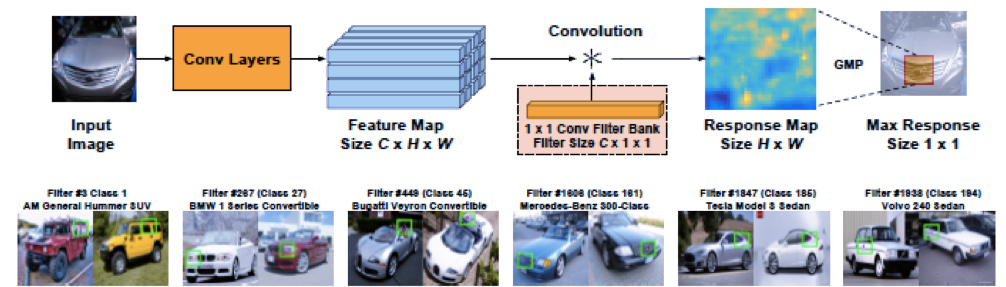

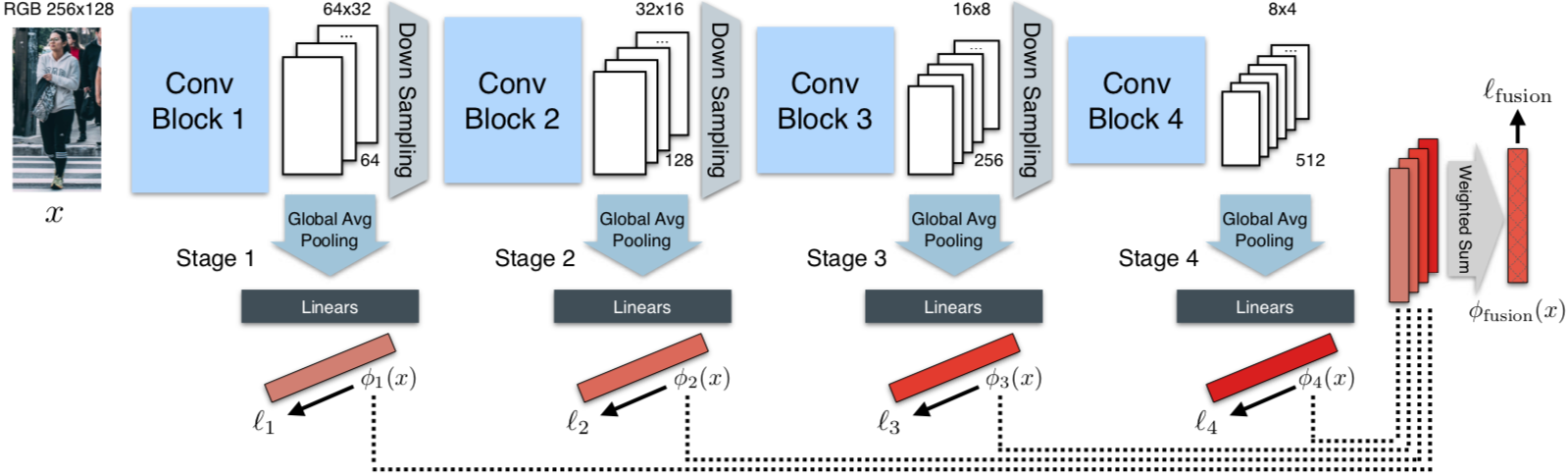

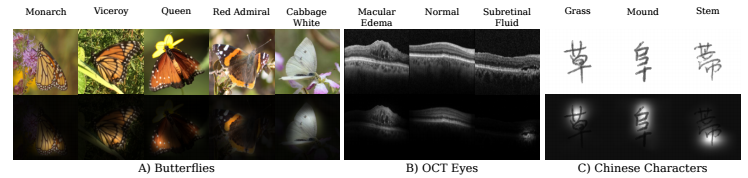

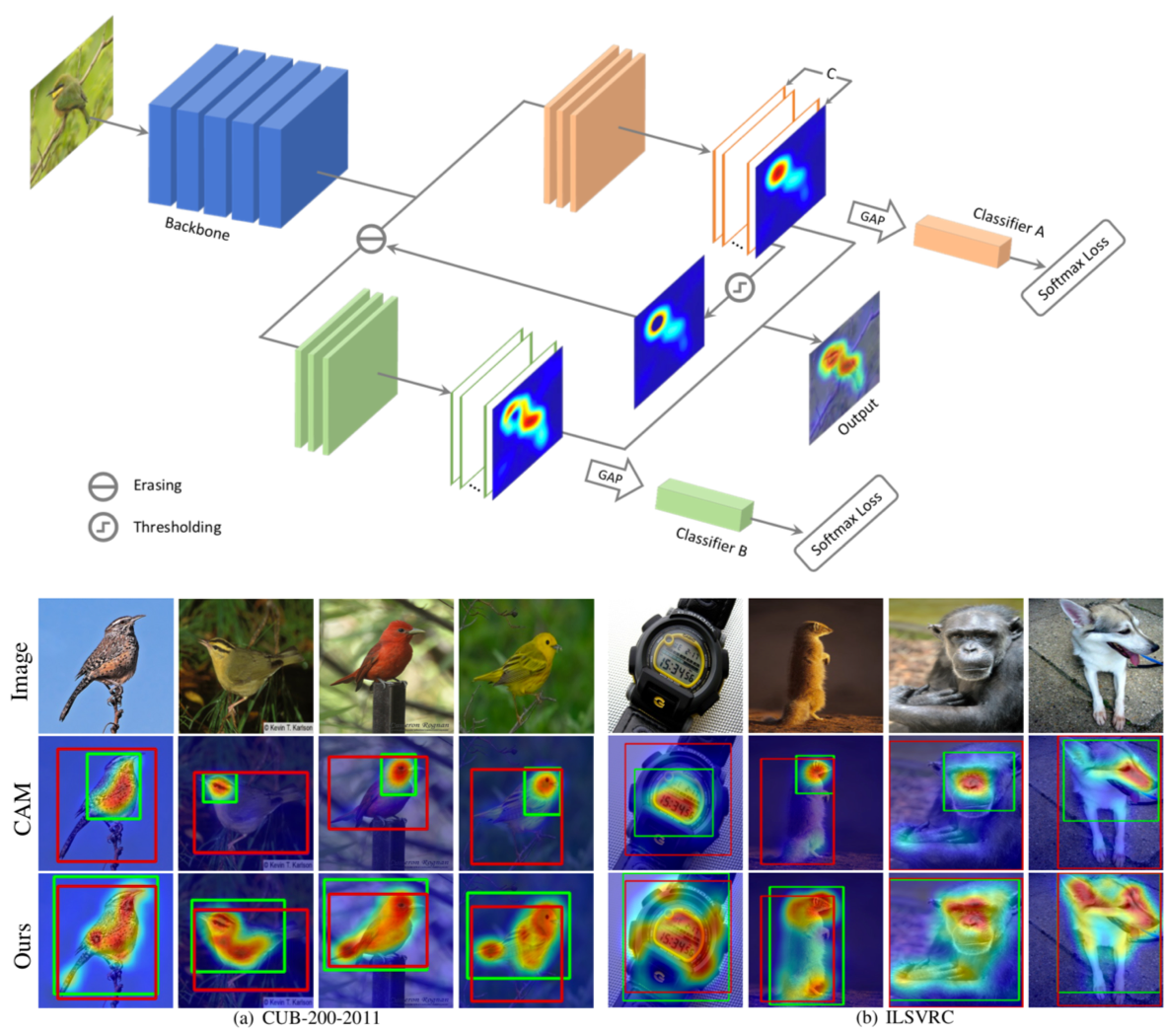

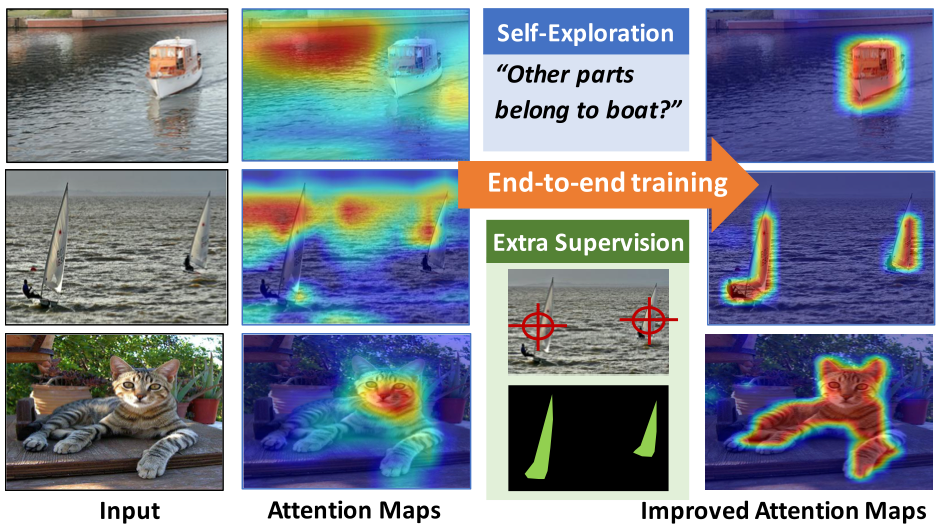

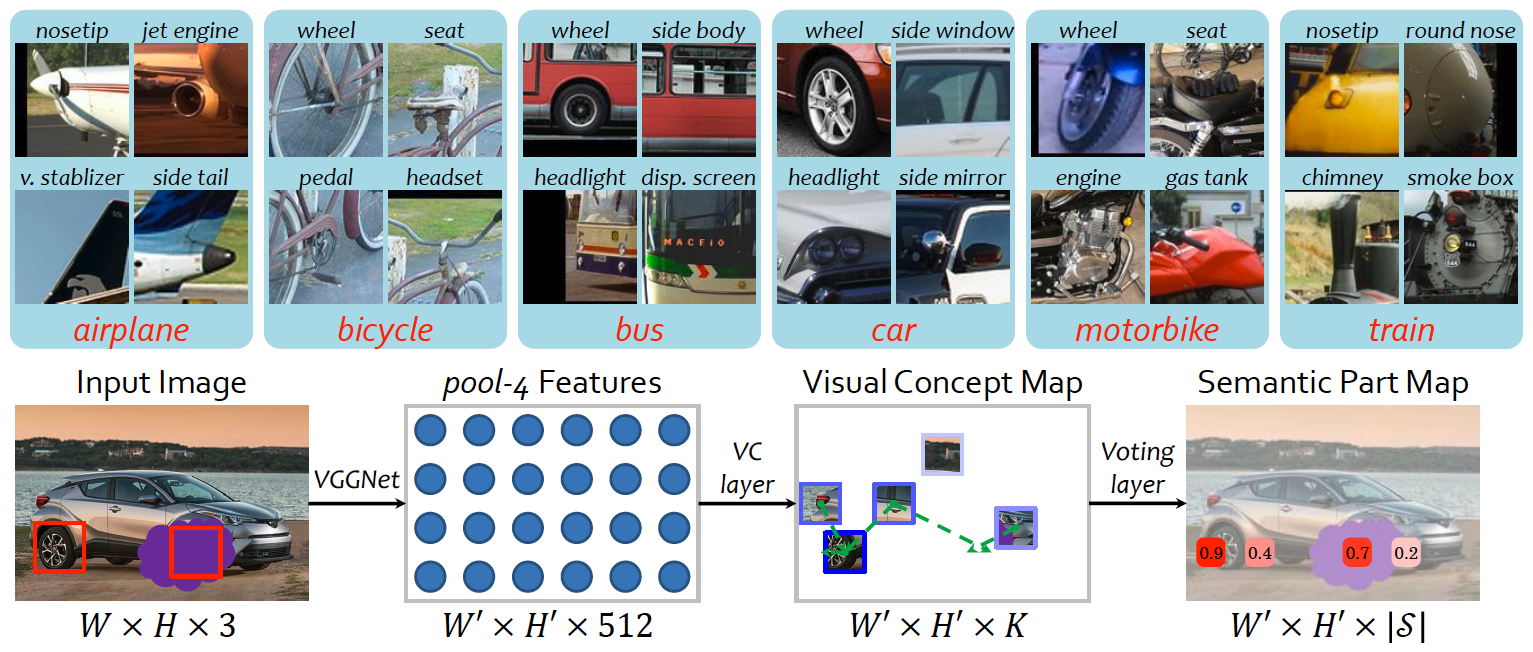

本研究では,fine-grained認識でクラス固有の識別パッチを余分な部分や境界ボックスの注釈なしにキャプチャする畳み込みフィルタバンクを学習する.このことで,中間層の表現学習がCNNフレームワーク内で強化されることを示す. 一般的なfine-grained認識のデータセットを対象に評価実験をしたところSoTAを達成.

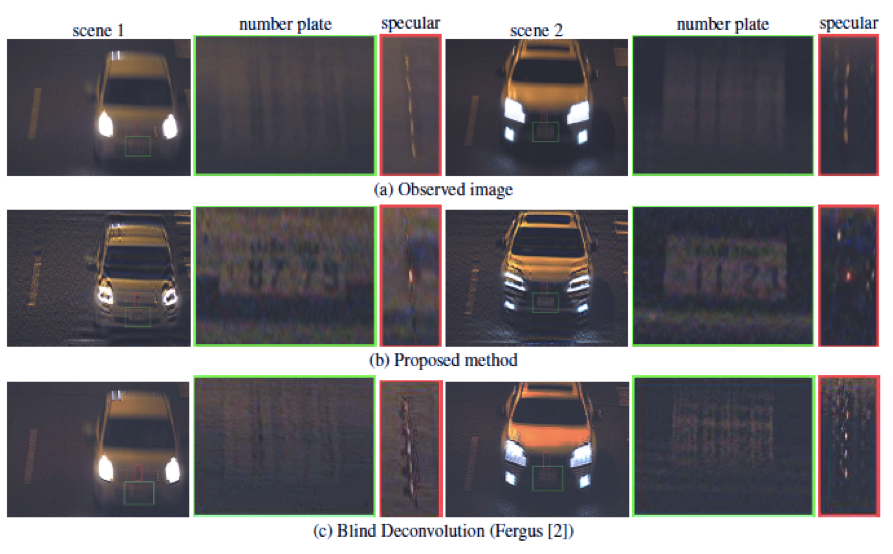

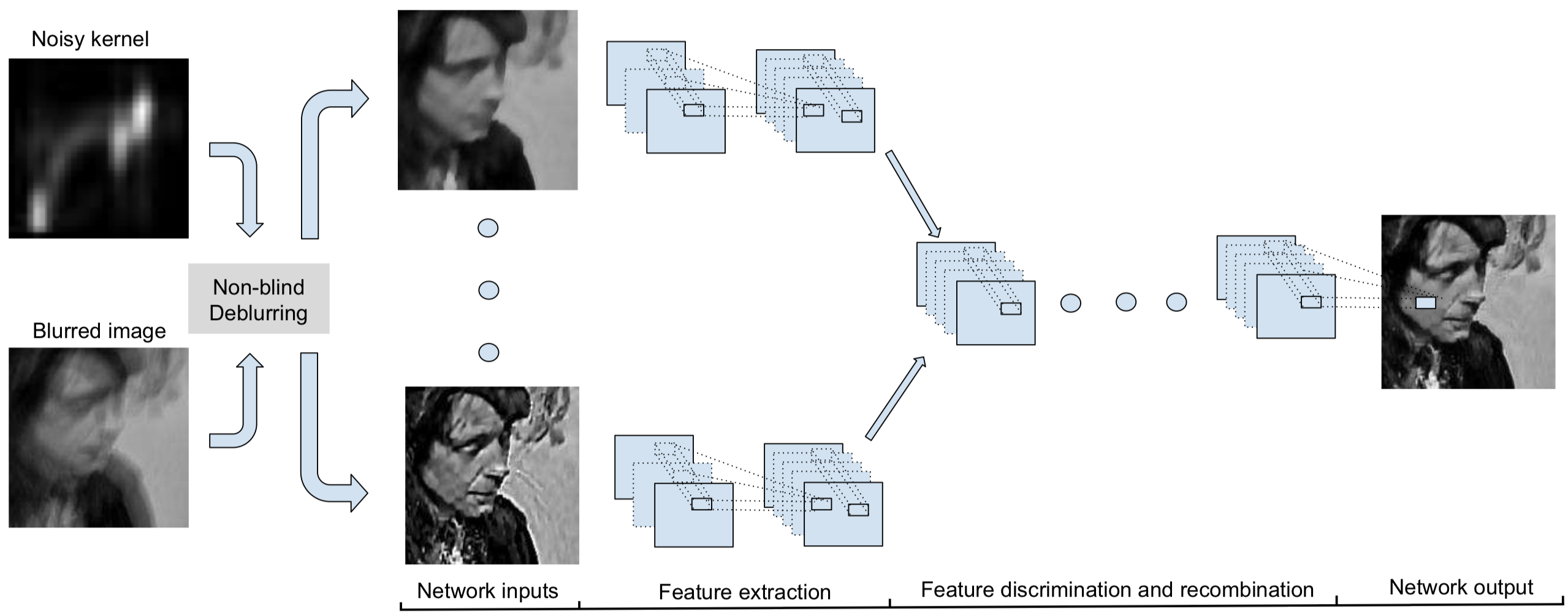

蛍光灯などの光の見づらいフリッカー模様は市販のカメラと鏡面反射を伴う動く物体の単純な組み合わせによって観測することができることを示し,抽出されたフリッカー模様に基づいて画像内の動きのぼやけを除去するための効率的な方法を提案する.環境光のフリッカー模様により誘発される高い周波数特性と画像のブレを除去することが可能になる.

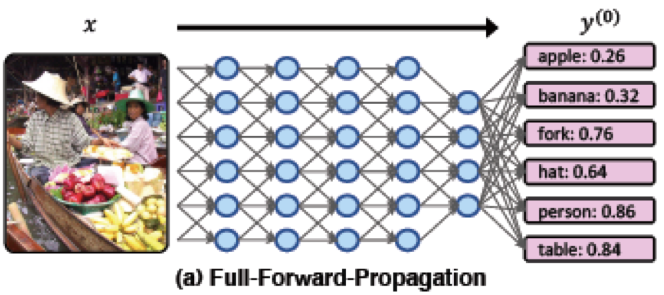

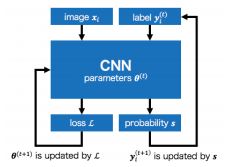

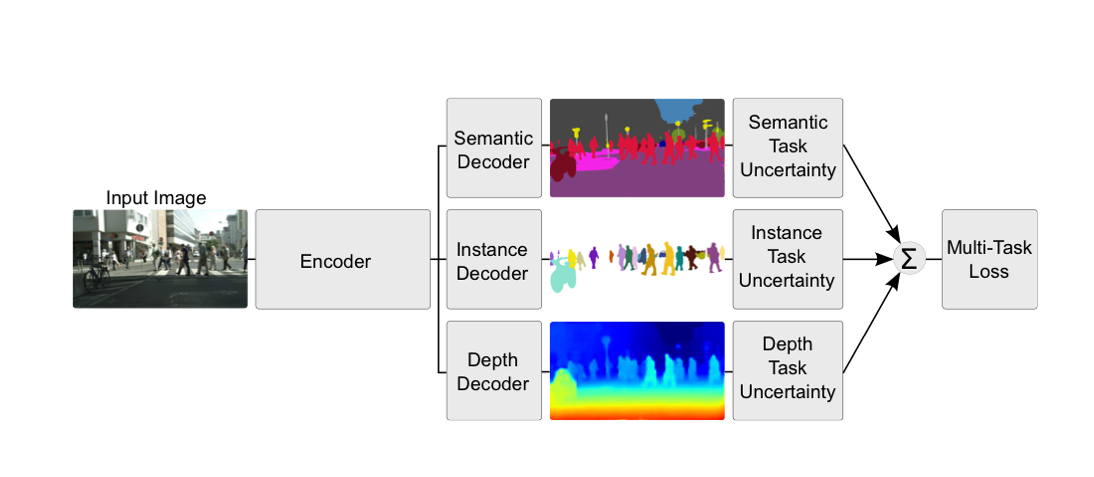

既知ラベルが利用可能であるときに、深い畳み込みニューラルネットワーク(CNN)のための推論手順を提案.一般的なフィードバックベースの伝搬手法で重なり合わない任意の組のターゲットラベルの値が分かっている場合に,未知のターゲットラベルの任意の組の予測精度を向上.マルチタスクモデルを使って実験し,feedback-propがすべてのモデルで有効であることを示す.

以下の3つのステップで構成されている.

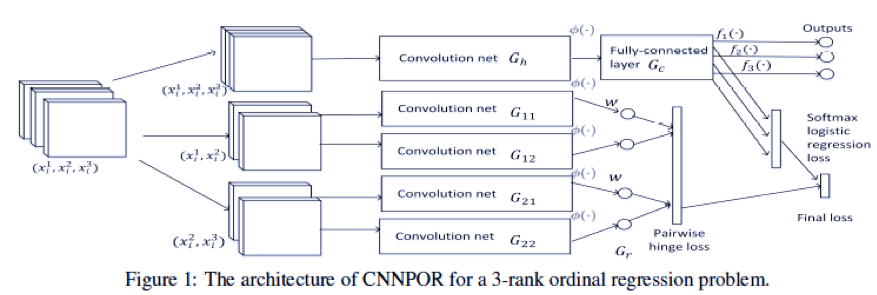

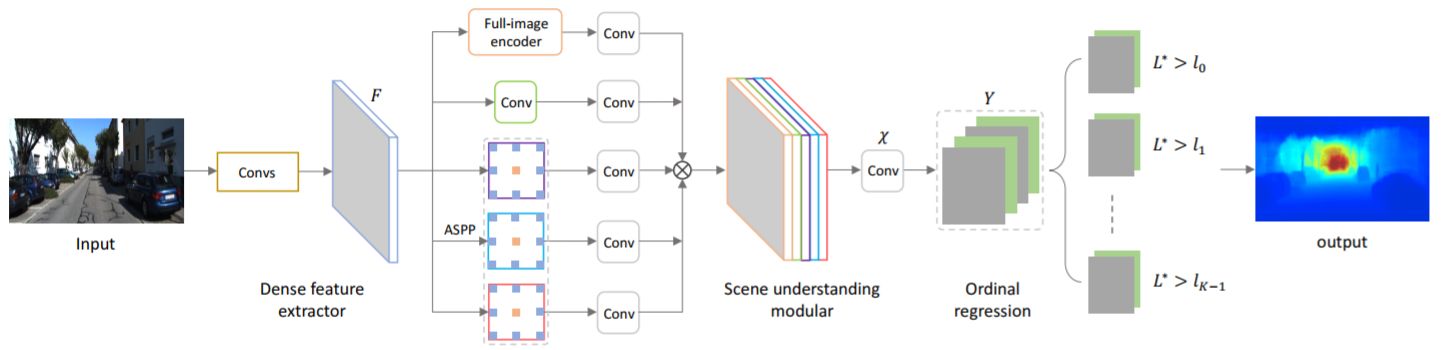

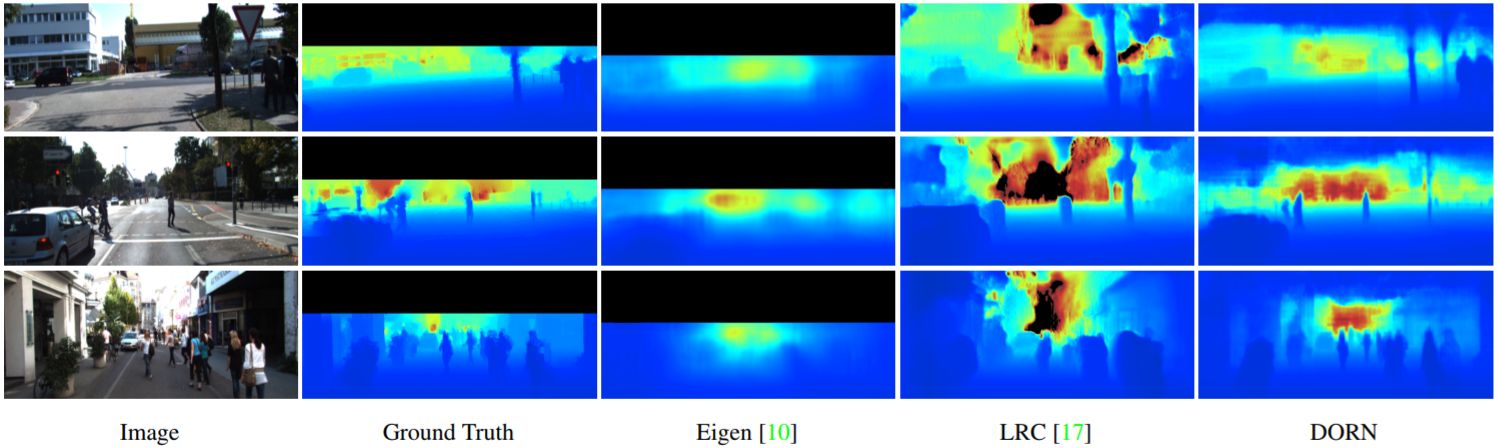

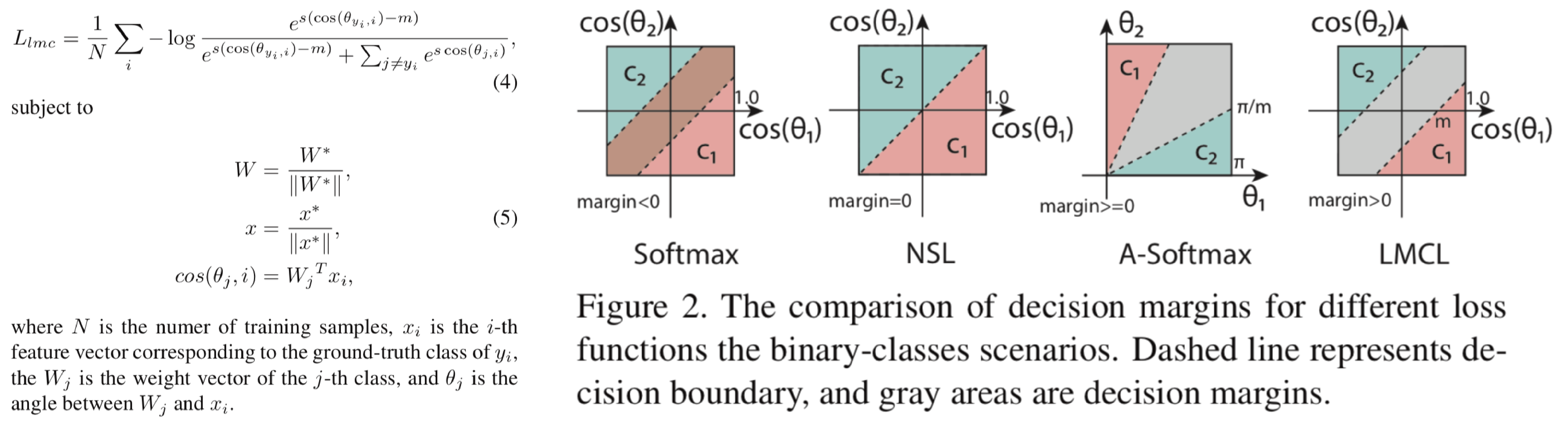

順序回帰は、インスタンスをを順序カテゴリに分類することを目的とした教師付き学習の問題である.クラス内情報を表現するための高次な特徴と,序数関係を同時にクラス分けするための機能を自動的に抽出することは困難である.そのためにCNNによる実装が考えられる.本研究では,インスタンスの順序関係によって制約される複数のカテゴリの負の対数尤度を最小にする序数回帰問題の制約付き最適化手法 convolutional neural network with pairwise regularization for ordinal regression (CNNPOR)を提案.4つのベンチマークを用いて実験し,CNNPORは既存手法よりも良い結果であり,SoTAを示した.

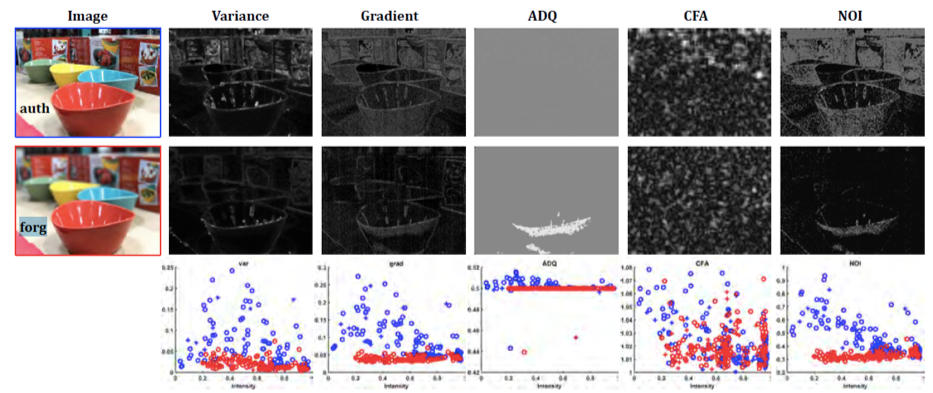

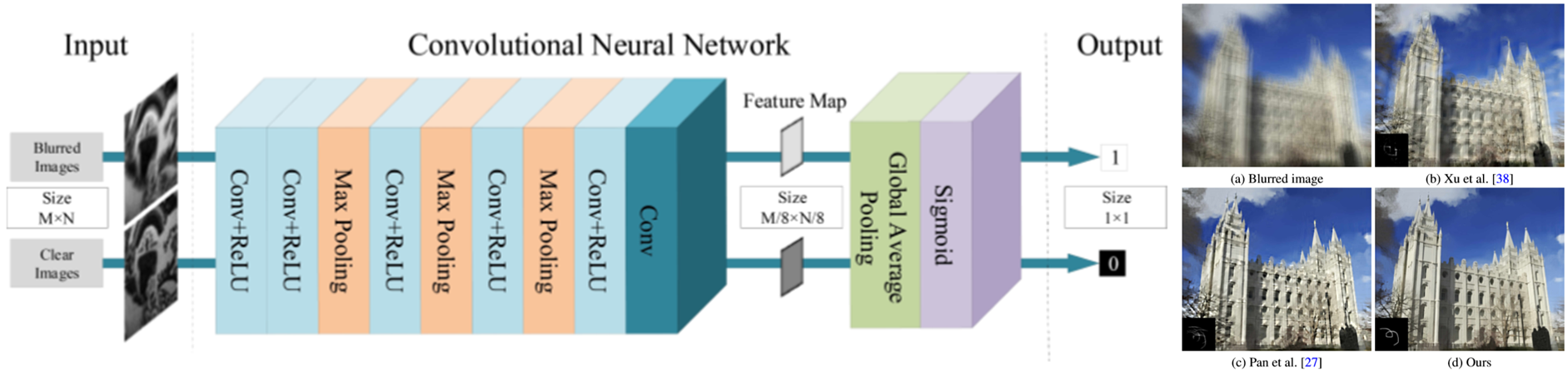

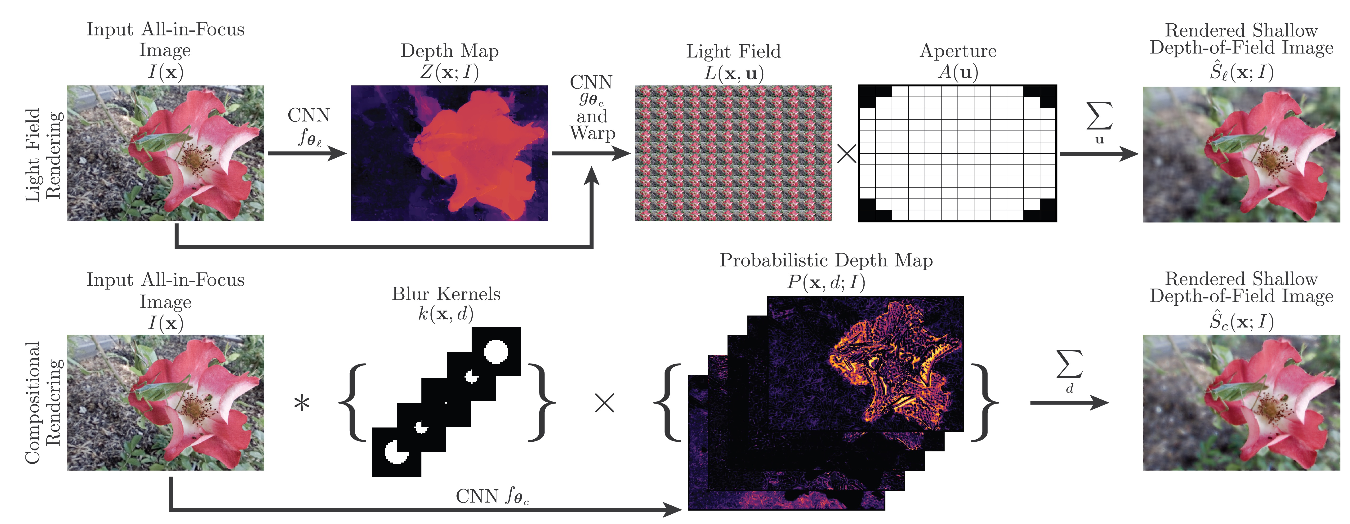

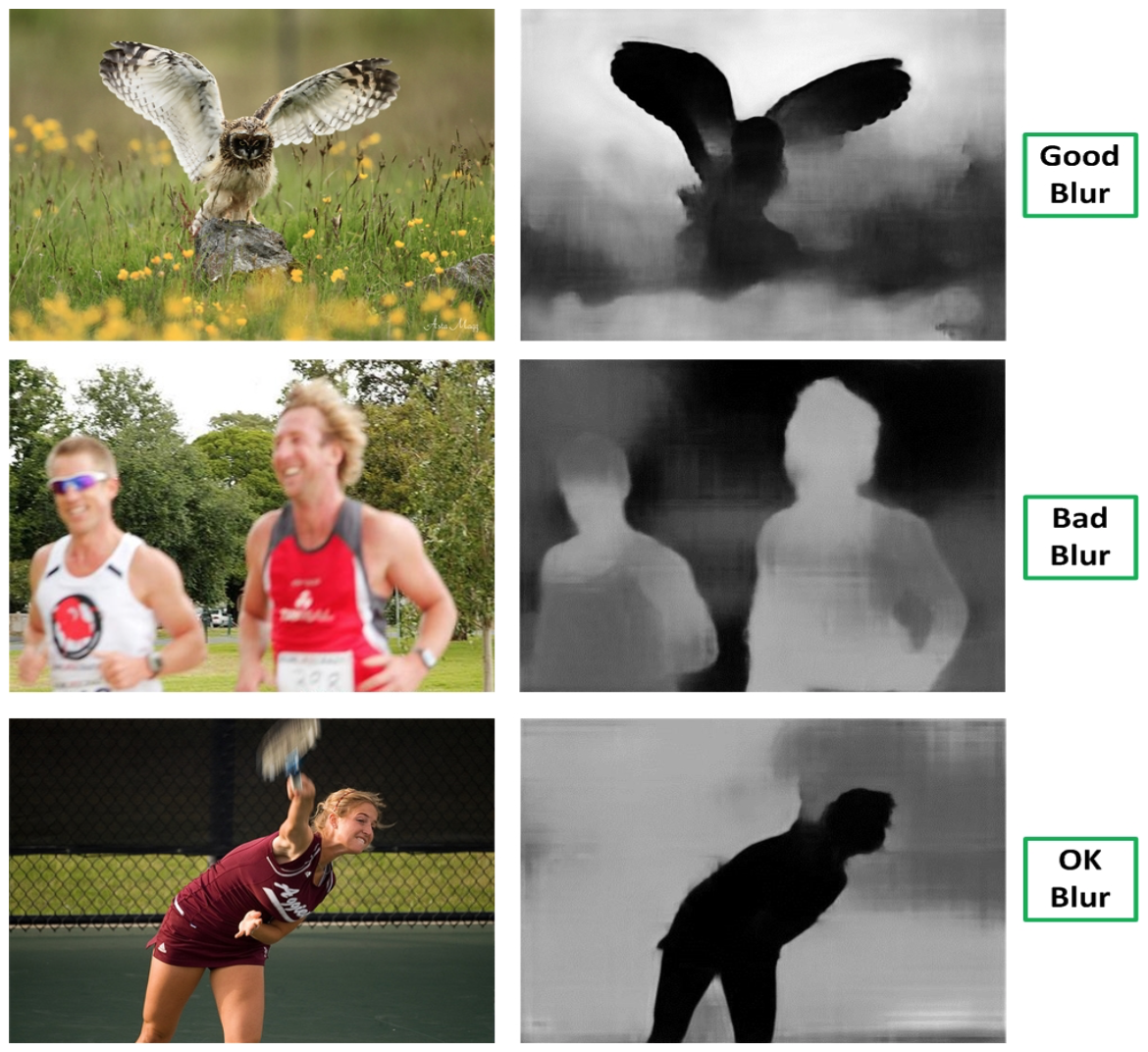

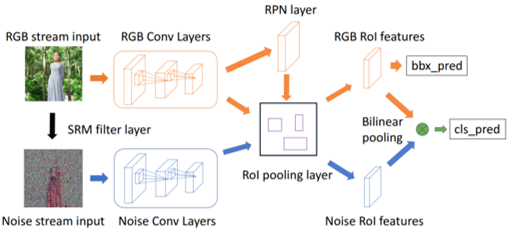

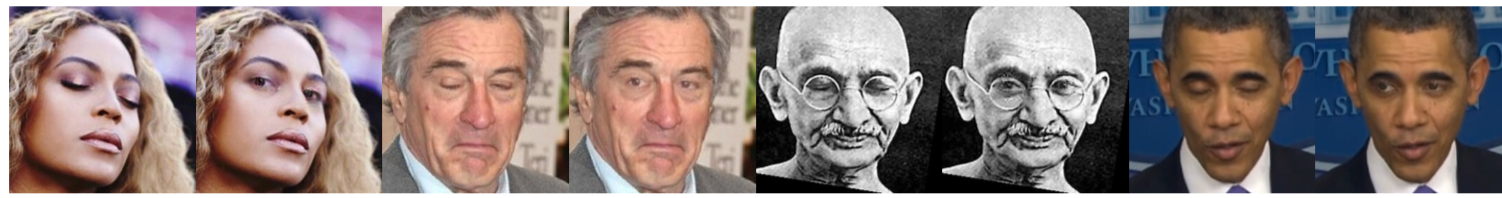

近年画像操作ツールの自動化とリアリティの向上によってソーシャルメディアの誤った情報が増えているため,画像の捜査が重要になる.本手法では画像の人工的なぼかしによる加工を検出し、画像強度と様々な手がかりとの間に非相関な測光関係を生成する.iPhone7Pulsなどのポートレートモードの画像の新しく収集されたデータセットと野外の画像の一般的なデータセットの両方で評価実験をしたところ,既存の手法を上回った.

光度ヒストグラム分類のための小さい2つのCNNを融合することで手がかりを統合する.このことで,自然な画像の非対象部分をぼやかせる浅い被写界深度DoFを持つ画像を区別するため画像の捜査方法を提案

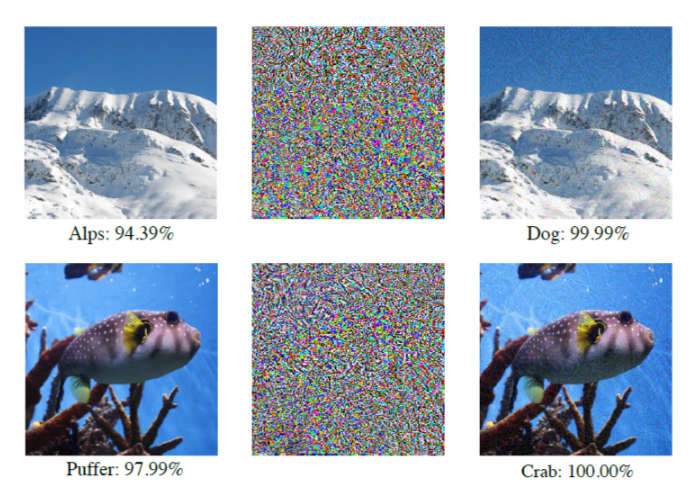

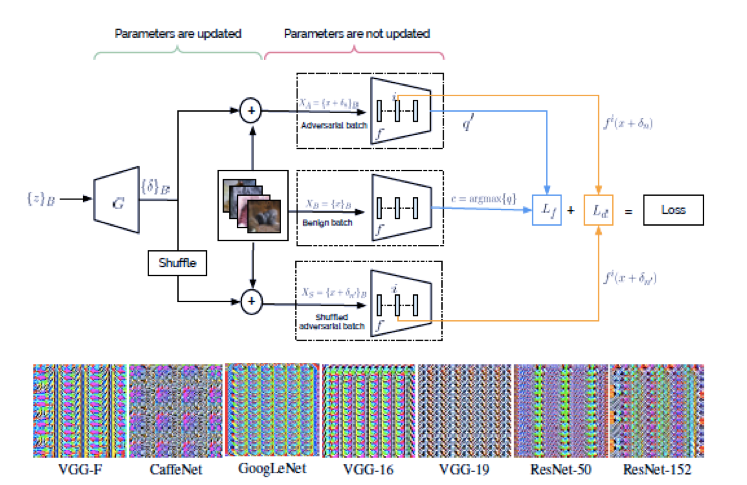

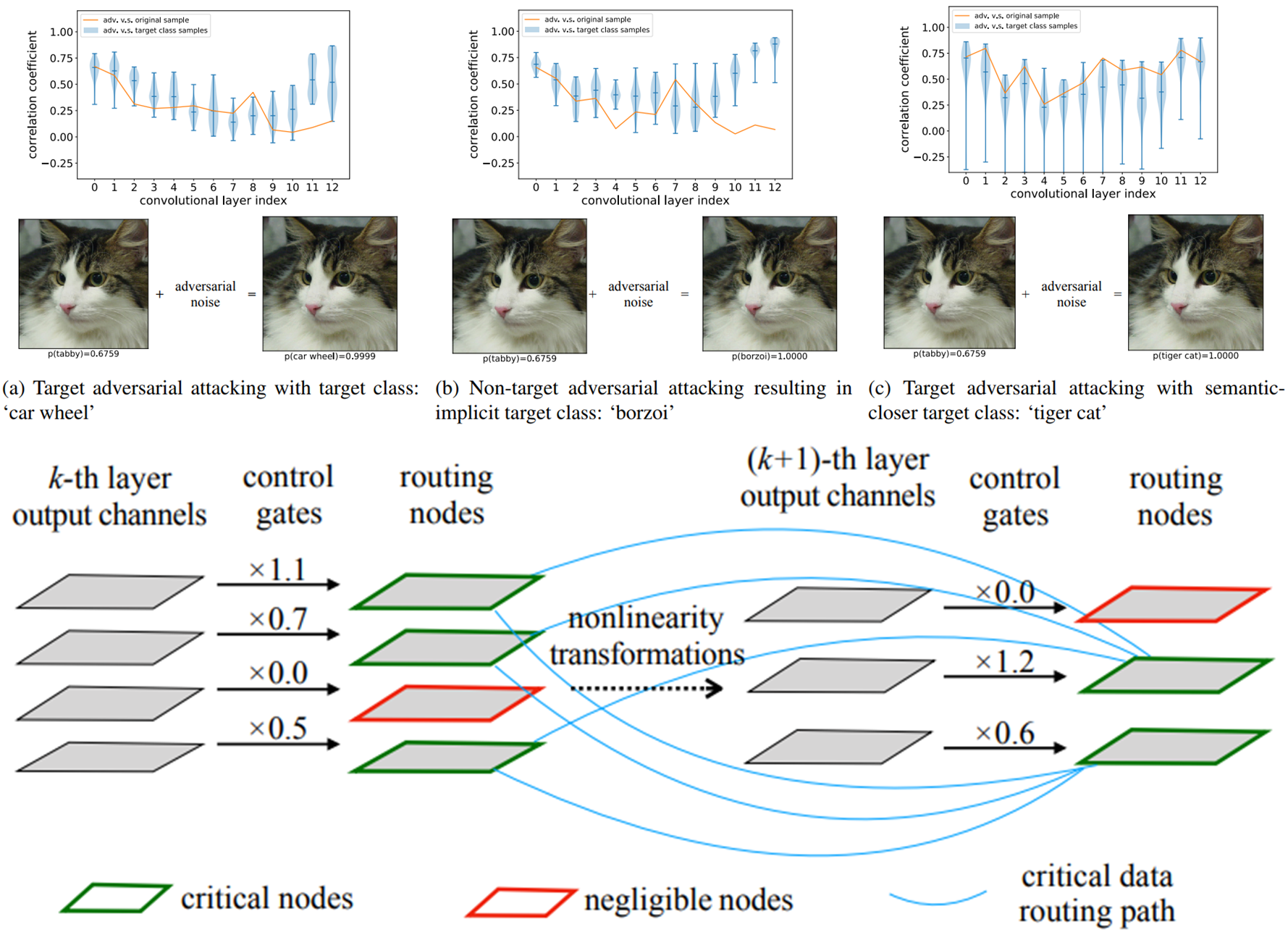

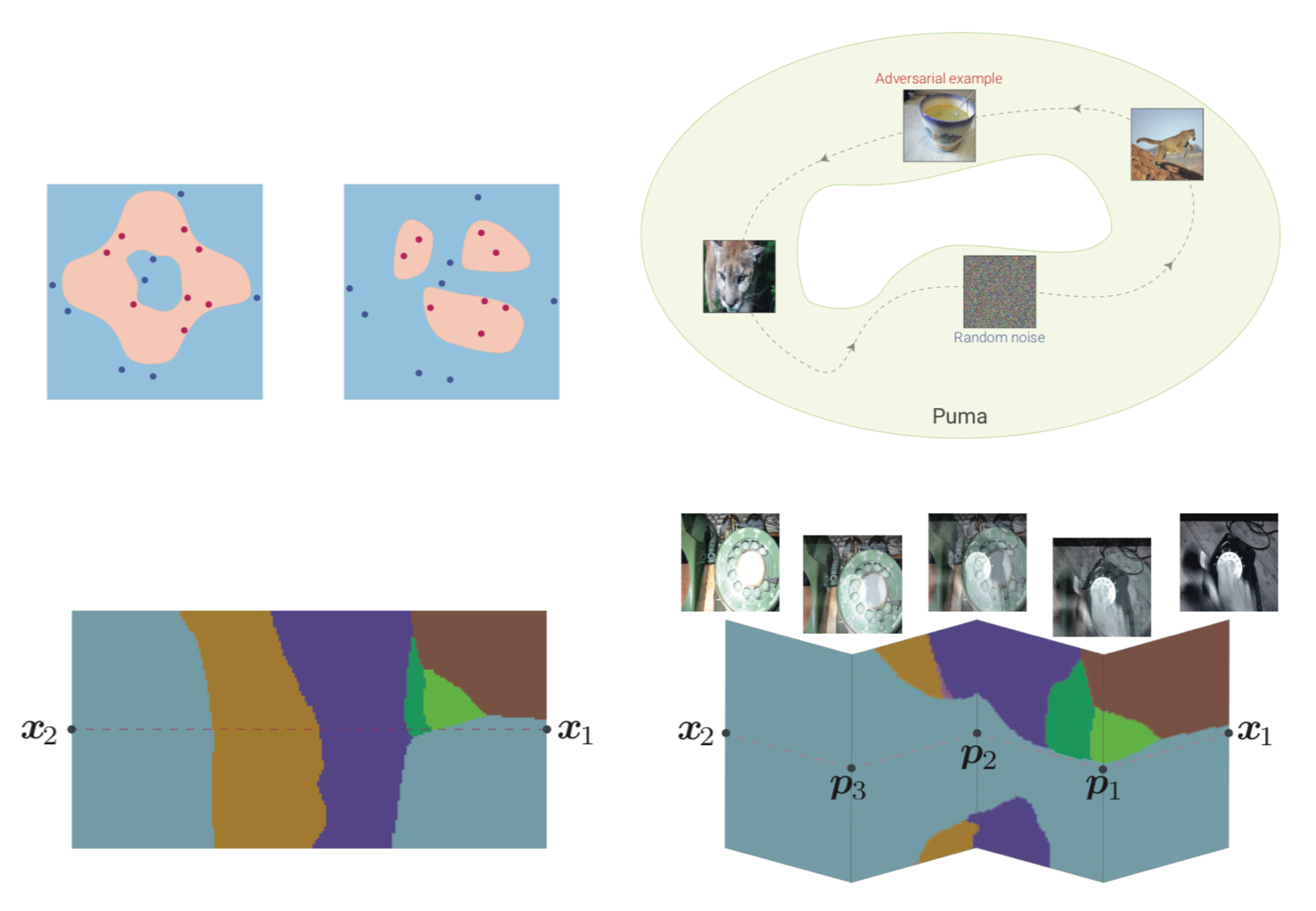

DNNsは,アルゴリズムに対するセキュリティ上の懸念をもたらす,敵対的な攻撃に対して脆弱である.敵対的攻撃は,ディープ・ラーニング・モデルが展開される前の頑健性を評価する重要な代理として機能する.しかし,既存の攻撃の大半は精度の低いブラックボックスモデルしかだますことができない.この問題に対処するため,反撃攻撃を促進するために,運動量ベースの反復アルゴリズムの幅広いクラスを提案する.攻撃の成功率を向上させるために,モンテウム反復アルゴリズムをアンサンブルモデルに適用し,強力な防御能力を備えた対抗的に訓練されたモデルも攻撃に対して脆弱であることを示す.提案された方法は,様々な深いモデルや防衛方法の頑健性を評価するためのベンチマークとして役立つと考えられる.

Ensembleの敵対的訓練は、訓練されたモデルだけでなく、他の拘束モデルからも生成された敵対的なサンプルを用いて訓練データを補強する.したがって、アンサンブルの訓練を受けたモデルは、ワンステップ攻撃とブラックボックス攻撃に対して堅牢である.本稿では,ブラックボックスモデルだけでなくホワイトボックスモデルを効果的に欺くことができる反撃攻撃を促進するための,広範なモーダルベース反復手法を提案する.この手法は,一段階のグラジエントベースの方法とバニラの反復法を一貫してブラックボックス方式より優れている.本研究では提案された方法の有効性を検証し,それらが実際に働く理由を説明するために広範な実験を行う.生成された敵対的な例の転送可能性をさらに向上させるため,ログが融合されたモデルのアンサンブルを攻撃することを提案する.アンサンブル敵対的訓練によって得られたモデルはブラックボックス攻撃に対して脆弱であり,より堅牢な深い学習モデルの開発のための新たなセキュリティ問題を引き起こすことを示している.

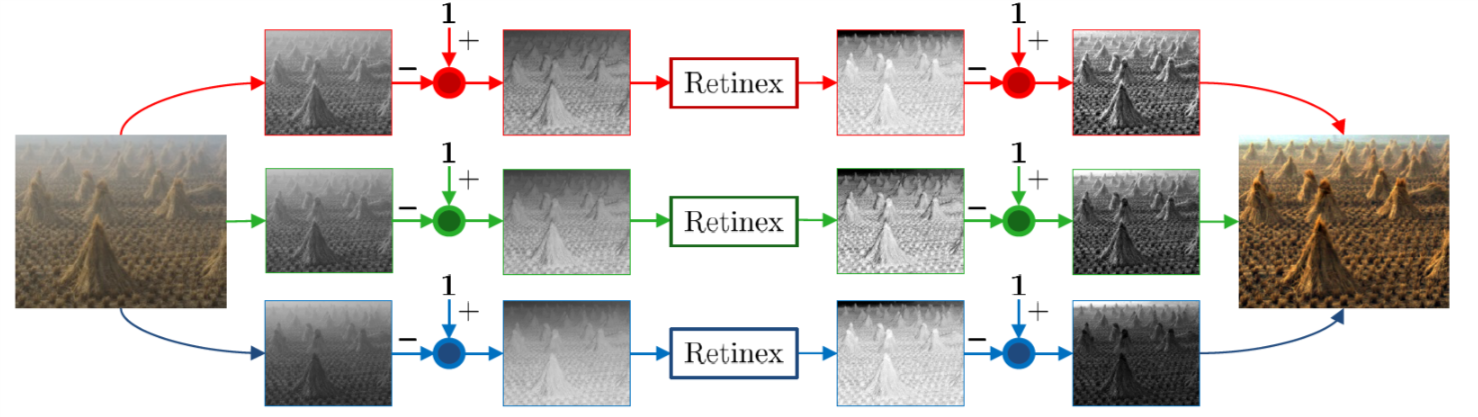

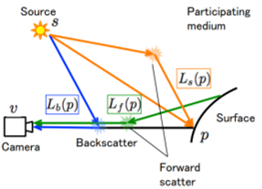

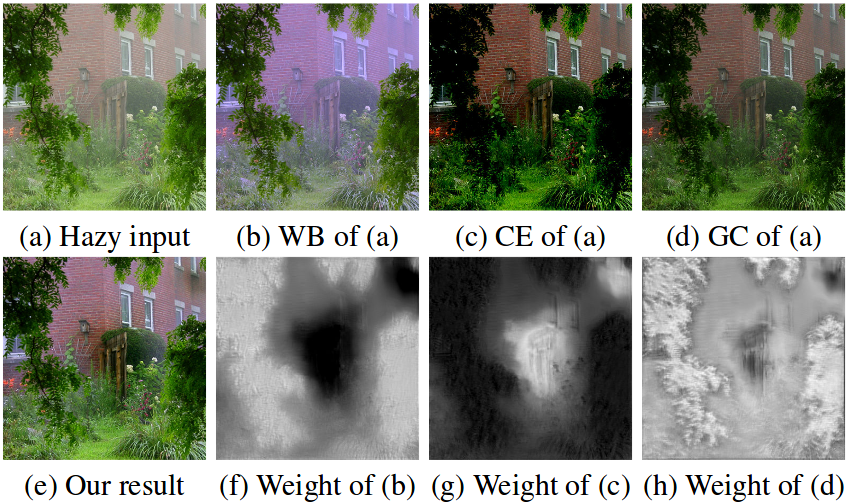

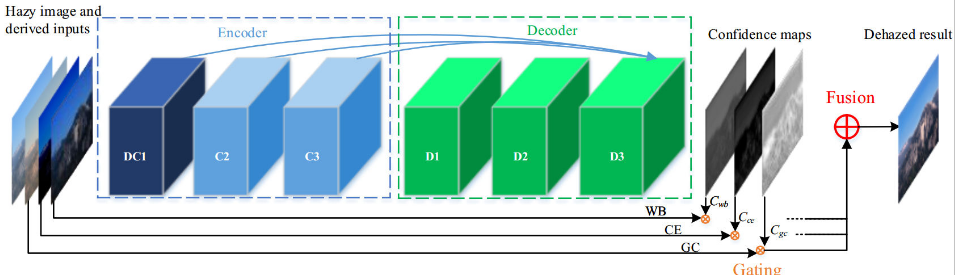

画像曇り除去は,霧の存在による屋外画像における望ましくない可視性の喪失の除去を扱う.ほとんどのRetinexベースのアルゴリズムは,常に明るさを上げるという特長を持っている.これは、輝度が反転したぼやけた画像にRetinexを直接適用することにより,効果的な画像の曇り除去ができる可能性があることを示している.この論文では、反転強度に対するRetinexが画像の曇りの問題に対する解決策であるという理論的証明を行う.包括的な定性的および定量的結果は,Retinexのいくつかの古典的で現代的な実装が,より複雑なフォグ除去法と対になって競合する画像枯渇アルゴリズムに変換され,この問題に関連する主な課題のいくつかを克服できることを示している.

多くの画像枯渇技術は通常、外部の情報源、または同じ場面の複数の画像を必要とする。著者は、2潜在層マルコフランダム場による深度と真の放射輝度の共同確率的推定によって、この必要性を克服する。この論文では、画像の曇りと不均一な照明分離の問題を結びつける二重の関係を厳密に数学的に証明した.倒立画像にRetinex演算を適用した後,結果を再び反転することにより,ぼかし処理された結果が得られ,逆もまた同様であることが示されている.特定のアルゴリズムに限定されるのではなく,Retinexの広範な手法に対してこれが正式かつ実験的に示されている.定性的および定量的実験は,現在の枯渇アルゴリズムと比較して競合結果を示した.

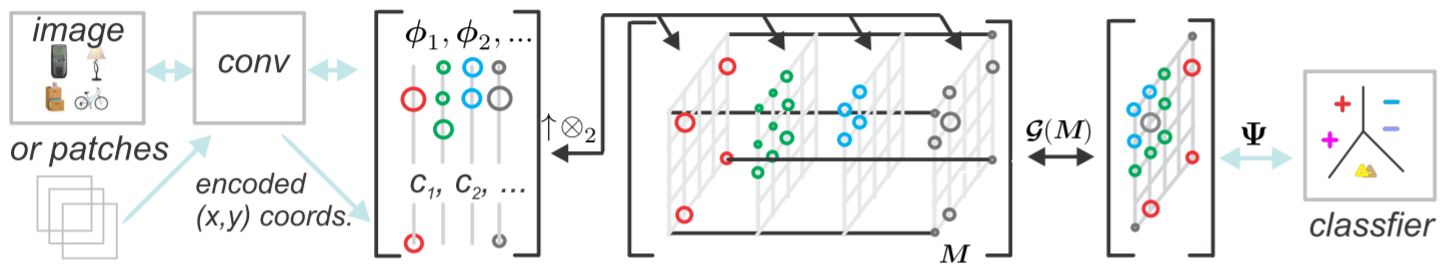

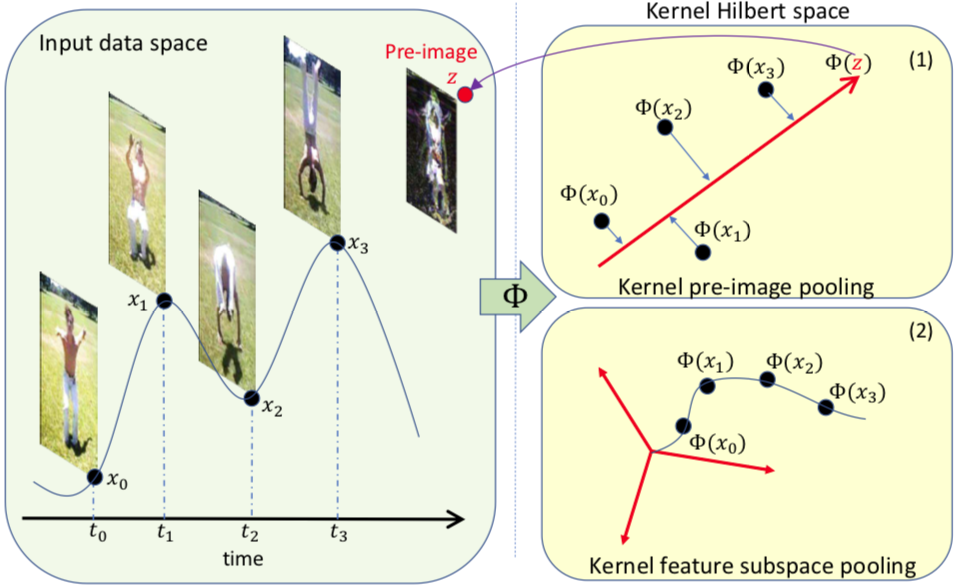

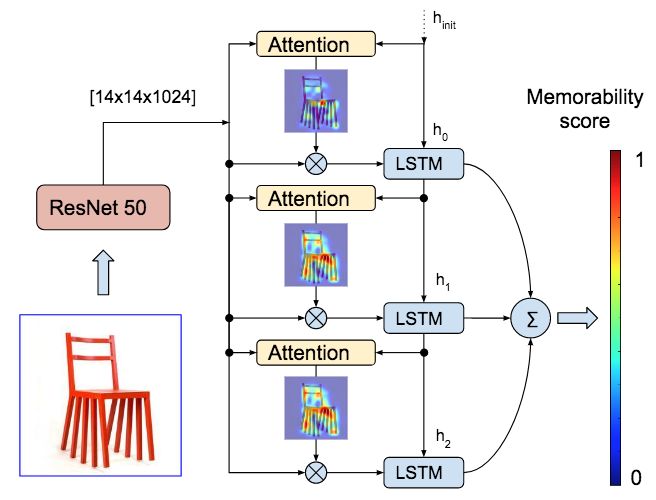

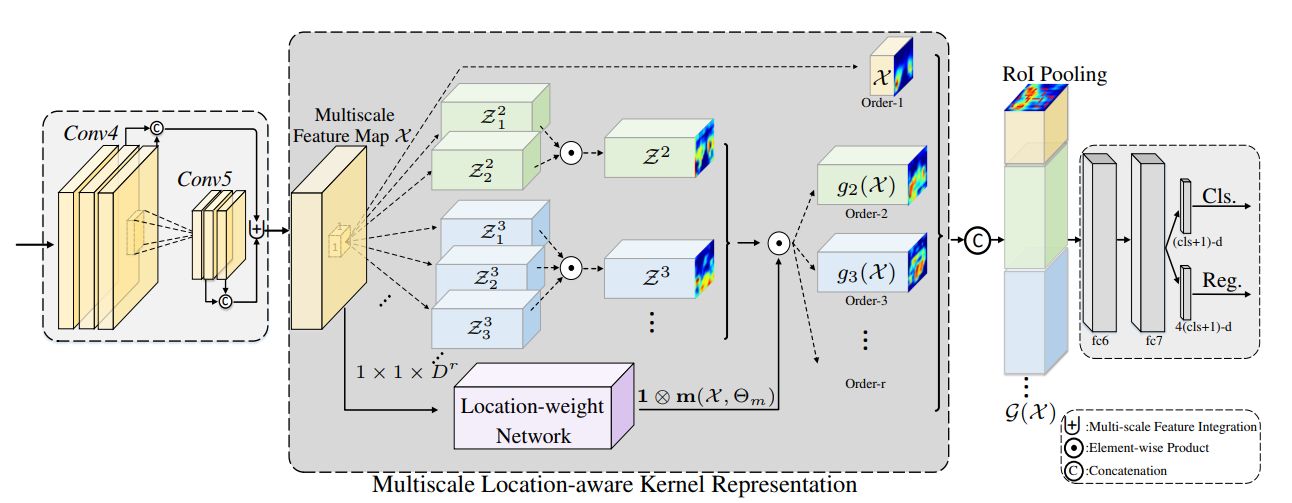

特徴マップの非線形プーリングにパワー正規化(Power Normalization;PN)を実装する新しい層を導入する.PNは,Bag-of-Wordsのデータ表現コンテキストで非常に有用な非線形オペレータである.CNN(ResNet-50)の最後の畳み込み層で生成された特徴マップの特徴ベクトルφとそれを符号化した空間座標cを組み合わせる.このカーネルを線形化すると,特徴ベクトルの2次統計を獲得するpositive definite matrixが得られる.ここでは,MaxExpとGammaの2つのPN関数について研究する.

ResNet-50モデルにPN層を実装し,fine-grained認識,シーン認識,マテリアル分類の4つのベンチマークを行い,すべてのタスクでパフォーマンスの向上を行うことができた.

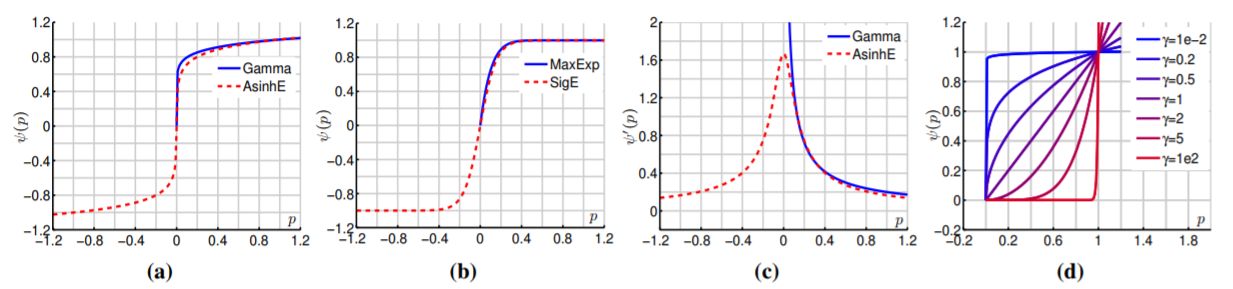

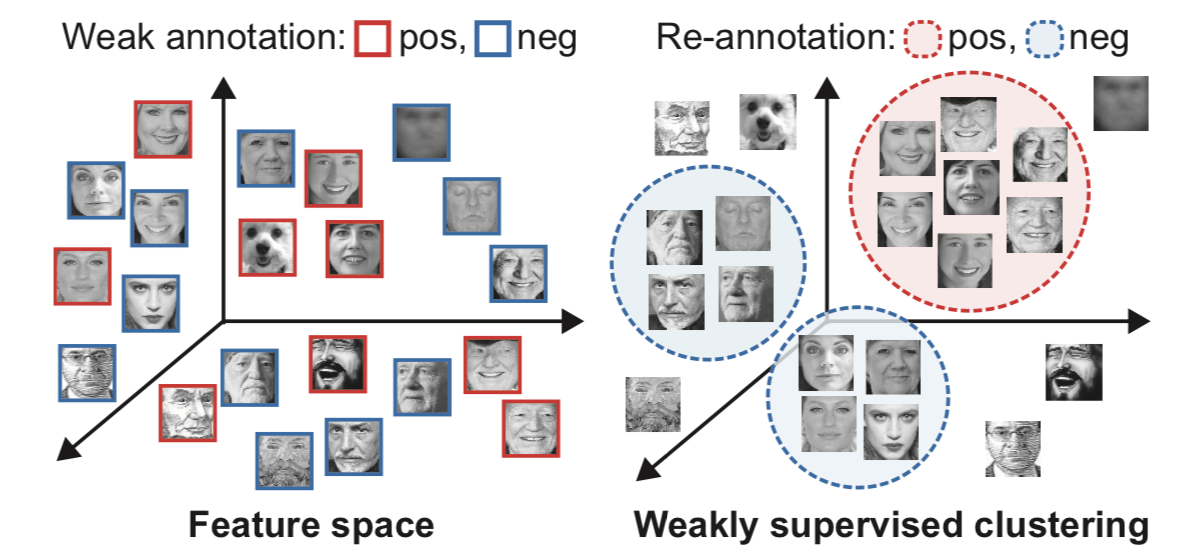

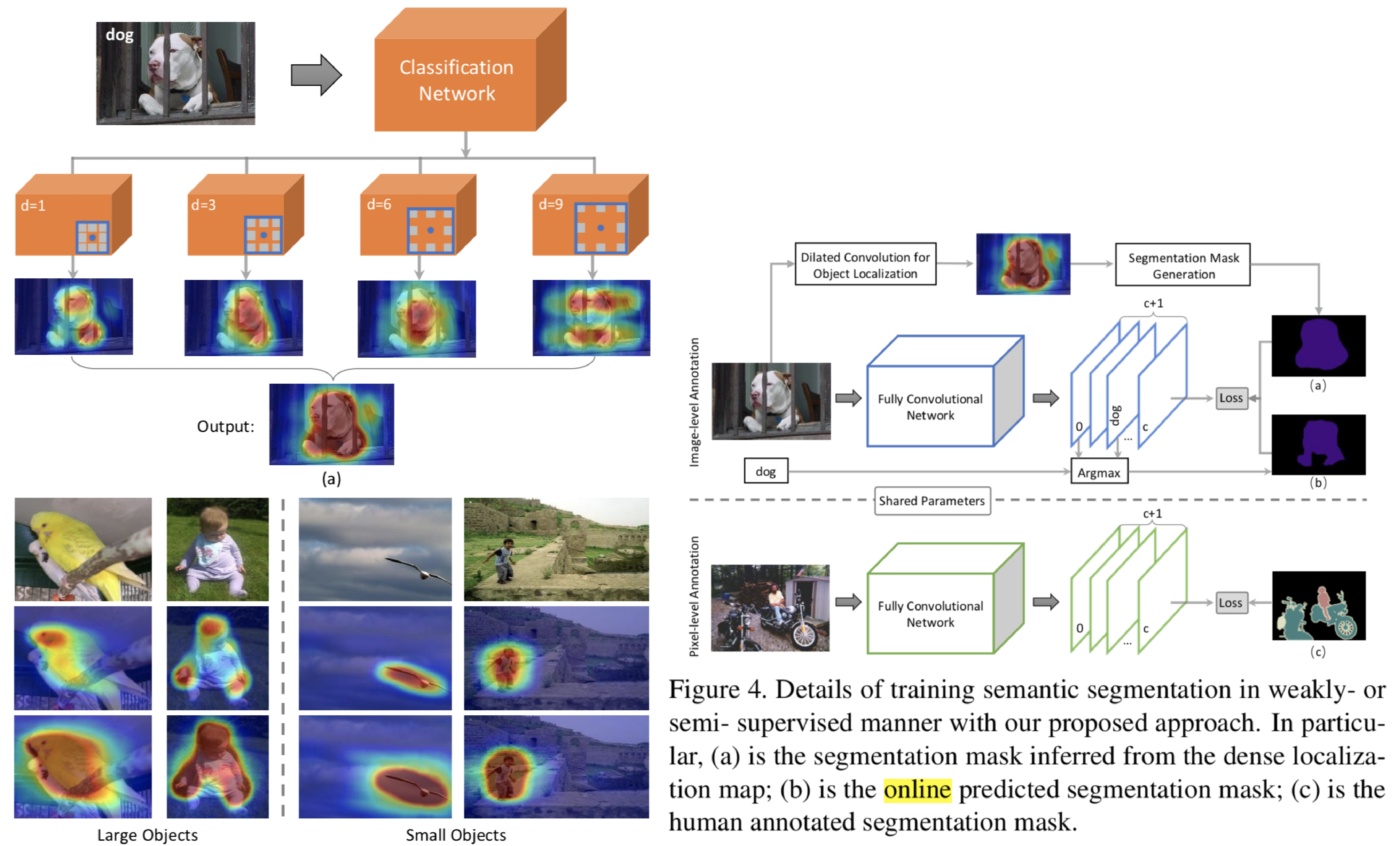

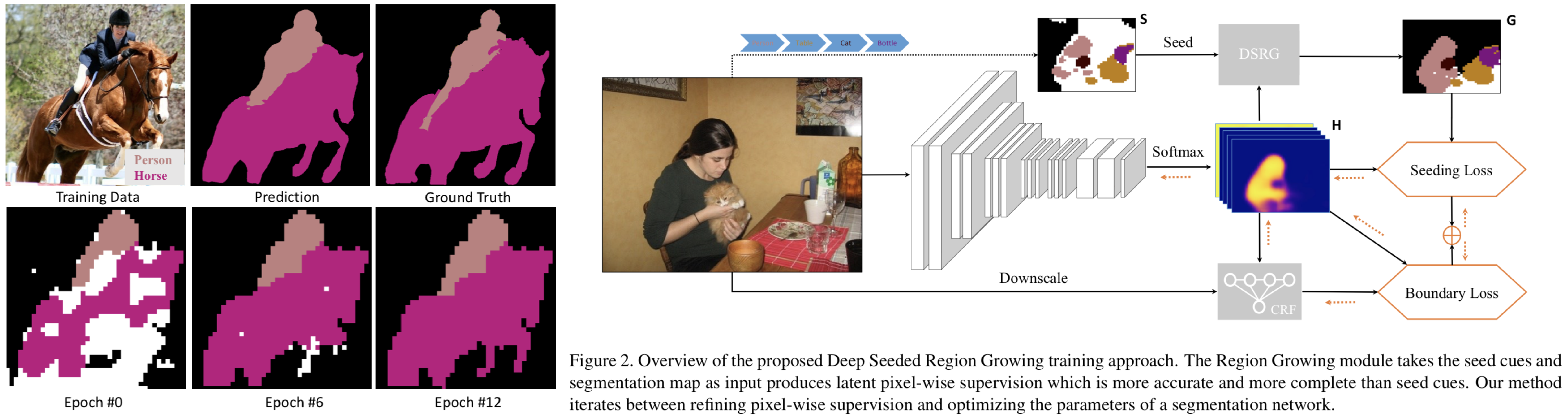

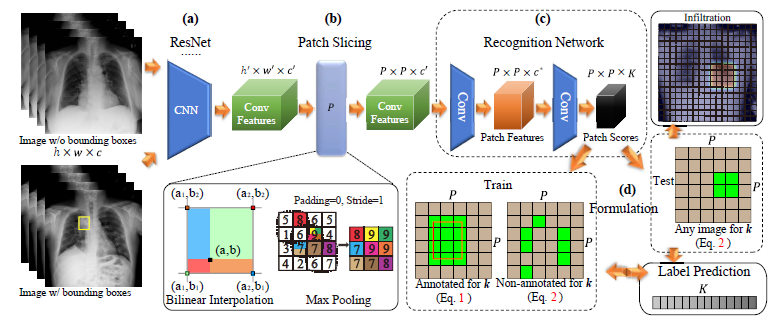

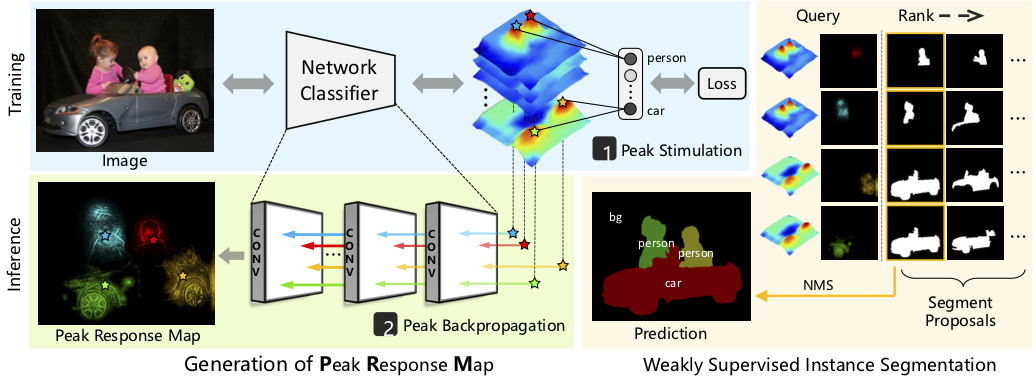

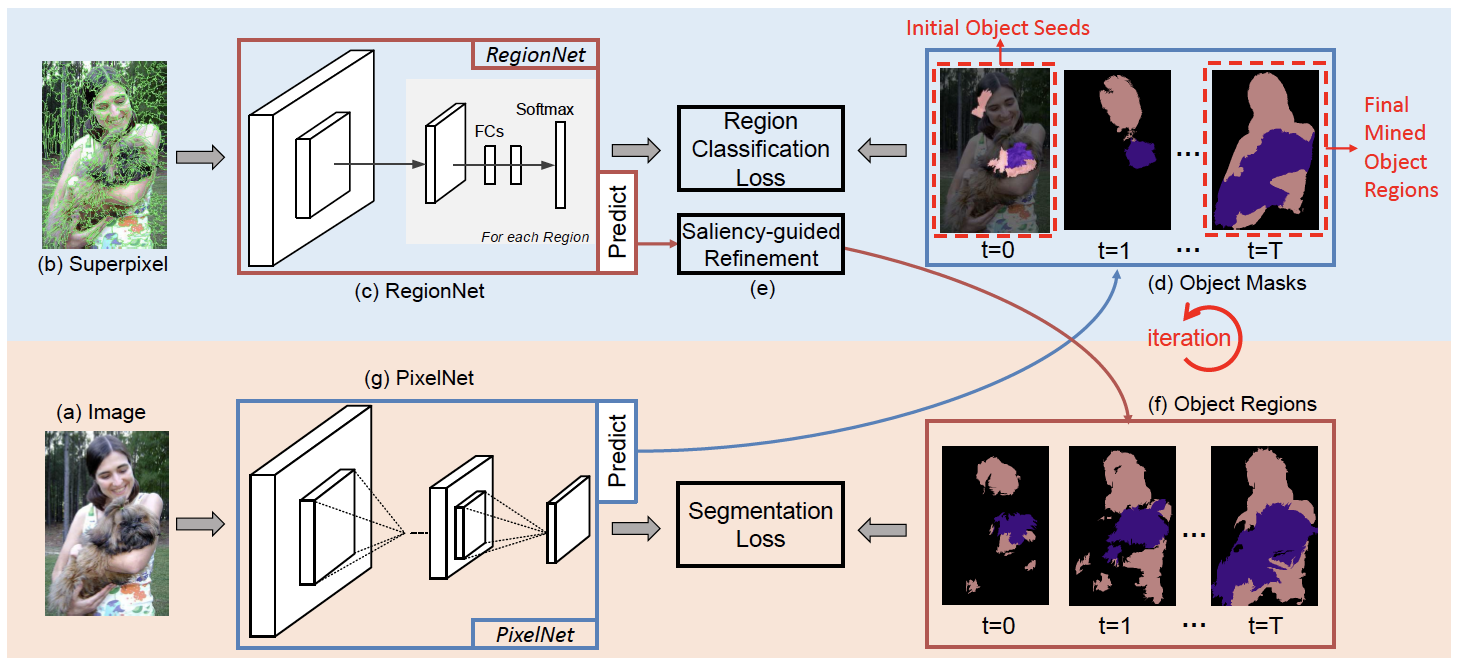

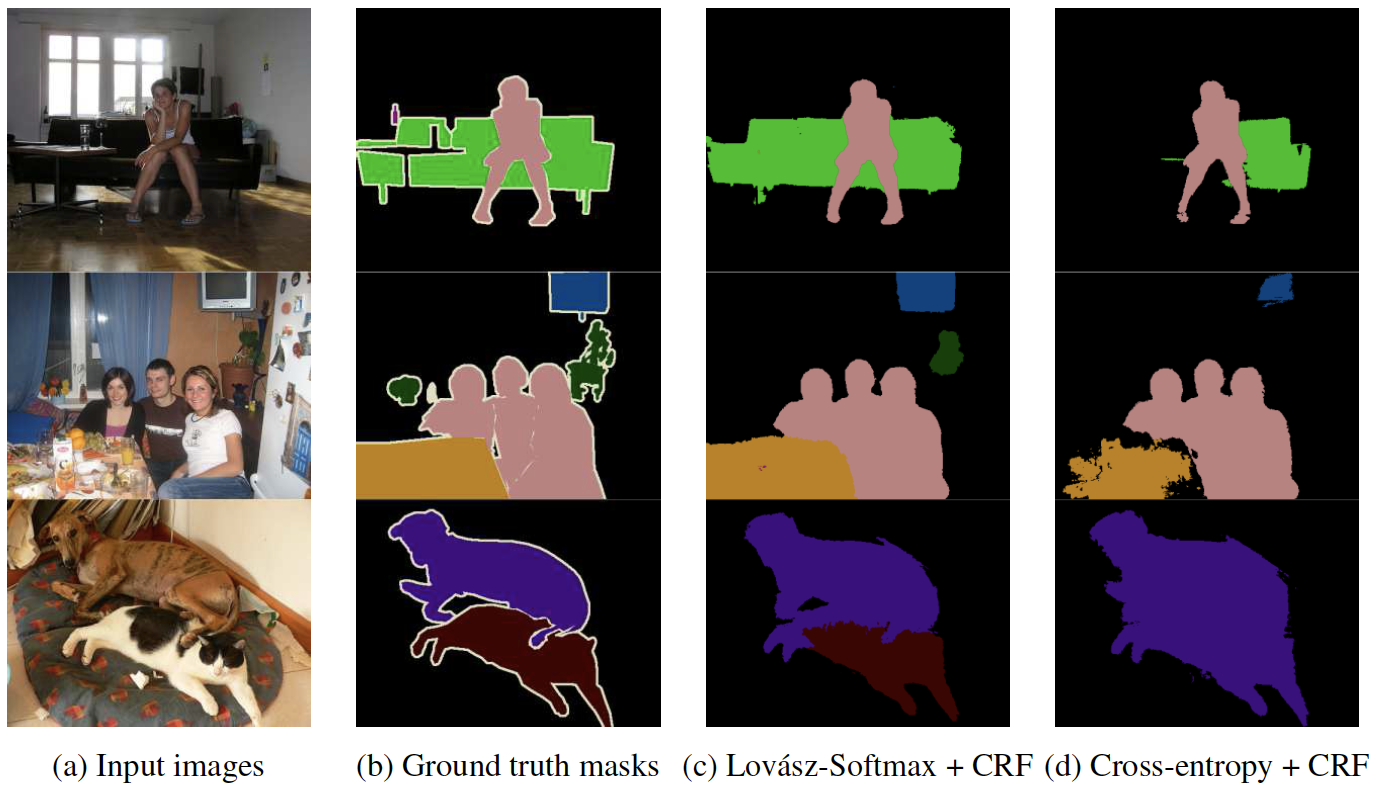

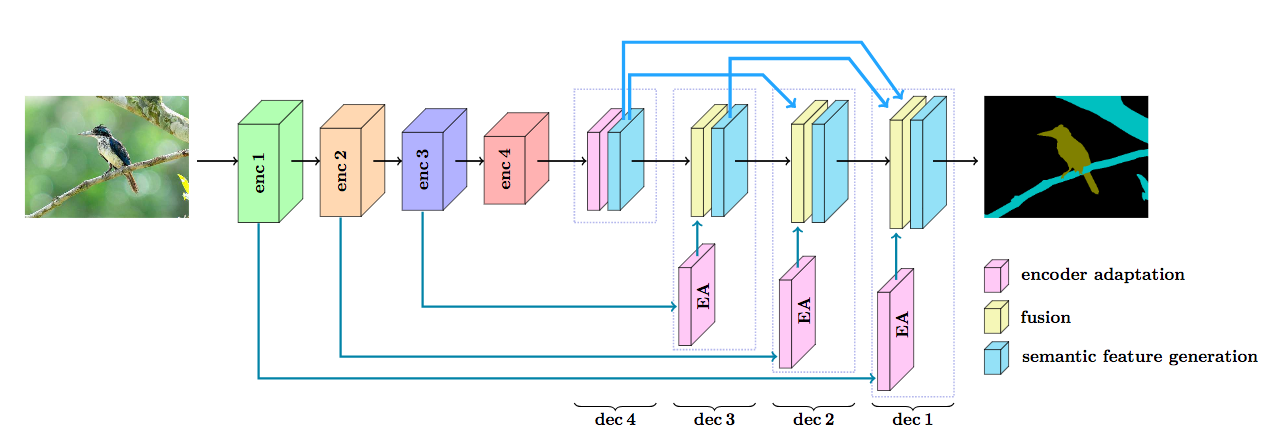

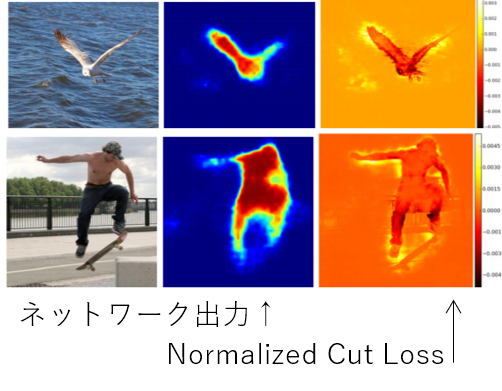

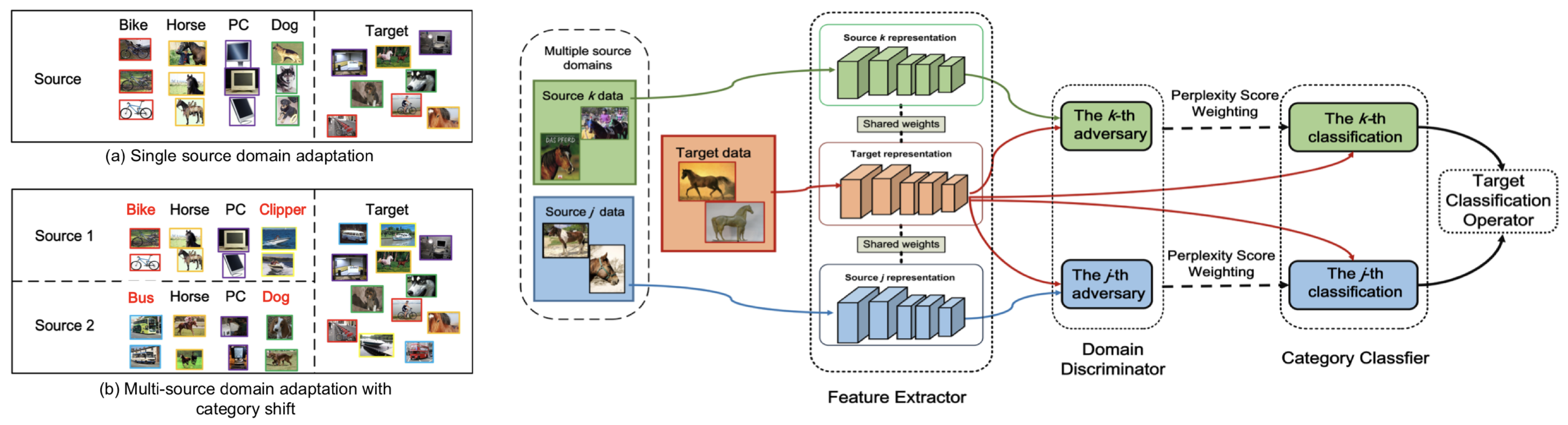

画像のクラスラベルのみを用いてセマンティックセグメンテーションのための高品質な識別器を学習する弱教師あり学習手法を提案.ブートストラップ法を用いて学習画像の正確なピクセルレベルの教師ラベルを作成し,Ground truthの代理として用いる.Domain adaptationのような手法をとり,ターゲットデータはPASCAL VOCなどのラベルつき画像,ソースデータはWebから収集した画像(Web domain)である.Initial-SECを始めに学習して,粗いラベルを作成する.間違ってラベル付けされている画像(ノイズ)はここで除去され,セグメンテーションに適した画像のみ残される.次に,WebSECを学習してWeb画像の粗いラベルを作成し,Grabcutにより細かいラベルを得る.そして,Web-FCNを学習して,Web domain内の特徴を得る.最後に,代理GTを用いてFinal-FCNを学習する.

セマンティックセグメンテーションの教師あり学習に必要な,多大な時間をかけてピクセル単位のクラスマスク教師画像を作成する手間を減らすことができる.ResNetをベースに用いることで,他の弱教師あり学習などと同等またはそれ以上の性能を得ることができた.

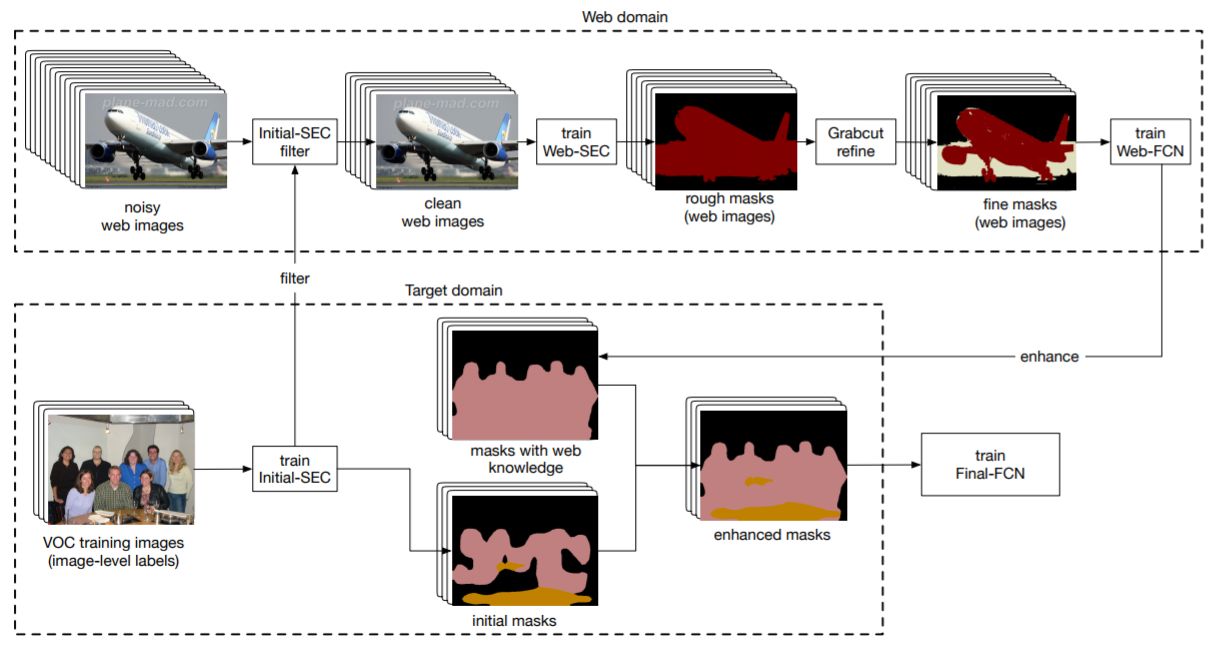

DNNの教師あり学習時に使用するカスタム正規化関数を提案.アノテーションセットをオートエンコーダーで学習することで,正規化関数を導出.セマンティックセグメンテーション実験では,スクラッチ学習によるモデルおよびImageNet pre-trained modelを用いたファインチューニングによるモデルの両者においてベースライン以上の精度を確認.また異なるCNNにおいても一貫して精度向上を確認.

学習の流れは以下の通り

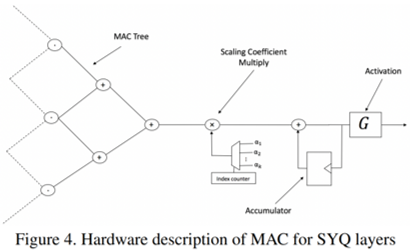

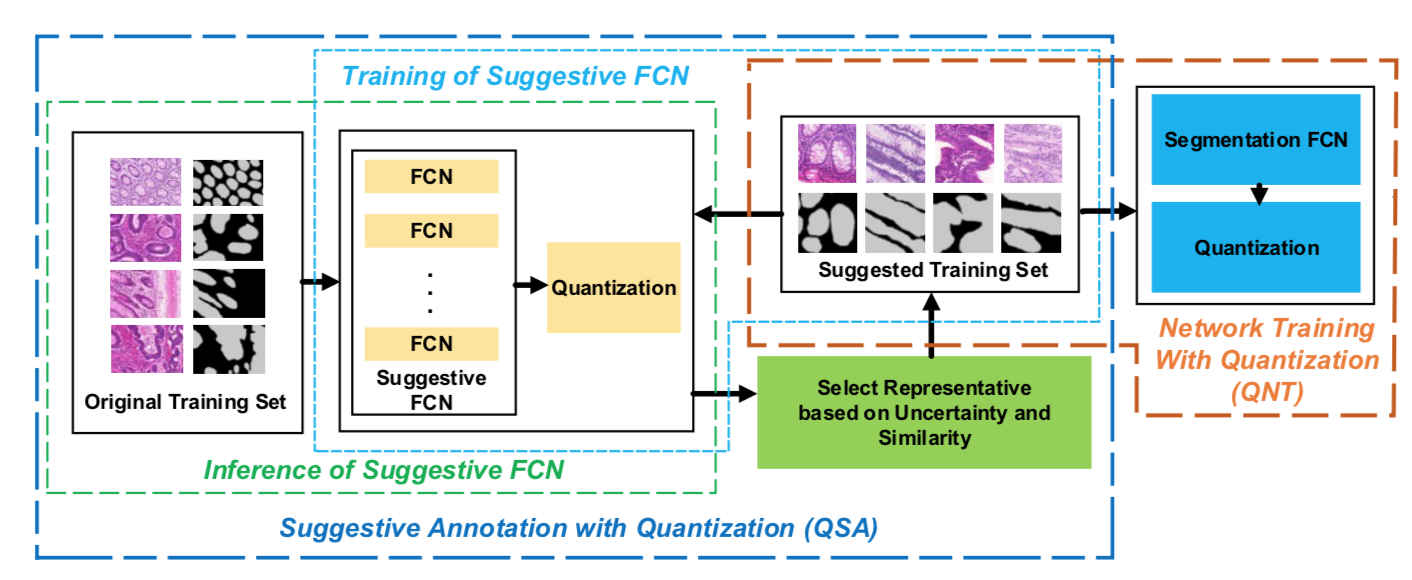

ネットワーク量子化問題において起こる精度の低下に対処するアプローチを提案.学習コードと学習コードに基づく変換を学習の2つのステップに分割量子化を行うTwo-Step Quantization (TSQ) frameworkを構築.CIFAR-10 と ILSVRC-12 datasetsを用いた網羅的な実験によるTSQの有効性,SOTAであることを確認.

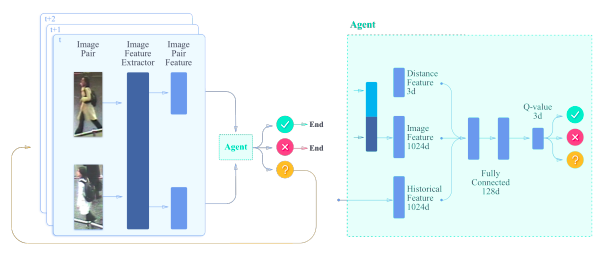

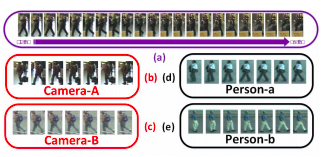

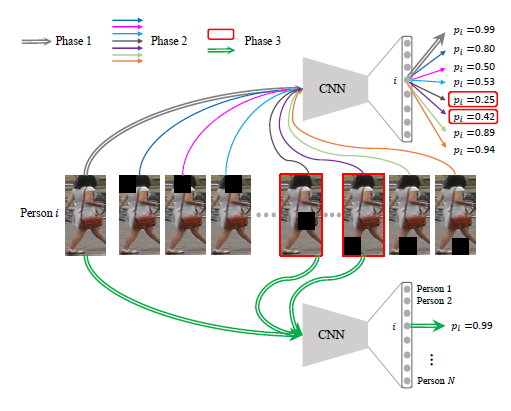

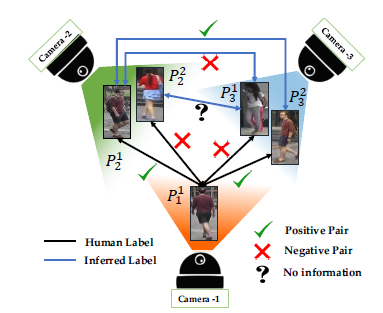

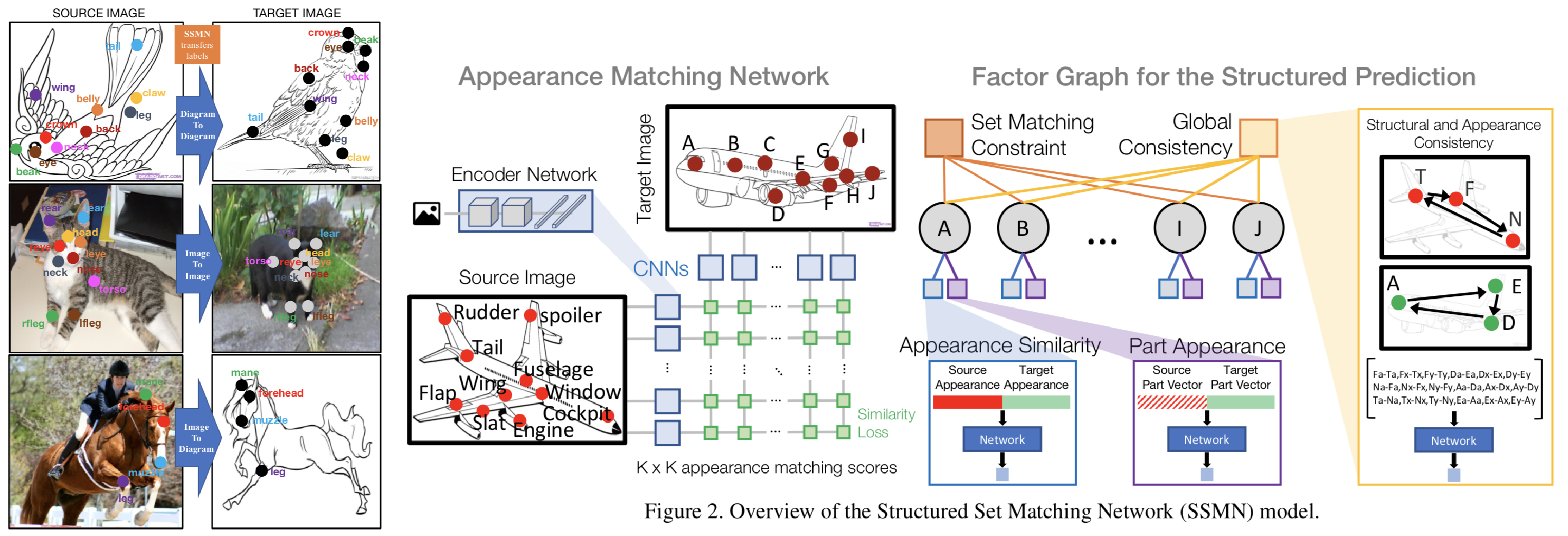

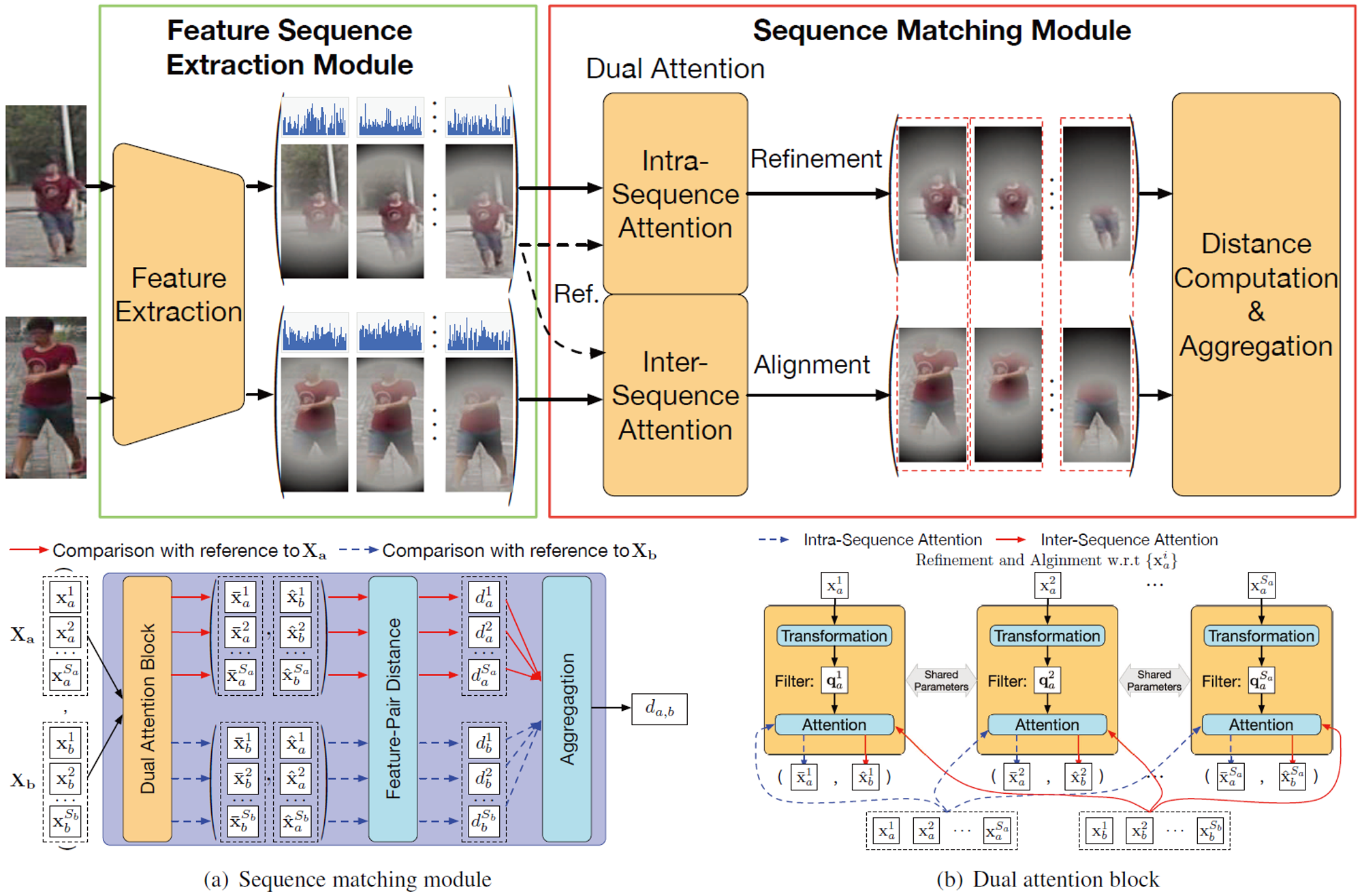

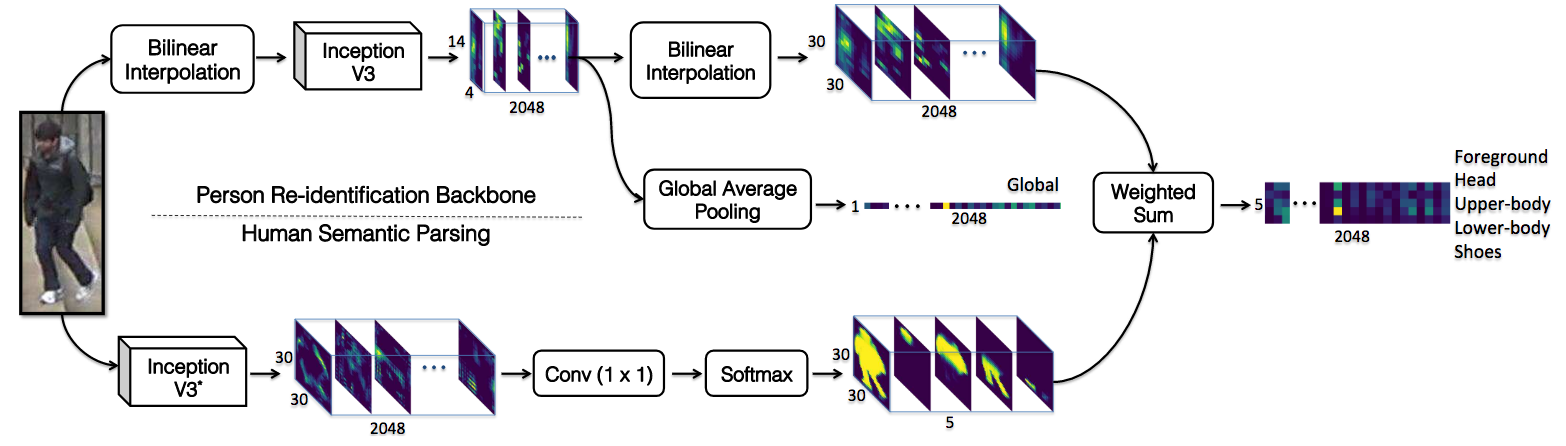

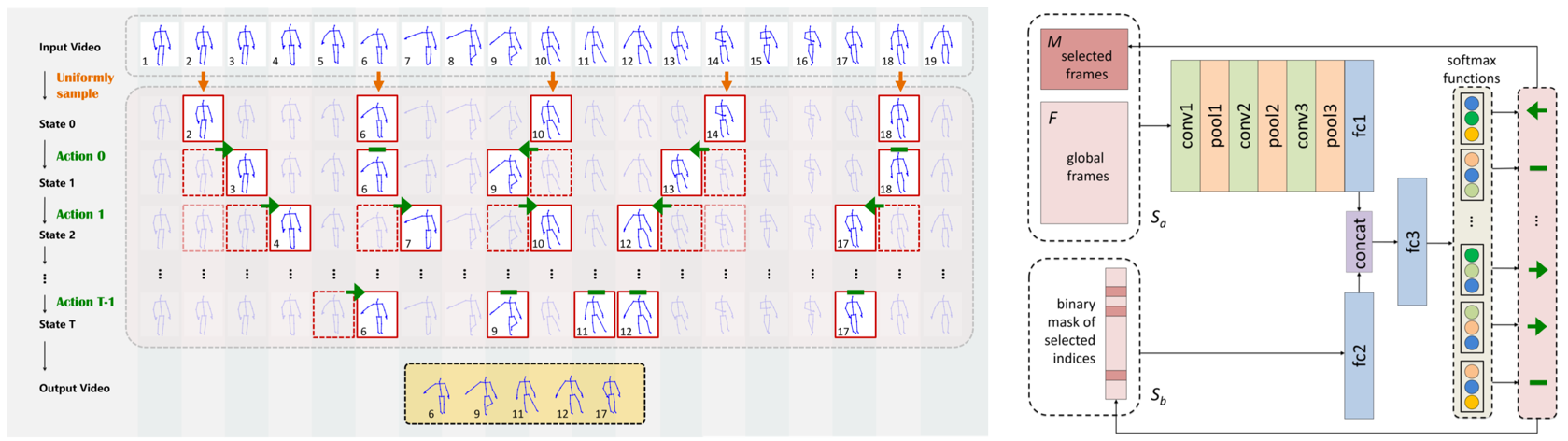

マルチショット(異なるカメラ間)な人物再同定(Person ReID)問題に解釈可能な強化学習ベースのアプローチを組み込んだ手法の提案.3つのベンチマークテストをでは提案手法は他の最新の手法と比較し,3%〜6%の画像しか使用することなく優れた性能を発揮.提案した手法は効率と性能の両面において,他の手法と比べ有利であると提示.

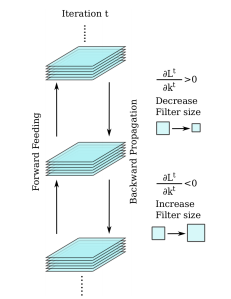

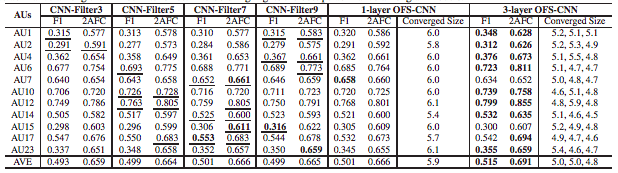

本論文では,CNNの層フィルタサイズと重みを学習データと畳込みフィルタから同時に学習する新規のフィルタサイズ最適化CNN(Optimized Filter Size CNN:OFS-CNN)を提案.実験ではOFS-CNNが様々な画像解像度に対して最適なフィルタサイズを推定し,網羅的な検索によって得られた最良のフィルタサイズを有することを確認.従来手法より優れていること確認.

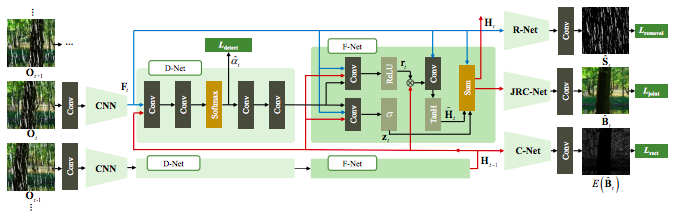

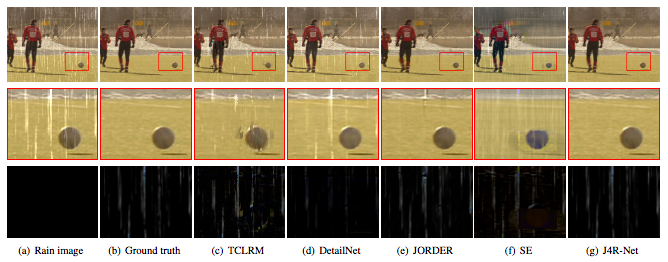

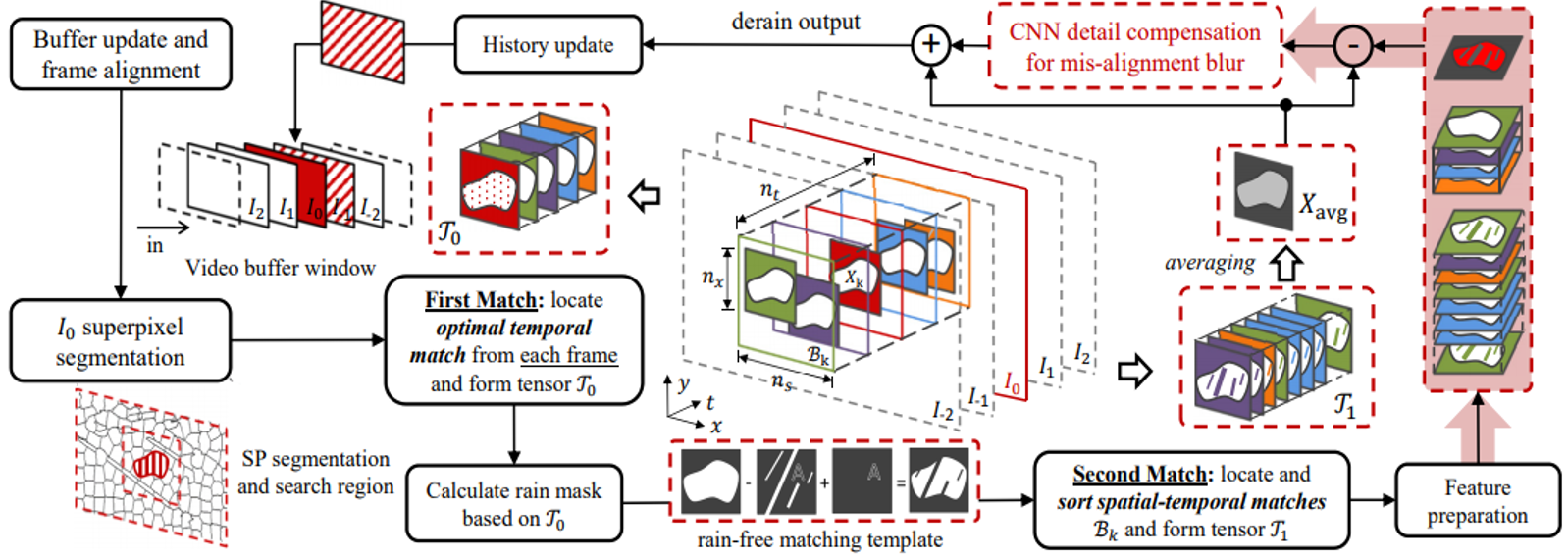

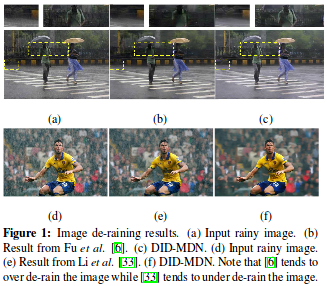

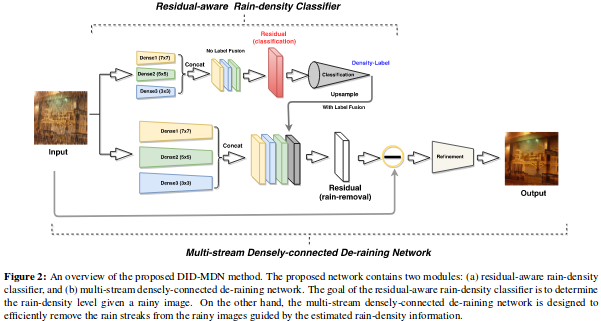

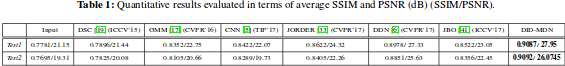

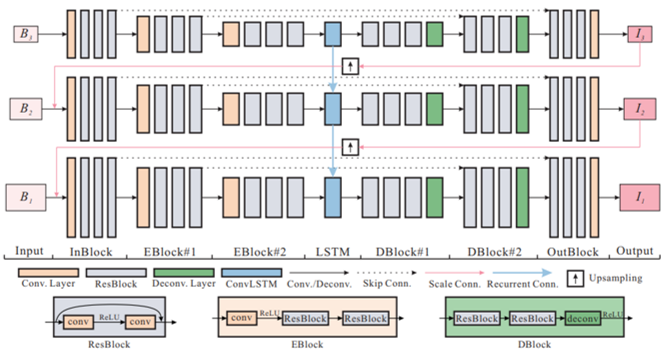

RNNを用いた映像中の雨を除去する手法を提案.雨による画質の劣化分類,空間的テクスチャに基づく雨の除去,時間的一貫性に基づく背景の詳細な再構築を同時に行うJoint Recurrent Rain Removal and Reconstruction Network (J4R-Net) を提案.既存手法を用いた網羅的な実験により,提案手法がSOTAであることを確認.

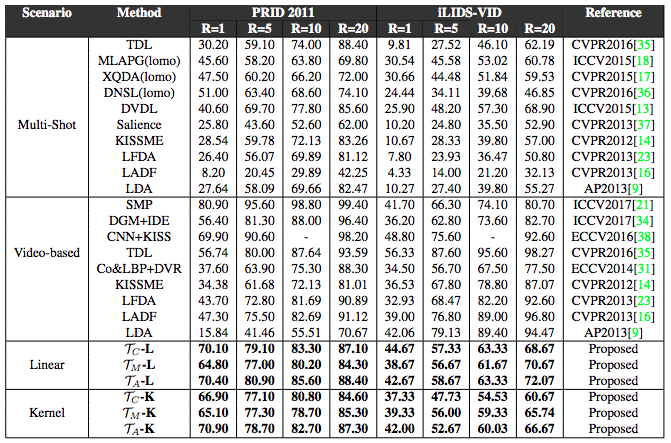

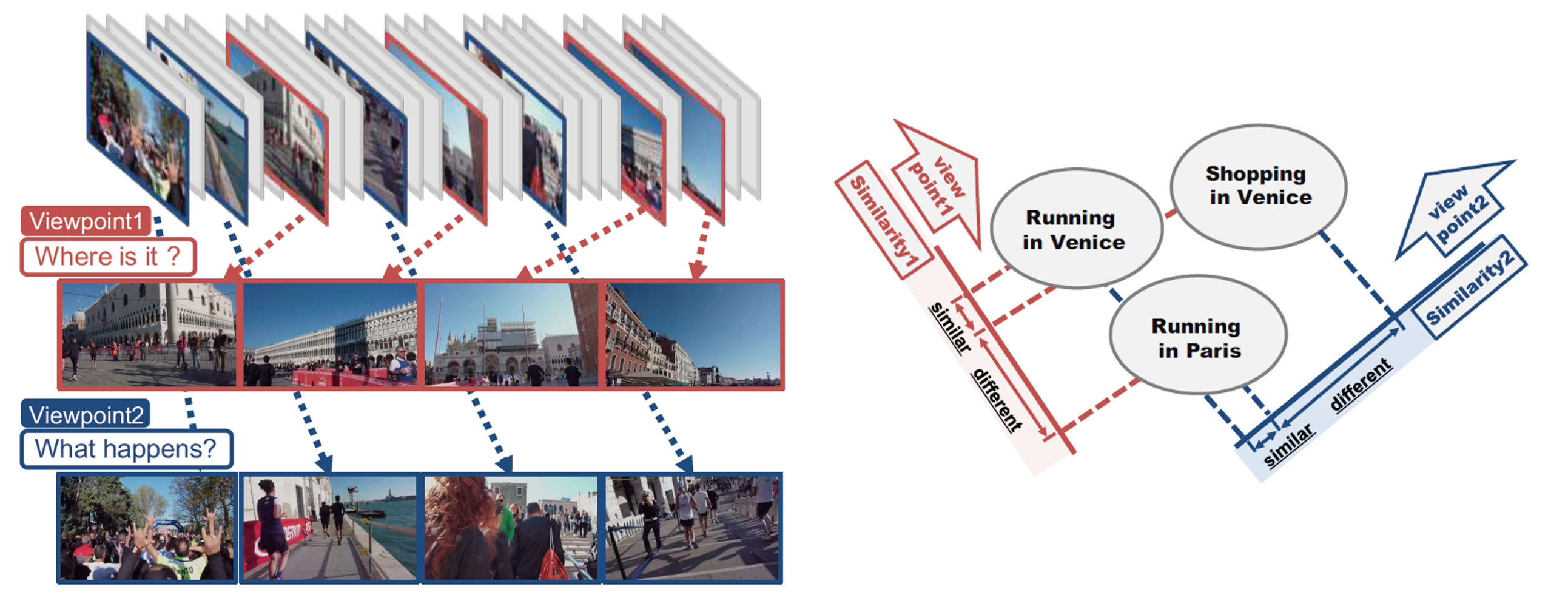

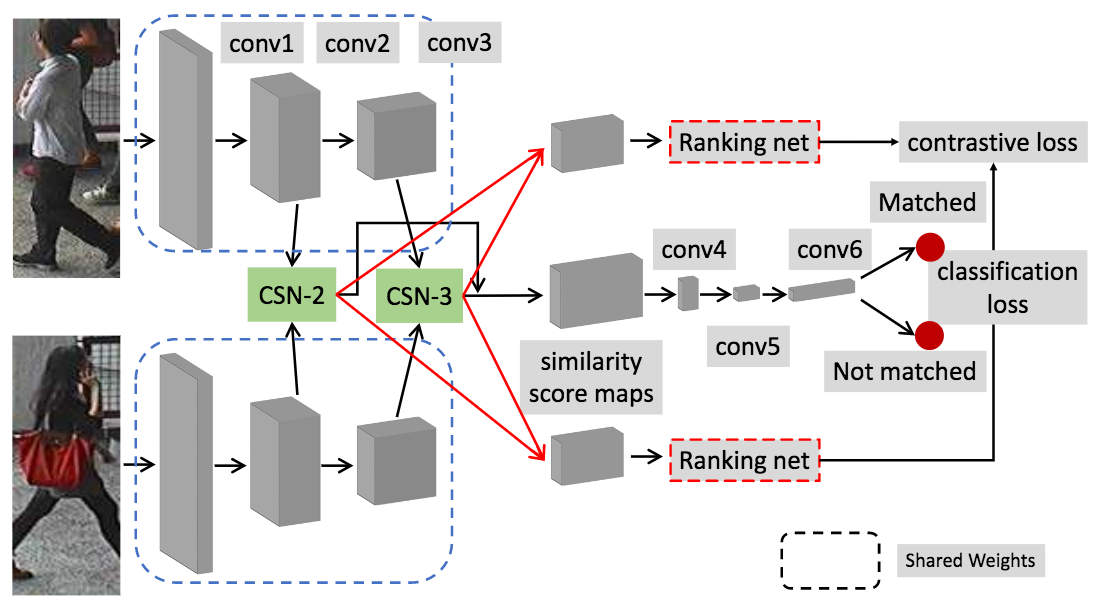

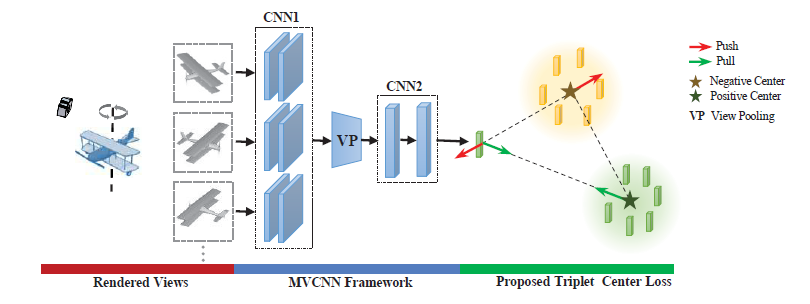

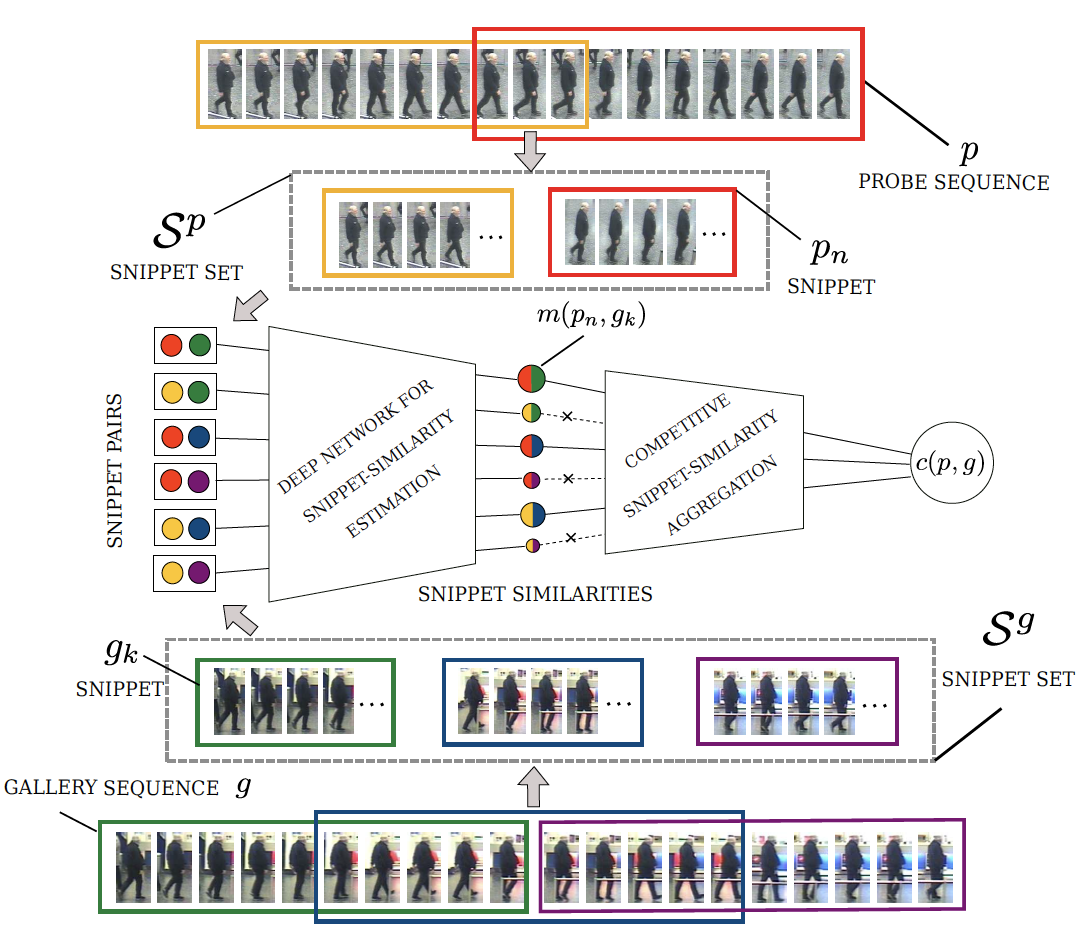

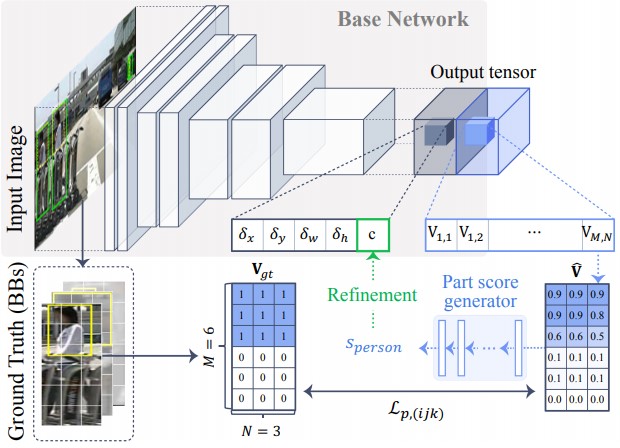

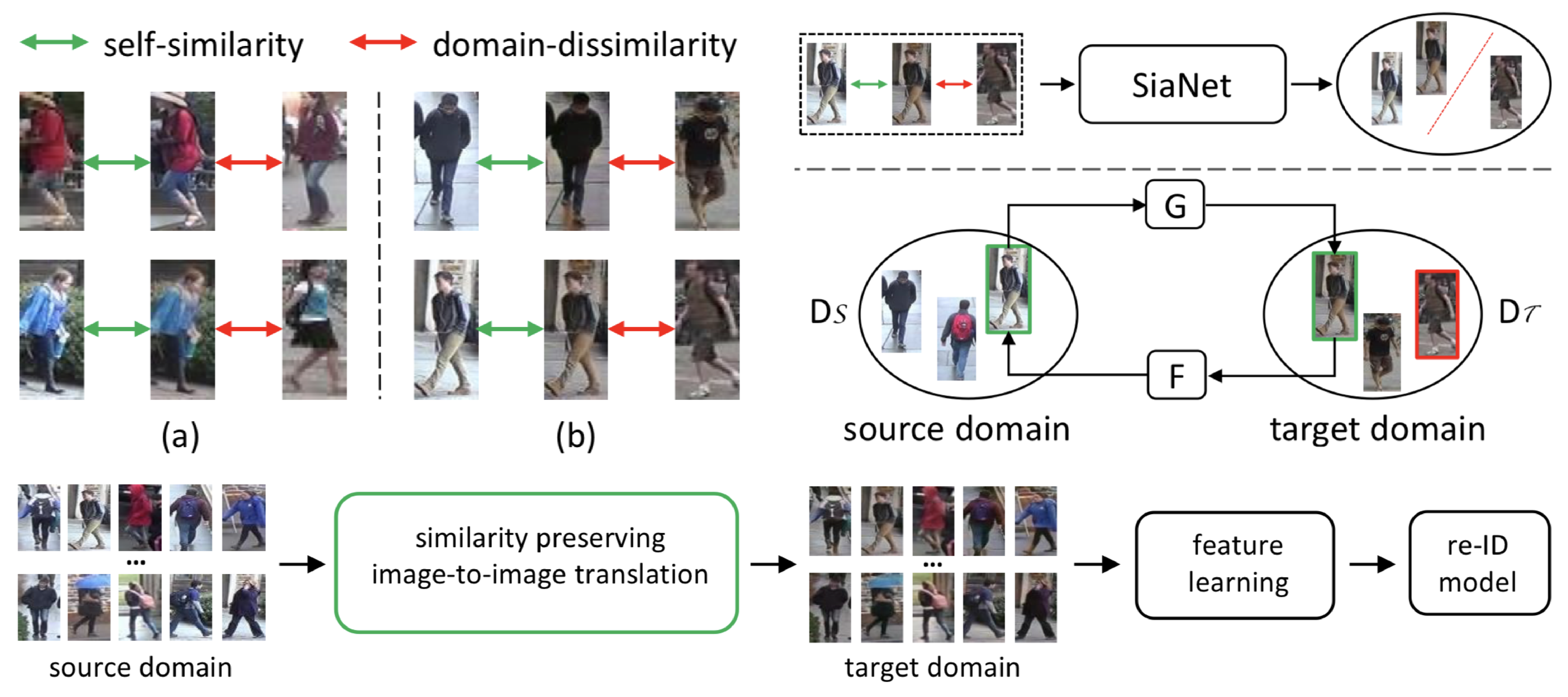

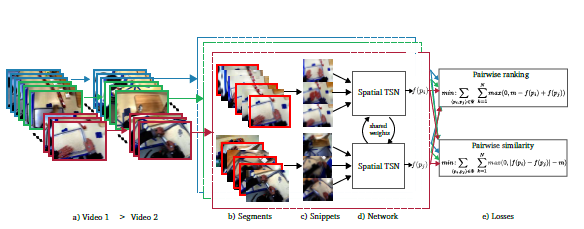

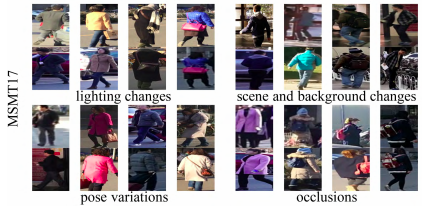

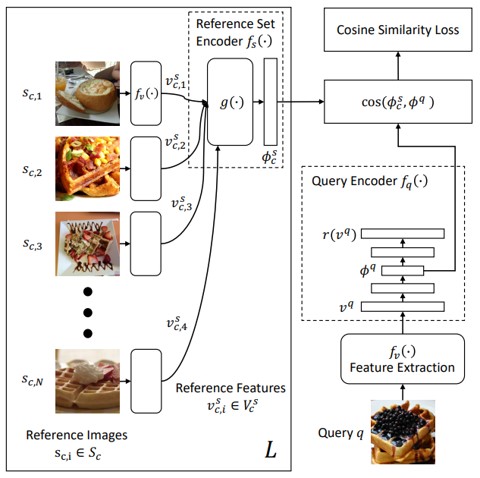

Multi-shot Person Re-IDentification (MsP-RID)に向けた類似的制約によるモデル学習方法の提案.視覚的指標を学習し,視覚的外観の大きな変化を扱うことで信頼できるモデルを構築.網羅的な実験・ベンチマークテストを行い,識別精度と速度ともに最先端のMsP-RIDの方法に比べ大幅な優位性を確認.

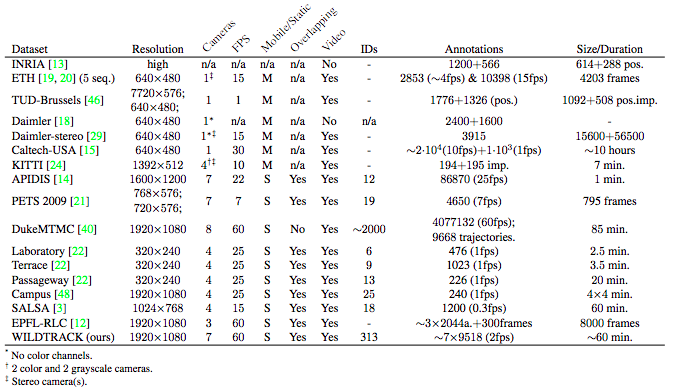

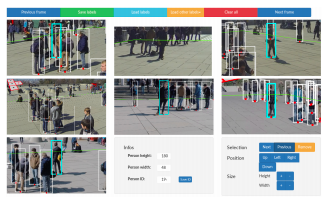

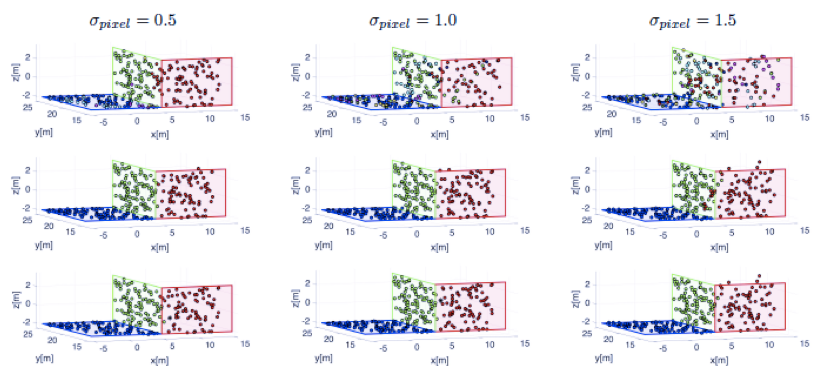

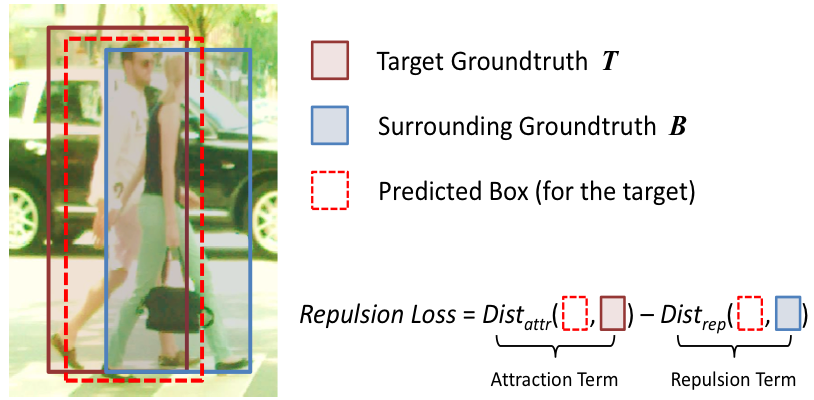

本稿では複数の同期されたカメラを利用した歩行者検出のための大規模かつ高解像度のデータセットを提案.カメラフレームと合わせて,正確なキャリブレーションと2frame/sの速度で検出するための400種類のアノテーション付きフレーム7種類を確保.これにより,40,000を超えるバウンディングボックスが注目領域に存在するすべての人に作成され、合計で300人以上の人物に対してアノテーションを付与.深層ニューラルネットワークを用いた多視点からの人物検出のベースラインアルゴリズムや非マルコフモデルを用いたベースラインアルゴリズムによるベンチマークテストを実施.

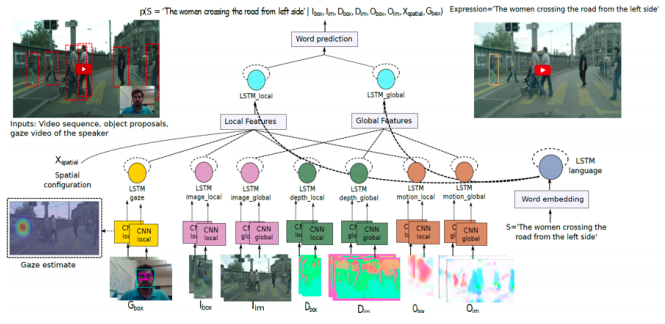

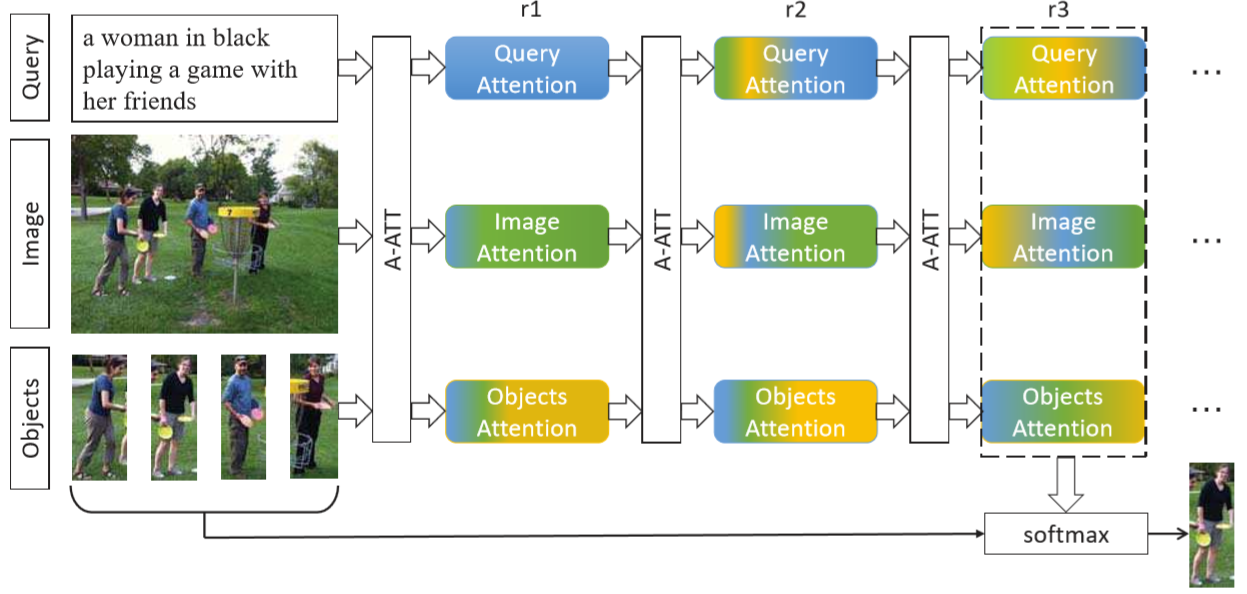

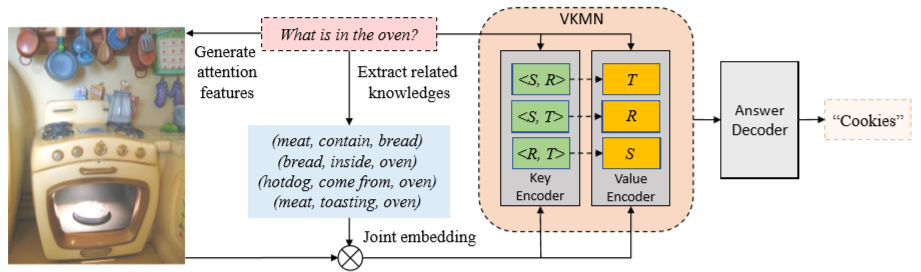

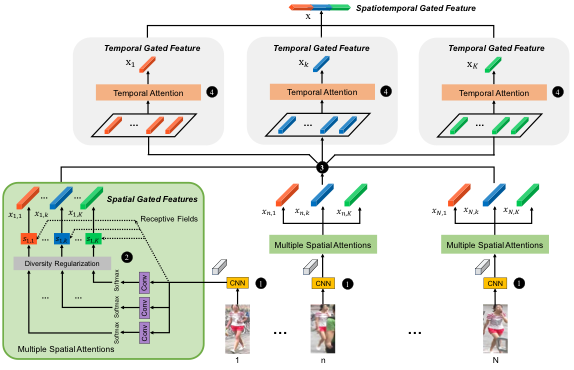

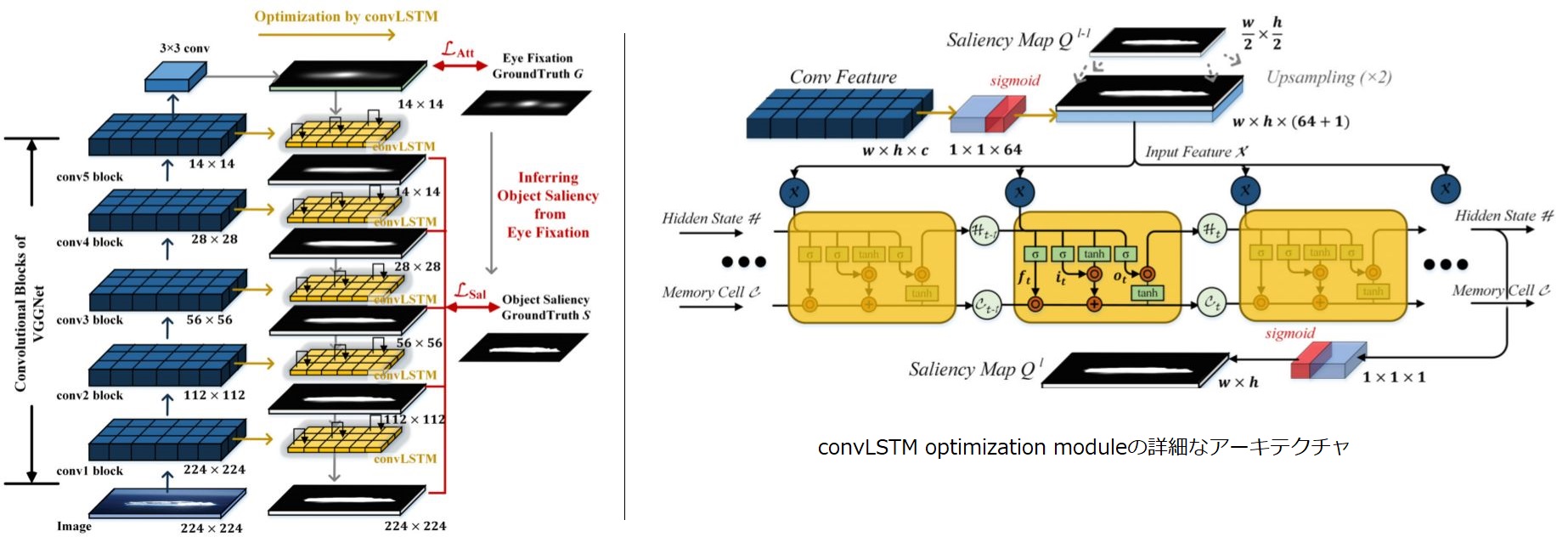

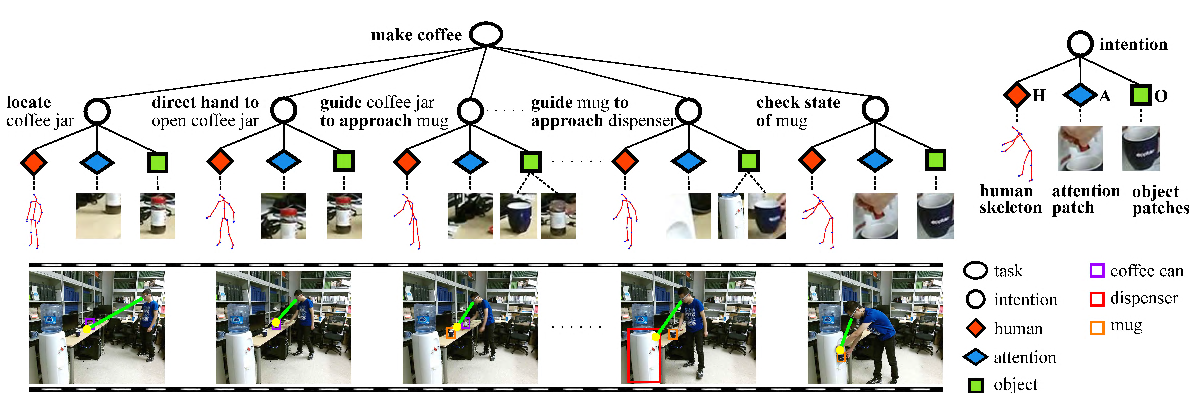

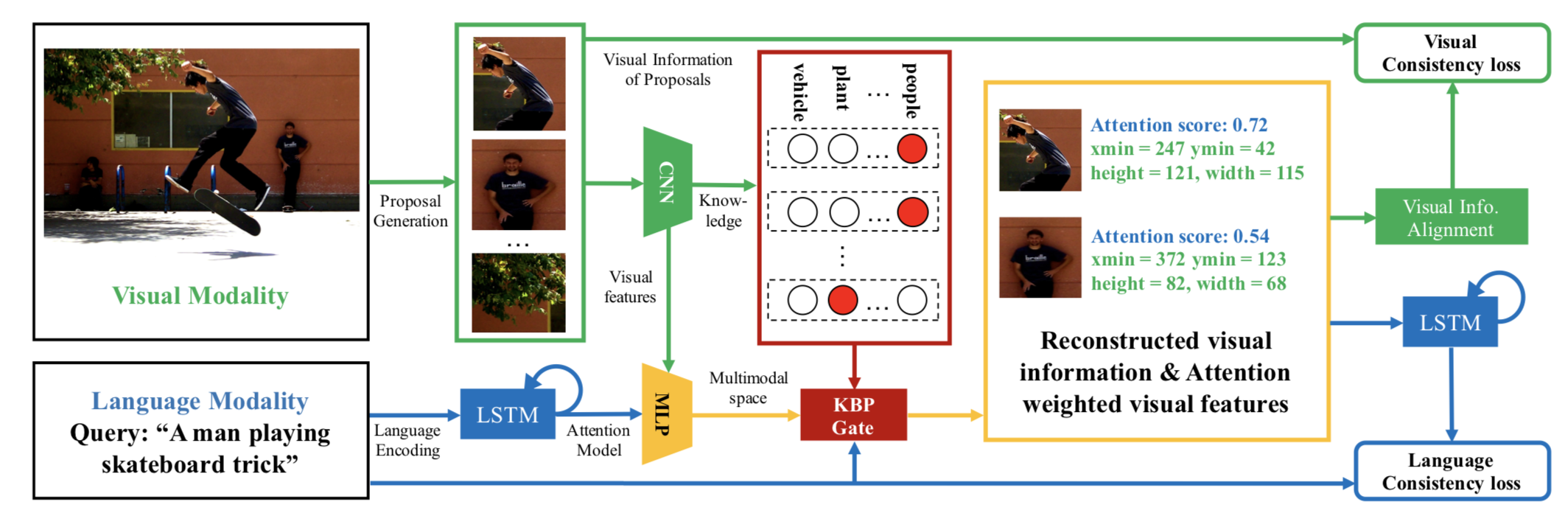

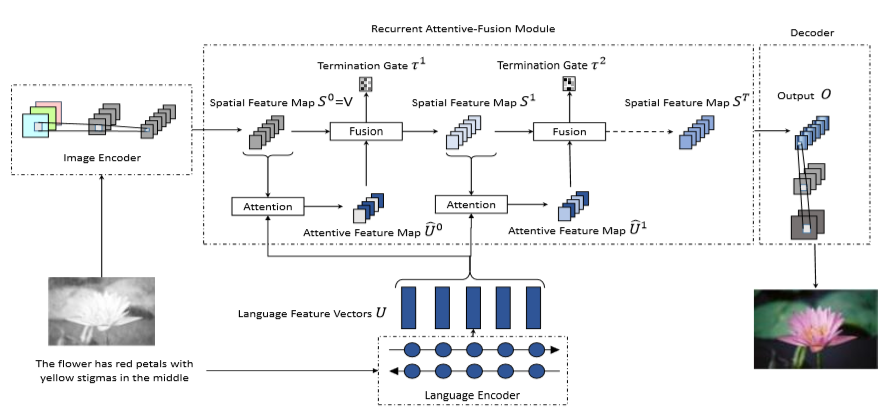

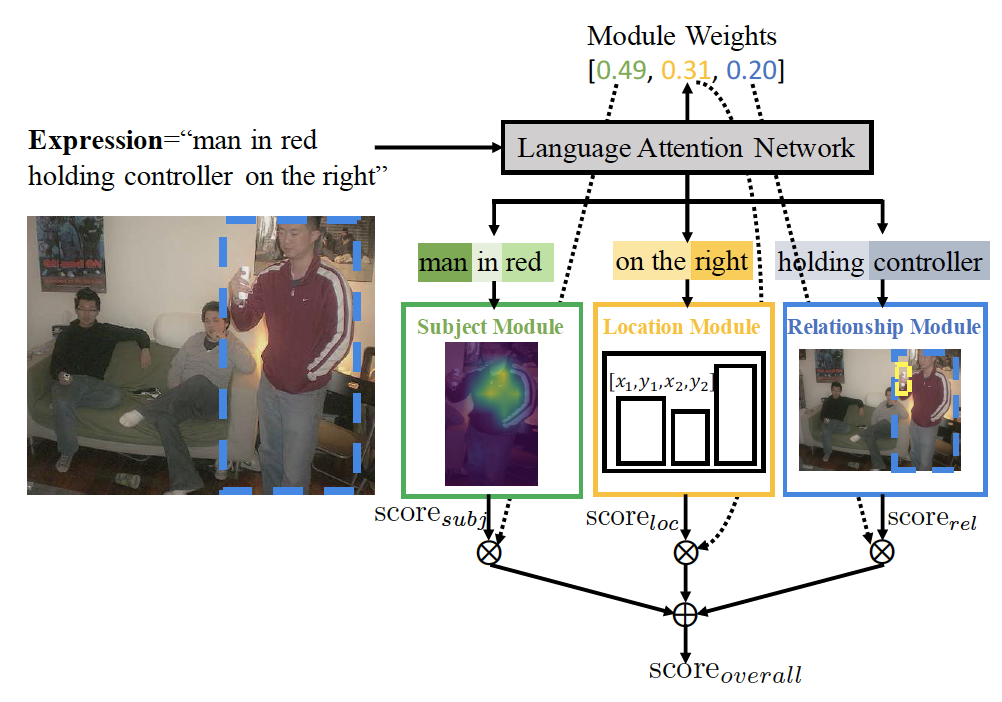

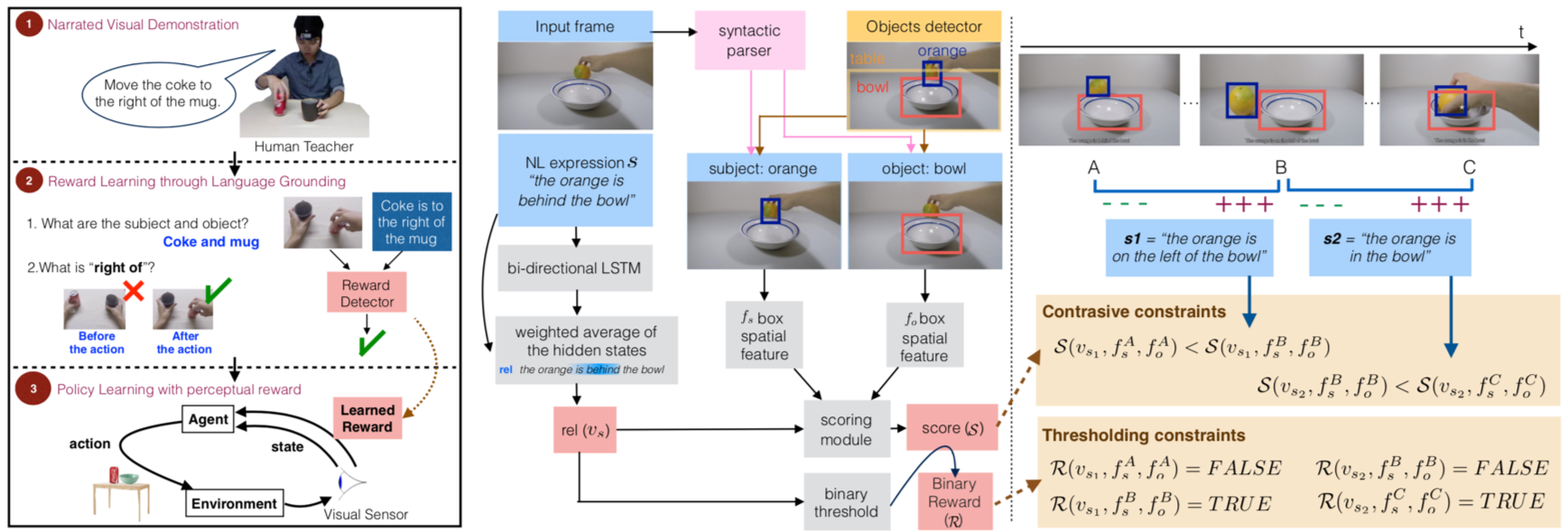

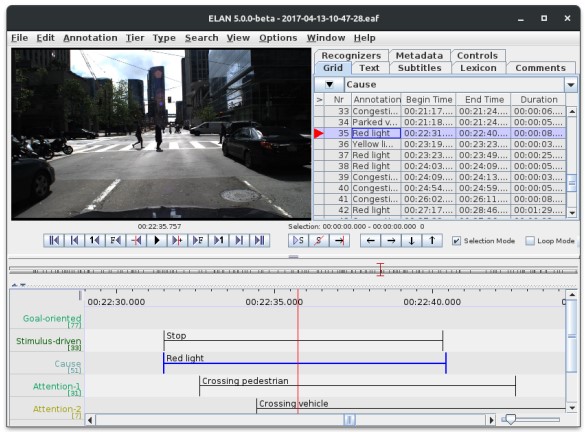

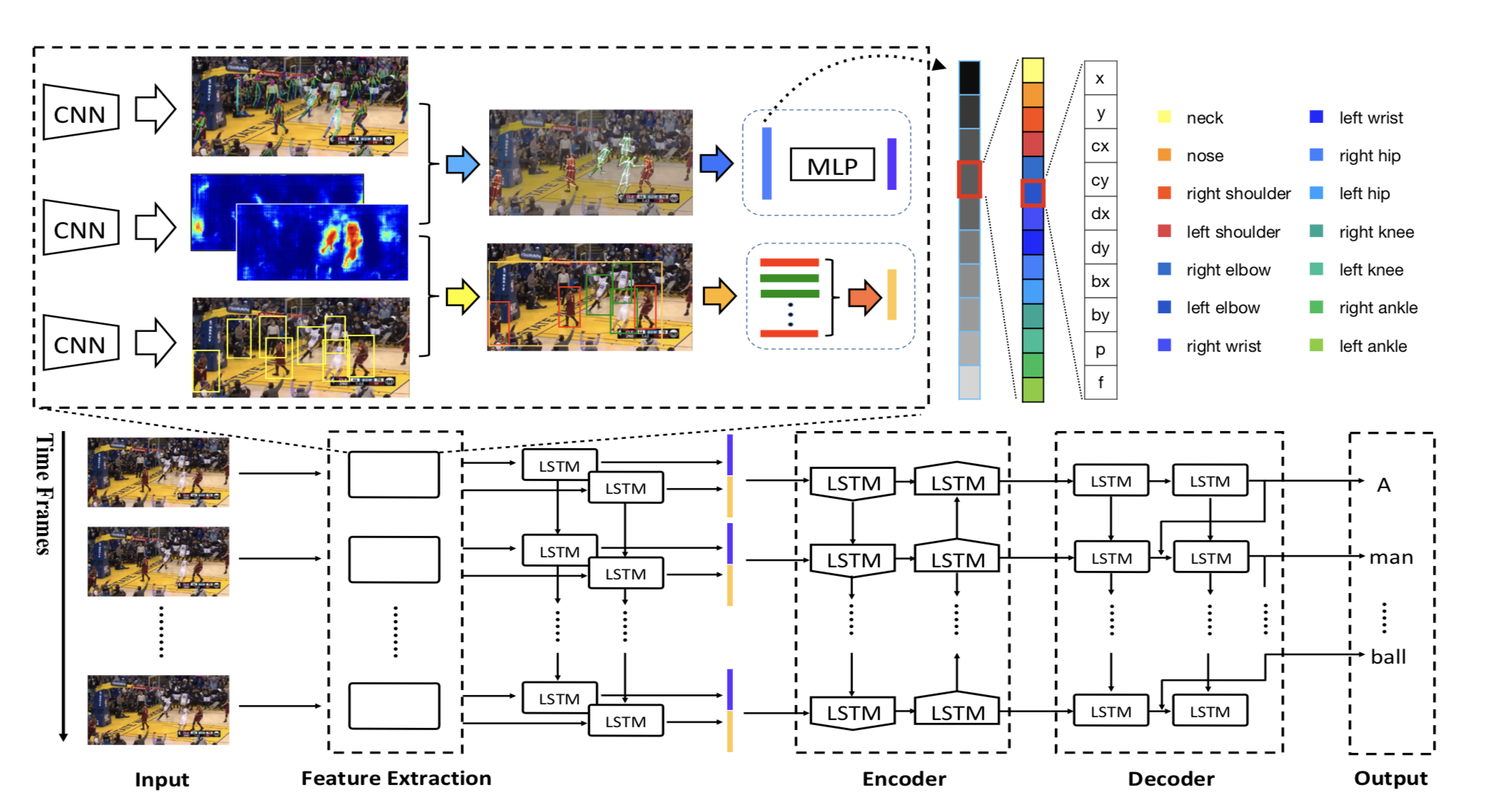

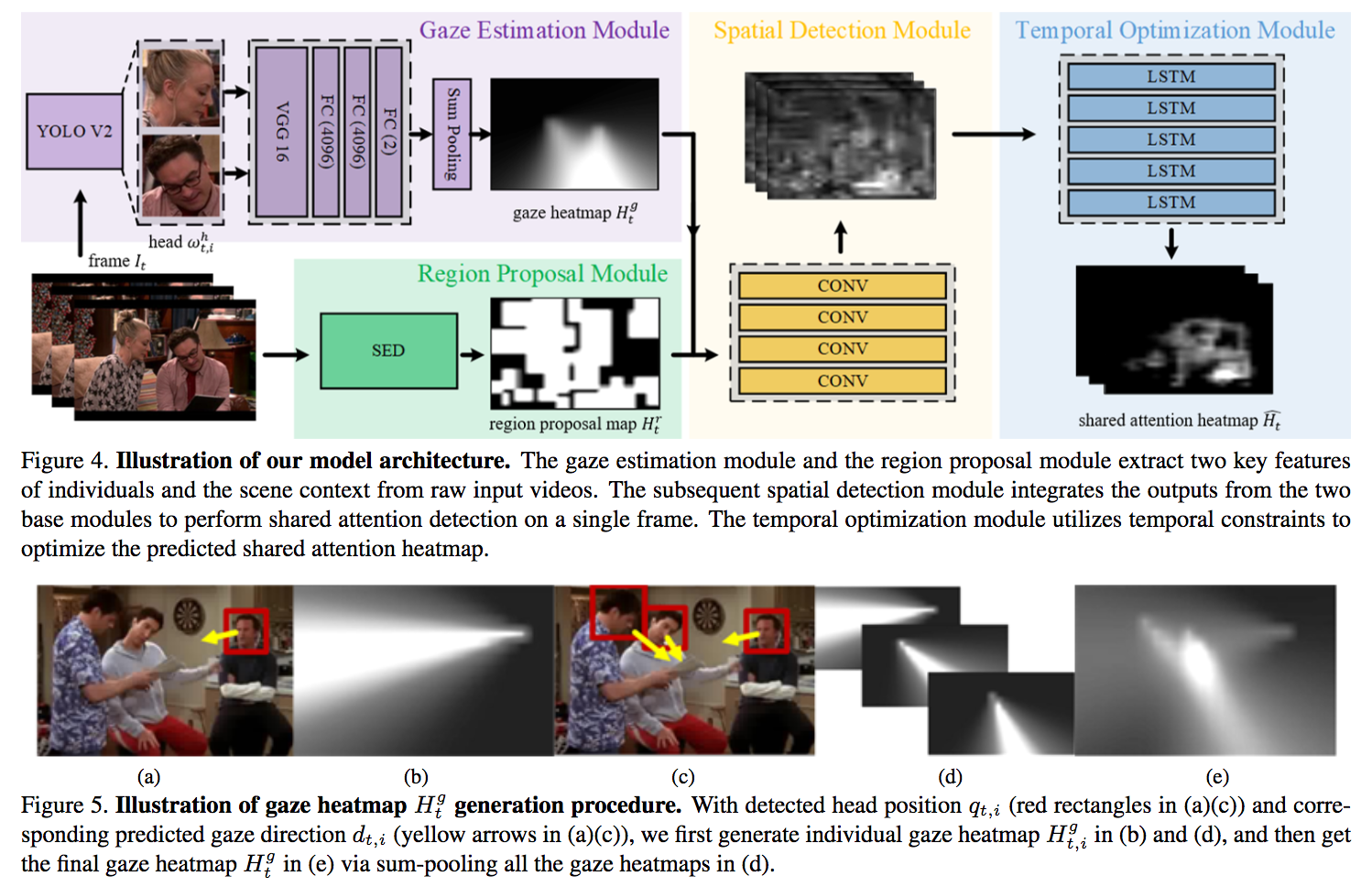

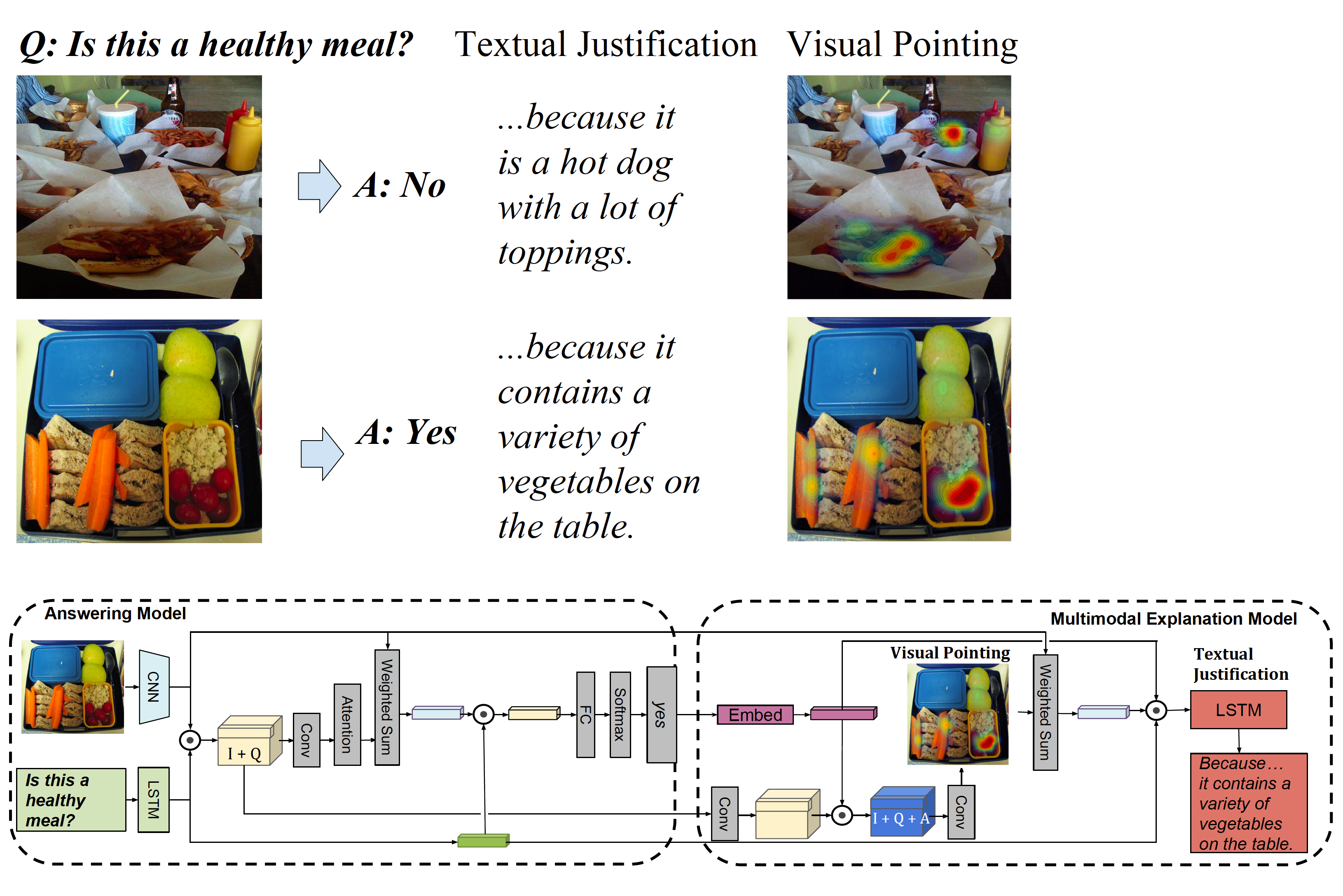

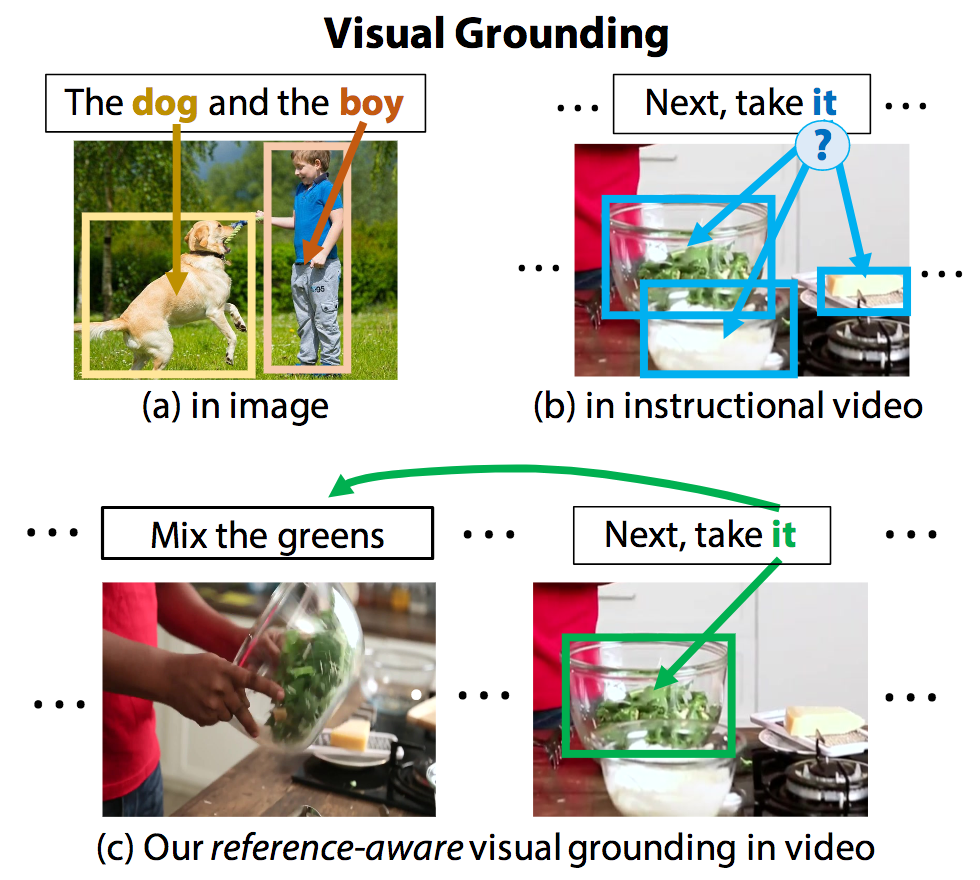

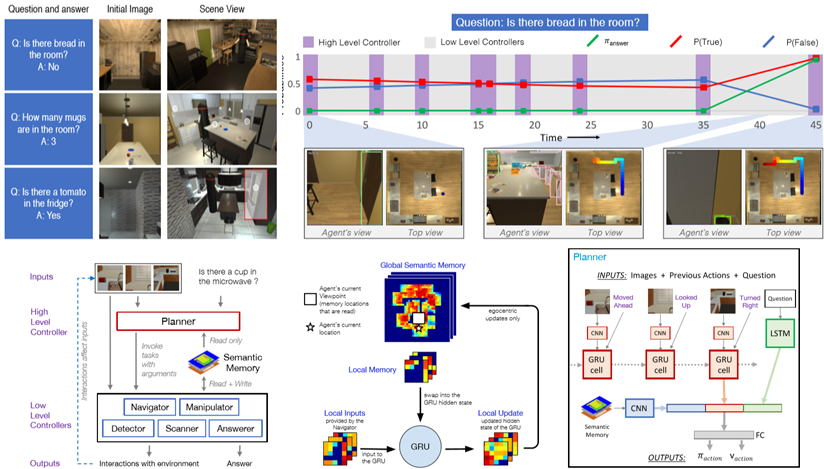

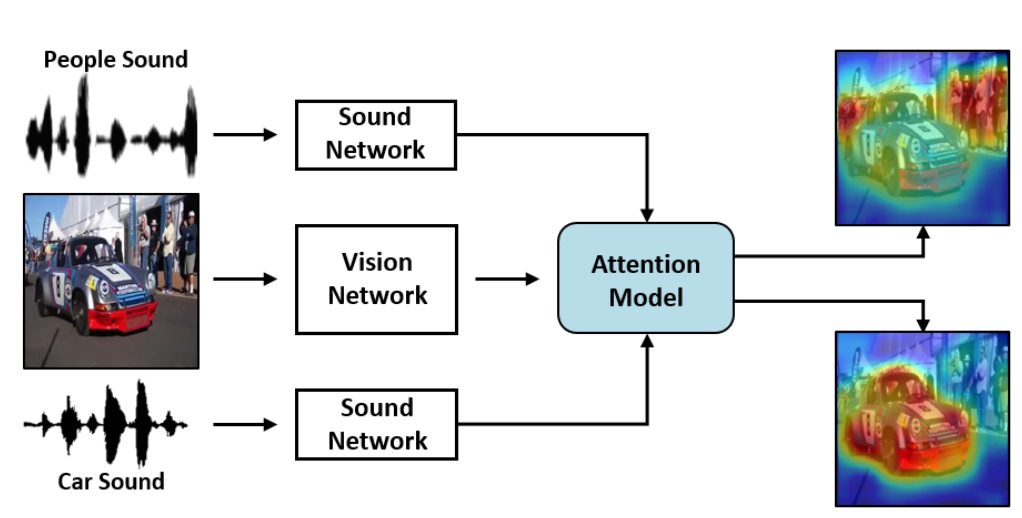

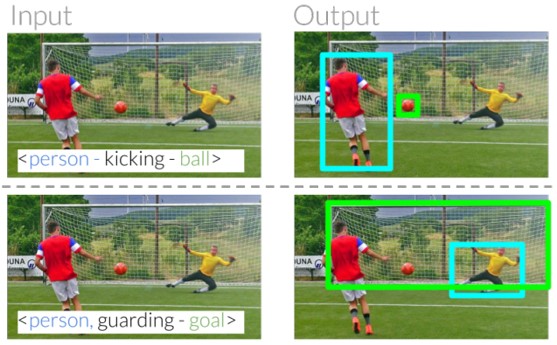

人間の視線情報を用いた動画中のObject Referring (OR)を行う.(OR: 言語記述を伴うシーン内のターゲットオブジェクトのローカライズの問題).物体の外観や動き,注視(視線情報),時空間コンテキストを1つのネットワークに統合する動画におけるORのための新規のネットワークを提案.提案した手法がモーションキューや人間の視線情報,時空間のテキストを効果的に利用可能であることを確認.従来のOR手法より優れていることを確認.

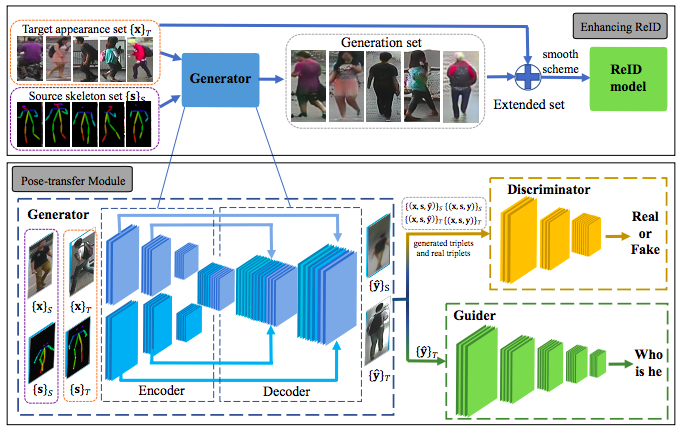

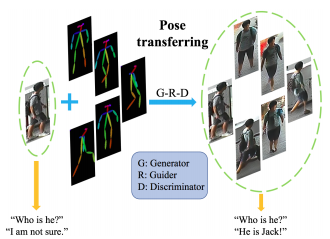

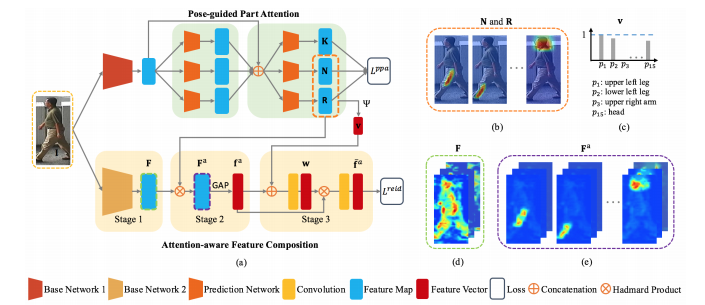

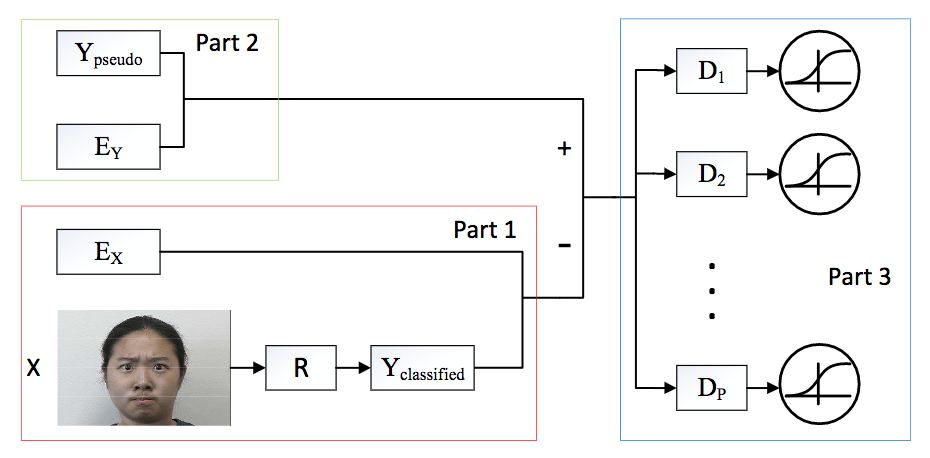

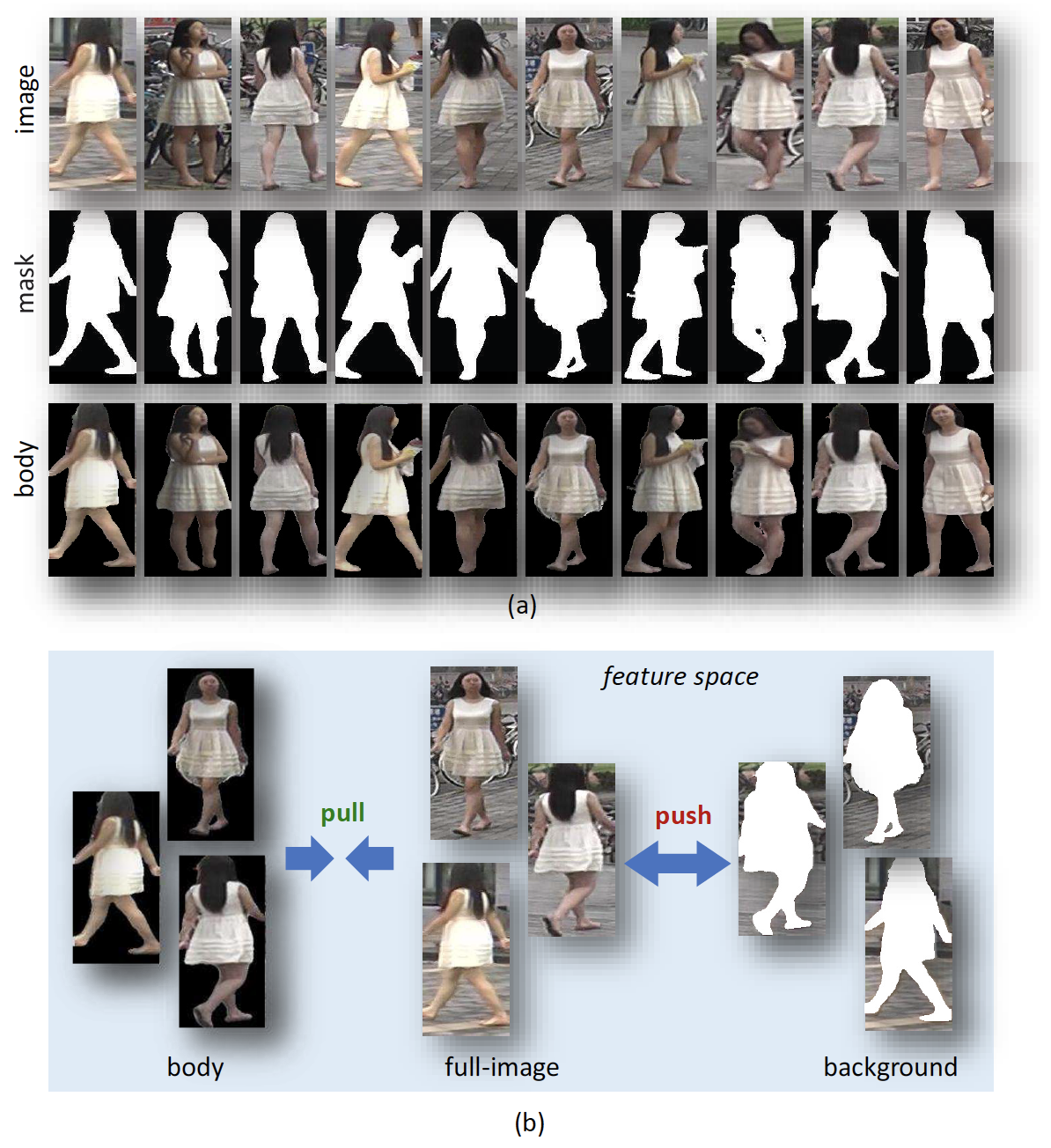

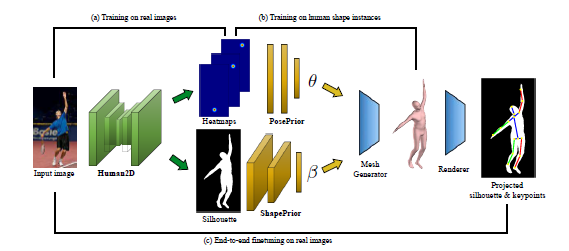

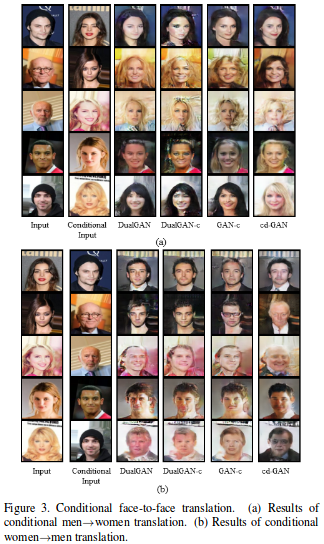

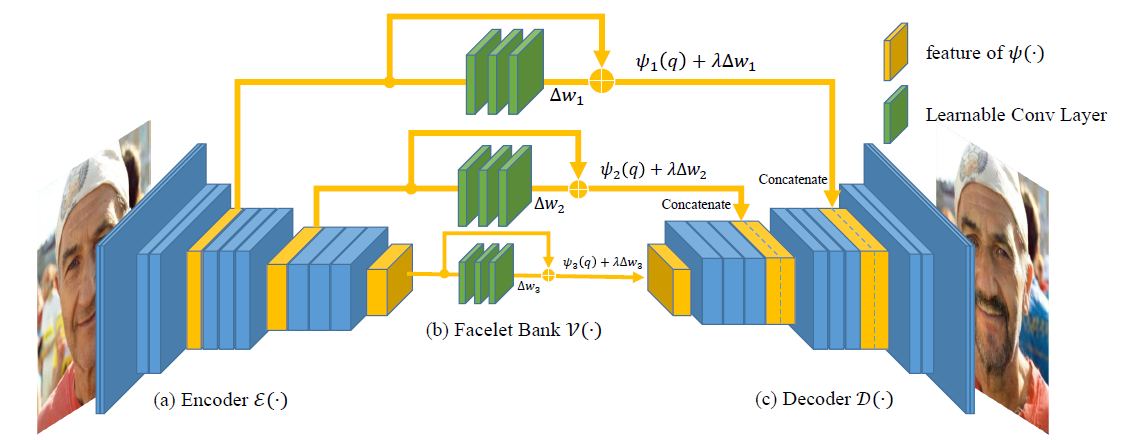

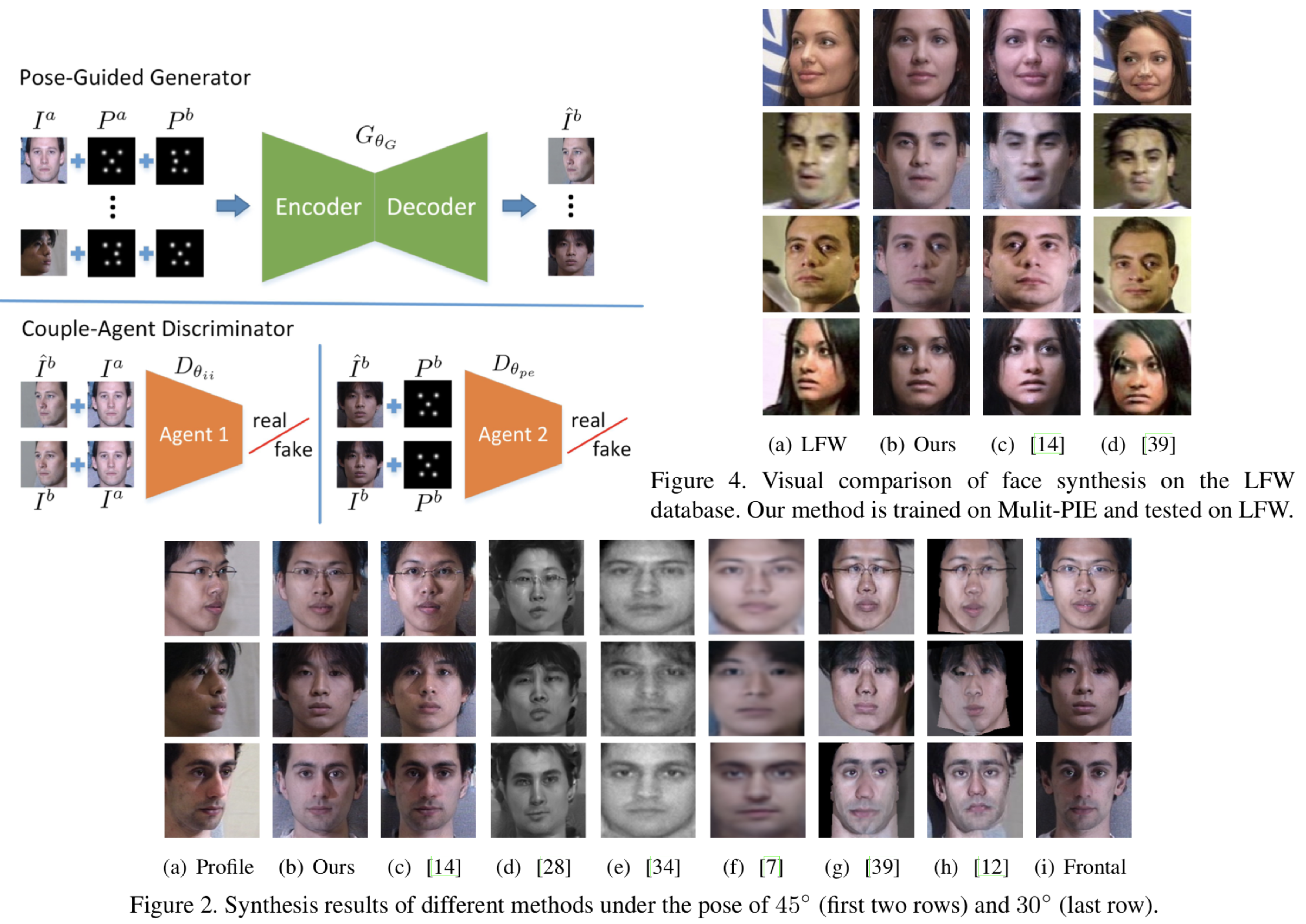

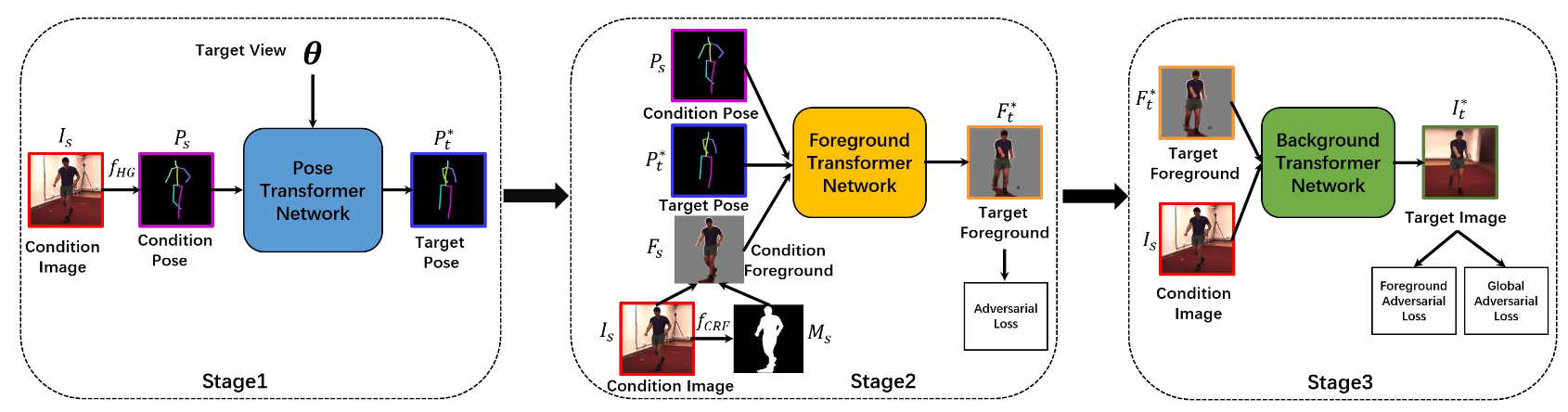

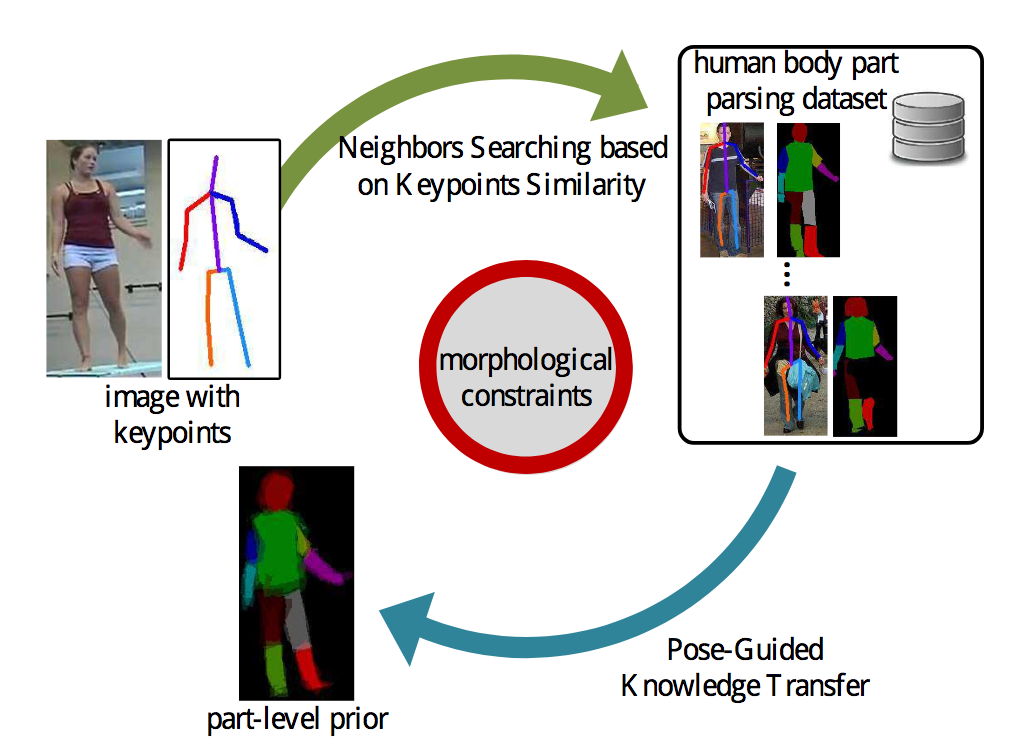

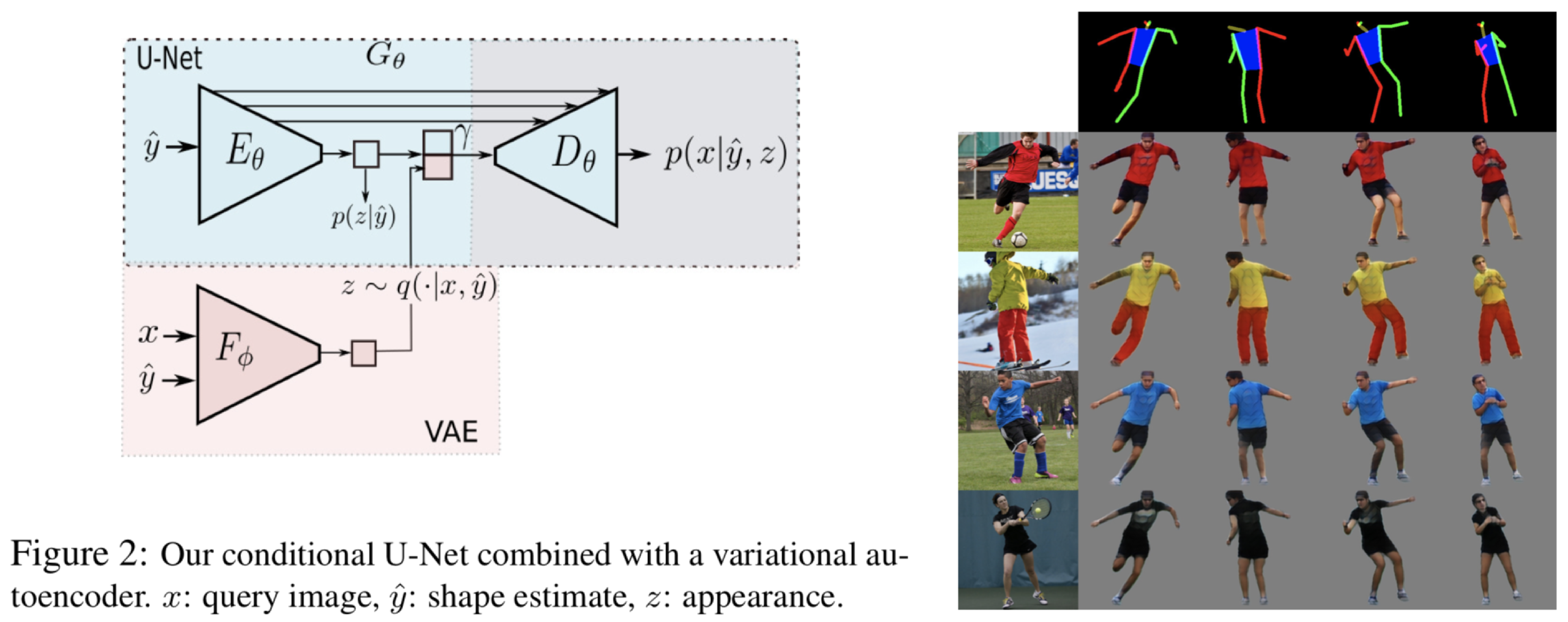

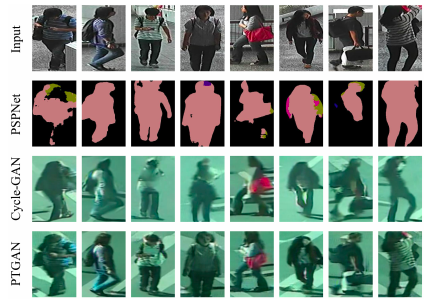

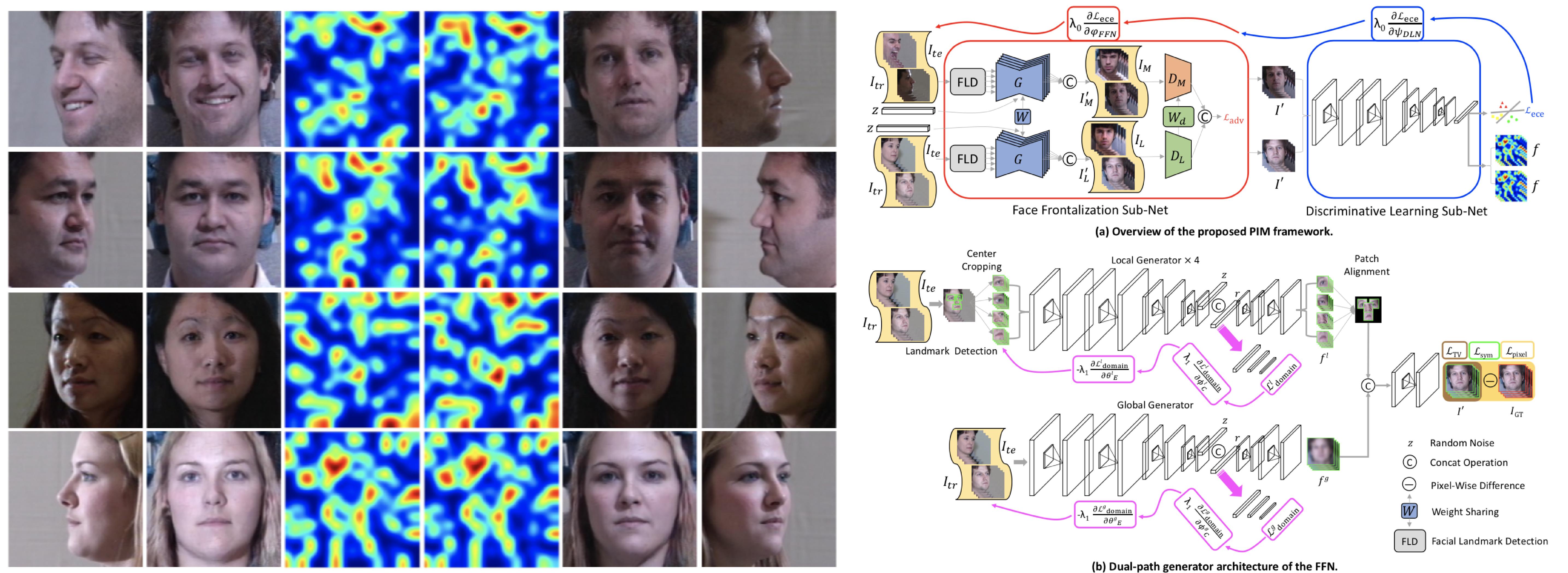

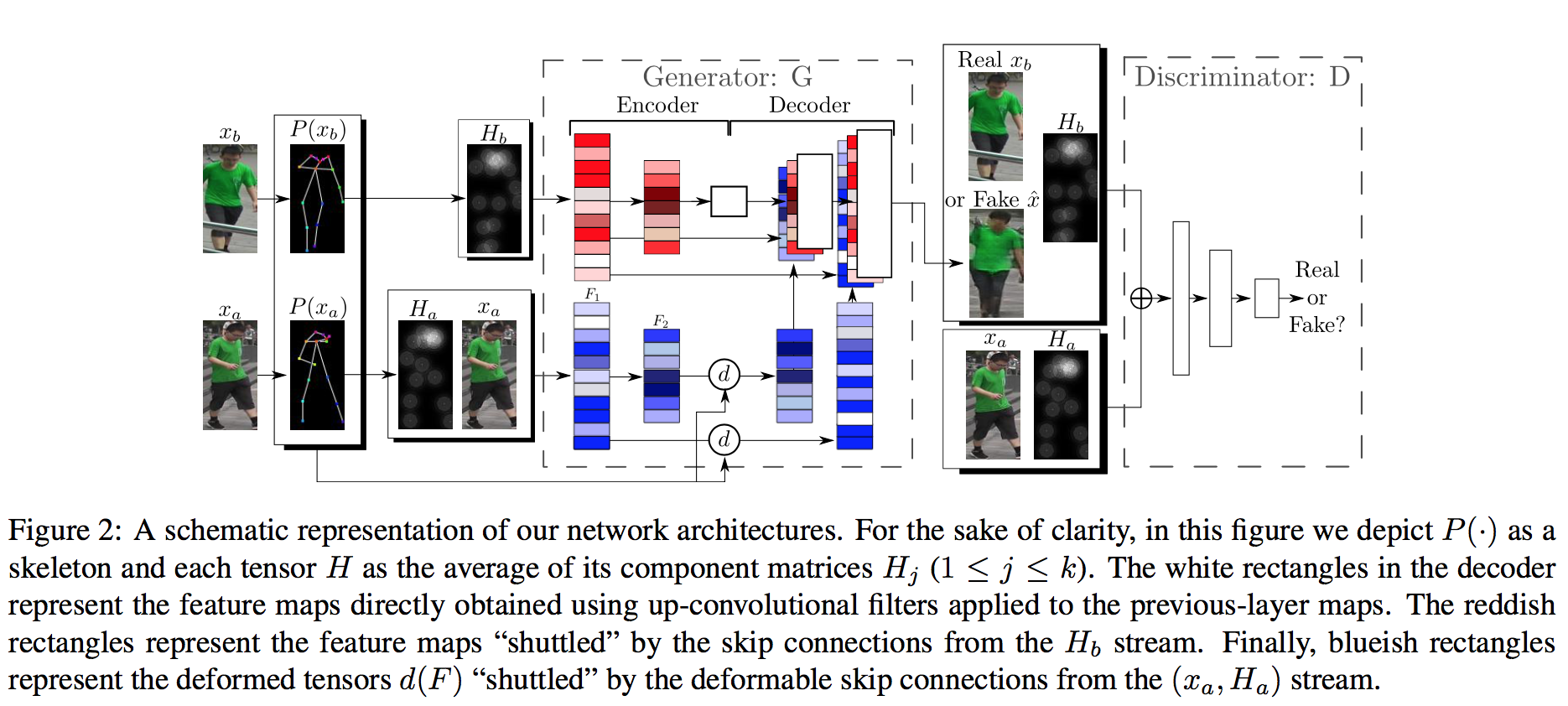

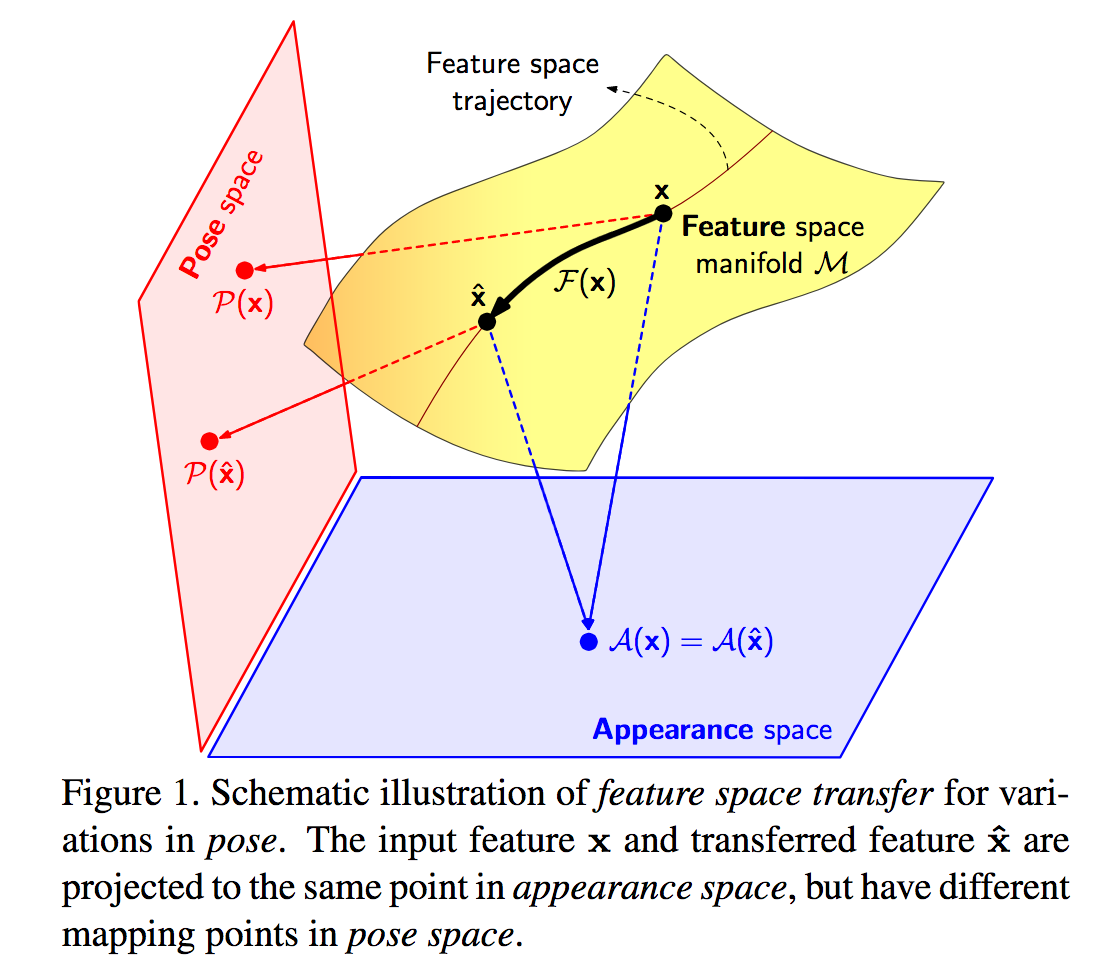

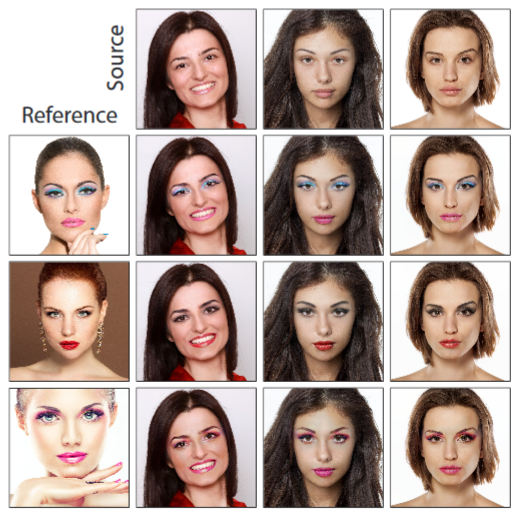

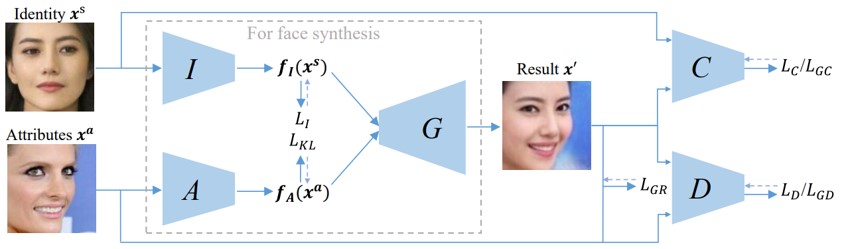

ReIDモデルの学習をより強化するために,Pose transferによるサンプルオーグメンテーションを利用したposetransferrable person ReID frameworkを提案. MARSデータセットのポーズインスタンスを利用し,豊富なポーズバリエーションを持つ新規データを生成,学習することでよりロバストな学習が可能.また従来のGANの識別器に加え,生成した新規データがReIDにおける損失を最適にするguider sub-networkを提案.Market-1501,DukeMTMC-reIDおよびCUHK03において精巧なモデルを使用することなくSOTAであることを確認.

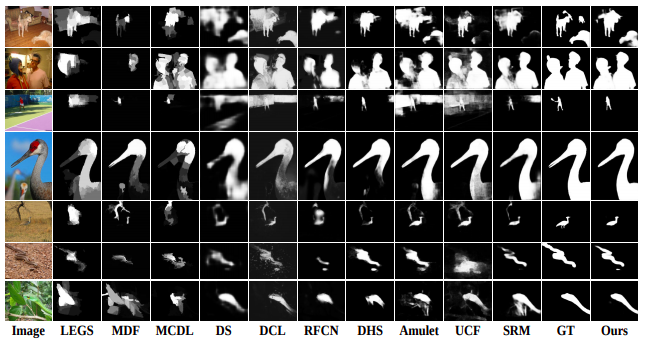

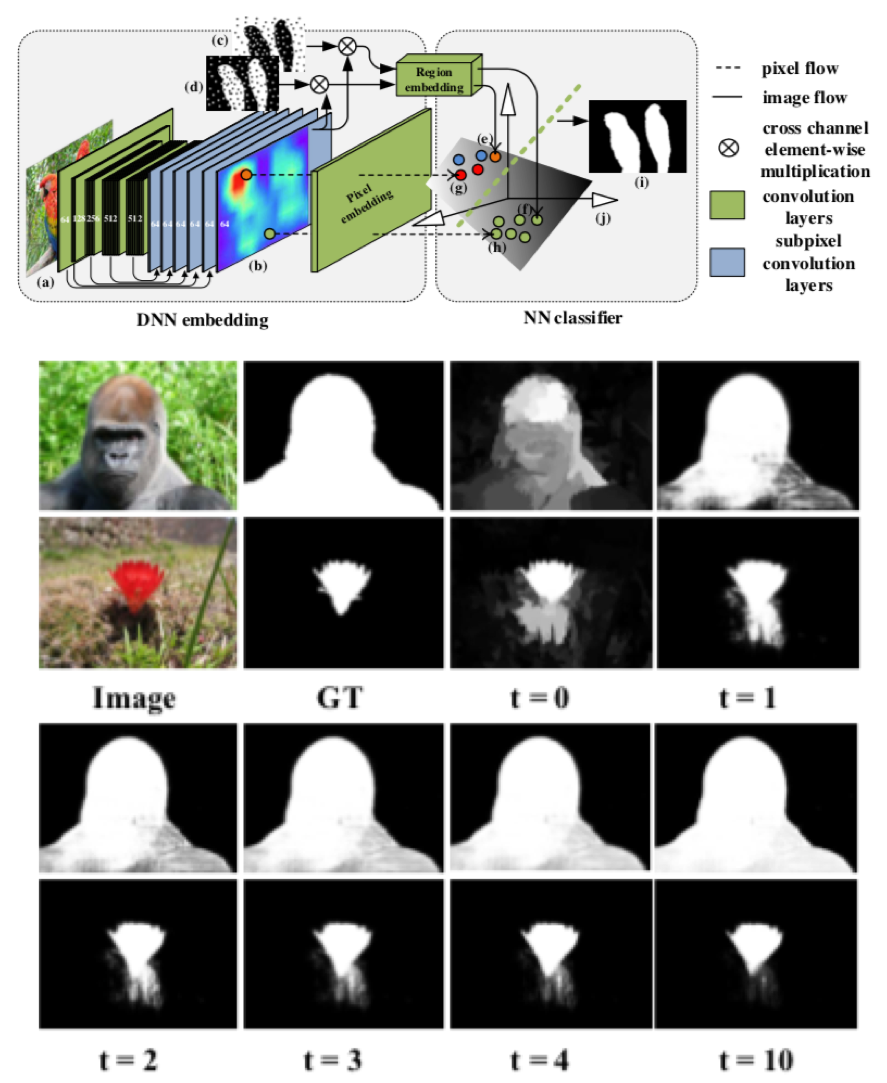

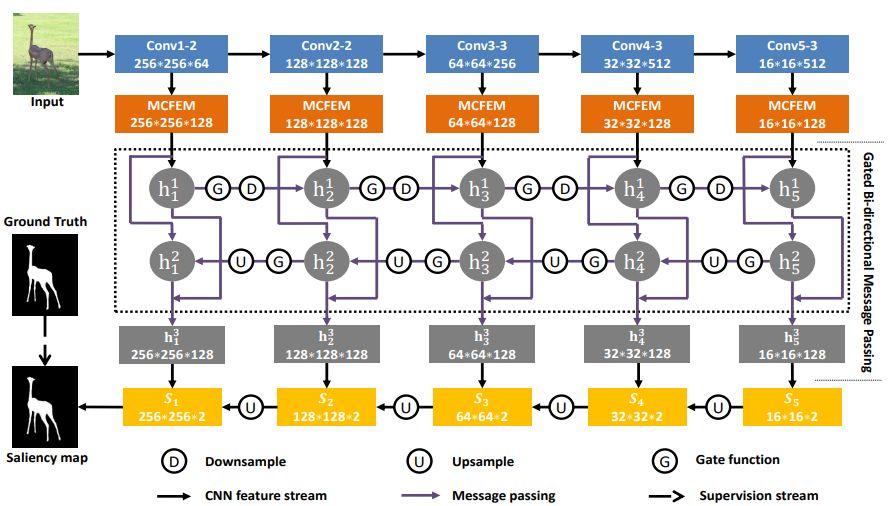

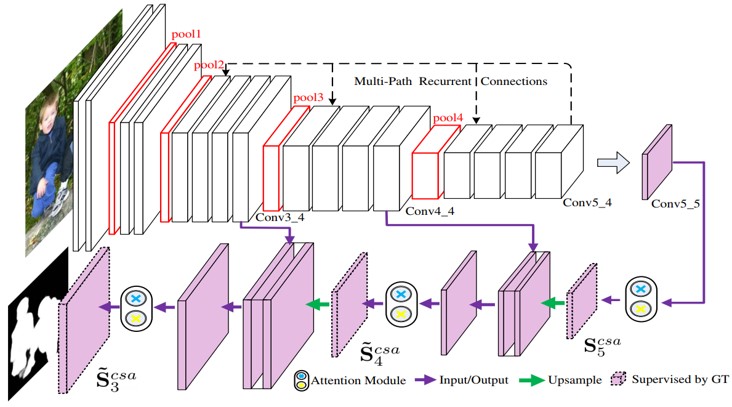

salient objectの位置を正確に特定するために重み付けされた応答マップによってコンテキスト情報を利用可能にするネットワークglobal Recurrent Localization Network (RLN)を提案.また,物体境界を正確に把握するために各空間位置について局所的なコンテキスト情報を適応的に学習するlocal Boundary Refinement Network (BRN)を提案.本アプローチが既存のすべての手法に対してSOTAであることを確認.

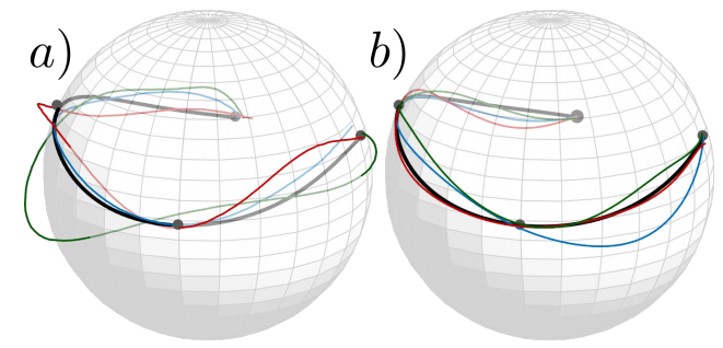

図において、(a)は、通常のGP回帰。黒曲線は予測値であり、他の色の曲線は予測分布からのサンプルであり、球体から大きくずれている。(b)は、データの幾何学的制約を考慮したWGP回帰を使用している結果。

diffusion weighted imaging(DWI)や球上の指向性データ、ケンドール形状空間で検証。多様な値の回帰のための効率的かつ柔軟な手法としてWGP回帰の有効性を示唆。

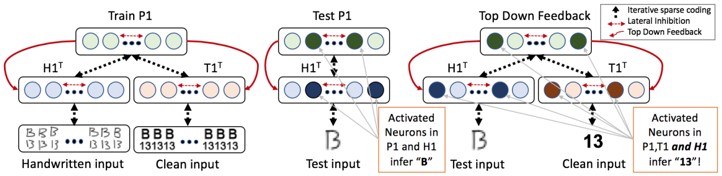

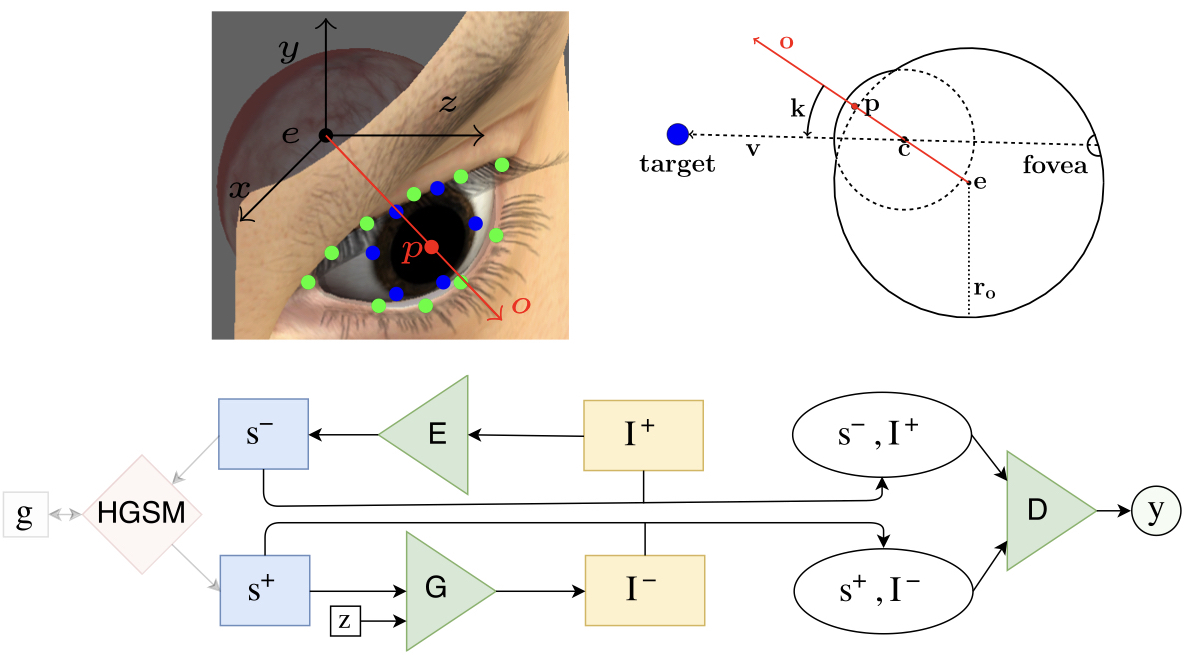

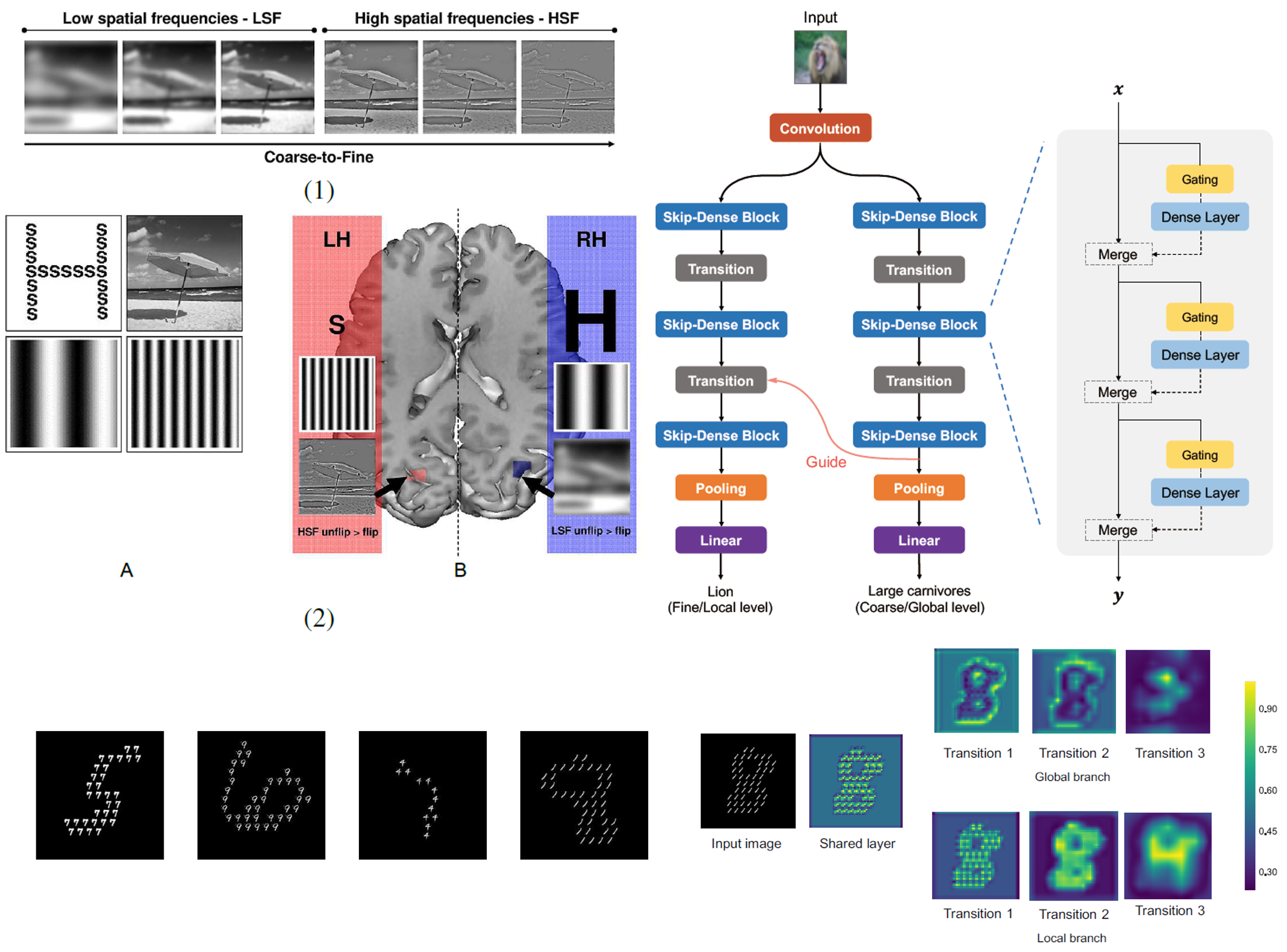

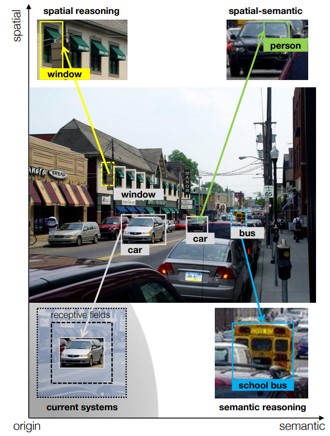

CNNは様々なCVタスクに貢献しており、分類問題では人間を超越しているという結果もある。一般的なアプリケーションでは、やはり人間には及ばない。希薄性、トップダウンフィードバック、横方向抑制など、人間(哺乳類)に見られる脳のしくみに着目し、深層学習においてそれを再現するようにモデリングしている。

CVや機械学習タスク全般における、定性的および定量的な改善を証明。

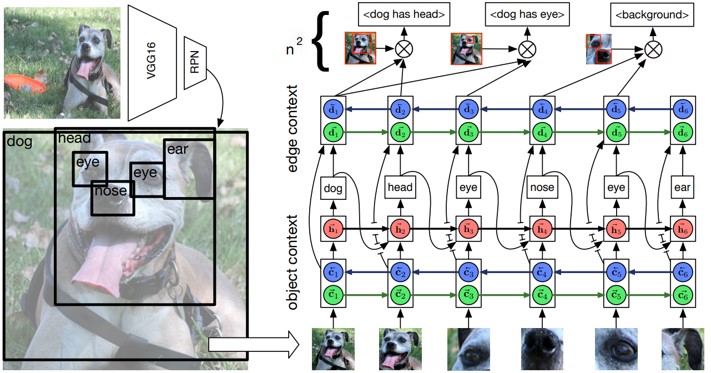

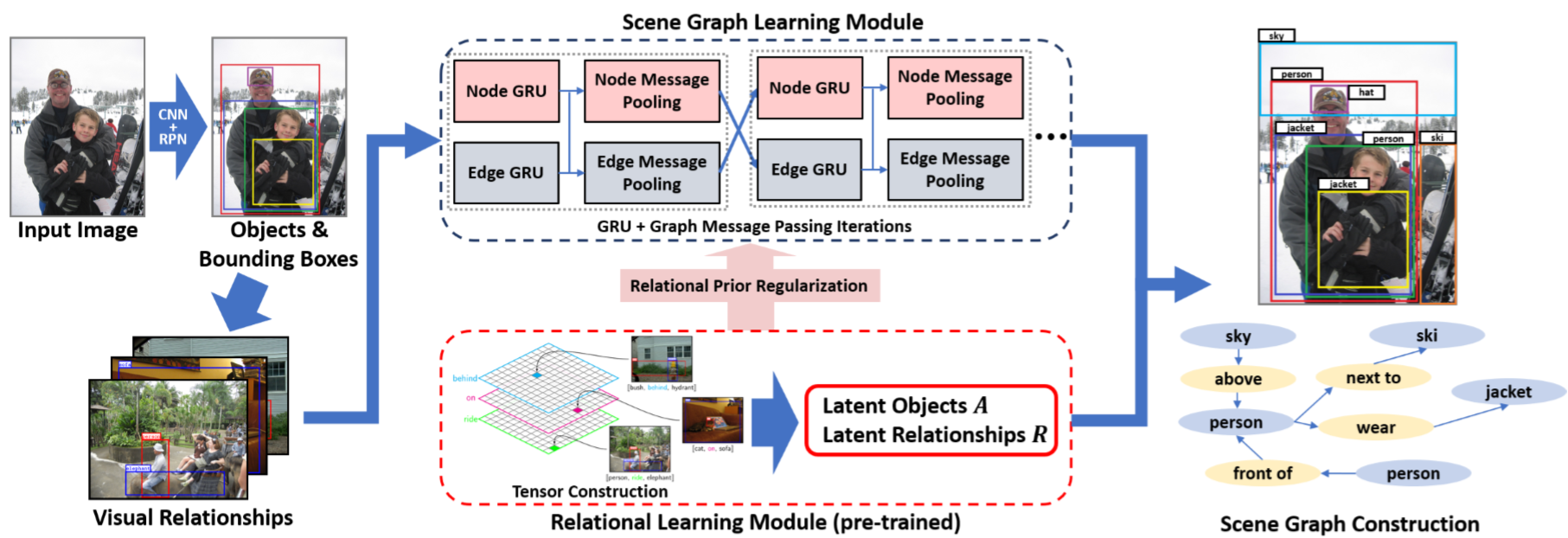

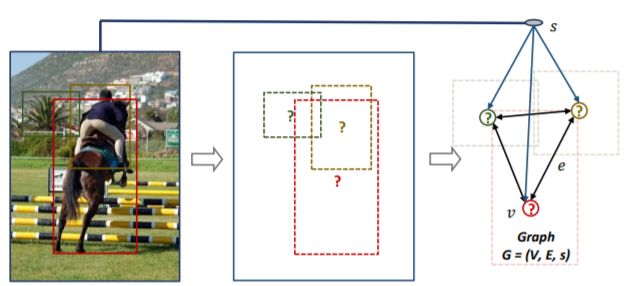

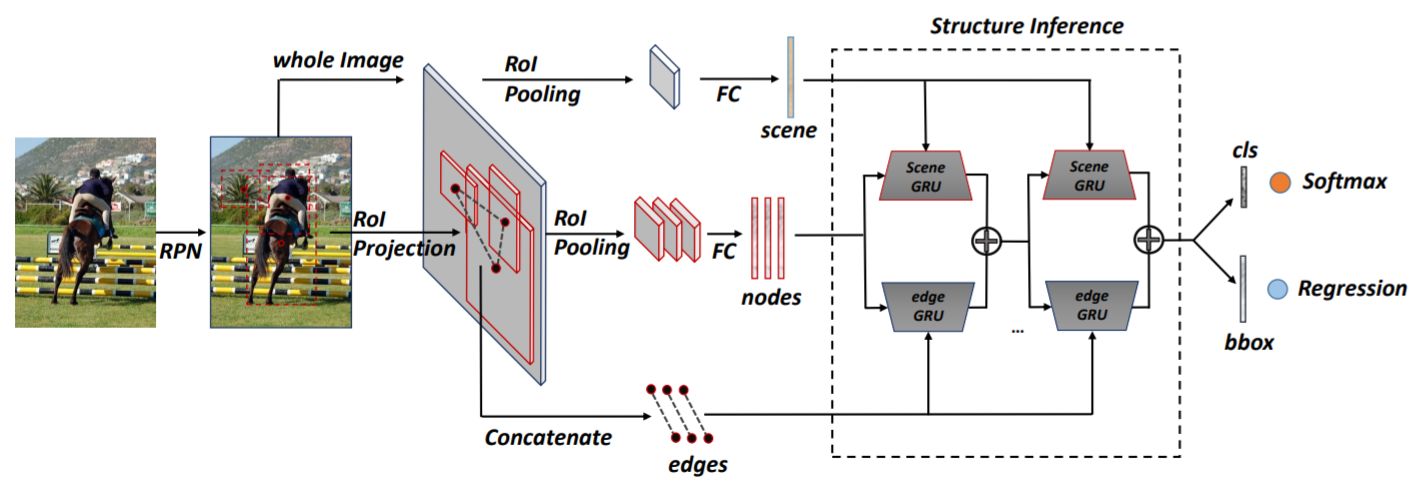

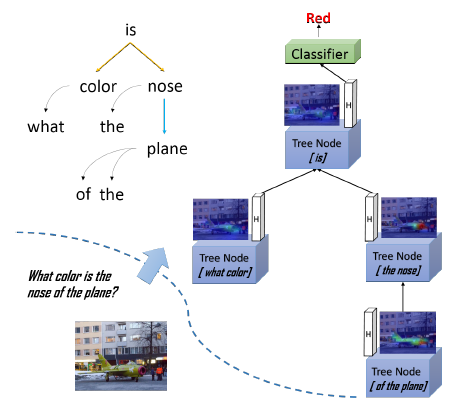

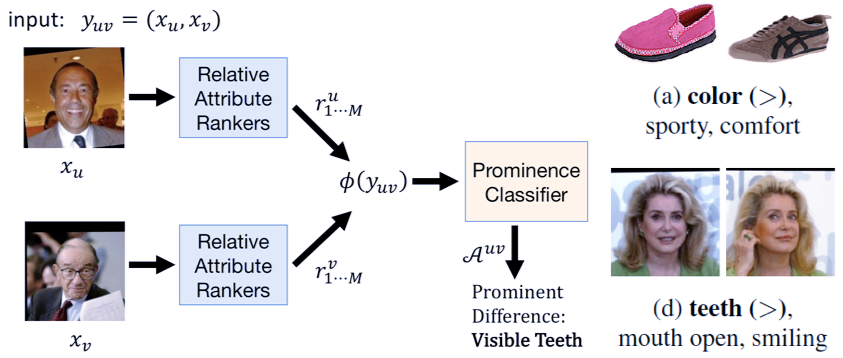

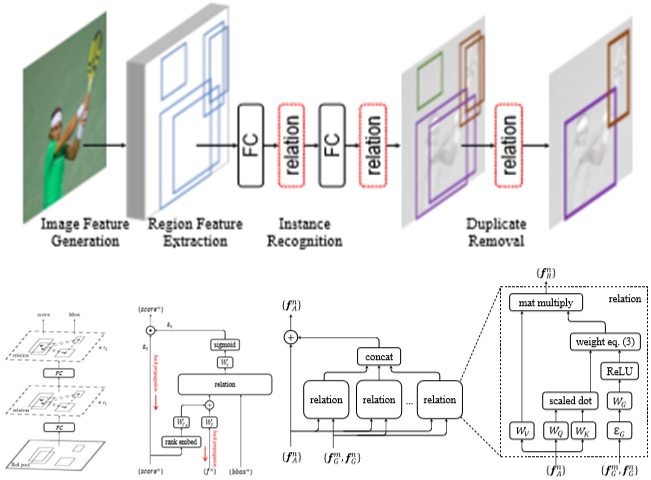

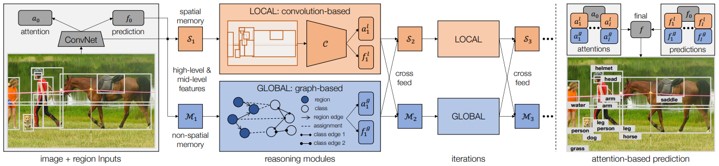

図の犬、耳、目などのバウンディングボックスにおいて、物体間の関係性を構造化する。モチーフという考え方を利用し、Visual Genome datasetを分析。

本マルチグリッド法は、エネルギーベースのCNNモデルを学習することができ、元のcontrastive divergence(CD)とpersistent CDより高精度。

2つの異なるクラスのモデル間の不一致や学習の不安定性などの問題を改善することによって、GAN法の代替え法として有効。

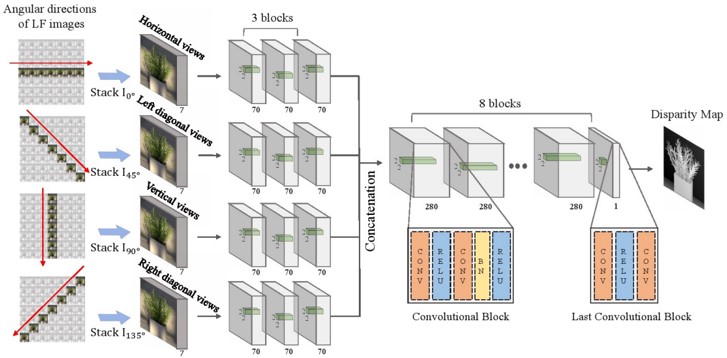

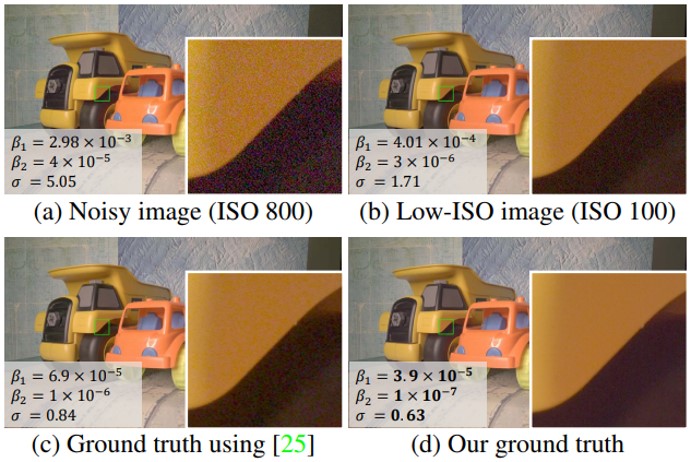

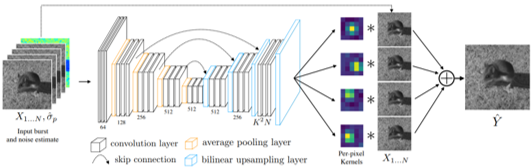

ライトフィールドカメラは、光線の空間的性質および角度的性質の両方を取得できる。様々な照明環境のライトフィールドから深度を計算可能。しかし、ハンドヘルドカメラからのライトフィールド画像は、ノイズが多く深度推定が困難。これらを克服したネットワークを提案。

HCI 4D Light Field Benchmarkにて高精度を確認し、実世界のライトフィールド画像に対する手法の有効性を確認。

CNNの効率化のために、より深く畳み込む手法やグループ化した畳み込みが提案されている。CLC Blockによってネットワークを構成することで、パラメータ数を抑えて計算効率を向上させることができる。

ImageNet-1Kにて効率化の有効性を証明。

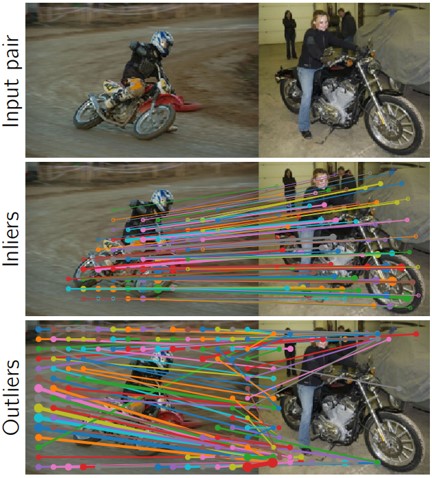

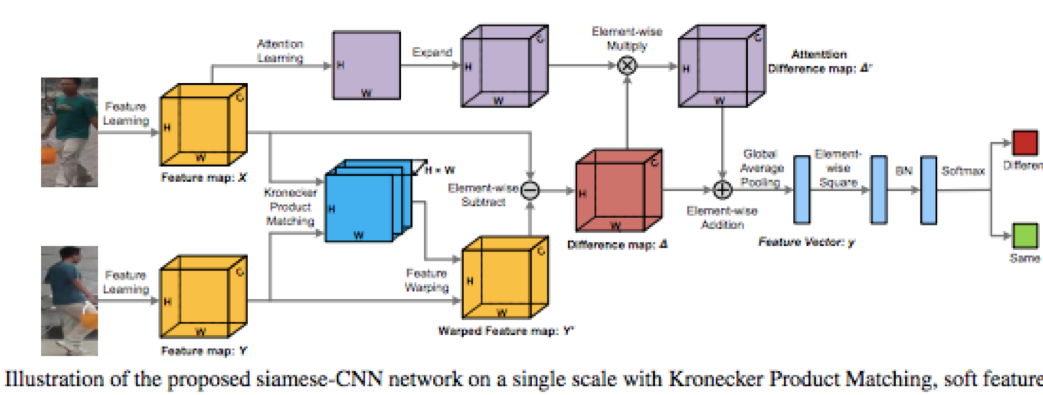

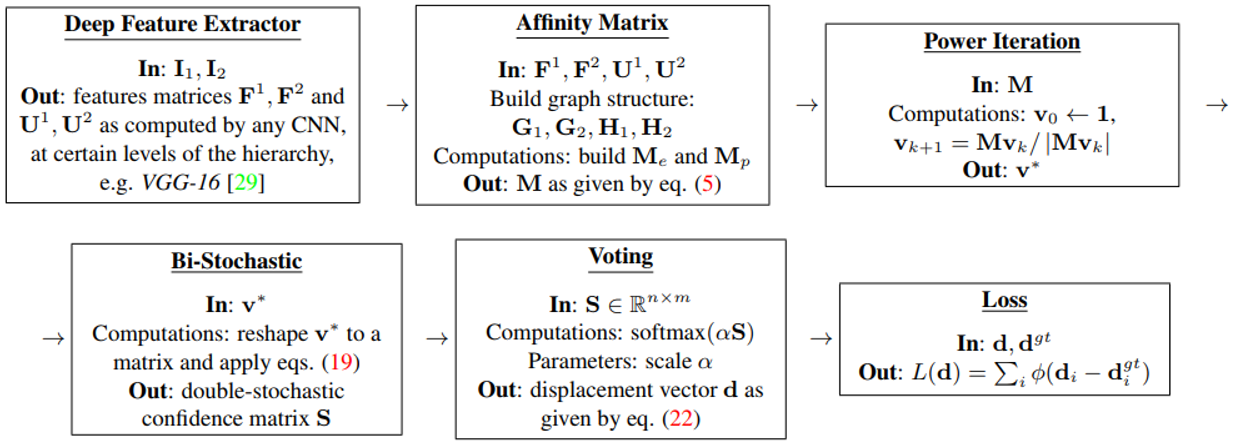

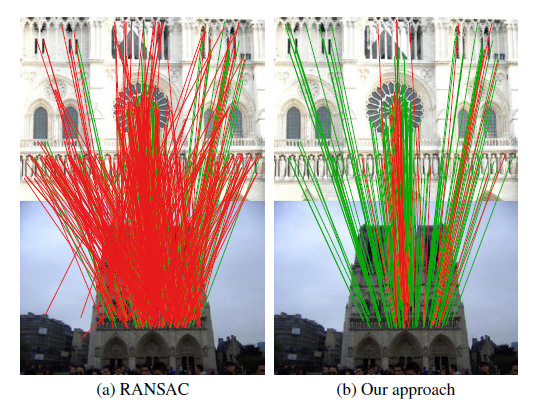

入力画像ペア(図上)において、意味的に一致する密な対応を、幾何学変換とおもに出力し(図中) 、幾何学的に一致しないペアを破棄する(図下) CNNを提案。RANSACからインスパイアされた手法によって、ネットワークアーキテクチャとトレーニング手順を設計し、弱教師付き学習で実装可能。

精度は高く、SOTA。しかし、依然として複数のオブジェクトが存在する場合や、違うクラスにおける画像ペアを扱うことができていない。

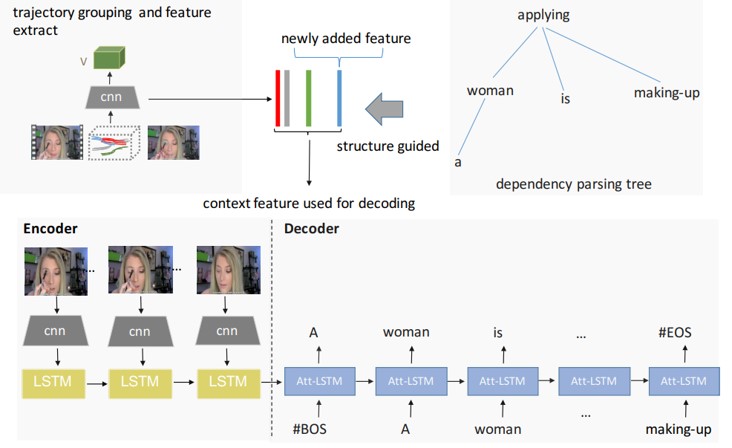

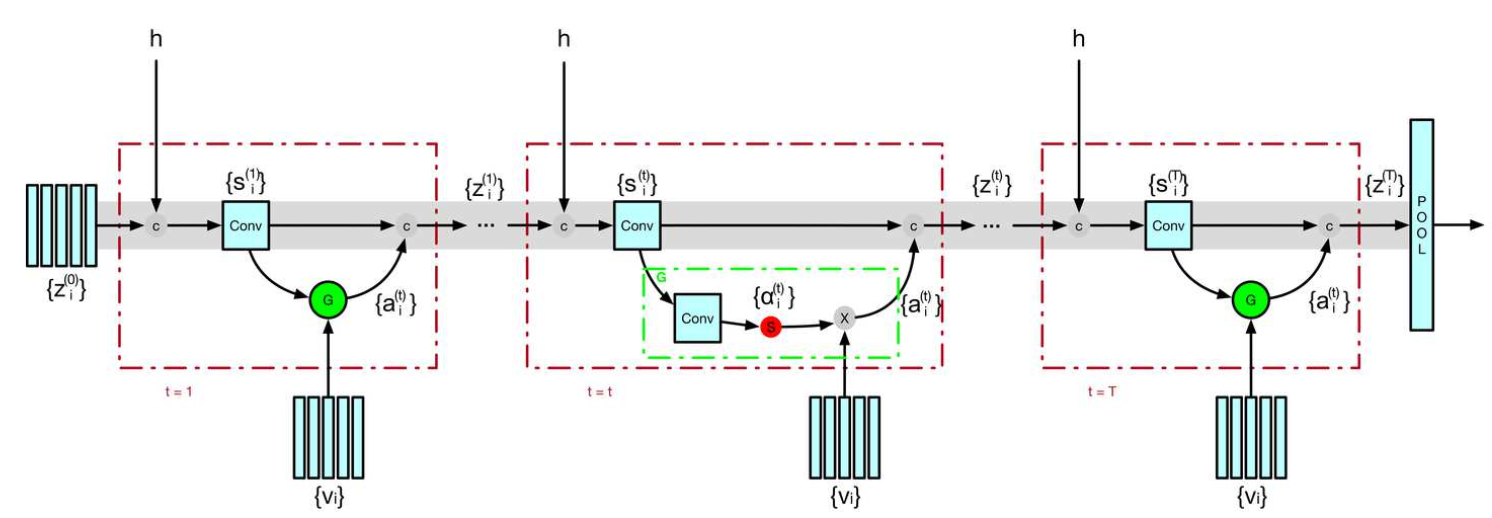

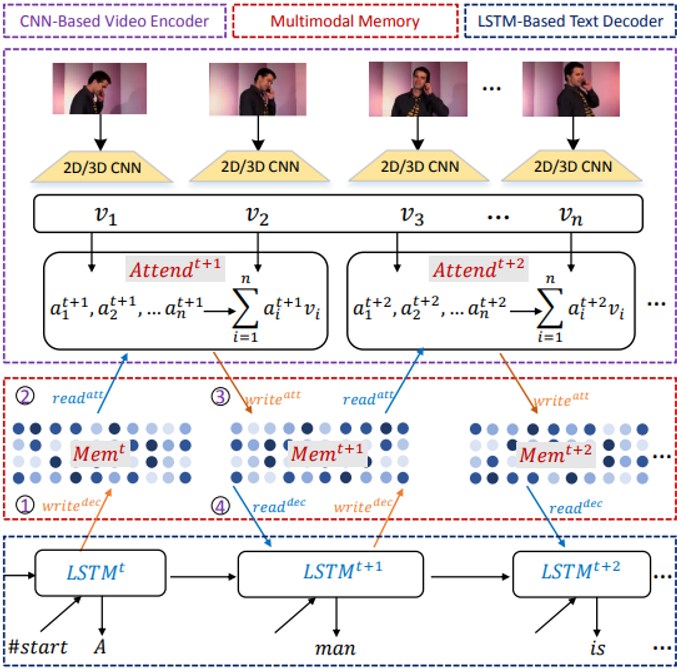

既存の手法では、RNNに入力する前にグローバルな画像特徴を取っているだけであると指摘。異なる時間において、顕著な物体に着目することや、微妙な言語表現を学習するために細かい移動や動きに対する関係性を見出す必要がある。Trajectoryレベルでの特徴を統合して学習することにより、動画中の動く物体を精度よく記述できる。

CharadesとMSVDデータセットで実験し精度向上を確認。また、提案手法は可視化ツールとしてみなすことができ、モデルの解釈能力を向上させることができる。

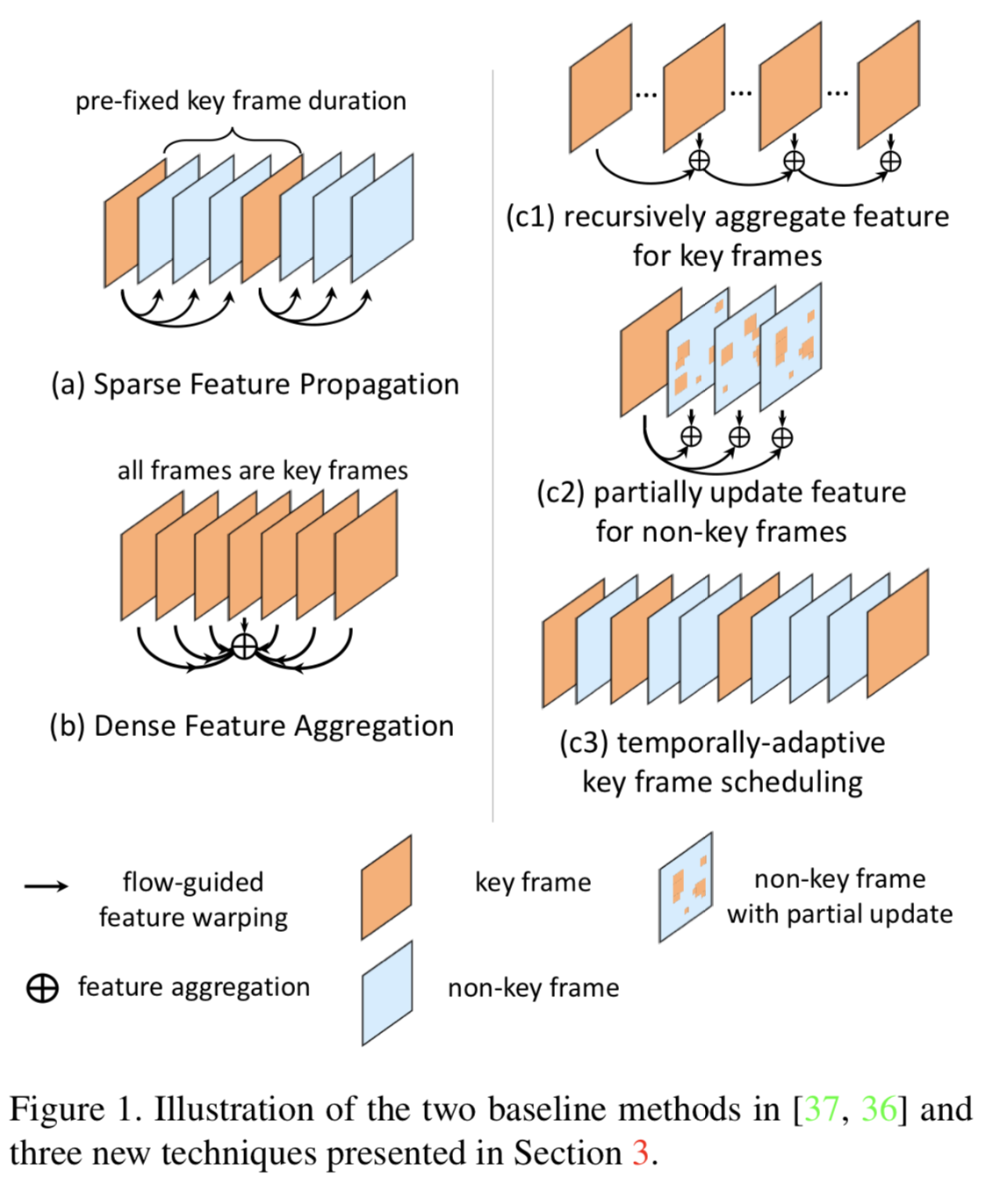

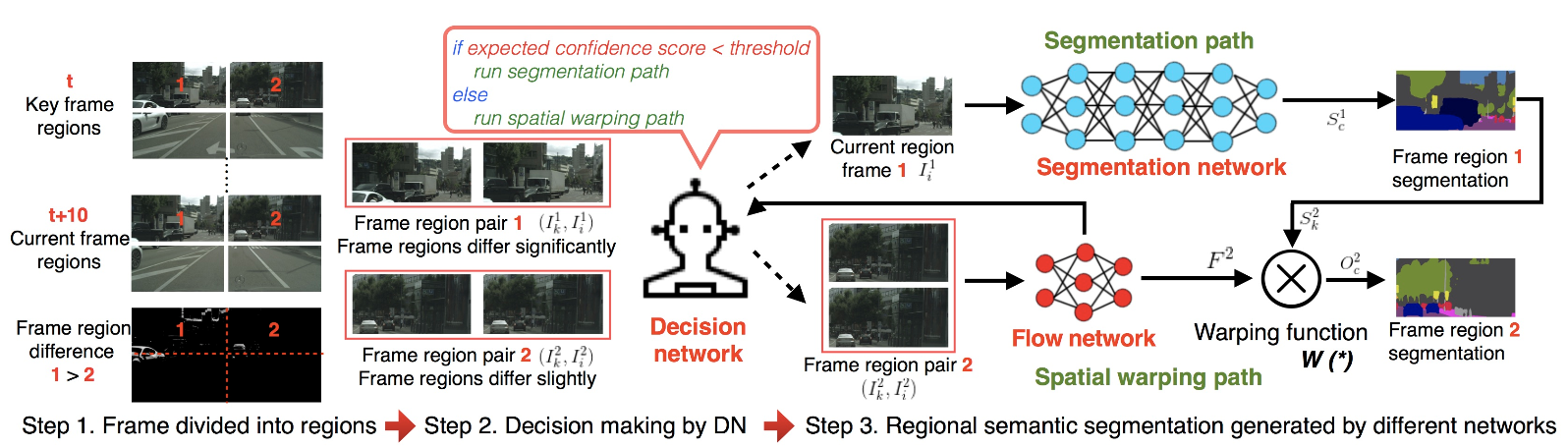

アノテーションなしで余分な計算を減らしつつ学習する。ラベルのないフレームに存在する情報を順番に利用でき、セグメンテーションの精度と時間的一貫性の両方を改善することに成功。

CityScapesやCamVidデータセットにおいて精度向上を確認。

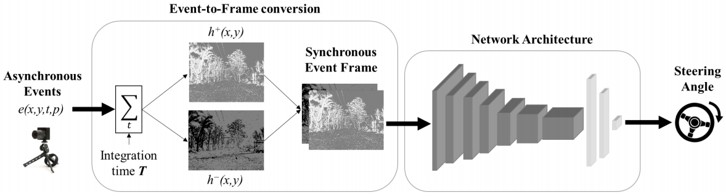

動き推定タスクにおいて無駄のない情報を得ることができるイベントカメラを用いて、そのポテンシャルを示すことにモチベーションを置いている。イベントセンサーの出力と連携して動作するように設計することで高精度に推定できる。

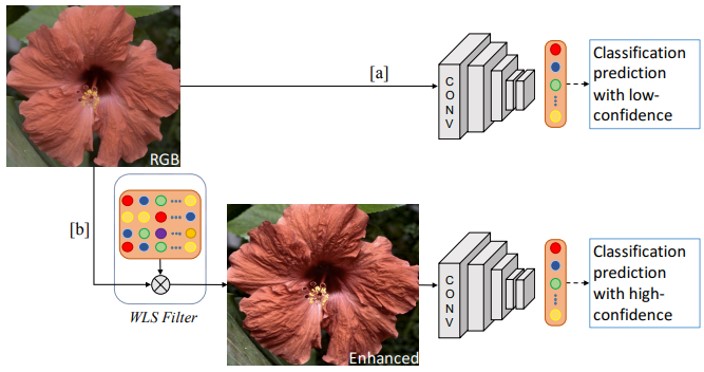

CNNは、画像の質感や構造を利用して、分類するための識別器として使われるが、Image Enhancementによって画像を協調し、CNNの前処理として使用可能。既存の画像強調手法は、人間の画像の知覚向けに設計されている。画像強調のためにCNNを拡張し、画像分類精度が向上するように共同で学習することができる。

CUB 200-2011、PASCAL VOC2007、MIT Indoor、DTDの4つのベンチマークデータセット(fine-grained, object, scene, and texture classification)で実証。全ての一般的なCNNにおいて精度向上を確認。

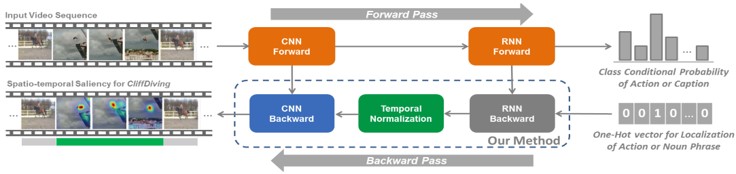

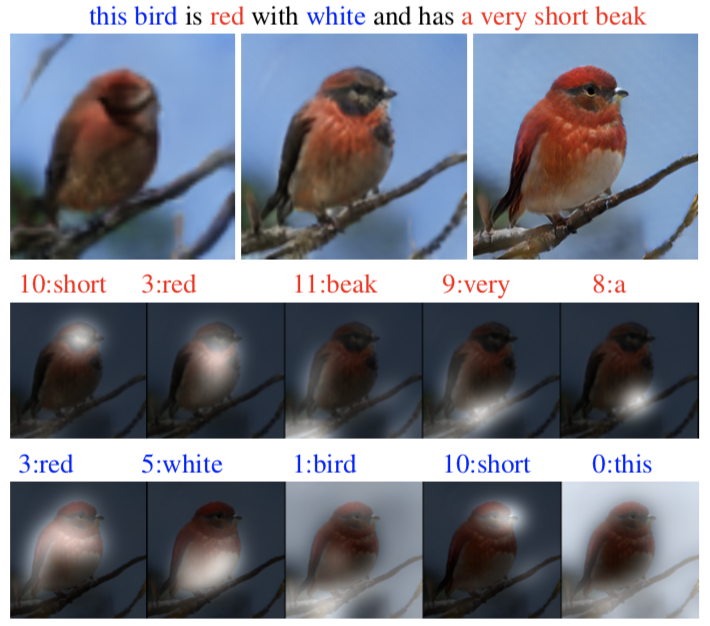

RNNが何を根拠にタスクをこなすのか、GradCamのように出力するモデルの提案。図は、CliffDivingとHorseRidingの両方を含む動画において、アクティブクラスであるCliffDivingの顕著性を強調している例。

ActionとCaptionにて実験。単語に対するローカライズの精度は良い印象だが、キャプショニングの場合の精度は微妙。

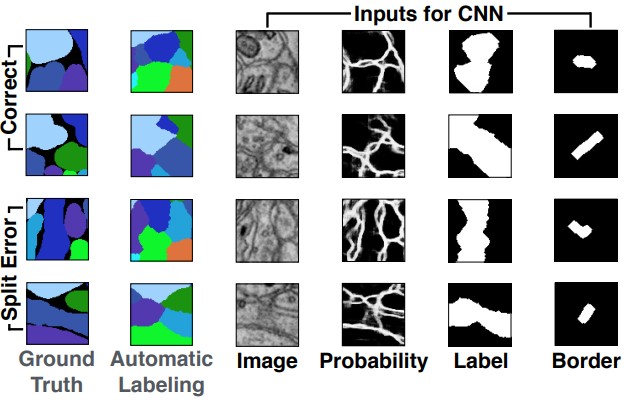

コネクトミックという神経の分野におけるセマンティックセグメンテーションでは、エラーがたびたび発生する。これらのエラー部分を人間に提示し、マージとスプリットの候補を自動でクラシフィケーションする。CNNで自動セグメンテーションのエラーを学習することで実現。人間がYes/Noを判定する校正が基本だが、確率に閾値を設けることで自動構成モードにも切り替えられる。

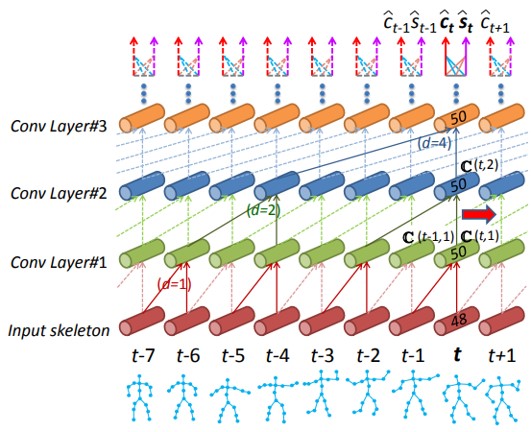

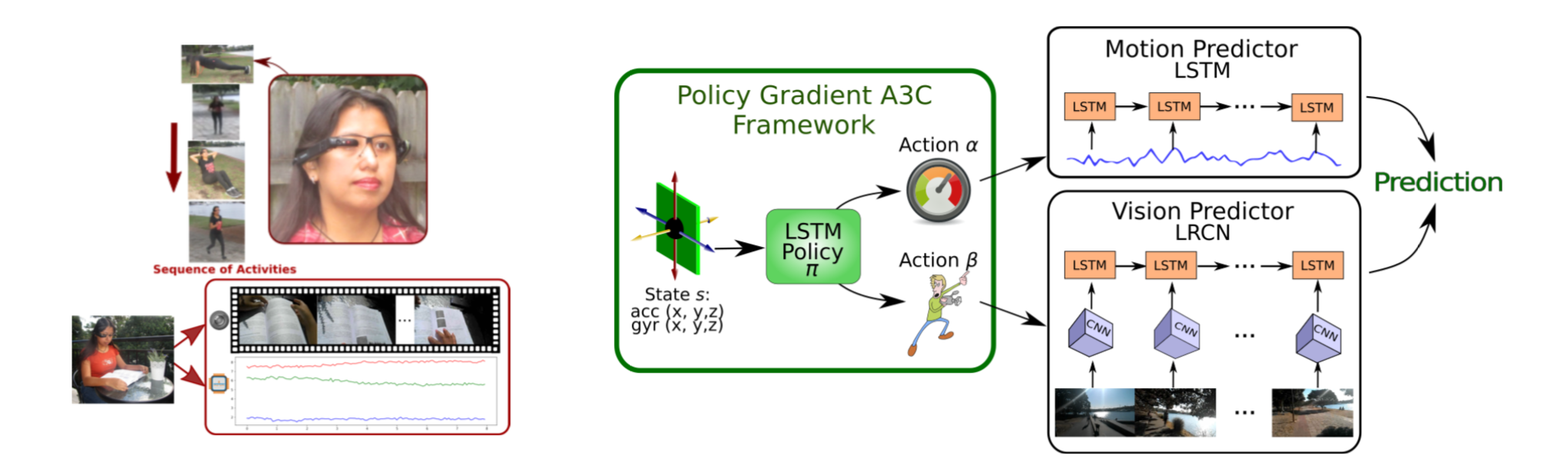

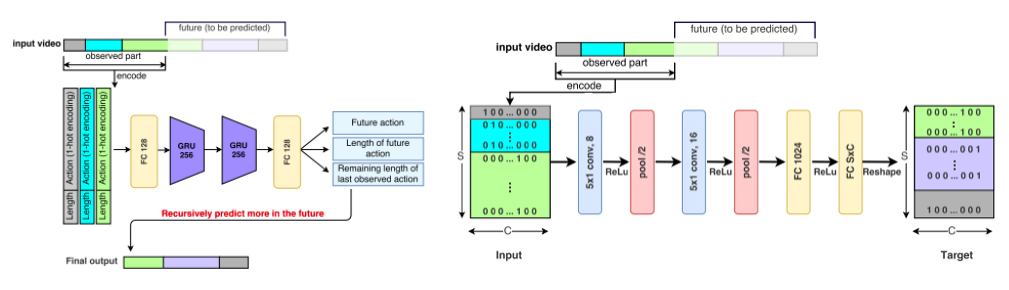

行動に対して、タイムステップごとにラベル付けをおこなう行動予測において問題視されるスケール変動や計算の効率化に着目している。スケルトンを入力とし、行動ラベルや行動開始時間を出力とする。

行動予測用データセットのPKU-MMDとOADにて実験し、従来手法と比較して高精度化を実証。

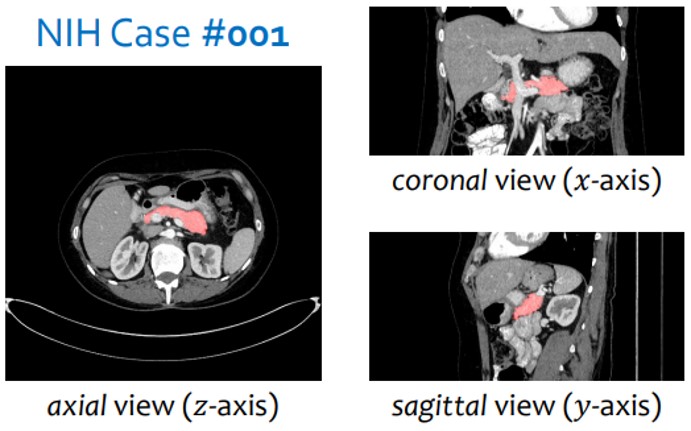

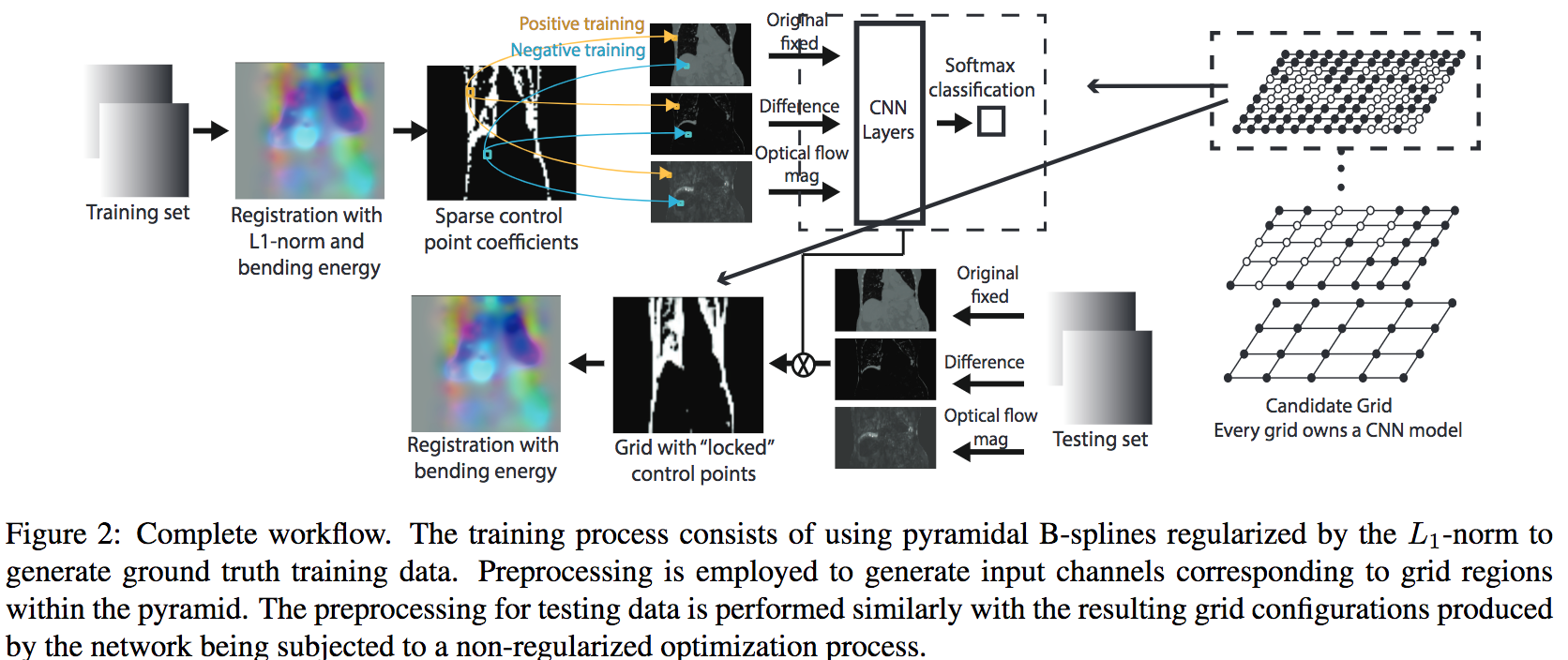

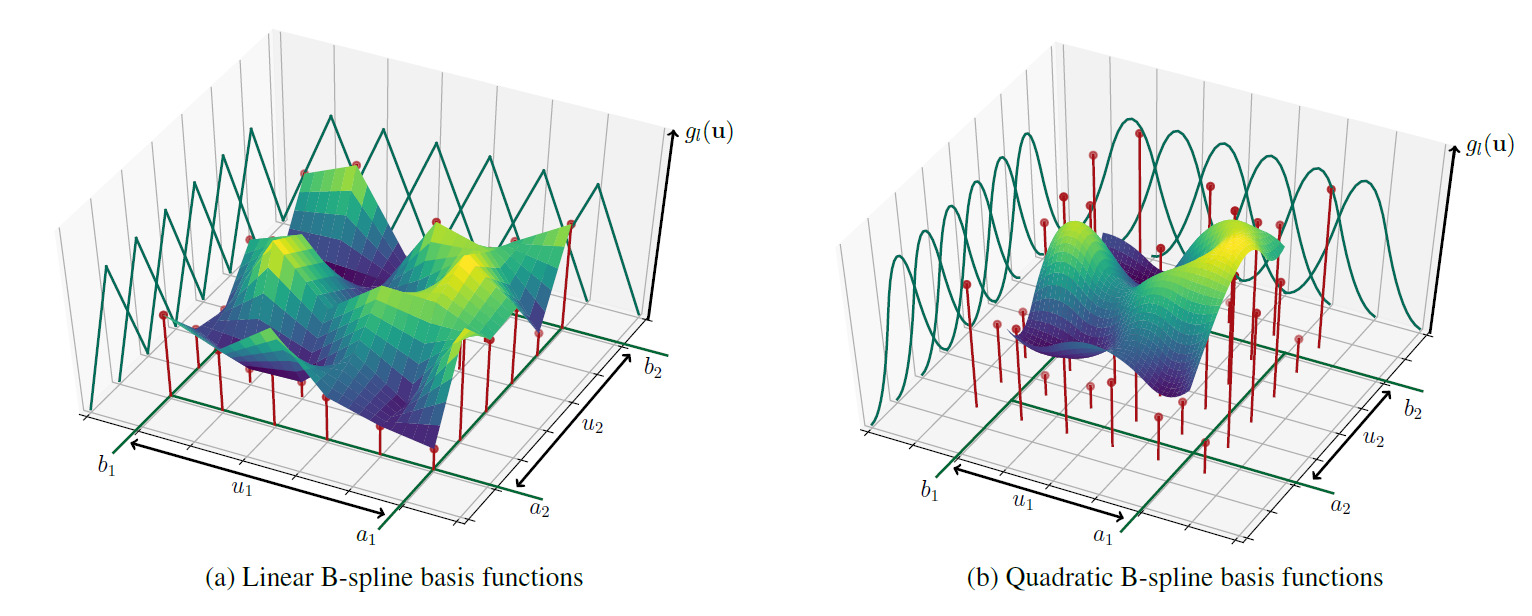

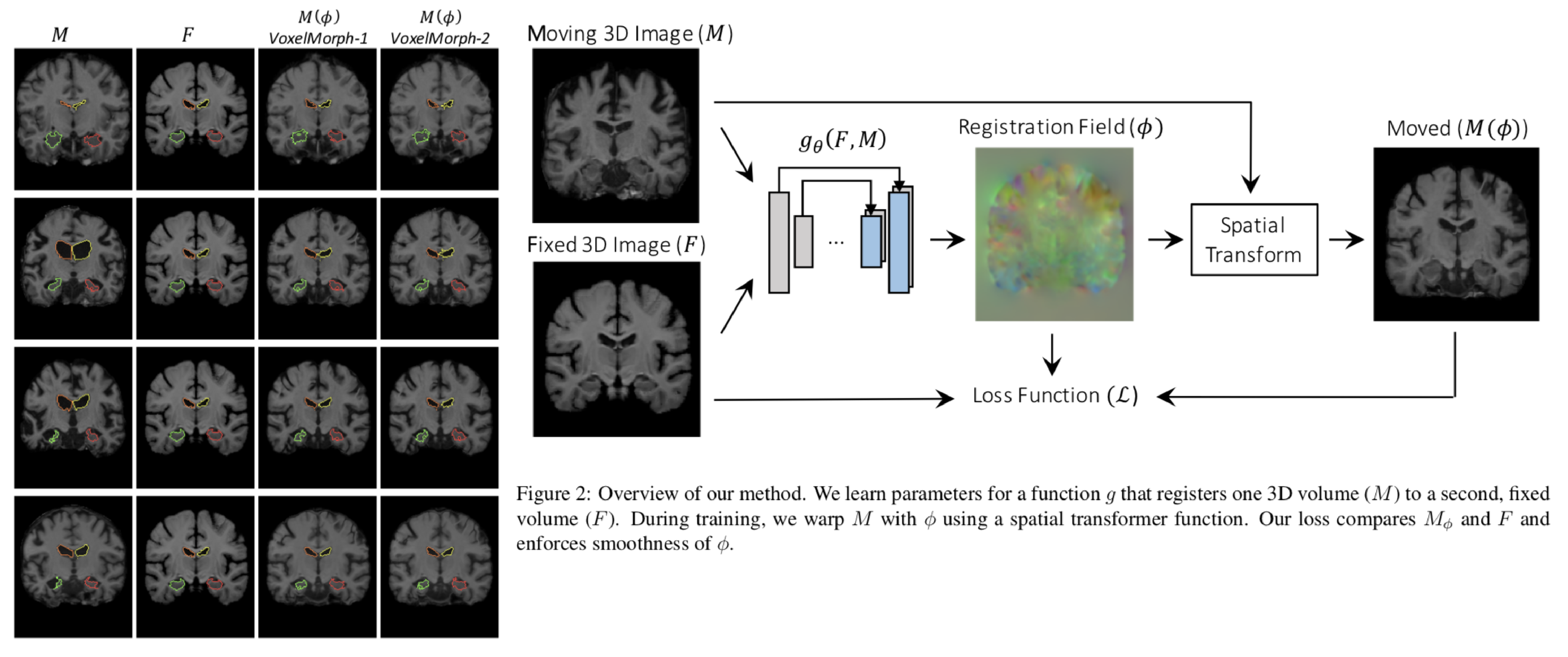

異なる時間に撮影された2つの画像や異なるモダリティを共通の座標系にマッピングする空間変換を再現しようとするタスクにおいて、2つの画像間の変換を記述するための最も適切なパラメータ化を学習することに焦点を当てたmulti-grid B-spline法を提案

B-splineのパラメータを大幅に削減

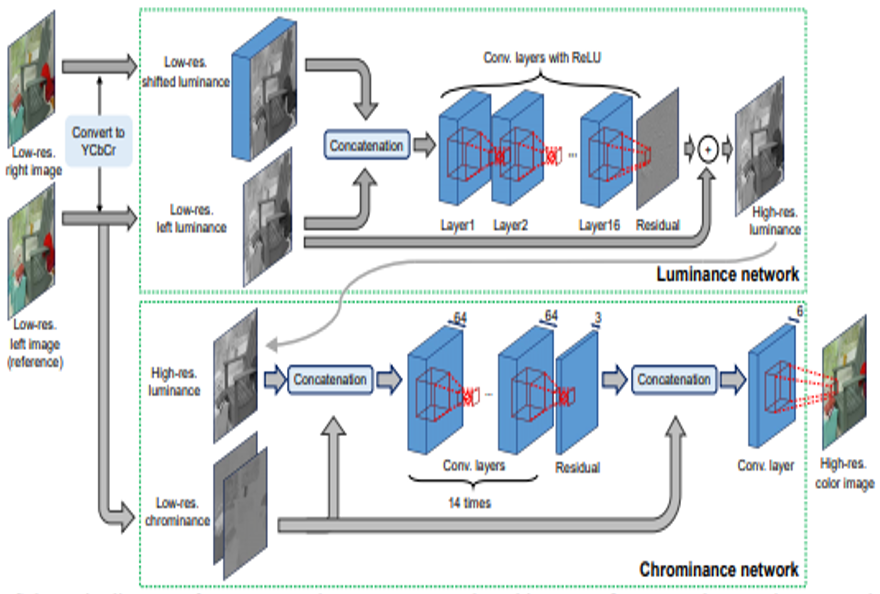

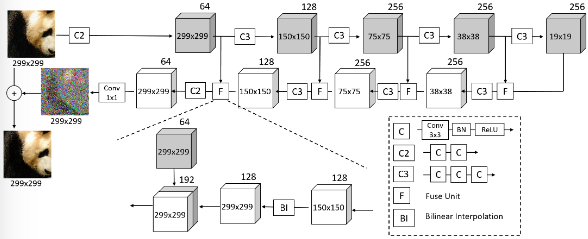

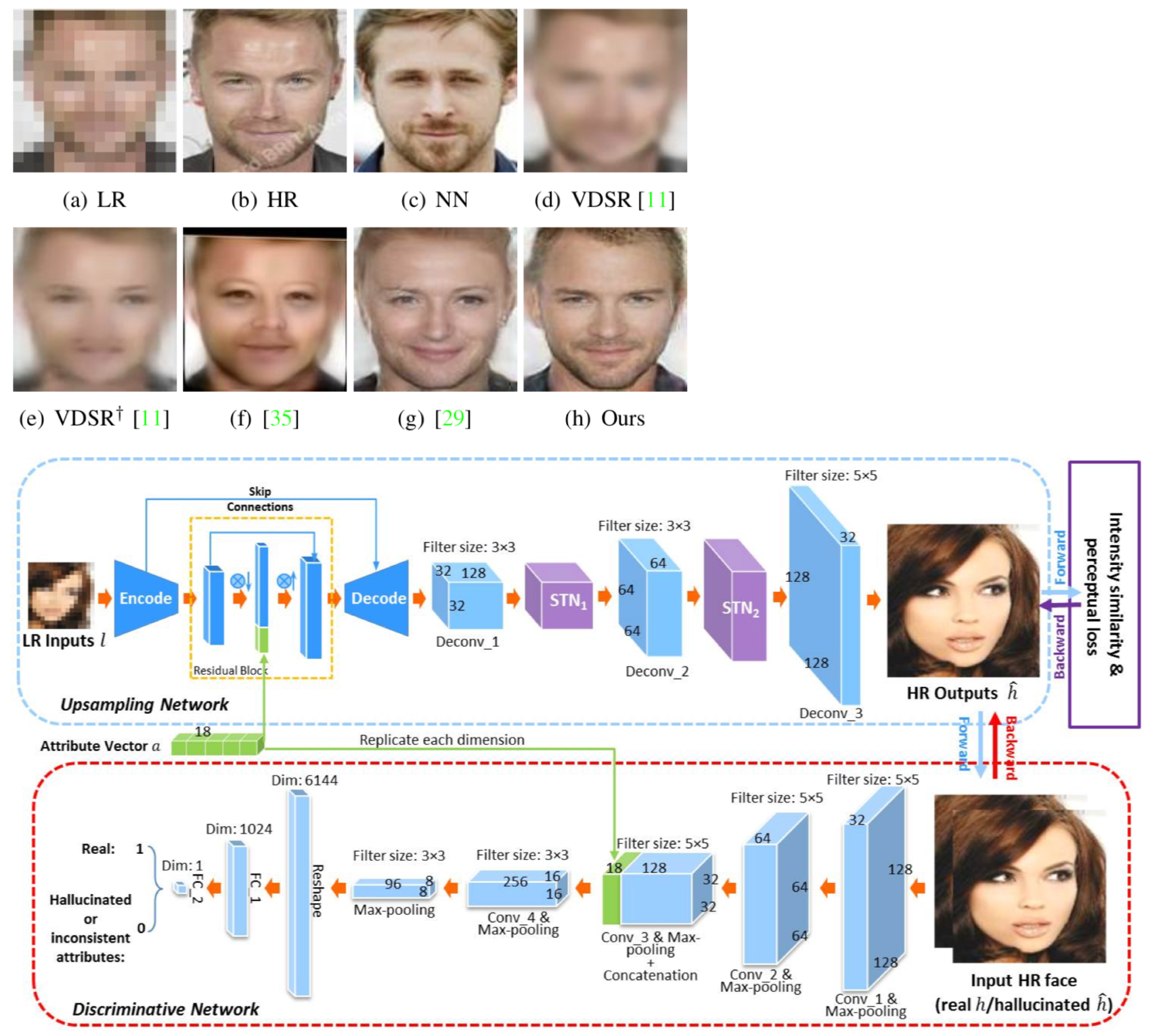

複数枚画像の超解像といえば主に時系列画像で行われてきたが,本稿ではステレオで行う. このとき,それぞれのステレオで視差が異なるので, 視差の考慮が必要である. ステレオ画像から視差は計算できるが, これを基に超解像を行う従来法によるとサブピクセル精度が出せずジャギーが出てしまう.

本稿では,End-to-Endにステレオ画像から視差に基づくシフト量と高解像画像の出力を行うDNNを提案する.構造的には,YCbCrにして照度,カラー成分に分けて2段階で学習するNNを構成, 照度画像で,まずシフトを考慮した高解像照度画像を生成.片方の眼の画像のシフト画像を複数枚用意し, もう片方の眼の画像と併せてCNNに入力. 出力の高解像照度画像と,低解像のカラー成分画像からCNNで高解像カラー画像を最終的に出力する.

従来のステレオベース手法よりなめらかな高解像画像が出力できている.PSNRでよりよいスコアをマーク.シフト量,シフト画像の枚数についても議論.

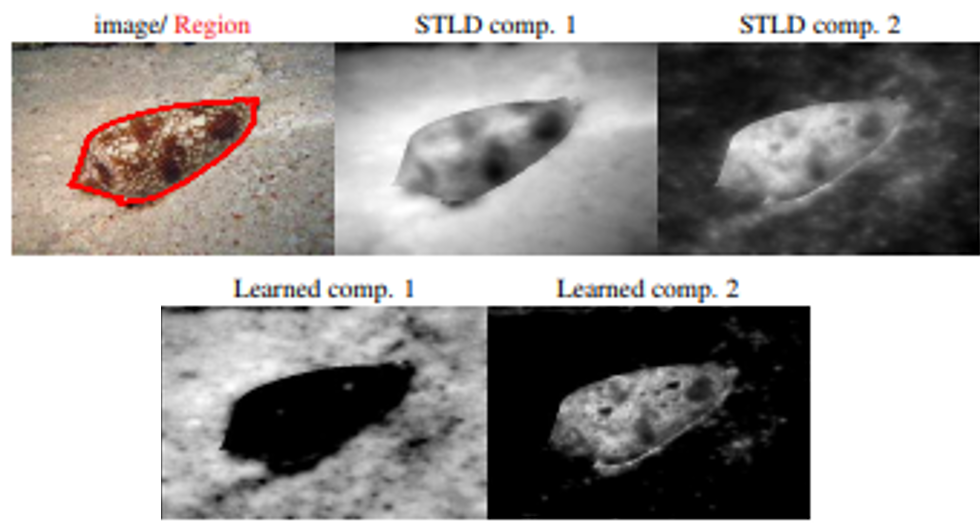

テクスチャセグメンテーションにおいて,それぞれのテクスチャ領域において照明条件などの条件に不変な特徴を取りたいが,その時にテクスチャの領域のセグメンテーションがされていないとテクスチャ間の特徴が混ざってしまうという,鶏と卵問題がある.

本研究では,Shape-Tailored Descriptorを提案.様々なスケール,任意の形状領域での向き付き勾配の基本特徴を弁別するNNを学習する. この特徴表現はROIにおける偏微分方程式により定義される. 学習したメトリックにより基本特徴を弁別することで,結合最適化問題の定式化及び最適化を行う. これは学習した特徴のグルーピングで行われる.

形状もちゃんと考慮された領域の特徴抽出を一つの枠組みで提供できている.

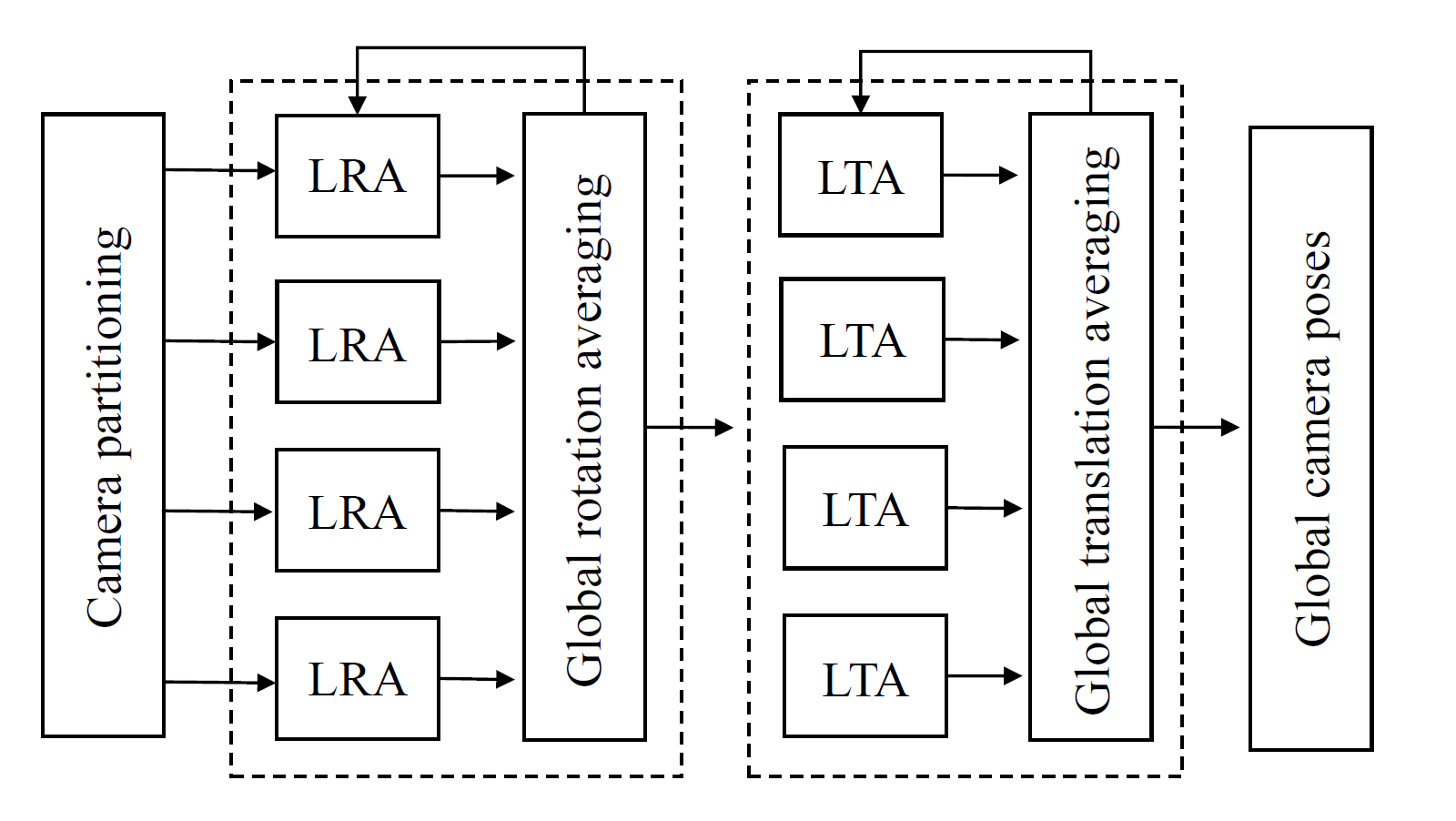

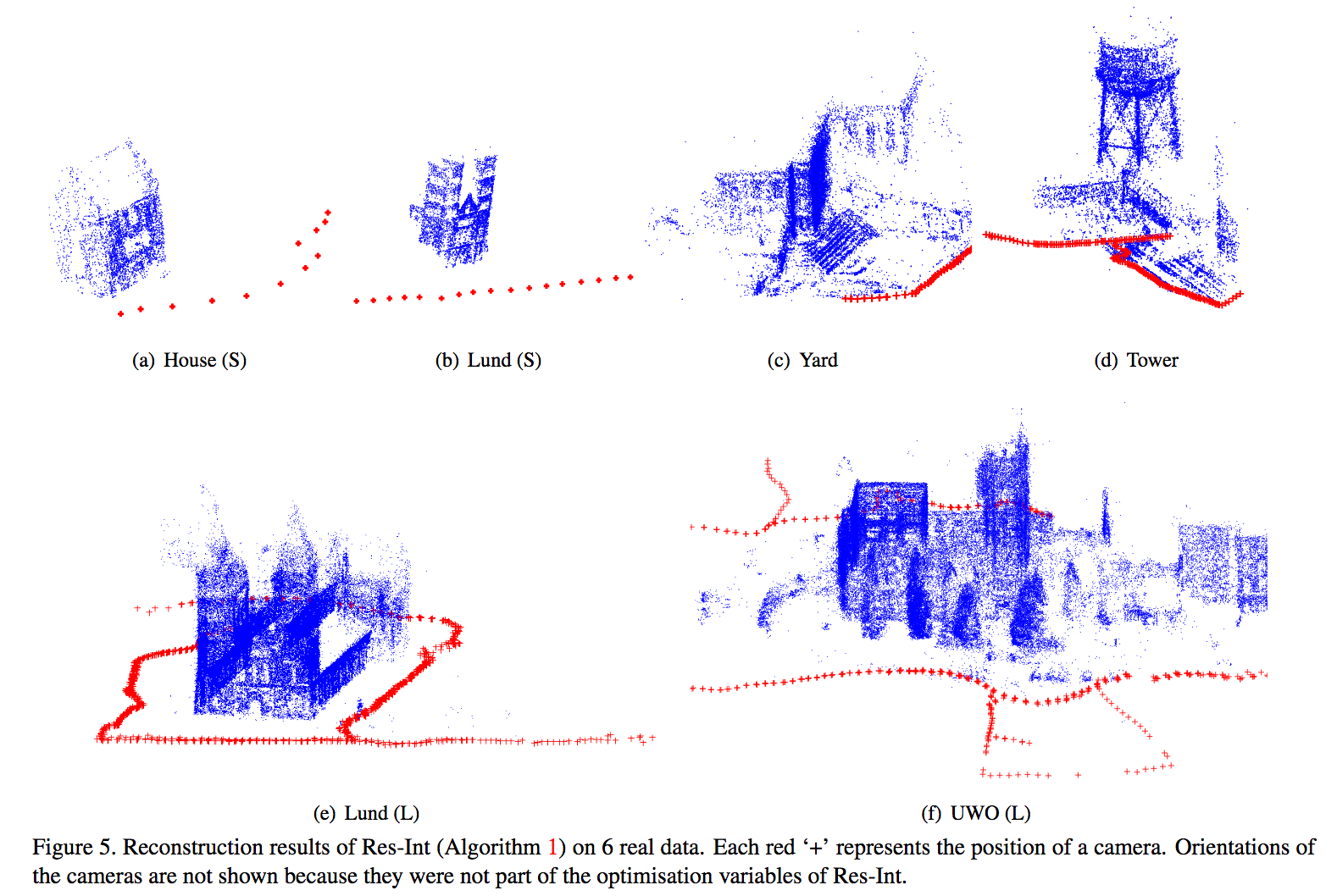

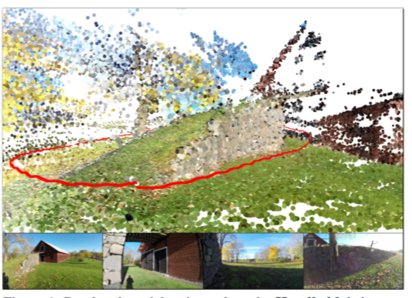

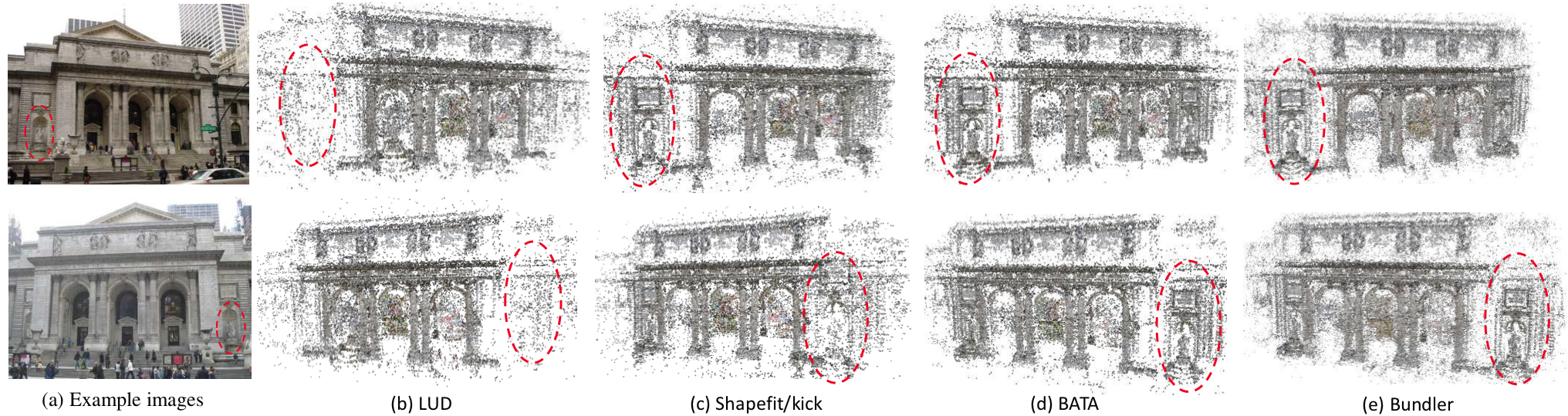

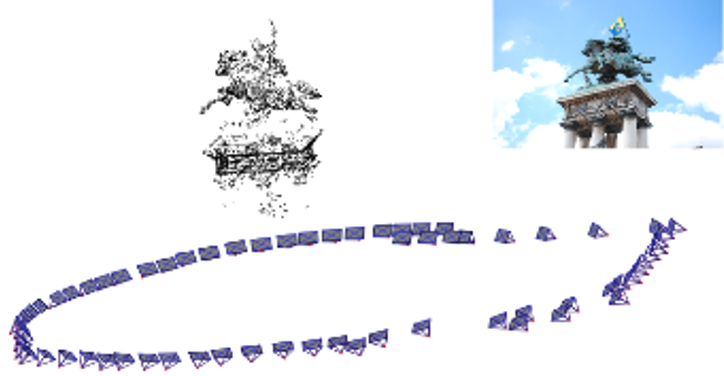

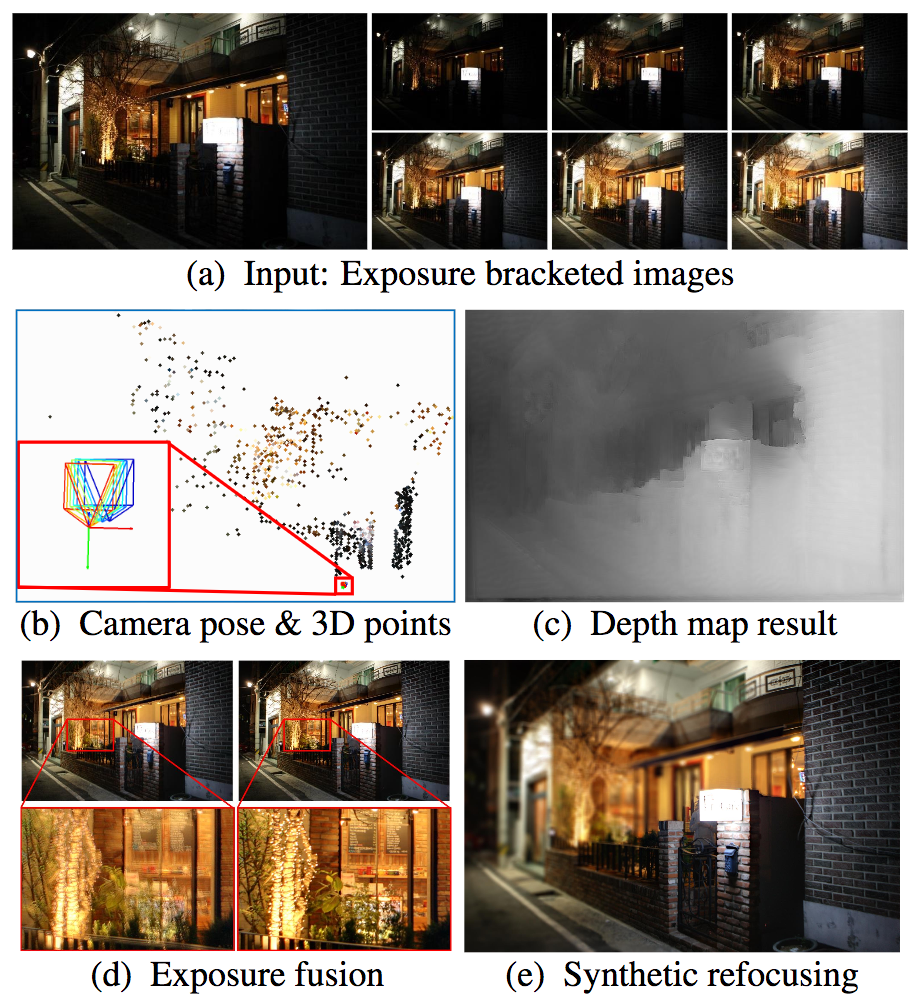

入力画像をいくつかのグループに分けて、何百万枚のスケールでglobal SfMを行った。最初に入力画像を相関に基づいて複数のパーティションに分割する。次に、パーティションごとに回転や並進といった変換を求めてから全体の最適化を図り、パーティションの境界を明確化したり、1つの座標系ですべてのカメラを表せるようにした。最後に収束するまで部分最適と全体最適をを繰り返す。

従来手法より多い数百万の入力画像でglobal SfMを行えるようにした入力画像が増加した場合に全体最適化で生じるメモリーの飽和を部分最適化を用いることで回避できるようにした

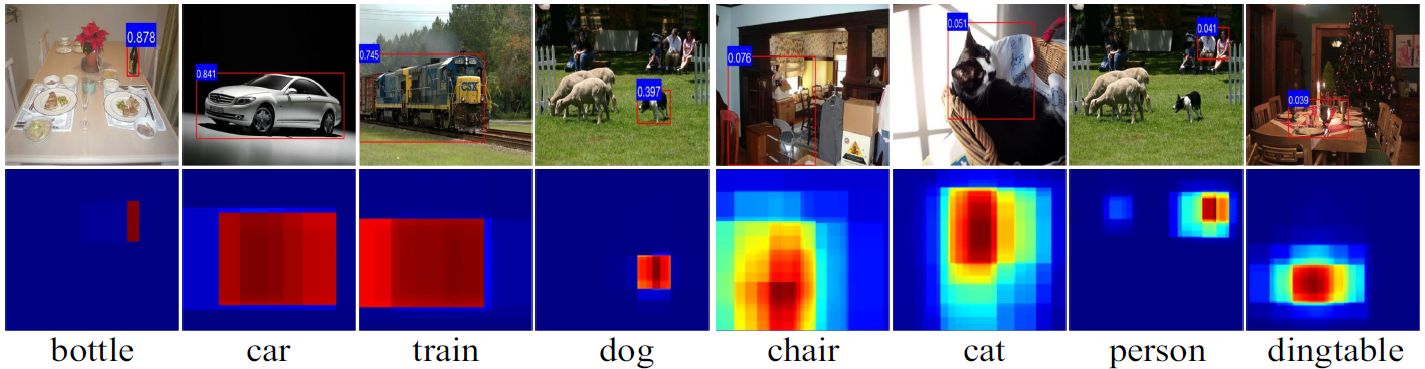

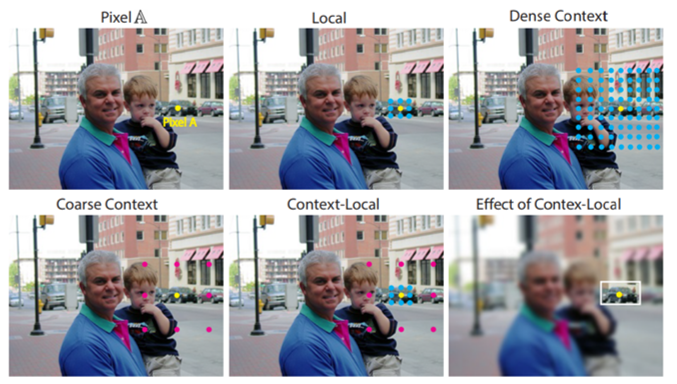

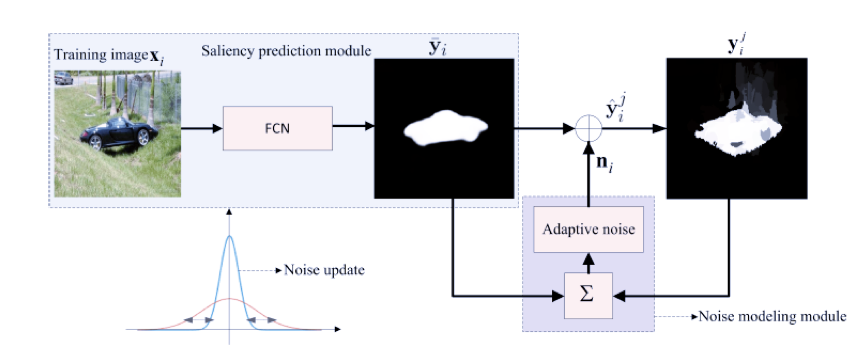

コンテキストはサリエンシー検出タスクにおいて重要な役割を果たす.しかし与えられたコンテキスト領域において,全てのcontextual informationが役に立つわけではない.この研究では,ピクセルごとにinformative context locationを選択的に関与することを学習するため,新たにピクセルワイズなcontextual attention network(PiCANet)を提案する.これにより,ピクセルごとにattention mapを生成することができる.

![]()

PiCANetにより,サリエンシー検出のパフォーマンスが向上すること確認した.グローバルおよびローカルのPiCANetは,全体的なコントラストと均質性の学習を容易にする.その結果サリエンシーモデルは,物体をより正確かつ均一に検出することができ,SOTA手法に対して有効に機能する.

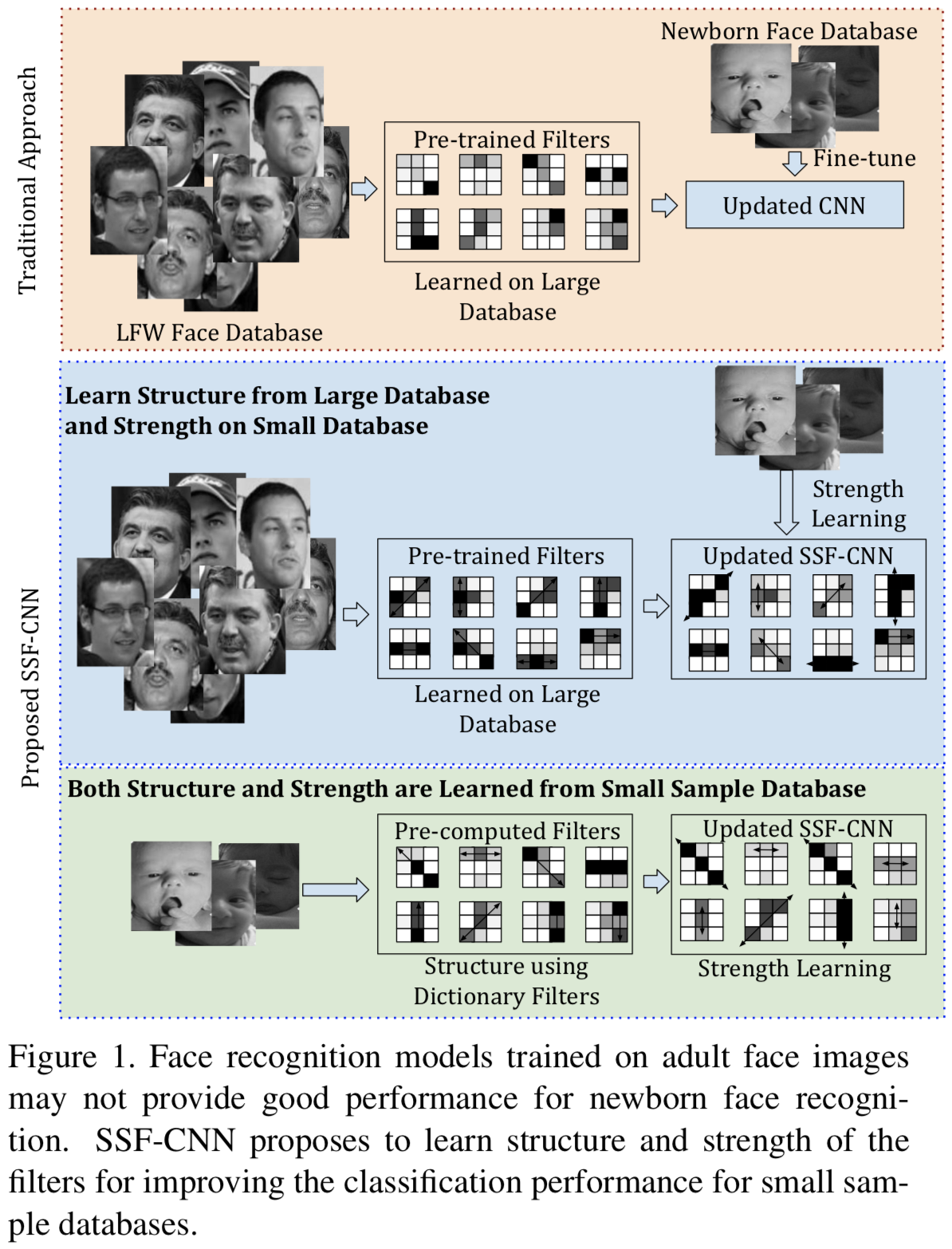

CNNのパラメータが多いため,データセットのサイズが小さいと過学習するという問題がある.この研究ではこの問題を解決するため,SSF-CNNを提案する.これは,フィルタの構造と強度を学習することにフォーカスすることにより,CNNのパラメータ数を減らすことができるという方法である.ここでフィルタの構造は,辞書ベースのフィルタ学習アルゴリズムを使用して初期化され,強度は小さなサンプルトレーニングデータを用いて学習される.これによりアーキテクチャーは,小規模および大規模のトレーニングデータベースの両方を使用した柔軟なトレーニングを提供し,小規模のトレーニングデータでも優れた精度を実現することができる.

このアルゴリズムの効果を確認するため,はじめにMNIST,CIFAR10とNORBのトレーニングデータ数を変化させながら実験を行った.その結果,SSF-CNNはパラメータの数が減少することを確認した.次にデータセットのサイズが小さいIIITD Newborn FaceとOmniglotを用いて実験を行ったところSOTAな結果を得ることができた.

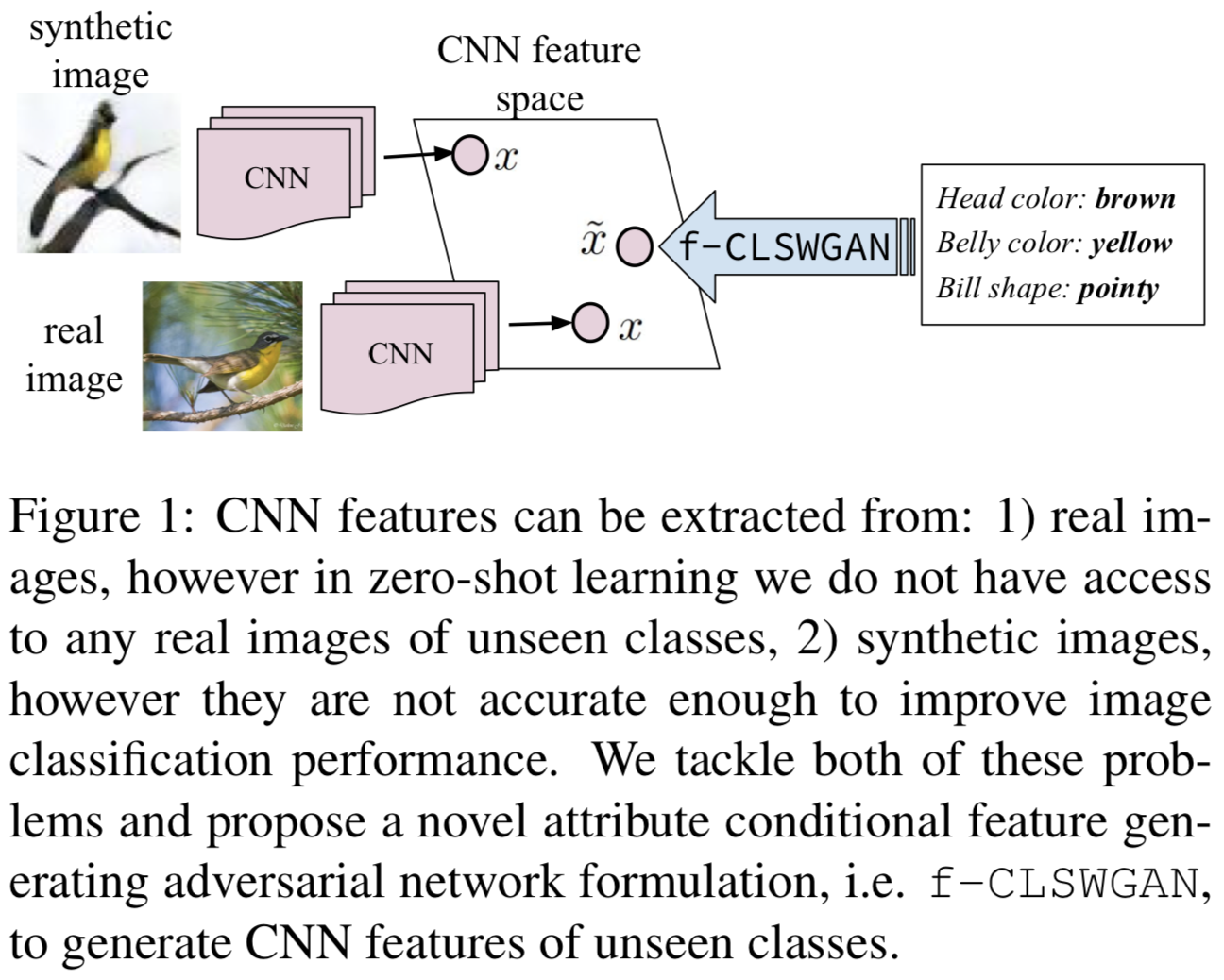

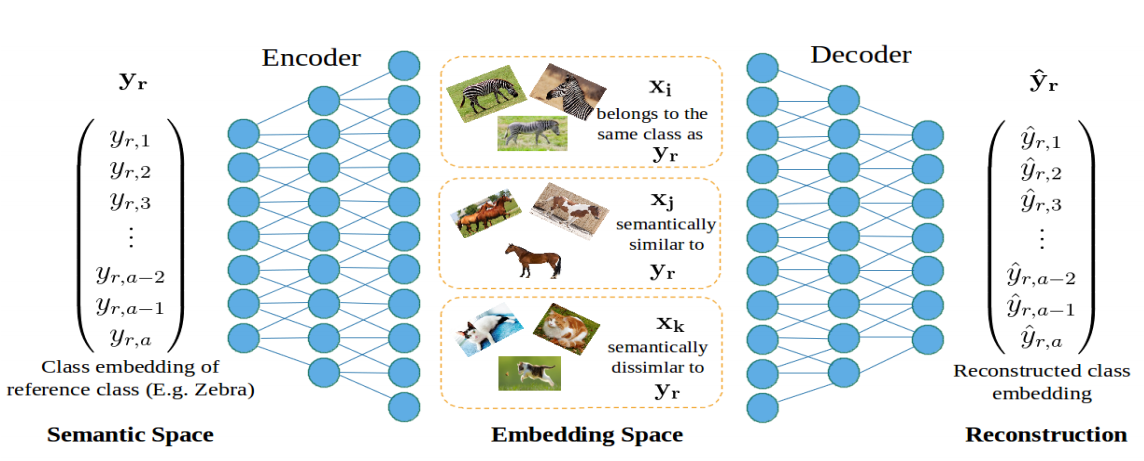

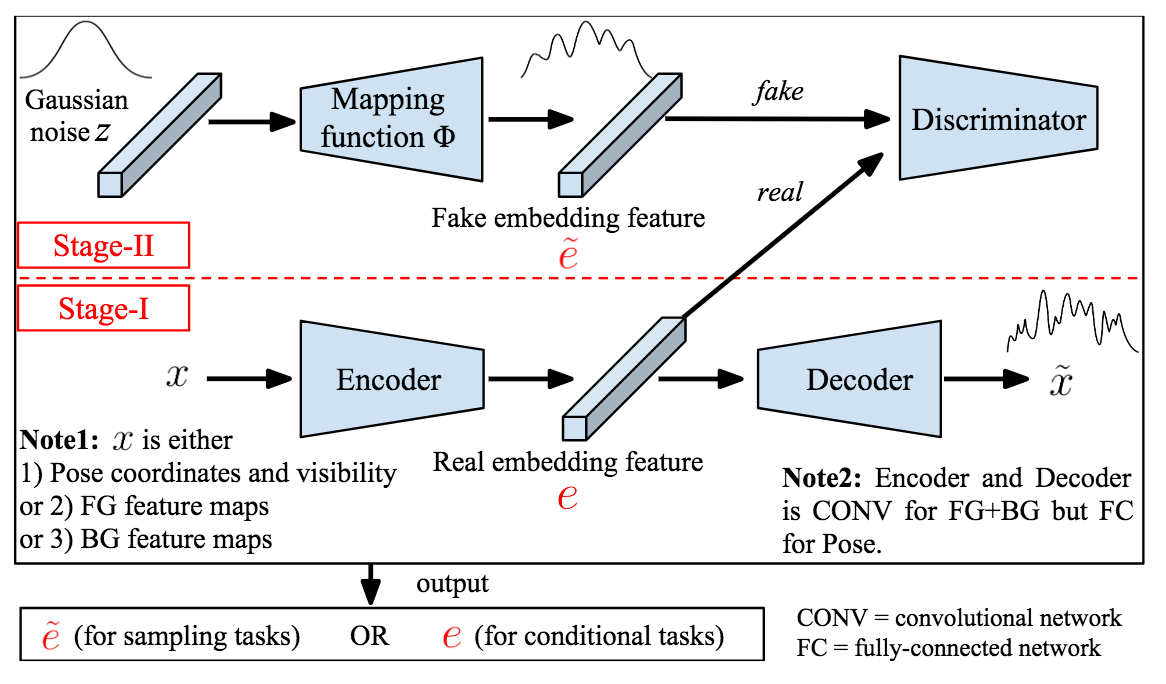

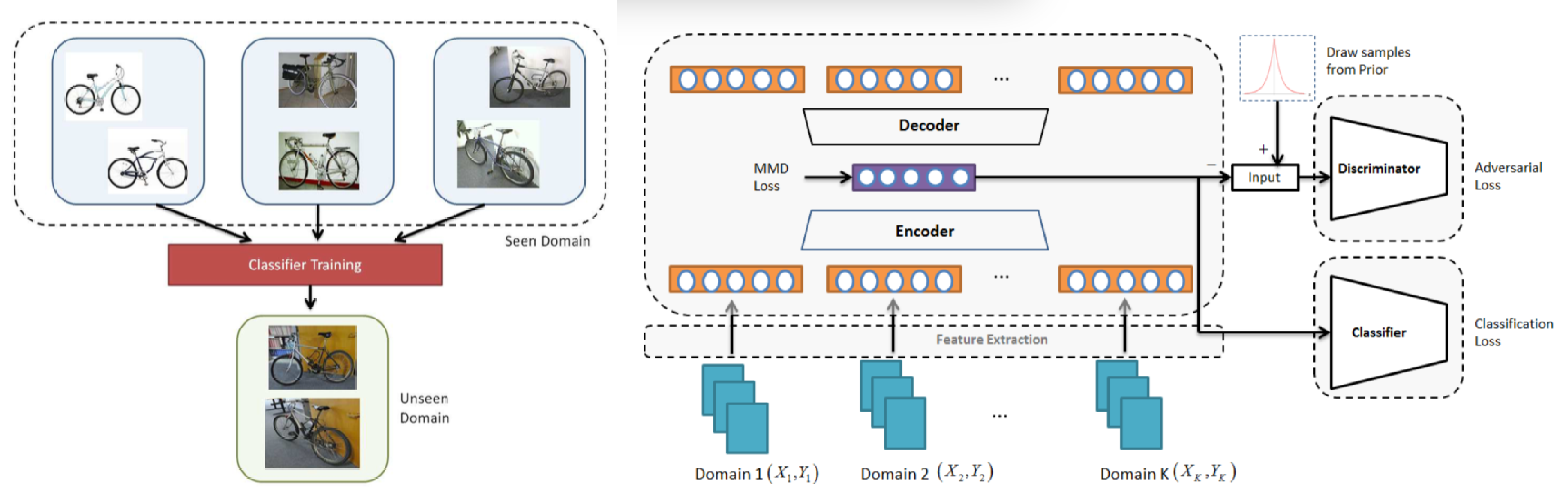

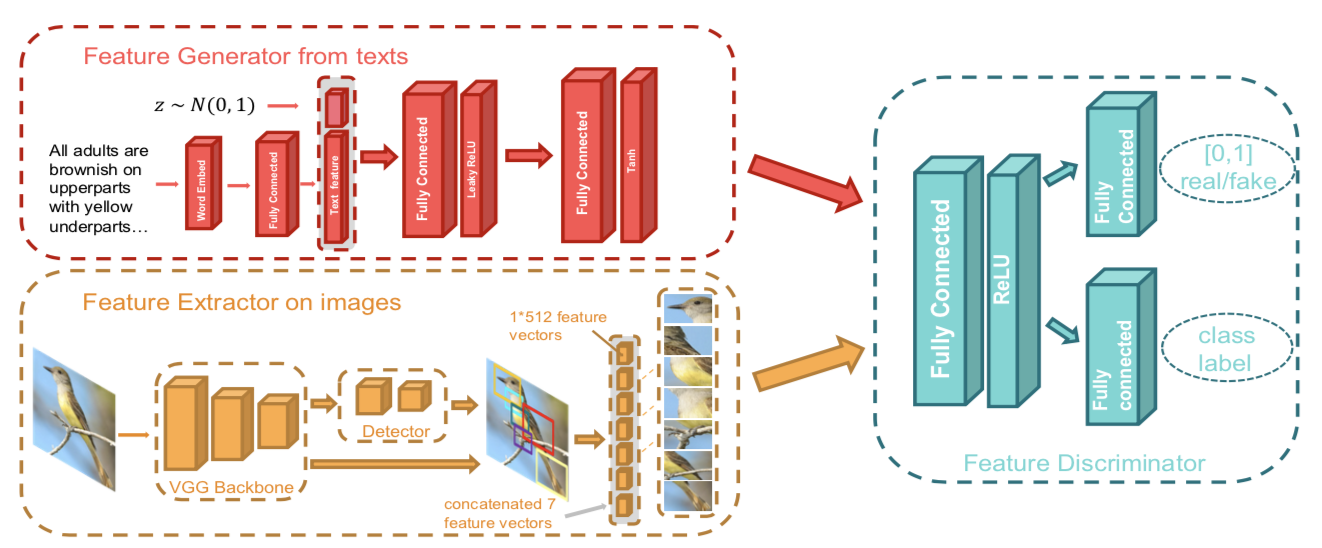

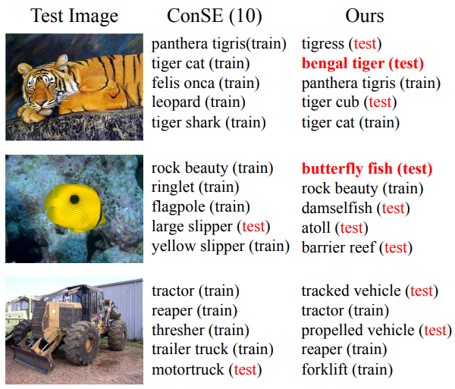

未知クラスのラベル付きサンプルの必要性を回避するため,画像ではなくCNN特徴量を生成するGAN(f-CLSWGAN)を提案する.クラスレベルのセマンティック情報で条件づけることにより,よりリッチなCNN特徴空間を生成することができるとのこと.

ZSL, GZSLの両方の問題設定において,CUB, FLO, SUN, AWA, ImageNetを用いて実験を行ったところ,提案手法によりSOTA手法の精度が向上した.

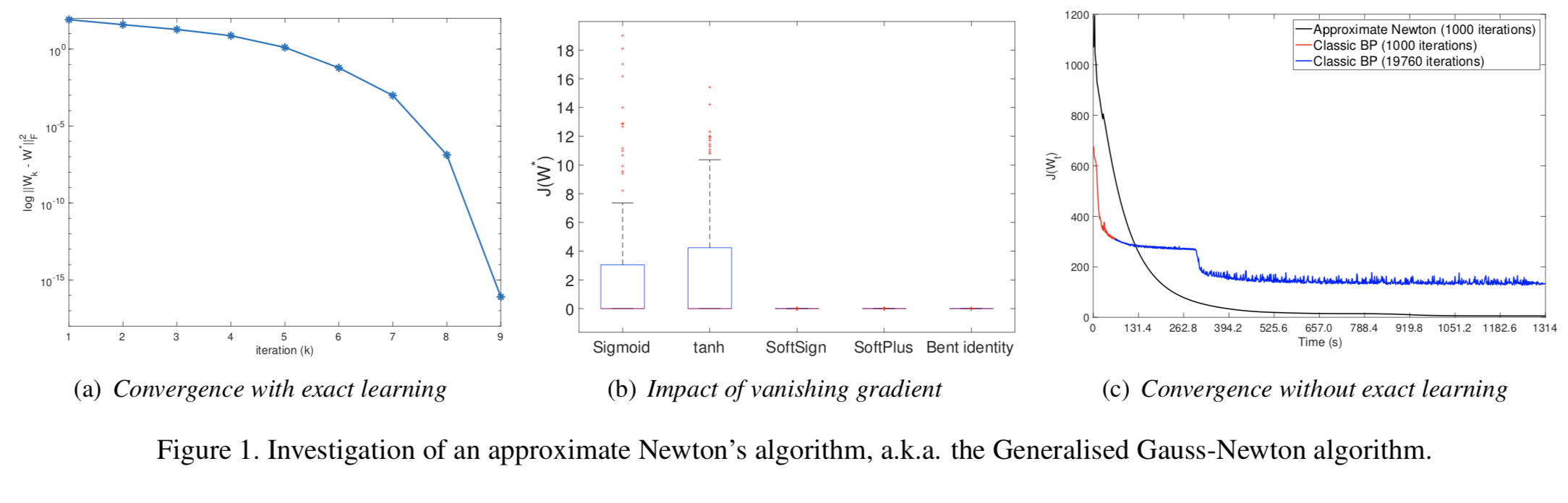

smooth optimisationの観点から、多層パーセプトロンに対する数学的な考察を行なった論文。DNNの学習の際に最もよく使われるアルゴリズムであるバックプロパゲーションは局所最適解に収束する可能性があることと、収束が遅いことが問題視されている。本論文ではロス関数のcritical point(停留点)に対する解析を行うことで、局所最適解に収束することなく帯域最適解に収束する条件を確認。また、より速くネットワークの学習を収束させるために、ヘッシアンに対する解析や、帯域的最適解に二次収束するという点でapproximate Newton’s algorithmと呼ばれるGeneralised Gauss-Newtonアルゴリズムを用いた学習による評価を行なった。

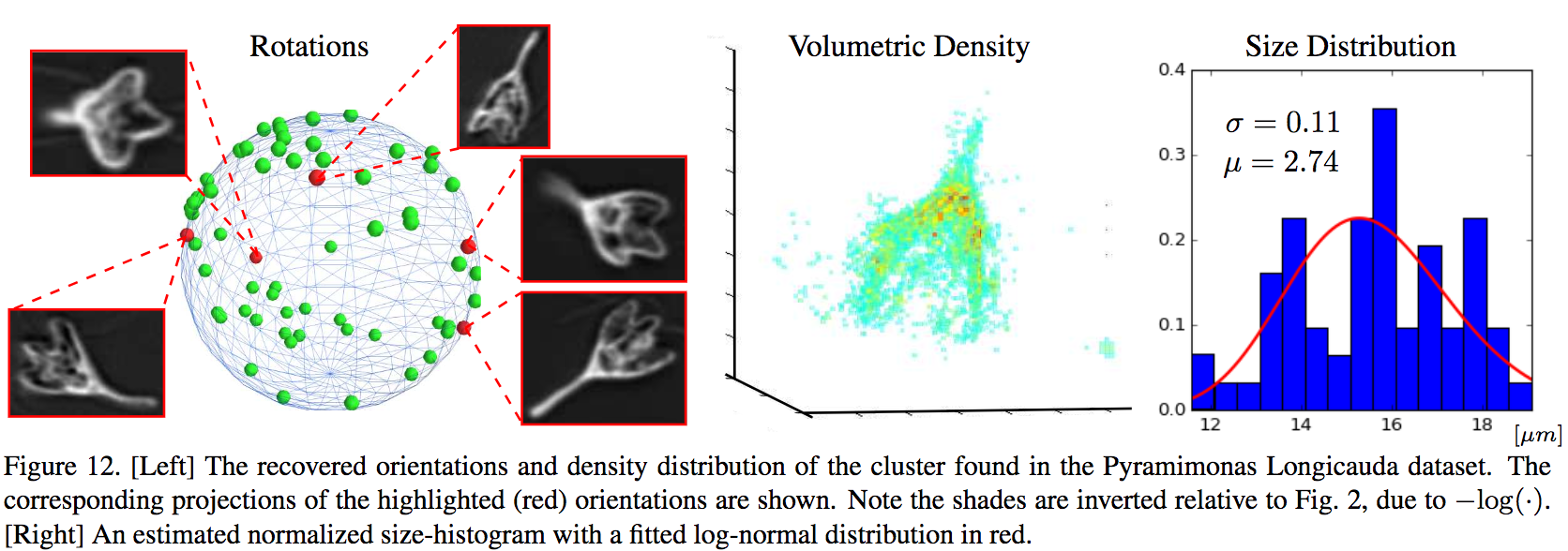

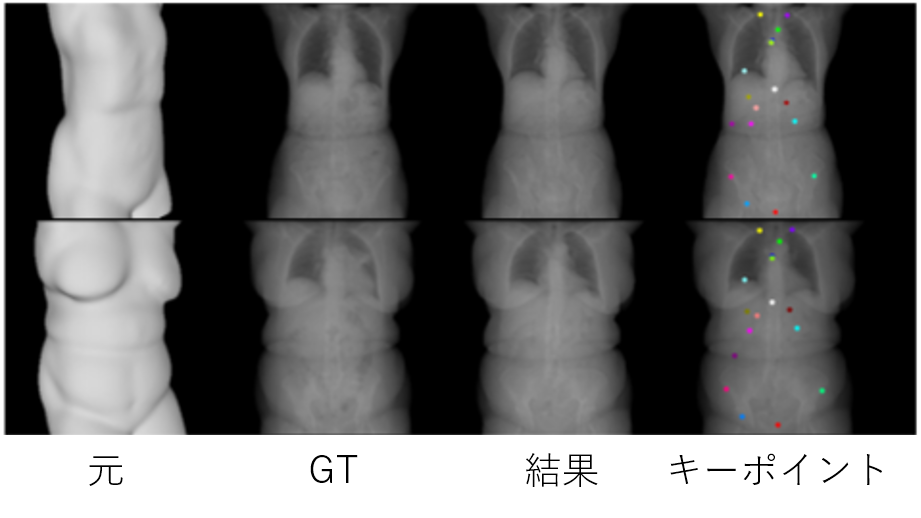

ランダムな3D方向、位置、およびスケールを有する3Dボリューム自然物体の断層を投影された2D画像から推定する3D-POPの提案

従来手法(SPR)よりスケール変化による推定誤差が少ない

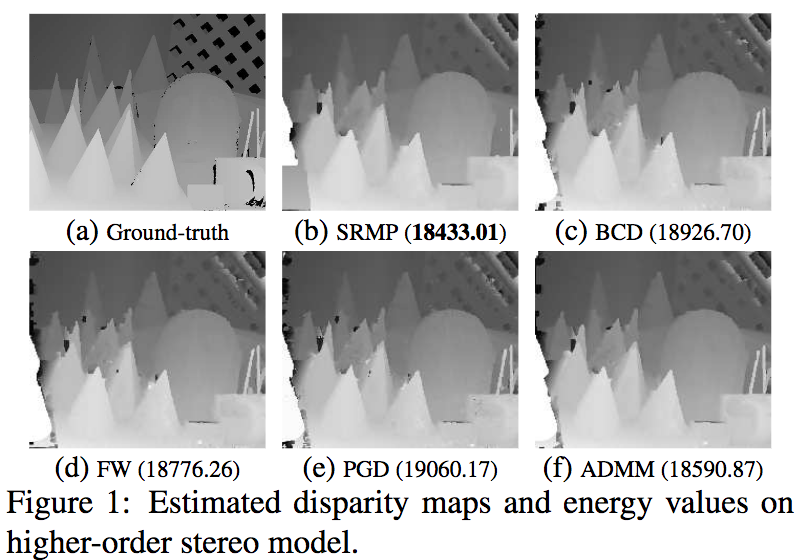

MRFにおけるMAP推論の非凸連続緩和法においてADMMに基づく多重線形分解フレームワークを使用し、より効果的な解を求める手法を提案

最先端のMRF最適化アルゴリズムと比較し、変数と制約の数が少ないため、メモリ効率が良い。また、高度に並列化可能なため,分散アプリケーションやリアルタイムアプリケーションにも適している。

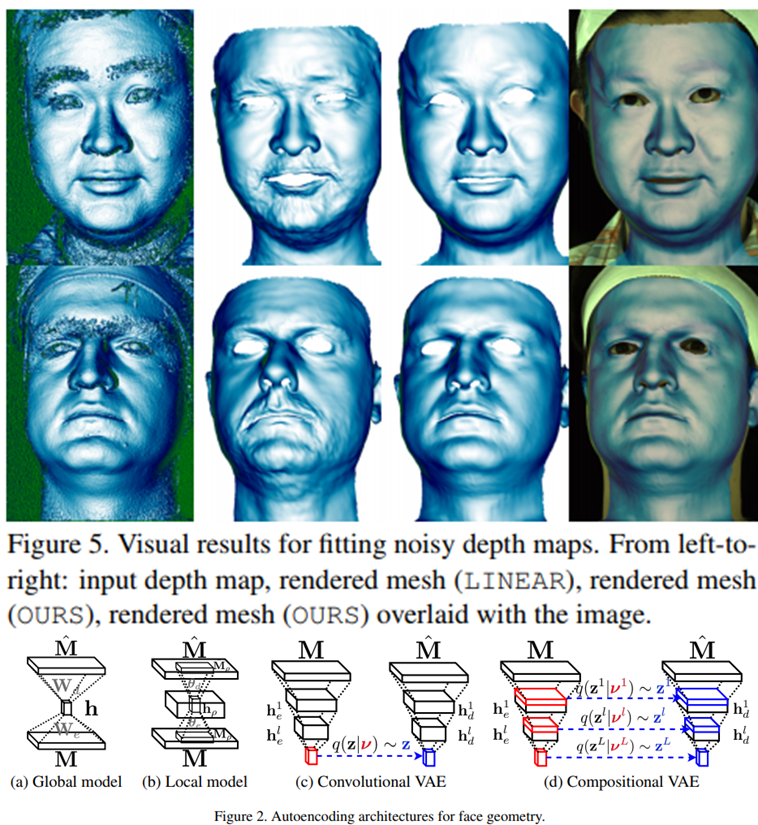

・クラス内の分散を低減し、クラス間のマージンを同時に学習するOrthogonal Low-Rank Embedding(OLE)を提案・ OLEはlossに低ランク制約と直交化制約を加える.

・学習画像が少ないデータセットで特に効果があり,Stanford STL-10でstate-of-the-art

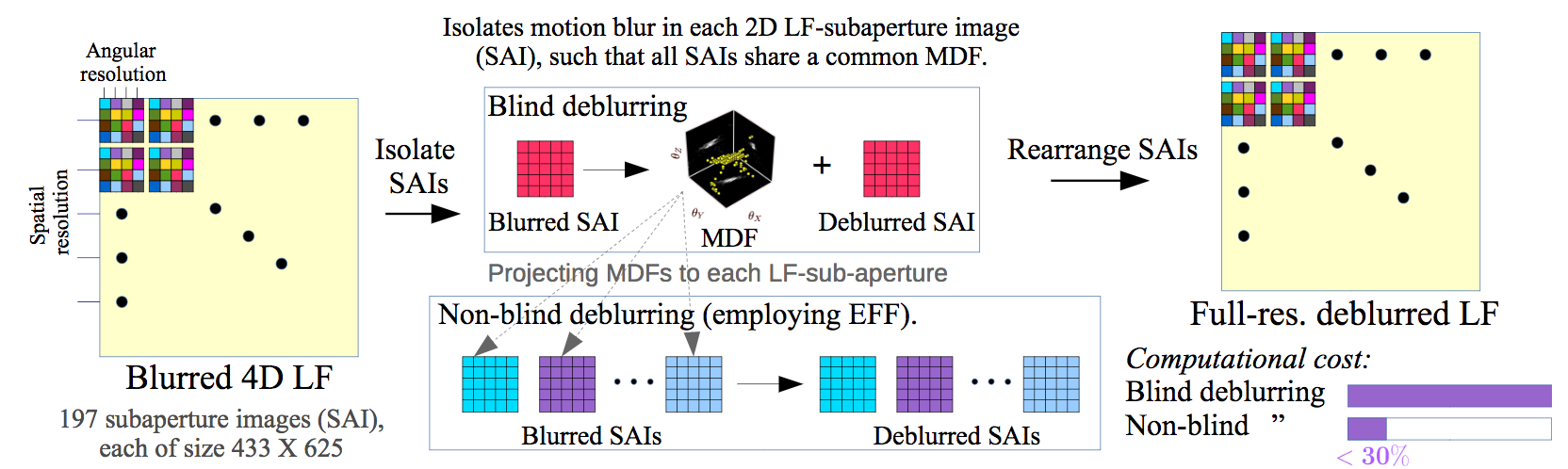

・ Light Field Blind Motion Deblurring (LF-BMD)を低次元の部分問題に分解できるMDFベースのブレ軽減手法の提案

・最先端の手法と異なり、現実的にレンズの屈折効果を捕らえ、広角のアングルや不規則な撮影者の動き対しても適用可能・並列処理可能なアルゴリズムのためGPUなどの並列処理可能

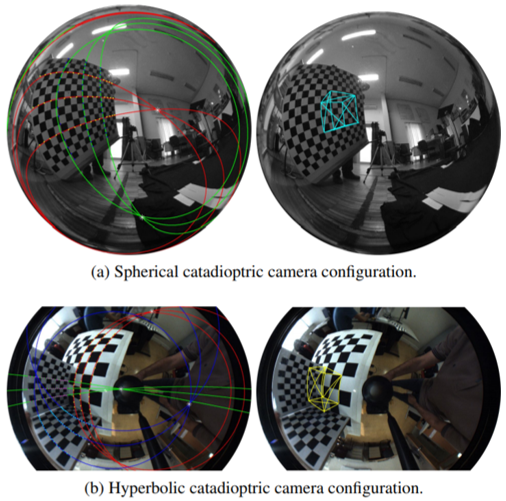

透視投影カメラ画像上の消失点,消失線に関する議論は多く行われてきたが,反射屈折カメラ画像上での消失点,消失曲線を表現する解析的モデルの開発は行われてきていなかった. 反射屈折カメラ画像上では,一つの消失点から発生する平行曲線は別の消失点に再度収束するというところが透視投影カメラ画像のものとは異なる.

そこで,カメラのキャリブレーションパラメータ,鏡形状係数,3D空間の平行線の方向ベクトルのパラメータを用いた パラメトリック方程式を提案. 鏡面は軸対称二次曲面で表現.それを透視投影カメラが観測するような光学モデルのもと,定式化.

今まで行われてこなかった反射屈折カメラにおける消失点・消失曲線のパラメトリック解析手法を与えた.

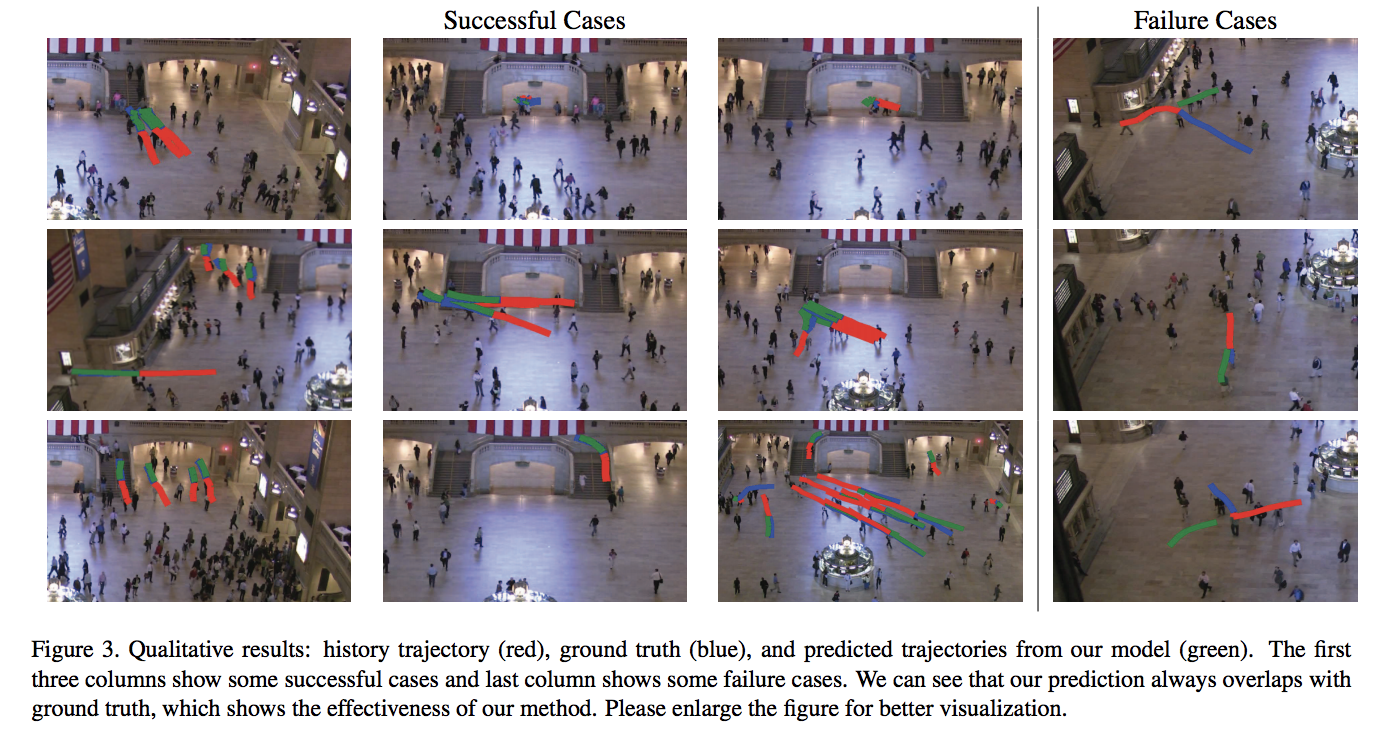

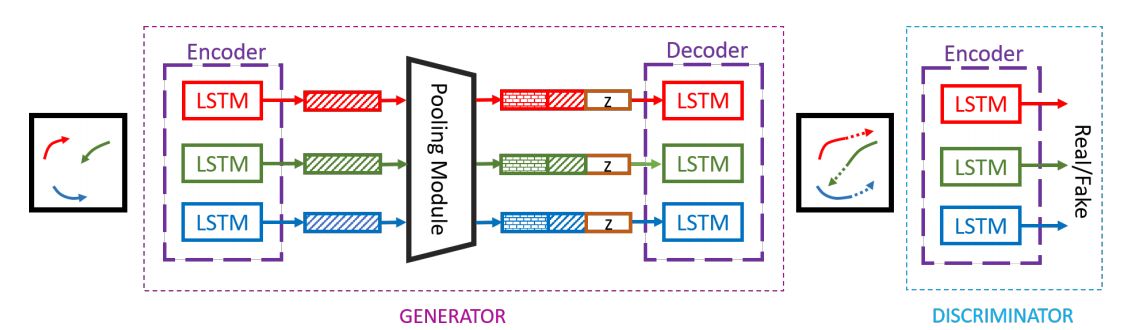

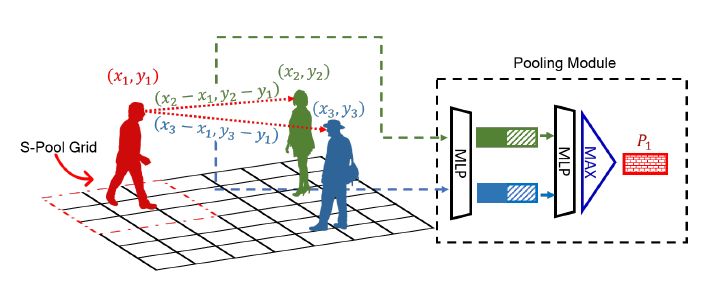

歩行者ごとで隣接フレーム間の変位を逐次予測するCIDNN(Crowd Interaction Deep Neural Network)を提案.群衆による歩行者の影響のレベルをLSTMによって重み付けをし,従来の手法に比べ, 対象の歩行者への空間的親和性の重要度を高くしている. 提案手法は以下を可能にし公的に利用可能なデータセットにおいて高精度な軌道予測を実現した.

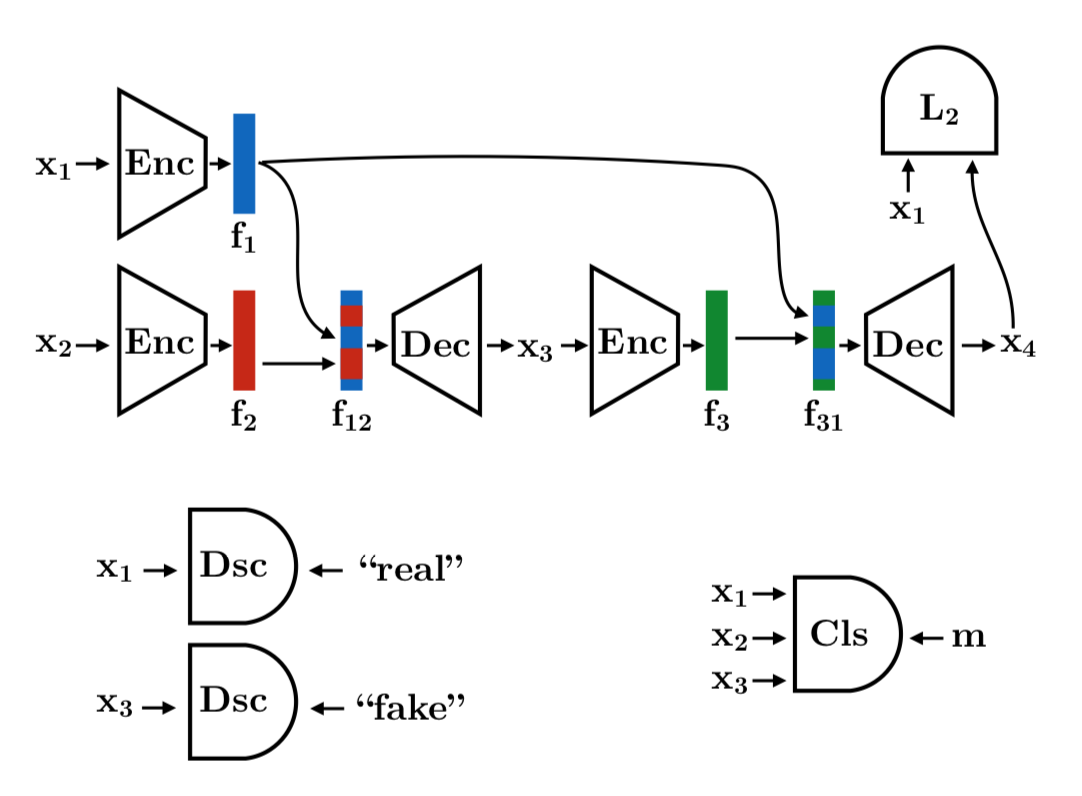

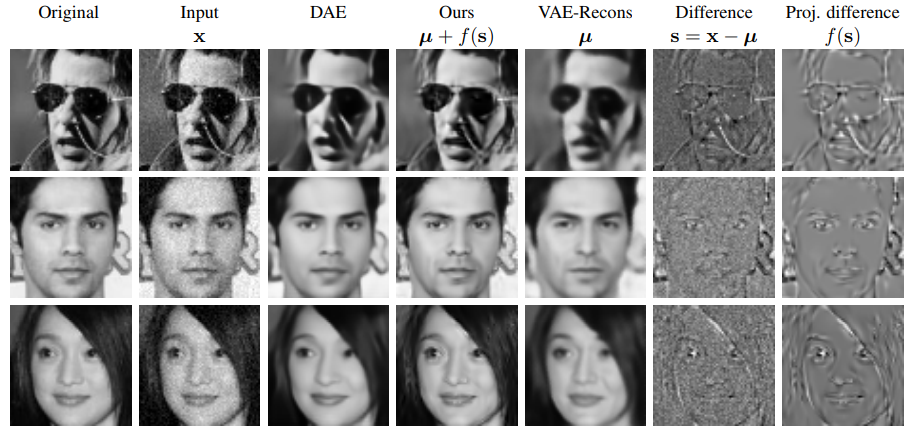

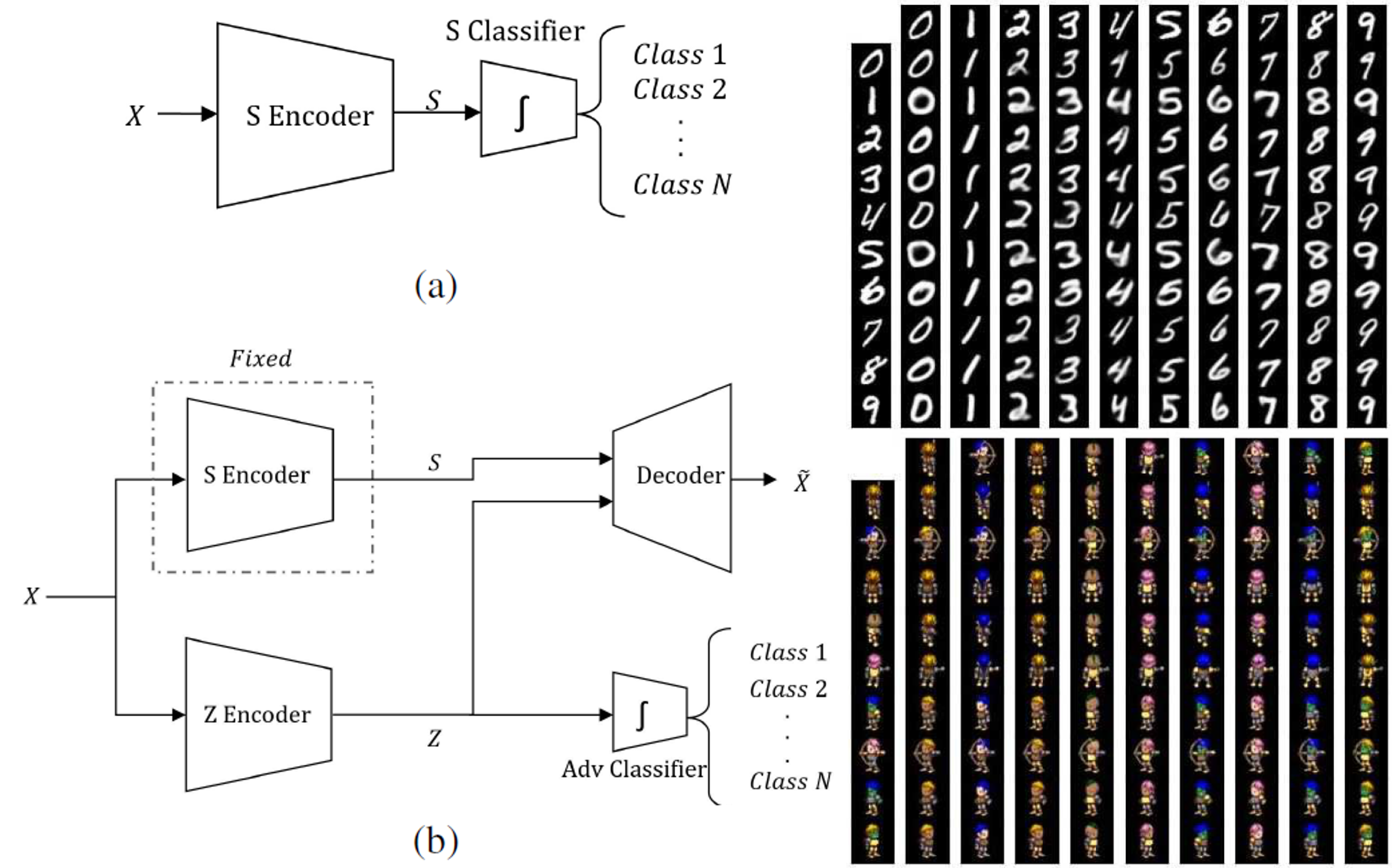

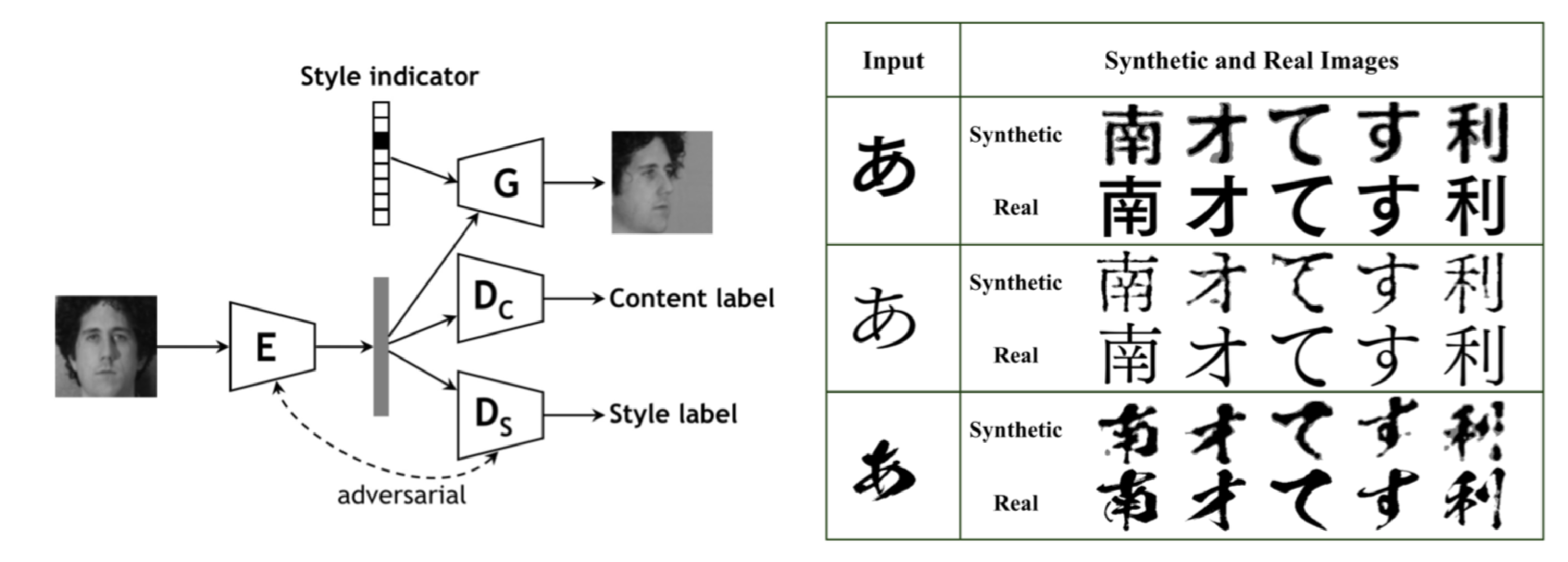

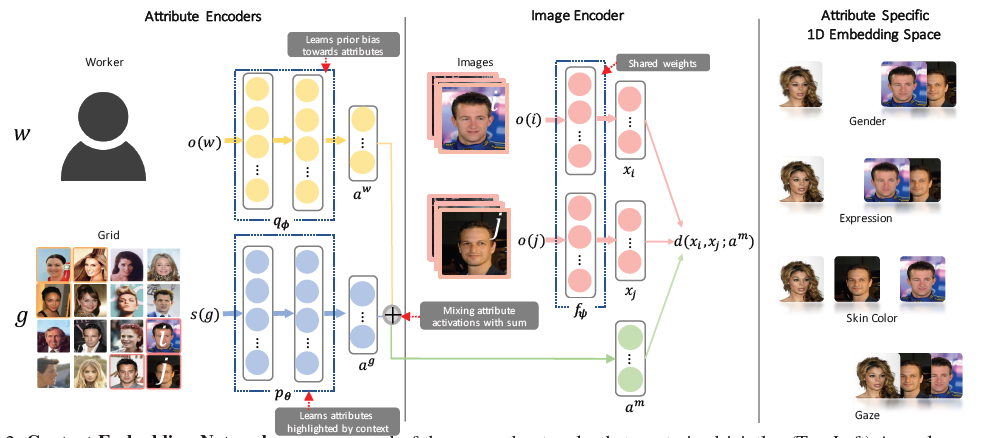

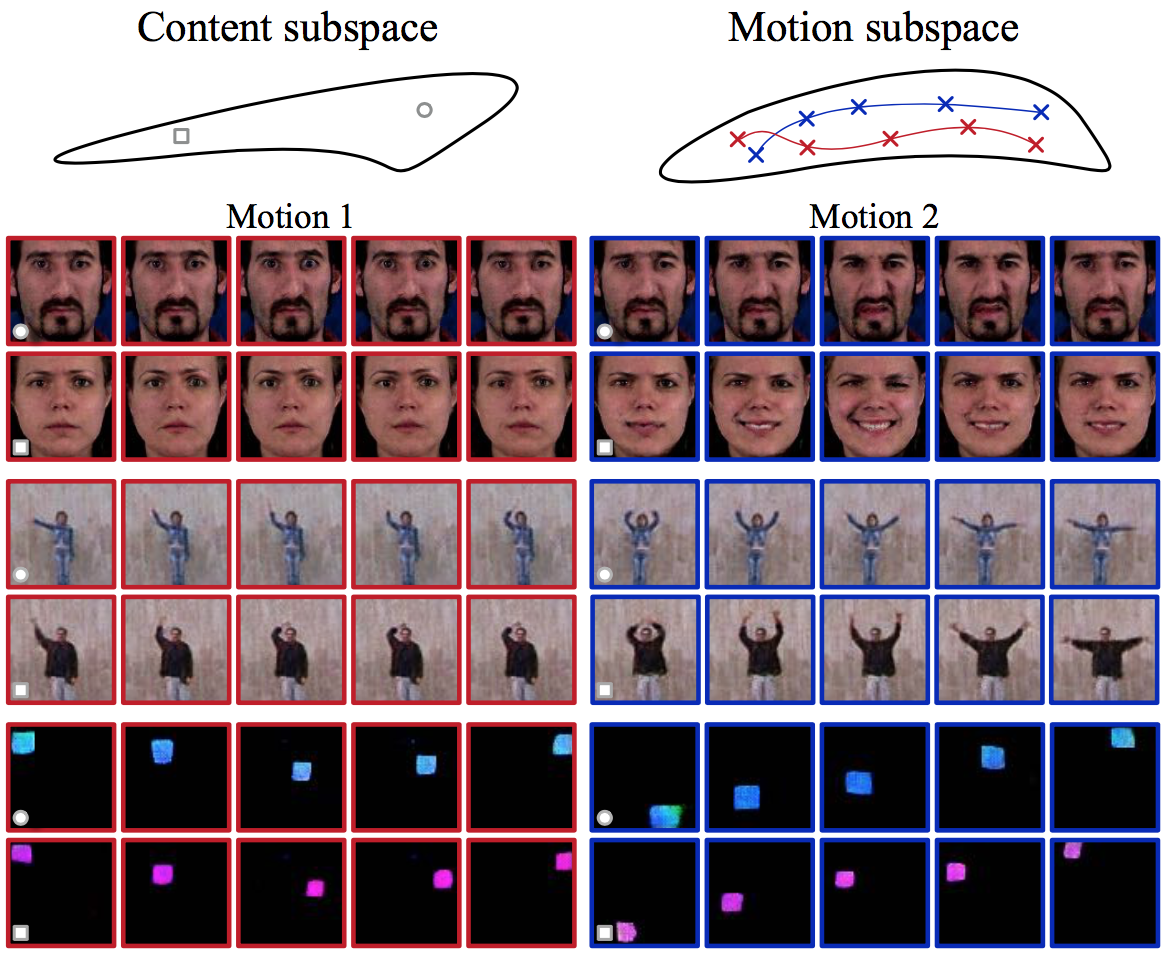

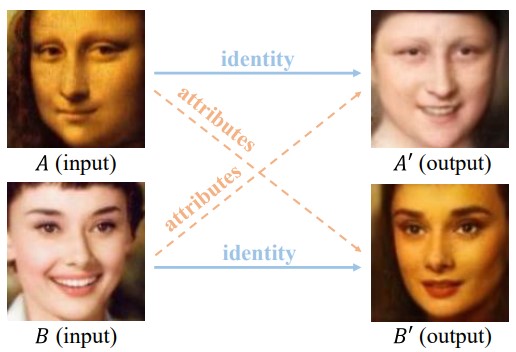

追加のアノテーションやドメイン知識なしに、disentangleな変動要因からなる表現をunsupervisedに学習することが目標。disentangleな変動要因とは、物体の姿勢や色など画像に渡って一貫して識別できる画像特徴に対応する要因のこと(ここではfeature chunkと呼ぶ)。この論文のポイントと提案手法は次の項目。1)disentangleな変動要因表現は、feature chunkの連結によって構成されるということ。2)autoencoderを利用し、不変的な画像属性とfeature chunkをencodeとdecodeすることを促進する目的関数、3)変動要因を見分けられ、各feature chunkが一貫性を持つ表現を確実にするために分類制約したこと。

前述の2)に関して、図のようなmixing autoencoderとadversarial learningを組み合わせたことが新しい。encoderとdecoderが(画像全体を表現するのに十分であれば)ただ一つのfeature chunkで表現できてしまう問題(shortcut problem)を分類制約を加えることで回避したことも新しい。

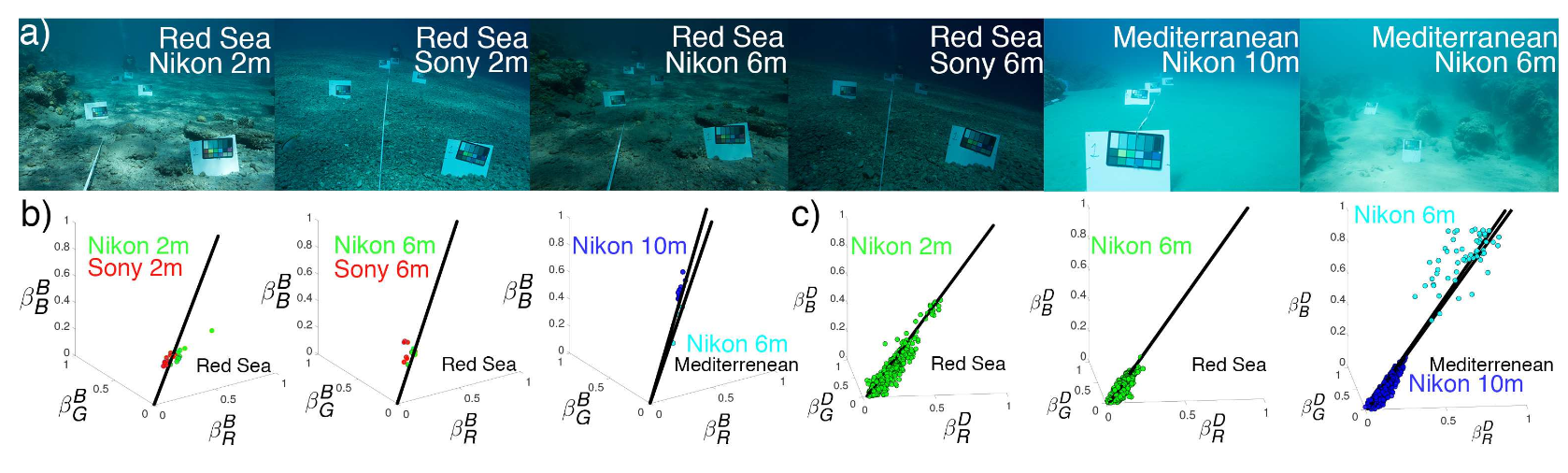

現在の水中画像形成モデルでは無視されていたより多くの依存関係を実際に導入することにより,画像補正を行う.

理論的分析と現実世界の実験を通して、一般的に使用される水中画像形成モデルがこれまで説明されていなかった誤差を生じることを実証した。

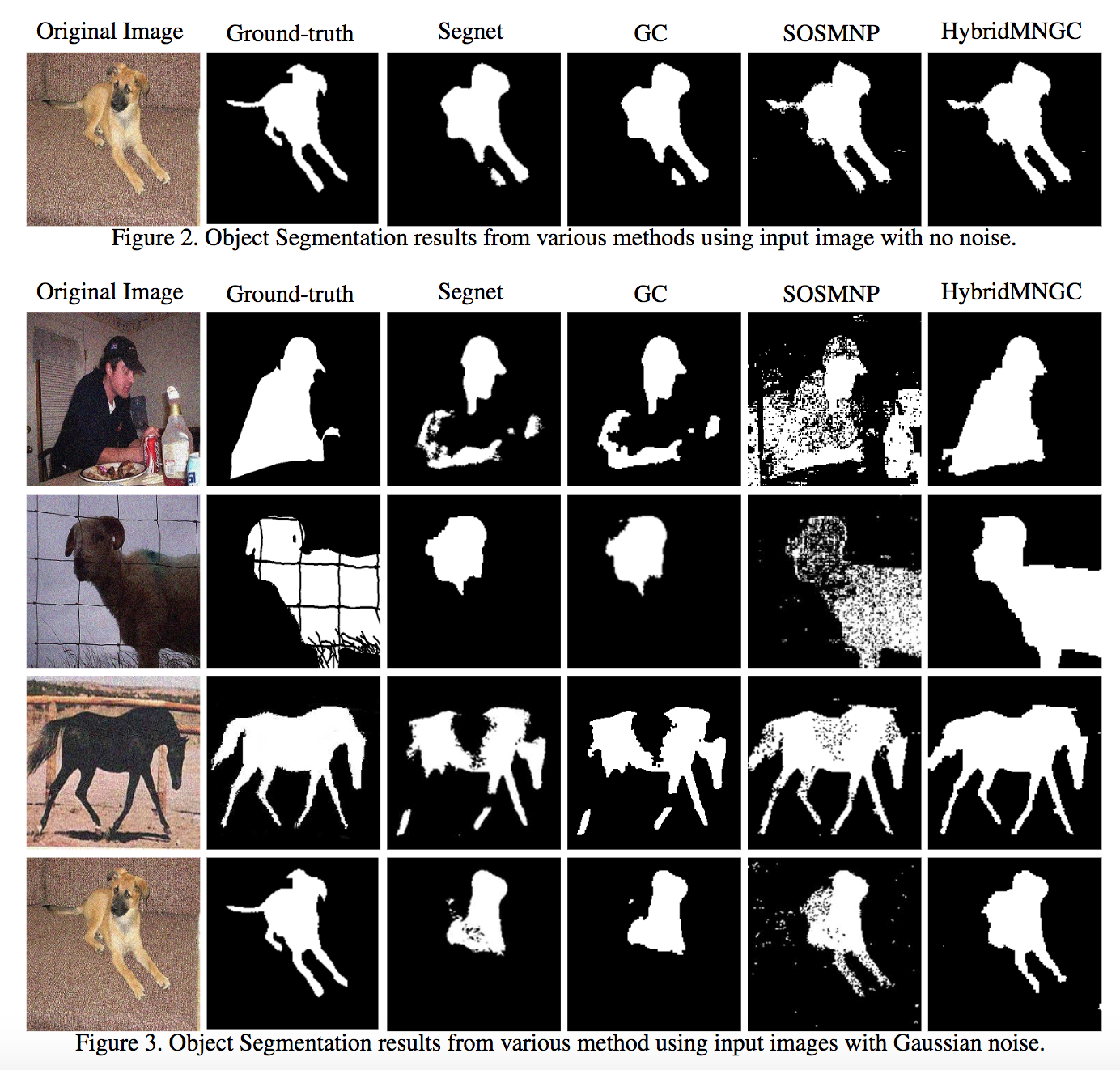

一般的なMRF-MAP問題はNP-hardだが、ポテンシャル関数がsubmodularのとき、多項式時間で解くことができる。この式を解くためには、フローベースのアプローチと多面体ベースのアプローチがある。その2つのアプローチを組み合わせるフレームワークを提案

Generic Cuts やSOSMNPのようなアルゴリズムを組み合わせることの有効性を確立

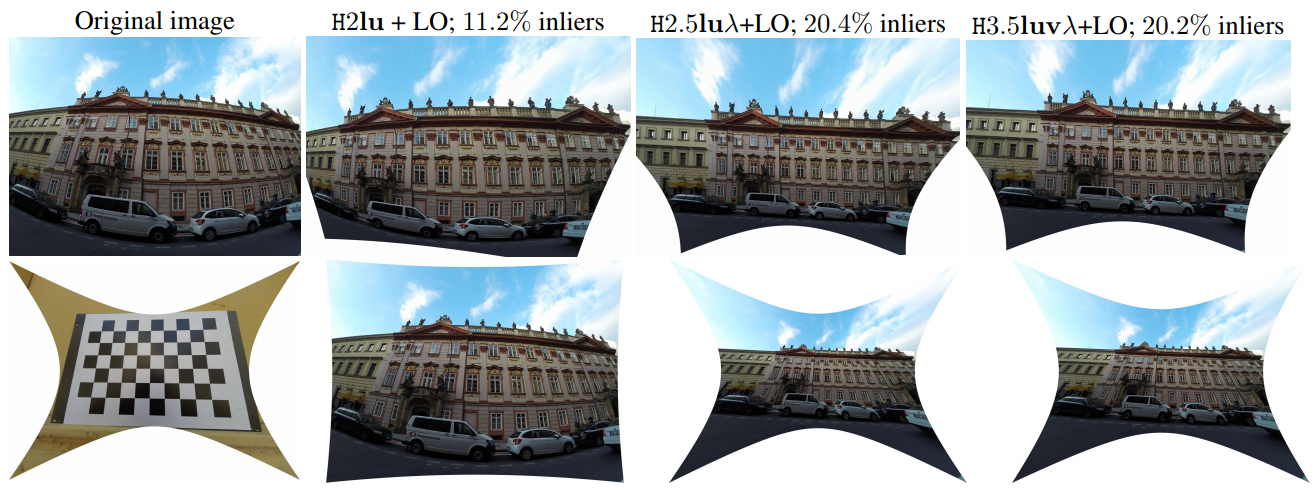

適度に歪んだレンズの画像であっても,,ピンホールカメラモデルを使用した平面補正は不正確または無効である.提案するソルバーは,カメラモデルにレンズ歪みを組み込み,精密な整流をワイドアングル画像に拡張する.これは現在コンシューマカメラにおいて一般的である.ソルバーは,放射状のレンズ歪みのための分割モデルと統合された,撮像されたシーン平面の共役変換によって誘発される制約から導かれる.理想的な彩度を持つ隠れ変数のトリックを使用して制約を再定式化し,Gröbner法で生成されたソルバーが安定し,小さくて速くなるようにする.

整流およびレンズ歪みは,共役的に翻訳されたアフィン - 共変動特徴または2つの独立して翻訳された類似共変動特徴のいずれかから回復される.提案されたソルバーはRANSACベースの推定器で使用され,少数の反復後に正確な整流が行われる.提案されたソルバーは最先端技術に対して評価され,ノイズの多い測定で大幅に改善された整流を表現する.

合成実験では,最先端技術と比較して,提案されたソルバーの整流精度およびレンズ歪み推定の測定に関して,良好な安定性およびノイズに対する優れた堅牢性を実証した.しかしながら,分割モデルによって歪められた共役変換から生じる多項式制約式は,安定したソルバーを生成するために隠れ変数トリックで変換される必要がある,定性的な実像実験では,高度に歪んだ広角レンズのための高品質の整流を表現した.

RGBイメージングからのハイパースペクトル再構成は,疎なコーディングと深い学習を経て著しい進歩を遂げているが,既存のRGBカメラが人間の三色知覚を模倣するように調整されているため,それらのスペクトル応答はハイパースペクトル再構成に必ずしも最適ではない.この論文では,RGBスペクトル応答を使用するのではなく,(ハードウェアで実施される)最適化されたカメラスペクトル応答関数と,エンドツーエンドネットワークを使用するスペクトル再構成のためのマッピングとを同時に学習する.

私たちのコアアイデアは,カメラスペクトルフィルタが畳み込み層のように効果的に作用するから,標準的なニューラルネットワークを訓練することによって,それらの応答関数を最適化することができる.我々は,空間モザイク処理を用いない3チップ構成と,Bayer形式の2×2フィルタアレイを用いた単一チップ構成の2種類の設計されたフィルタを提案する.数値シミュレーションは,既存のRGBカメラと比較して深く学習されたスペクトル応答の利点を検証する.

深い学習手法を用いて非負の無限大空間におけるフィルタ応答関数を学習する方法を示した.特殊な畳み込みレイヤーをU-netベースの再構成ネットワークに追加し,3つの独立したフィルタとBayerスタイルの2x2フィルタアレイの形で、標準RGBレスポンスより優れた応答関数を確認できた.実際のマルチスペクトルカメラを構築するために,CCDカメラの応答を設計プロセスに組み込んだ.2つのフィルタをうまく設計/実装し,スナップショットハイパースペクトル画像のためのデータに基づいたバイスペクトルカメラを構築しました.

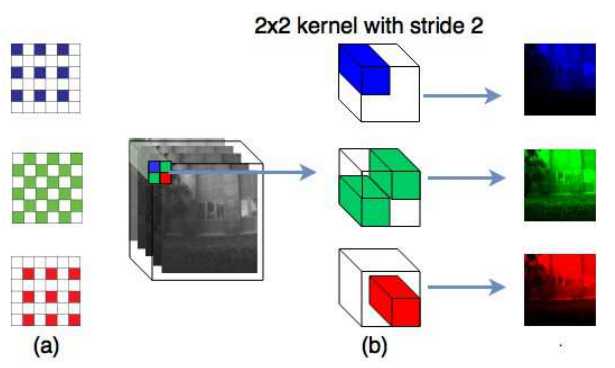

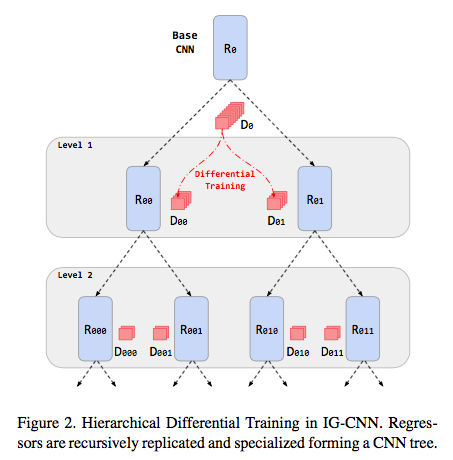

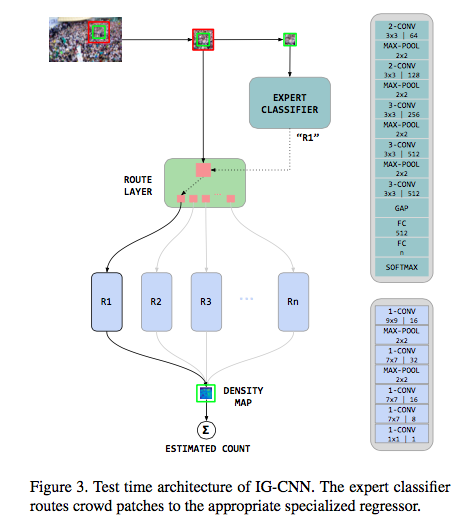

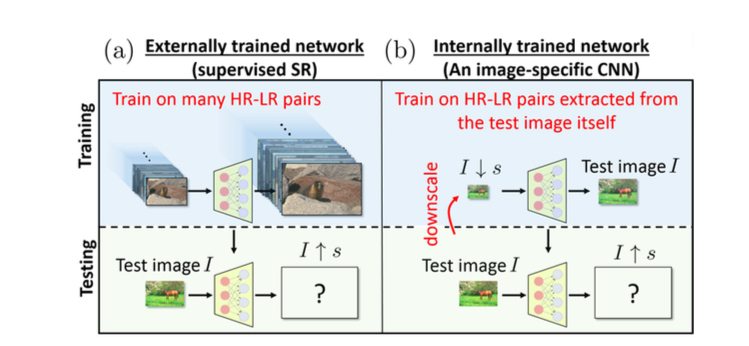

深い畳み込みネットワーク(ConvNets)は,多くのコンピュータビジョンタスクで前例のないパフォーマンスを達成しているが,単一の画像を集める集団への彼らの適応はまだ未熟な状態であり,過度の過度のフィッティングに苦しんでいる.ここでは深い負の相関学習(NCL)によって一般化可能な特徴を生成する新しい学習戦略を提案する.より具体的には,本質的な多様性を管理することによって,健全な一般化能力を持つ無相関回帰変数のプールを深く学習する.

無相関ConvNet(D-ConvNet)という名前の提案方法は,エンドツーエンドで訓練可能であり,バックボーン完全畳み込みネットワークアーキテクチャから独立している.非常に深いVGGNetとカスタマイズされたネットワーク構造に関する広範な実験は,いくつかの最先端の方法と比較した場合のD-ConvNetの優位性を示している.

Decorrelated ConvNet(D-ConvNet)と名付けた提案方法が,固有の多様性を管理することによって健全な一般化能力を有することを示している.DConvNetは,一般的であり,バックボーン完全畳み込みネットワークアーキテクチャから独立している.非常に深いVGGの広範な実験や,いくつかの難しいデータセットでカスタマイズされたネットワーク構造がD-ConvNetの優位性を実証した.

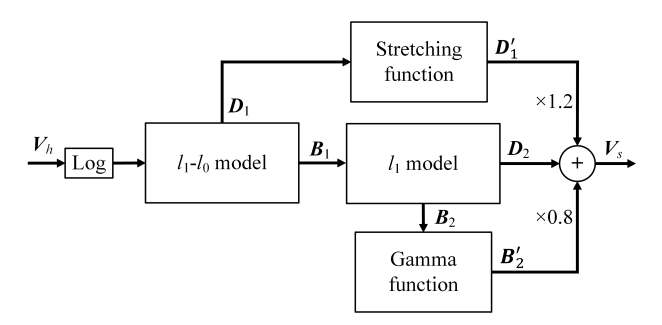

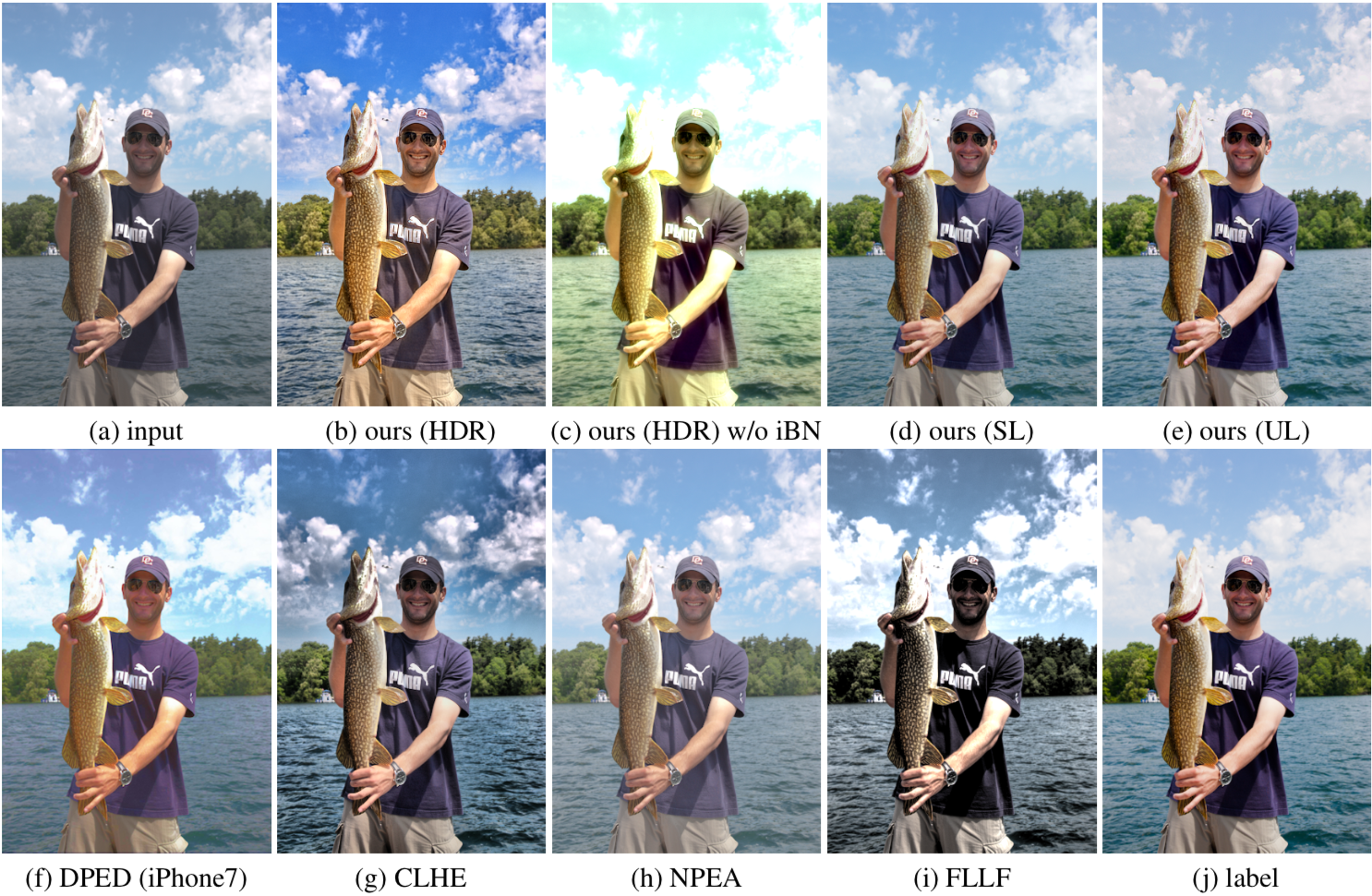

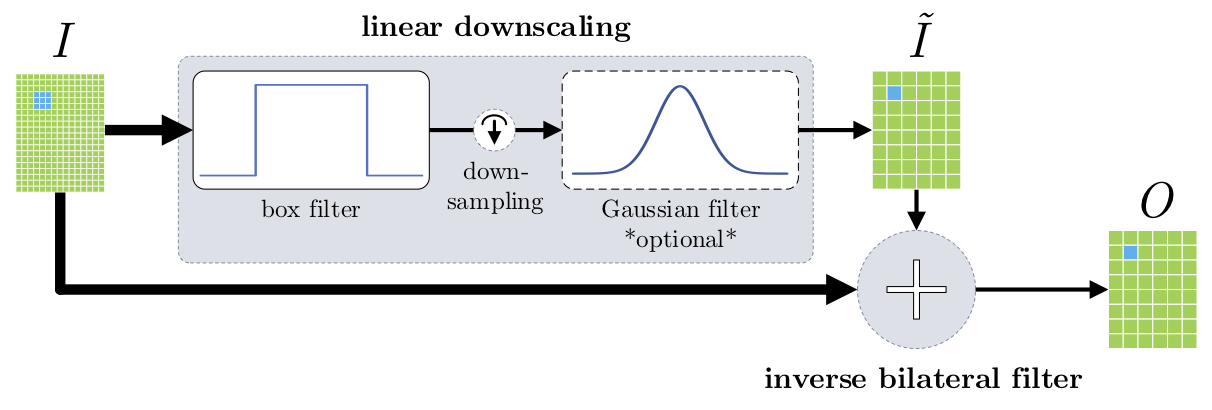

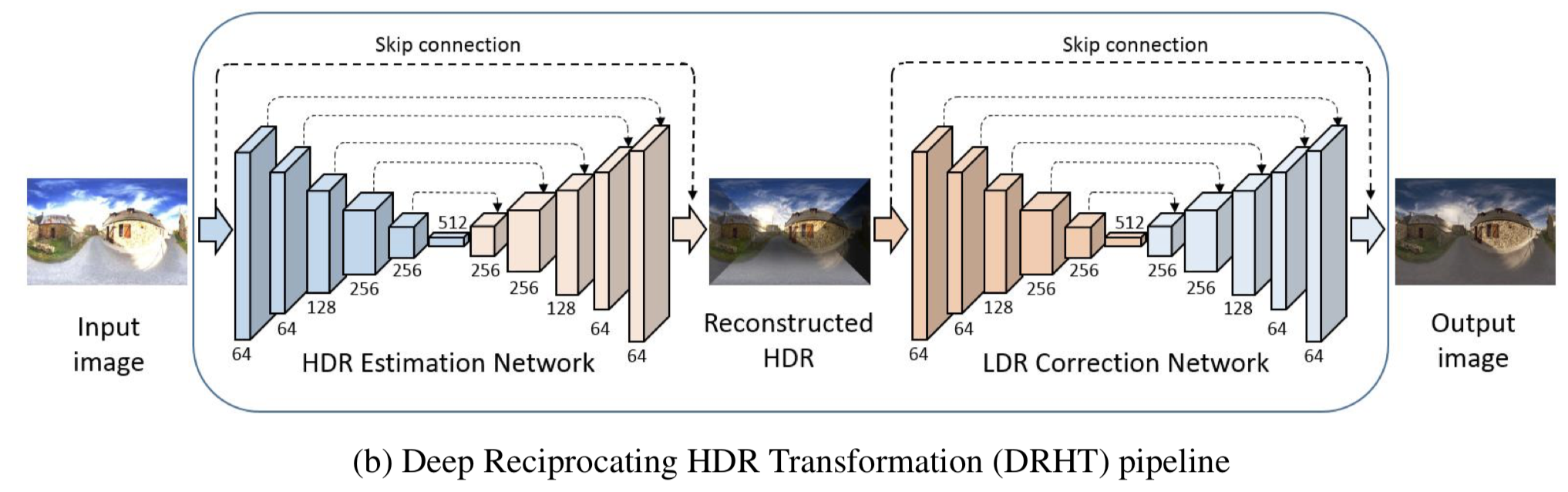

トーンマッピングは,視覚情報が保存された高ダイナミックレンジ画像から標準ダイナミックレンジ画像を再現することを目的とする.最先端のトーンマッピングアルゴリズムは,主に画像を基本レイヤーと詳細レイヤーに分解し,それに応じて処理する.本論文では,これらの問題に対処するハイブリッドl_1−l_0分解モデルを提案する.我々はさらに,我々の層分解モデルに基づいてマルチスケールトーンマッピングスキームを提案する.

最先端のトーンマッピングアルゴリズムは,主に画像を基本レイヤーと詳細レイヤーに分解し,それに応じて処理します.これらの方法は,2つの層に課せられた適切なプリヤの不足のために,ハローアーティファクトおよび過度の増強の問題を有する可能性がある.本論文では,これらの問題に対処するハイブリッドl_1−l_0分解モデルを提案する.具体的には,基底層には,その区分的な平滑性をモデル化するために,1つの希薄項が課される.ディテールレイヤーには構造優先として「0」の希薄語が課され,これは区分的に一定の効果をもたらす.我々はさらに,我々の層分解モデルに基づいてマルチスケールトーンマッピングスキームを提案する.

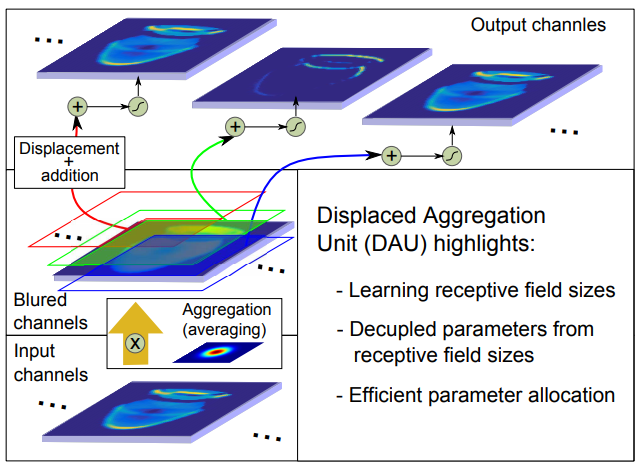

古典的なD-ConvNetは,パラメータの数の増加を防ぐために,徐々に分解能を低下させるか,手作業で拡張した畳み込みを適用することによって受容野のサイズを増加させる. 本論文では,手作業を必要としない新しい変位型集約ユニット(DAU)を提案する.固定された規則的なグリッド上に配置された単位(ピクセル)を有する古典的なフィルタとは対照的に,DAUの変位が学習され,フィルタが受容野を所与の問題に空間的に適応させる.通常のフィルタを備えたConvNetsと比較して,DAUを備えたConvNetsは,より速いコンバージェンスと,パラメータの最大3倍の低減で同等の性能を実現します.

分類およびセマンティックセグメンテーションタスクでDAUの強さを広範に実証している.通常のフィルタを備えたConvNetsと比較して,DAUを備えたConvNetsは,より速いコンバージェンスと,パラメータの最大3倍の低減で同等の性能を実現する.さらに,DAUにより,斬新な視点からDeepNetWorkを研究することができる.DAUフィルタの空間分布を研究し,フィルタ内の空間カバレッジに割り当てられるパラメータの数を分析する.

フィルタごとのパラメータ割り当てに関する包括的な調査では,既存のConvNetsのパラメータの非効率的な割り当てが示された.DAU-ConvNetsは従来のCovnNetsに匹敵する性能をフィルタ当たり3倍少ないパラメータで達成した.分析によれば,増幅係数が最も低いユニットを除去することで,性能を犠牲にすることなくパラメータの10%を節約することができるため,さらなる改善の余地があることがわかる.さらに,完全に接続されたレイヤにDAUを適用するための最近の予備的な作業は,完全に接続されたレイヤのパラメータの節約も可能であることを示している.

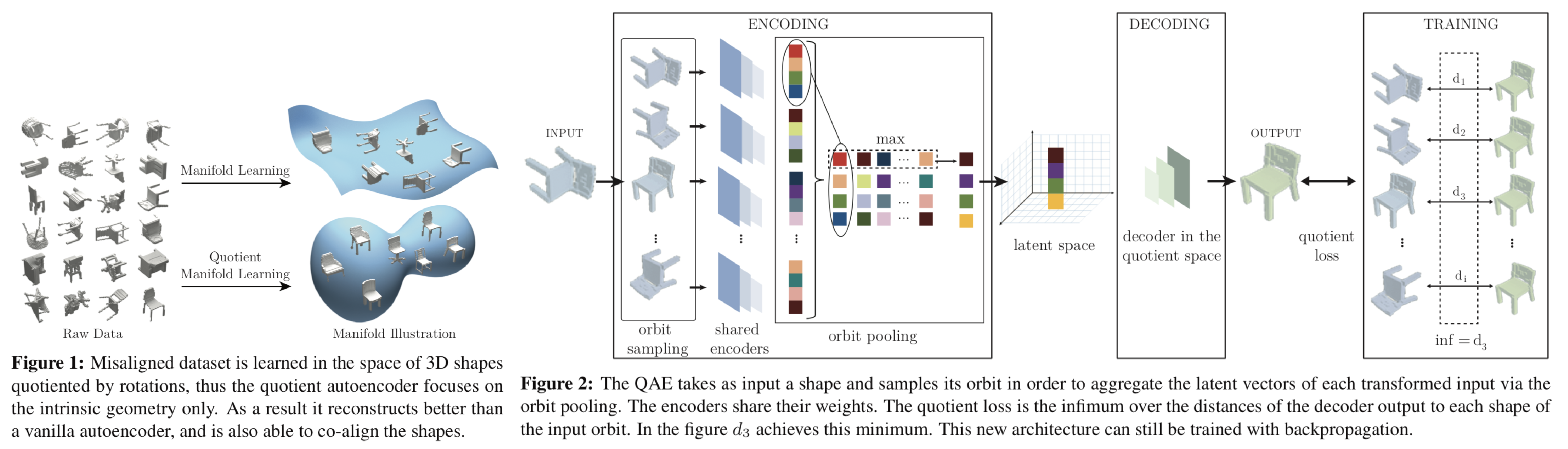

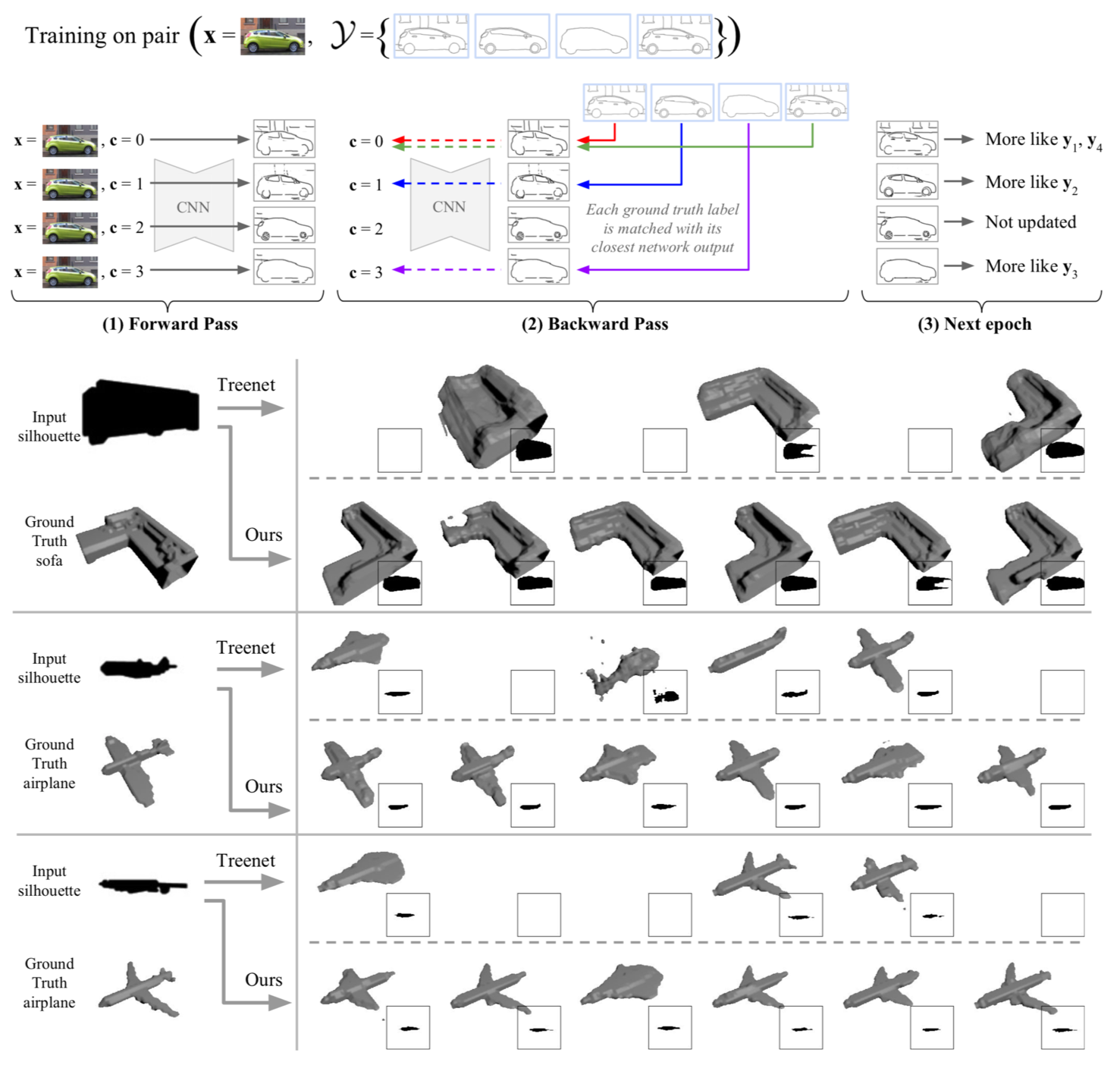

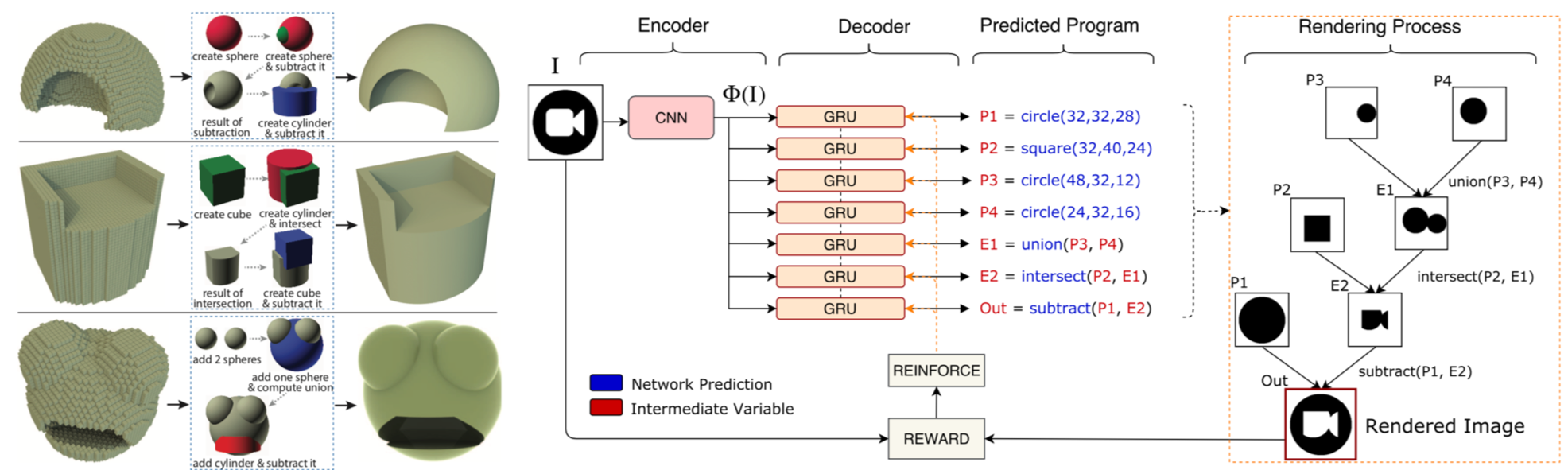

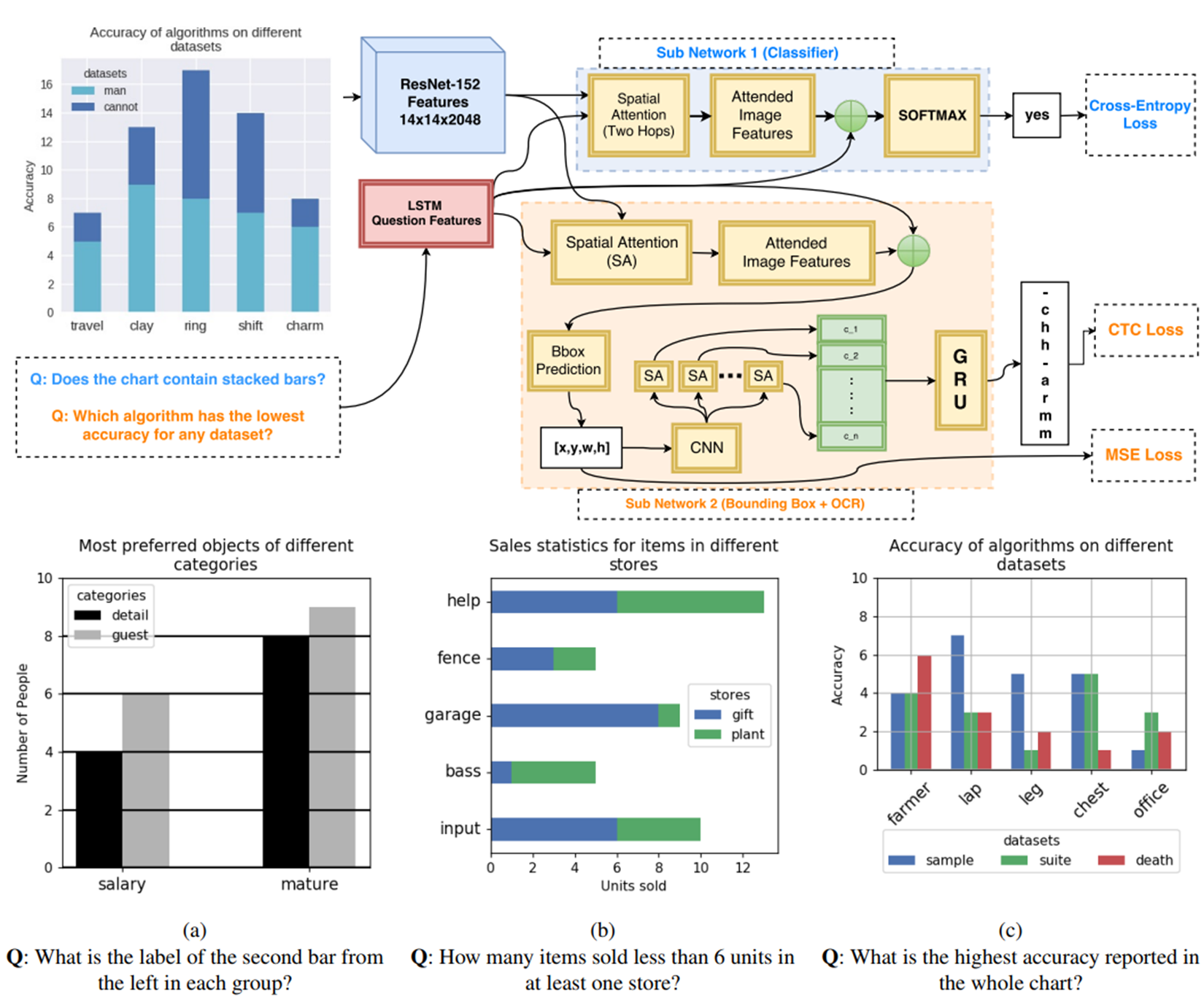

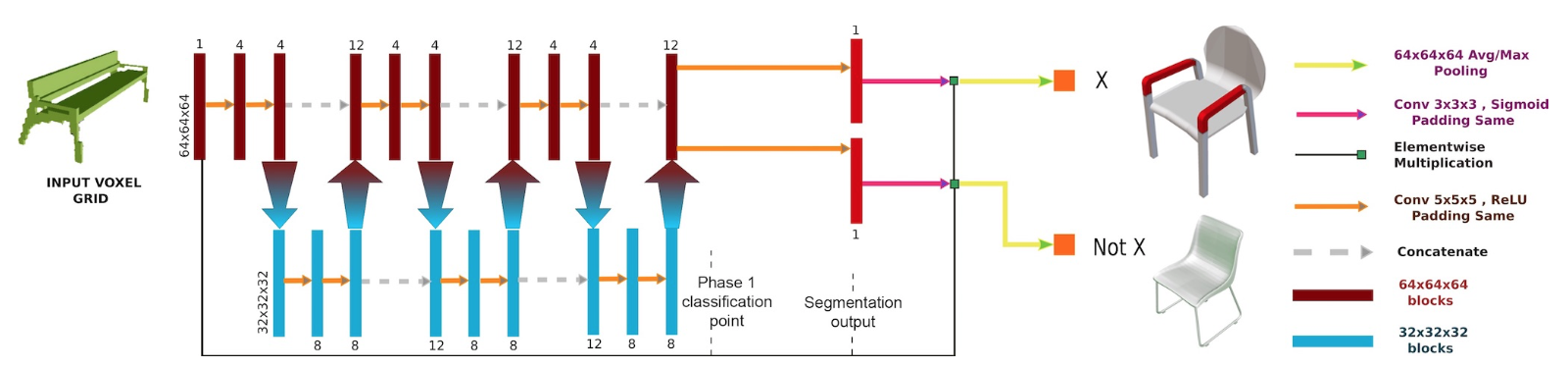

3D shapeを学習する際にposeに独立なgeometryの潜在変数空間を学習するネットワークであるquotient autoencoder(QAE)を提案。通常のAEに加えて、orbit poolingとquotient lossという2つのアイディアを追加した。orbit poolingでは、入力された3D shapeに対して様々な回転を与えそれらから得られる潜在変数のうち、各成分の最大値をその3D shapeを表現する潜在変数とする。quotient lossでは、リコンストラクションされた3D shapeと参照3D shapeの距離の下限をロスとして採用する。この2つの方法によってposeに不変な潜在変数空間を構築する。

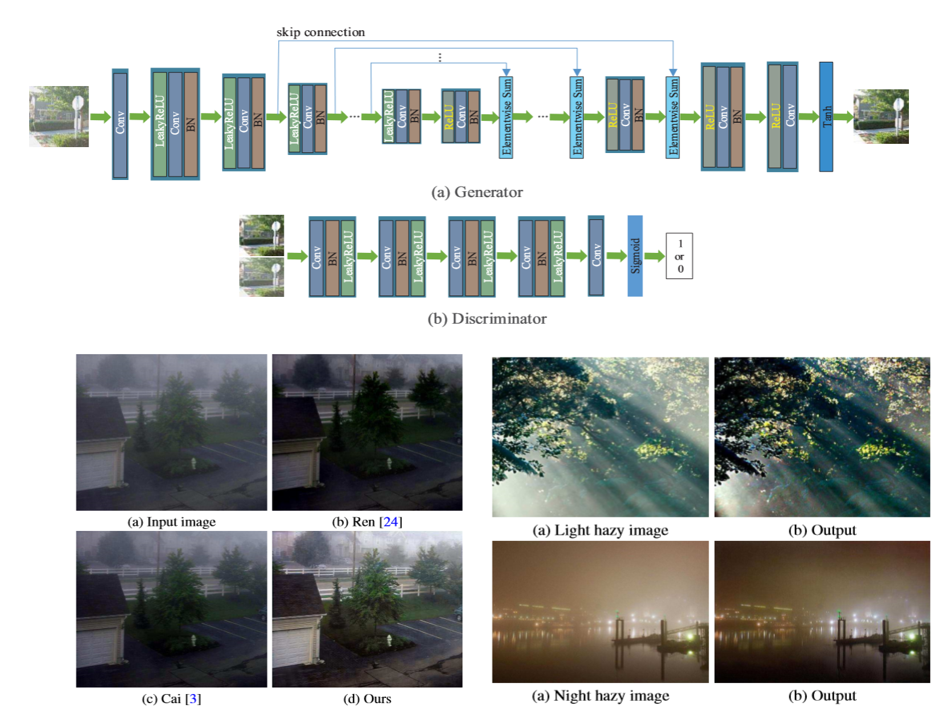

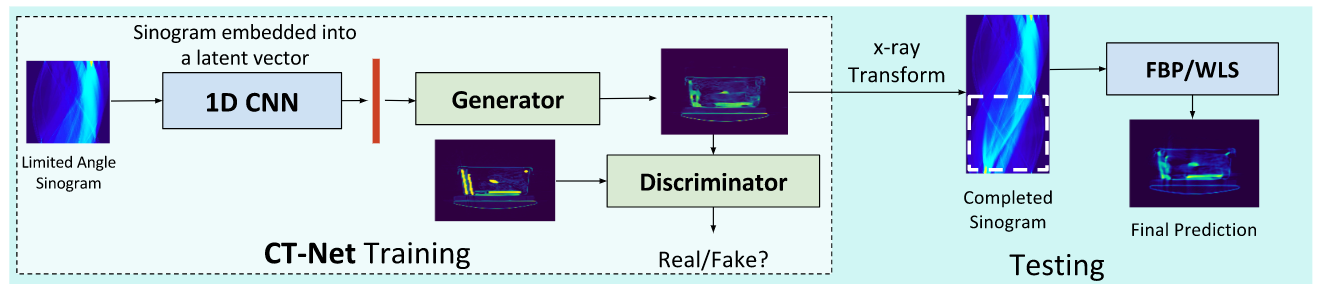

本稿では,かすんでいる画像から鮮明な画像を復元する手法を提案する。既存の手法では伝送マップおよび大気光を推定するために,例えば暗いチャネル,色の視差,最大のコントラストといった手作りの特徴を使用することが多い。本稿ではこの問題を条件付き生成的対立ネットワーク(cGAN)に基づいて解決する。ここで,鮮明な画像は,end-to-endの訓練可能なニューラルネットワークによって推定される。基本的なcGANの生成ネットワークとは異なり,本稿ではより良い結果を生み出すことができるように,エンコーダとデコーダのアーキテクチャを提案する。

・条件付きGANを用いることにより,かすんでいる画像から鮮明な画像の生成を実現している。・鮮明な画像を生成するためにVGGフィーチャとL1正規化勾配を事前に導入することによって,基本のcGANフォーメーションをさらに修正している。

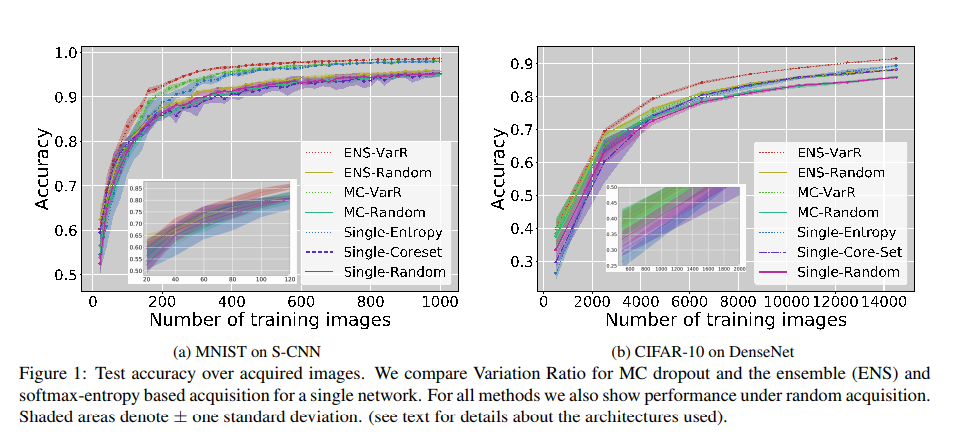

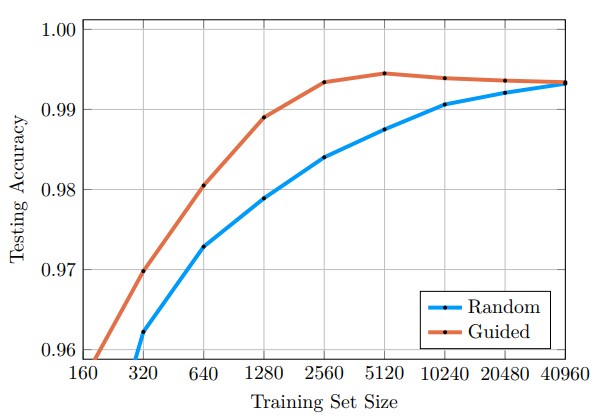

本稿では高次元のデータと畳み込みニューラルネットワーク分類機を用いたアクティブ学習から最近提案されたいくつかの手法の検討をする.モンテカルロドロップアウト手法と幾何学手法に対してアンサンブルベースと比較する. MNISTとCIFAR-10の結果を示し,約12,200個のラベル付き画像で90%のテストセット精度を達成し,ImageNetで初期結果を得た.

アンサンブルベースの不確かさは,他の不確かさ推定方法(特にMCドロップアウト)よりも一貫して優れていることを示し,MNISTとCIFAR-10の最先端のactivity learningパフォーマンスにつながる.

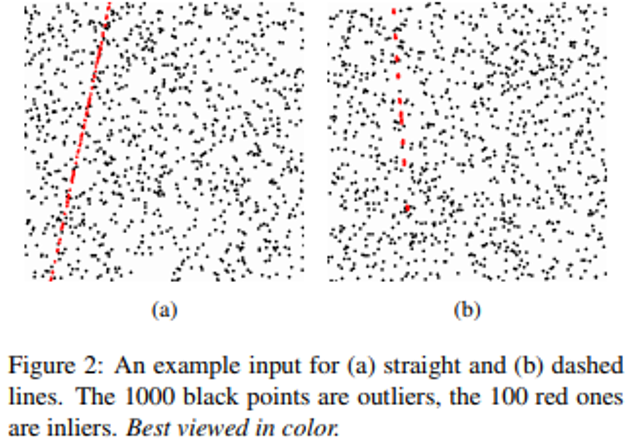

凸緩和を介して複数の幾何モデルを複数の構造データにフィッティングするための新しい方法を提案.COnvex Relaxation Algorithm(CORAL)を用いて多次元データを適合させ、セグメント化するための新しい最適化を行う.復ごとに同等のアーキテクチャで2桁の速さで最小化されるため、より多くの幾何学的マルチモデルフィッティング問題にリアルタイムで堅牢なパフォーマンスを得た.

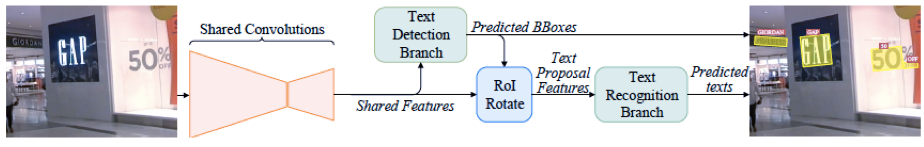

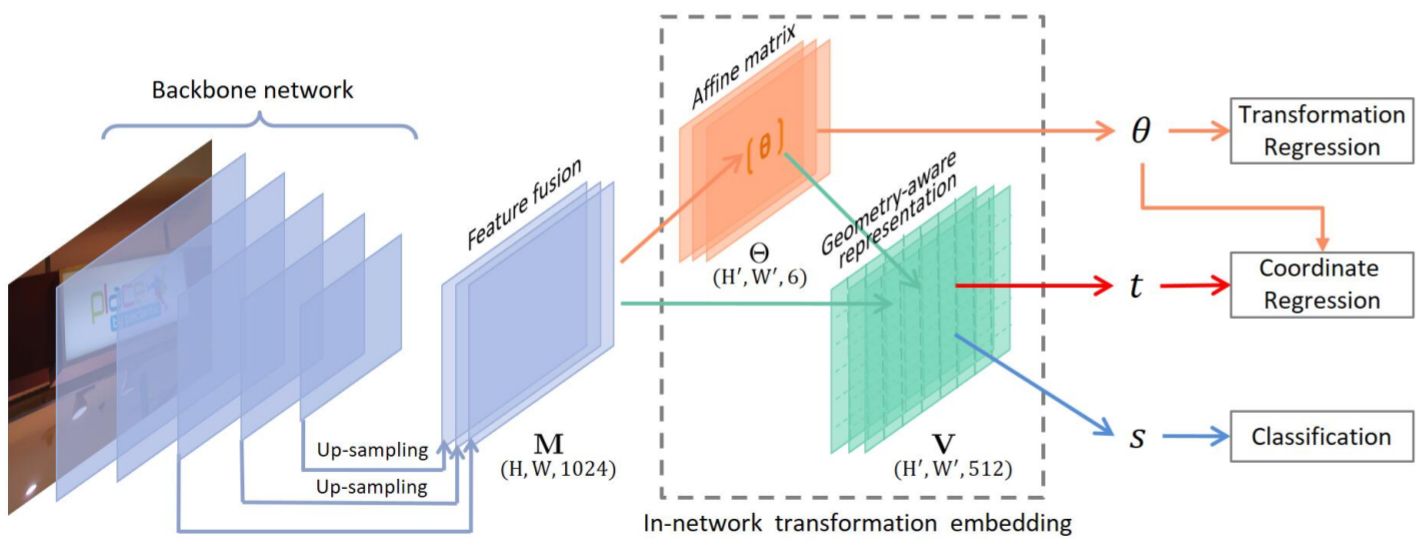

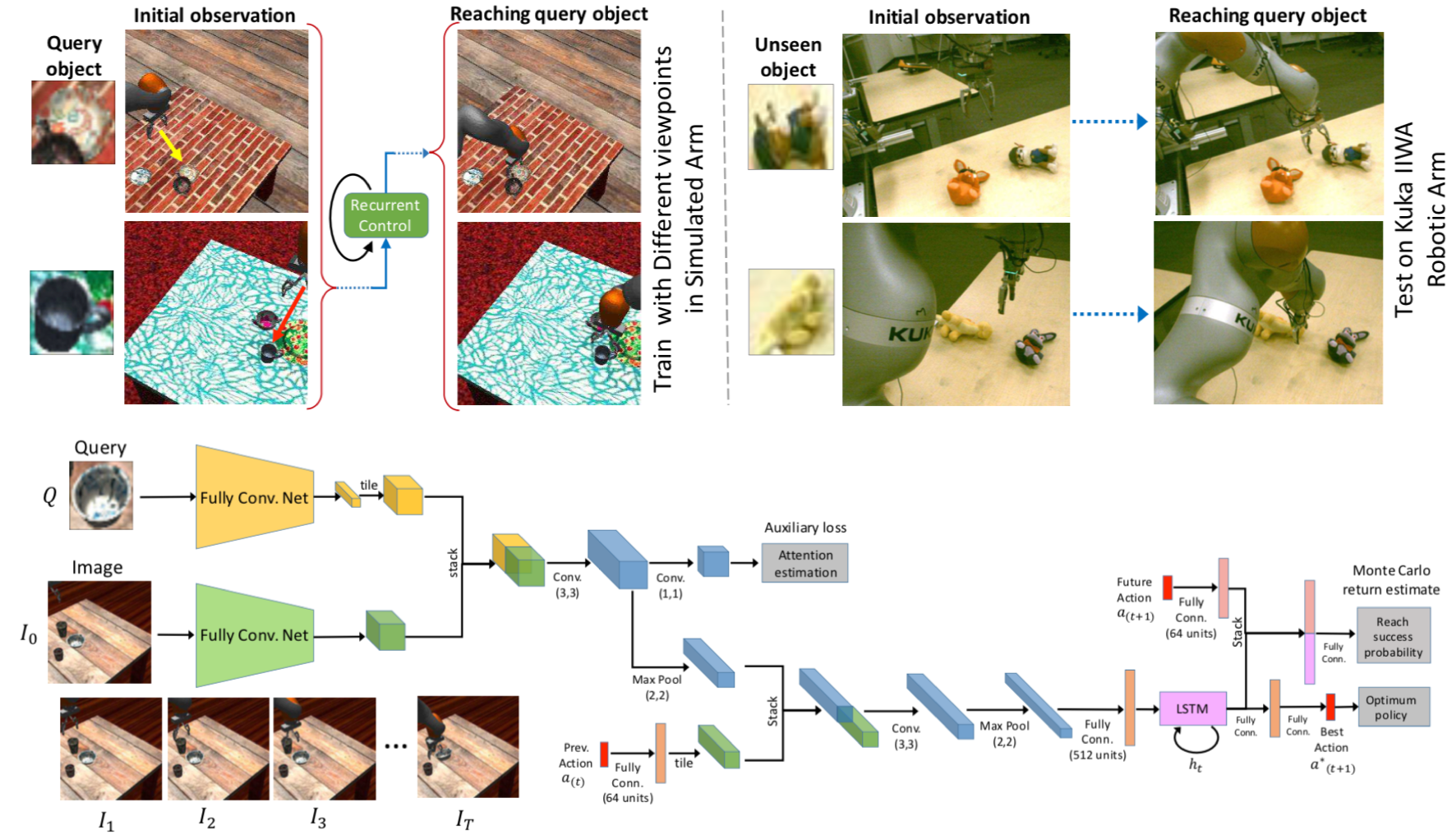

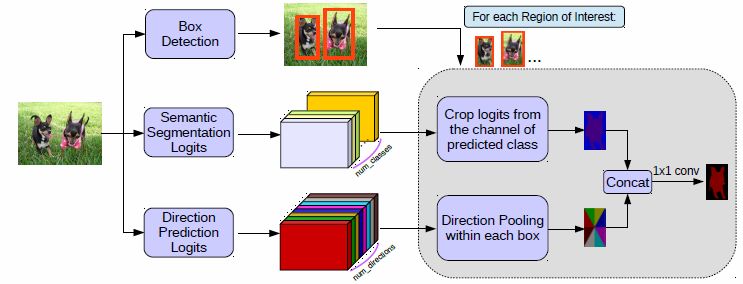

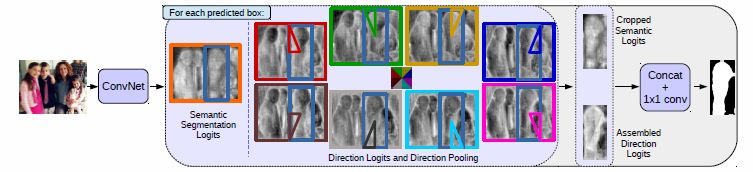

既存のテキストの認識手法は,検出と認識を別のタスクとして扱う物が多い,しかし,本研究では,同時に検出と認識をするためのend-to-endで学習可能なFast Oriented Text Spotting(FOTS)を提案する.ICDAR 2015、ICDAR 2017 MLT、およびICDAR 2013を用いた文字の検出,識別の評価実験では既存の手法と比較してSoTAであった.

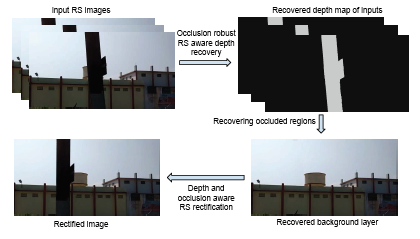

一組のイメージカーブを用いて,3D直線に対応するという知識に基づき単一画像内のRS歪みを補正するロバストな方法を提案.一様な運動モデル下で移動するローリングシャッターカメラによって出現する3D直線の投影のためのパラメトリック方程式を定式化し,少なくとも4つのイメージカーブを用いて,姿勢パラメータとは別にカメラの角速度を効率的に推定する方法を提案.さらに,3D直線に対応するイメージカーブを選択し,3次元での実際のイメージカーブを選択するRANSACのような戦略を提案.

・ 合成データと実データの両方を用いた比較実験によりstate-of-the-art.

高次のMRF(Markov Random Field)によるトランスダクティブ推論のための新しいアルゴリズムの提案.MRFでは単項式のエネルギーは可変分類器によってパラメータ化され,連続的な分類子のパラメータと離散的な変数の共同最適化問題として提起される.問題解決のために,凸緩和などの従来手法と対照的にADMM(Alternating Direction Method of Multipliers)での効率的な最適化手法として関連目的関数を離散的かつ連続的な問題に切り離すことを提案.離散変数の完全性を保ち,臨界点への大域収束性を保証している.

・ MAPの推論問題の準最適解を得ることができ,計算上より困難なMRFを考慮することが可能.・ k-meansと対照的に深層特徴と統合される ・ 従来手法より一貫した結果となり,ランタイム,メモリ消費について効率的.

画像歪みに対するCNNの頑健性を改善する研究.特徴分布の高いモーメント統計は画像の歪みによってシフトする可能性があり,性能低下につながる.この効果を低減するために,特徴量の量子化によるアプローチを提案.1)スケーラブルな分解能を持つ床関数,2)学習可能な指数を持つ累乗関数,3)データ依存指数を用いた累乗関数の3種類の非線形関数をCNNに採用.

・ 提案手法を用いたResNet-50でモーションブラー,ごま塩ノイズ,それらの複合の歪みで歪んだ画像を用いたILSVRC-12分類タスクでそれぞれ6.95%,5.26%,5.61%の精度向上.

多視点での車両の再識別問題を解決するために,視覚情報のみを用いたViewpoint-aware Attentive Multi-view Inference(VAMI)モデルを提案.VAMIは,任意の視点の車両画像を与えると,入力画像毎に単一視点の特徴を抽出し,その特徴を可変多視点の特徴表現に変換する.また,異なる視点で重要となるコア領域を選択し,敵対的学習で効果的なマルチビューの特徴推論を実装するため,視覚的なアテンションモデルを採用.

VeRiとVehicleIDの2つのデータセットでの車両の再識別についてstate-of-the-artよりも改善.

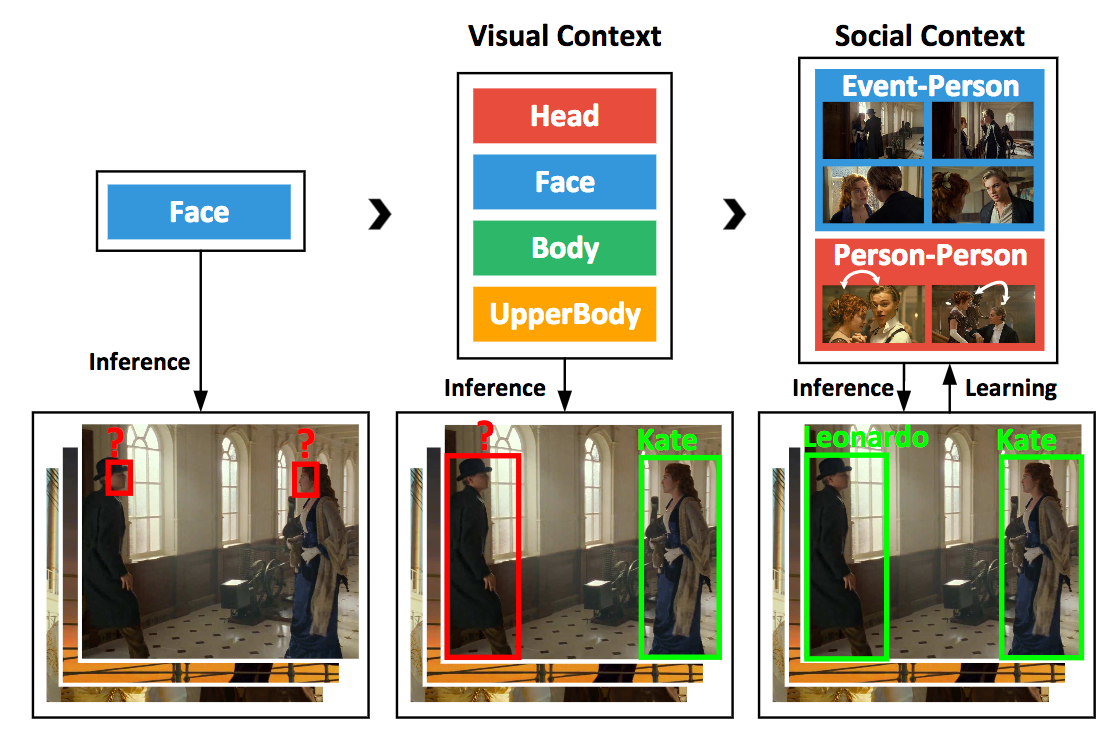

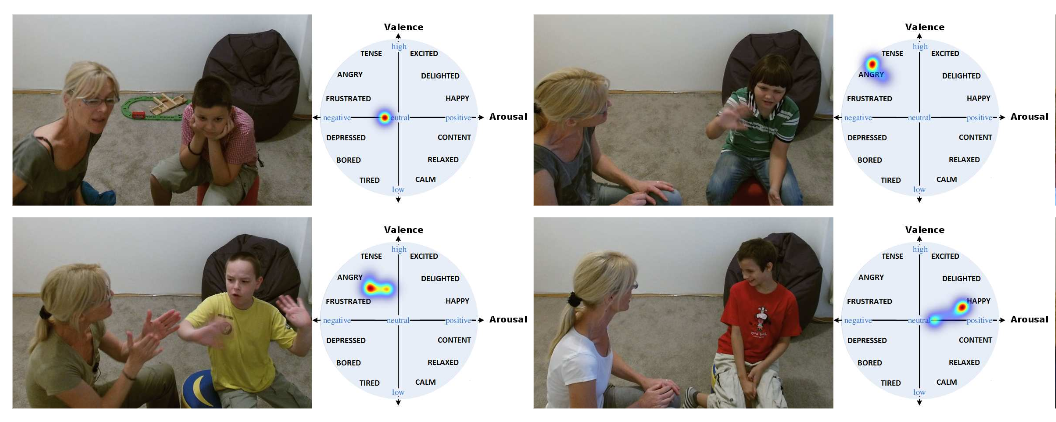

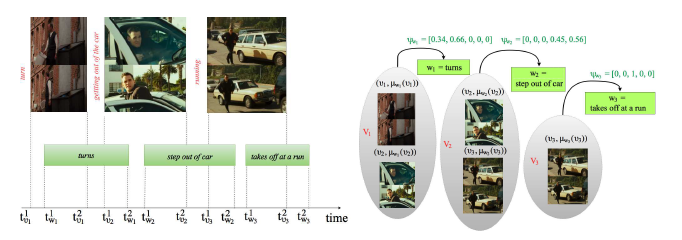

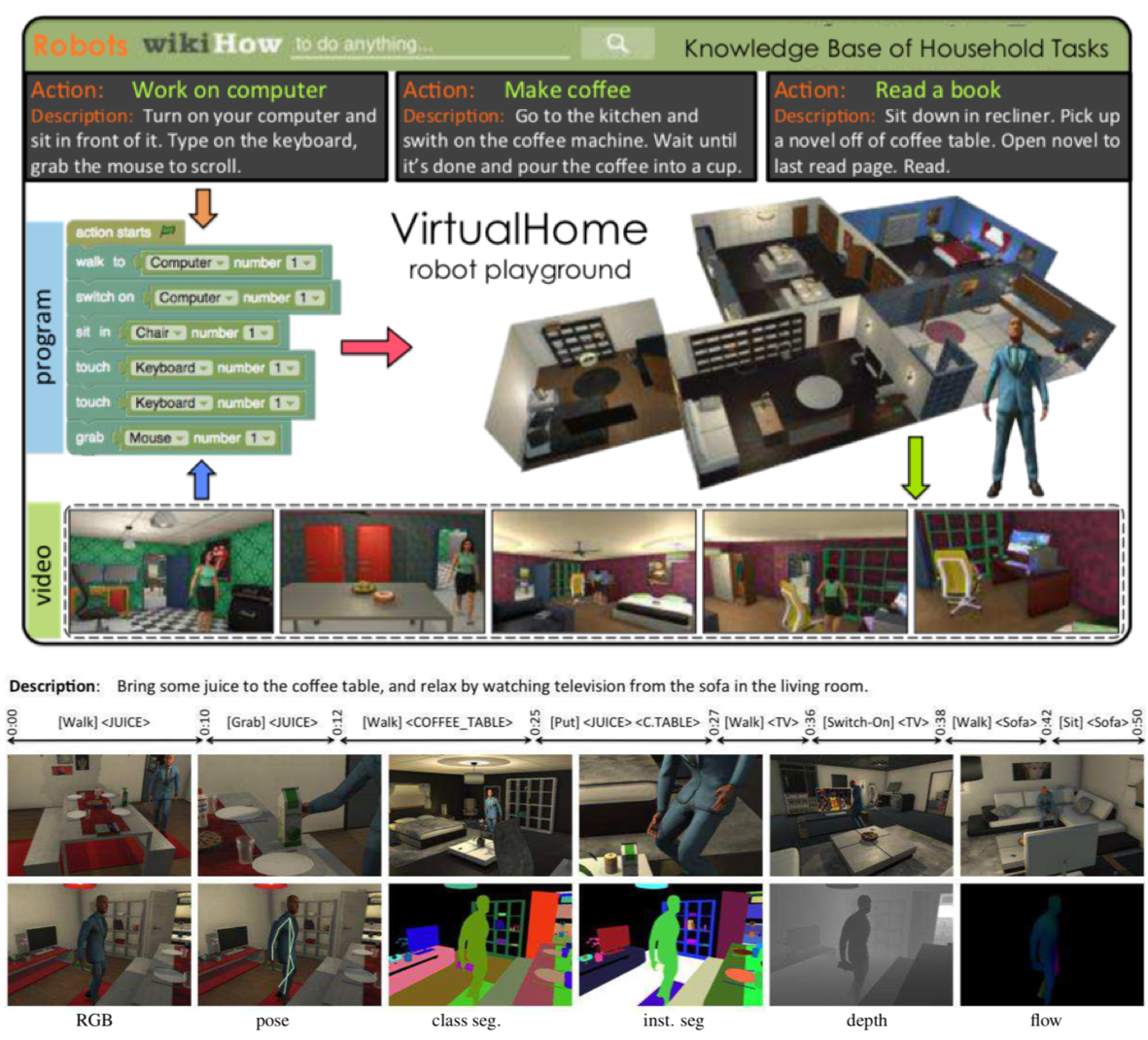

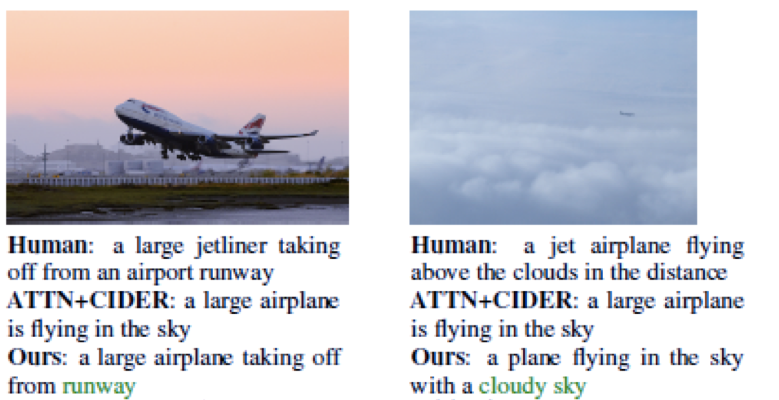

MOVIE graphsという新しいデータセットの提案.映画のクリップ中の社会的状況のグラフベースのアノテーションを詳細に行ったデータセットであり,各グラフは現在誰が写っているのか,感情や体格はどうか,複数人写っている場合の関係は,それらの間のインタラクションはといったさまざまなノードで構成されている.また,データセットの徹底的な分析を行い,時間経過とともにシーンの異なる社会的側面の興味深い常識的な相関関係を示す.グラフを用いてビデオとテキストを照会する方法として1)私たちのグラフは各場面をまとめて複数の意味的に関連する状況を取り出す方法,順序付けと理由の理解を通してインタラクションの理解のための方法を提案.

・ 人間中心の状況の推論された特性に焦点を当てた最初のベンチマークである.・ 各クリップには,シチュエーションラベル,シーンラベル,および支援言語の説明がアノテーションされおり,視覚的かつ時間的に接地されている.グラフのキャラクターはクリップの中の顔のトラックに関連付けられ,ほとんどのインタラクションは発生する時間間隔に関連付けられる.

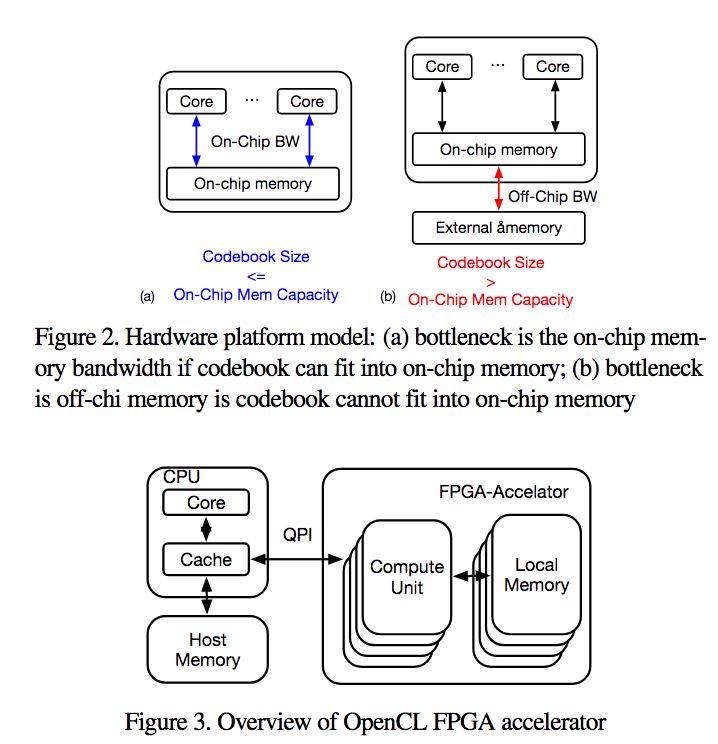

近似的最近傍探索法(Approximated Nearest Neighbor; ANN)をベースにした直積量子化(Product Quantization; PQ)手法を提案する。粗な量子化、直積量子化、回転行列、コードブック計算に量子化法を用い、OpenCL-FPGAを使用したIntel HARPv2プラットフォームにより実装する。

大規模かつ高次元のANNにおいて、FPGAによりCPU/GPUのパフォーマンスを越えることに成功した最初の例である。YFCC100M/BigANN/Deep1Bにおいて検証を行なった。

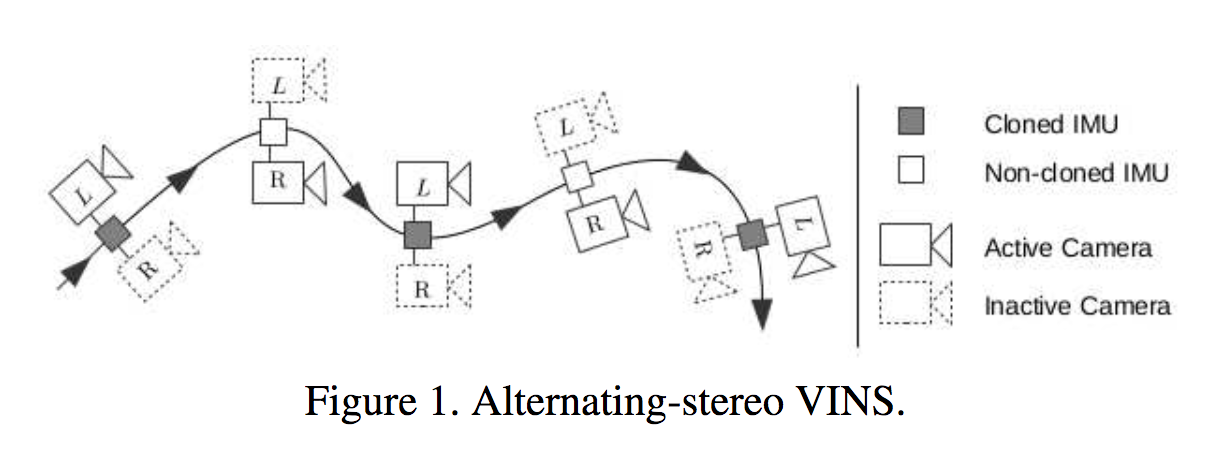

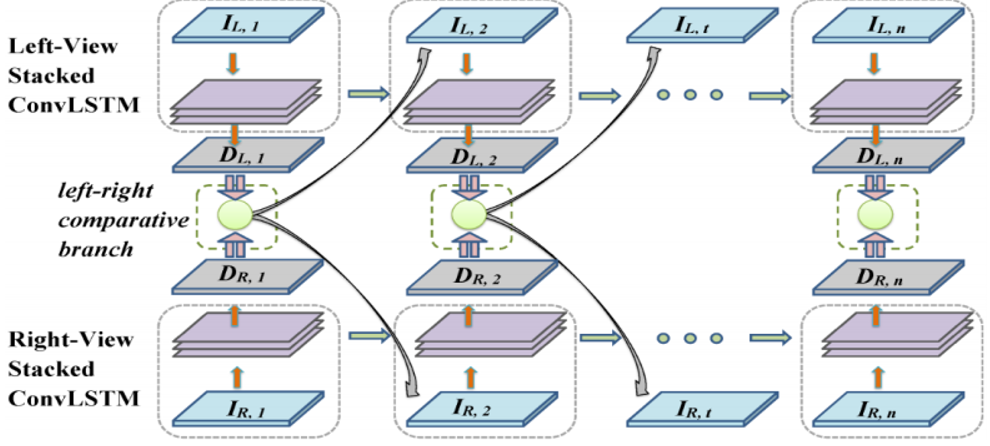

ビジョンベースの慣性ナビゲーションシステム(Vision-aided Inertial Navigation Systems; VINS)に関して、低コストなステレオビジョンを提案する。通常は2カメラを用いるが、計算的なコストやレイテンシが問題になってしまう。Left-Rightカメラの代替として、片方のカメラのみでカメラ姿勢を推定、もう一方のカメラにより補間を行い、最後にスケール問題を解決。右図のように交互にアクティブなカメラを切り替えて探索を行う。

Low-latencyなステレオのカメラを交互に切り替えて慣性ナビゲーションを行うalternating-stereo VINSを提案する。実際にシステムを構築して実験を行なったことも評価されている。

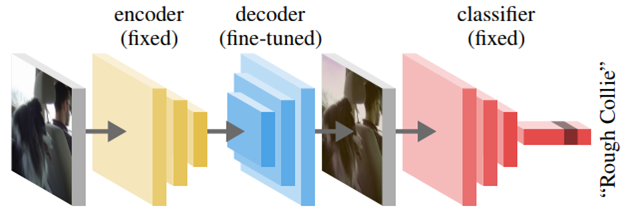

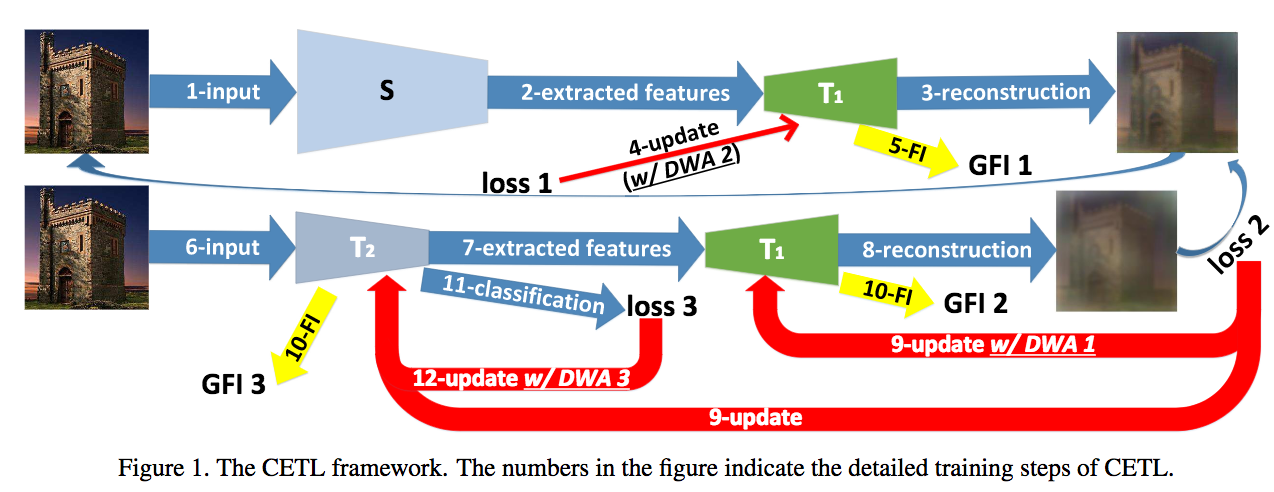

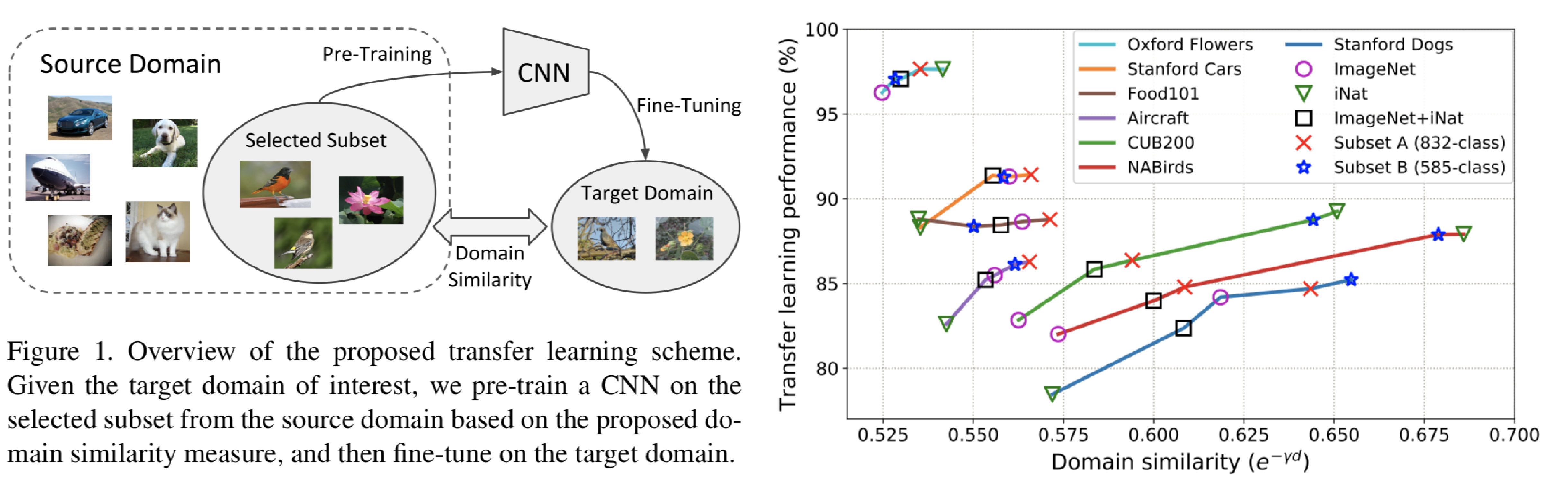

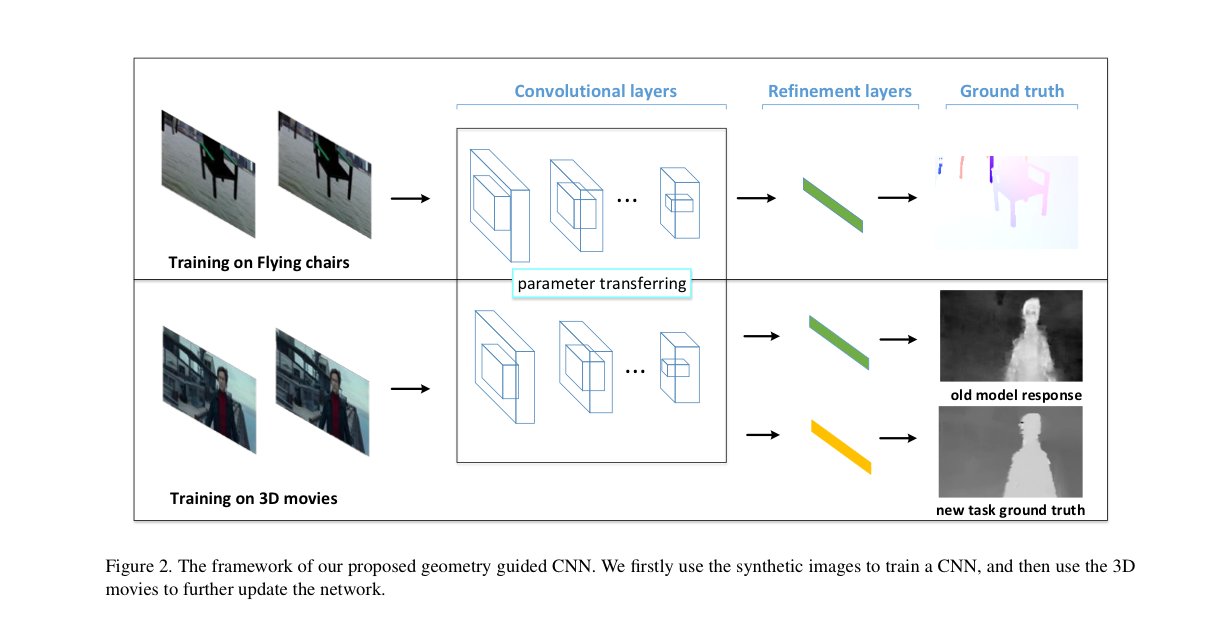

ふたつのネットワークの協調学習であるCoupled End-to-End Transfer Learning(CETL)を提案、デコーダのパラメータを共有して対象ドメインに関してデータが少ないという転移学習の問題を改善する。さらに同ネットワークを最適化させるための誤差関数であるCoupledLossを提案した。ドメイン変換や知識蒸留でも使えることを示した。

転移学習の問題(事前学習には膨大なデータがあるが、対象データが少量)を解決するためのCETLを提案した。汎用フィッシャー情報を提案して複数タスクにおける最適化を実行した。

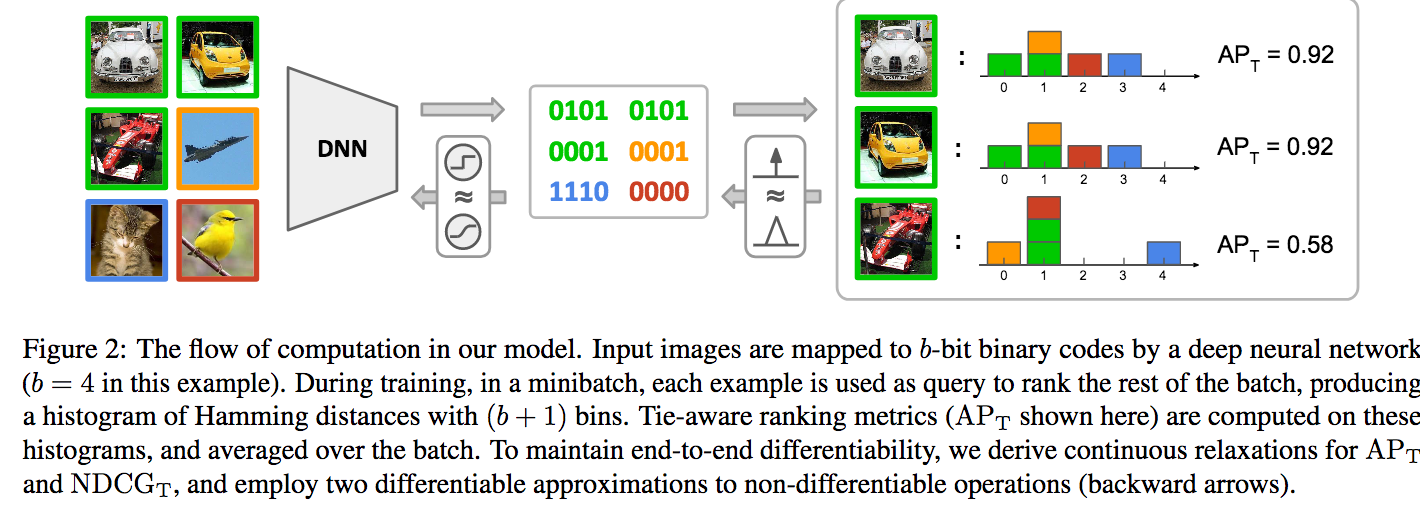

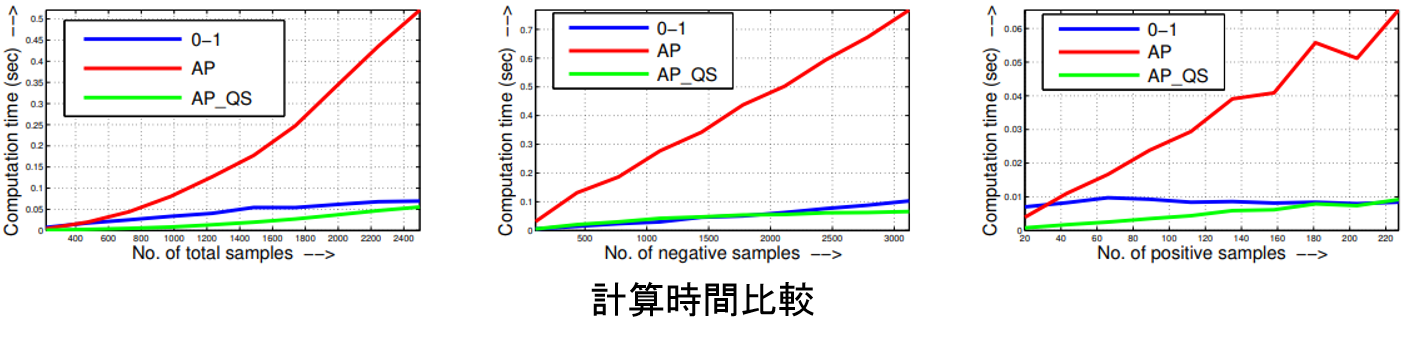

ハッシングに関するランキングを直接最適化、Average Precision(AP)やNormalized Discounted Cumulative Gain(NDCG)などにより評価できる手法について提案する。Intによるハミング距離をランキングし、AP/NDCGにより評価、勾配を最適化することによりCNNを学習する。ハミング距離による画像検索において新しいベースラインを作ることに成功した。

ハッシングによる最適化について、評価指標をダイレクトに誤差に用いることができるTie-aware Learningを提案し、画像検索問題に応用した。CIFAR-10,NUS-WIDE,LabelMe,ImageNet100において新しいベースラインを作った。

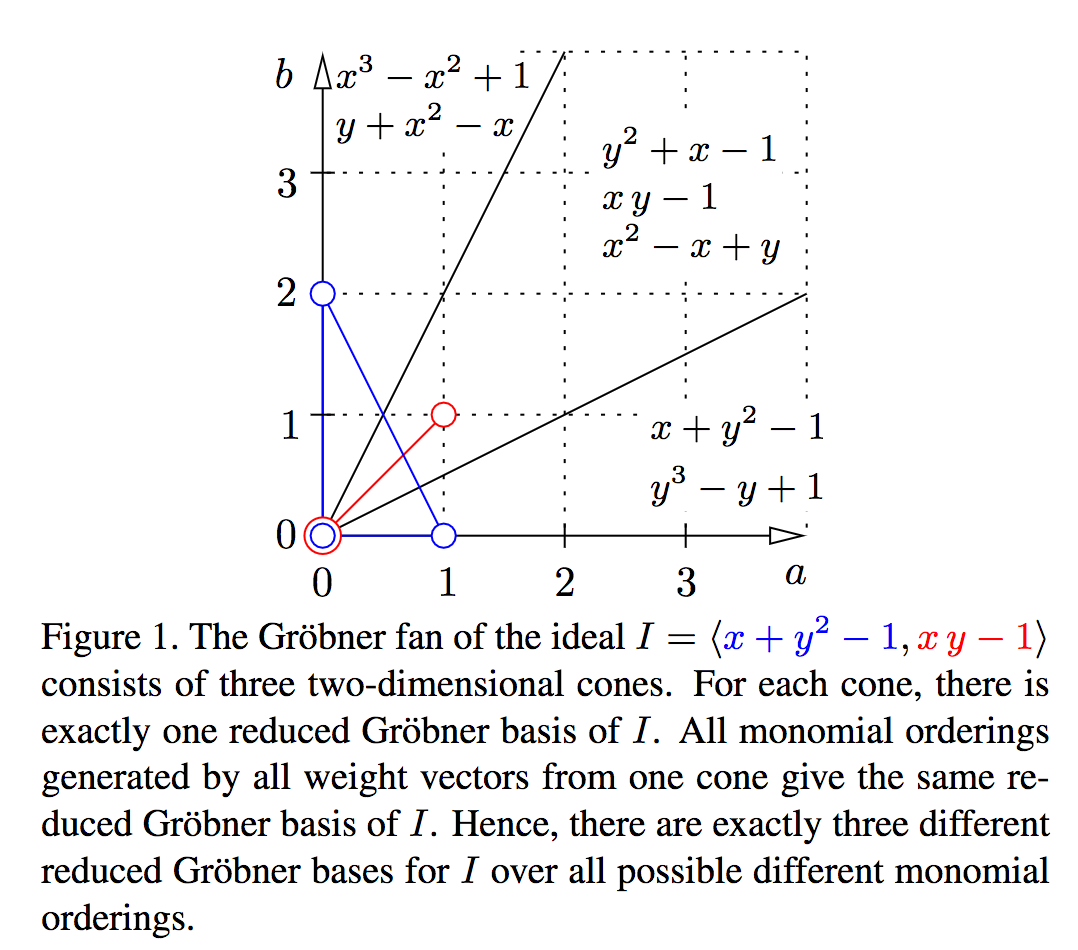

CVのアルゴリズムはカメラモーションやシーンにおける3次元構造など幾何的なロバスト推定を要することが多く、RANSACに頼ることも多い。本論文では単項式の選択により高速な多項式計算を実装するための方法について検討する。Grobner基底を利用することにより、効率的な計算を実現する。

Grobner基底によりロバスト推定を高速化する方法について提案することに成功。単項式によるサンプリングについてヒューリスティックな方法を実現。幾何推定やカメラ校正問題についてState-of-the-artな方法を高速に実装。

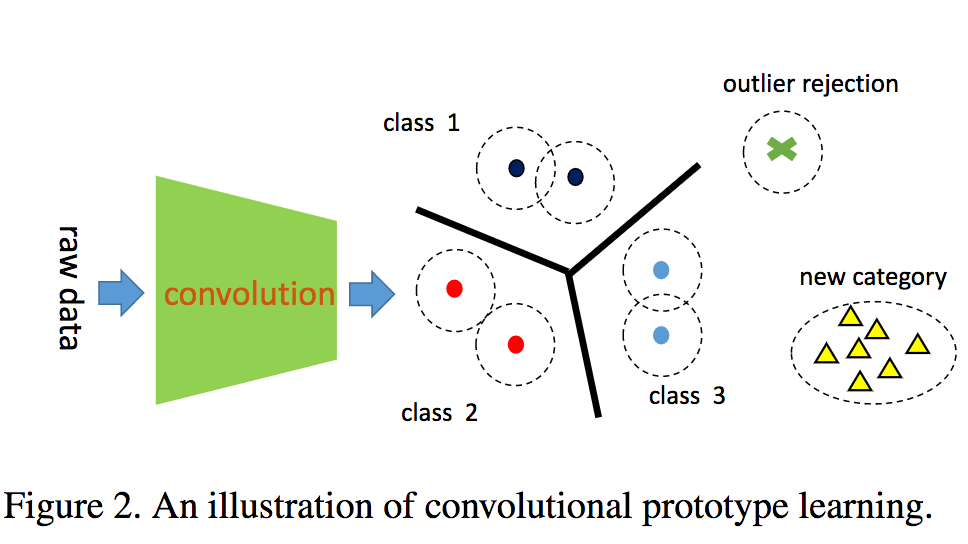

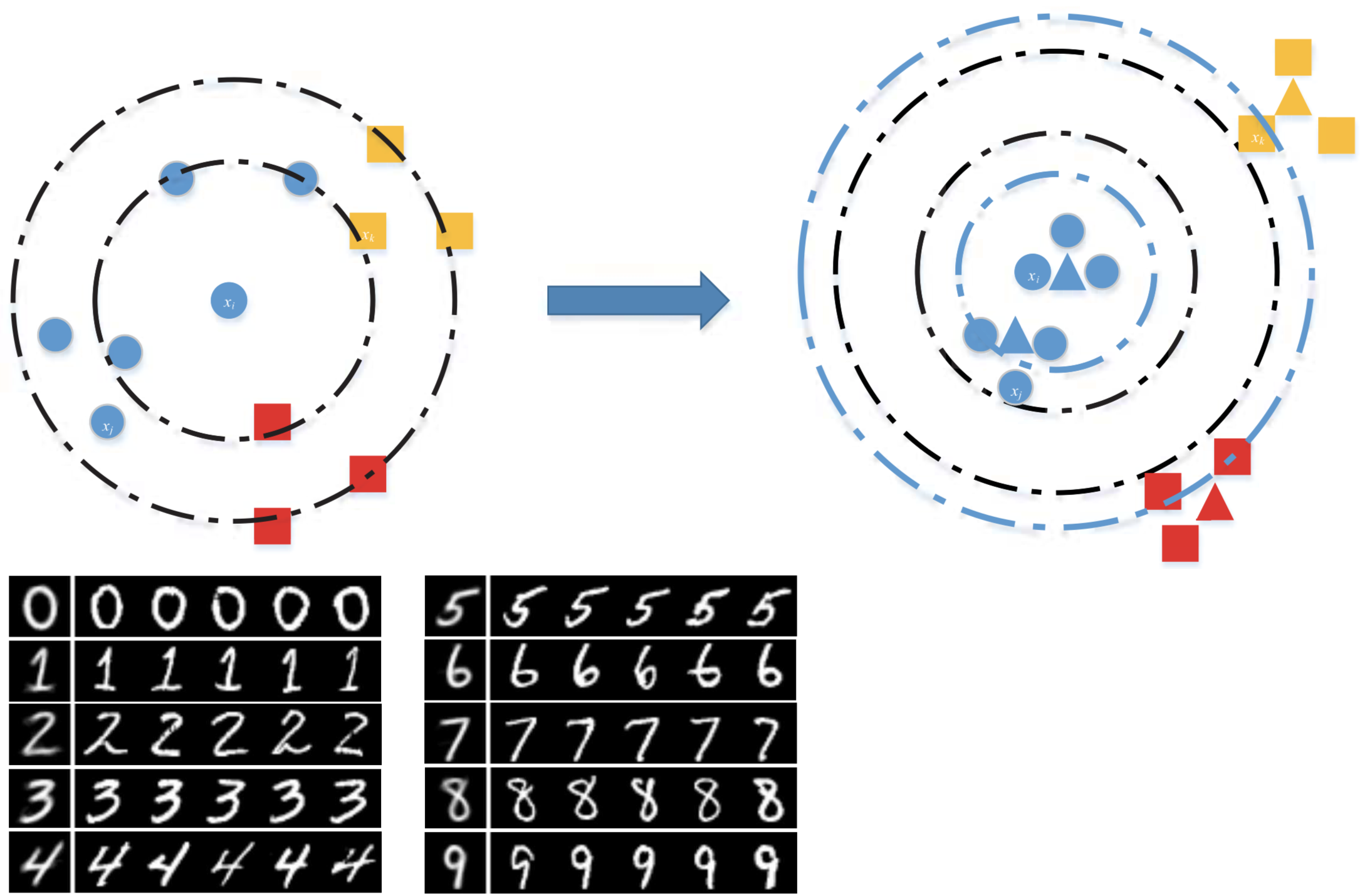

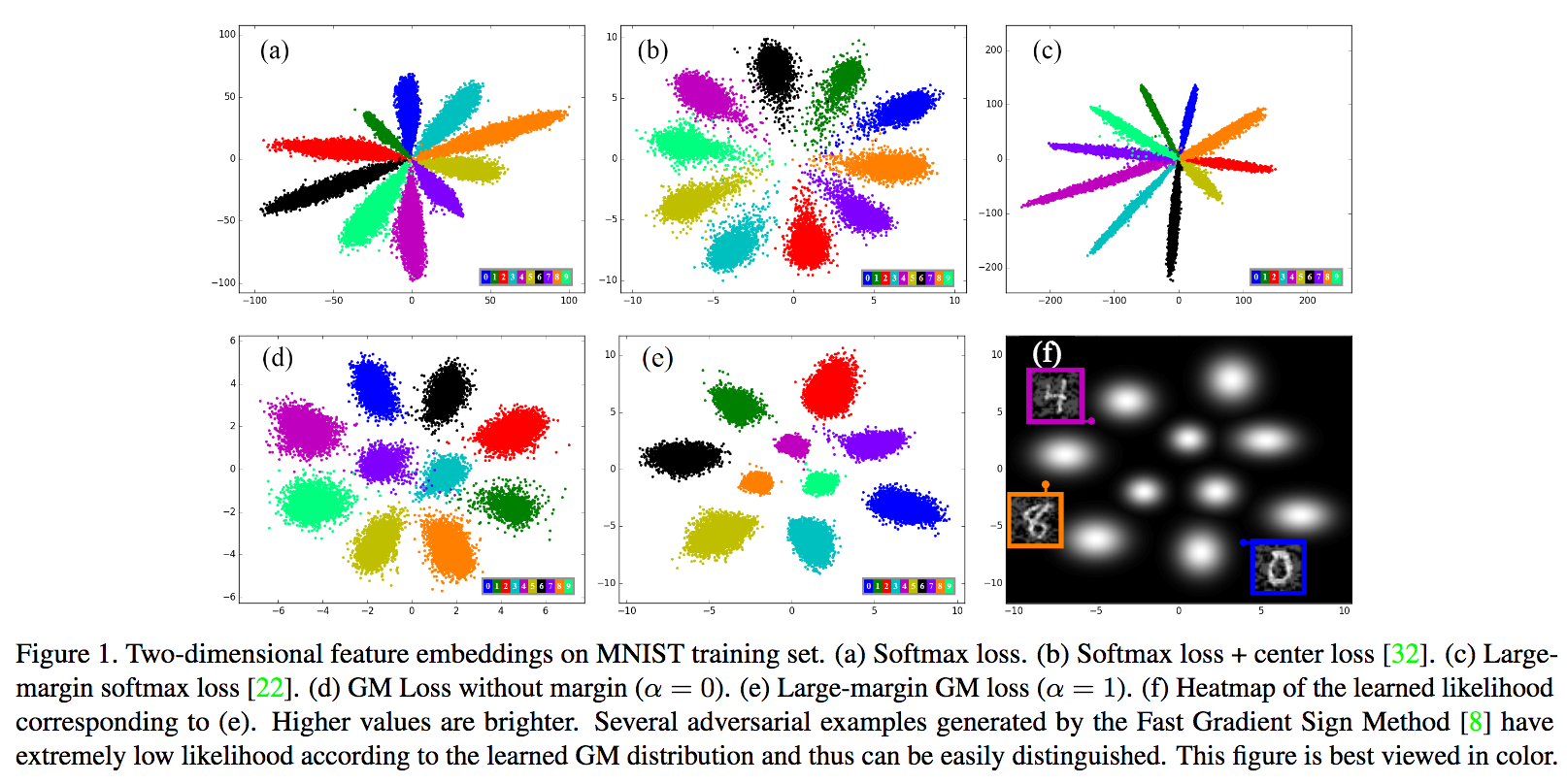

CNNによりロバスト性を与えるための学習手法Convolutional Prototype Learning(CPL)を提案する。識別器が騙されるということが少なくなり、識別問題に対して有効である。複数カテゴリに対して条件を与えること、PrototypeLoss(PL)による正則化を与えることでクラス内のコンパクト性を高めた。

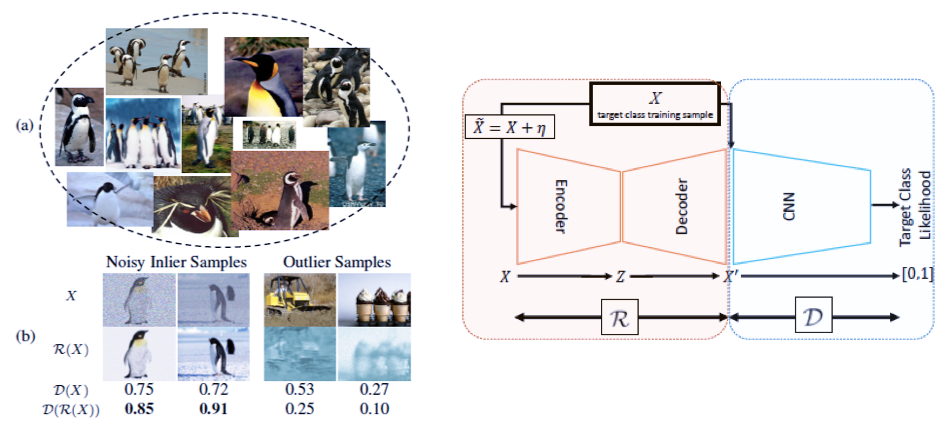

識別のロバスト性を高めるCPLを提案した。CPLではカテゴリを識別するだけでなく、アウトライア除去と新しいカテゴリを追加する機構が備わっている。MNIST/CIFARにて分離性の高い特徴を生成することができた。

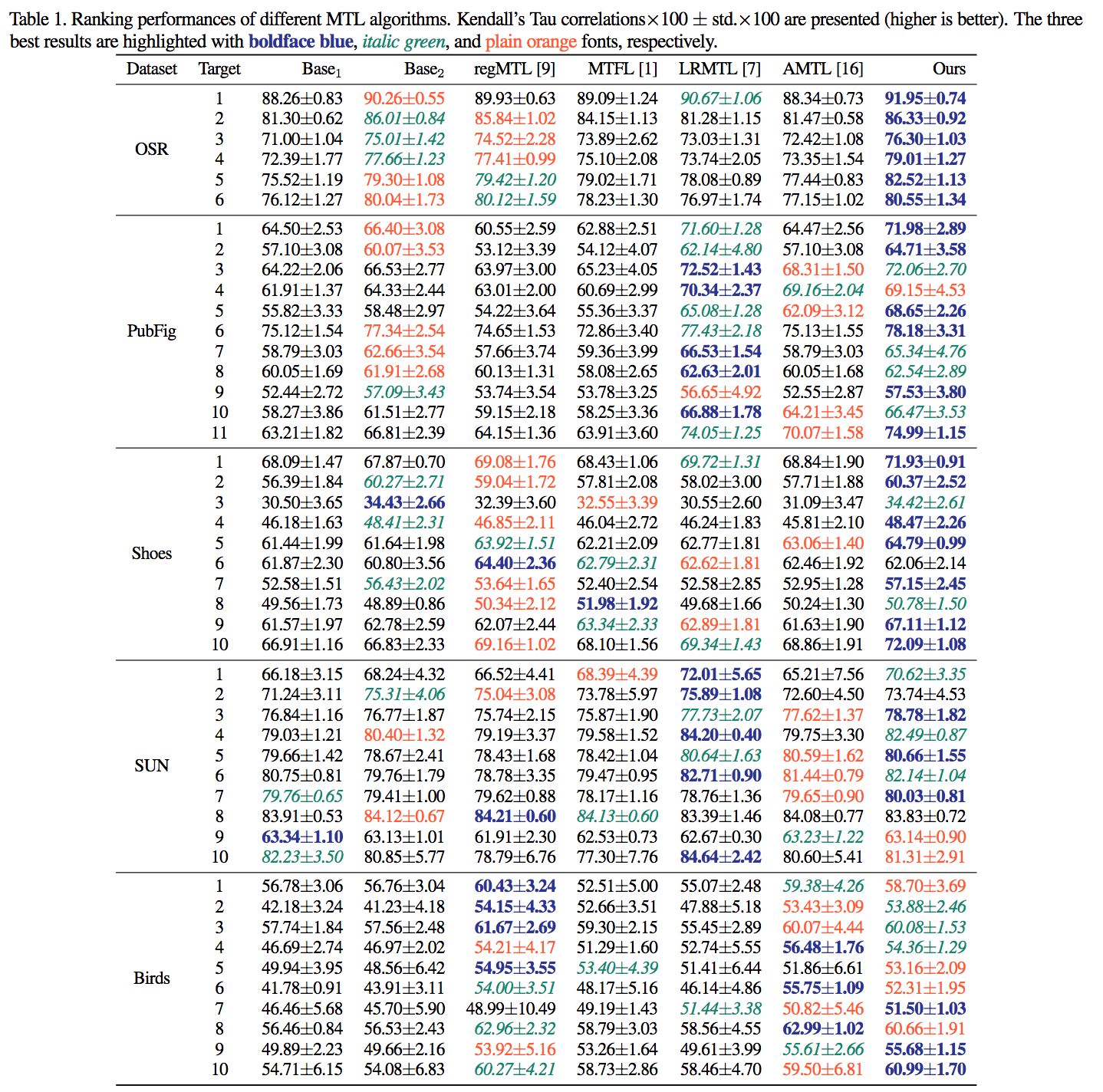

Multi-task Learning(MTL; 多タスク学習)について、例えばCNNとGaussian ProcessといったHeterogeneousな学習や推定を同時に行う新しい方法を提案する。タスクに依存しないランダムパラメータを求めることができるため、あらかじめタスクごとの知識を前提としないMTLを実現可能である。実空間における回帰やランキングの問題において良好な精度を実現可能である。

異なるタスク間(CNNとGaussian Processなど)において事前情報を前提としない学習法を提案した。各種データセットにおいて良好な精度を実現した。(表に示す通りであり、大体においてベースラインよりも精度が高い)

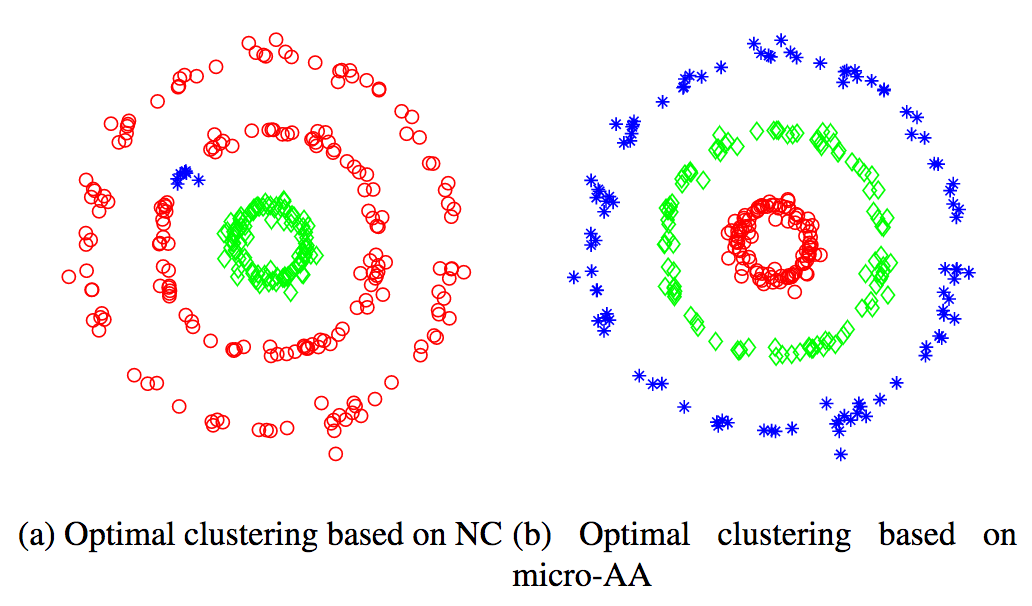

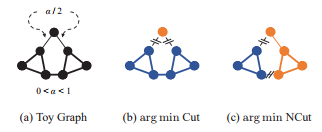

グラフベースのクラスタリングに関して、Micro-averageを用いたコスト関数micro average association(micro-AA)を提案。グラフベースのクラスタリングはSpectral Clusteringが従来法の代表例であり互いに素な分類が望ましいが、所望のクラスタより小さな集合を形成してしまい望ましくない。本論文では初期値にも依存しない局所的最適化解を求めることができる。Direct Local Optimization(DLO)により、近似を行うことなく全体最適化を行う。DLOでは初期値に依存するが、Initial-guess-free algorithmを用いることにより解決。

グラフベースのクラスタリングについて、micro-AAを提案、さらに全体最適化する方法や局所最適解に陥らないような最適化テクニックについても紹介したことが大きな貢献である。COIL20 datasetにて100%のクラスタリングを実現するなど、良好な精度を実現することに成功した。

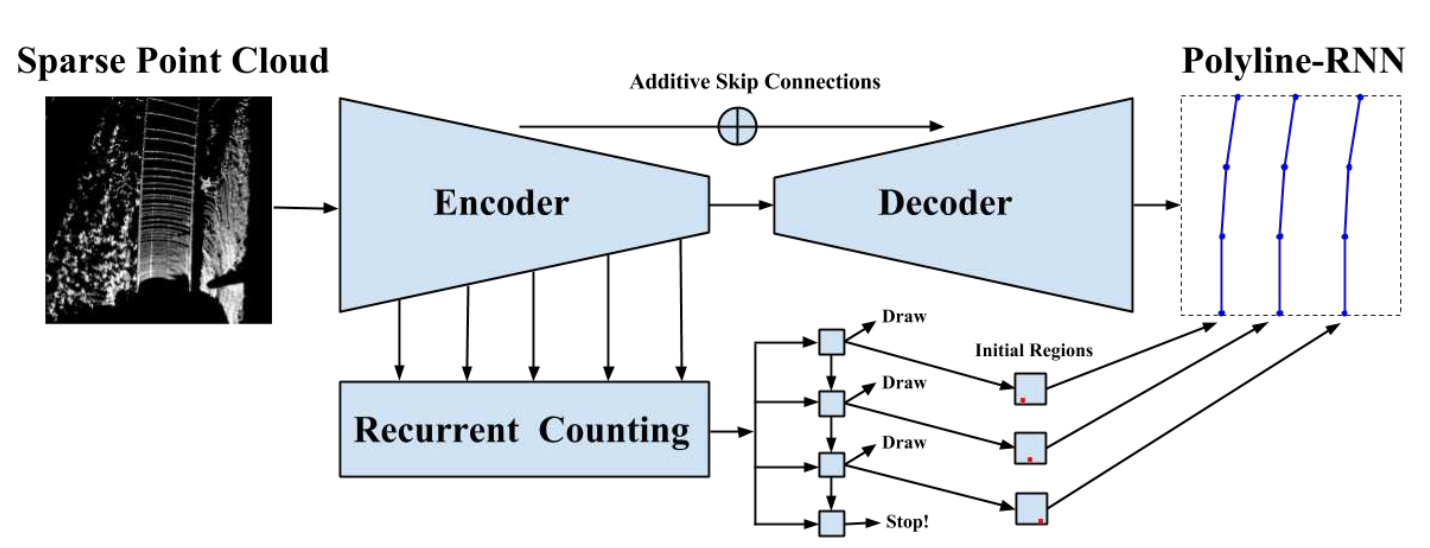

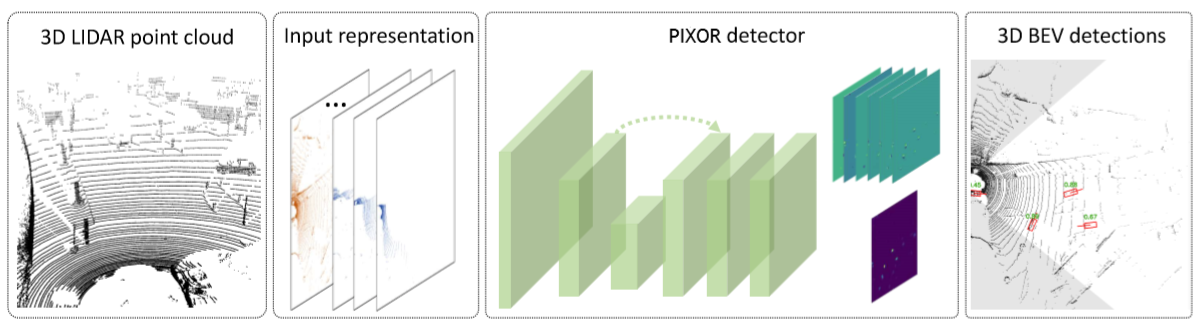

スパースな3次元点群データから道路面(レーン検出レベルで)構造を把握するためのHierarchical Recurrent Attention Networkを提案する。また、3次元点群処理において推定したエッジと正解値の微分可能な誤差関数Polyline Lossも提案する。高速道路にて90km/hで移動する車両から92%の確率でレーン検出を可能にした。右図は提案手法であるHierarchical Recurrent Attention Networkの構造を示したものである。基本的には対称のスキップコネクションを含むEncoder-Decoder方式であるが、Encoderの各層からRecurrent Countingを行う層を追加、Decoderとの整合性をとることで精度を高める。

高速道路を想定した環境でも3次元点群処理を高精度に実行するネットワークHierarchical Recurrent Attention Networkを提案した。入力である点群処理からレーン検出を行うことができる。さらに誤差関数PolylineLossを提案することで点群からの推定値と正解値との誤差を計算することができネットワークを学習可能とした。

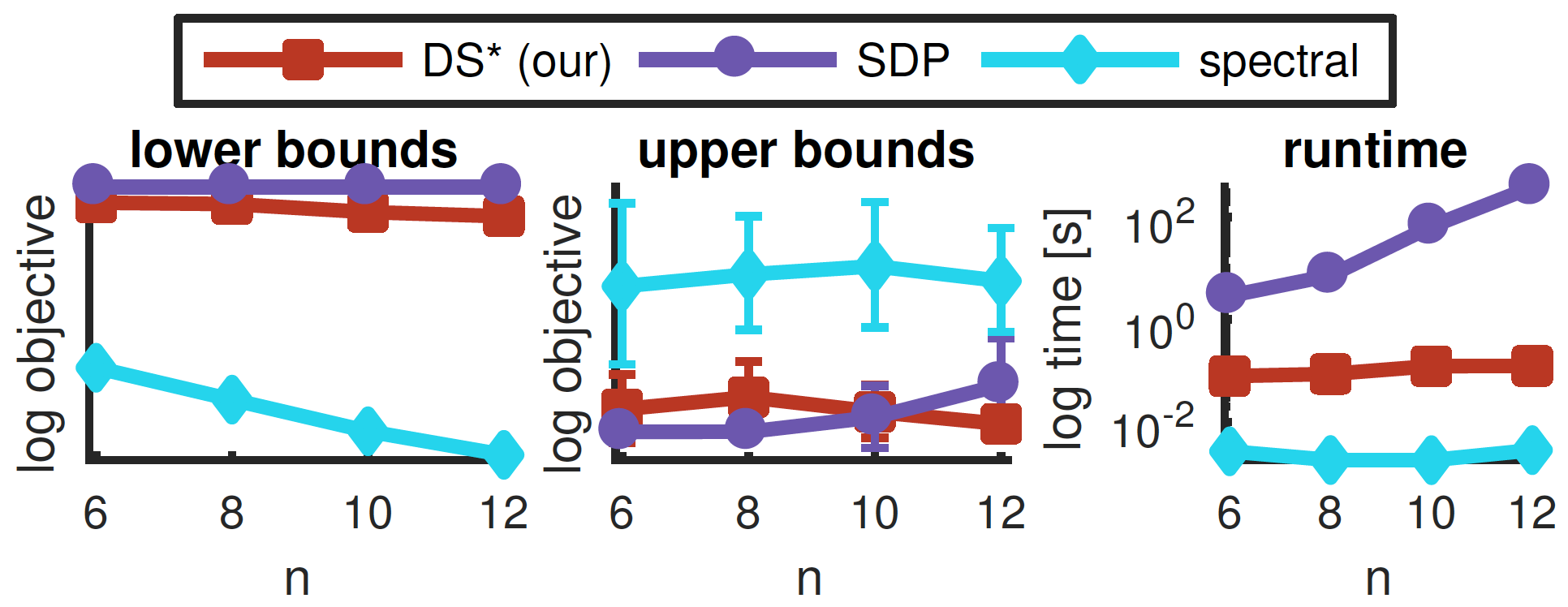

Product Quantization(PQ; 直積量子化)は与えられたデータを低次元に分解できるため、高次元のエンコーディングに対して有効である。本論文ではPQの直交(orthogonal)時について解析するとともに、Spectral Decompositionについても関係性を調べる。本論文の解析によりスペクトル解析に関する知見が得られることや、計算コストについても言及できる。本論文で提案する定式化により、よりシンプルで効率化されたdecomposition手法を与えることができる。

PQの課題においてスペクトル解析と関連することを示した(+定式化)ことが最大の貢献である。各種データセット(Sift25K/1M,Mnist,Cifar,VladLong)にて従来法よりも良好な精度を実現するとともに、効率的な計算ができることも示した。

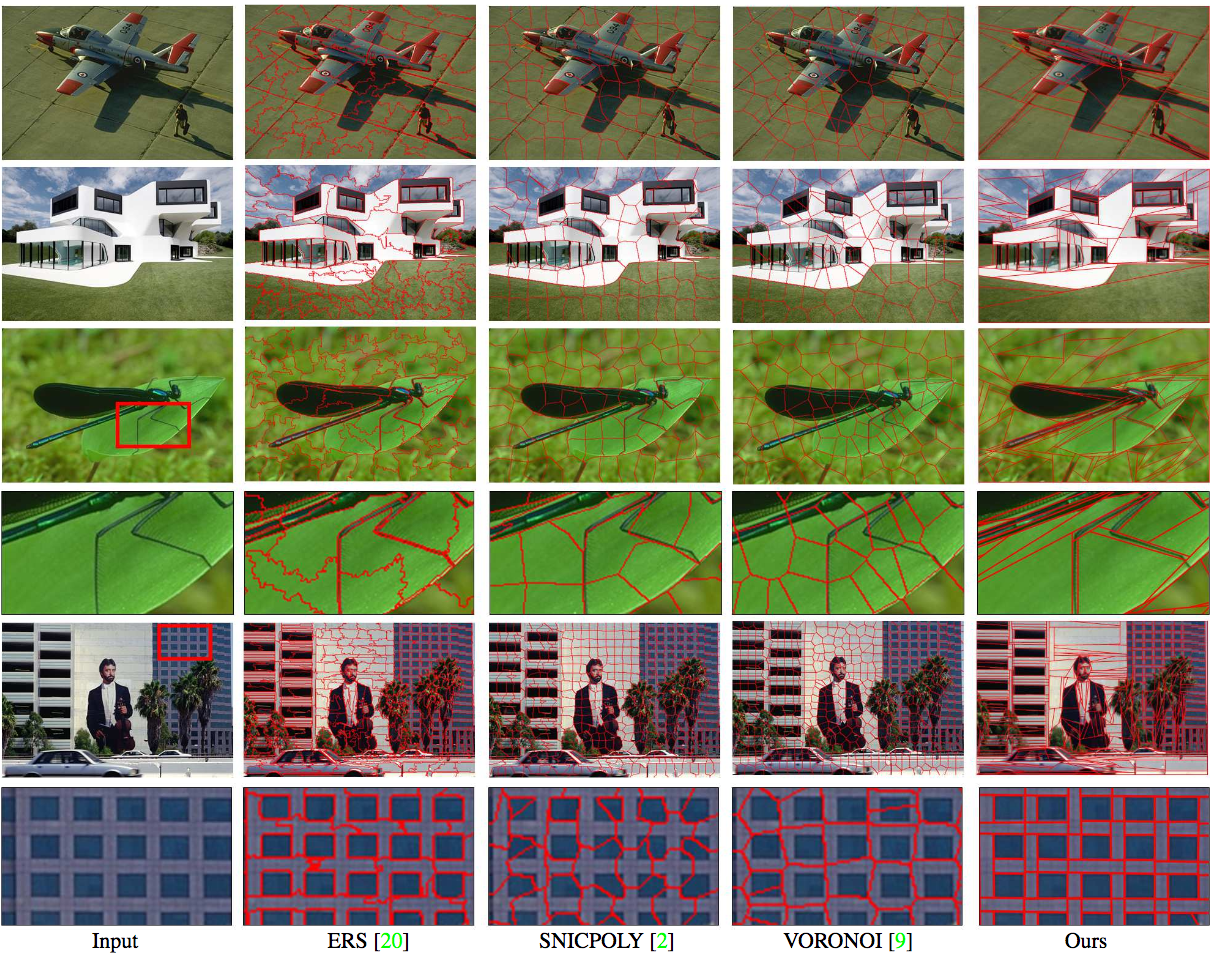

スーパーピクセル(Superpixels)において多角形形状にて画像領域を近似する問題を取り扱う。従来手法(例えばボロノイマップ)では細い形状にて多角形性を失いがちであるが、本論文では克服することに成功し、サイズや形状によらず柔軟な推定が可能である。事前情報として直線のセグメントを計算しておくことで精度が向上することが明らかとなった。実験ではより少ない多角形で幾何学的な特徴を捉えることに成功した。

画像のスーパーピクセル近似にて、多角形により効率化された計算を可能にした。事前情報として直線検出と組み合わせることにより画像中の情報をよりよく捉えることができる。

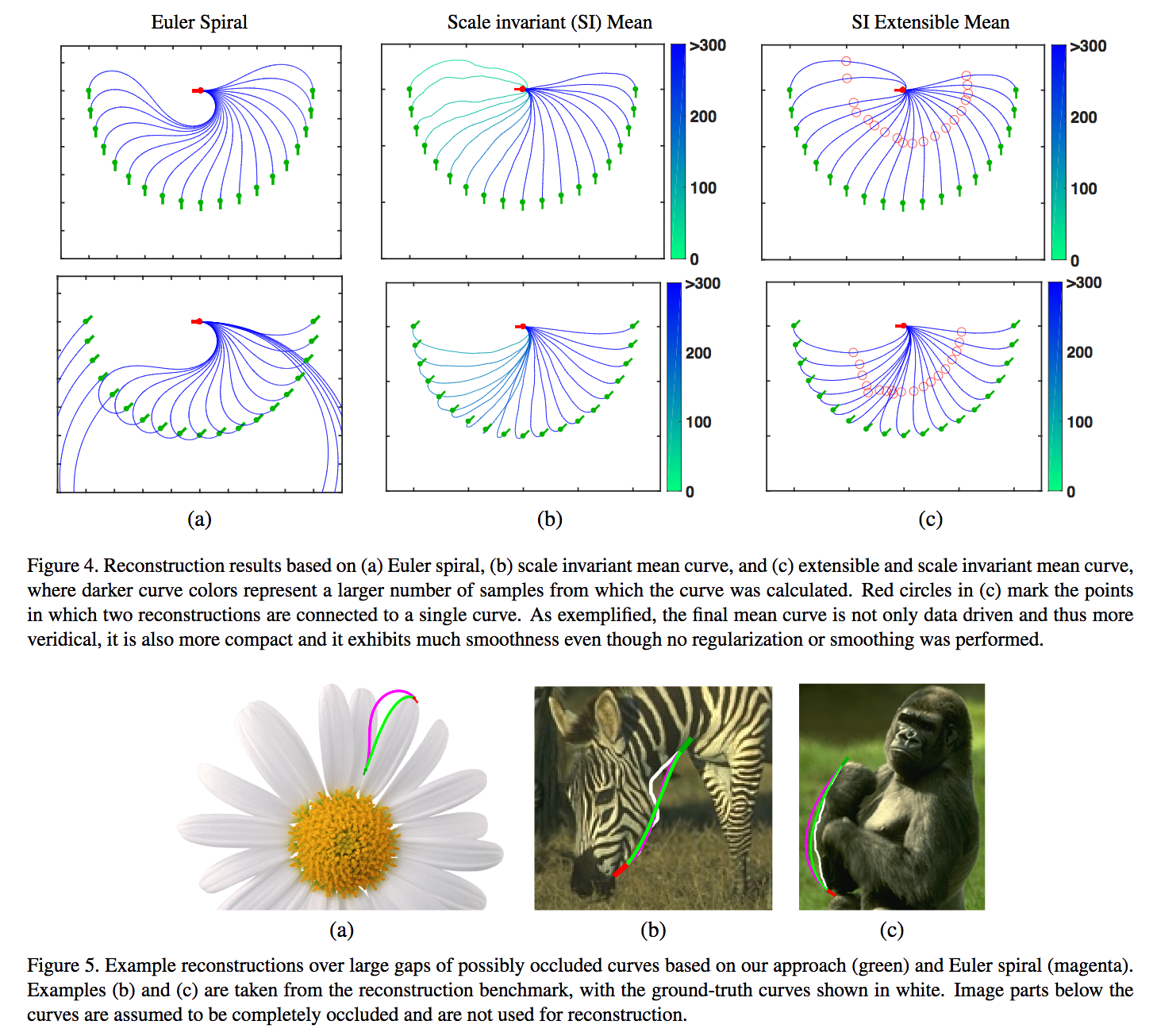

自然の中に存在するカーブ(Natural Curves)を想定、認識することで欠損やオクルージョン環境下の補完/インペインティングを実行。与えられた画像中の物体から2つのエンドポイント(End Point)とタンジェント角度(Tangent Orientation)をラベルづけ、推定したカーブの平均値により補完を実行する。

自然のカーブを想定することでオクルージョンや欠損を含んでいたとしても補完をやりやすくした。基本的には2点のエンドポイントをタンジェント角で繋ぐことでカーブを認識し、背景には様々な角度表現やデータを配置している。

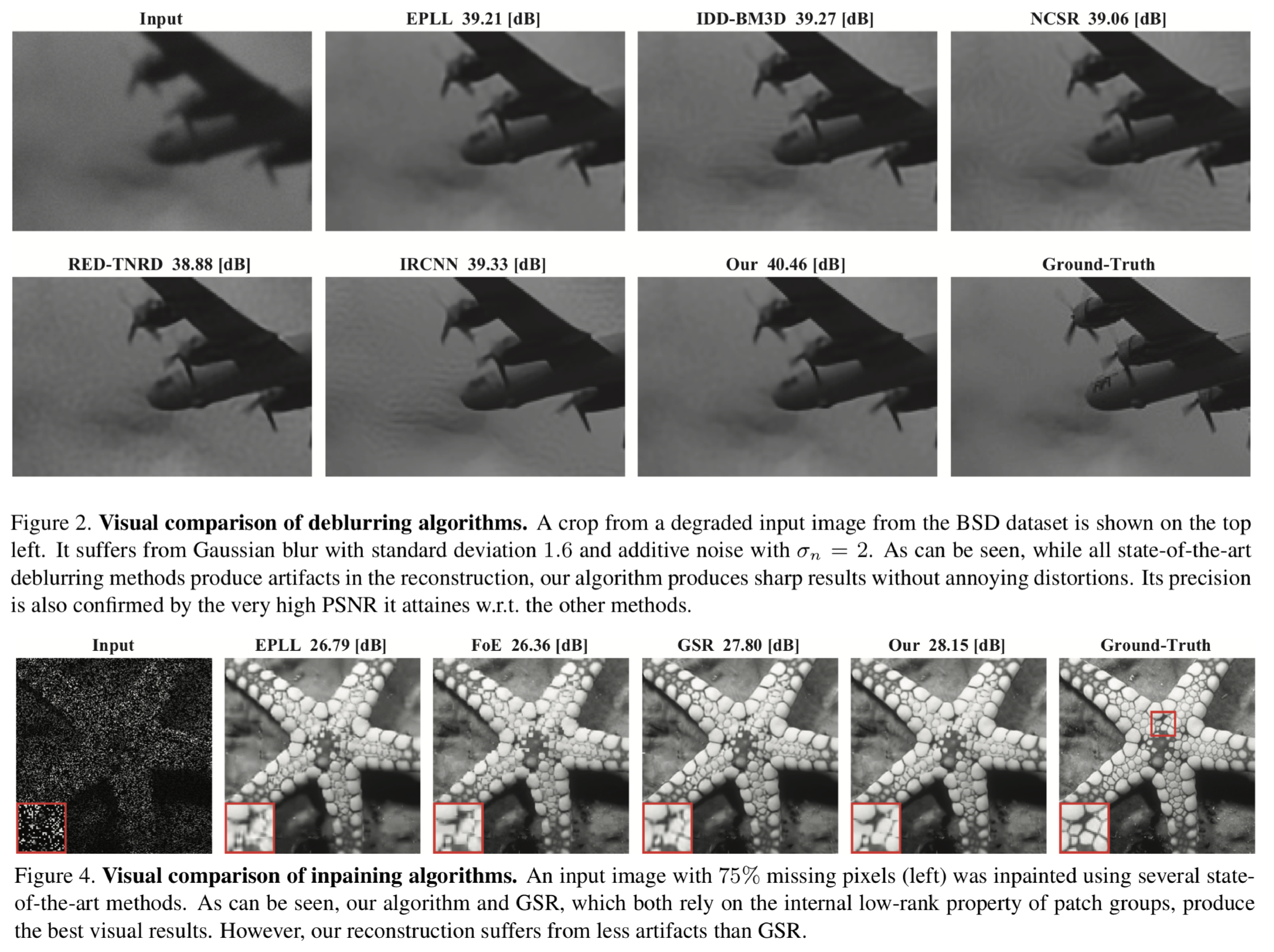

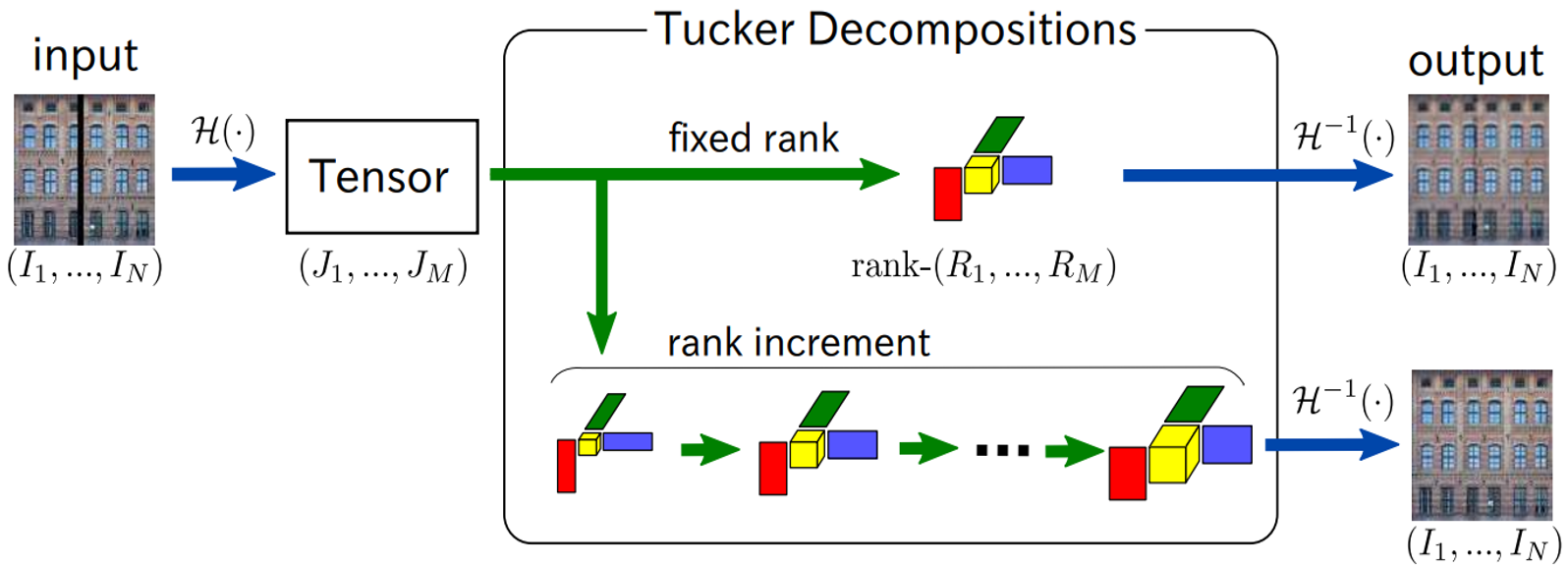

低階数の信号モデリングは、画像処理アプリケーションにおける非局所相関をキャプチャーするために広く利用されてきた。グループ化された画像パッチによって生成された多次元配列に対して低階数の多次元配列因子分析を用いる新しい手法を提案する.低階数多次元配列は、画像再構築をさらに改善するために,代替方向乗算法(ADMM)に送られる.動作アプリケーションは圧縮センシング(CS)であり,深い畳み込みアーキテクチャが採用され,CSアプリケーションにおける高級なマトリックス反転を近似する.NLR-TFAと呼ばれるこの低階数多次元配列の因数分解法に基づく反復アルゴリズムが詳しく示される.ノイズのないものとノイズのあるCS測定の実験結果は、特に低CSサンプリングレートでの提案手法の優位性を証明する.

パッチグループ化に基づいて推定画像から多次元配列を生成する.次に多次元配列を分解後に多次元配列を低階数に設定する. この新しい低階数多次元配列は,ADMMによって解決されるグローバルな目的関数に送られる. これらの2つのステップは,何らかの基準を満たすまで繰り返し実行される.

本稿では、双方向検索モデルを学習するための非常に簡単で効果的な文字レベルのアーキテクチャを示す.マルチモーダルコンテンツを整列させることは、画像と記述との間の意味的対応を見つけることの難易度を考慮すると特に挑戦的である.そこで実際の文字を明確な粒度レベルで畳み込むことによって、テキストセマンティック埋め込みを学ぶために設計された効率的な文字レベルのソースモジュールを示す.私たちのアプローチで生成されたモデルは、単語埋め込みに基づく最先端の戦略よりもはるかに入力ノイズに対して堅牢である. 概念的にもかかわらずはるかに単純であり,より少ないパラメータしか必要としない.テキスト分類,特に多言語およびノイズが多い分野での堅実なパフォーマンスを示す.

CHAIN-VSEという生の文字に基づいてテキスト埋め込みを学習できる双方向検索のためのシンプルなアーキテクチャによって,概念的には関連研究よりもはるかに単純なアーキテクチャであってもMS COCOなどを考慮して,テキストからイメージへとテキストからテキストへの両方で最先端の結果が得られる.

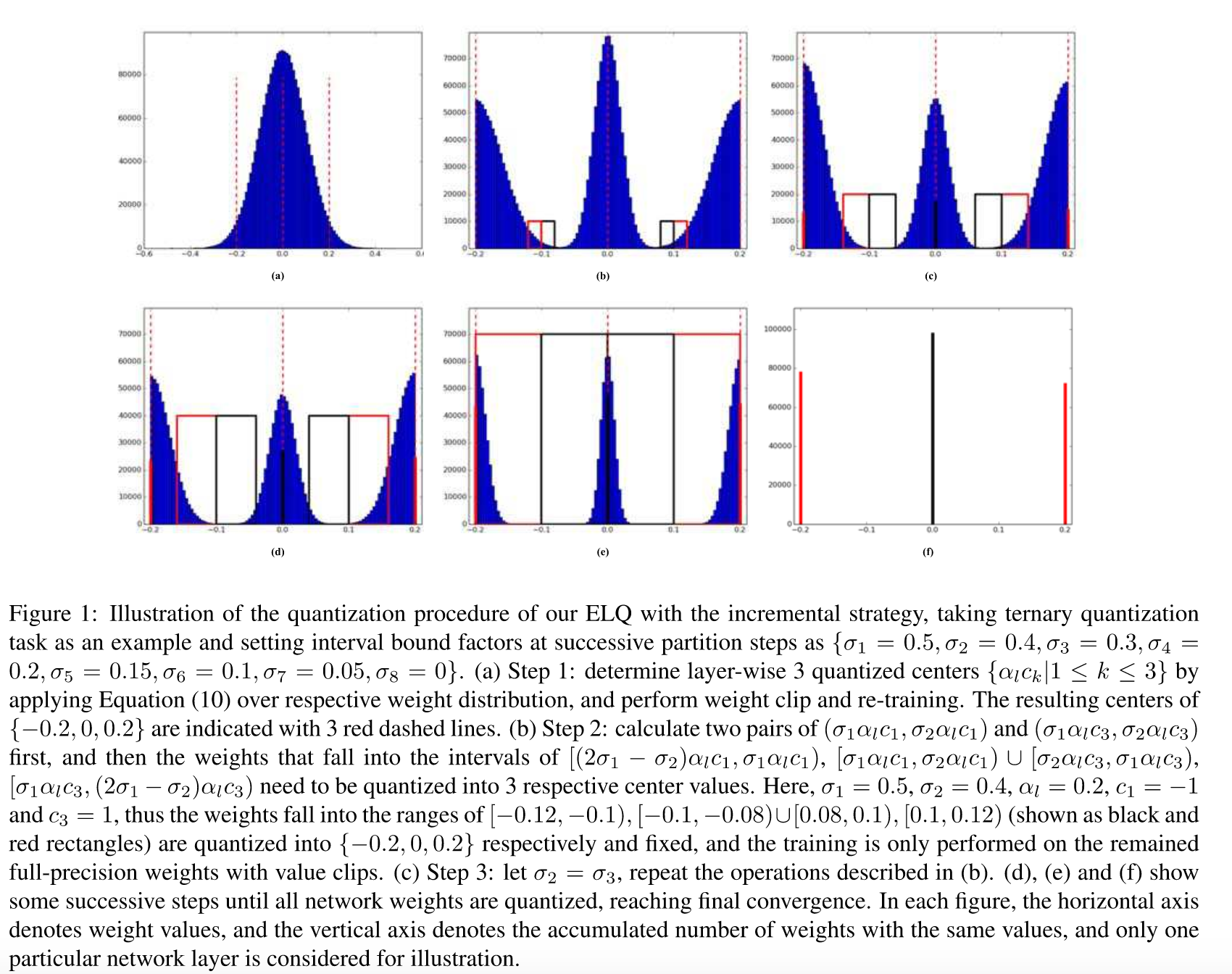

3値や2値などの非常に低ビットのパラメータ値を持つDNNモデルを顕著な損失なく32ビットの浮動小数点数に近似させる新しい方法であるELLS(Explicit Loss-Error-Aware Quantization)を提案

Imagenetでの実験では量子化を行ったことによる精度の低下の少なさでstate-of-the-art

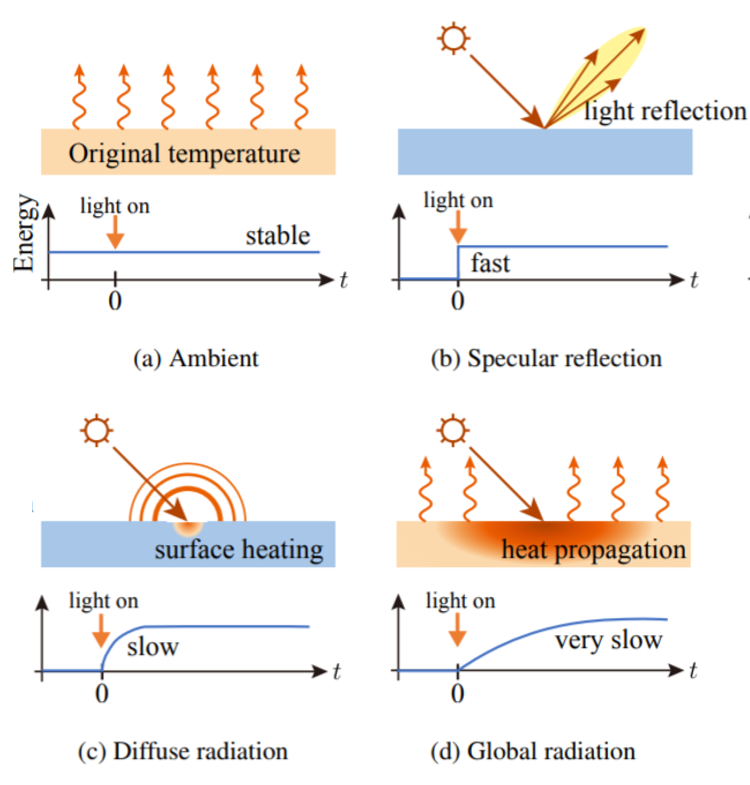

熱画像における経時変化の光伝送分解手法を提案.熱の伝播の速さは光よりも非常に遅く,遠赤外光の過渡遷移がサーマルカメラで観測可能である. 近似的ににコントロールされた環境における可視光画像と似ているため, 従来のCV技術をストレートフォワードに熱画像に適用できるのが肝.

熱画像における散乱光成分は分離可能で,したがって物体の表面の法線を推定可能である.

熱画像を用いれば,黒色,透明,半透明物体に適用可能である.

可視光と熱の伝播モデルの差を考慮したCV技術転用のモデル化方法を与えている.また,遠赤外光の伝播特性の差異を用いた手法は新しい.

熱変化は実際経時変化が人間にも認識できるレベルの速さなのが特徴的で,研究には実際専用の知見が必要そう. 適用可能かどうかは実際やってみないと分からないところが多いと思う.頑張ってほしい.

可視光以外を使っている研究の「黒色,透明,半透明OK」は実際キラーワード.

デジタルカメラで実行される重要な操作の1つに、センサ固有の色空間を標準の知覚色空間にマッピングすることがある.この手順は、ホワイトバランス補正の後に色空間変換を適用することを含む。 この比色マッピングの現在のアプローチは、2つの決まった照度(すなわち,2つのホワイトバランス設定)について計算された事前にキャリブレーションされた色空間変換の補間に基づく. 異なる照度の下で取り込まれた画像は,この補間処理の使用により,色の再現精度が低下する. 本稿では,現在の比色マッピング手法の限界について議論し,色再現精度を向上させる2つの手法を提案する.7つの異なったカメラでアプローチを評価し,色再現誤差の点で最大30%(DSLRカメラ)と59%(携帯電話カメラ)改善した.

比色マッピング手順を改善する2つの方法として,1つ目は,補間方法における追加のキャリブレーションされた照度を含む補間方法の単純な拡張を行う. 2つ目は、フルカラー補正マトリクスに依存した,すべての入力画像に対して固定CSTマトリクスを使用する方法である.

学習ベースのサブピクセルリファインメント手法Linear Predictiorsにおいて,効率的な計算方法を提案. テンプレート画像をワープさせて誤差が小さくなるようにワープパラメータを最適化するやり方について扱う.

新手法Symbolic Linear Predictorsにより,学習ステップの効率化を実現.一度計算すると複数回異なる画像パッチに対し使いまわせる. これにより,性能を落とさずにオンラインで実行可能に.SLAMなどで使えるようになる.学習ベース手法の実行時効率性のの恩恵がうけられる. また,推測可能な誤差尺度を提案.推測することで,テンプレートの位置合わせ時の誤差を小さくすることができるようになる. 従来手法によれば何百も存在するキーポイントにおいて評価が必要であったが, これにより最良のキーポイント達だけ使えばよくなる.

![]()

SLAM等における有用な手法をアプリケーションレベルに効率化した.

Subpixel Refinementが共通認識のように語られているが,まとめ人的には画像上の位置合わせにおけるサブピクセル精度での精整のことだと気づくのに結構時間かかった.勉強不足だろうか.

コントリビューションの明示的主張のない,CVPRでは珍しい論文.

カメラレディ原稿のフォーマットの不備がある.校正頑張ってほしい.

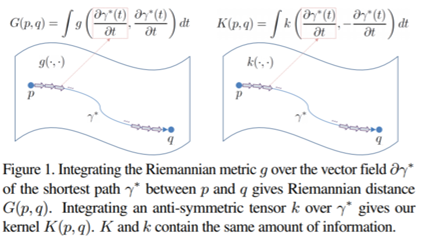

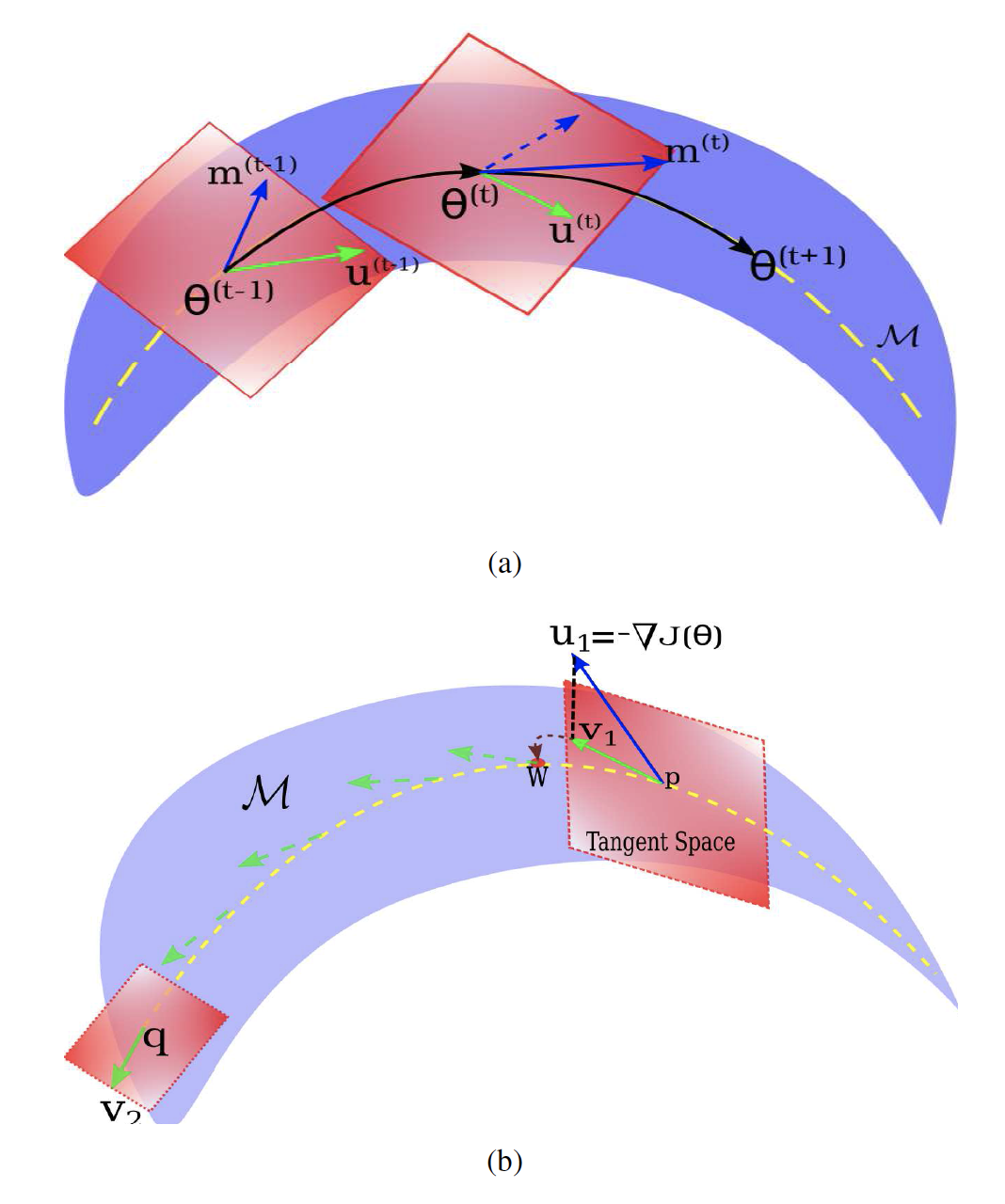

世の中のデータはマニフォールド上にある事が多いので,ユークリッド空間のような環境空間ではなく,データの表すマニフォールド幾何を考え, その正規化によって学習できると性能を向上できる. 実際,マニフォールド幾何はテンソルで扱えるのだが, 既存手法ではテンソルの学習における微分可能なマニフォールド幾何の正規化ができていない.

本稿では,テンソルの正規化・学習ができるように,リーマン多様体上での学習を考え, サロゲート(代理)目的関数を導入. テンソルが表す幾何特徴をカプセル化する. これにより,非対称かつ高次テンソルの学習ができるようになる.

多様体におけるテンソルの学習ができるようにした.実際やってみたら予想通り学習もうまくいった.

マニフォールド(多様体)局所的にはユークリッド空間とみなせるような空間.地球は丸いけど住民にとっては平面.

リーマン多様体(超粗く言うと)隣は次どっちにどれだけ離れてるかという情報が定義されている多様体.多様体の基本の表し方の一つ.

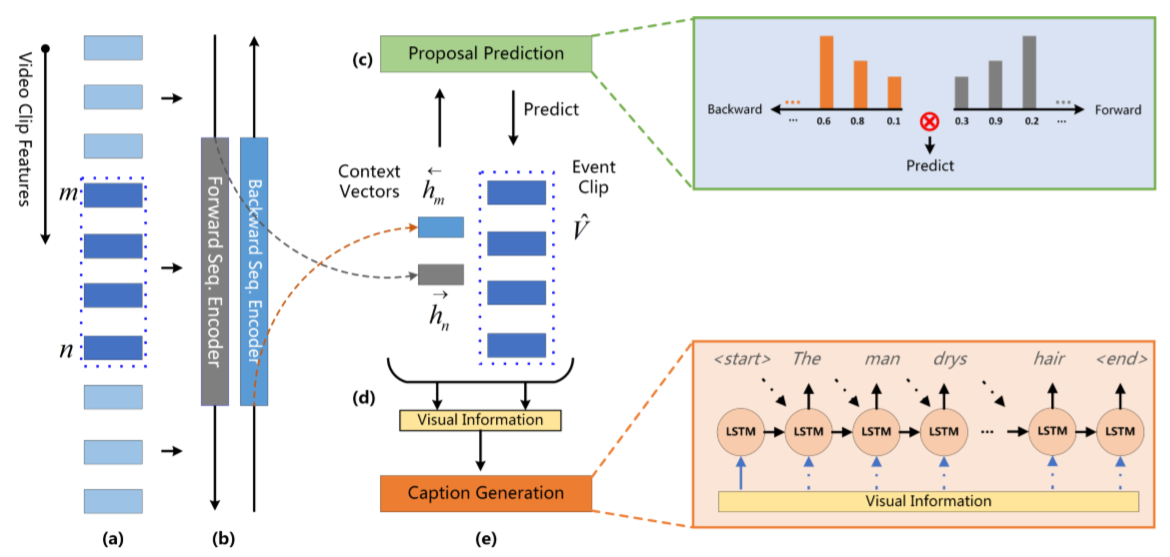

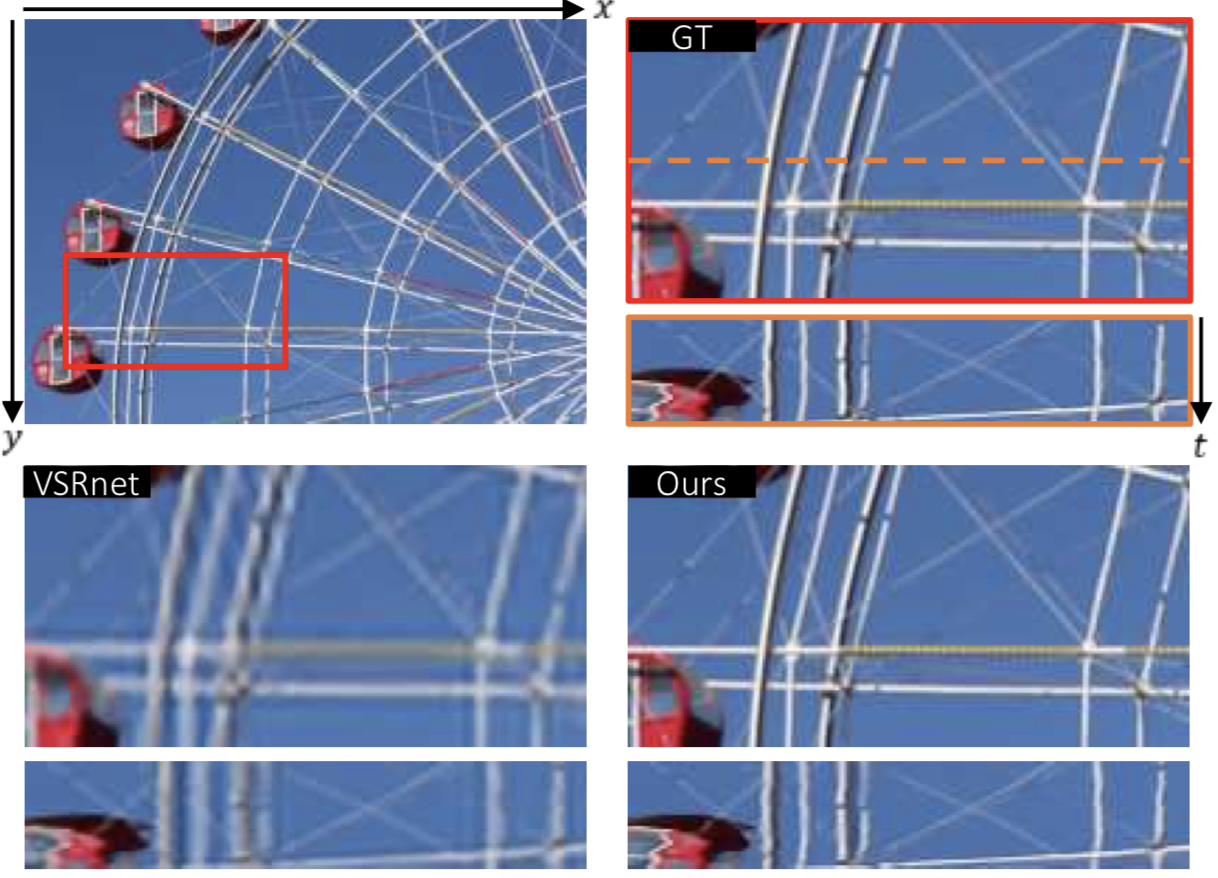

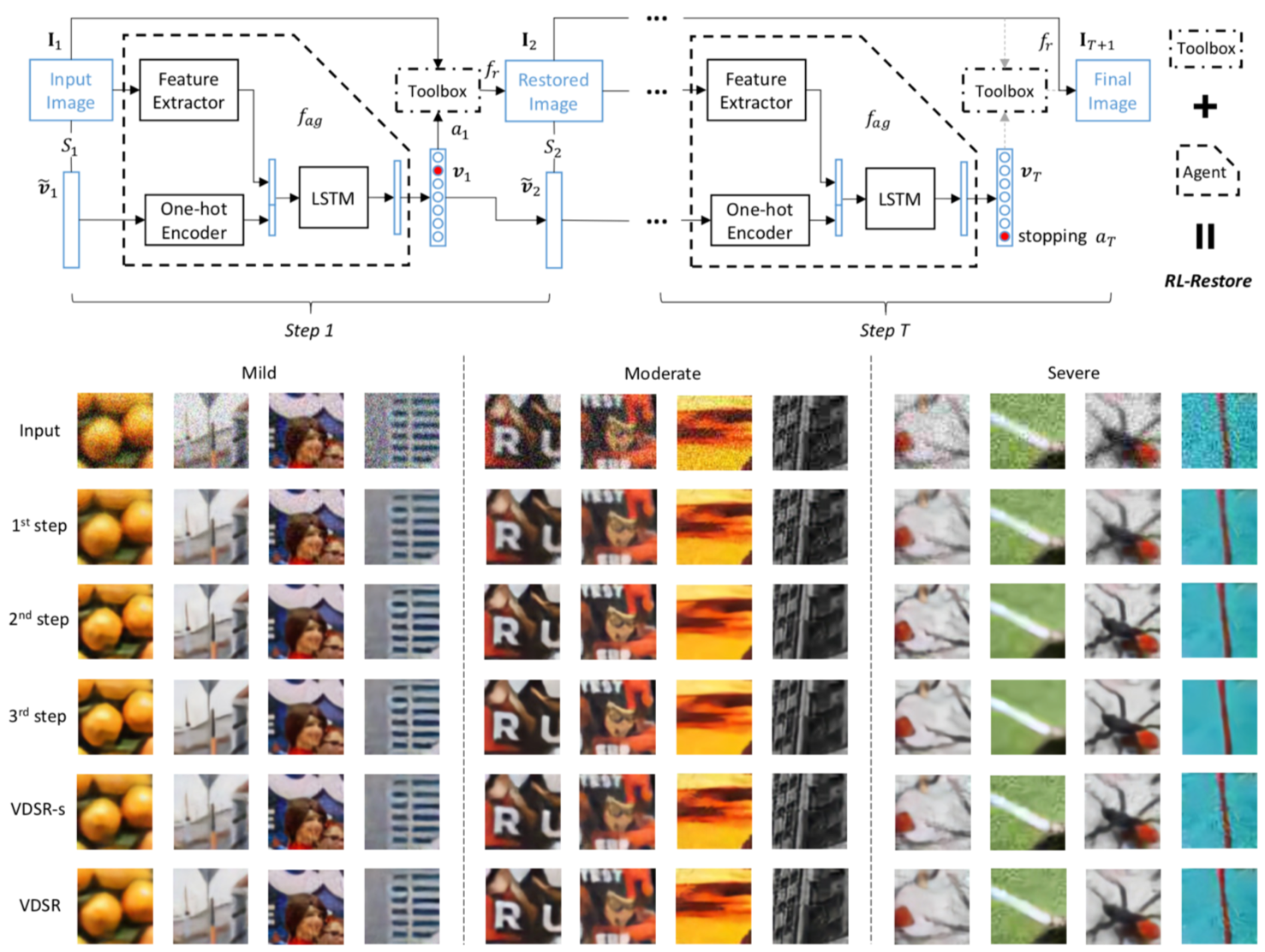

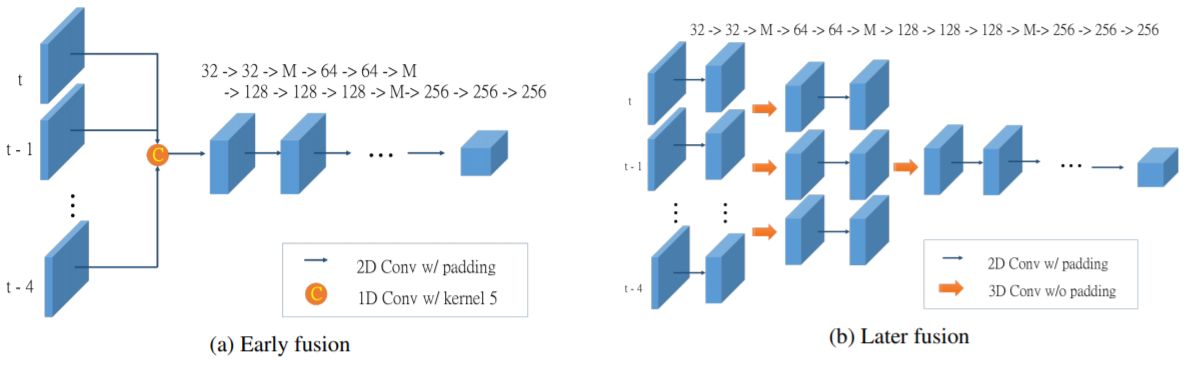

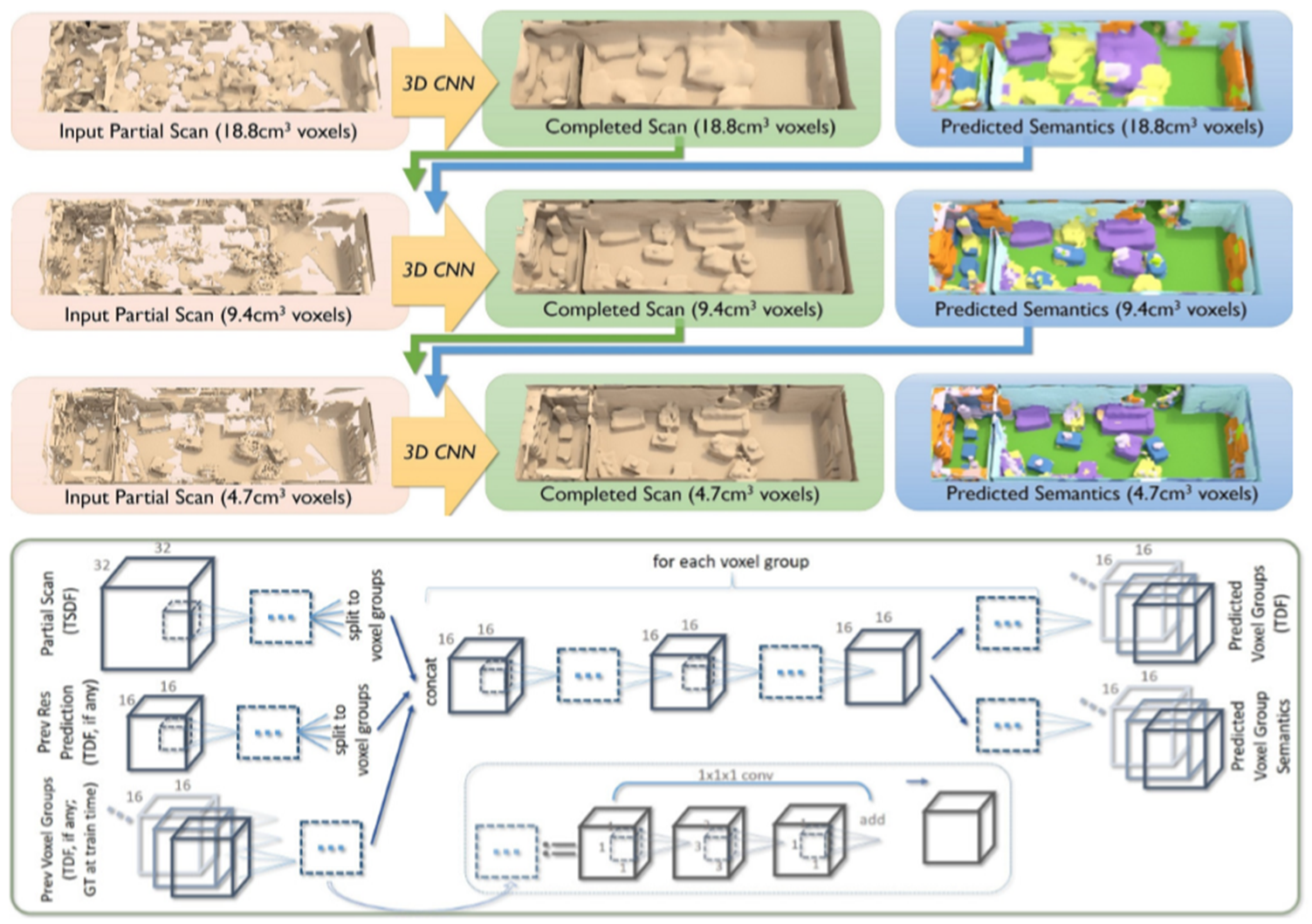

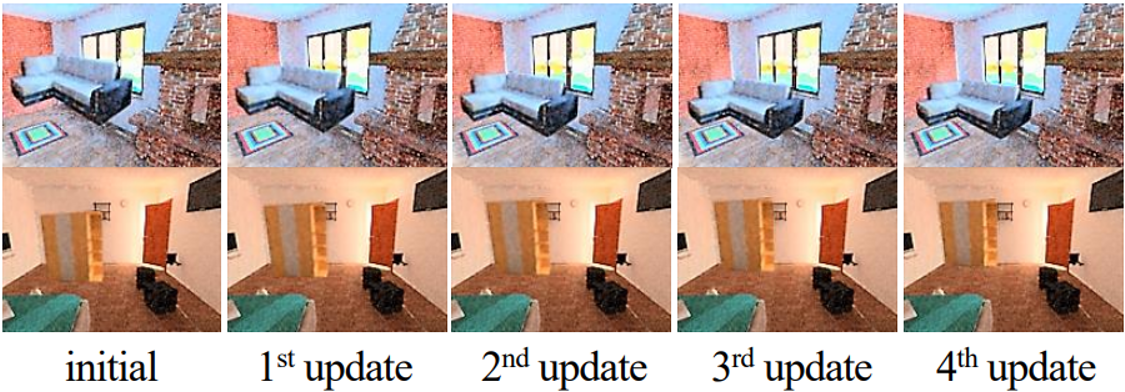

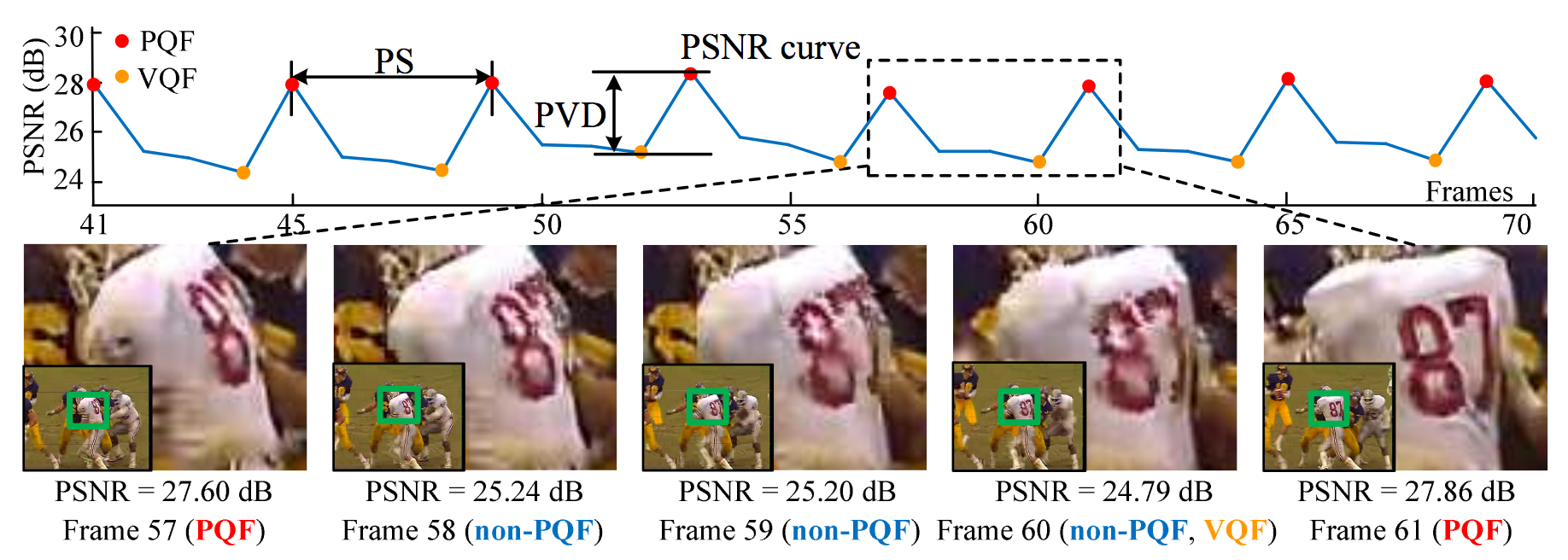

既存の動画超解像方法とは根本的に異なるフレームワークとして,動的にアップサンプリングフィルタや残差画像を生成するディープニューラルネットワークを新たに提案する.このアプローチにより,入力画像から直接高解像度画像を得ることができる.新しいデータオーギュメンテーション方法と大量の学習動画を用いることにより,SOTAなパフォーマンスを達成.

図に示すように,提案手法はSOTA手法の一つであるVSRnetと比較して,チラツキが減少していることがわかる.さらにバイキュービック法やVSRnet,VESPCN等と比較し提案手法は,PSNR,SSIMの両方においても優れていることがわかった.

バイオメディカルアプリケーションにおいて,人間の血液中の細胞を検出,測定,分類は重要である.しかし,広範囲に及ぶ細胞の変動や画像を使用した診断にも解像度の限界があるため非常に難しいタスクとなっている.そこで本稿では,ホログラフィックイメージにおける白血球の検出,測定,分類に新たな手法を提案した.具体的には細胞集合の確率生成モデルをベースとしている.それぞれのクラスのテンプレートは血液の細胞についての静的な分布情報から作られる. 分布についてのパラメータは,患者から得た血液の情報(実際に数えた結果?),セルテンプレートは辞書形学習を拡張させたものを使ってセル分類のクラスから得たセルの画像で学習している.

実際に20の正常な血液サンプルと12の正常でない血液サンプルを使って実験しており,従来手法ではエラーが30%ほどに対し,提案手法ではを6.8%以下に抑えた.

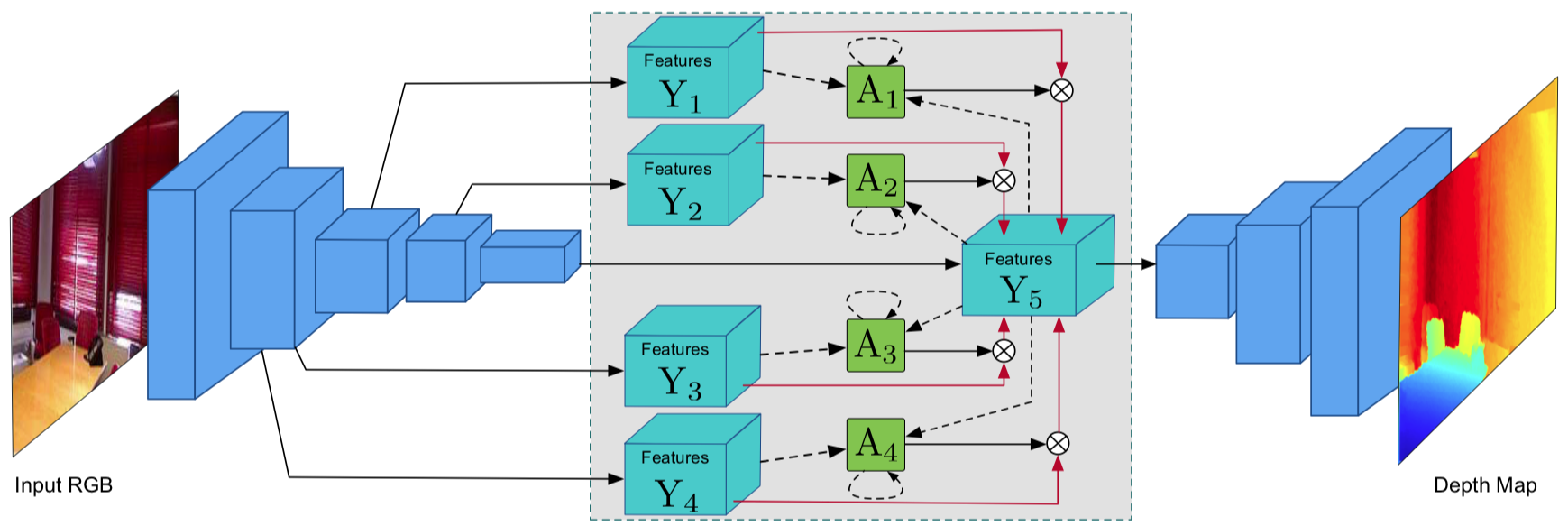

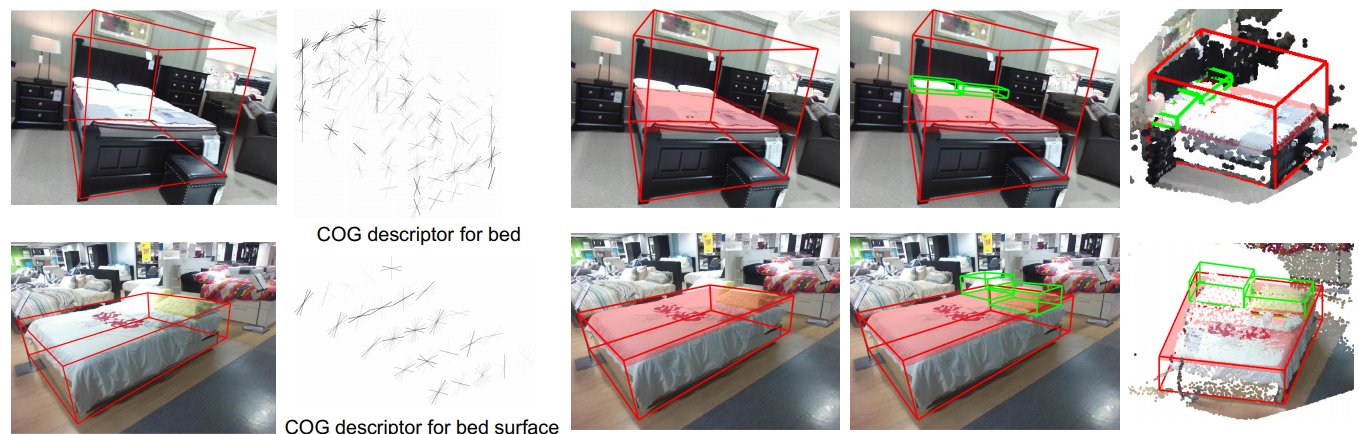

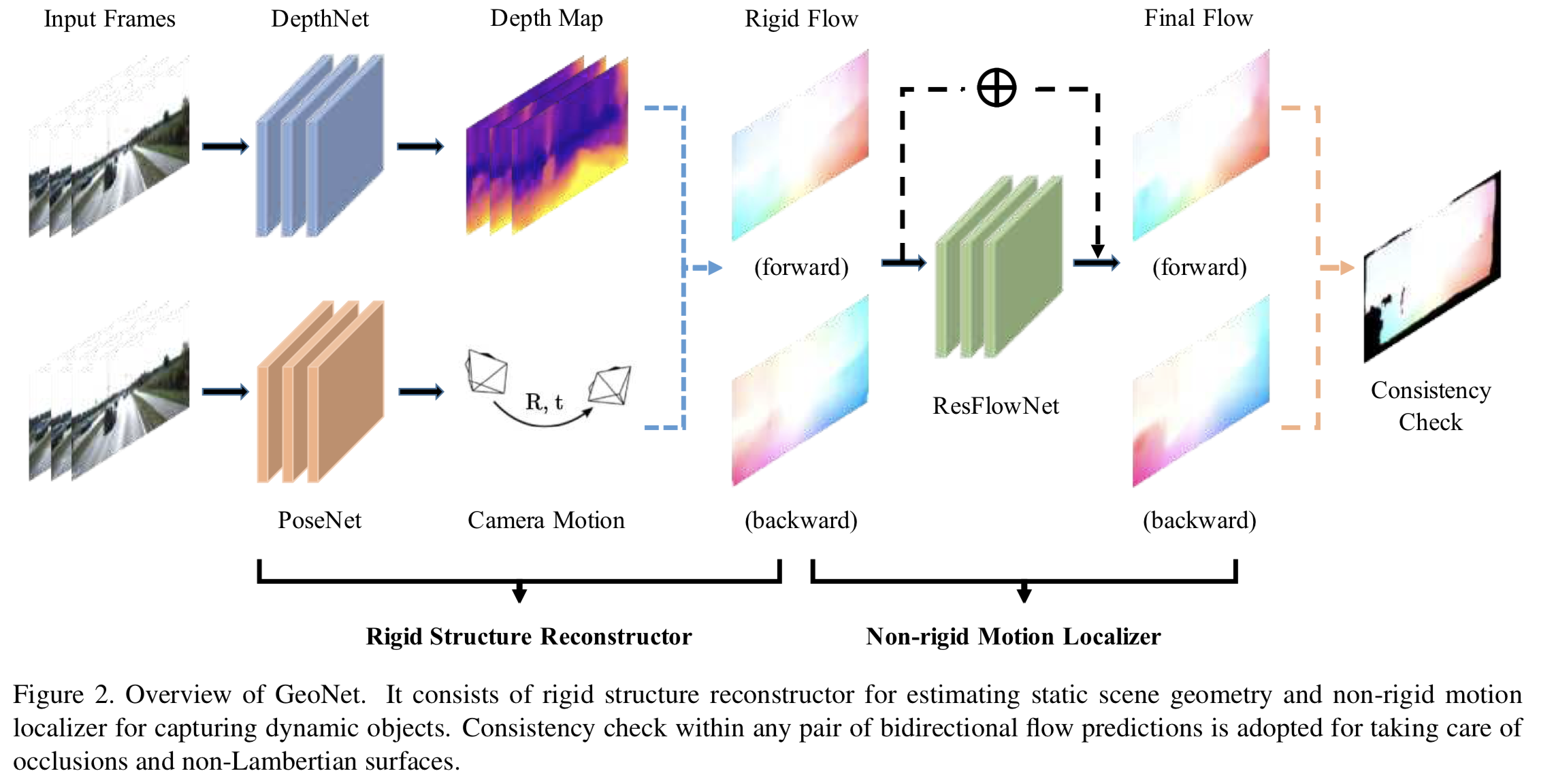

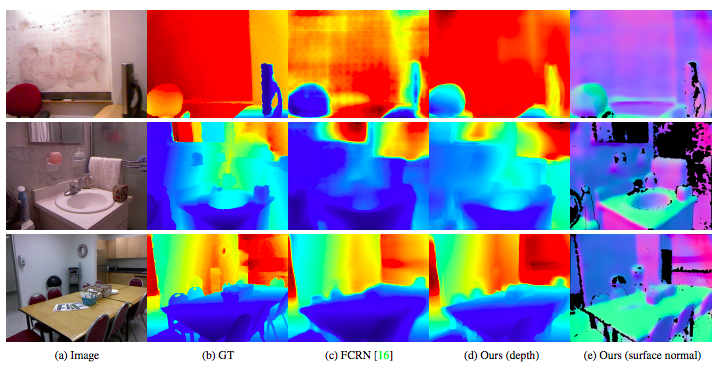

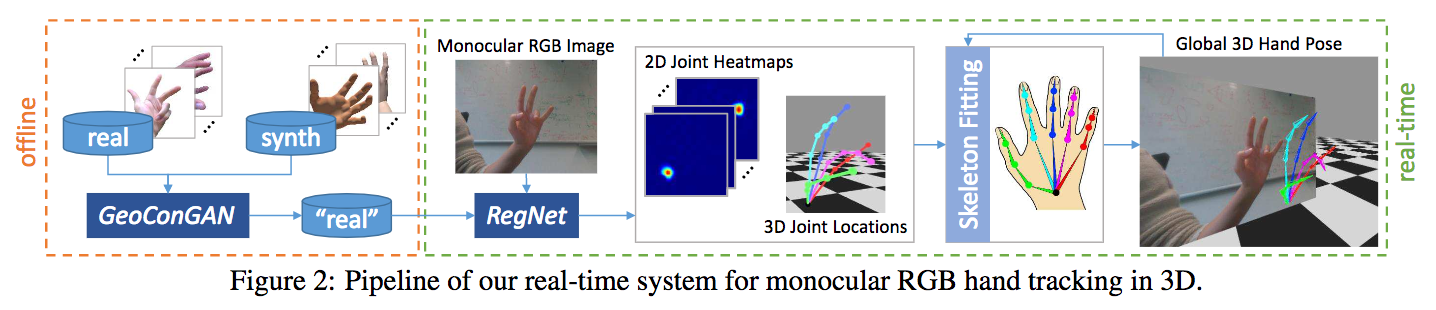

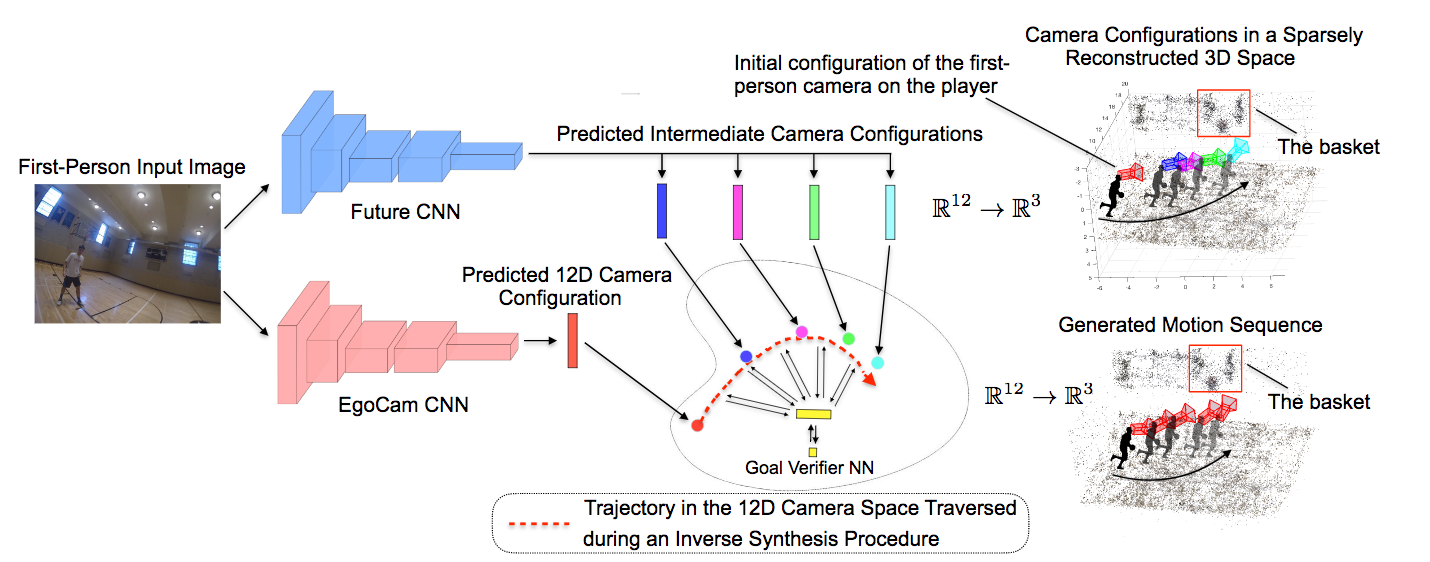

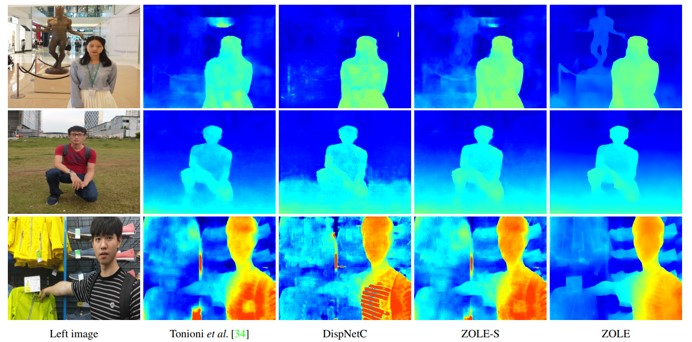

眼カメラで撮影した動画をデプス推定する論文.従来のデプス推定では,CNN姿勢予測器を用いてデプス予測を行っているが,従来までの手法だけでは単眼カメラで撮影した動画のデプス予測に最適な手法ではない.そこで本稿ではDirect Visual Odometryを改良したDDVO,Pose-CNN,DDVO+Pose-CNNの3つの手法を用いて姿勢予測し,さらにデプスを教師なし学習で推定する手法を提案している. 構造としては一度の入力に3つの連続した画像 I1,I2,I3を使用する.それらの入力からまずI1,I3からデプスの逆数の値を取ったinverse depth mapと,すべての画像の姿勢推定を行い,I2とそれ以外の画像の姿勢の関係性を推定する.そしてI2とI1,I3とのwarped imageの相違性を比較しロスを求め評価する.

実験の評価方法としてKITTIデータセットを使用しており,従来手法と比較し,単眼カメラで撮影した動画でありながら,提案手法のPose-CNN+DDVOを使用したものが最も高い評価値である.

モバイルカメラなどで実際に撮影したレシートや文章などの歪んだ画像をフラットな画像に修正するネットワークを考案.手法としてはセマンティックセグメンテーションに似ており,画素単位で判別していく. ネットワークアーキテクチャとしては2組のU-Netを用いて実現している. 1つ目のU-netでは逆畳み込み層部分を分割して,特徴マップを抽出したものとフォワードマップy1を出力する. これらを合成して2つ目のU-netの入力にする.2つ目のU-netではフラットな画像に修正した画像1枚を出力する. この処理をLossが小さくなるまで繰り返し行う. 評価方法としては実際にモバイルカメラを用いて論文などのプリントを撮影した画像とそのプリントをスキャンしてGround truthにしたものを90Kほど用いてトレーニングを行っている.

折れ曲がっている部位や極度に撮影の仕方が悪いものは歪んでしまっているが,それでも文字が読み取れるレベルまで画像が修正できている.

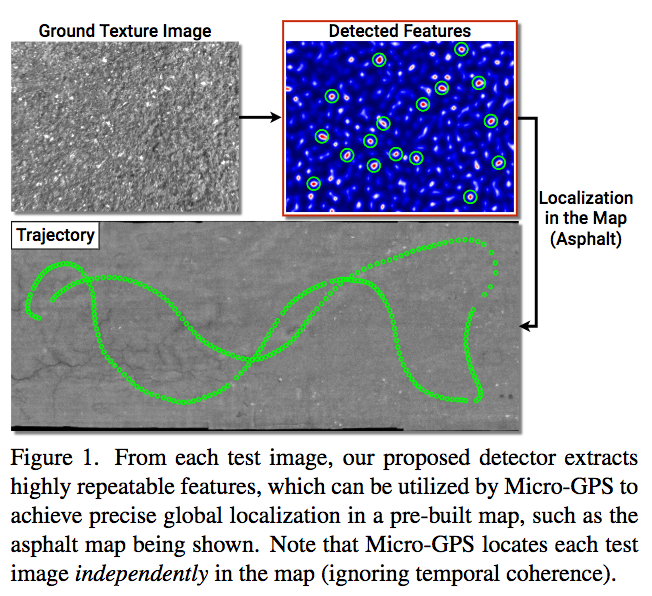

地形認識はロボット分野や自動運転に対し重要な処理である.しかしテクスチャを使った地形認識では,例えば"grass"と"leaves"は似ているために間違った認識がされることがある. そこで地形認識のためのDeep Encoding Pooling Network (DEP)を提案した. 事前に学習したCNNを特徴抽出器として利用し,CNNからの出力をtexture encoding layerとglobal average pooling layerに送る. texture encoding layerではテクスチャのdetailを持ちつつ,global average pooling layerが持っていたローカル空間情報を出力する. 30000枚以上の画像を40クラスに分類したGTOSデータセットで学習し,よりリアルな条件下で評価するために,テストデータには携帯のビデオで撮影した81個のビデオをasphaltやsandなどの31クラスに分類したGTOS-mobileデータセットを作成した. ネットワークの評価はGTOS-mobileだけでなくMINCやDTDも使用し評価している.

ランダムに10000枚の画像を選び,ResNetや著者たちの従来手法であるDeep TENと提案手法で識別させ比較すると,提案手法がもっとも分類がうまくいっている.

実際にテストデータにGTOS-mobileを使用した結果も,ResNetやDeepTENより2~5%ほど精度が向上している.

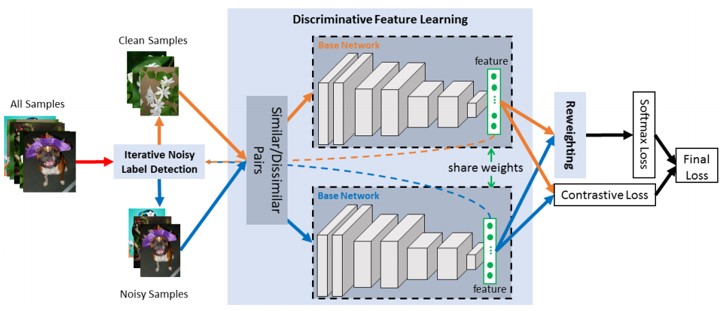

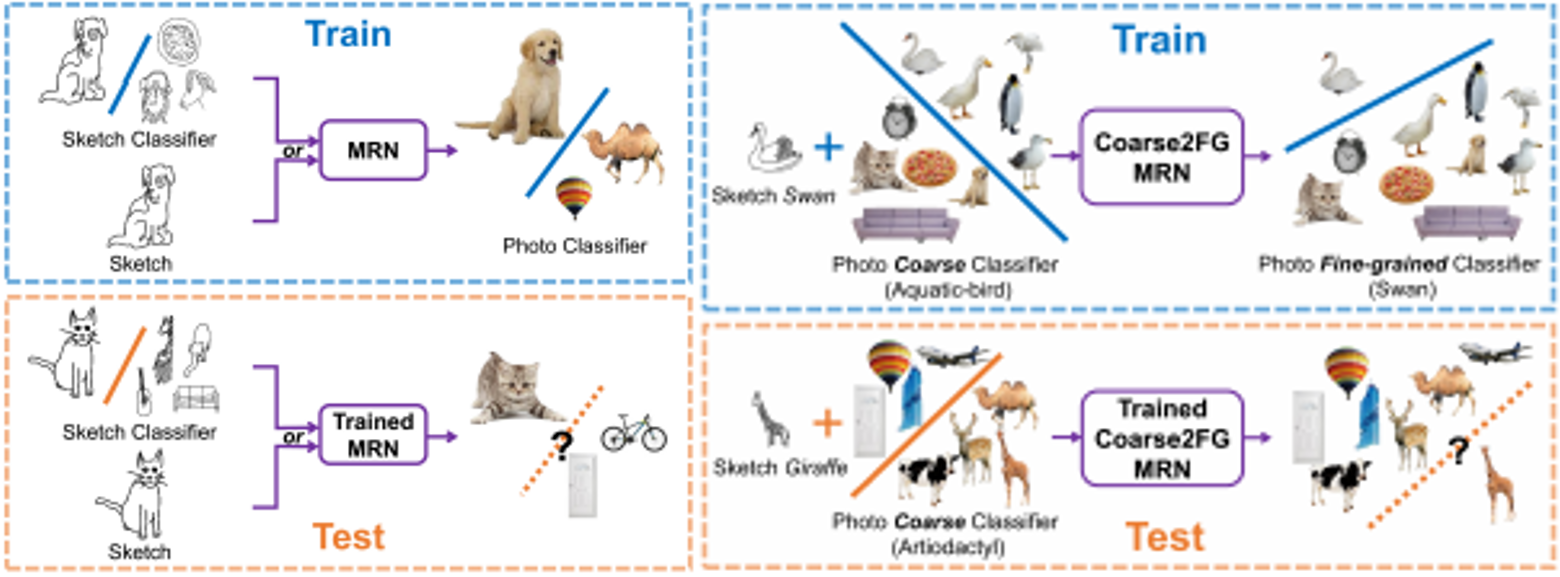

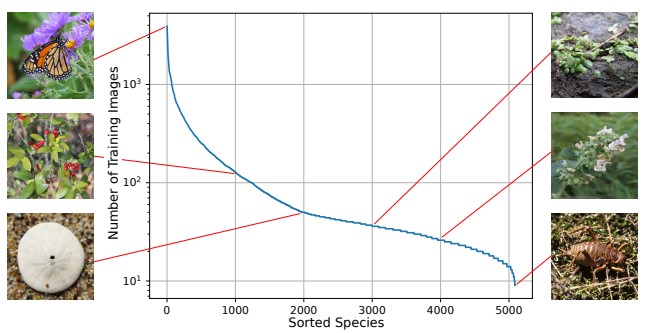

品種などの微妙な違いでカテゴリを区別されるような細かい画像のクラス分けは膨大なカテゴリ分けの高いコストにより難しいタスクとなっている.これにより起こるトレーニングデータの不足に対処する研究として以下の二点が存在する. (1)人のアノテーションが加わっていないフリーなウェブイメージを利用. (2)Zero-shot Learning(ZSL)を利用. しかし,(1)ではウェブイメージにラベルノイズ付きが多いこと,(2)ではZSLは未だに従来の学習に比べて精度が良くないという問題点が存在する. そこでウェブイメージと補助的なラベルデータを用いてトレーニングデータに関連付けられていないテストカテゴリを予測するフレームワークを提案した. 評価にはZSLの評価にもよく使われる3つのデータセット,CNB, SUN, Dogsを使って評価している.

従来手法(特にZSL)に比べ格段に精度が上昇している.

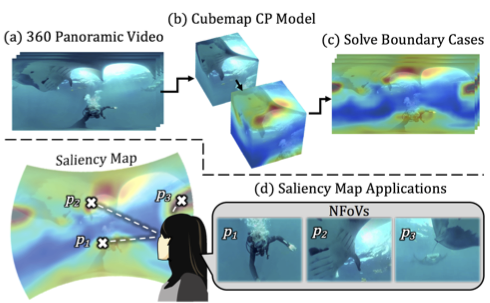

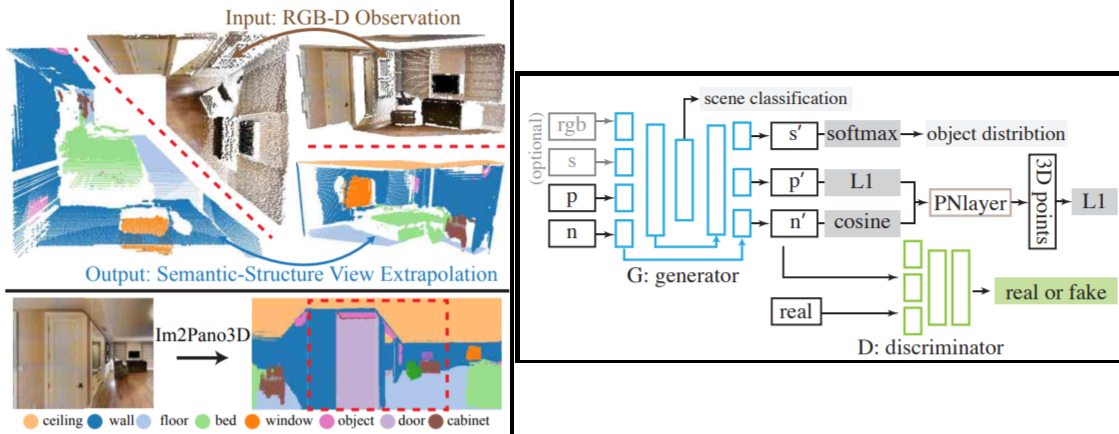

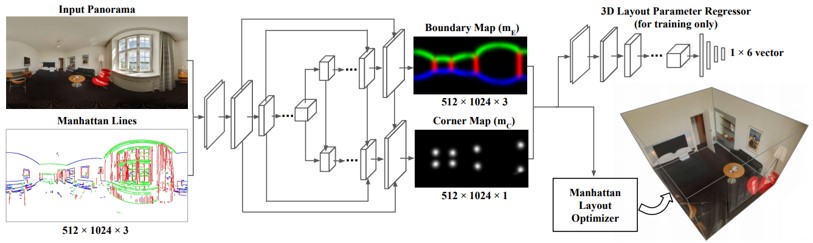

室内の2Dパノラマ画像1枚から3Dモデルを推定する研究.本稿ではパノラマ画像から18視点の画像(パノラマの中心点から対象を普通に撮影したような画像),sub-viewを生成する. それらを入力とし,sub-viewごとに顕著生マップ(Saliency map)とオブジェクト検出から前景と背景を分けると同時に直線検出(Line segment detection)を行いパノラマ画像を解析し,geometric cueとsemantic cueを推定する. これらから地面の推定,オクルージョンの推定を行い,形状の復元を行う.

FAROとsyntheticデータセットを使って評価した結果,背景とオブジェクト検出におけるdepth cosine distanceが従来より最先端な結果となった.

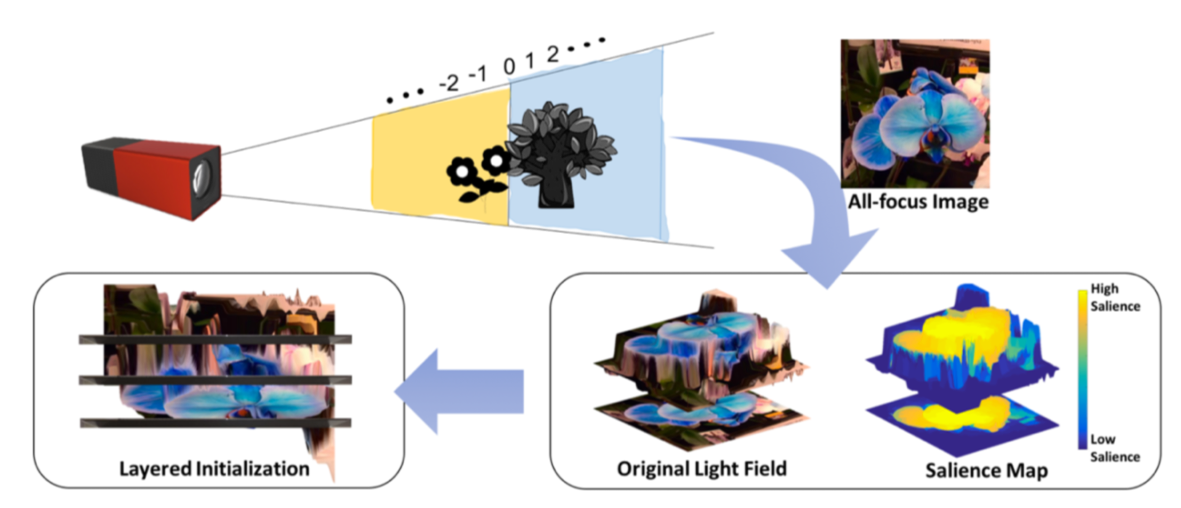

Multi-layer light field 3D display のための depth calibration の研究. Saliency の高い領域を推定し, その領域の深度を可能な限り表現出来るように calibration することで, Multi-layer light field 3D display の持つ深度表現の制限の元で知覚的に最適化された depth calibration を行う手法を提案. 主観評価実験では既存手法よりも最低でも12%以上良いという結果を達成.

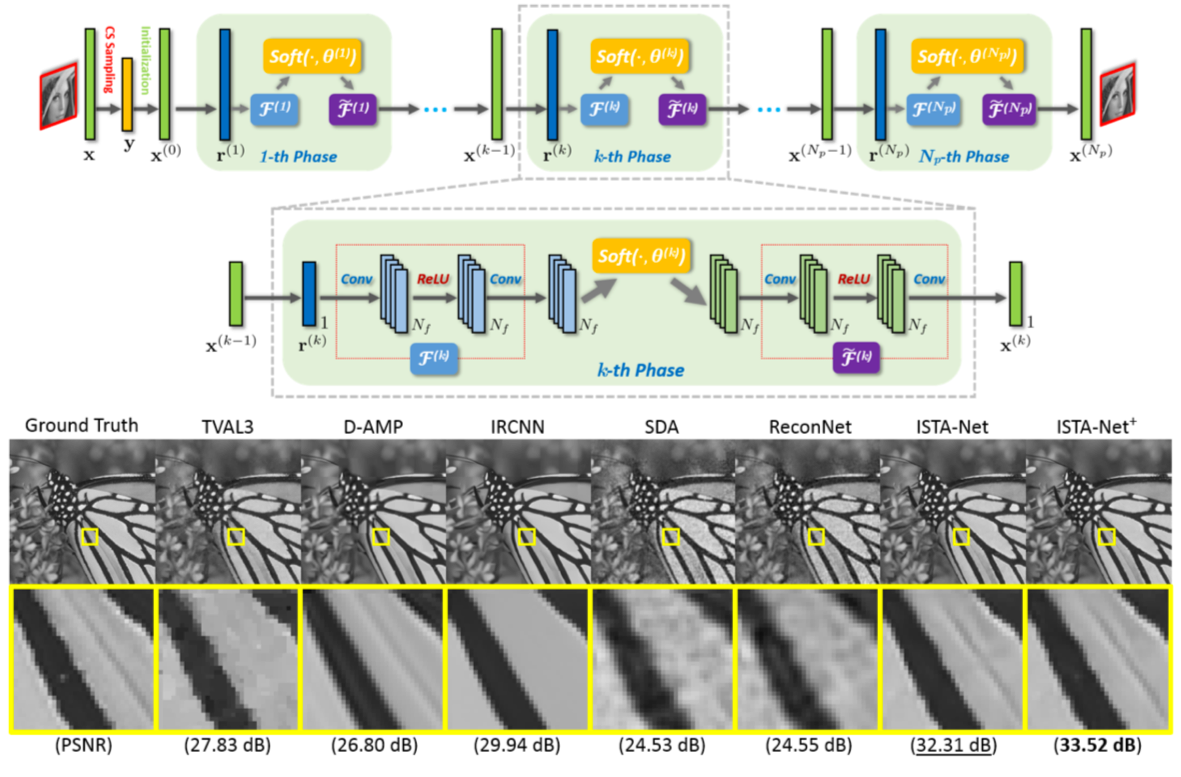

Compressive sensing (CS) reconstruction の研究. 従来の Iterative Shrinkage-Thresholding Algorithm (ISTA) のイテレーションを end-to-end で学習可能なネットワークに置き換えた, ISTA-Net を提案. 評価実験では幅広い CS Rate において既存の最適化に基づく手法とネットワークに基づく手法の両者よりも優位な結果を達成した.

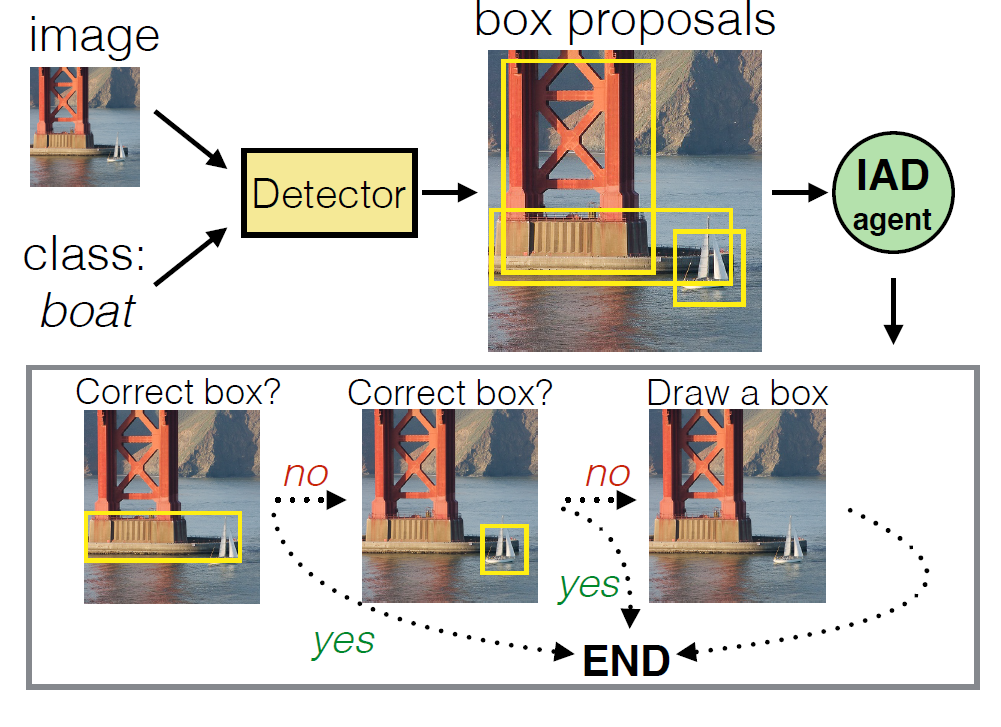

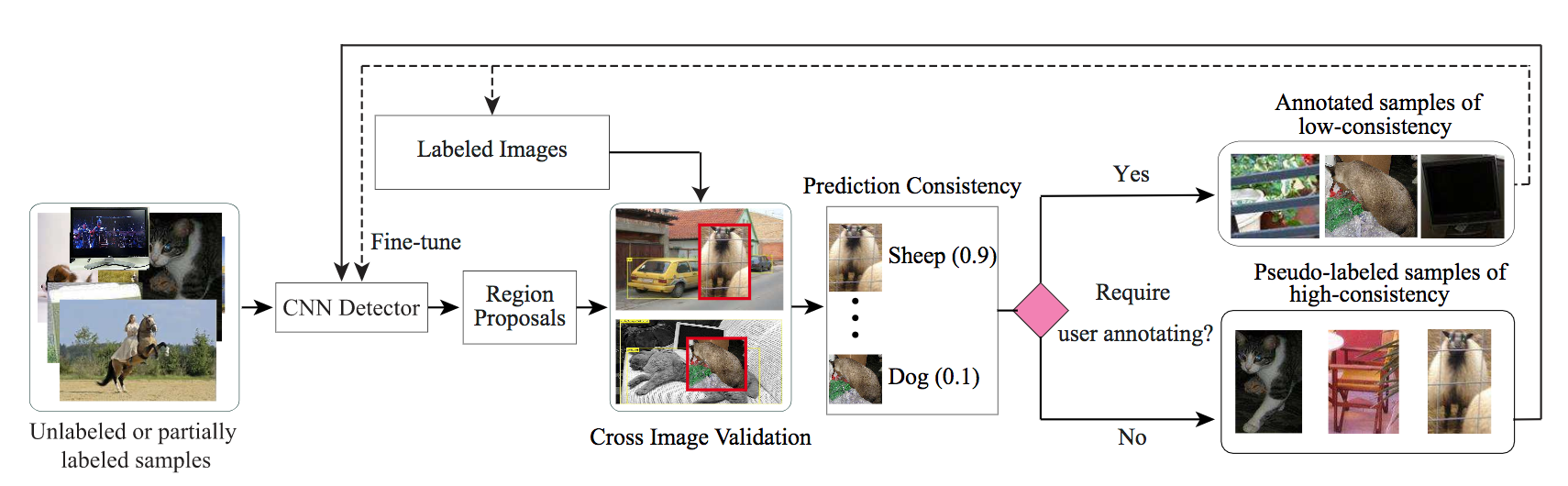

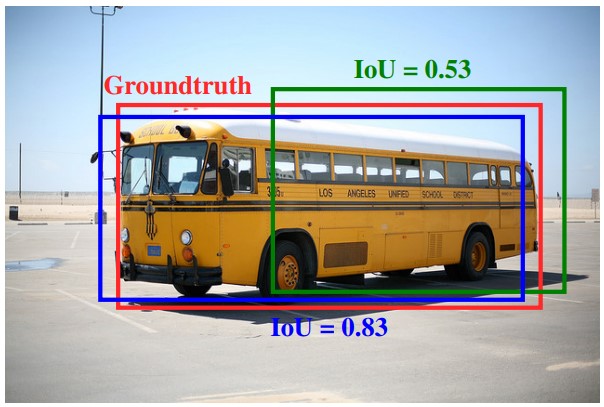

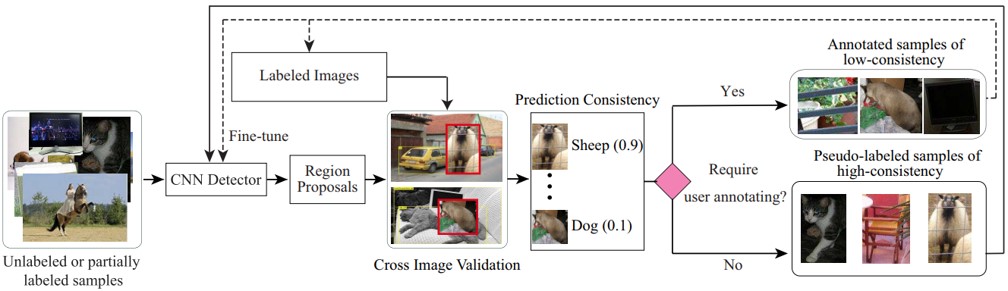

アノテーションには対象領域を矩形で囲むのとその確認作業の2つのステップがある。画像がシンプルで検出領域の信頼性が高い場合は手作業で矩形を付ける作業を行わず、確認作業のみを行ったほうが時間を短縮できる。一方、検出領域が小さく、数多くあると確認作業に時間がかかってしまうため、手作業で矩形をつけたほうがよい。このように画像ごとに最適なアノテーション戦略を練る必要があり、Intelligent Annotation Dialogs (IAD) はこの手助けをする。本論文では2つのIAD手法が提案されている。1つ目は検出領域がアノテーターに受け入れられる確率を考慮して、アノテーション時間をモデル化することで最適化する。2つ目はモデリングを行わず、強化学習により最適な戦略を見つける。

物体検出等において精度の高いアノテーションは重要であるがそのコストは高いままである中で、IADを利用することにより既存手法に比べてアノテーション時間を短縮できると示した。

**論文

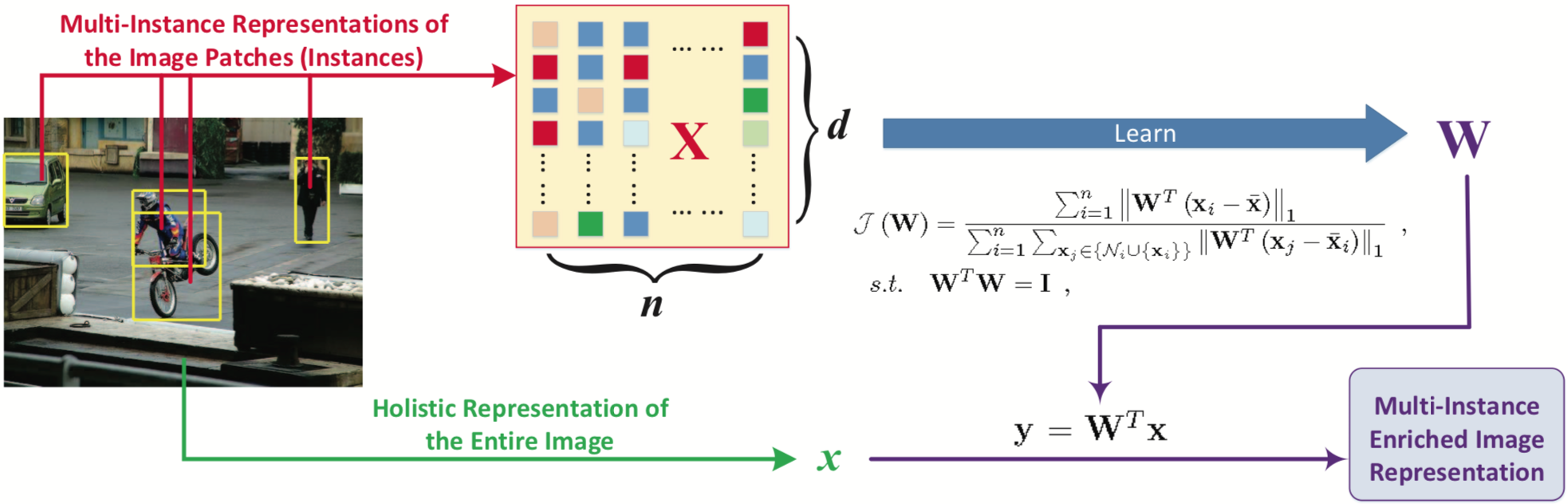

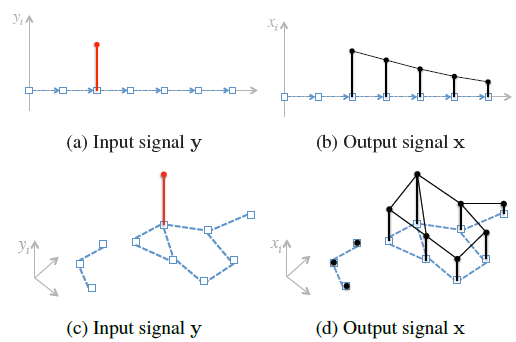

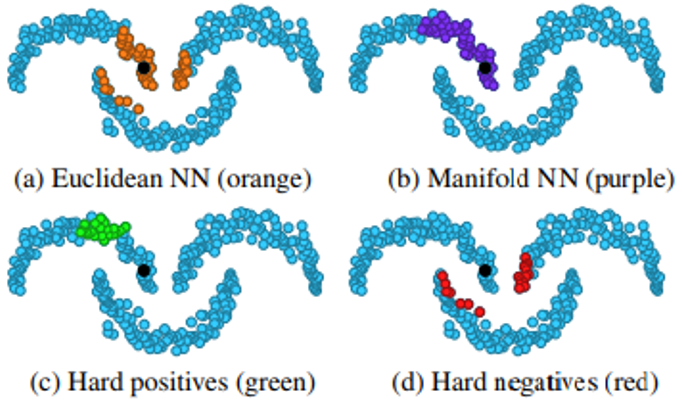

Object retrievalにおけるManifold searchの計算コストをEuclidean searchまで下げるためのembeddingを提案した。nodeが特徴量に対応するものをグラフとして扱い、観測ベクトルyから類似度を表すランキングベクトルxを予測する線形システムを扱う。

10^5オーダーの数ある画像に対して、オフラインプロセスを2,3時間で、オンラインプロセスは従来手法と同等に処理することが可能に。精度は従来手法と同程度である。 mAPはrank-1kあたりで収束している。

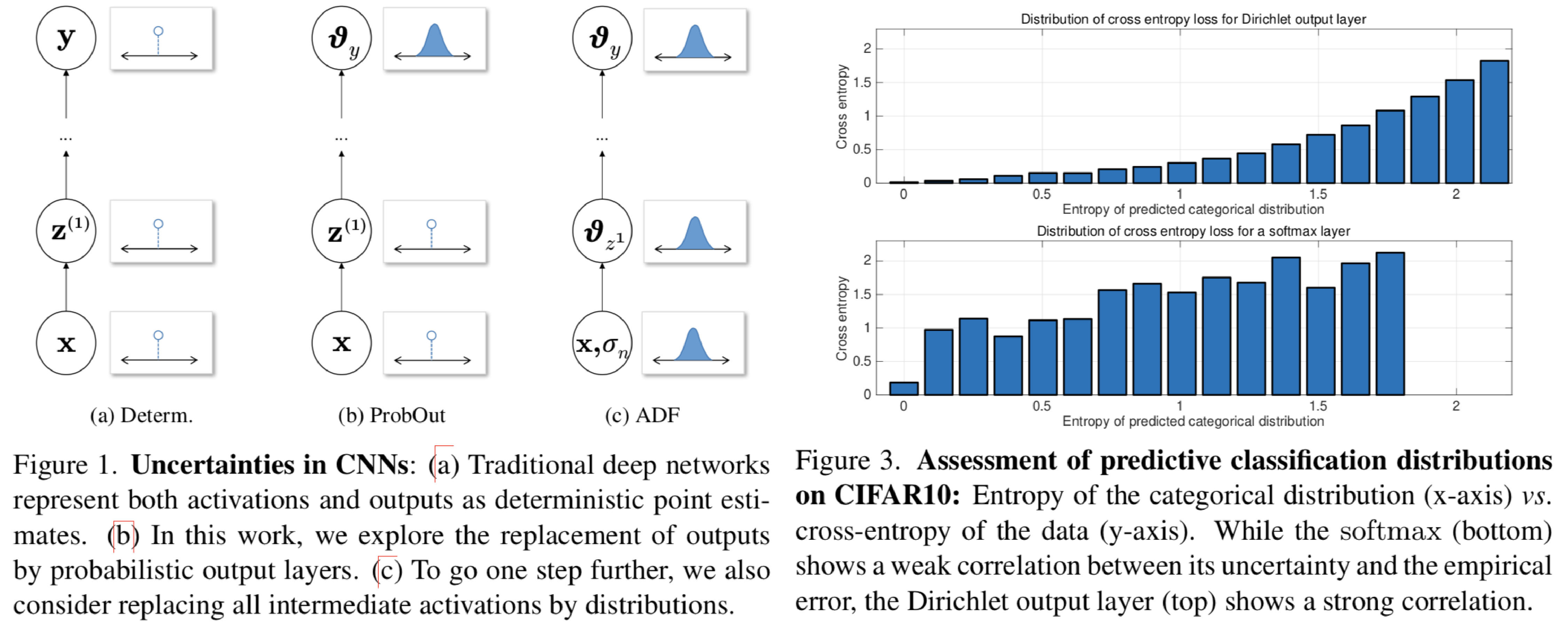

DNNに対して活性化や最終層の出力を確率分布で置き換えるモデルを提案。DNNでは要所要所で確率モデルを使用しているが、多くのモデルでは活性化や最終層の出力はサンプリングに終わっている。一方でfull Bayesian networksではパラメタ自体を確率分布に置き換えているが、テストの実行に長い時間がかかってしまう。提案手法ではネットワークの最終層の出力を確率分布で置き換えるprobabilistic output layers (ProbOut)と、assumed density filtering(ADF)を導入することで活性化を確率分布で置き換える2つの方法を提案。これを既存のネットワークに組み込むことで、テスト時の実行速度を落とすことなく識別・回帰の両タスクで高い精度を実現。特に識別ではディリクレ分布に基づく出力を行うモデルを提案。

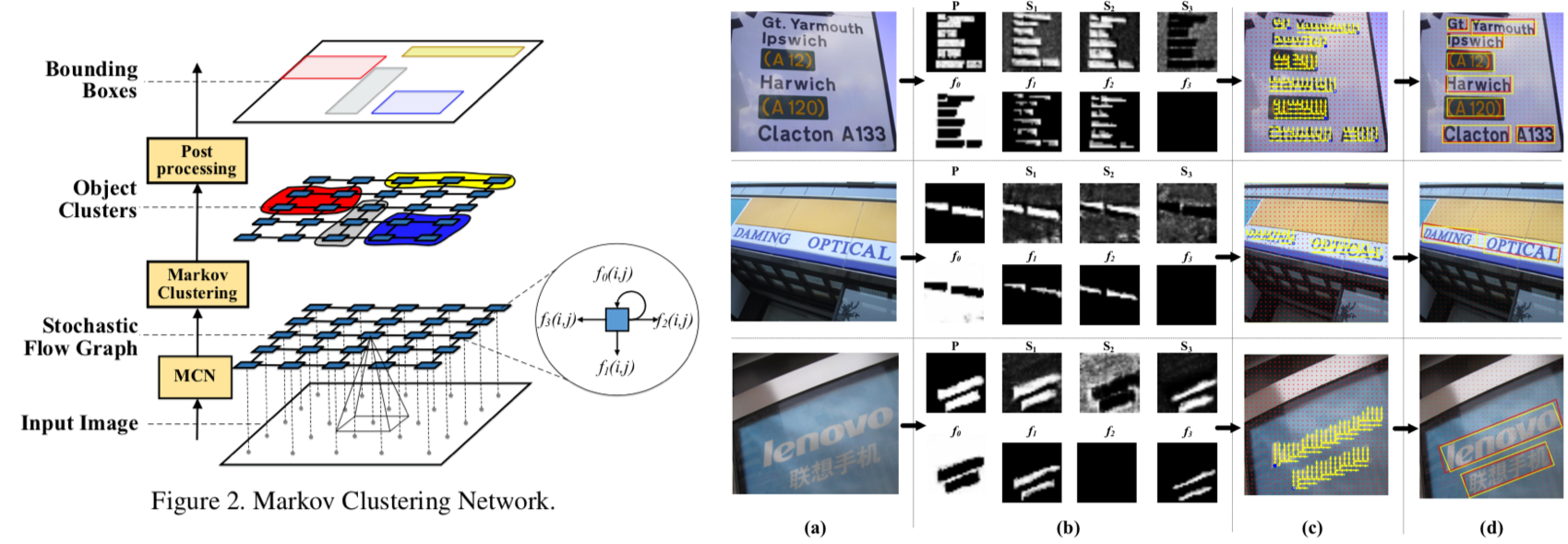

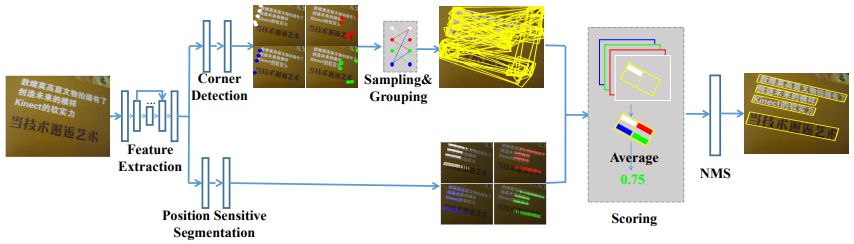

ボトムアップに Scene Text Detection を行う手法を提案. 物体検出を Stochastic Flow Graph のクラスタリングとして定式化した. ボトムアップな手法の恩恵として, スケールや回転に頑強になると共に, 並列化による高速化が可能となった. 評価実験では MSRA-TD500 dataset で SOTA を達成し, かつ既存手法の1.5倍(34FPS)高速に動作.

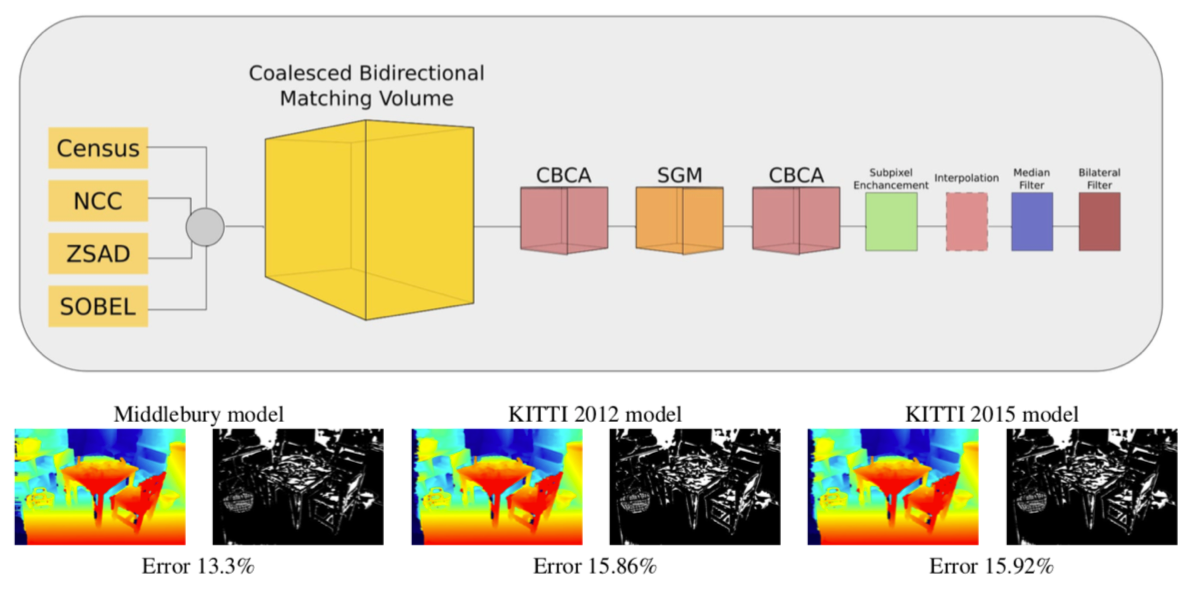

stero matching に用いる mathching volume の推定を学習データに依存せずに, ロバストに行うモデルを提案. 4つの matcher から得られた mathching volume から確信度の高い部分(確信度の計算は双方向から行う)をそれぞれ抽出し, random forest classifier を用いて最終的な mathching volume の生成を行う. 評価実験では MC-CNN と同等の高い精度を達成すると共に, 高い汎化性能を確認した.

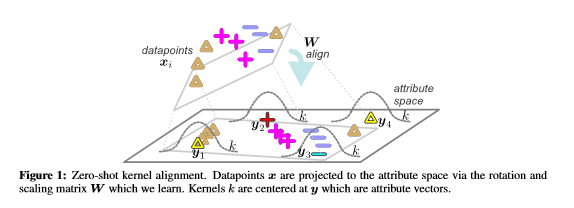

Image-specific な saliency map を得るために, 既存の saliency detector を強化する問題を zero-shot learning として定式化. DNNを用いて, 画像の特徴量マップと各画素のアトリビュートを同じ計量空間に射影し, アトリビュートが射影された点をアンカーとして最近傍探索によって新しい saliency map を得る. ECSSD や PASCAL-S など5つのベンチマークで評価を行いSOTAを達成した.

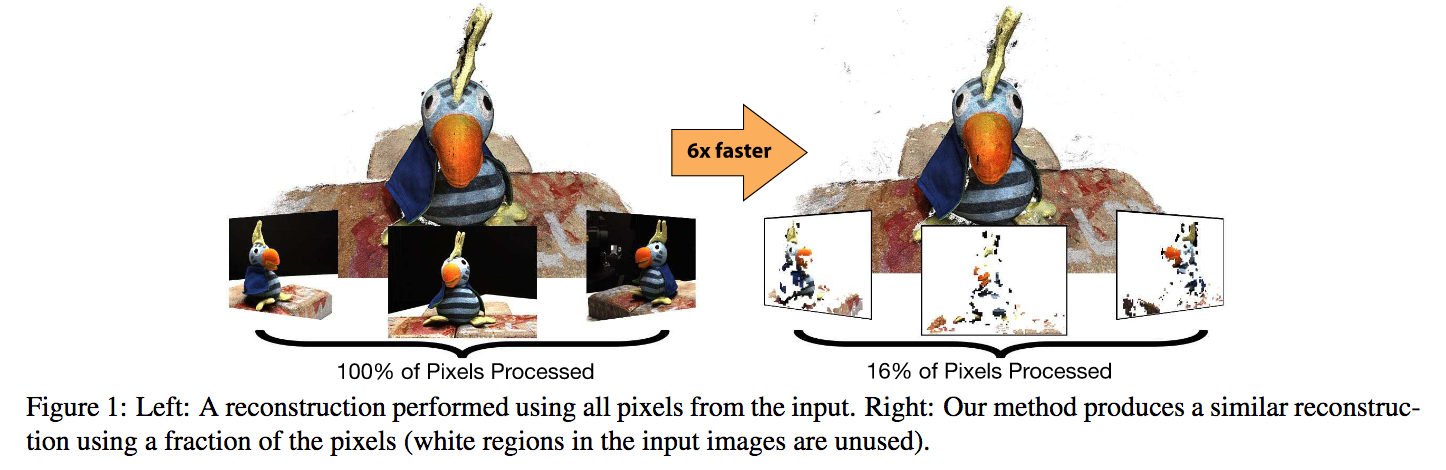

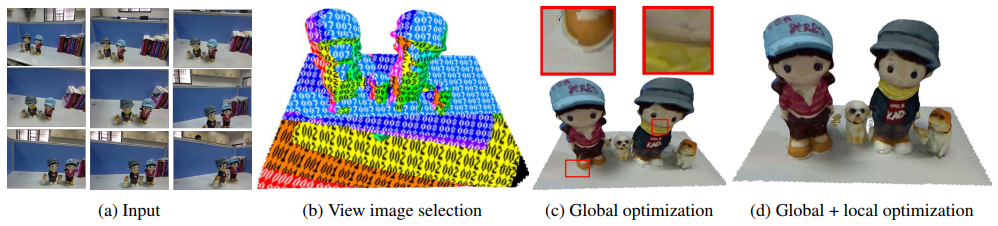

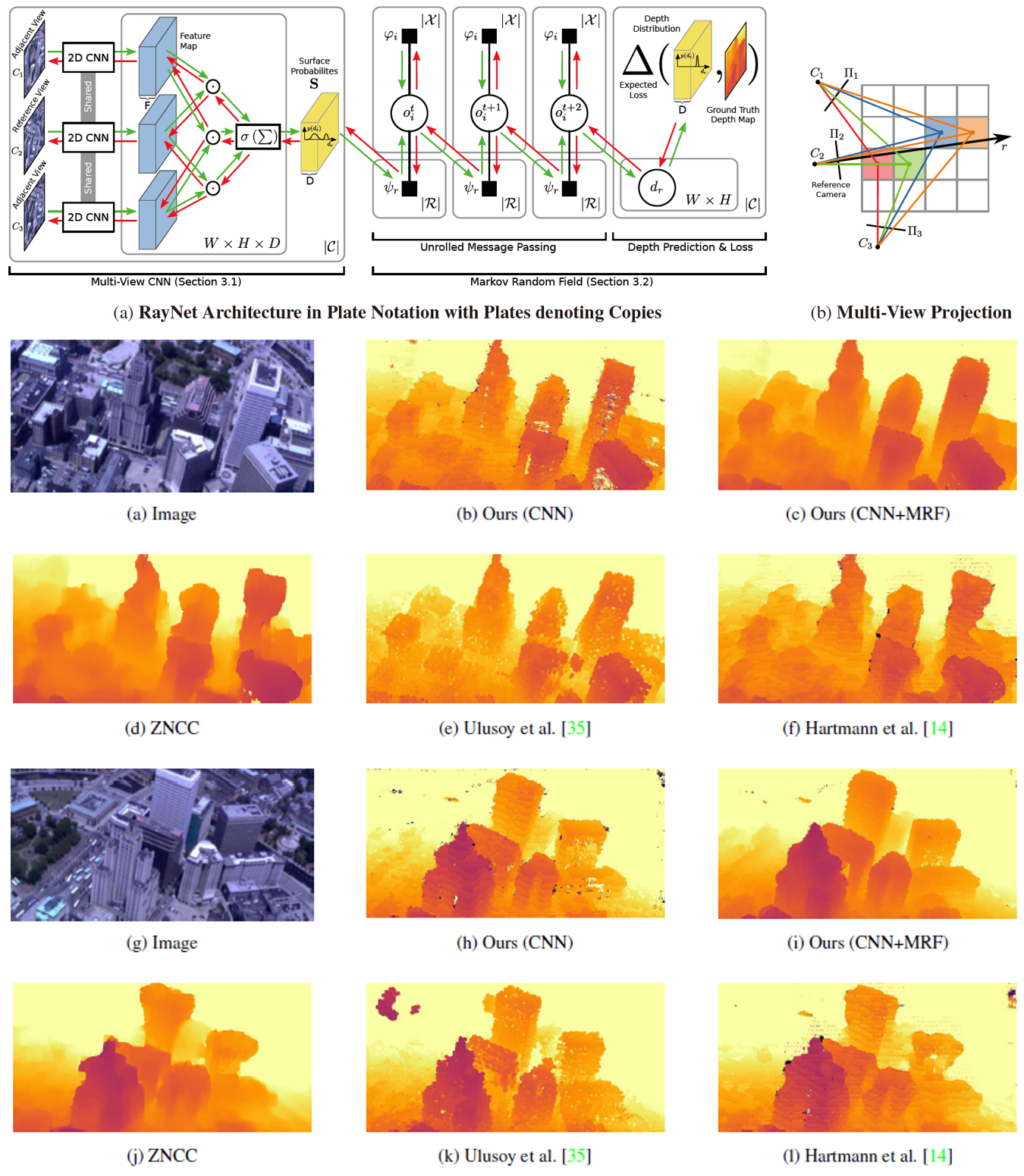

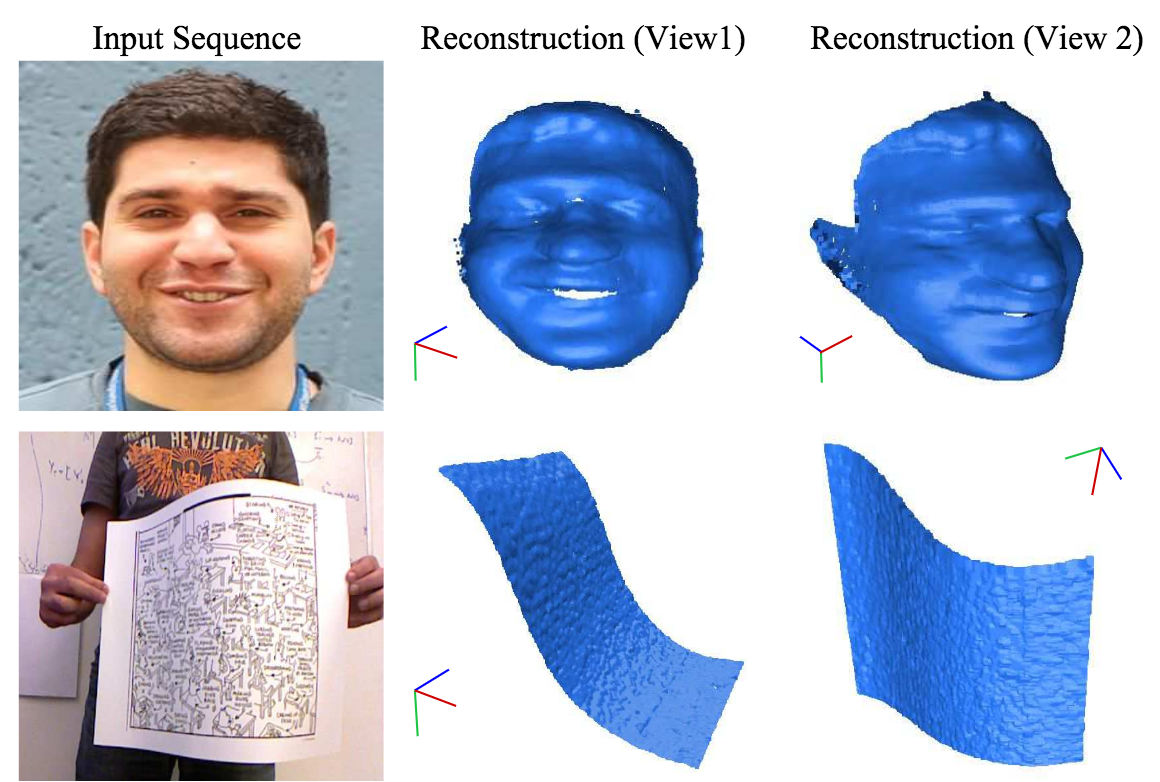

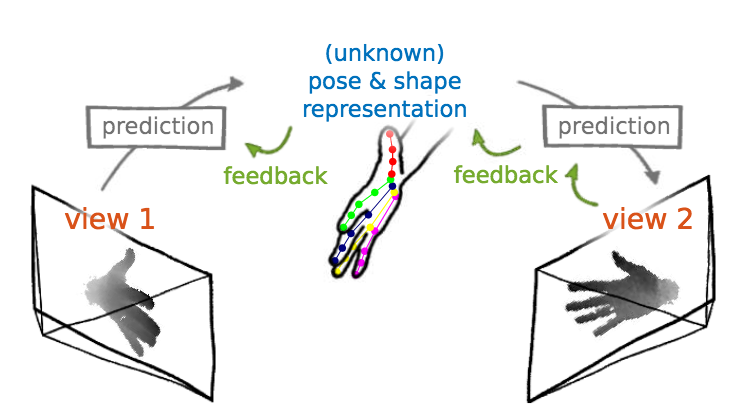

Multi-view stereo(MVS)による3次元再構成の問題を取り扱う。事前確率による画像パッチにより少量のデータで3次元形状を復元、より高速な処理を可能とした。右図のように3次元再構成を行うために重要なデータを予め抽出することで16%のデータで約6倍高速にMVSによる3次元データを復元するに至った。ニューラルネットベースの手法(I2RNet)やDepthから3次元復元のための重要なデータを選定。

MVSにて事前確率(w/ Depth, I2RNet)を用い少量の重要なデータを用いることで高速な3次元復元を可能とした。

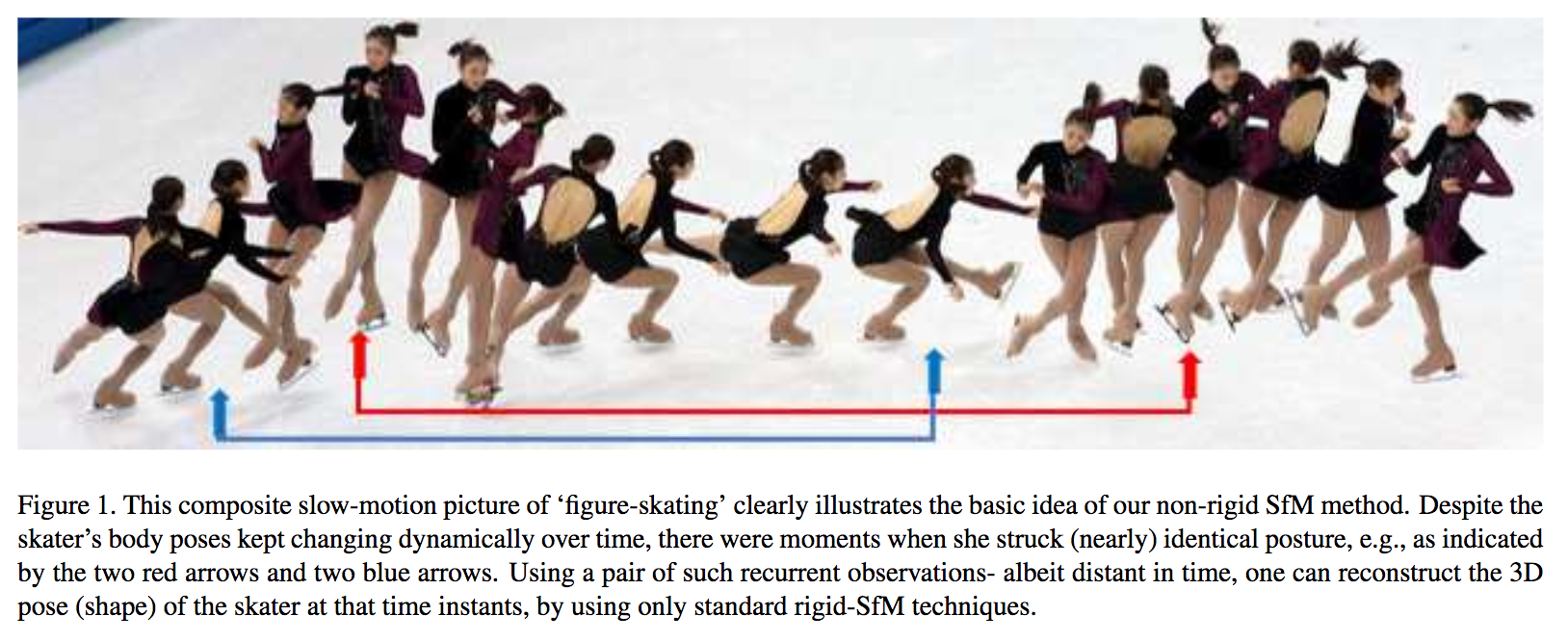

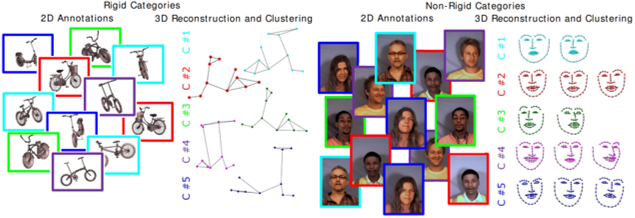

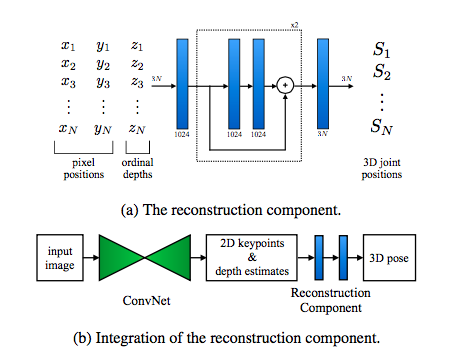

動画像の入力から非剛体に対するSfM(Non-Rigid Structure-from-Motion)に対して再帰的に繰り返し動的行動を復元できる新しい手法を考案する。非剛体の形状変化は再帰的になる傾向があるという性質を利用して形状復元を実施した。この性質を用いると、従来の剛体形状復元の方法をほぼ改編しなくても同じようなモデルで復元を可能とした。右図は再帰性を用いた非剛体推定の例である。フレームによりほぼ同じ姿勢が表れており、この知識を用いると剛体推定と同じような枠組みで非剛体を推定できる。

再帰的な動作を捉えることで、従来の剛体推定とほぼ同じモデルで動画からの非剛体推定ができるという知見を与えた(ことが大きな貢献であり、採択された理由である)。

カメラ姿勢の中でも角度が既知であるというStructure-from-Motion(SfM)の中でも特殊な問題を扱う。再投影誤差(Reprojection Errors)に関してMini-Max問題を想定し、この問題について擬似凸プログラミング問題(Pseudo-Convex Programming)として解決する。従来では非常に処理時間がかかる同問題に対して、本論文では(比較的)大規模なデータにおいて高速化を図った。最適化の更新処理においてMinimum Enclosing Ball (MEB)を用いることでメモリ低減と同時に高速化を実現した。

SfMにおいても特殊と言われる、カメラ角度が既知の状態における擬似凸最適化の問題で、繰り返し最適化手法を考案することで比較的大規模な問題において高速な演算を行うことに成功した。

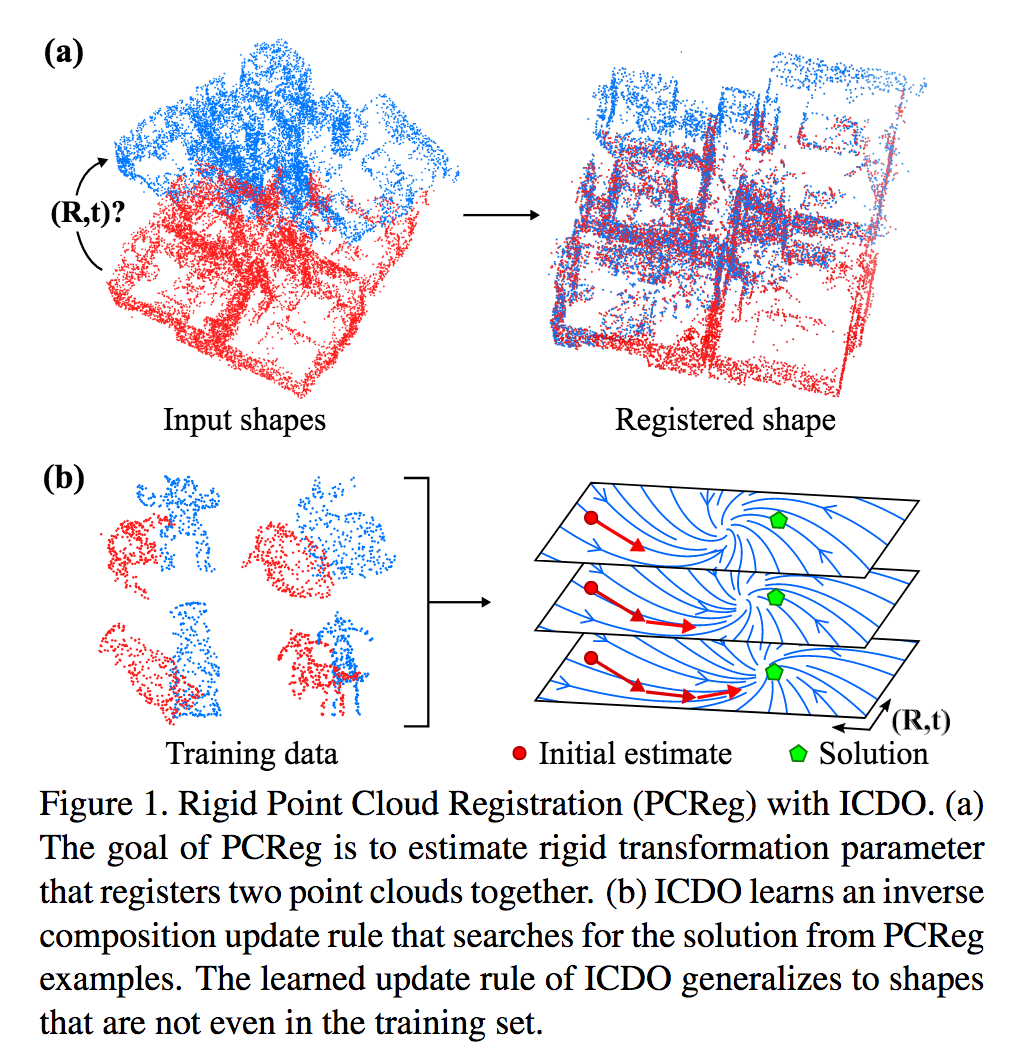

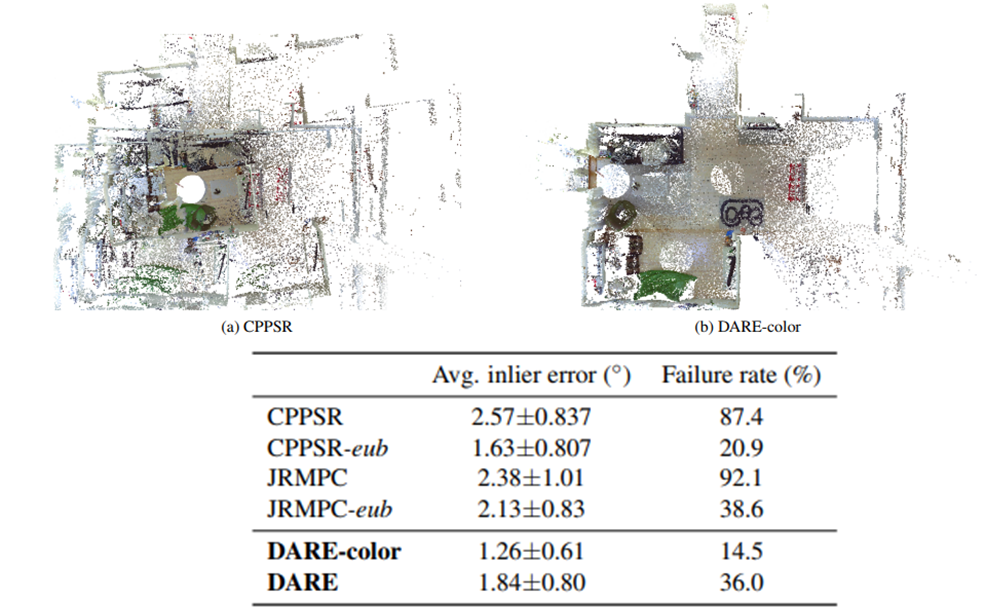

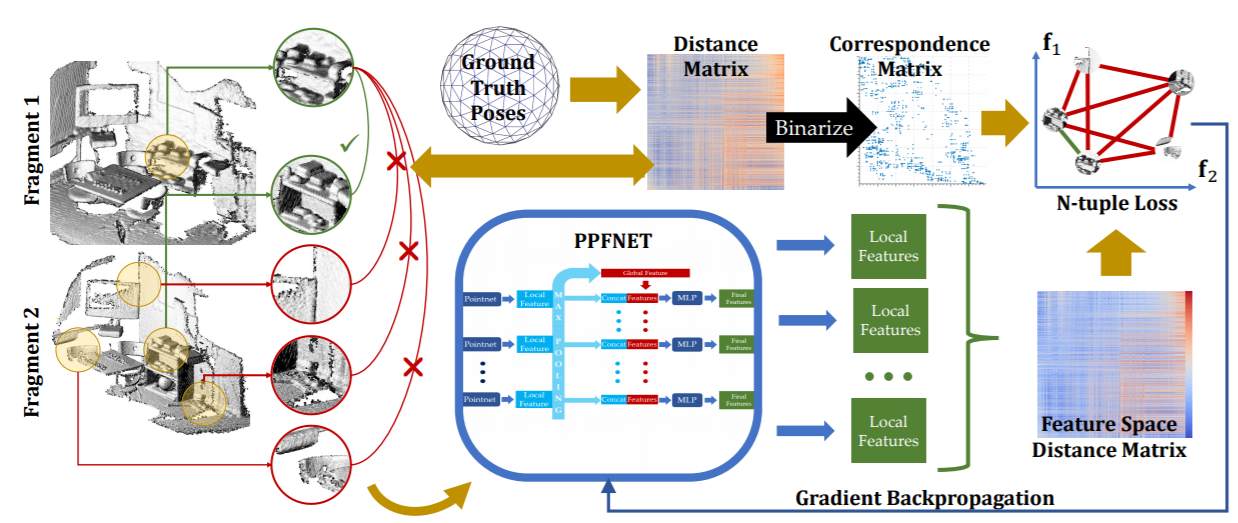

剛体の3次元点群のレジストレーション(位置合わせ)を行うための手法Inverse Composition Discriminative Optimization(ICDO)を提供する。従来のICPはローカルの位置合わせに着目しているために、局所最適解に陥りやすく初期値やアウトライアに依存して位置合わせが失敗してしまう。提案手法であるICDOでは合成トレーニングデータにより学習を行い、繰り返し最適化を行うことでより全体的な最適解に近づけるという戦略を取っている。(本手法はDOの拡張であると位置付けている)

3次元点群の位置合わせ問題において、合成データを用いて学習を行うことにより、全体最適解に合わせやすくした。従来法であるDOの拡張であると主張していて、学習した物体に依存するDOに対してICDOでは物体に依存せず全体最適解に位置合わせすることができる。

Structure-from-Motion(SfM)やカメラ位置推定の一種である6DOFの姿勢推定の問題について取り組む。大抵の場合、中心座標(Principal Point)は画像の中央と決めているが、ここでは対応する4.5点(P4.5Pfuv)を基にして中心座標や焦点距離を推定する。さらにはアスペクト比を5点対応から、中心座標とレンズディストーションを7点対応から推定する。

カメラ行列に関して多項式の拘束を与えることで、4.5点対応で中心座標や焦点距離を、5点対応でアスペクト比を、7点対応(特にこれが難しい!)からは中心座標とレンズディストーションを推定した。

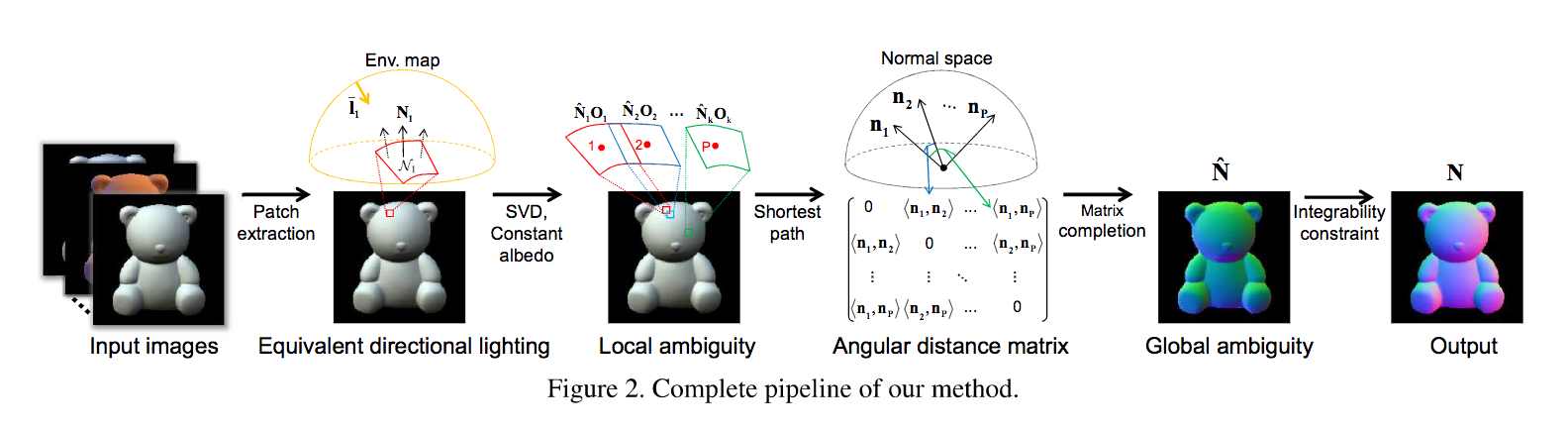

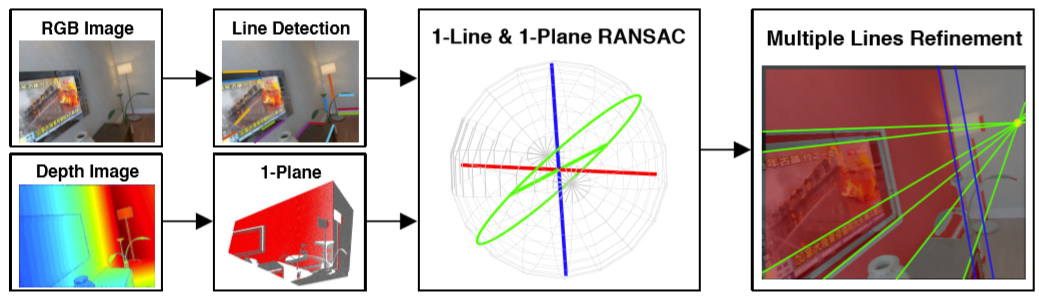

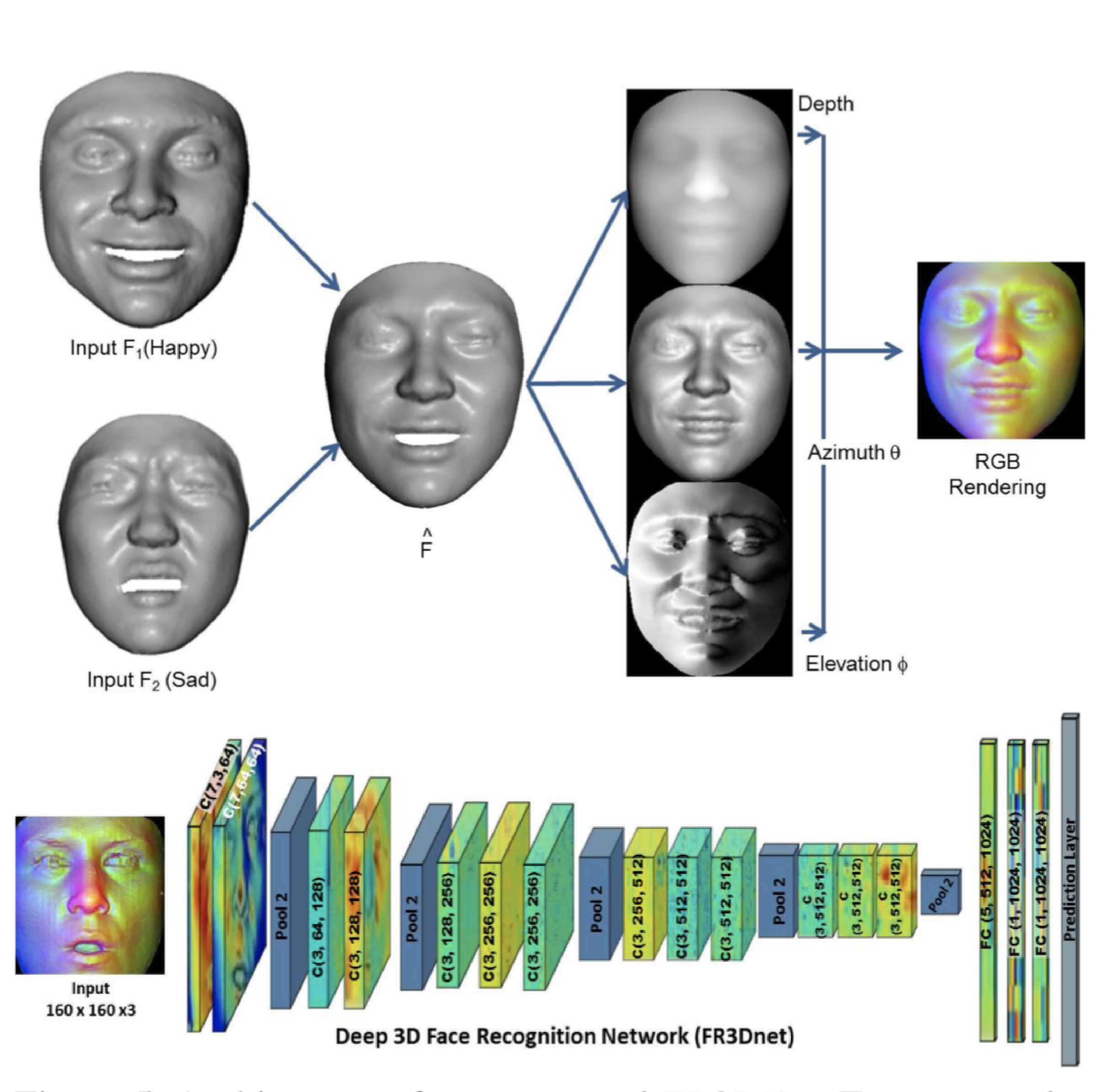

未校正(w/o calibration)かつ未知照明環境(unknown natural illumination)にてフォトメトリックステレオを実現するため、Equivalent Directional Lighting Modelを提案。滑らかに変化するような表面形状の復元や回転に対する曖昧性を許容した復元を可能にした。回転を考慮することでパッチの統合による曖昧性を排除して全体の表面を最適化した。図は提案手法のフロー図である。最初に光源を推定(Equivalent Directional Lighting)し、次にSVDしつつ局所的な(回転による?)曖昧性を除去、法線の空間にて行列計算・補完を行い出力する。

未校正かつ未知照明の環境にて、滑らかな表面形状変化を捉えるフォトメトリックステレオ手法を考案した。パッチ毎に回転の曖昧性を推定して全体の構造を把握することに成功した。

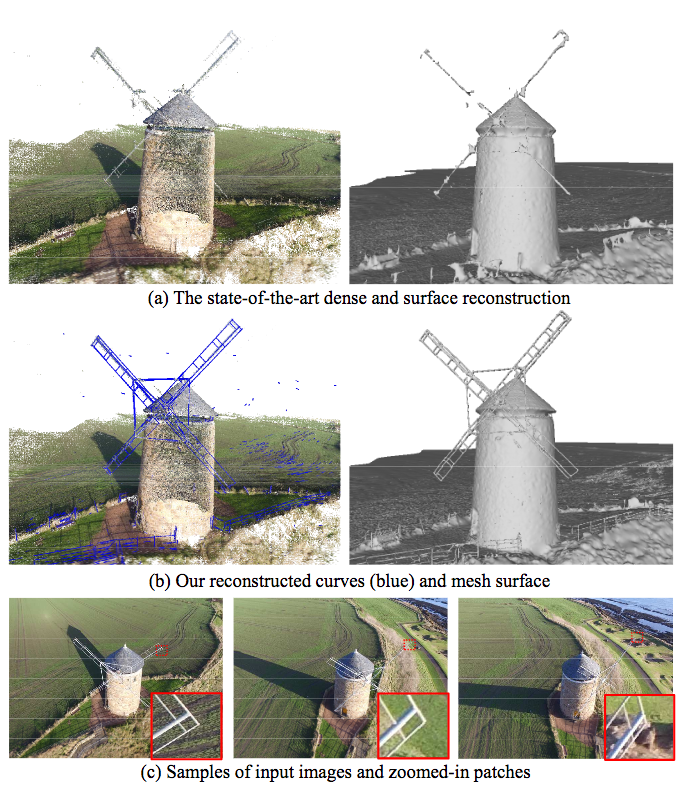

細い(Thin)構造の物体を3次元復元するためのMulti-View Stereo手法を提案。トポロジーや連結性を考慮して復元を行ない、3次元メッシュ構造を復元することに成功した。3次元カーブ再構成、4面体系(tetrahedra)を復元してCurbe-conformed Delaunay Refinementを実施する。さらに、メッシュが4面体系上に復元される。

形状が細い構造物を合成データ/リアルデータ両方のデータセットにおいて3次元メッシュ復元を可能にした。また、図に示されている通り、(細い形状を含め)表面形状を保存したままの復元に成功した。

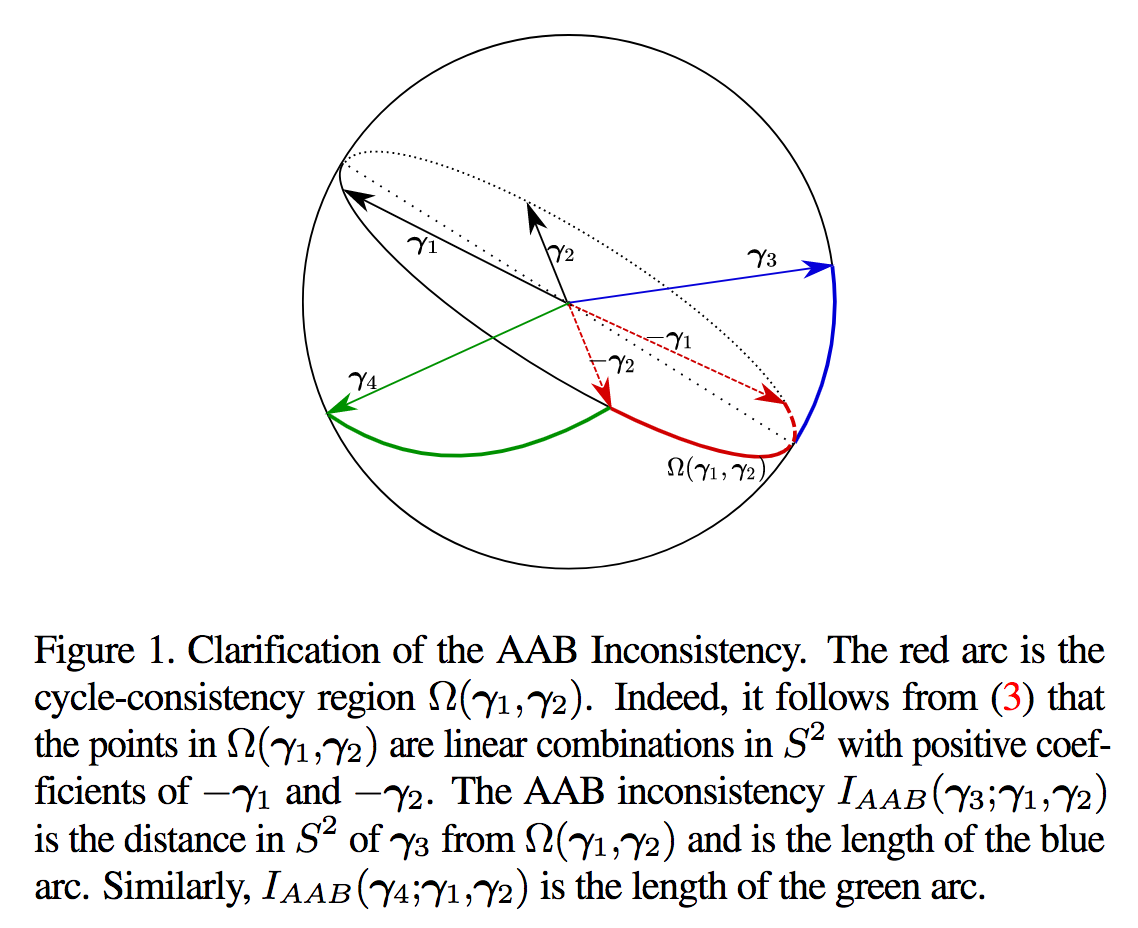

Structure-from-Motion(SfM)にてカメラ位置推定を改善する手法について、本論文ではAll-About-that-Base (AAB) Statisticを提案、重み付けの方法について検討し、カメラ方向についてずれのレベル(ここでいうCorruption levelとは?)を推定しながら位置推定を実現。これによりカメラ方向(Camera Orientation)推定、重み付けについて理論的な証明を行うこと、より高速な手法の提案が展望として考えられる。

2つのカメラにおける誤差を推定して復元する重み付け方法について提案し、カメラの位置推定に寄与した。

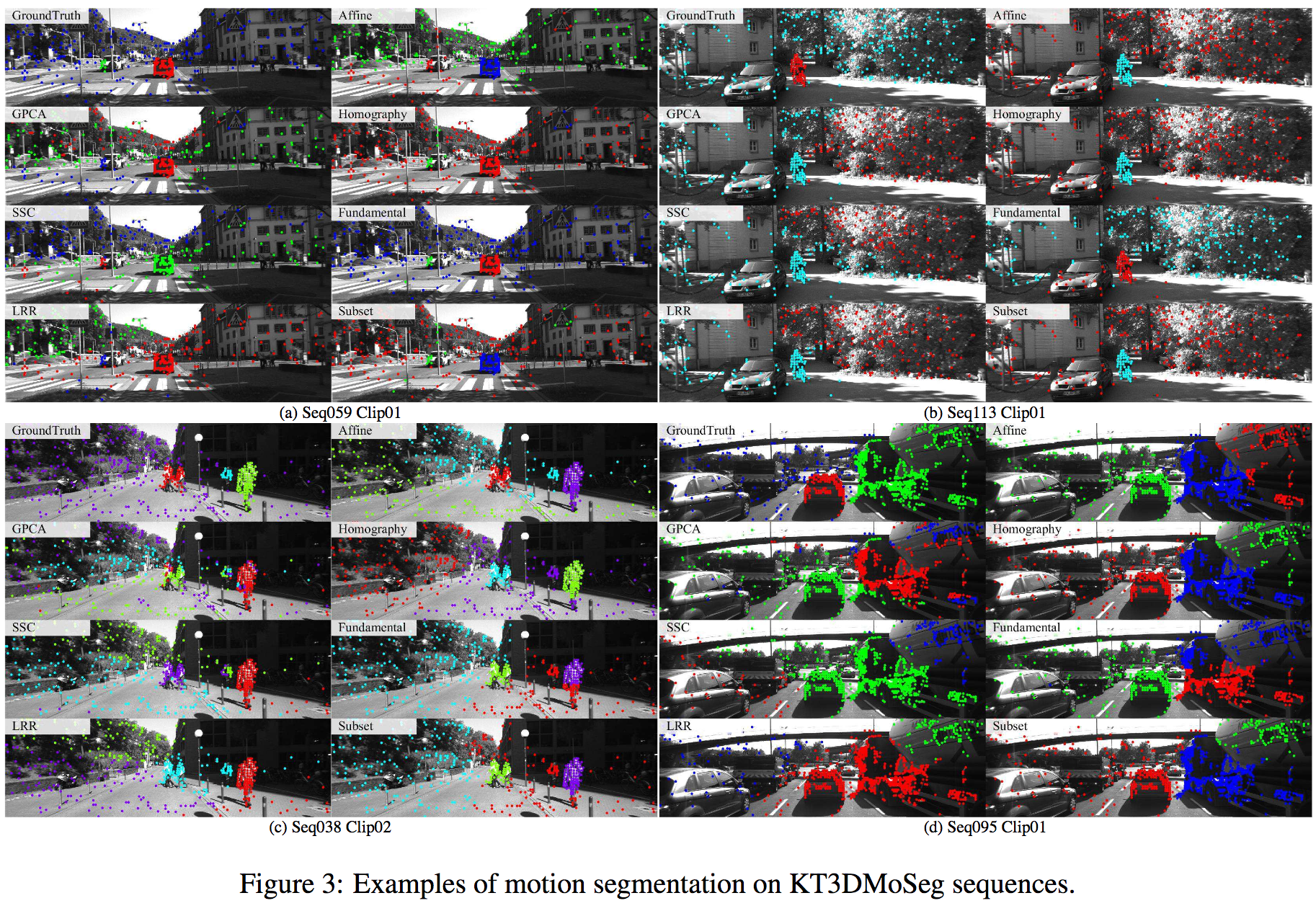

動的環境のモーションセグメンテーションにおいて幾何的な情報をホモグラフィとして抽出、平面などをインライアとして扱いマッチングの精度を補間的に高める。従来の基礎行列の手法では(動的環境下では)困難でも、マルチビューのスペクトラルクラスタリングとの統合で相補的にモデルを改善する。

既存の基礎行列やホモグラフィといったモデルに対してマルチビューのスペクトラルクラスタリングを用いて空間の幾何構造を把握する研究である。Hopkins155, Hopkins12, MTPV62, KITTIデータセットにてSOTAな性を実現している。

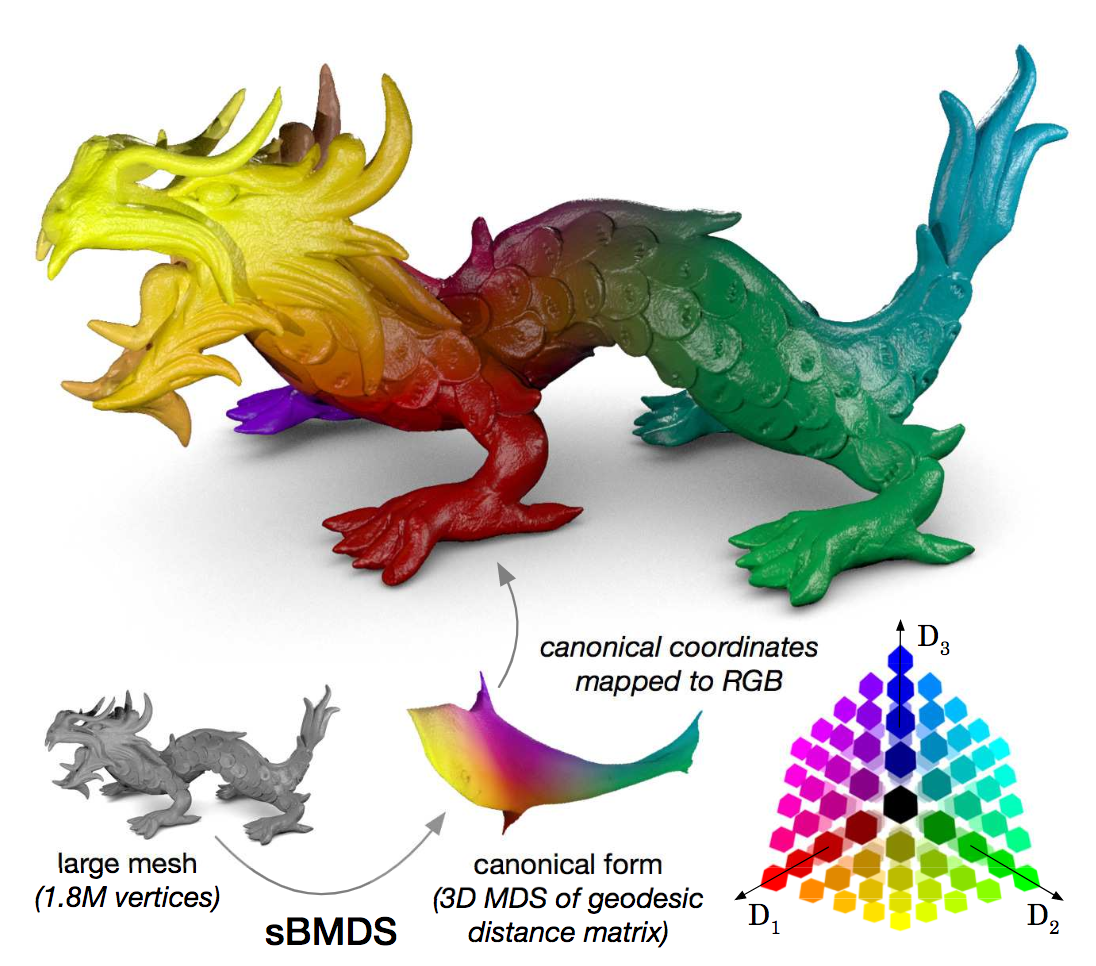

本論文では3次元形状において、膨大な空間からマッチングする領域の探索問題を考える。従来では低ランク近似(Low-Rank Approximation)による手法、例としてMDS(Multidimensional Scaling)を適用してきた。本論文ではBiharmonic Interpolationによる測地距離行列を用いたSparse Biharmonic MDS(sBMDS)を提案することでより効率的な探索を実施することができる。sBMDSではデータの多様体を捉えて探索する点を大幅に抑えることができる(1.8Mx1.8M, 26TB => 50,000 landmarks, 20.9GB)。

スパース補間技術であるsBMDSを提案したことで、マッチングする領域を大幅に減らすことに成功。非剛体のマッチングに要する時間は半分、メモリは20分の1になったと主張。

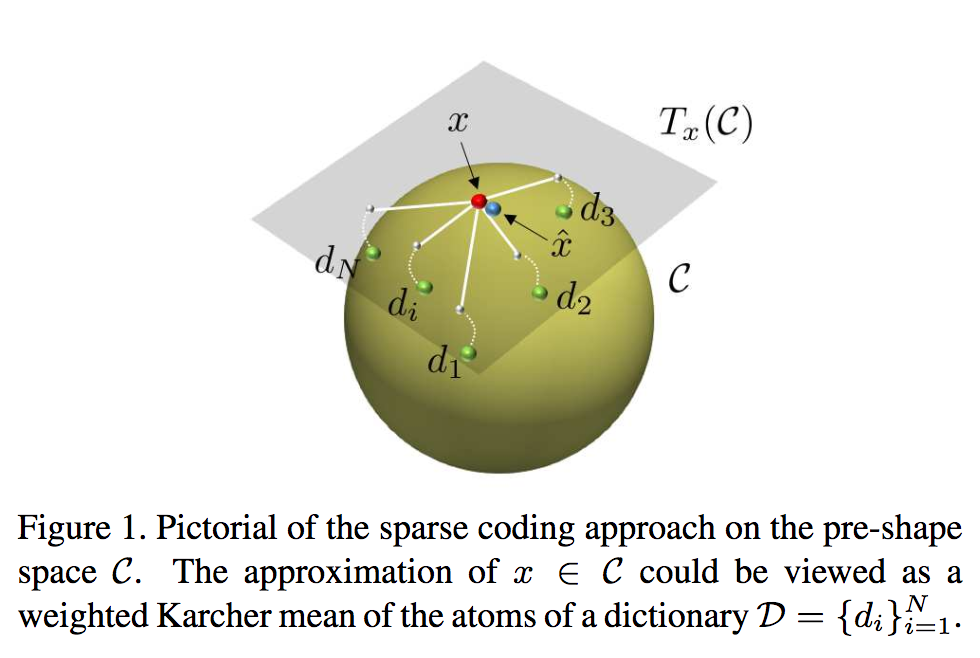

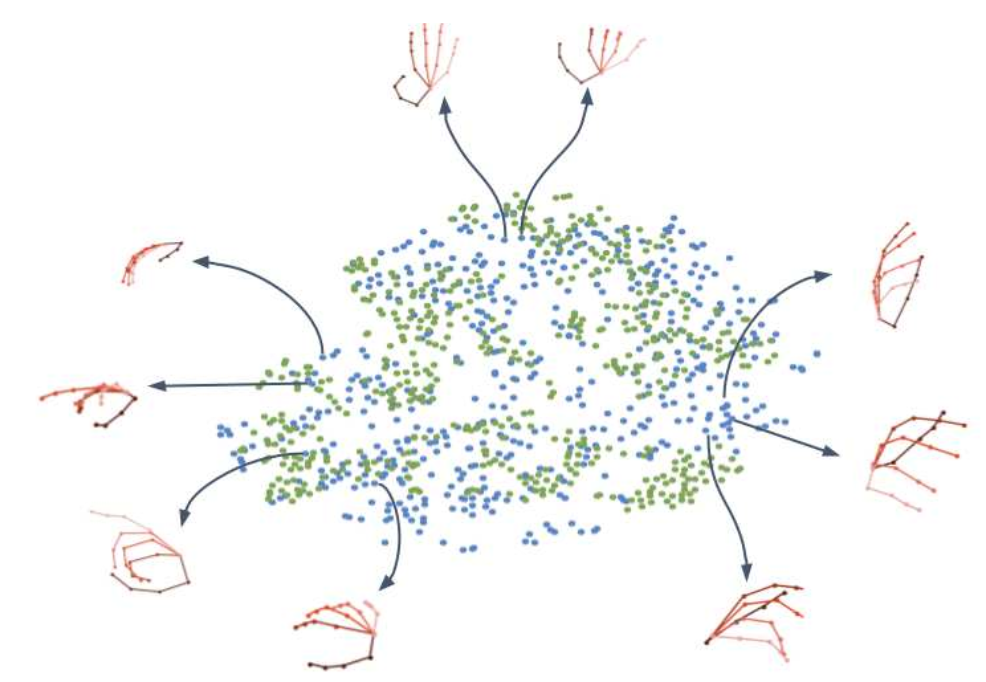

本論文ではスパースコーディング/辞書学習として著名なKendall's shape spaceを用いて3次元関節点を入力とした人物行動認識に取り組む。Riemannian幾何による形状空間を構築してスパースコーディング/辞書学習を提案。行動認識を実現するために、Fourier temporal pyramidを施した後にBi-directional LSTMやLinear SVMを適用する。

3次元関節点を入力とした人物行動認識の文脈において、Riemannian辞書によるスパースコーディングを実装したことで非線形空間をスパースかつ時系列情報のユークリッド空間にて取り扱うことができた。

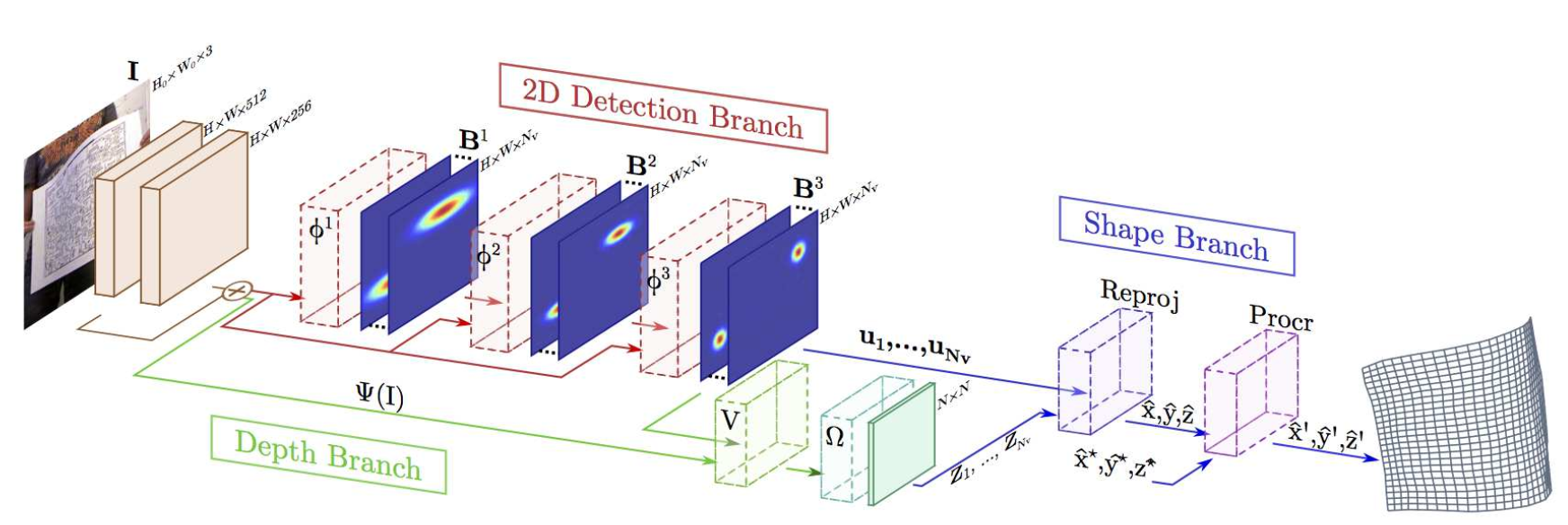

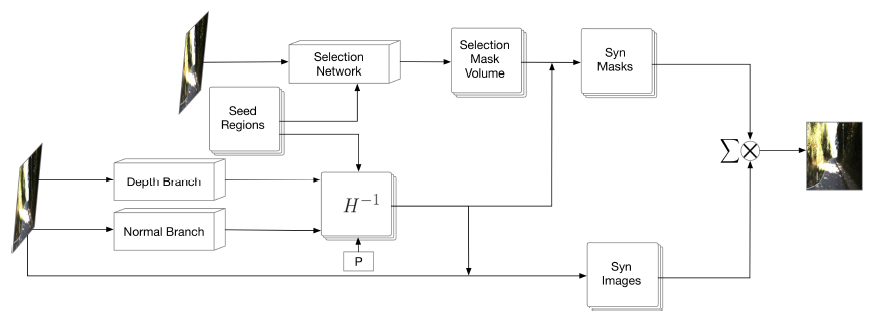

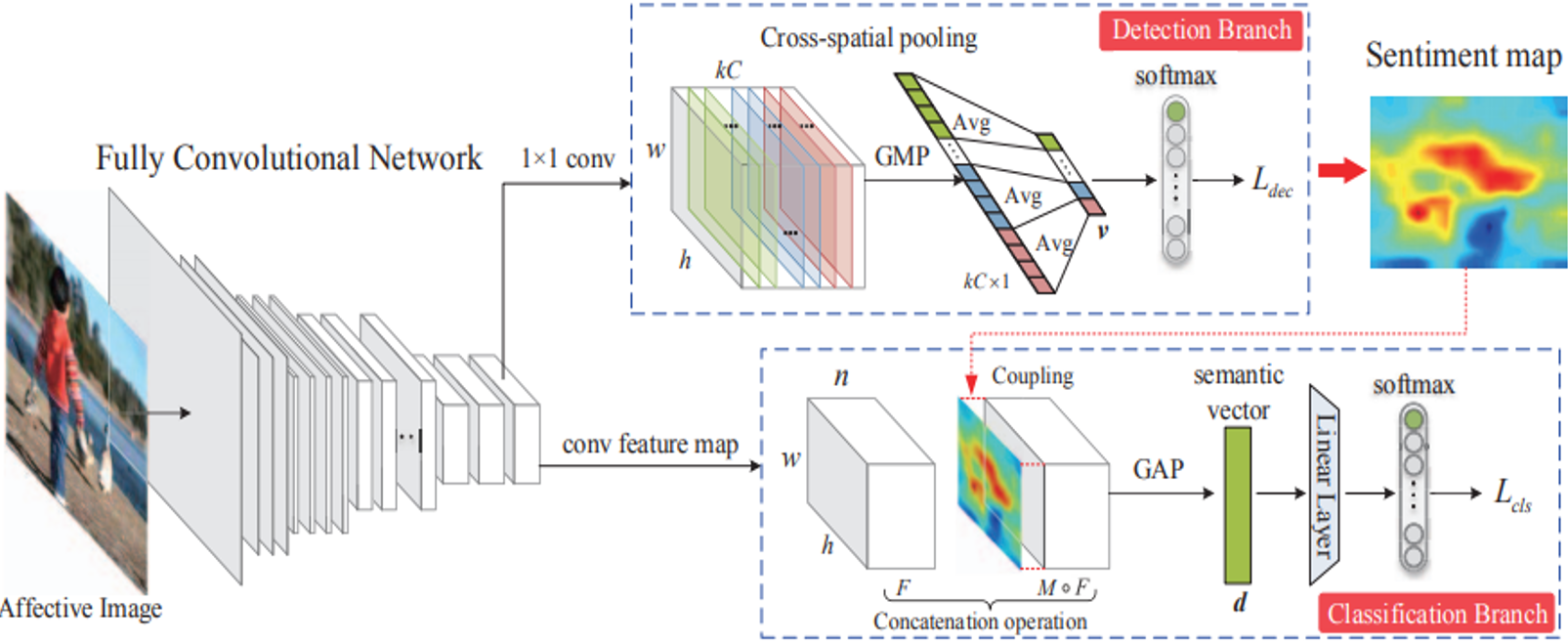

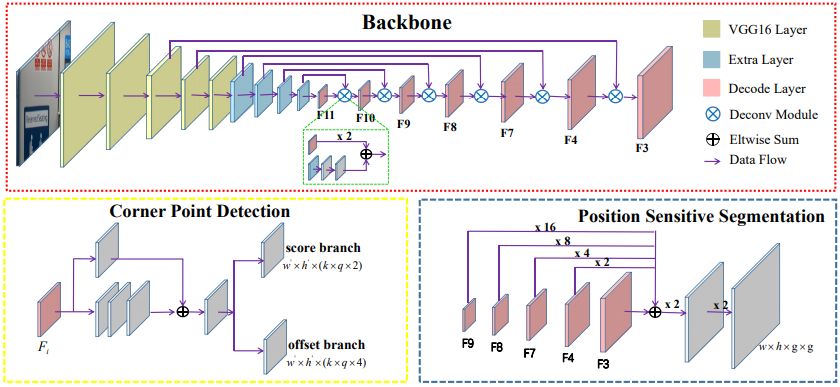

紙やシャツなど柔軟な物体に対する形状変化を3次元的に捉える手法を提案した。従来法とは異なり、表面形状に関してテンプレートを準備する必要がないこと、テクスチャ欠損や部分的オクルージョンに対して頑健である。幾何的な変化を捉えるために、基本的に深層学習をベースとしており、2次元画像でのメッシュ検出、3次元形状の復元を実行する。形状変化、材質、テクスチャや照明条件の変化が入る空間を含んだ大規模データセットにて深層学習アーキテクチャをEnd-to-Endで学習。右図は提案手法の概要を示している。ネットワークは主に2次元画像中で位置を特定する2D Detection Branch、3次元的な幾何情報を復元するDepth Branch、非剛体形状を復元するShape Branchから構成される。

End-to-Endかつリアルタイムな3次元表面形状復元手法を提案。実空間にて撮影したベンチマークにてState-of-the-artな表面形状トラッキングを実現した。現在まではEnd-to-Endな学習が難しいとされていたが、幾何的な情報を復元するに特化した構造とそのためのデータベースを構築したことが評価された形となった。

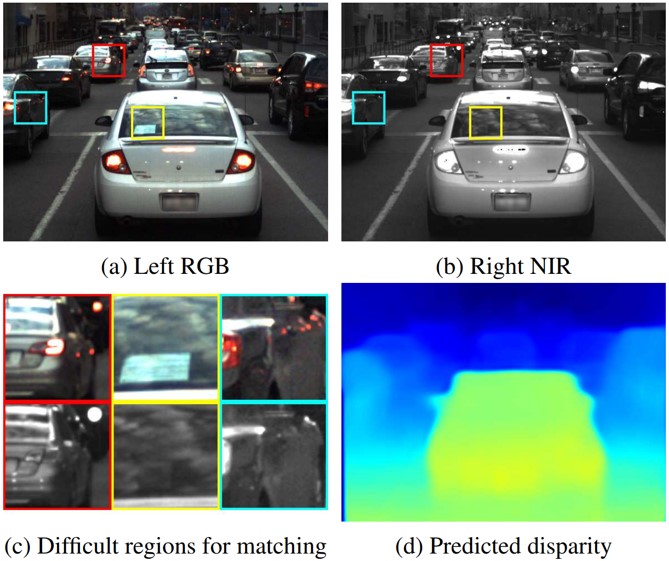

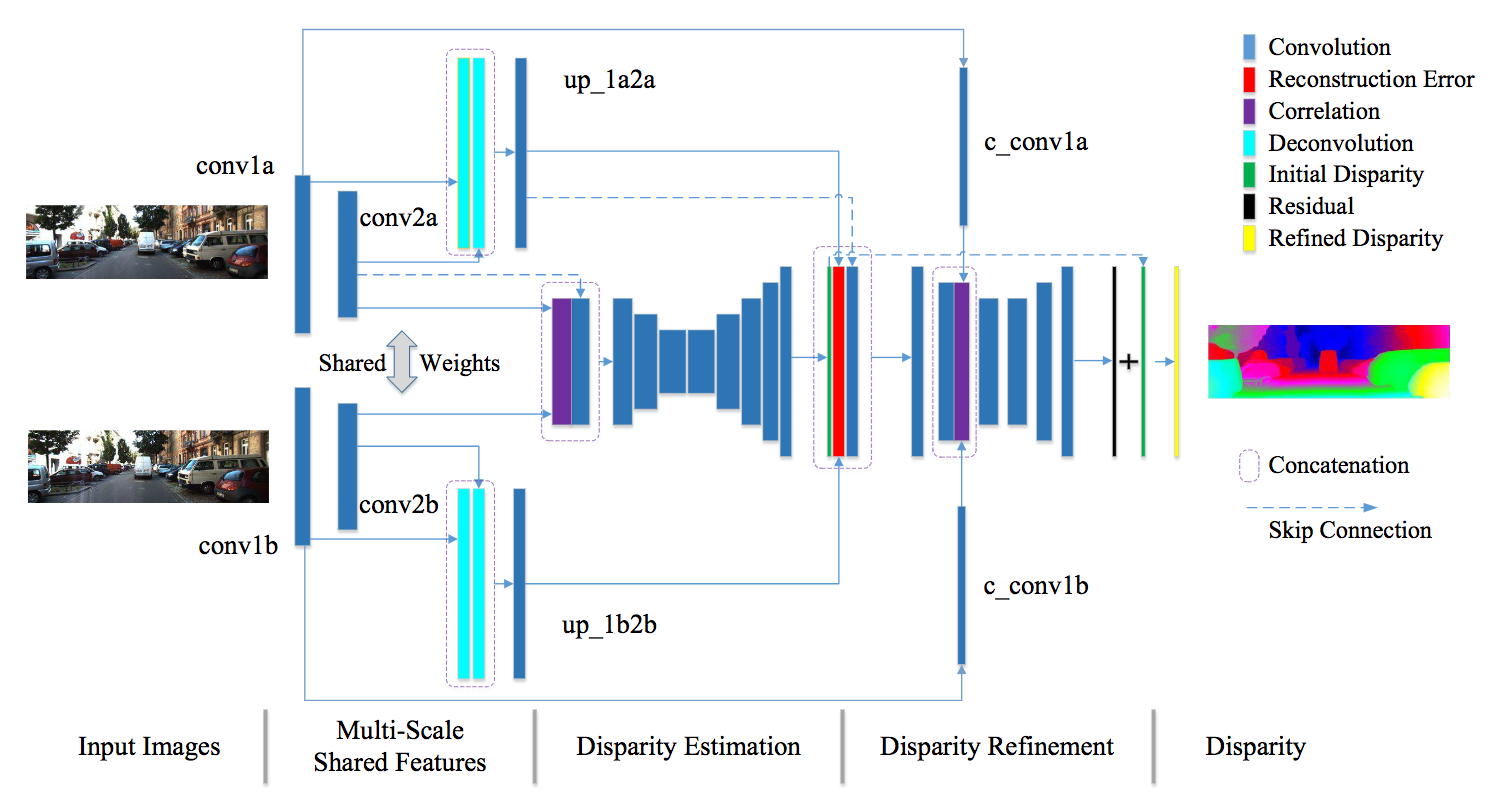

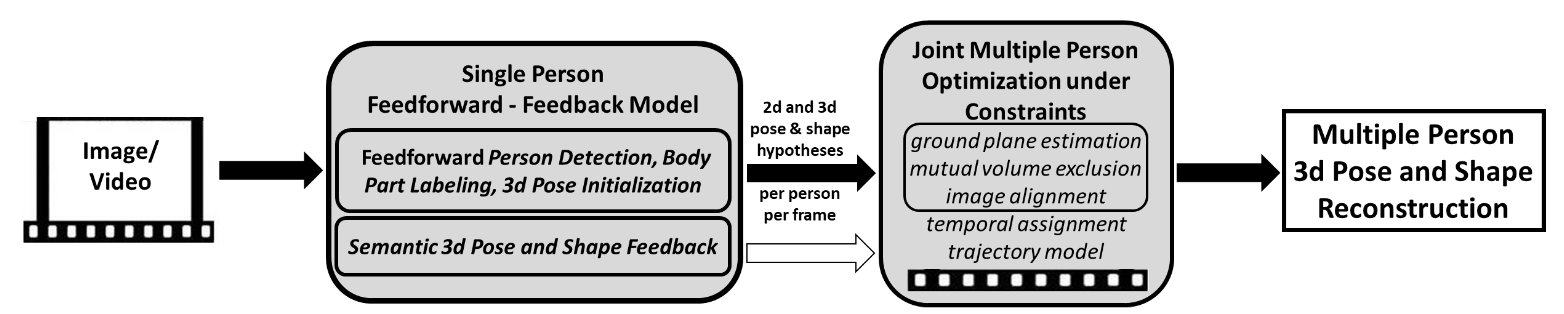

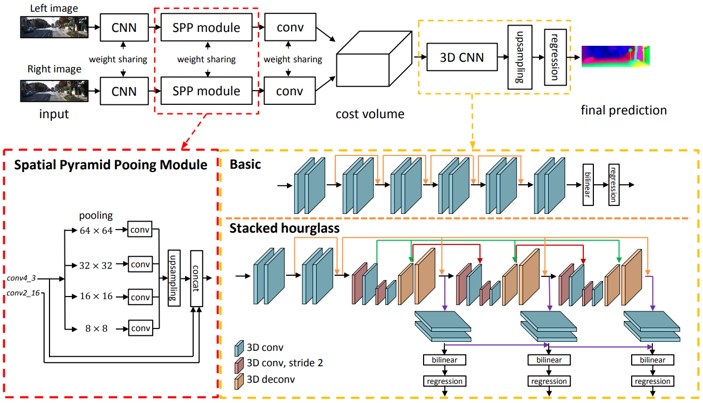

CNNのフォワード(のみ)によりステレオマッチングの出力である距離画像を出力する取り組み。従来のステレオマッチングでは左右画像マッチング、視差計算、距離画像修正により構成されていたが、CNNにより大幅に処理コストを削減する。提案のネットワークでは4つのパーツから構成され、マルチスケールで重みを共有しながら特徴計算を行い(Multi-scale Shared Features)、左右画像のマッチング(Disparity Estimation)、距離画像修正(Disparity Refinement)、距離画像の最終出力(Disparity)を実施する。アーキテクチャについては右図に記載されている通りである。

距離画像計算を一回のCNNのフォワードで実施するネットワークを構築し、ベンチマークであるScene FlowやKITTI datasetにて(論文投稿時)State-of-the-artな精度を実現した。グレースケールの色の一致性、勾配の一致性や特徴空間における恒常性(Feature Constancy)を考慮した結果、CNNによるステレオマッチングの出力が向上したと主張。

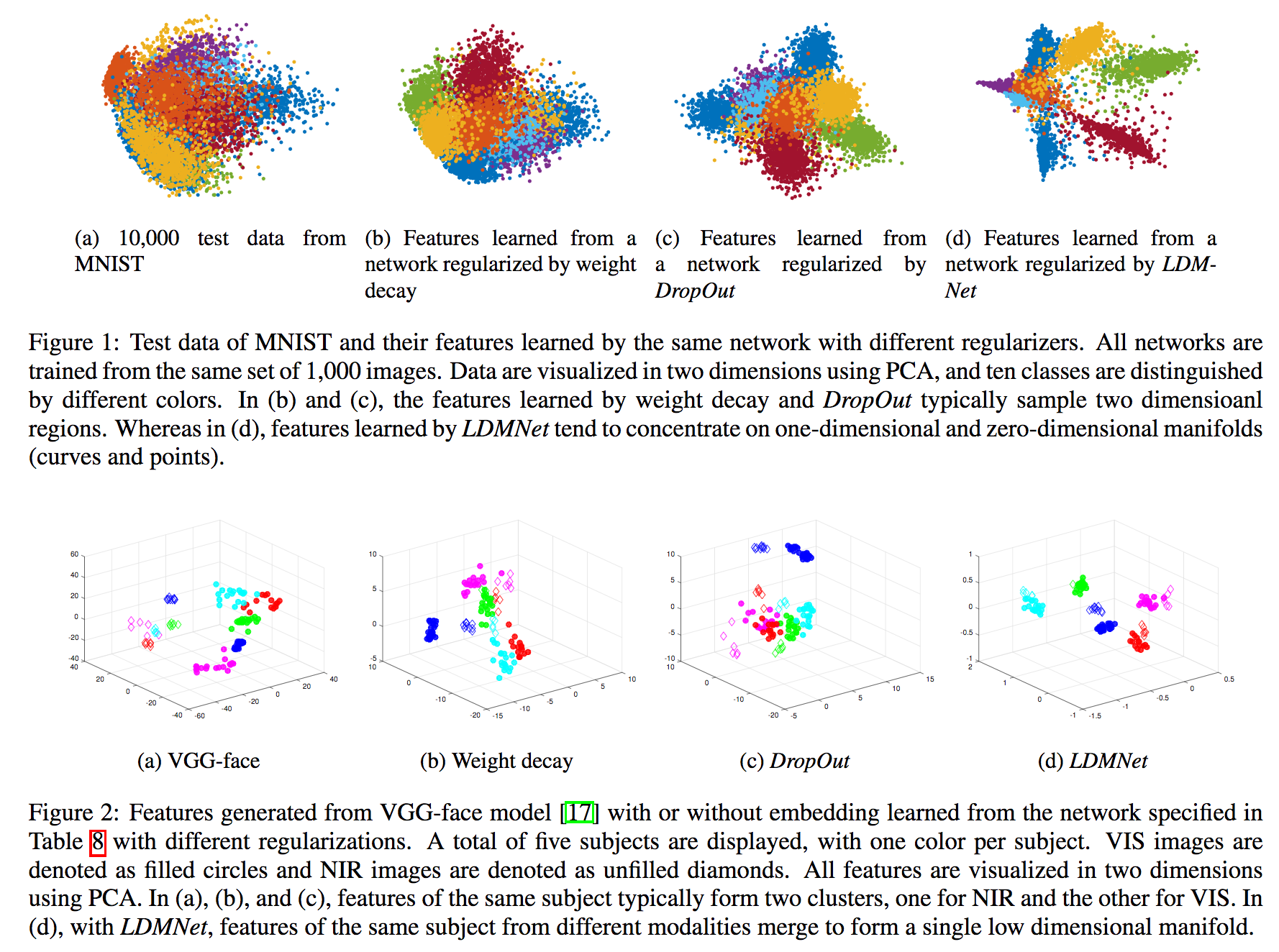

データの数や質によってはオーバーフィッティングを起こしてしまうが、本論文ではLow-Dimensional Manifold-Regularized Neural Network (LDMNet; 低次元の多様体により正則化を実行するネットワーク)を提案することで特徴量や入力データに対して正則化を行う取り組みである。外的なパラメータなしに多様体を探索することが望ましいが、ここではEuler-Lagrange方程式は計算的な複雑性を上げることなくポイントクラウド計算にてLaplace-Beltrami方程式と等価(ここ自信ない)であることを示した。実験においてLDMNetは異なるモダリティ、例えばCross-spectralな顔認識において有効であることが判明した。右上図はweight decay/DropOutなどによる正則化手法と比較した結果である。LDMNetは特徴量をもっともよく識別する空間に配置する多様体を構成できている。

低次元の多様体空間を構成することで、入力データには(できる限り)依存せずデータ/特徴空間に関する正則化を行うことができるLDMNetを提案した。より少ない画像枚数の学習にて良好な精度を実現することが明らかとなった。各カテゴリ50枚のMNIST学習にて95.57%を実現(ベースラインは91.32%/92.31%)した。

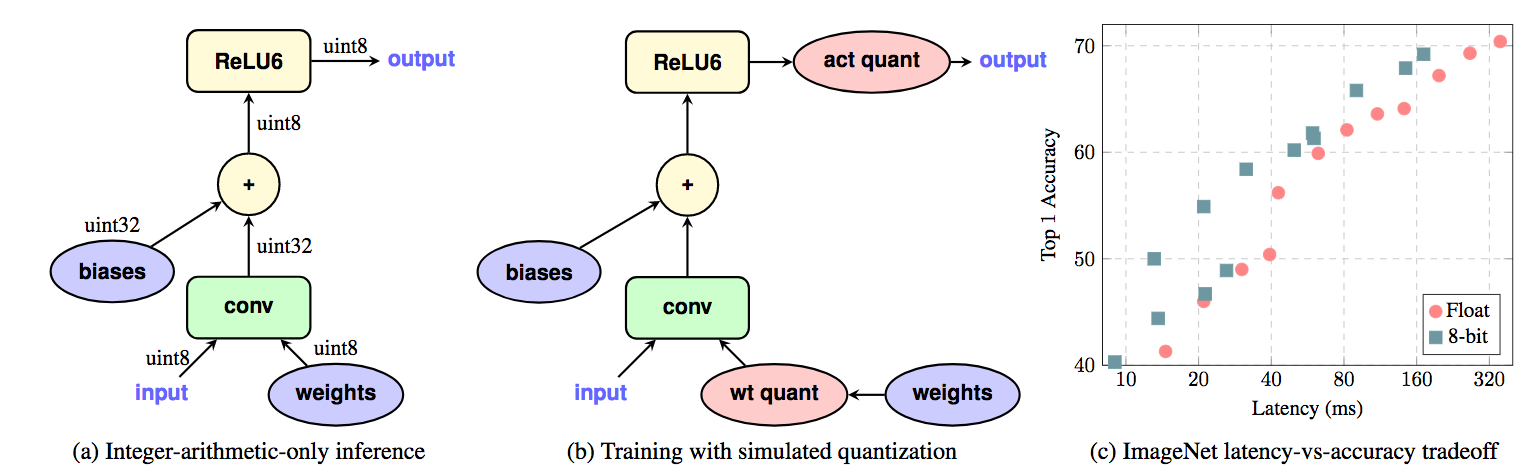

Integer(int)演算によるニューラルネットの効率的な量子化および学習の提案である。Int演算でFloat演算よりも効率的な計算を可能とした。同様に、End-to-End学習についても精度を保持しつつ演算の高速化にも成功、accuracy/latencyのトレードオフについても効率的な解決策となった。関連研究であるMobileNetについても効率化に成功し、ImageNet/MSCOCOにてCPU実装をデモした。

8ビットInt型の演算のみでニューラルネットの学習を実施。学習/推論においてFloat型の精度/速度を凌駕する性能を発揮した。さらに、MobileNet等の効率化されたアーキテクチャについてもより効率化を実現した。

さすがにGoogleは保有データのみでなく、アルゴリズム面においてもトップを行っている。データあり、資源あり、人ありでその上分野を網羅的に攻めることができている。

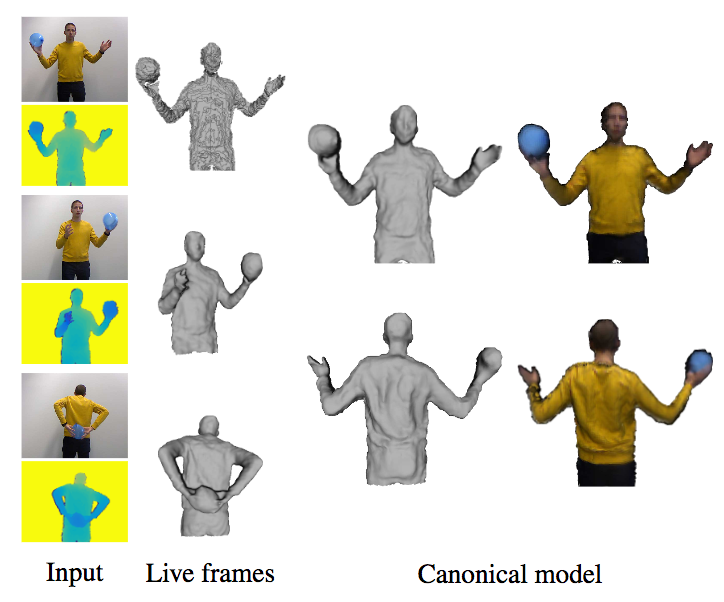

非剛体物体の3次元再構成について、人物のみでなくインタラクションしている物体に対しても密な復元を行う手法SobolevFusionを提案。さらに、従来法とは異なり、勾配をL^2の内積で定義し変化をSobolev spaceで扱えるようにしたこと、RGBのテクスチャも貼り付けることが可能になった。Variational Level-setにて領域の切り抜きを実施し、復元方法はTruncated Signed Distance Field (TSDF)を投影することで行われる。この流れはDynamicFusionやKillingFusionから来ている。

DynamicFusion/KillingFusionを改良したSobolevFusionを提案した。変化した3D空間をSobolev空間で扱えるようにして動的な空間に関して詳細まで復元することに成功した。

ピクセル同士のマッチングをピクセルの共起性に着目して行う手法を提案した。ピクセルの出現頻度で正規化された共起行列を用いることでテンプレートマッチングを行う。 その際、Multi-dimensional scalingを用いてマッピングを考えることで、画像を別空間に投影して扱うことを可能にする。

![]()

RGB空間だけでなくDeep featuresなどピクセルとして表現されるあらゆるものに適用可能である。したがって、これまでに提案されてきたあらゆるCVの手法(論文中ではLucas-Kanade法及びKCF trackerを紹介)を使用することが可能である。

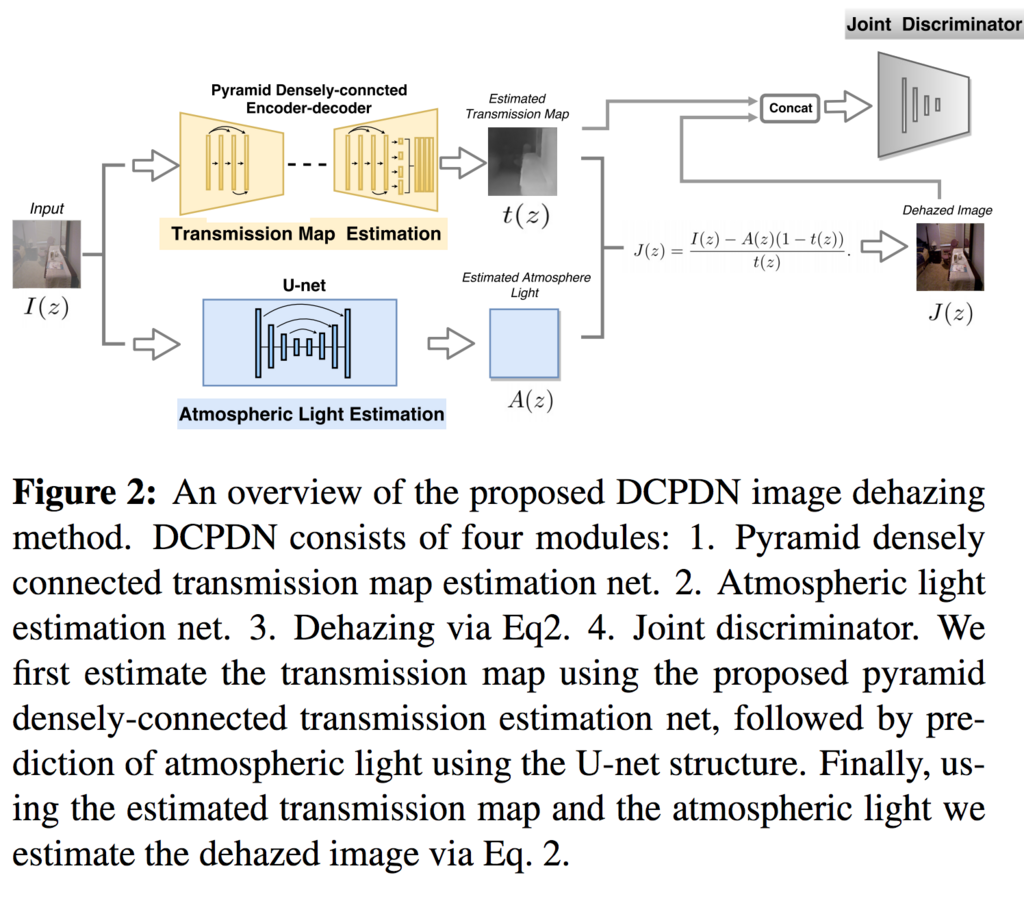

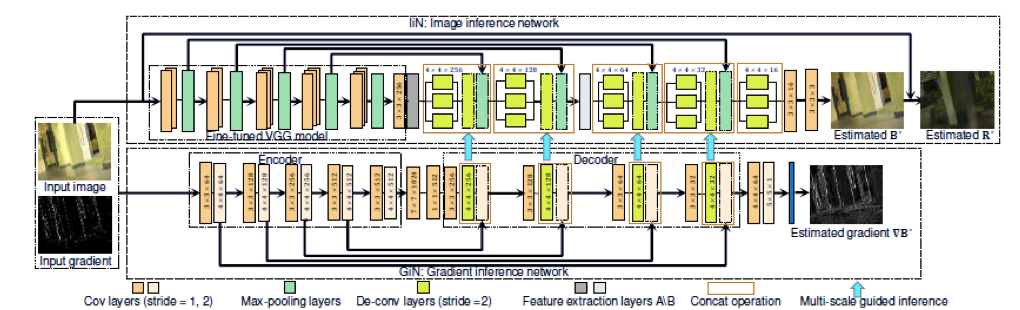

霞んだ大気が写っていると認識タスクなどではノイズとなりうるケースがあり、除去する必要がある。そこで以下の手法を用いてSoTA達成し、End2Endで学習を行える除去方法を提案した。 画像を数式化し、それを解く手法をDensly Connected Pyramid Dehazing Networks(DCPDN)とした 霞んだ画像のEdgeなどの構造(TransmissionMapEstimation)と、霞など(AtmosphericLightEstimation)に分離して特徴量を獲得し、それら2つからDehazeImageを作成。 その後、DehazeImagerとEstimation、2つのペアの構造が似ているかをJoint-Discriminatorで識別し学習する。 また、Edgeは画像に分け目でありImageGraduentsに特徴付けらること、輪郭やEdgeのようなlow-levelな特徴量はCNNの最初の方の層で抽出されることの2つの背景から Edgeの特徴量を豊富に学習できる、ImageGradientを取る関数、VGGでcontent featureを取る関数の和であるEdge-preserving Lossを提案を提案した。

SSIMでの比較結果が最も高く、結果を見ても綺麗であった。Edge-preserving LossとJoint-Discriminatorがうまく寄与していた。

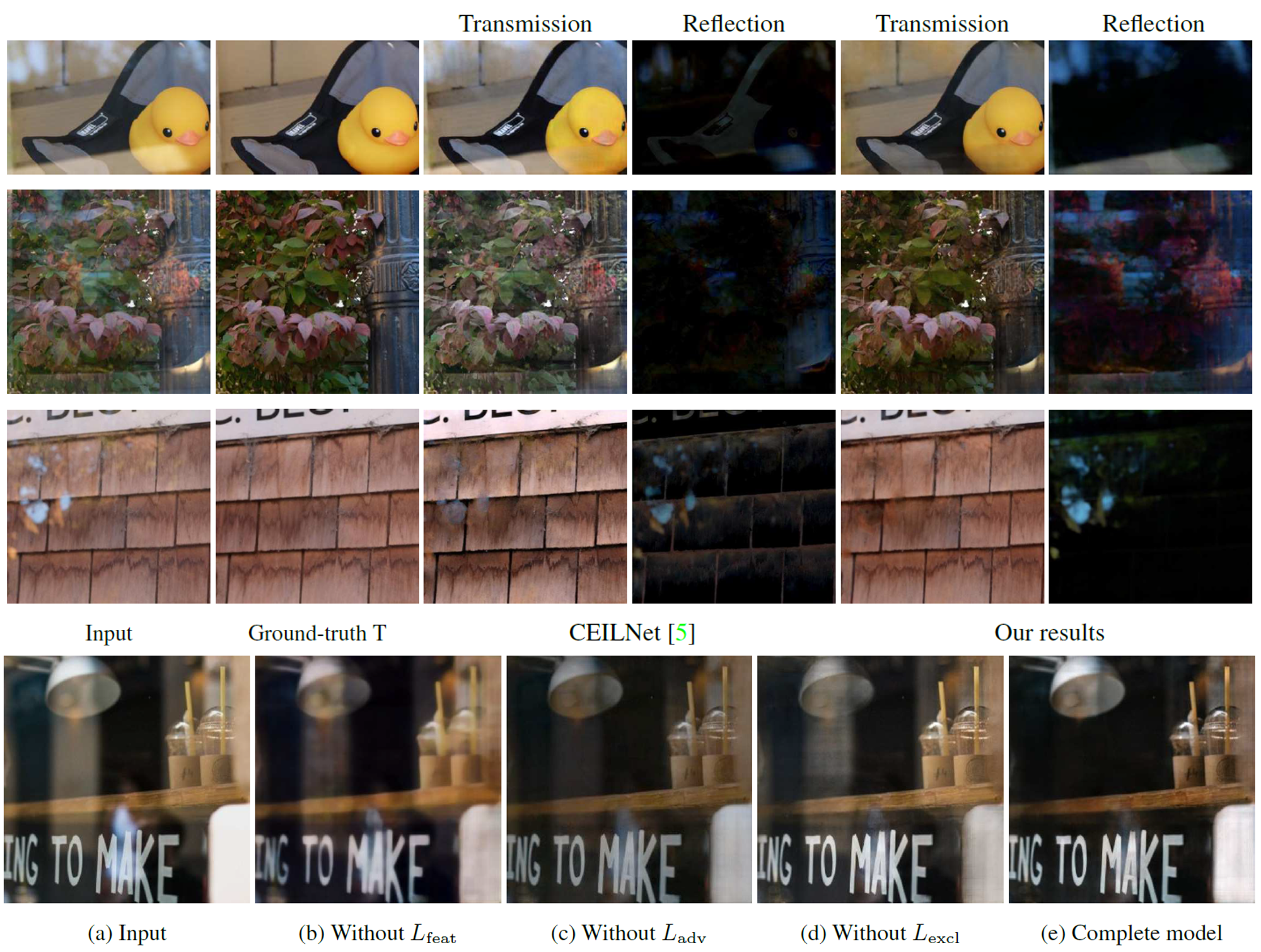

画像内のガラスの反射は,CV分野にとって脅威となる.この問題を解決するためにConcurrent Reflection Removal Network(CRRN)を提案.人間の知覚に影響を考慮したロス関数を用いて、画像の外観情報とマルチスケールの勾配情報を統合し、多様な実世界のシーンで撮影された3250枚の反射画像を用いて学習したものである.公開されているデータセットを用いて実験したところSoTAを示した.

Person re-identification(ReID)のためのdata augmentationの方法を提案した。ReIDの難しさの一つとして、カメラの違いなどにより様々なocclusionが発生することである。 そこでocclusionを発生させた学習データを作ることで精度向上を計る。 始めに、通常通りReIDの学習を行うことでネットワークが画像のどの領域に注目するかを調べる。 明らかになった注目領域を塗りつぶすことでocclusionとし、学習しなおすことでocclusionに頑健な学習を実現する。

従来手法では上半身など画像の一部の領域にのみに注目していたため、注目領域にocclusionがあると精度が下がったのに対して、提案手法により画像全体に注目するようになりocclusionに頑健になった。実際、Rank1 accuracy, mAPどちらもベースラインと比べ数値が向上したことを示した。

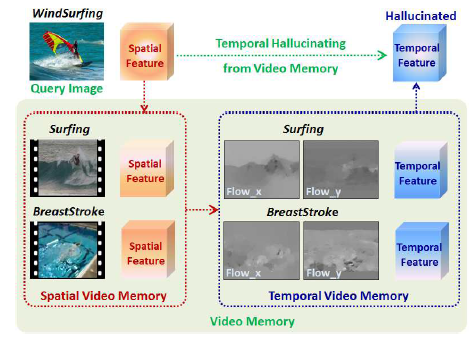

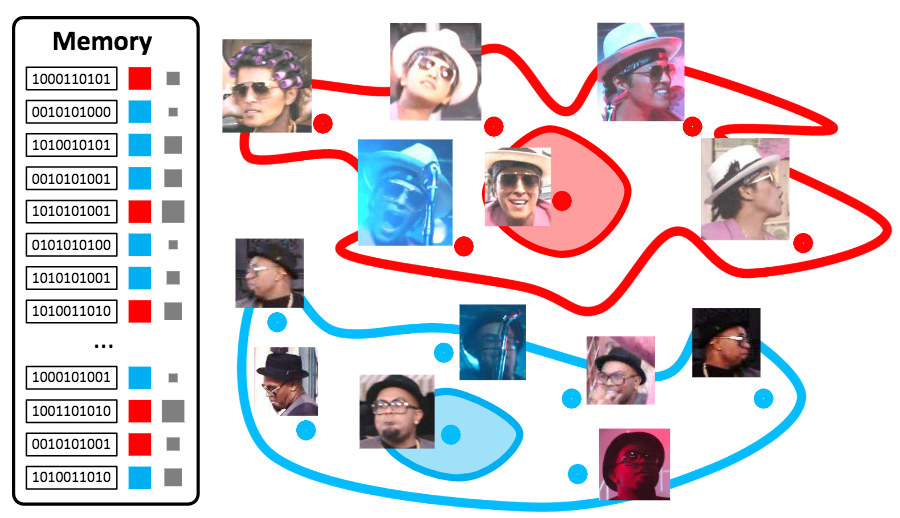

1枚画像からの行動認識を、類似する動作の記憶を手がかりに行うHybrid Video Memory(HVM)を提案した。 人間は未知の光景に遭遇したとき、過去の記憶を手がかりに類似したものから類推することができる。 HVMは人間のこのプロセスを模倣し、数枚しかない学習データを類似する動作と関連付けることで学習を可能にする。 学習済みTwo-stream CNNに1枚画像を入力し、Memory動画とSpatial Featureを比較することにより類似する動画へ重み付けを行う。 この類似する動作から得られるTemporal Featureの重みつき和を入力画像のTemporal Featureにする。 行動の予測は得られたTemporal Featureと学習画像及びMemory動画のTemporal Featureの類似度により各動画への重みを決定し、学習画像及びMemory動画のラベルの重み付き和を出力ラベルとする。

UCF101をMemory動画として、WEB101, VOC, DIFF20の3つの画像データセットに対する行動予測を実施。いずれのデータセットに関しても、従来手法と比べ提案手法が最も精度が高い(WEB101 35.4%, VOC 42.2%, DIFF20 60.2%)結果が得られた。

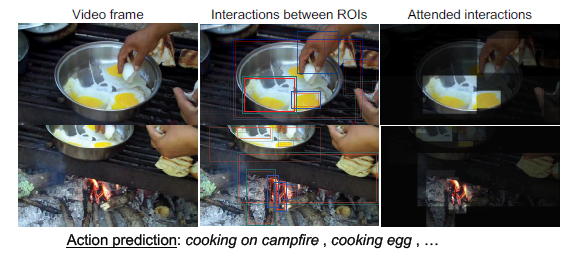

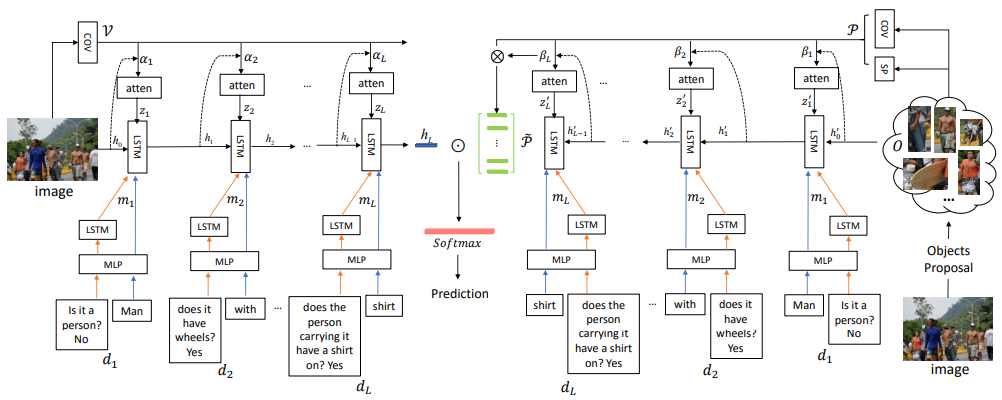

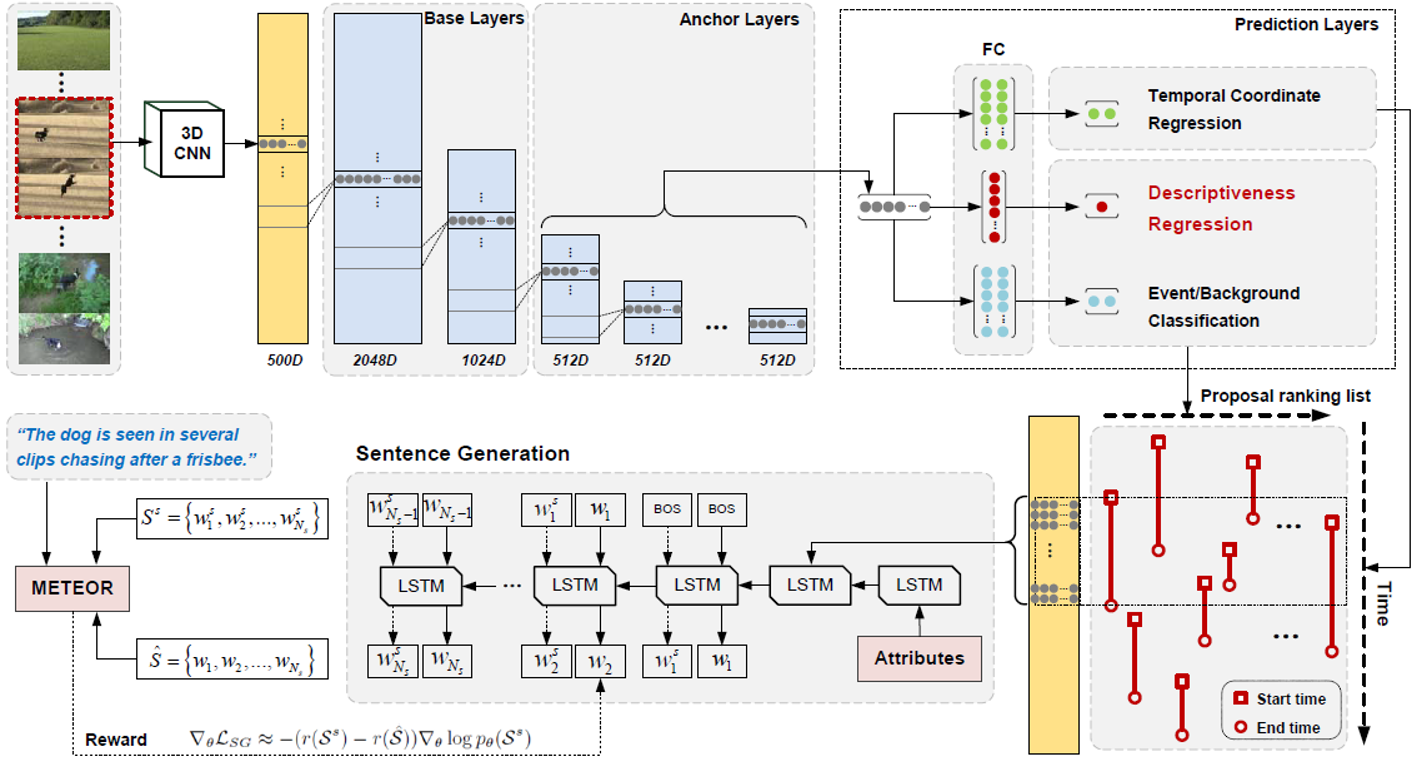

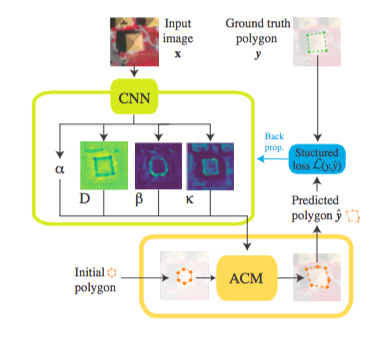

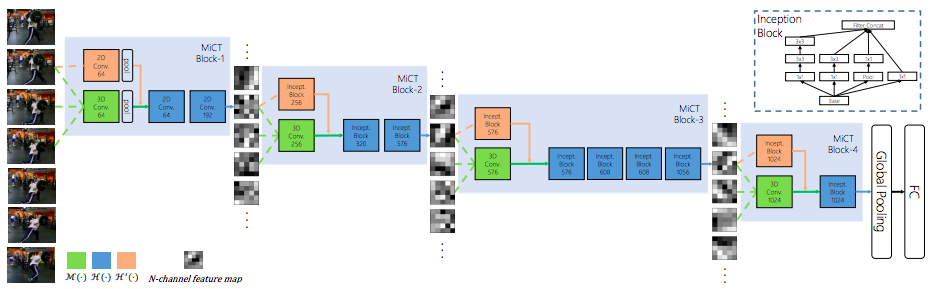

動画認識のために物体同士のinteractionを表現する方法を提案した。画像中の物体同士の関係を記述する方法は多く提案されているが、動画の場合全フレームに適用してしまうと情報量が多すぎて現実的ではない。 そこで動画に写っている物体同士の関係を高次な特徴として取得することで動画認識に利用する。 動画の各フレームから物体認識によりROIを取得し、K個のMulti Layer Perceptronに画像特徴とLSTMの過去の出力を入力する。 得られた各特徴をLSTMに入力することで物体同士の関係を表すattentionを得る。

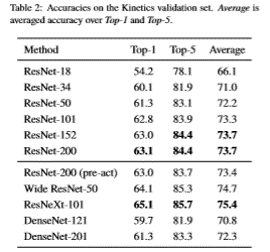

論文中ではAction Recognitionとキャプショニングの2つのタスクを提案した。Kineticsを用いたAction Recognitionは、既存手法(1FPSにサンプリングした)よりもTop1, 5共に提案手法の方が精度が高い。 キャプショニングはMETEOR, ROUGE-L, CIDEr-D, BLEU@Nの4つのデータセットで実験をし、Validation setの精度は向上したがTest setの精度が高いLSTM-A3には劣る部分がある。

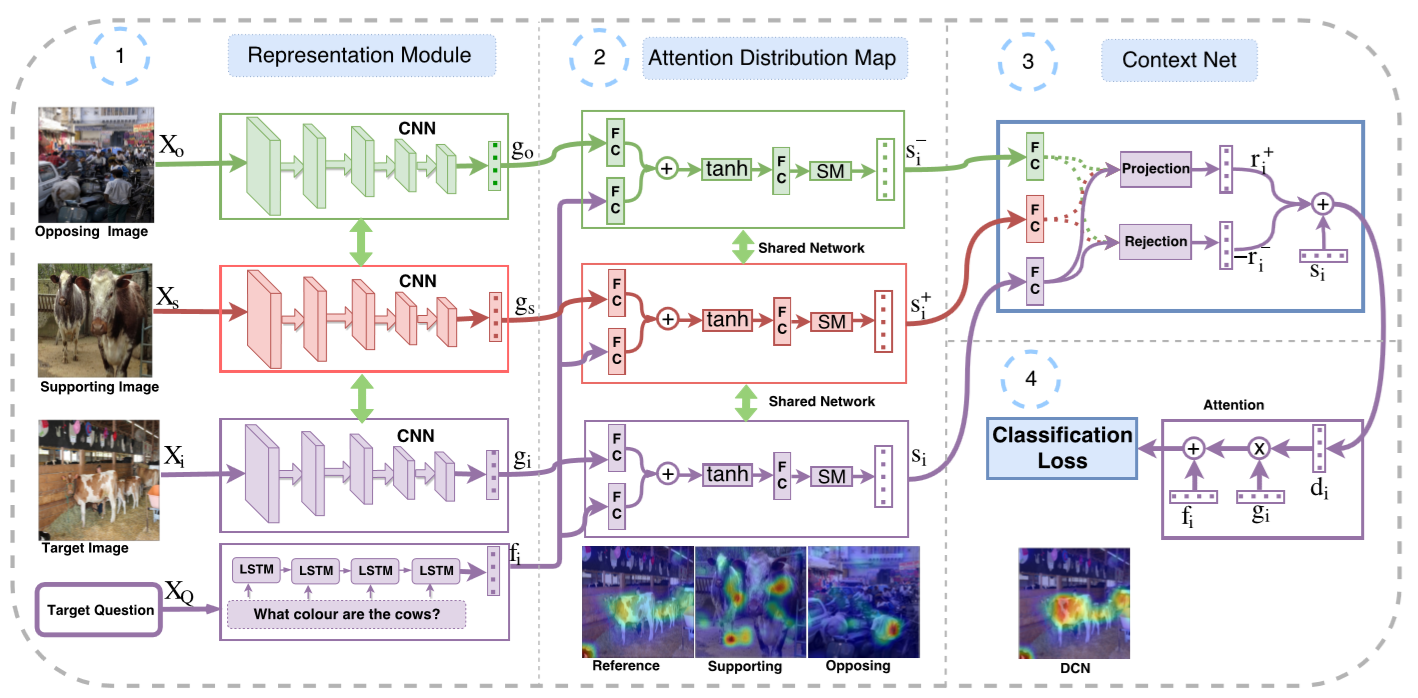

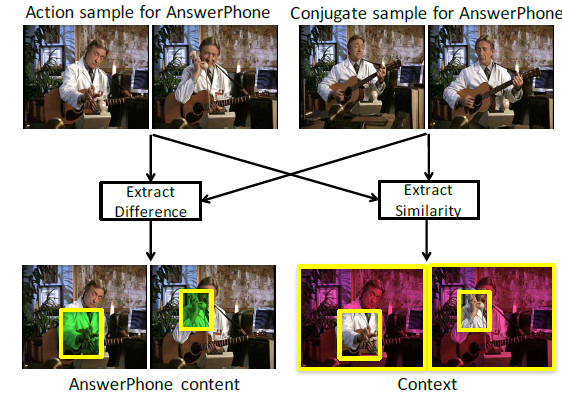

動画中からコンテキスト情報を取り除き動作そのものから行動を推定する手法を提案。行動認識において、背景などのコンテキスト情報は識別のための重要な手がかりである。 しかし、学習データが似たようなコンテキストのものを多く含んでしまうと、実際には動作が違うにもかかわらず背景などによって異なる動作を認識してしまう。 そこで動画を行動とコンテキストに分解し、行動のみから識別を行う。 行動とコンテキストそれぞれのラベルをつけた学習データを用意するのは困難なため、同じ動画からアクションを含む部分(action sample)と含まない部分(conjugate sample)を考える。 ネットワークとして行動に関する特徴とコンテキストに関する特徴を抽出するものを考える。 行動特徴に関しては、conjugate sampleには注目のアクションを含まないため2つのsampleから抽出した特徴が類似しないように学習する。 一方でcontext sampleに関しては2つのsampleは背景などを共有しているため類似するように学習する。 これに加えてaction sampleから得られる2つの特徴を用いた行動識別を考え、classification lossとする。

ActionThread datasetで実験し、13の行動のうち10の行動が提案手法のprecisionが最も高かった。UCF101, Hollywood2を用いてconjugate sampleをaction sampleの隣接するセグメントにとして行った実験も提案手法の精度がベースラインを上回った。

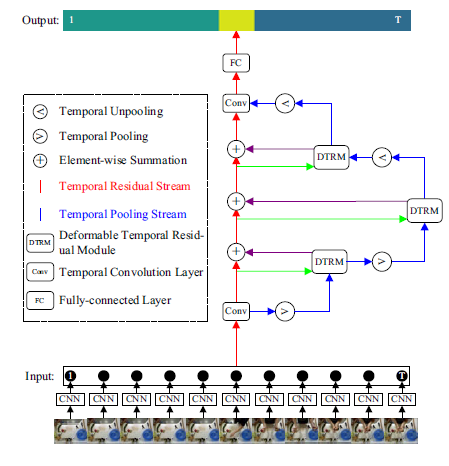

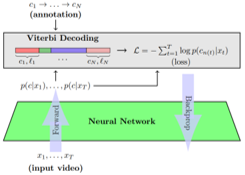

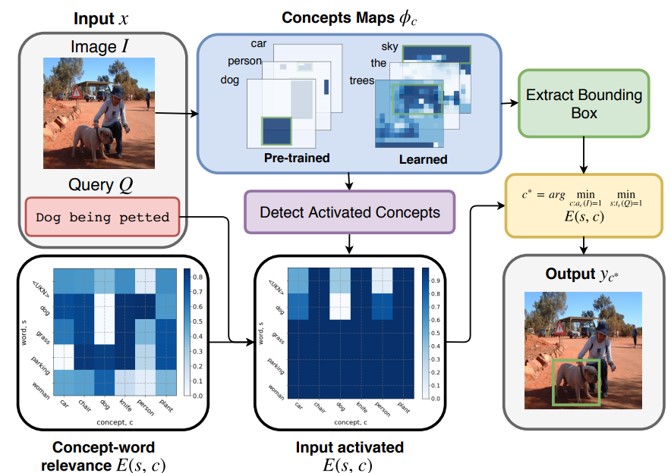

action segmentationのためのネットワーク、Temporal Deformable Residual Networks(TDRN)を提案した。動画の各フレームからCNNにより抽出した特徴を入力とし、two-streamの構造で特徴を処理していく。 Temporal Residual Streamは、動画のfull scaleのコンテキスト情報を解析する。 Temporal Pooling Streamは、時間方向のPooling, Unpoolingを複数回施すことにより時間方向に関して様々なスケールのコンテキスト情報を解析する。

従来のネットワークは1つのstreamで処理するのに対して提案手法は2つのstreamで処理する。さらに2つのstreamは独立してるのではなくTemporal Pooling Streamに逐次Temporal Residual Streamから得られた特徴を入力していく。 50Saladas, GTEA, JIGSAWSの3つの動画データセットで評価し、F1, Edit score, Accuracyの3つの指標いずれも従来手法よりも向上した。

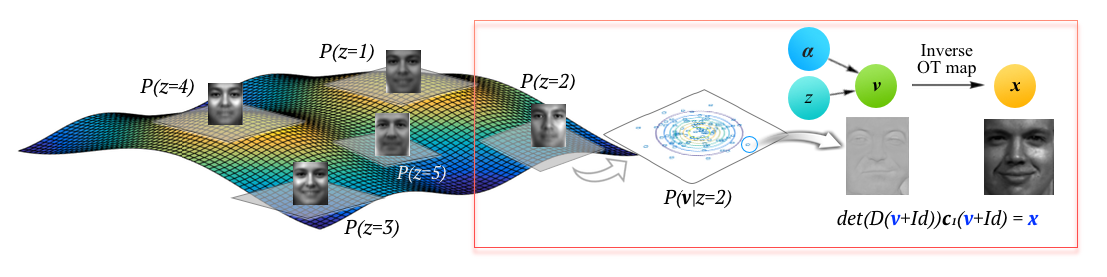

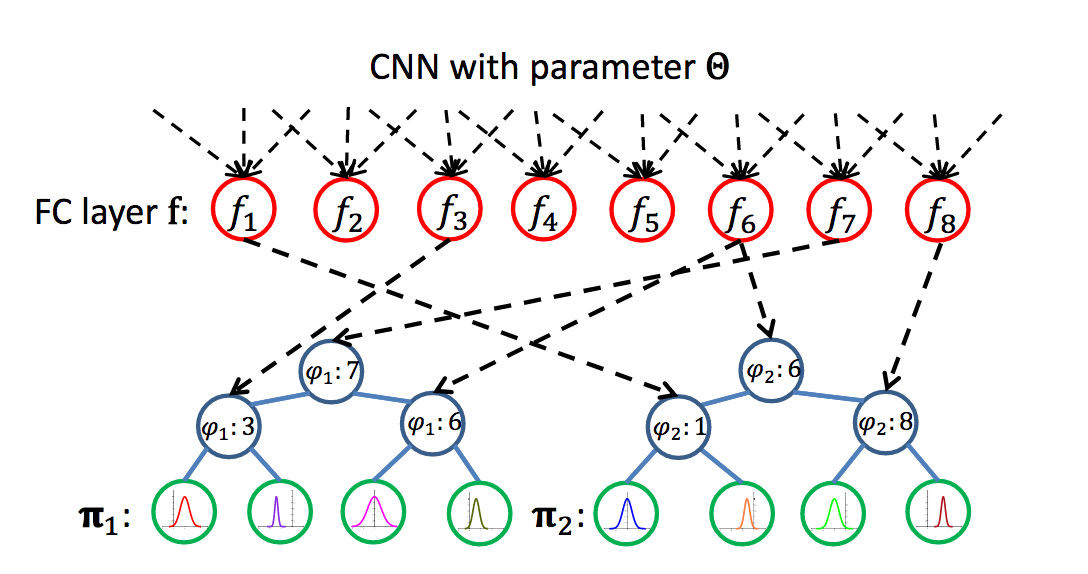

Kantorovich-Wasserstein metricに基づいて高次元データを微分同相写像により表現する手法を提案した。K-meansによりクラスタリングされたK個の接平面毎にテンプレートとなるベクトルをprobablistic PCAにより学習する。

MNIST, ADNI PET, NUCLEIの3つのデータセットにより評価。少ない学習データから提案手法によりデータ数を増やし識別タスクの精度を上げることに成功した。 確率モデルを考えるためBayesian Classificationを可能とし、Logistic Regressionより精度が高いことを確認した。

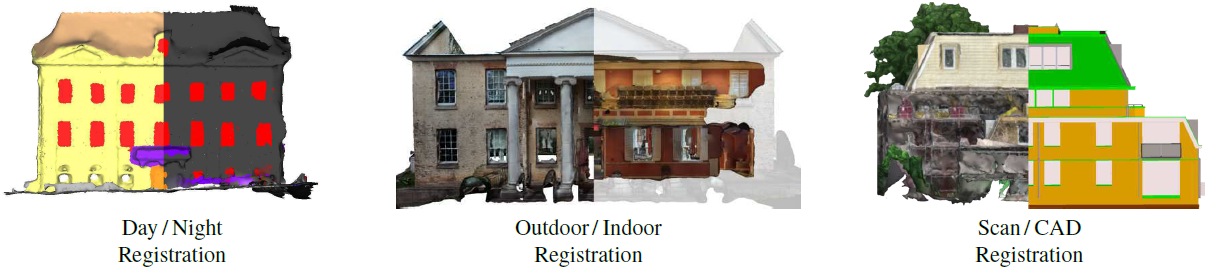

DayとNight、OutdoorとIndoorなど2種類の3次元モデルのregistrationをする手法を提案した。入力として3次元のsemantic labelを考え、各ラベル領域の点郡を楕円によって近似する。 このとき、点郡から得られるConvex Hullの内側の楕円Inner Ellipsoidと外側の楕円Outer Ellipsoidを考える。 2つの3次元モデルsourceとtargetの楕円をそれぞれInnerとOuterと考え、InnerがOuterの内部に存在する場合をラベル同士が対応していると考える。 この対応してる楕円の数が最大になるような変換を考えることでモデル間のregistrationを実現する。

合成データのテストでは、楕円数が少ないときは1秒以下で計算が可能であり、多い時でも従来手法よりもoutlier ratioが70%程度までは早い計算が可能である。精度に関してもICPよりRMSEが小さいことを確認した。 リアルデータのテストではrotation errorは最大で3°以下、translation errorとscale errorは3%以下であった。 計算時間はおよそ2から5分程度である。 何故Analyzing Humansのセッションなのだろうか?

3次元の曲線を3次元の表面にregistrationするための手法を提案した。曲線(表面)上の点を、点に加え微分情報を表すvector(法線もしくは接平面)のpoint+vector(2-tuplesと呼ぶ)と考える。 2点の2-tuplesを考え、4つのパラメータにより表現して対応曲線と表面上の点が対応しているかの判定を行う。

ノイズがある場合、ない場合どちらにおいても、元のデータよりも点の数が減っていると従来手法は精度が下がるのに対して提案手法は点の数が少なくなっても精度が下がりにくい。計算時間は、オフラインのプロセスが0.3~1.9sであり、オンラインのプロセスは10^0から10^-1のオーダーで計算できる。 curve vs curveやsurface vs surfaceのregistrationにも発展させることが可能である。

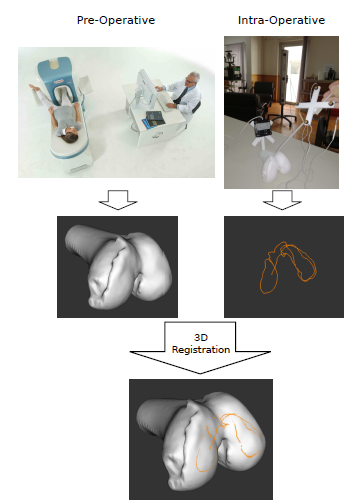

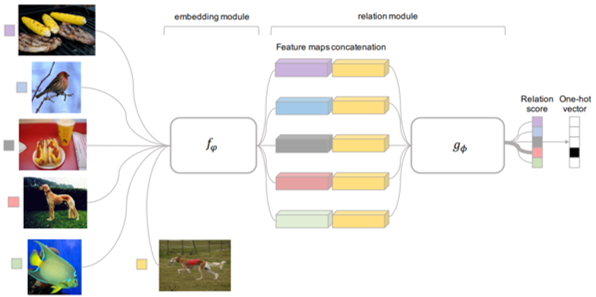

One-shot learningでよく用いられる評価時の設定(C-way k-shot, Cカテゴリで各カテゴリk枚の画像を教師に,入力画像のカテゴリを推定する)と同じ条件で学習を行うため,Memory Networkとbi-LSTMを用いたMemory Matching Networks(MM-Net)の提案. 学習時,学習データから数カテゴリ・カテゴリ毎数枚の画像が教師データとして選択され(support set).embeddingされたrepresentationがmemoryに書き込まれる. 入力画像のカテゴリ推定は,メモリから読み出した各教師画像のrepresentationと,入力画像から得たrepresentationの対応(matching)を取って行う. この際,入力画像からrepresentationを得るCNNのフィルタのパラメータは,メモリから読み出した教師画像のrepresentationの列からbi-LSTMで推定する. 評価時も,学習データからsupport setを選択する操作を除いて,学習時と同じ手順で行う. Omniglotの多くの条件でSOTA,miniImageNetにおいてもSOTA.

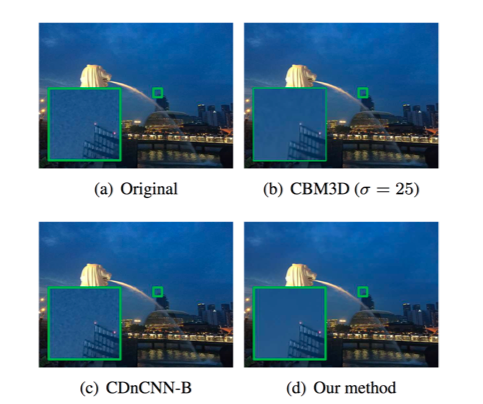

・ 超解像やノイズ除去などのLow-level VisionのためのDualCNNの提案・ DualCNNでは全体の構造の推定,細部の推定をそれぞれ行い超解像やノイズ除去などのタスクに応じた定式化を行い画像の生成を行う

・従来の超解像やノイズ除去はそれぞれタスクに特化したアーキテクチャが考案されていたが,本手法では1つのネットワークで最先端の手法と同等の精度を実現

密集した物体を追跡するタスクを行うため、蜂の巣を撮影し、映像中の蜂についてそれぞれの位置と方向がラベル付けされたデータセットを構築したのち、CNNで追跡するタスクを行った論文。実験の結果、人間と同等の精度で密集した蜂を追跡することに成功した。

![]()

セグメンテーションを行うU-Netの構造と類似しているが、ネットワークサイズを94%削減したネットワークに対して、物体の同定と向いている方向に関する損失関数を設計した。向いている方向の精度を向上させるため、再帰的なフレームワークを導入することで人間と同等の精度を達成した。

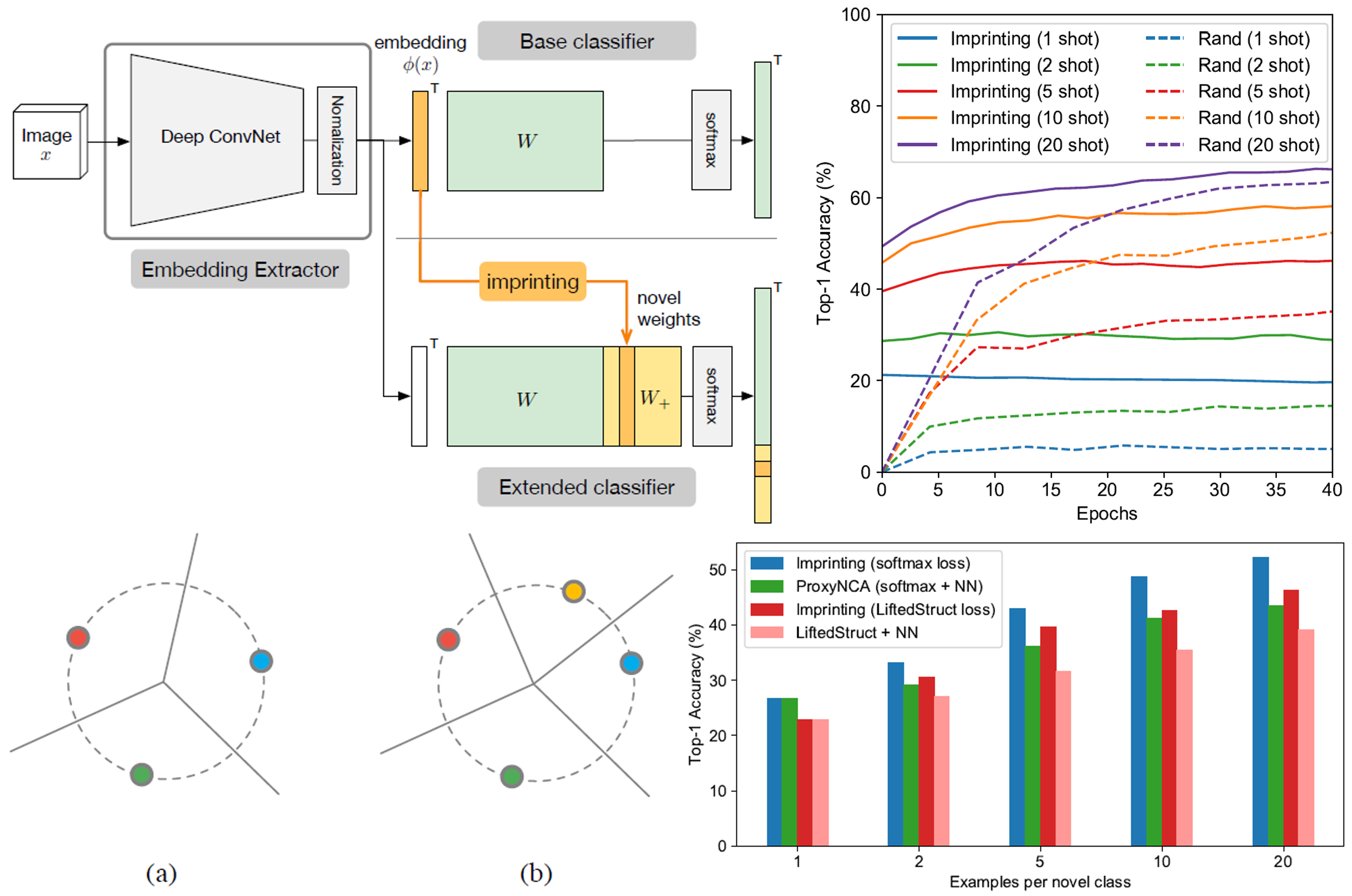

クラス分類タスクに対してLow-Shot Learningを行うためのWeight Imprintingという技術を提案した論文。Low-Shot Learningは予め十分な量のデータが与えられて学習した後に、データ数が非常に少ない分類すべき新しいクラスが与えられ、その上でそれらを分類するタスクである。Weight Imprintingはすでに学習したクラスの部分に変更を加えないため、学習コストが少なく、少ないデータ数で学習可能である。

Weight Imprintingはクラス分類器に適用する手法である。通常のCNNによるクラス分類器と異なる点は、畳み込み層から得られた特徴量を正規化する点と、バイアス項のない全結合層である点である。バイアス項がないため、重み係数は正規化された特徴量のテンプレートとして機能する。したがって、分類すべき新しいクラスが与えられたときに、その正規化された特徴量をそのまま重み係数とすることができる。複数のサンプルが与えられた場合は平均を計算して、重み係数とする。Weight Imprintingはテンプレートとして機能する重み係数との内積をが最大となるクラスを推定結果とするため、Nearest Neightborと同等の機能を持っている。

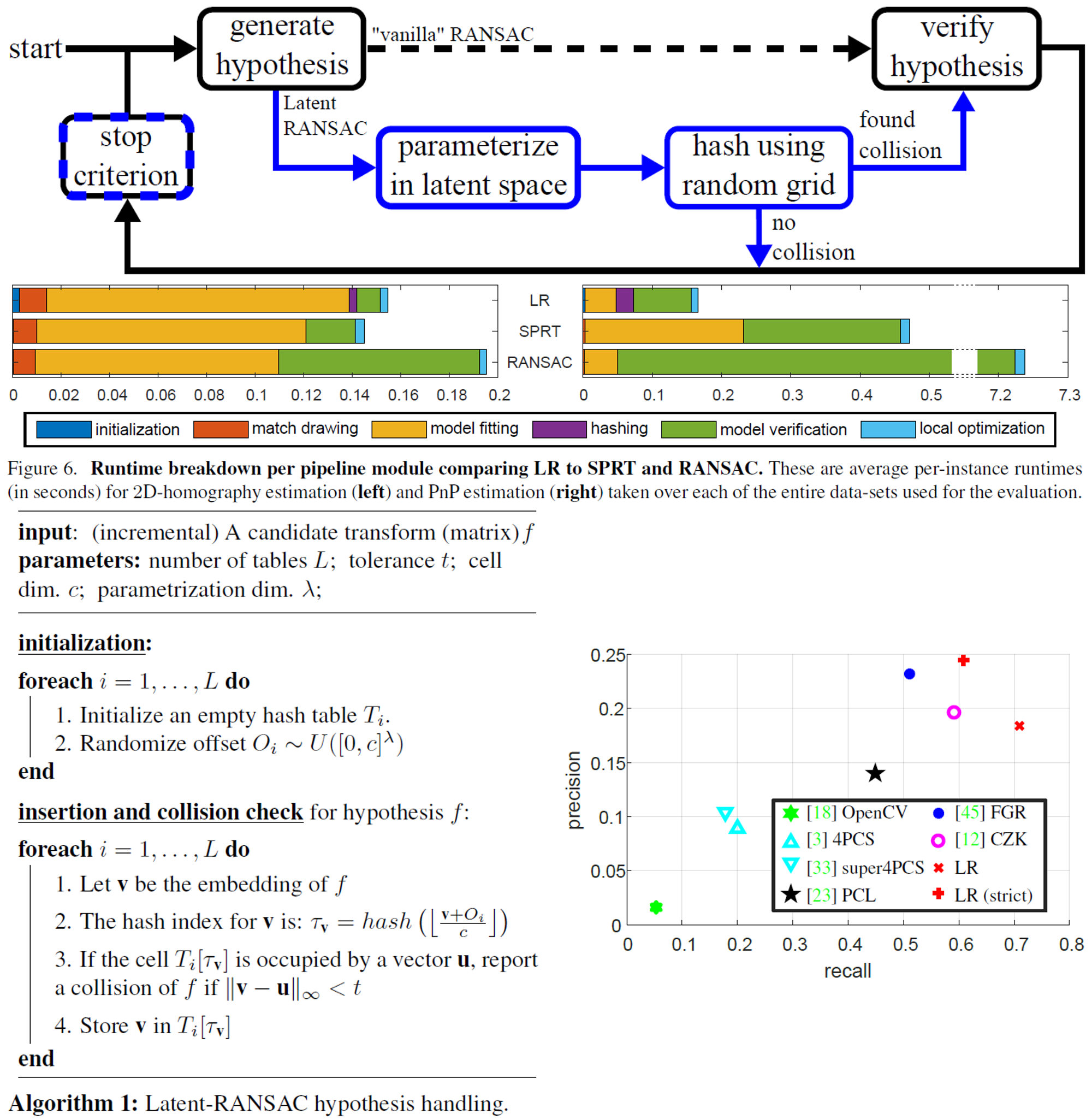

データサイズに依存せず、RANSACを定数時間で行えるようにした論文。RANSACのボトルネックはサンプリングした仮説を検証するステップにあるため、従来その検証を高速化する手法が提案されてきたが、提案手法は検証を行う前に潜在空間でフィルタリングを行うことで妥当な仮説のみを検証することで高速化を行った。

従来のRANSACでは全ての仮説を検証していたが、提案手法ではそれを高速にフィルタリングする。このフィルタリングのプロセスは、まず潜在空間上にパラメータ化し、それに対してRandom Grid Hashingを用いて、現在の仮説がそれ以前に生成された仮設と衝突するか否かを検証することで行われる。この検証前のプロセスの改良に伴い、それに適した探索を終了する基準も提案した。

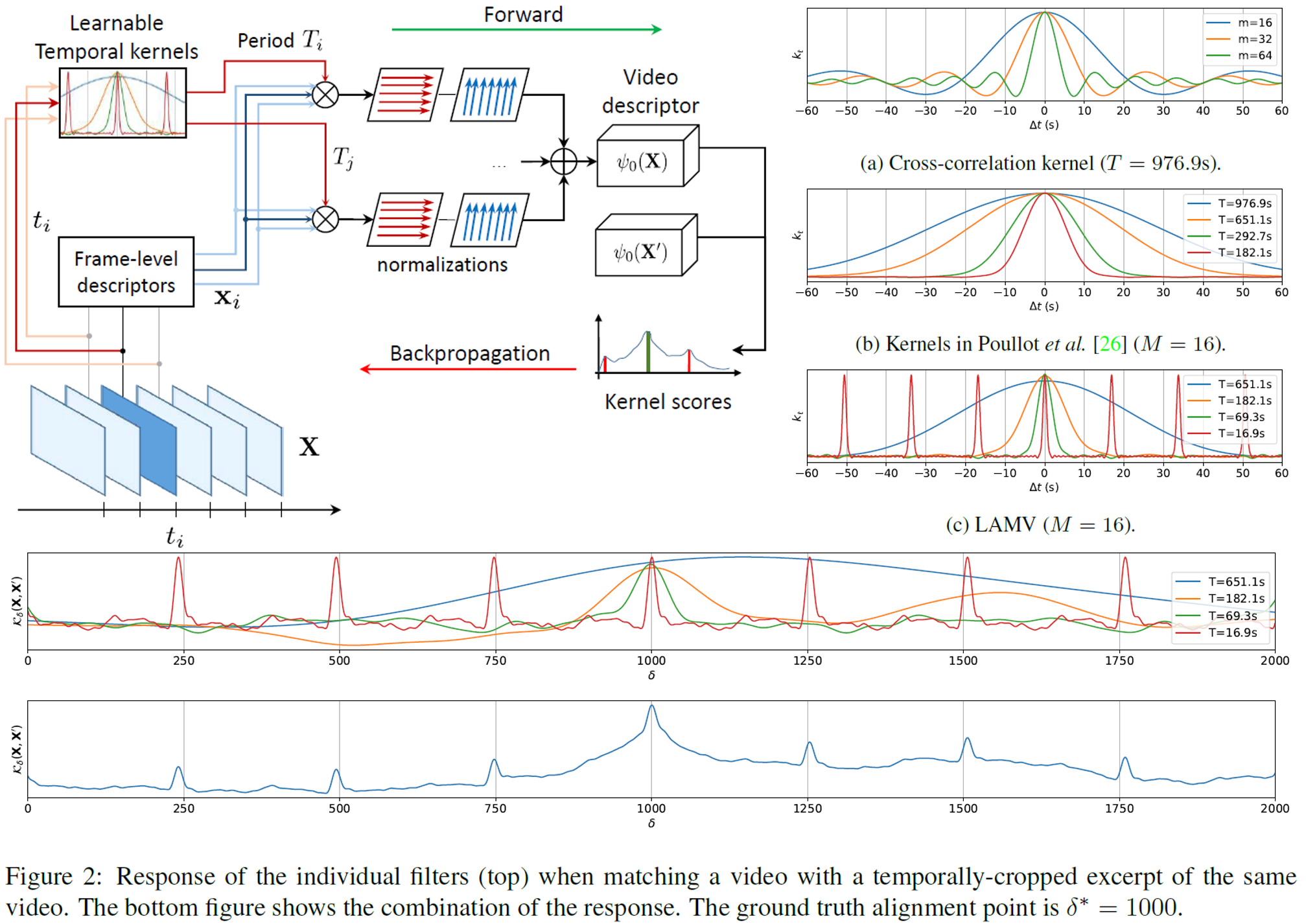

ニューラルネットワークにおけるTemporal Match Kernelを再考し、動画の比較や位置合わせができる学習可能なTemporal Layerを用いた手法(LAMV:Learnable to Align and Match Videos)を提案した論文。Video Alignment、Cody Detection、Event RetrievalのタスクでSoTAを実現した。

同じネットワークを通して得られた特徴量を比較するという意味では、LAMVはSiamese Networkと類似したアプローチである。Temporal Match Kernelを微分可能なレイヤーとすることでニューラルネットワークの導入する。損失関数はベースとなる動画と重複部分を持つ動画と重複部分を持たない動画に対してTriplet Lossを取る。

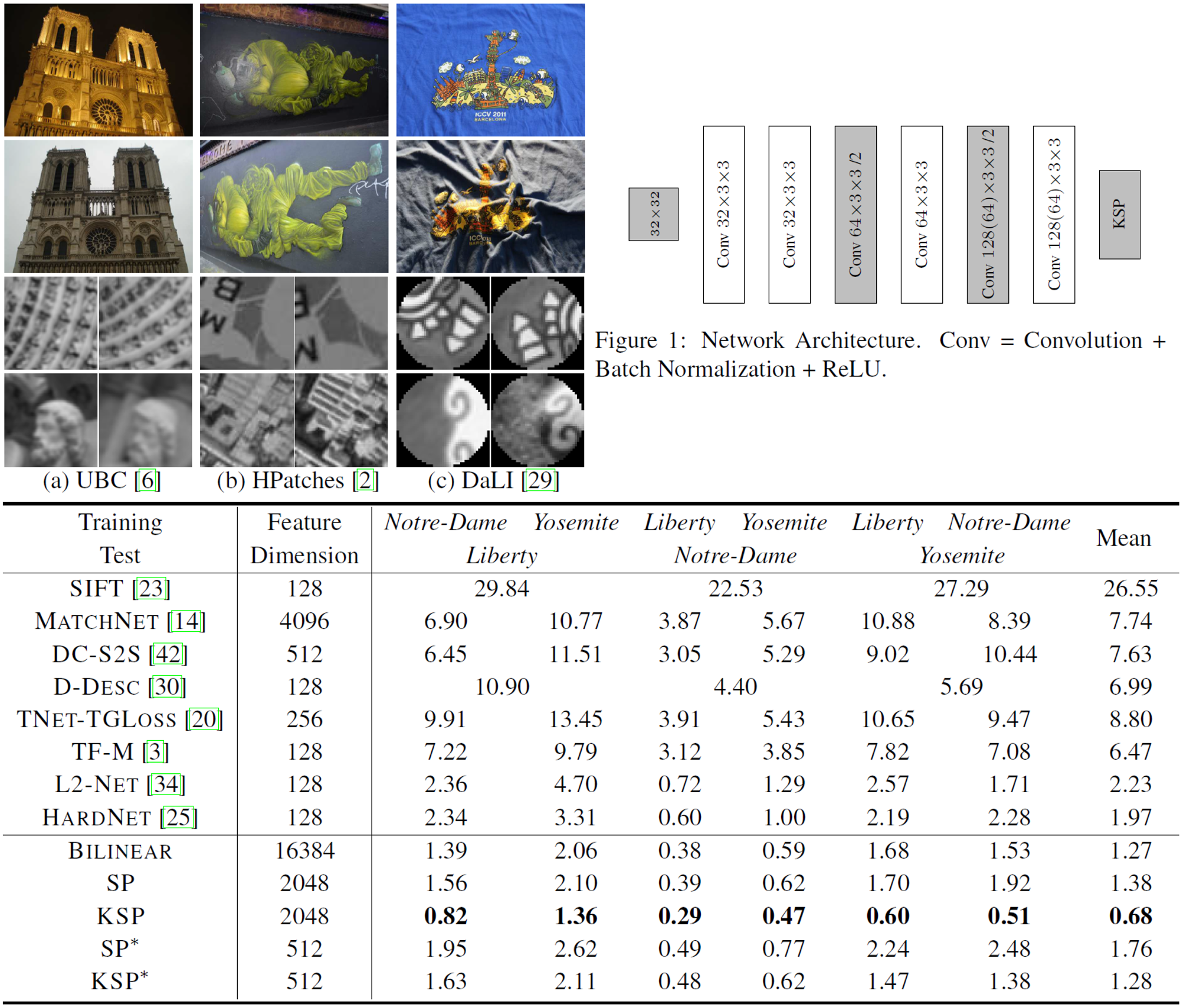

CNNの特徴量表現の識別性能を向上させるため、幾何学的変形に不変なプーリング手法であるSubspace Poolingを提案した論文。さらに精度を向上させるため、Marginal Triplet Lossにカーネル法を適用し、Bilinear Poolingより良い精度を少ないメモリ容量で実現した。

Subspace Poolingは特徴量マップを列成分に並べた行列に対してSVDによって次元圧縮を行う。この方法は、行列の行成分の順列(位置に関する入れ替え)に対して不変である。Patch Matchingのような2点距離を測るようなタスクに対しては、Subspace Poolingで得られた特徴量をガウシアンカーネルを用いたカーネル法を適用することができ、これによりさらに精度を向上させた。

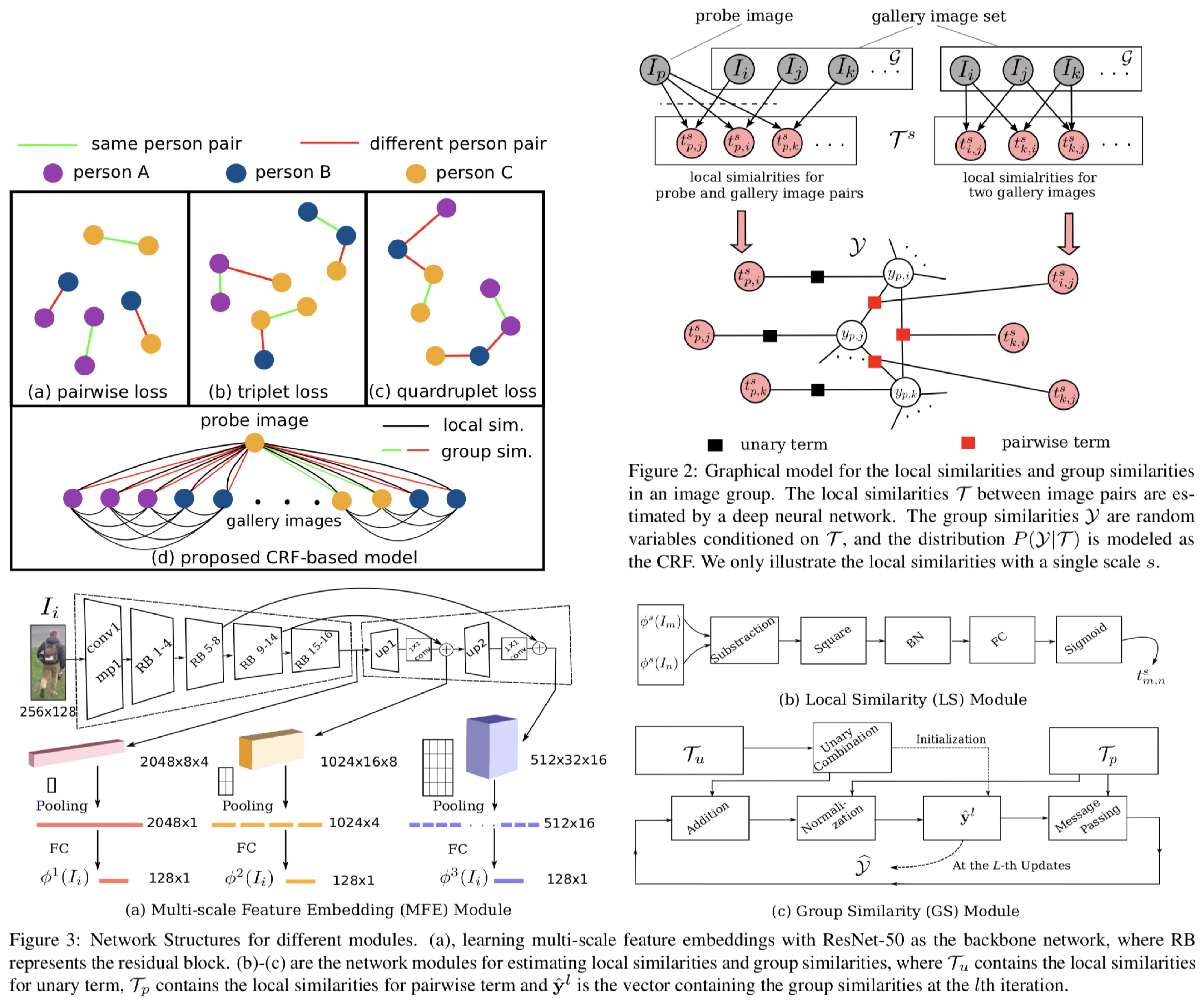

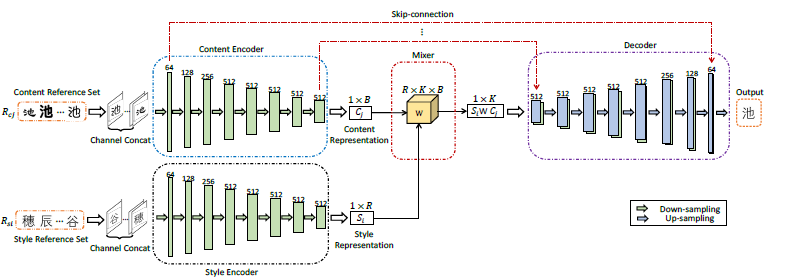

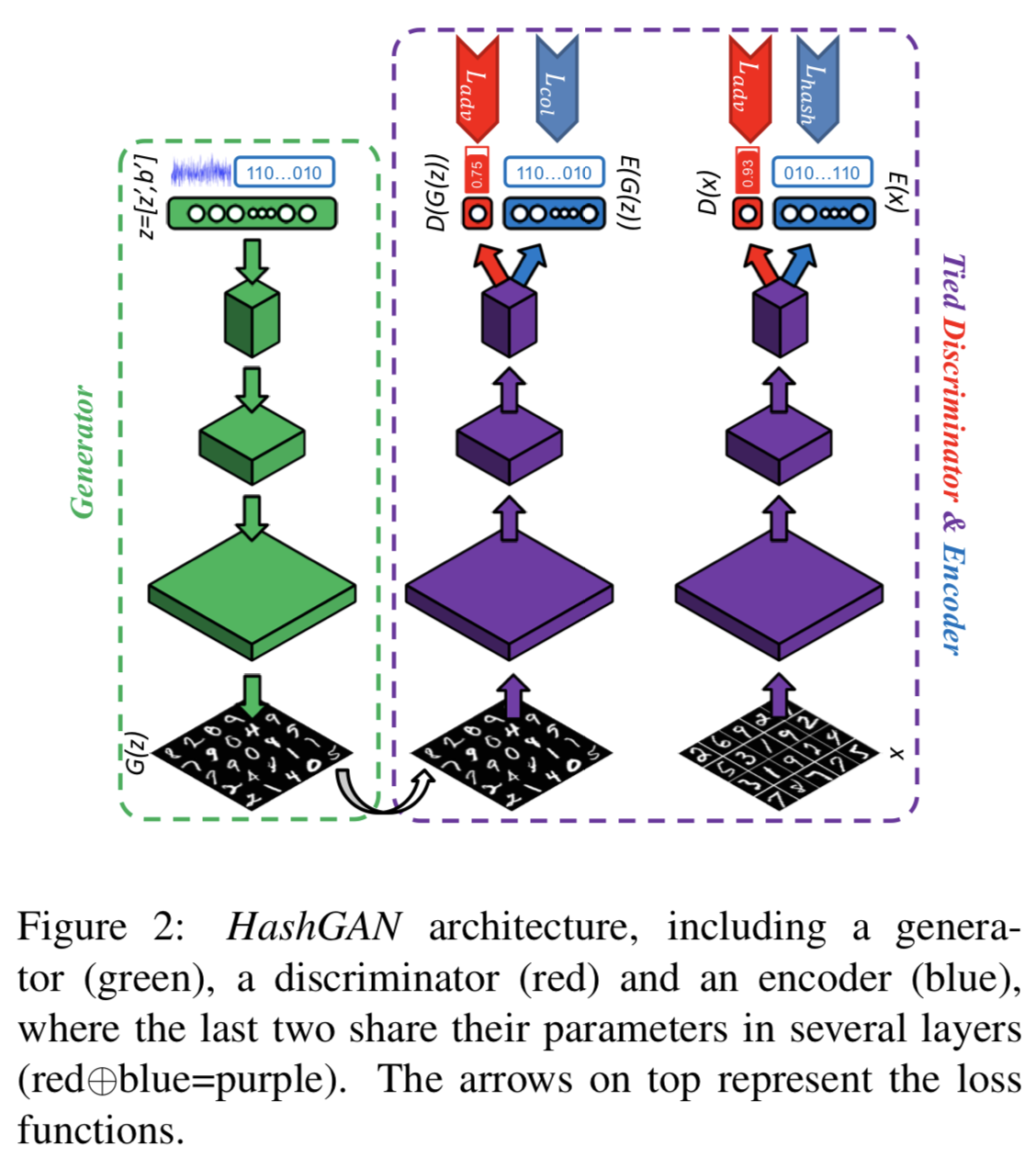

Disentanglementタスクを敵対的ネットワークの構造を利用して行った論文。Disentanglementとは要因を分解するようなタスクであり、手書き文字であれば何の文字が書かれているかという情報と書かれている文字のスタイルを分離するようなタスクである。提案手法は最初に正解ラベルを与えられるようなタスクを学習させた後、それ以外の要素を抽出するようにもう一つのネットワークを学習させることでこれを実現した。実験では、分離した2つの要因を補間したり、掛け合わせたりする検証と2つの要因に相関が無くなっているかを確認するための検索タスクを行った。

まず初めにネットワークSを正解ラベルの存在するクラス分類のタスクで学習させる。次にSとは異なるネットワークZを学習するのだが、SのエンコーダとZのエンコーダから得られた特徴量からReconstructionするように学習するブランチと、Zのエンコーダから得られた特徴量からできるだけクラス分類の精度が下がるように学習するブランチで学習する。特にクラス分類の精度を下げるように学習する方は、クラス分類に必要な情報をできるだけ忘れるようになっており、Disentanglementのタスクに効いている。

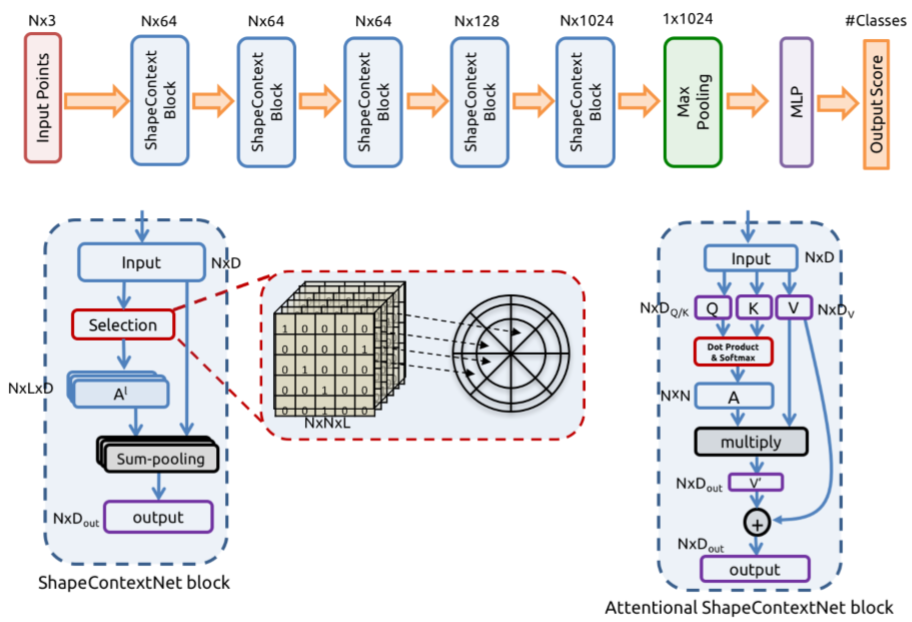

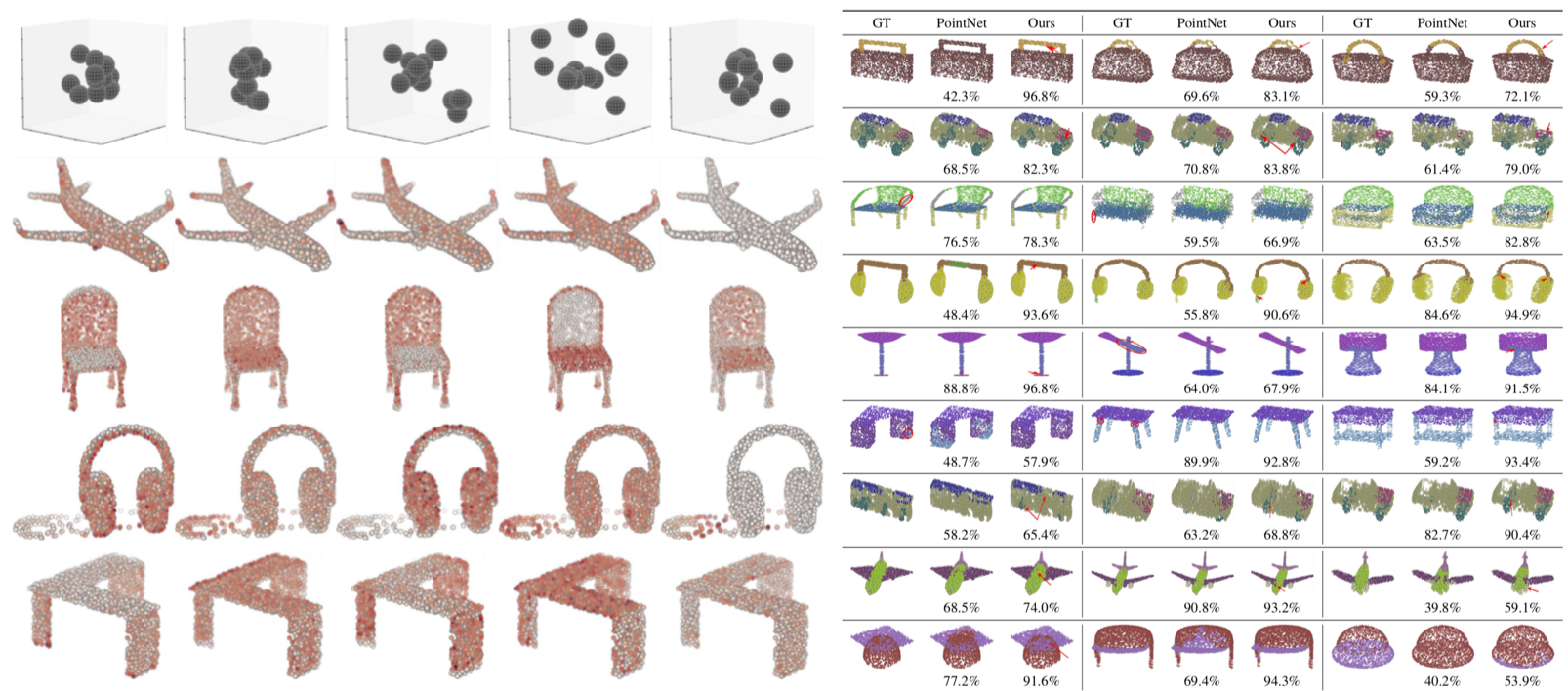

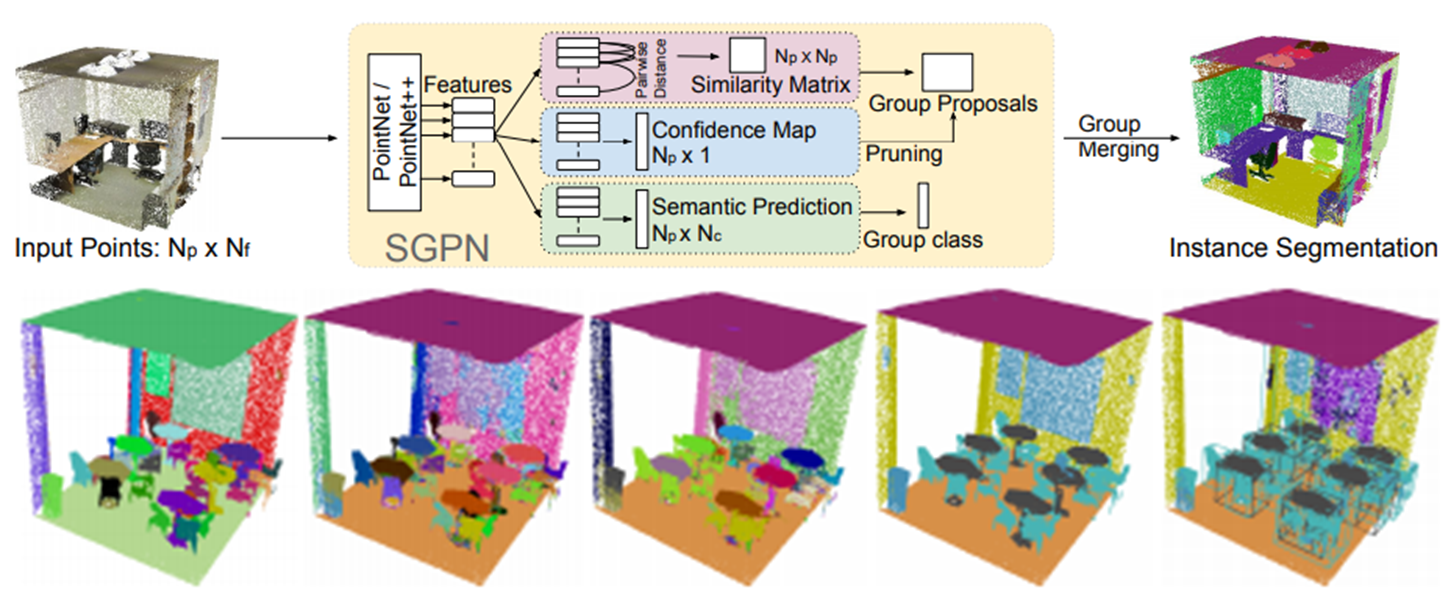

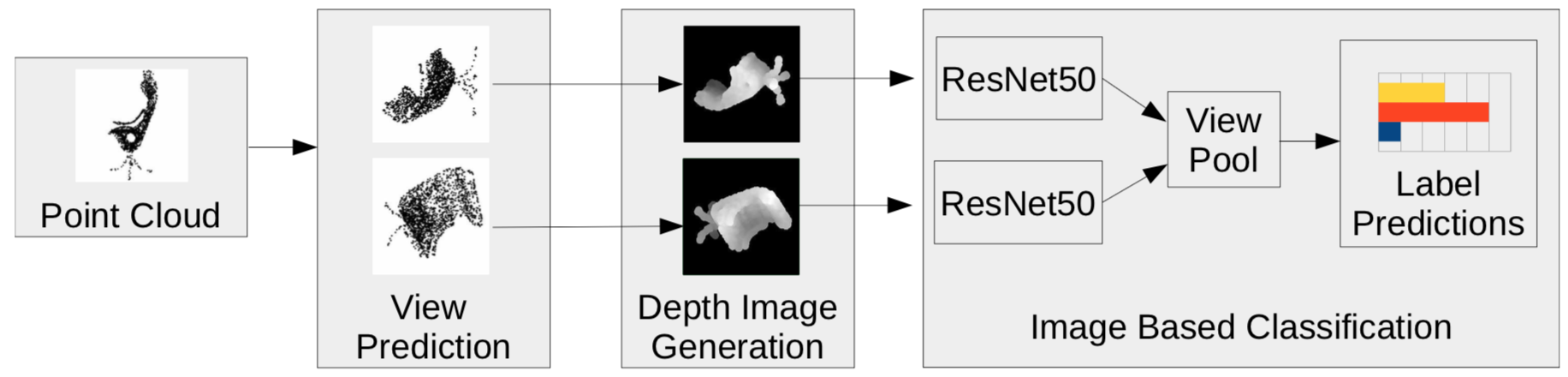

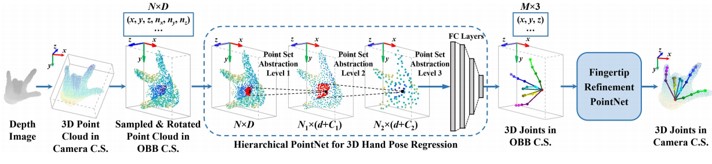

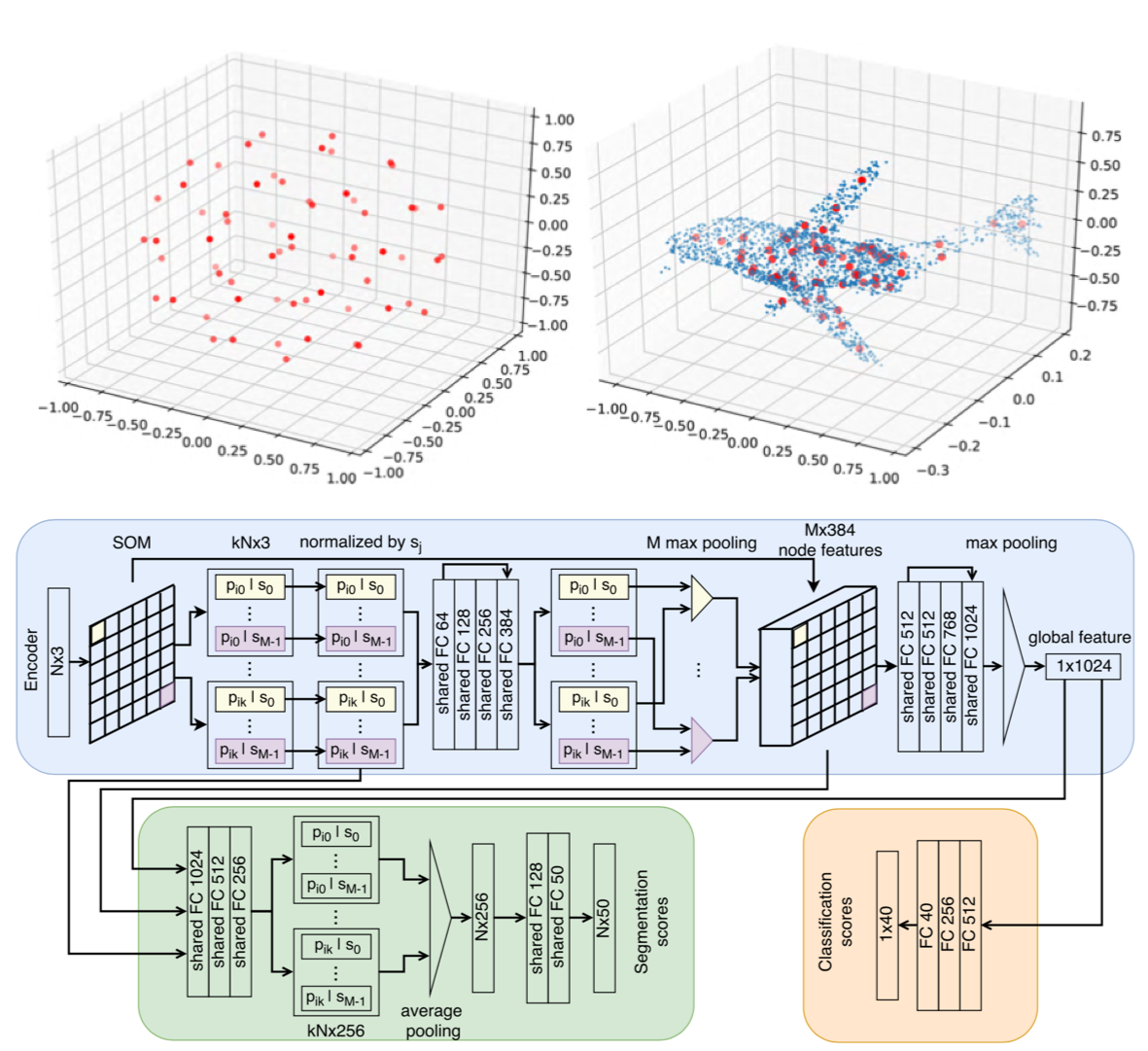

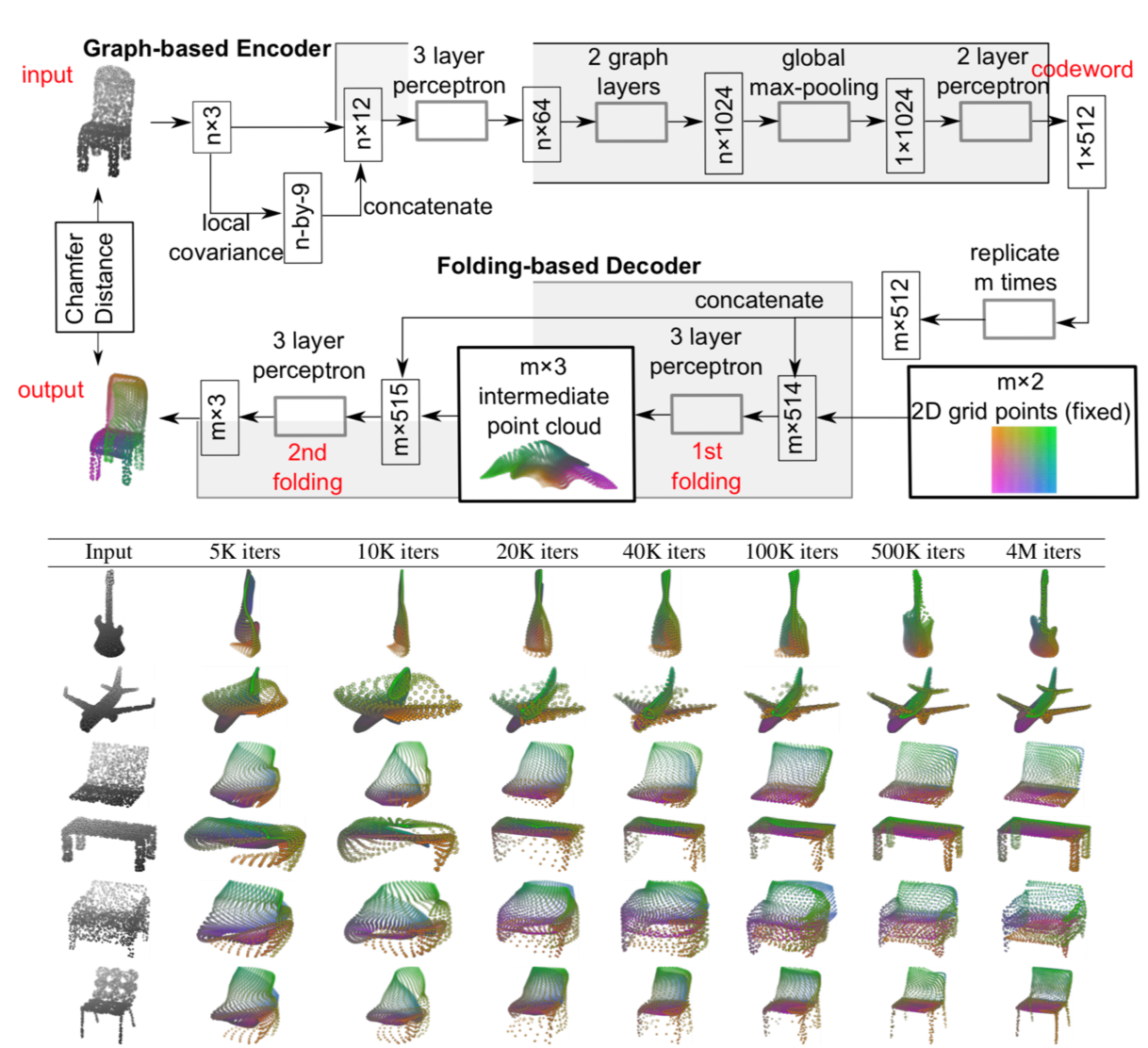

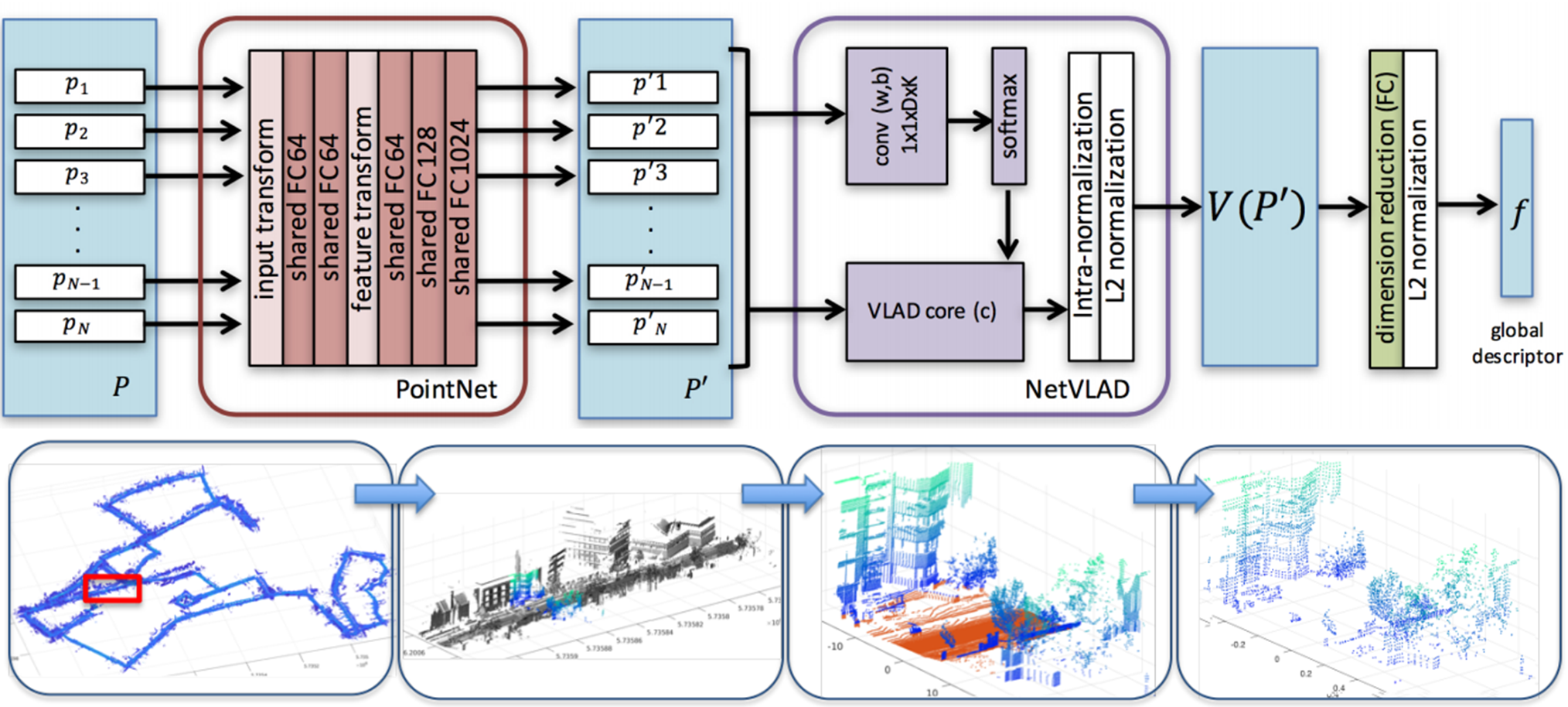

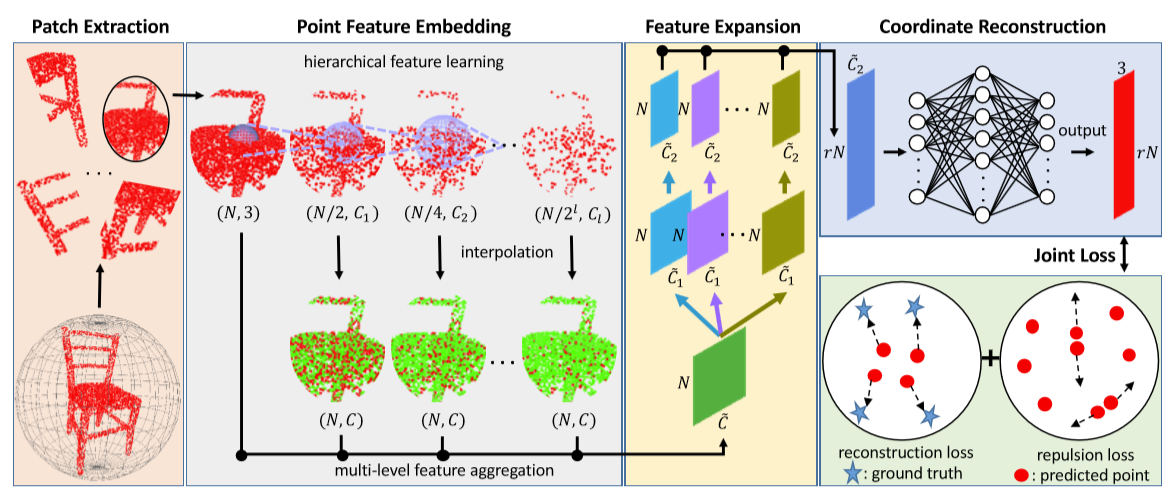

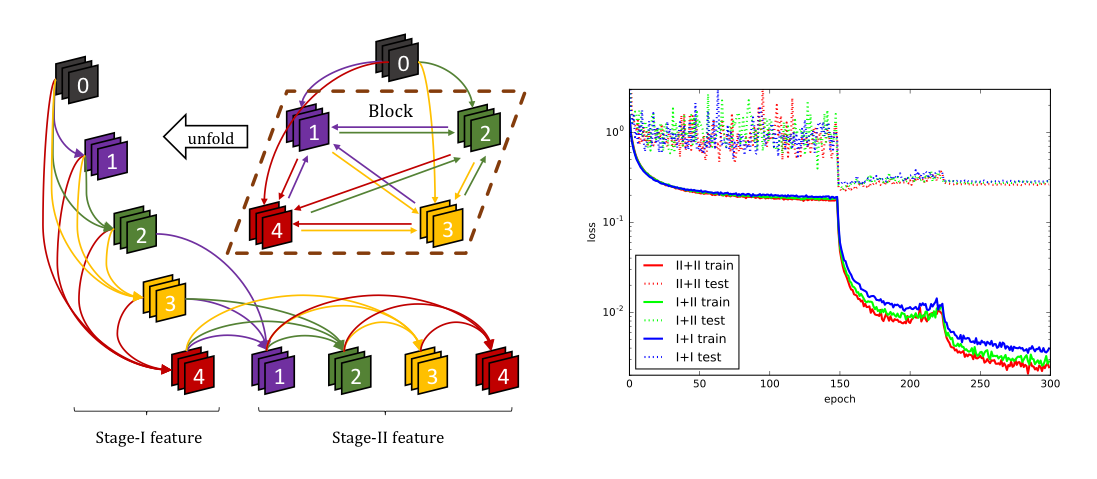

PointNetでは考慮出来ていない, PointCloud の局所的な構造を抽出するために, 新しい2つの演算 (kernel correlation と graph-based pooling) を提案. classification と segmentation のタスクで行った評価実験では PointNet++ と同等以上の結果をより少ないパラメータ数で達成した.

この研究では以下に示す3つのことを行なった.

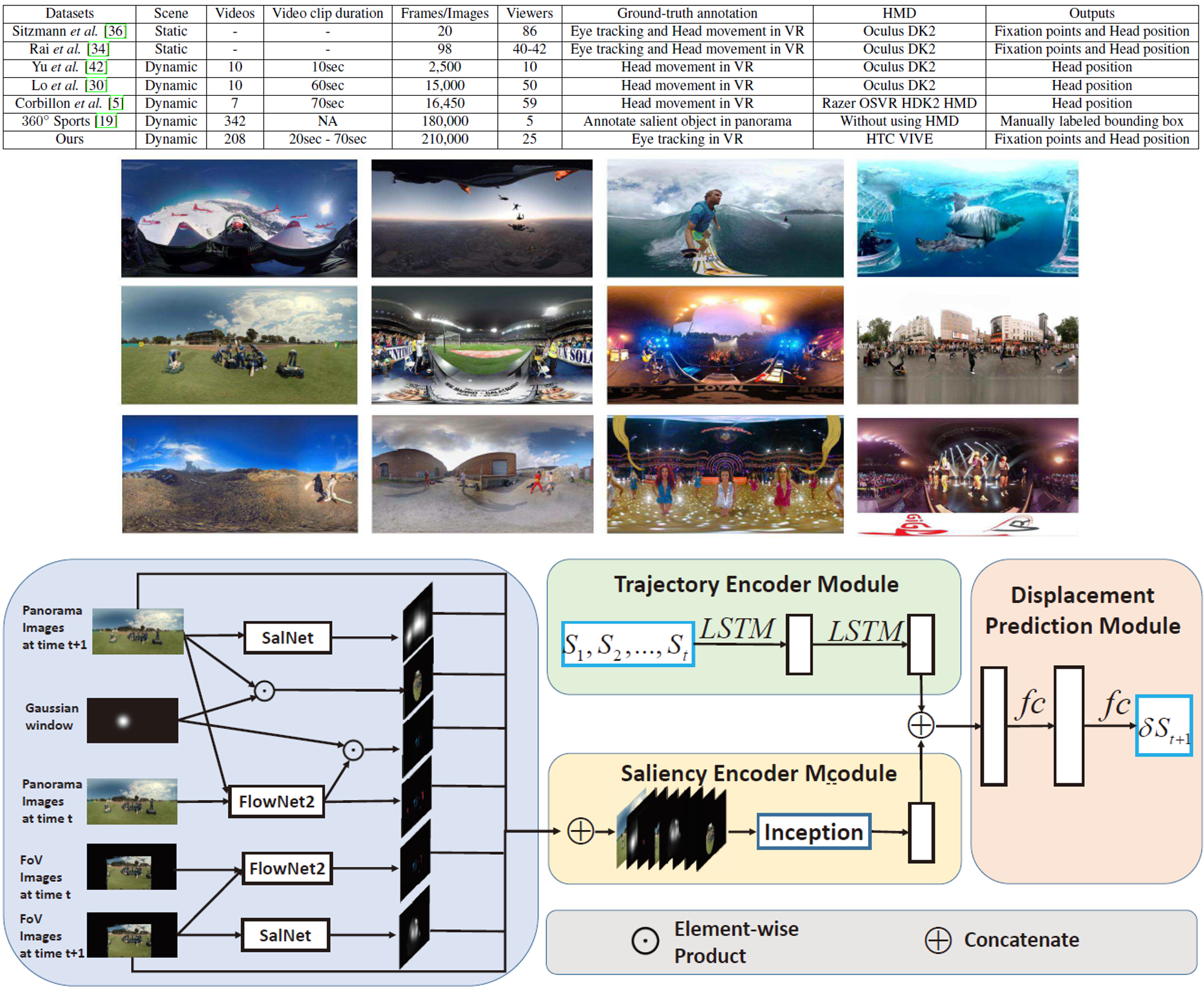

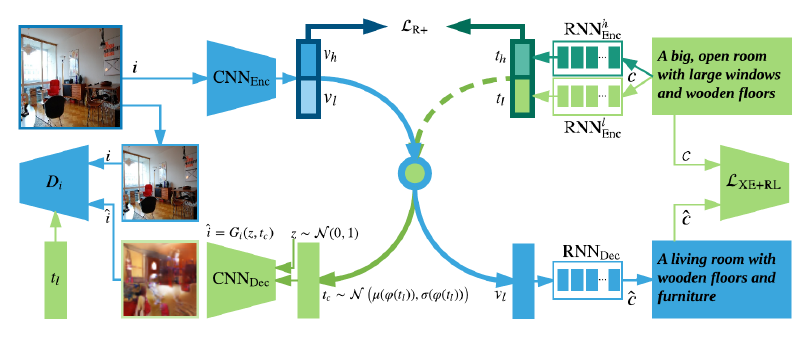

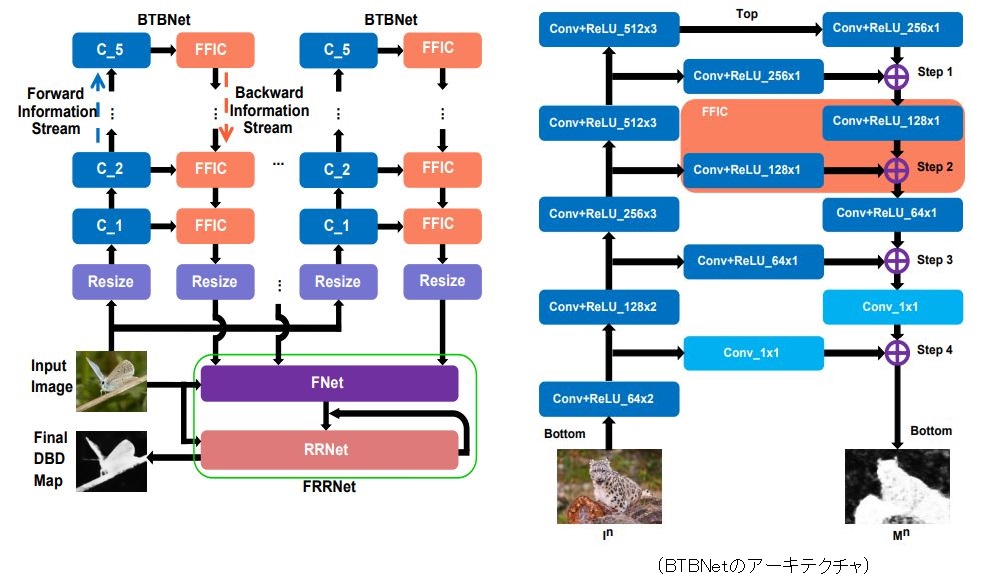

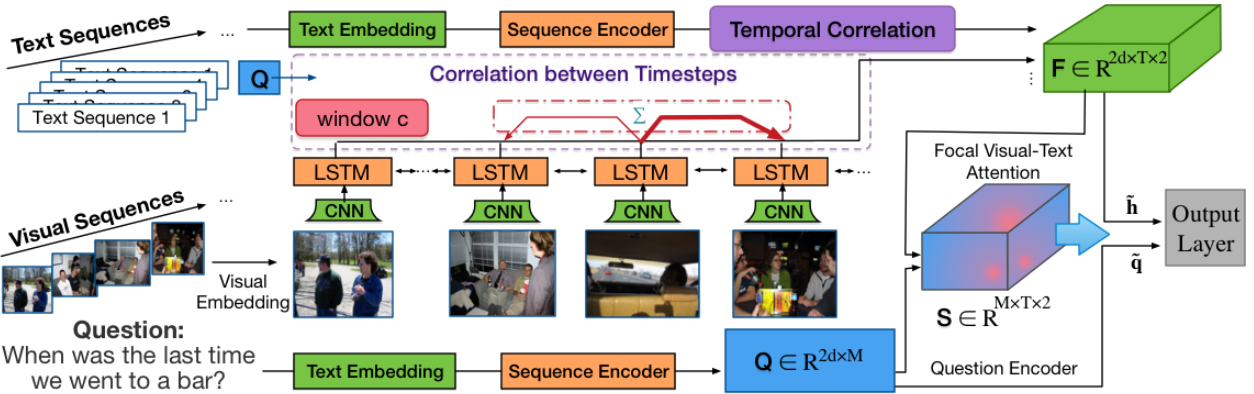

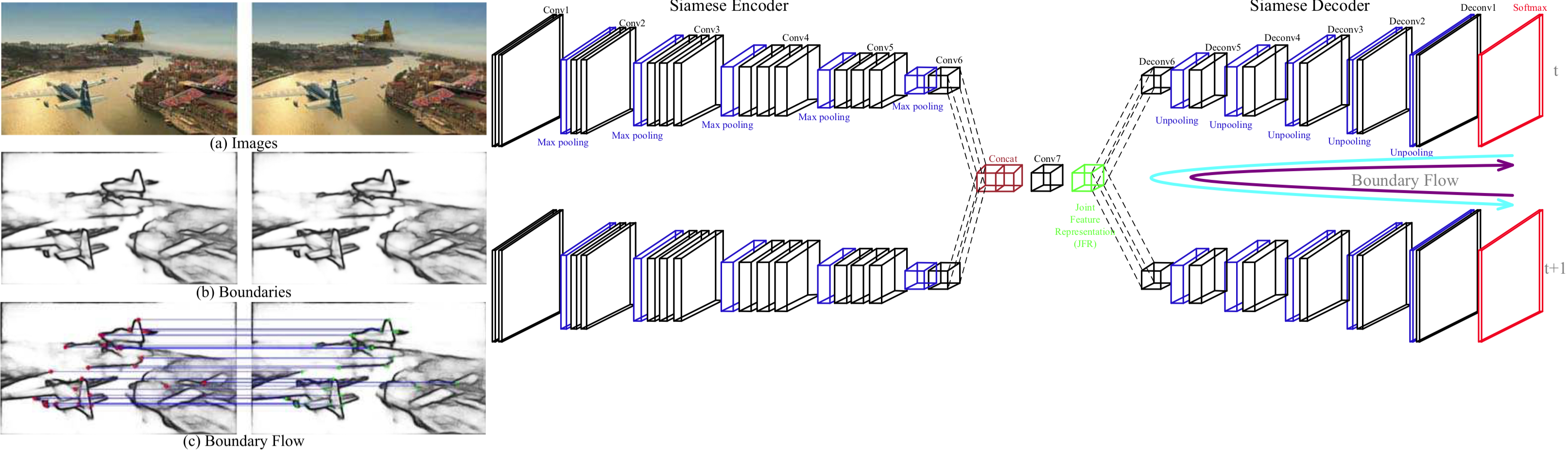

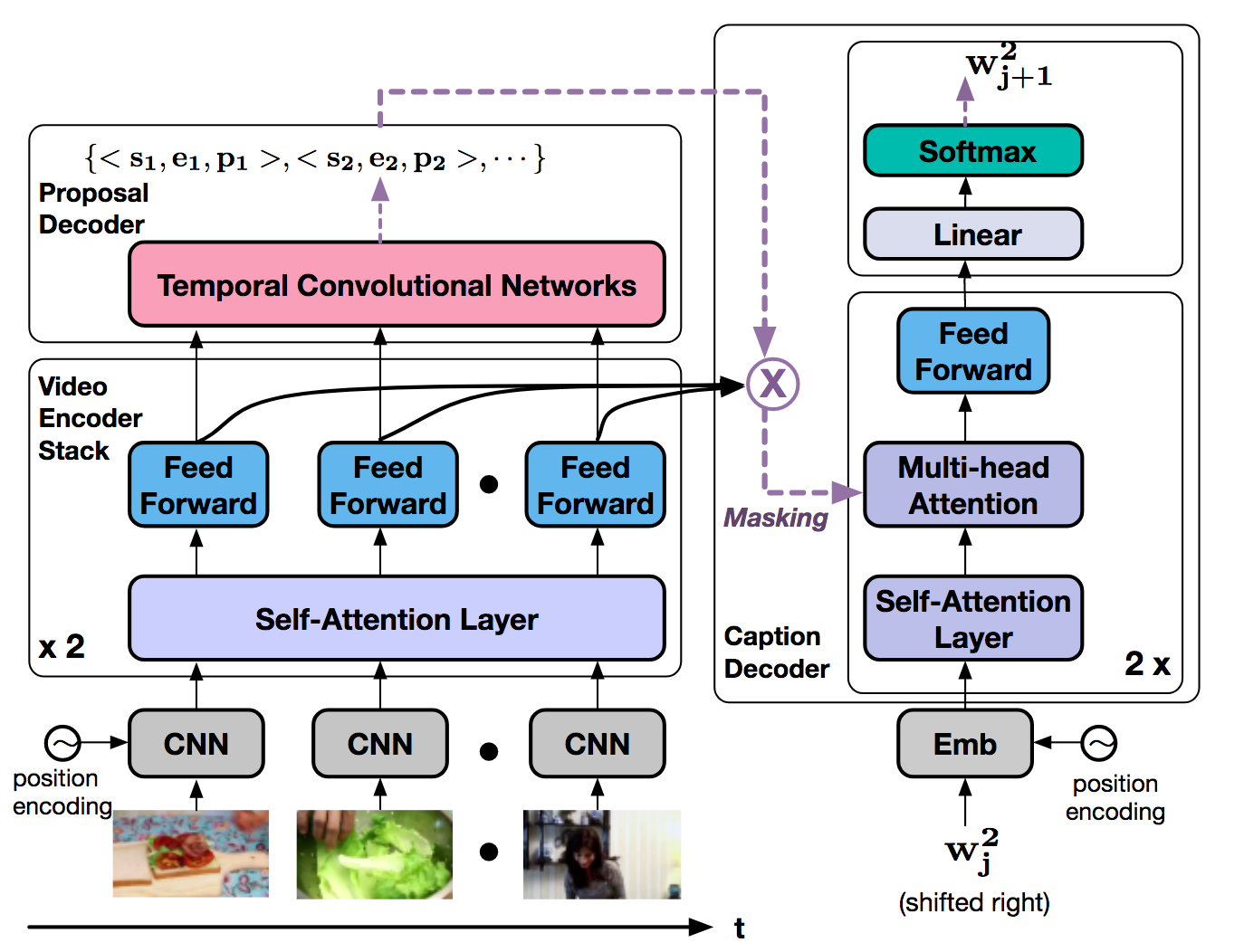

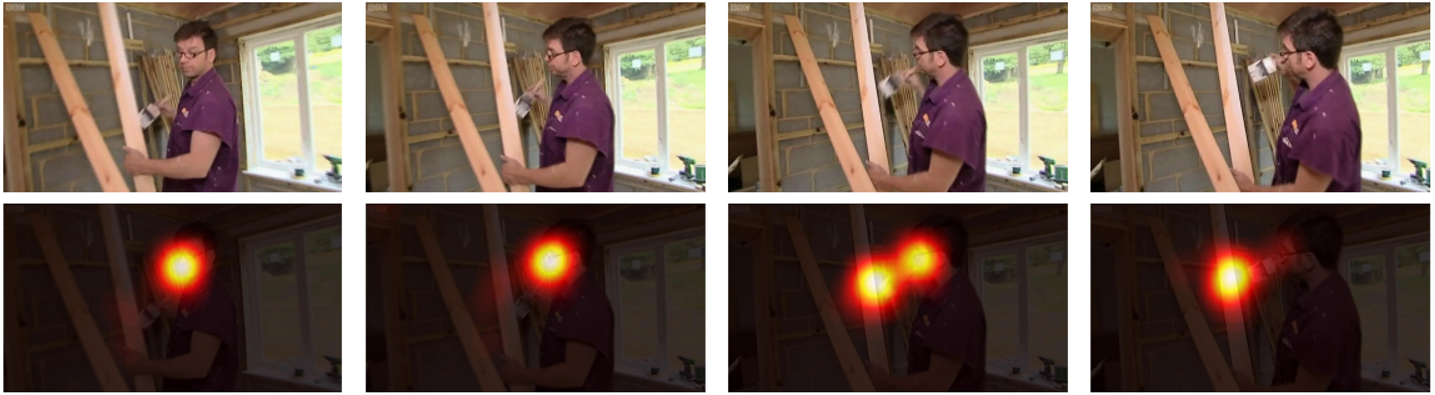

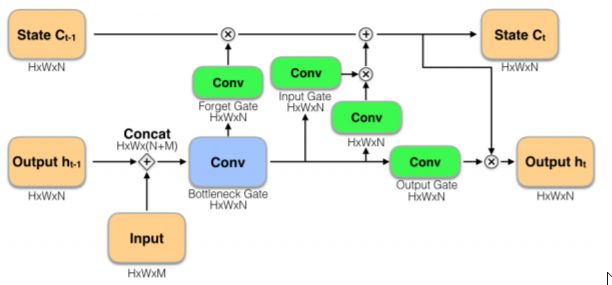

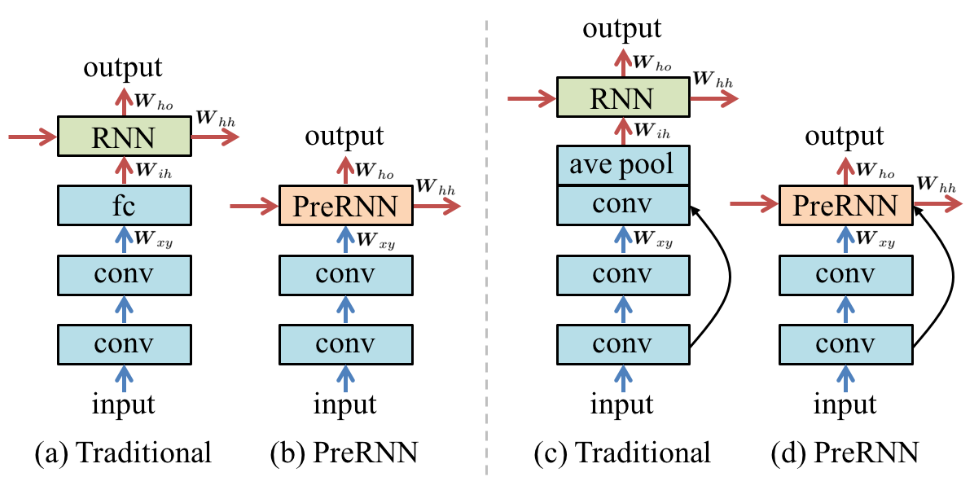

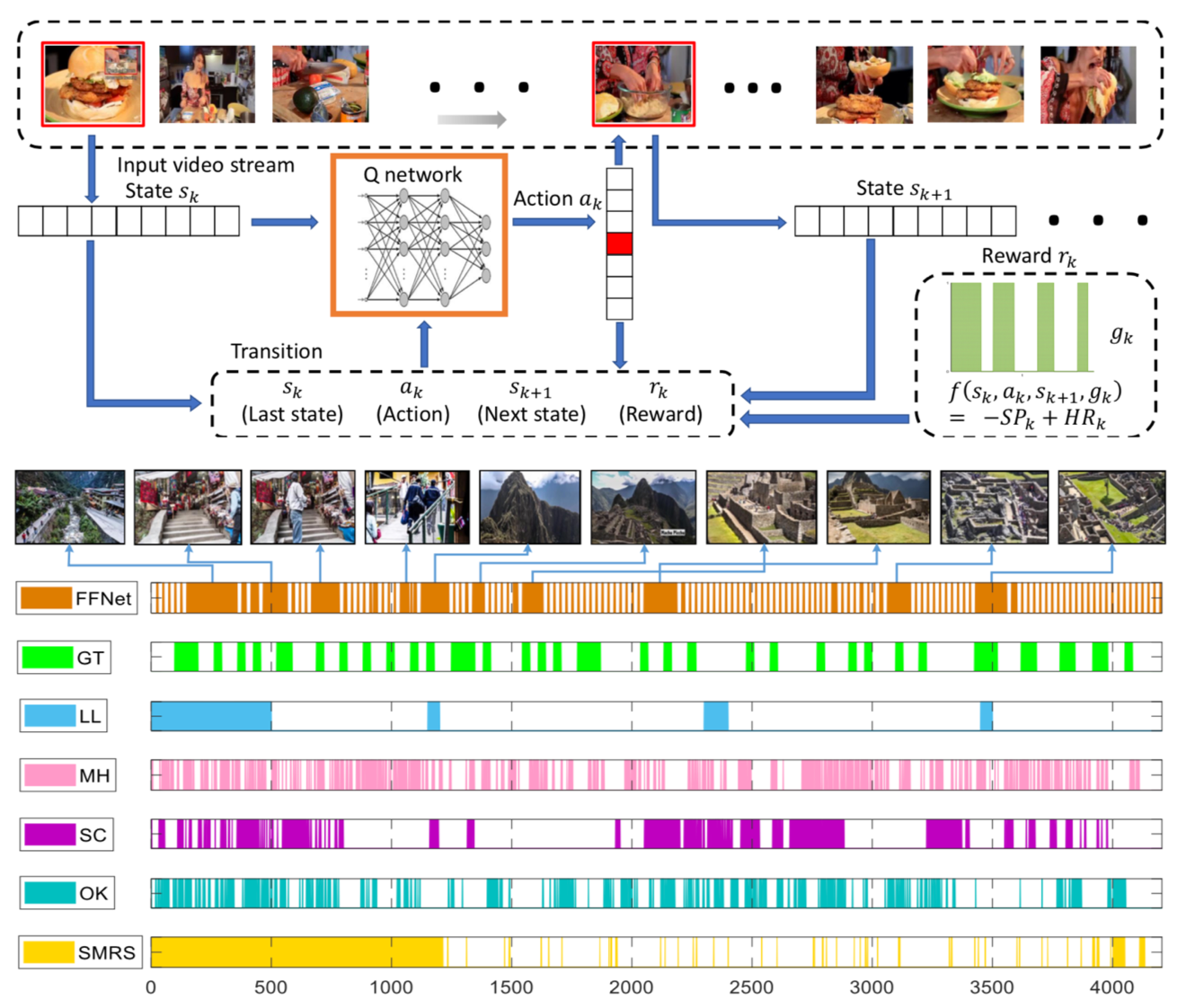

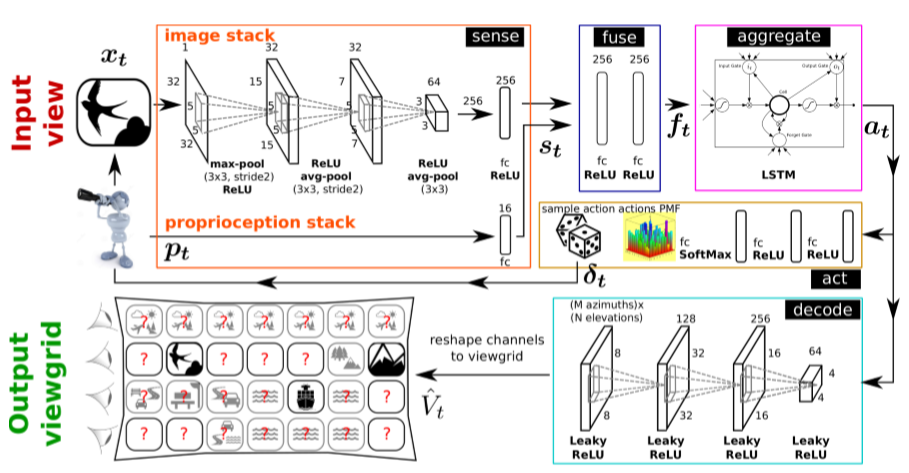

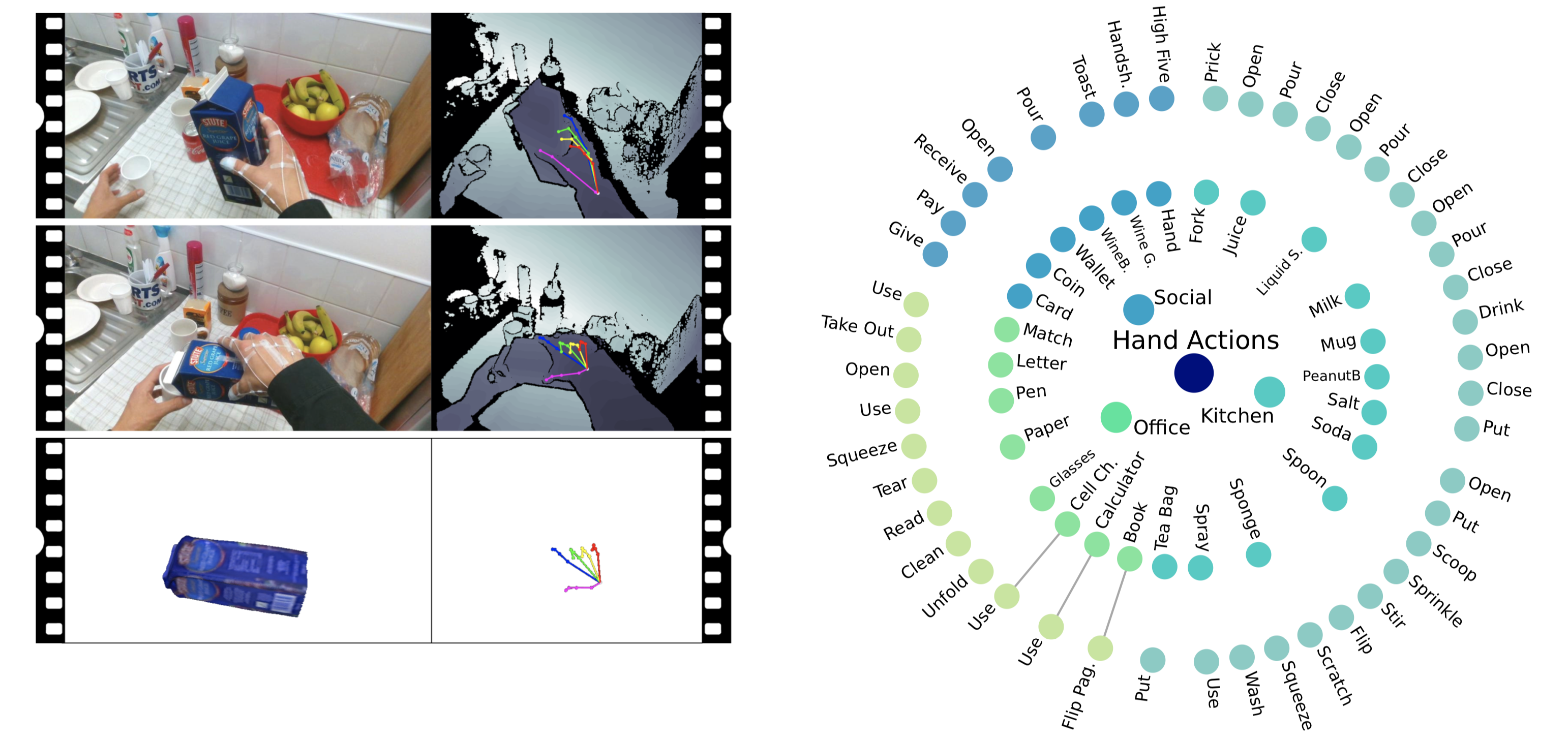

DHF1Kデータセットは,1000個の動画から構成されており,シーン,モーション,アクティビティ等が既存データセットよりも幅広くカバーされている.

DHF1K, Hollywood2, UCF sportsデータセットを用いて実験を行なった結果,提案モデルがSOTAモデルよりも優れていることがわかった.評価指標としては,Normalized Scanpath Saliency, Similarity Metric, Linear Correlation Coefficient, AUC-Judd, shuffled AUCを用いた.

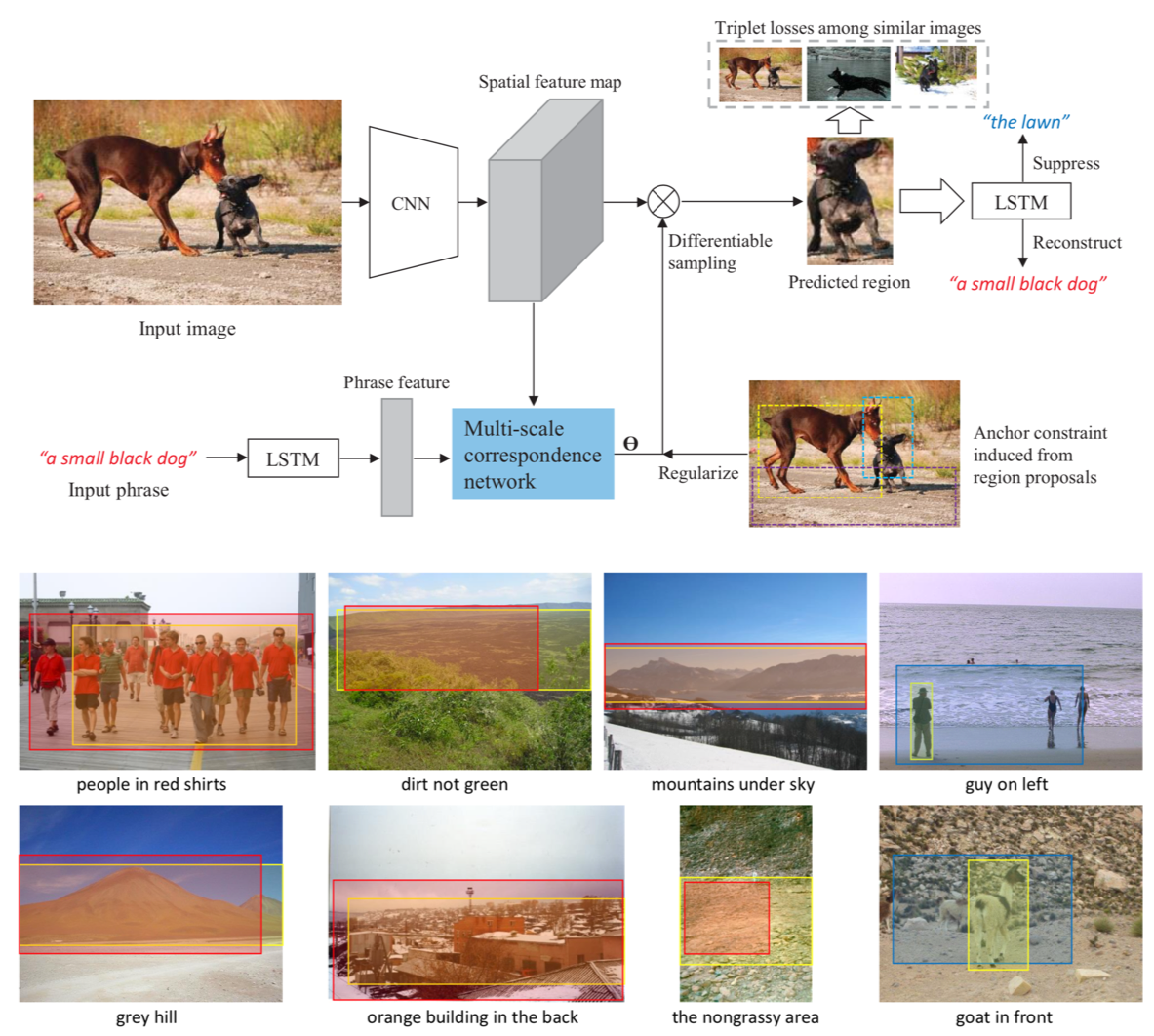

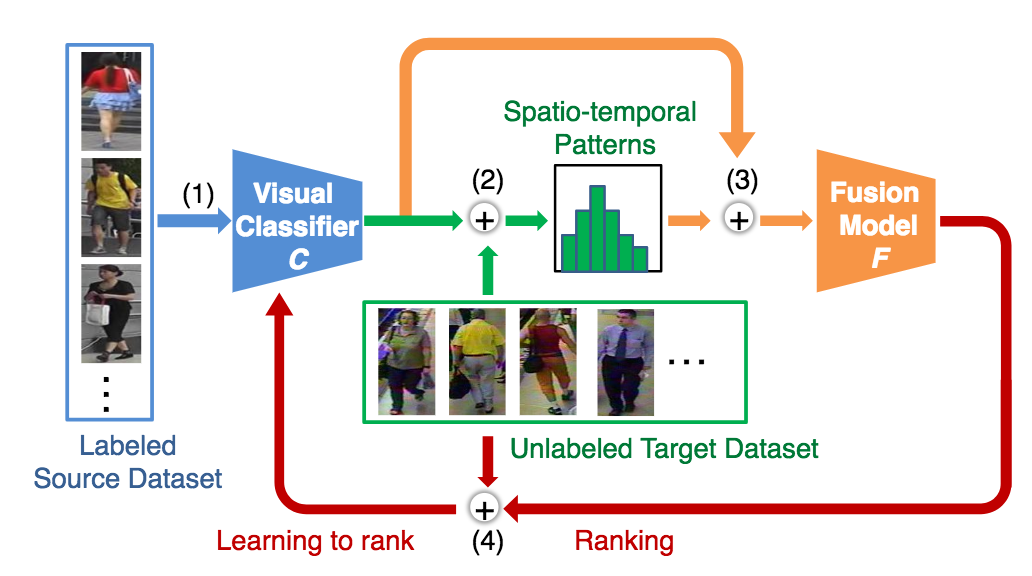

弱教師(画像レベルのアノテーション)によって Textual phrase localization を行う研究. 提案手法では anchor constraint の元で fine-grained な Bounding Box を連続的に探すことが可能. Flickr30K Entities と ReferItGane datasets を用いた評価実験では, 既存の弱教師に基づく手法に大きな差をつけてSOTAを達成した.

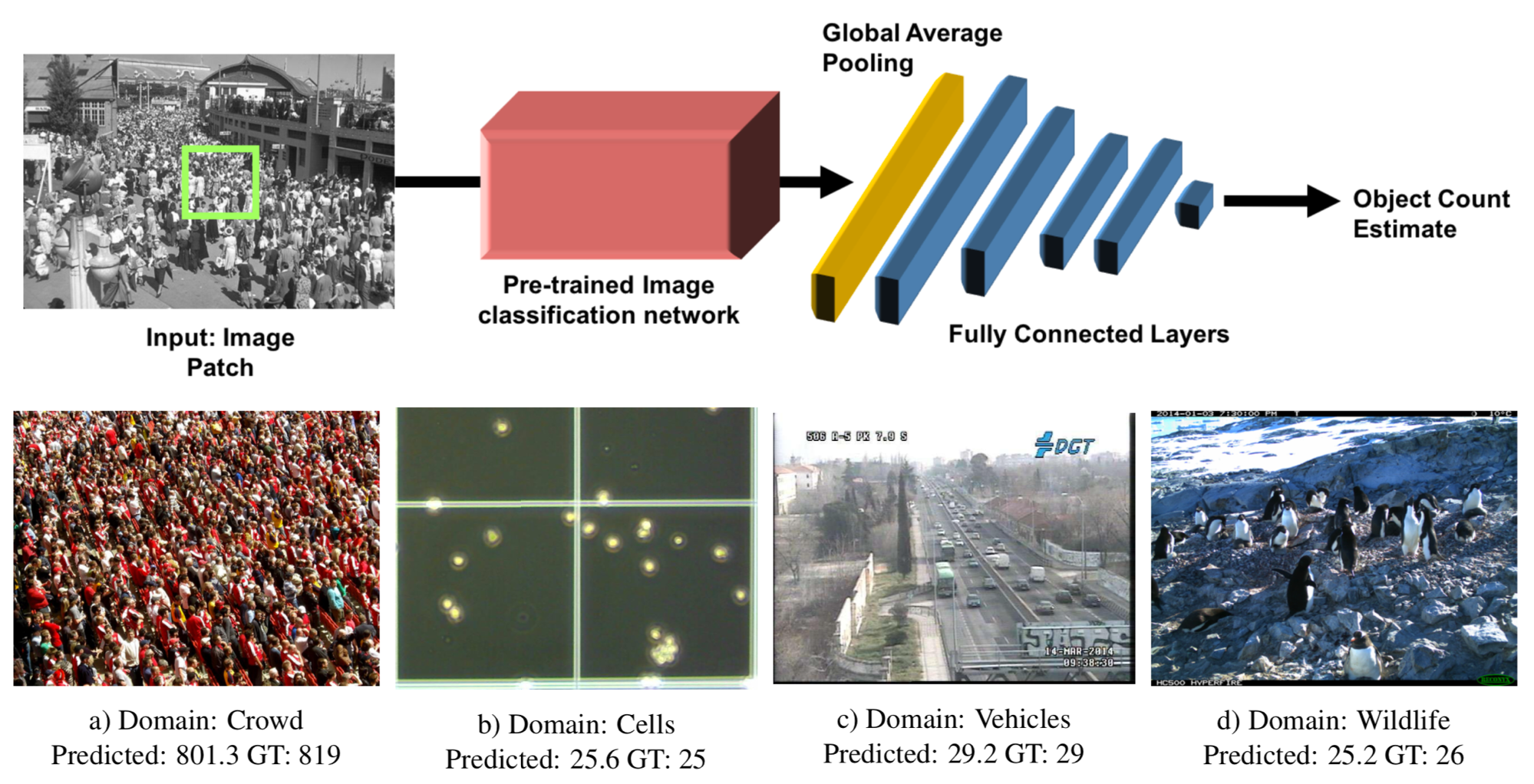

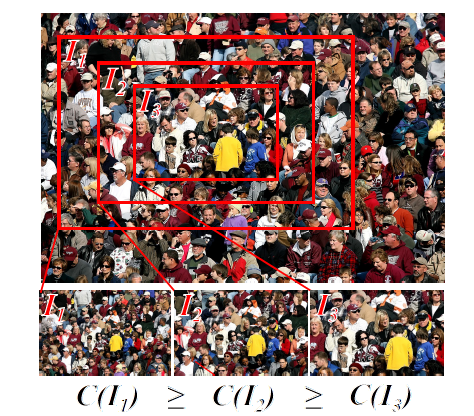

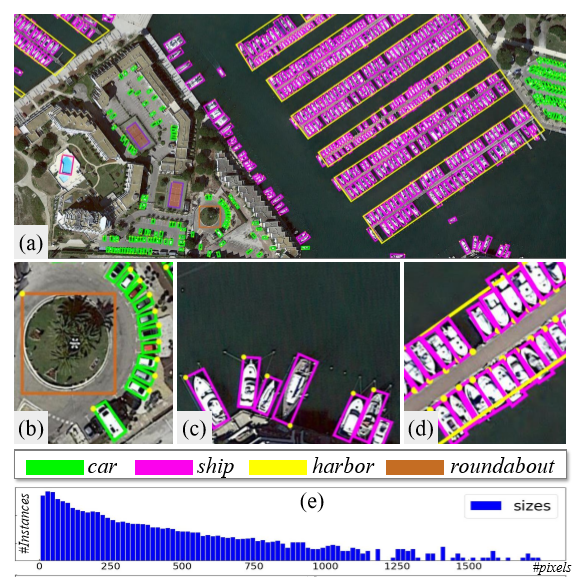

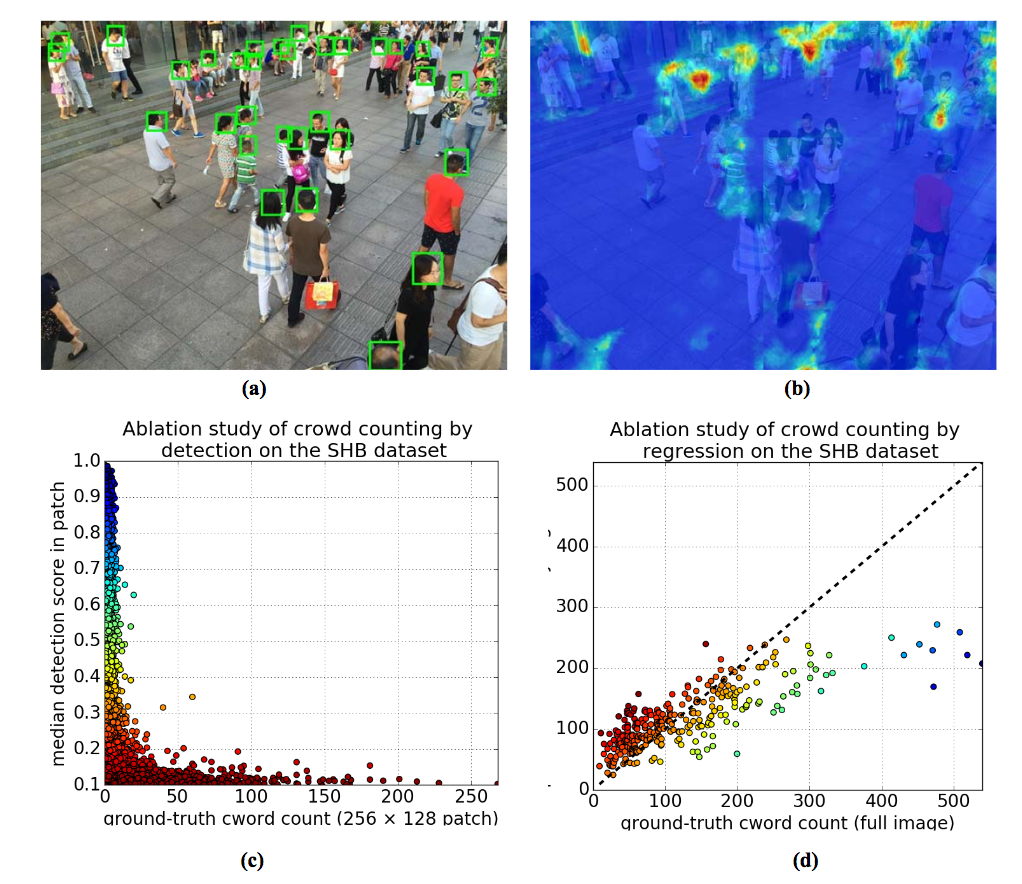

Multi-domain なパッチベースの object counting の新しいモデルを提案. 提案手法は multi-domain に対応するための domain specific modules を内包しており, 全体のパラメータの内 5% を追加で学習するだけで新しい domain に対応することが出来る. 評価実験では, 単一のモデルで異なる domain に対する数え上げのタスクでSOTAを達成した.

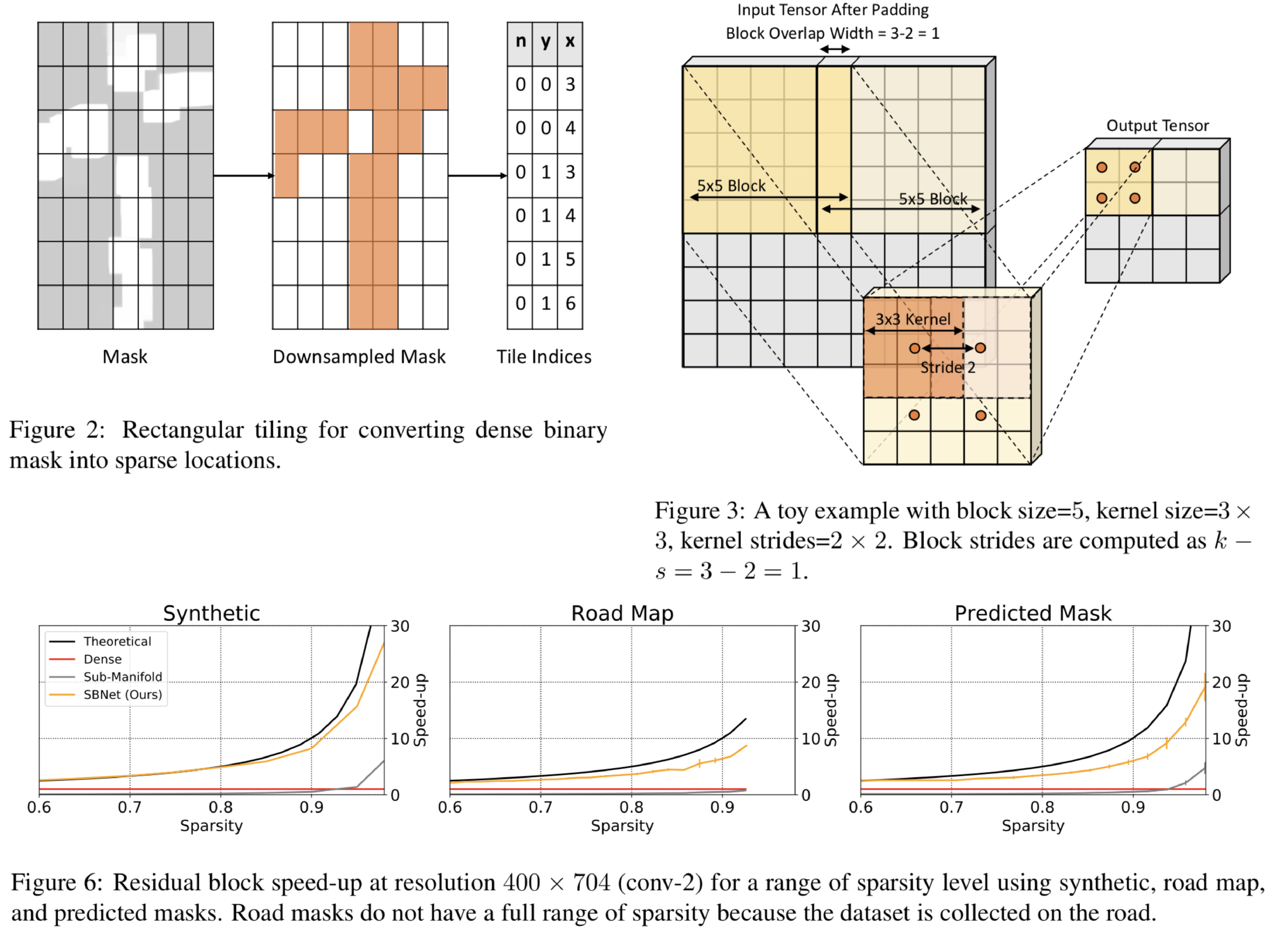

オブジェクト画像に対するCNNの計算コストを削減するために、画像の前景に対する離散的なマスクを生成し、convolutionを行うSparse Blocks Networks (SBNet)を提案。従来のCNNでは画像全体に一様にconvolutionの操作を行うため計算コストが高い。また、既存手法では構造的な離散化を行なっていないために、計算コストは小さくなっても実行時間が短くならないという問題点があった。提案手法では多くのオブジェクト画像は周りを背景で囲まれており、一部の領域にオブジェクトが存在するという構造情報に基づいて、前景の可能性が高い領域に対する離散的なマスクを形成する。これを入力テンソルに適用することで小さい計算コストで精度を落とすことなくCNNの学習を行う。

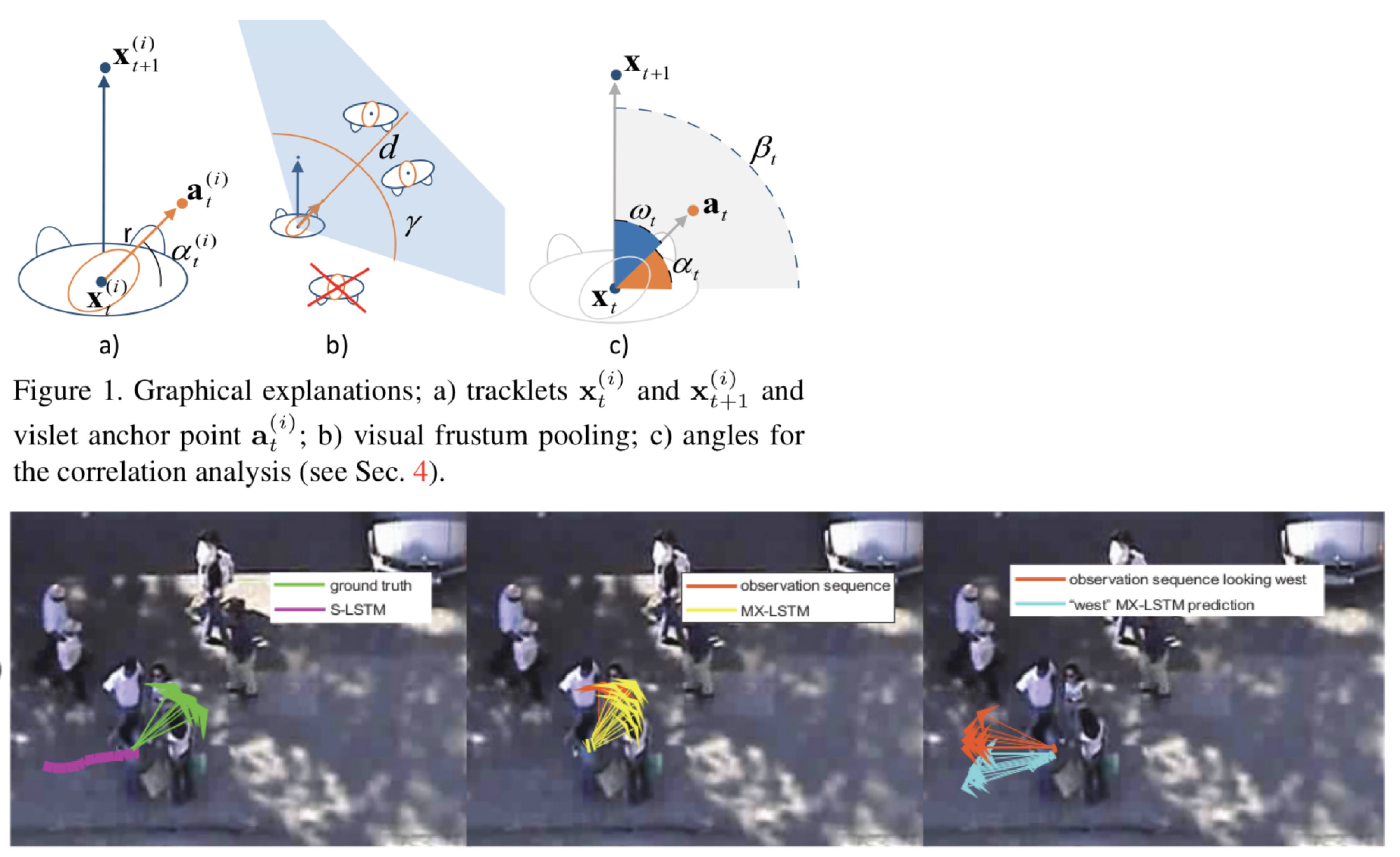

人間の軌道予測を行う際に、頭部の向き情報を加えたLSTMベースのネットワークMiXing LSTMを提案。事前実験により人間の歩行軌道と頭部の向きが関係することを明らかにした上で、手法を提案。xy平面状の軌道(tracklets)と頭部の向き(vislets)の両方のstreamを考慮する。また、既存手法であるSocial LSTMでは周りの歩行者の軌道を隠れ変数として考慮していたが、提案手法では推定された頭部の向きを中心とした視野角内に存在する歩行者のみを考慮することで精度の向上を図っている。最適化にはd-variate Gaussian parametersを用いた。

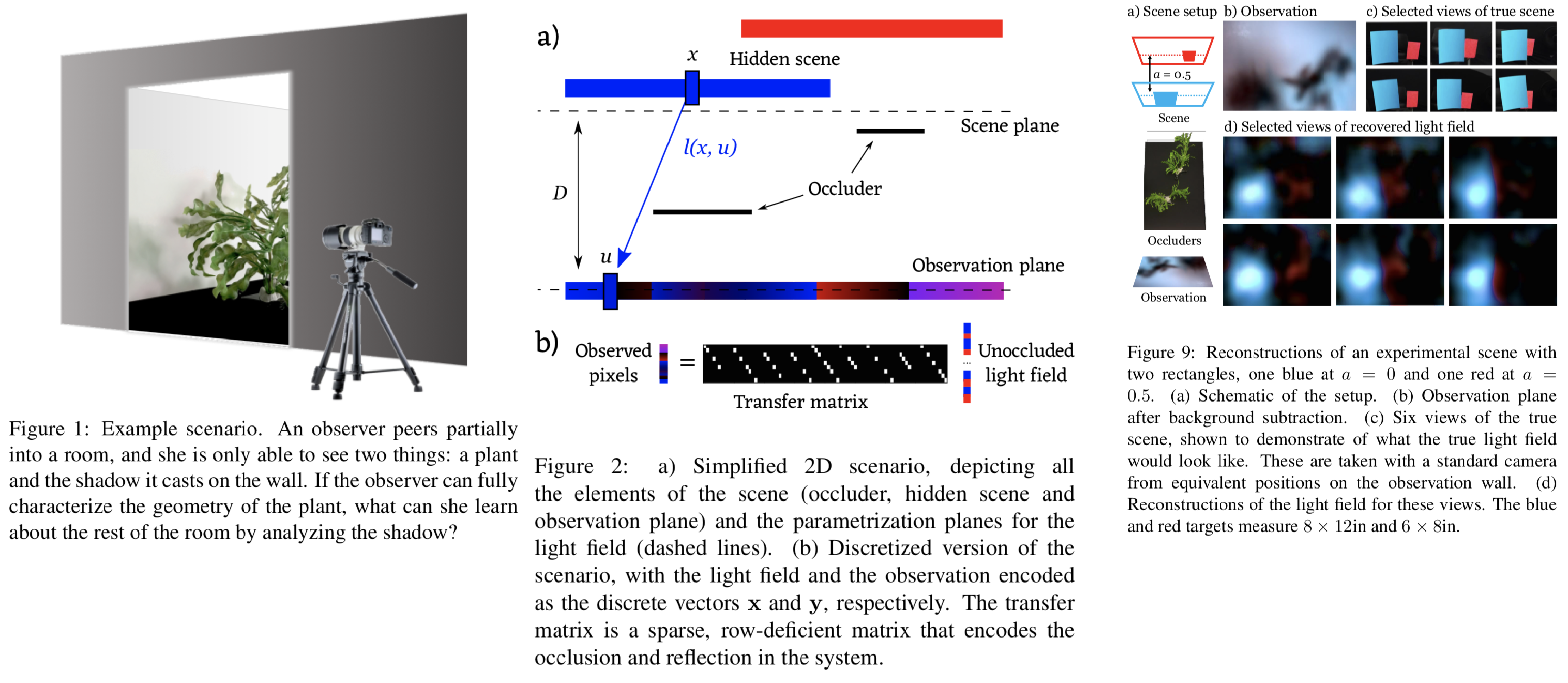

直接観測していない四次元light fieldを観測可能な物体によるディフューズ面に投影された二次元平面上の影から推定する手法を提案。既存研究としてtime-of-flightカメラを用いて二次反射光による観測可能な反射と見えていないシーンを含んだ全てのシーンとの関係性と、ありえそうなシーンの構造を事前情報として用いて観測できないシーンのオブジェクト数を数えるnon-line-of-sight (NLoS) imagingをあげているが、この研究ではよりチャレンジングな目的を達成する。提案手法ではNLoSで使用されている二次反射光に加えて、現実のシーンではスペクトルが低周波成分に集中するという情報を用いることで平面上の影から観測不可能な四次元光を推定する。

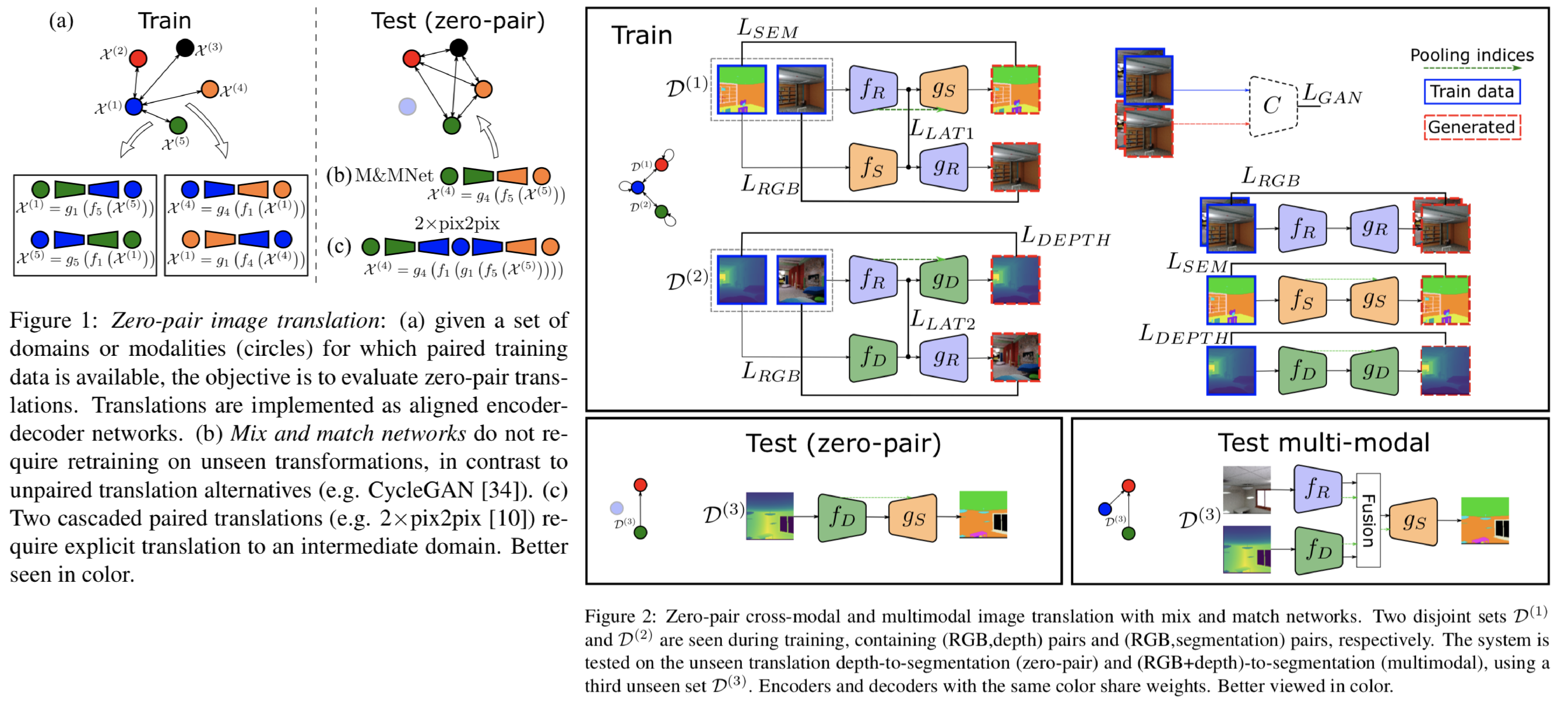

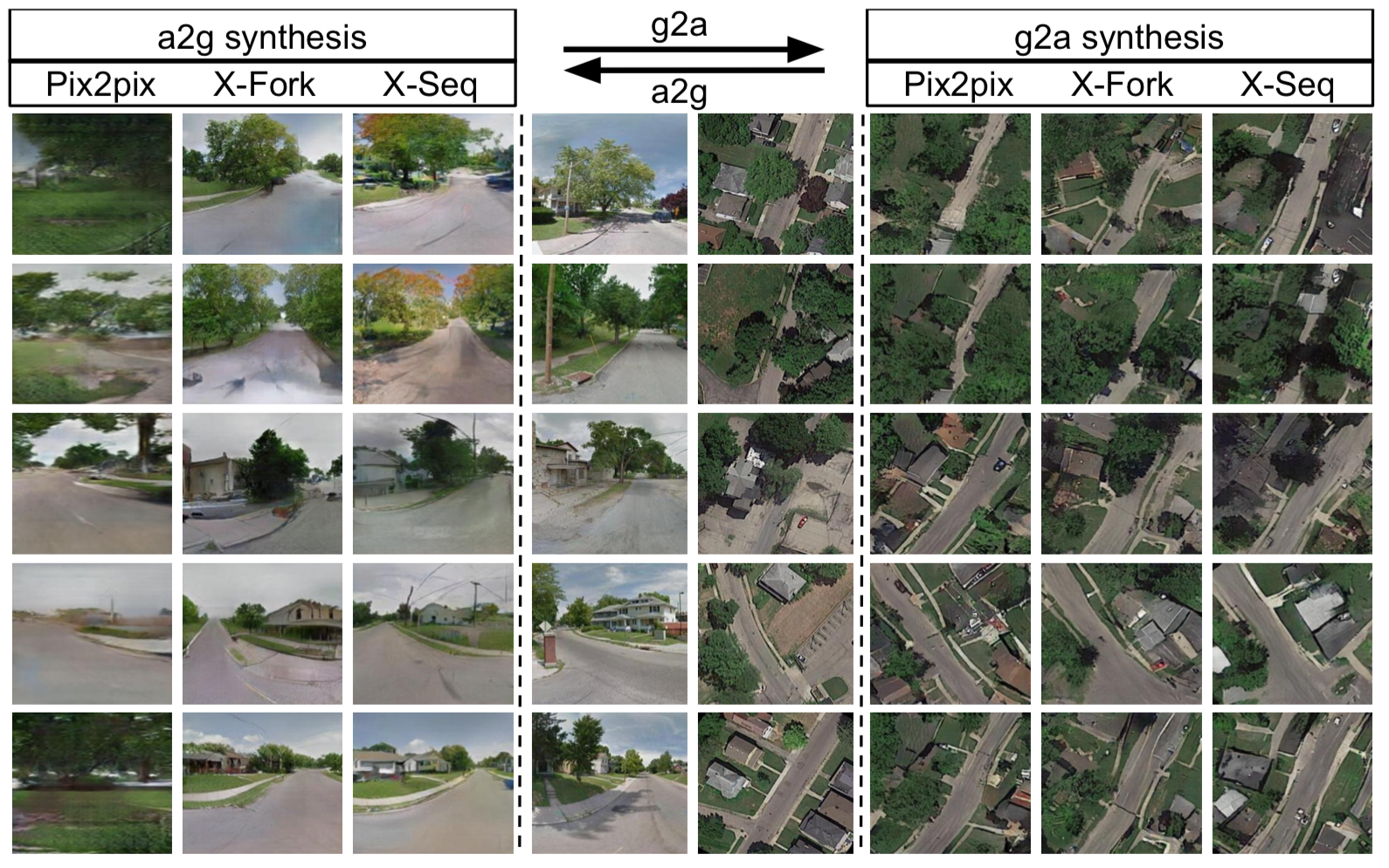

異なるドメイン間の画像変換において、ある一つのドメインとその他のドメイン間の画像変換をトレーニングすることで、テスト時にはトレーニングを行っていないドメイン間の画像変換を行うmix and match networksを提案。提案ネットワークはautoencoderによって構築される。以下ではdepth(D) to semantic segmentation(S)を行うために、RGB(R) to D, R to Sをトレーニングするロス関数を説明する。

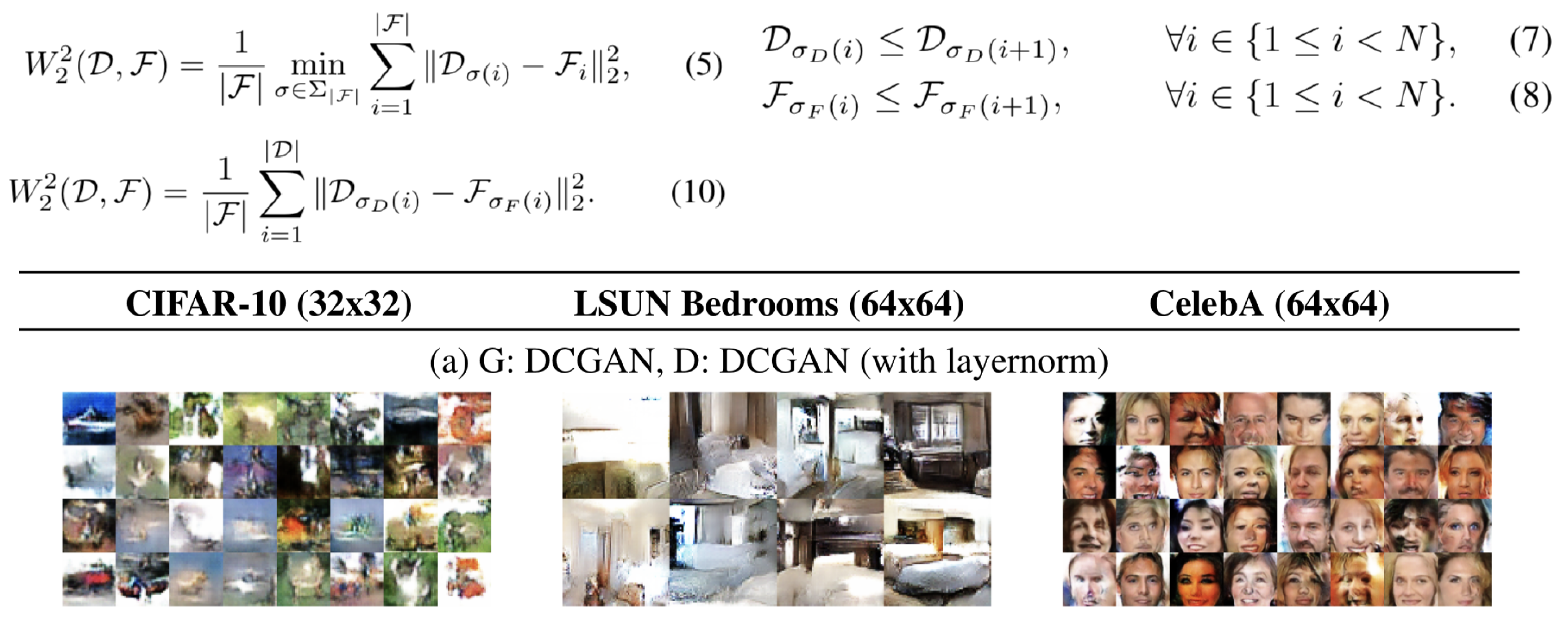

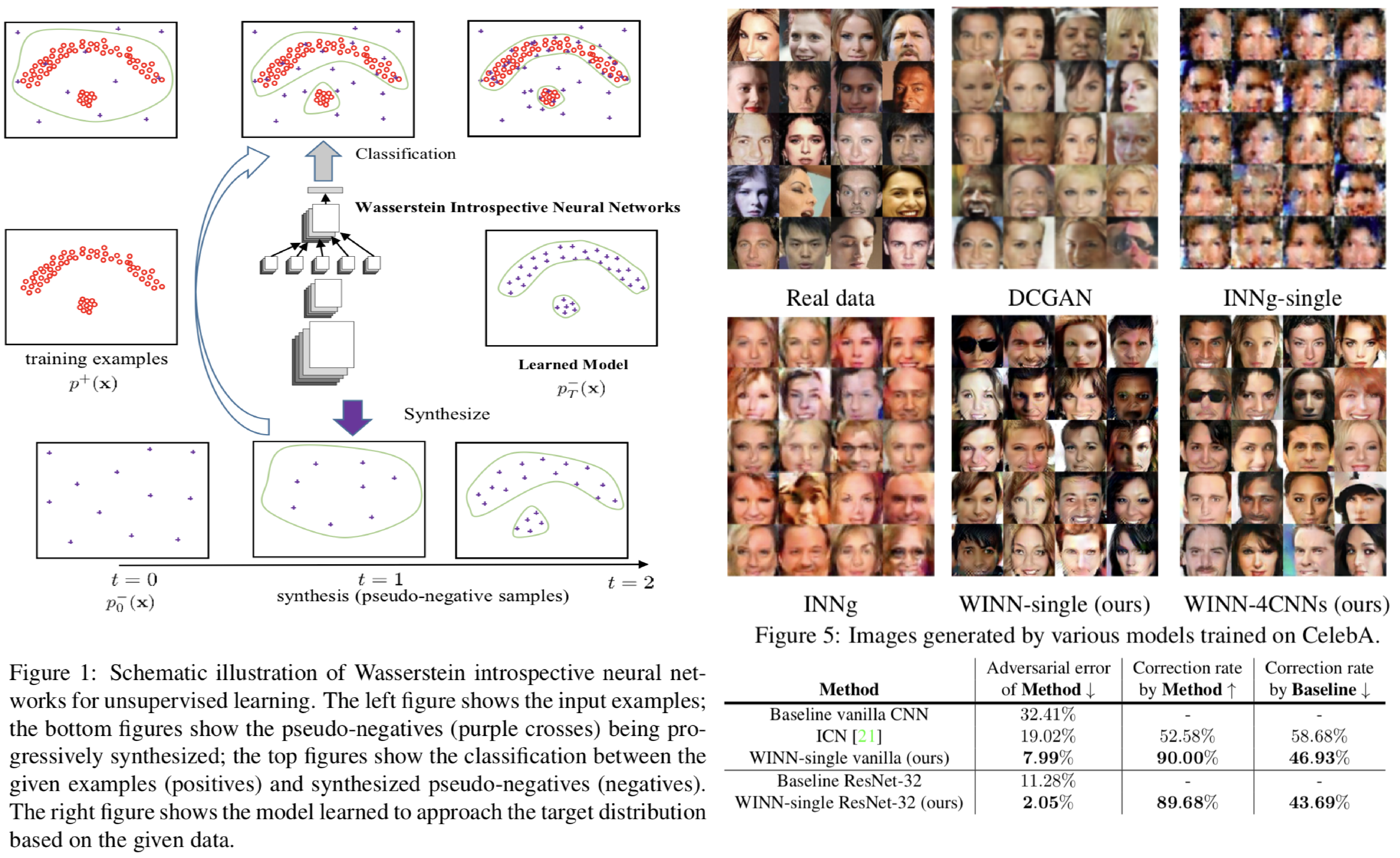

GANの学習を安定して行うことができるwasserstein distance(WD)から導出されるsliced WDを導入することで、安定したGANの学習方法を提案。一次のデータに対する二次のWDを式(5)に示す。このままでは最適化が難しく、計算コストも大きいが、式(7)、(8)のようにソーティングを行うことで、WDは式(10)のように簡単な数式に置き換えることができる。この式(10)のことをsliced WDと呼ぶ。しかし実際には画像データは一次元ではなく、高次元であるため、random projectionによって画像データを任意の一次元ベクトルに射影することでsliced WDによる学習を行う。

自然画像が持つ類似パッチを利用した、自然画像のデノイジングを行うWNNMを一般の画像の任意のdegradation(ブラー、ピクセルの欠損など)に対するdistortionへ拡張した手法を提案。提案手法では以下のステップを踏んで画像のdistortionを行う

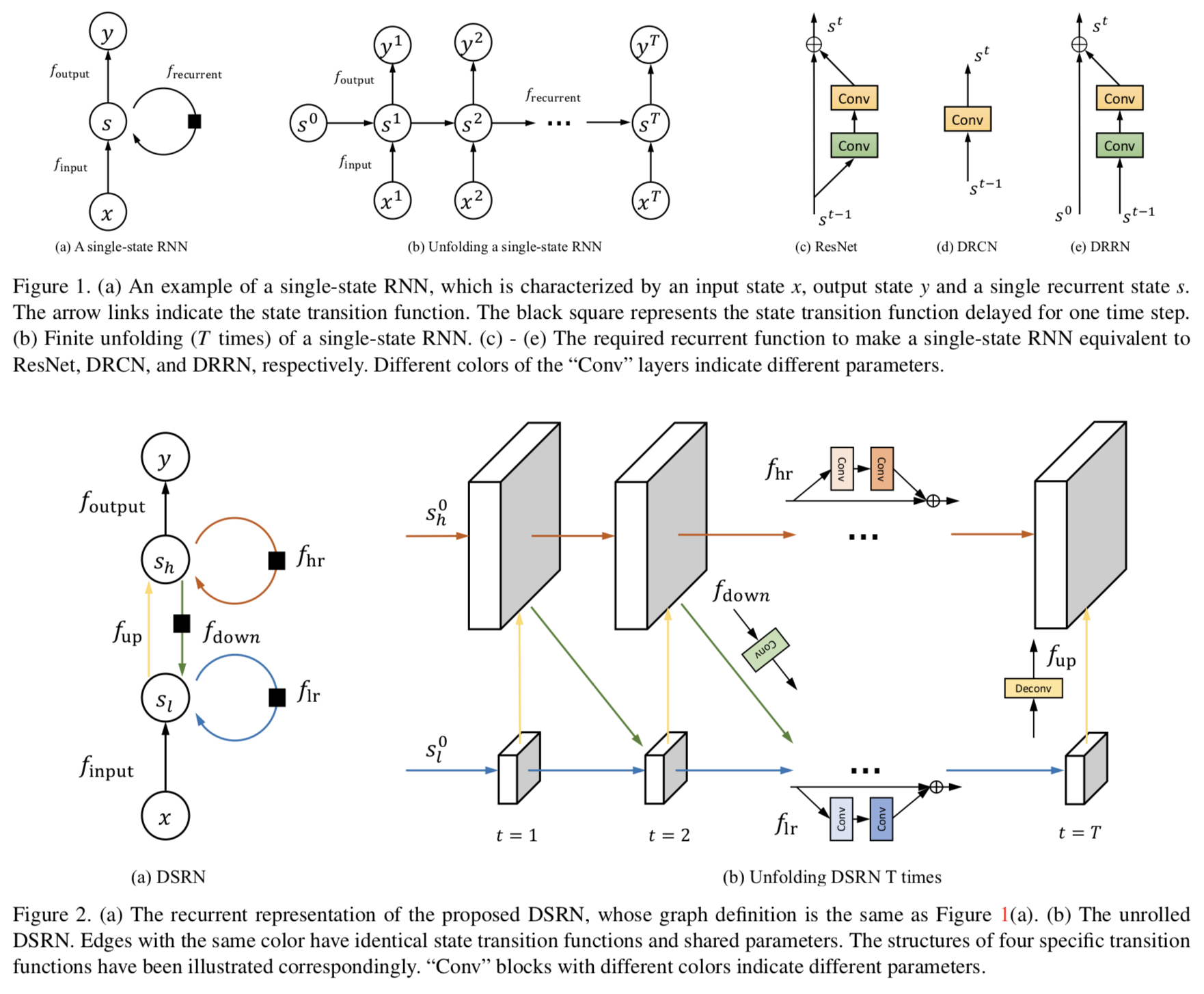

画像の超解像を行うために、高解像度(HR)と低解像度(LR)の2つのstateを持ったRNNベースのモデルであるDual-State Recurrent Network (DSRN)を提案。画像の超解像はCNNで行われることが多いが、パラメタ数が多く、これを削減するためにRNNに着目。RNNを用いた画像の超解像を行うDRRNと異なる点として、提案ネットワークではbottom stateでLRを、top stateでHRをキャプチャし、 delayed feedback mechanismを用いることでLRとHRの双方向のマッピングを行う。

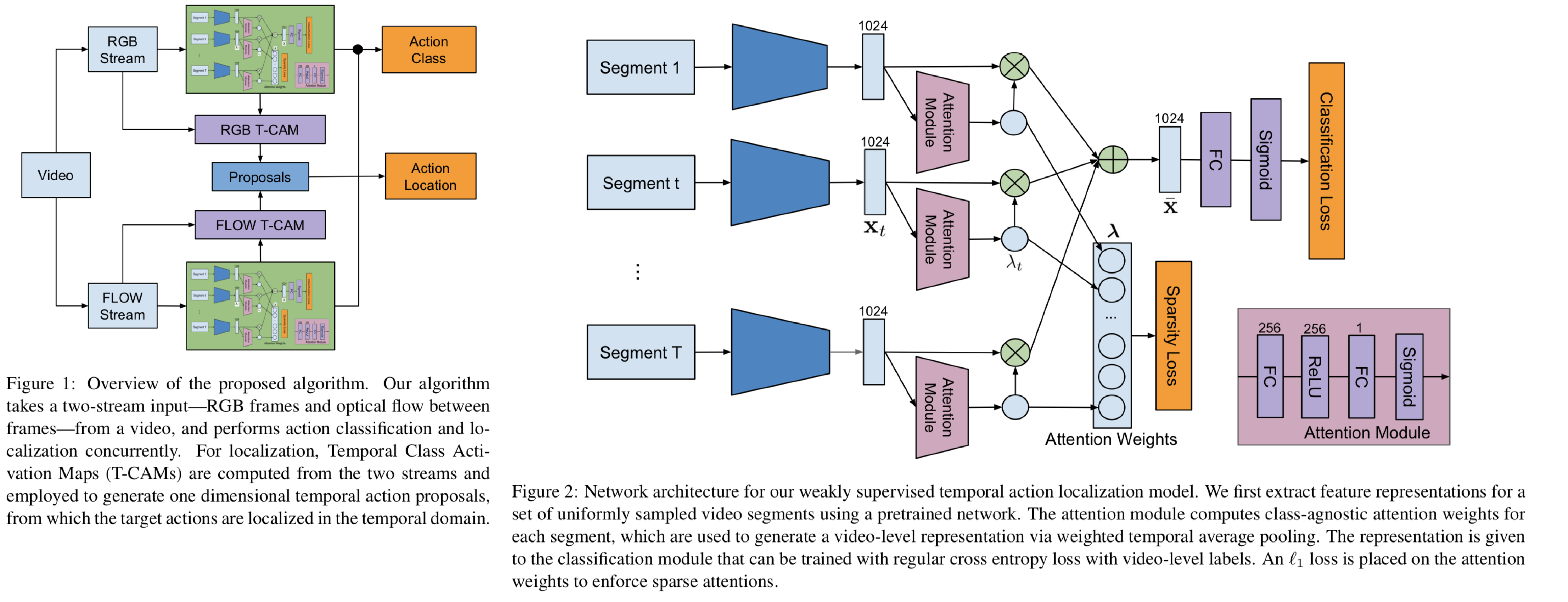

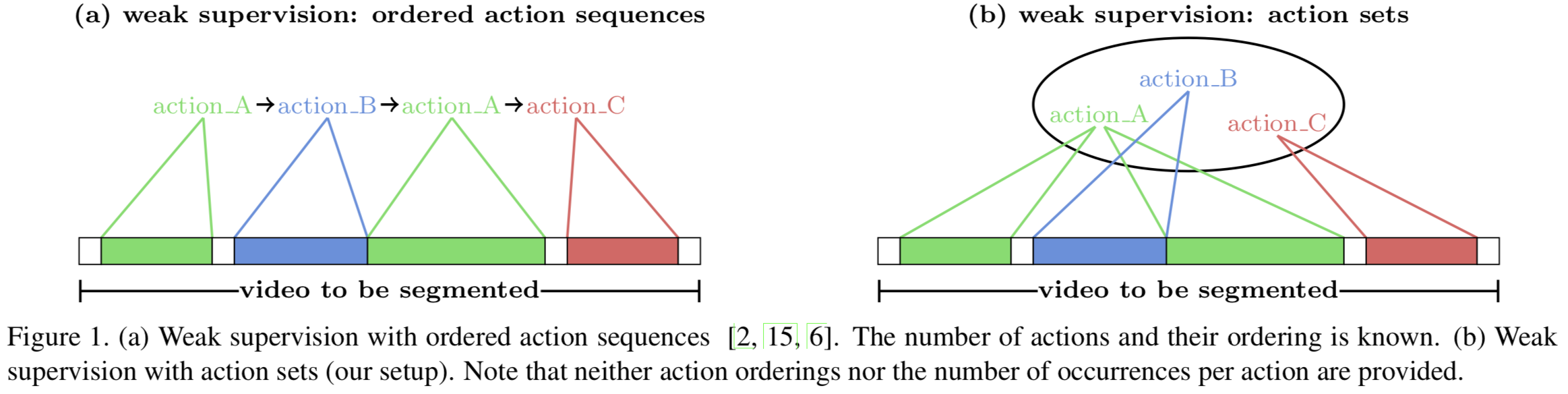

トリミングがされておらず、かつvideo-levelのactionラベル(動画内に存在するactionのラベル)を用いた弱教師学習によって、時系列上のaction localizationを行うSparse Temporal Pooling Network (STPN)を提案。提案手法では一定間隔で取り出された動画のセグメントに対してactionのclassificationロスと、各セグメントごとの、クラスに関わらず、actionのsparsityをL1ロスを用いて考慮することで、actionが存在し得るセグメントをプールしていくことでネットワークのトレーニングを行う。上記をRGBの入力とoptical-flowの入力を用いたtwo-streamで行う。

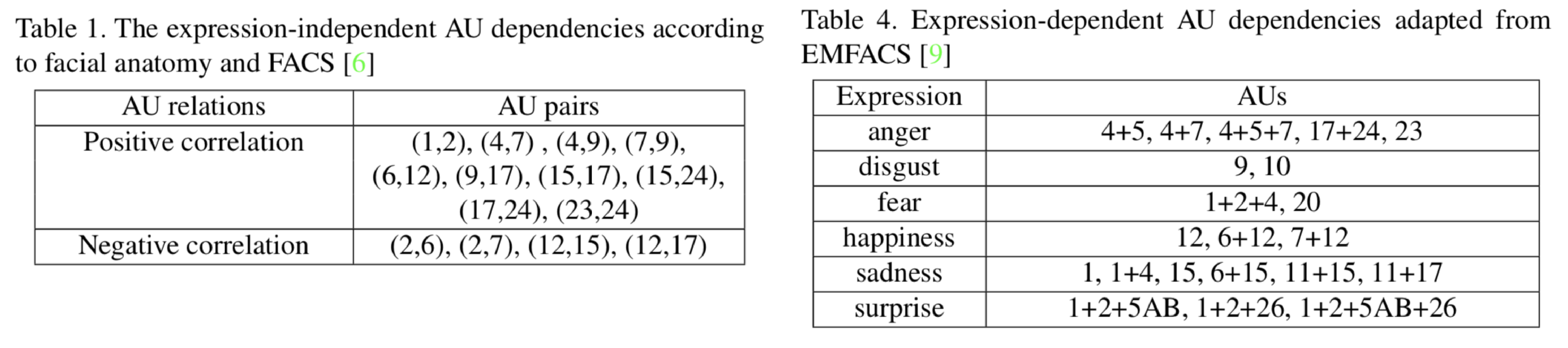

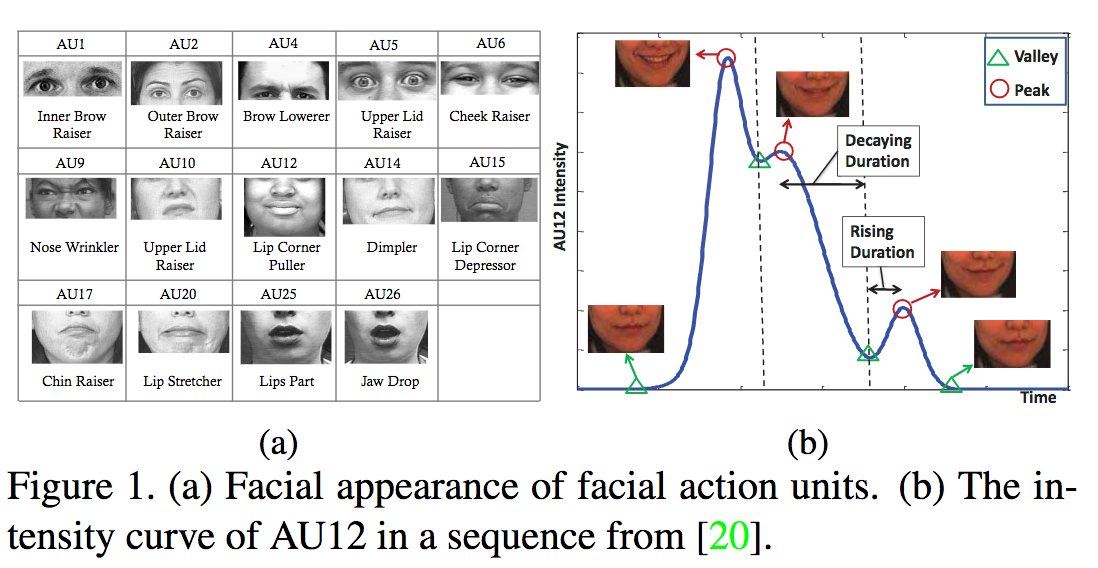

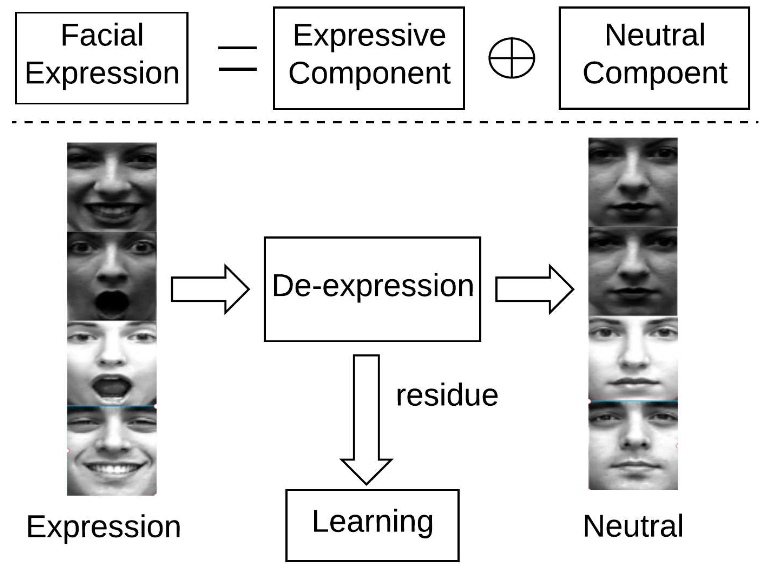

facial action units (AUs)のアノテーションを用いず、顔画像から得られるAUsの確率分布を用いてAUsの識別を行う手法を提案。AUsは表情や個人に依存するため、専門家がアノテーションしなければならずデータセットの構築が難しい。提案手法では、解剖学てきな知見から得られるAUsの確率分布と表情に関する研究から得られるAUsの確率分布を使用し、それぞれのAUsの識別器を同時に学習する手法を提案。

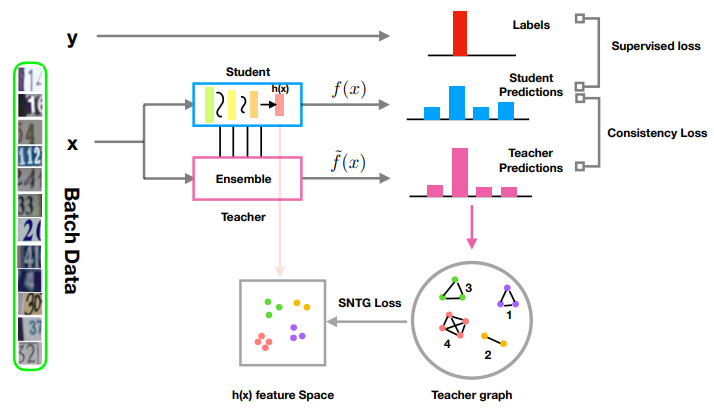

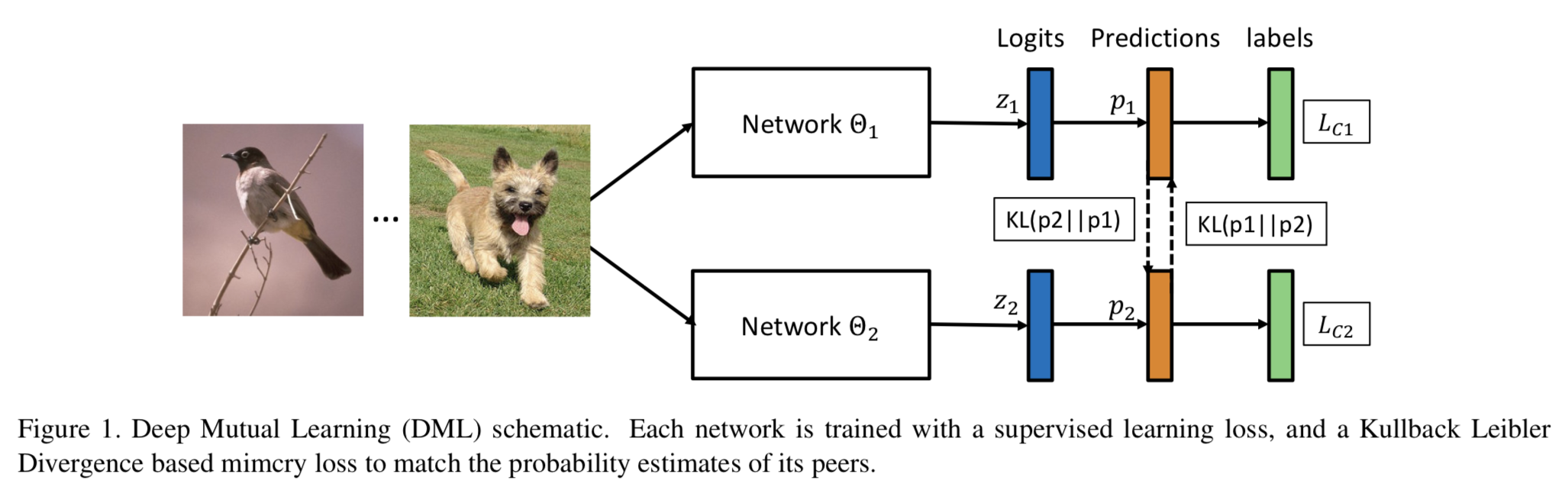

複数のネットワークを同時並行で学習し、お互いの情報を共有することで最終的な精度を向上させるDeep Mutual Learning(DML)を提案。論文中では特に識別タスクを扱っている。それぞれのネットワークを通常の識別に関する教師あり学習のロスと、他のネットワークによる推定ラベルの確率分布を事前情報としたKL divergenceをロスとして用いることで学習を行なっていく。比較手法としてネットワークの蒸留をあげており、上流ではteacherネットワークはstudentネットワークよりも小さくなければいけないが、DMLでは小さなネットワークだけで学習を行うことでき、ネットワークのサイズにとらわれない枠組みとなっている。

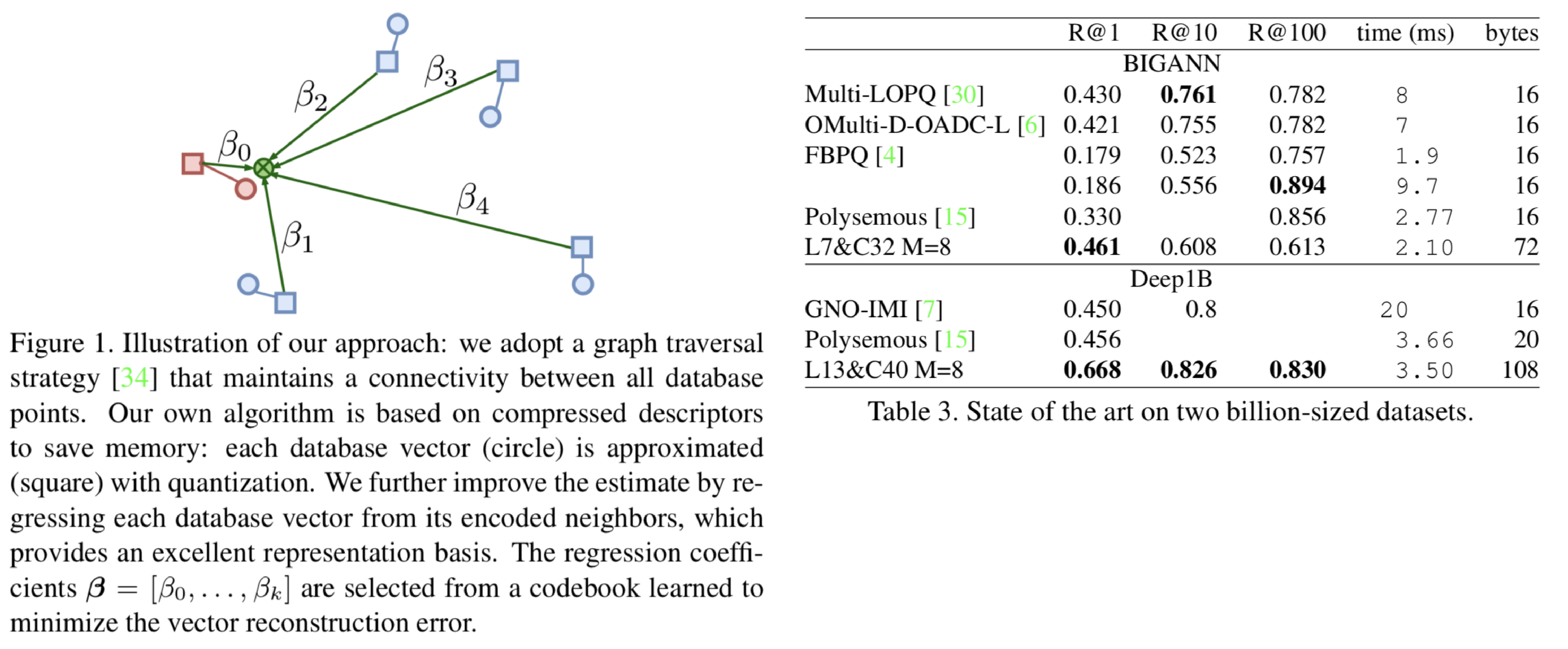

暗号化によるデータ圧縮とグラフ構造を用いた画像の類似度探索手法L&C(link and codeを提案。DNNなどで得られた特徴量をそのまま使用するとデータ容量が大きく、既存手法では精度が低いことを主張。提案手法ではデータ容量を小さくしつつ、検索精度を上げ、検索時間短くする手法を提案。各データベースで与えられている画像特徴量を暗号化を用いて圧縮し、次にHSNWというグラフベースのインデックス手法を用いてグラフを構築。グラフの精度向上のためにエンコードされた画像を復元し、近傍のデータから十分探索可能な場合には余計なデータを付加せず、そうでない場合には周囲のデータによる回帰をオフラインで行い、その回帰係数を格納する。

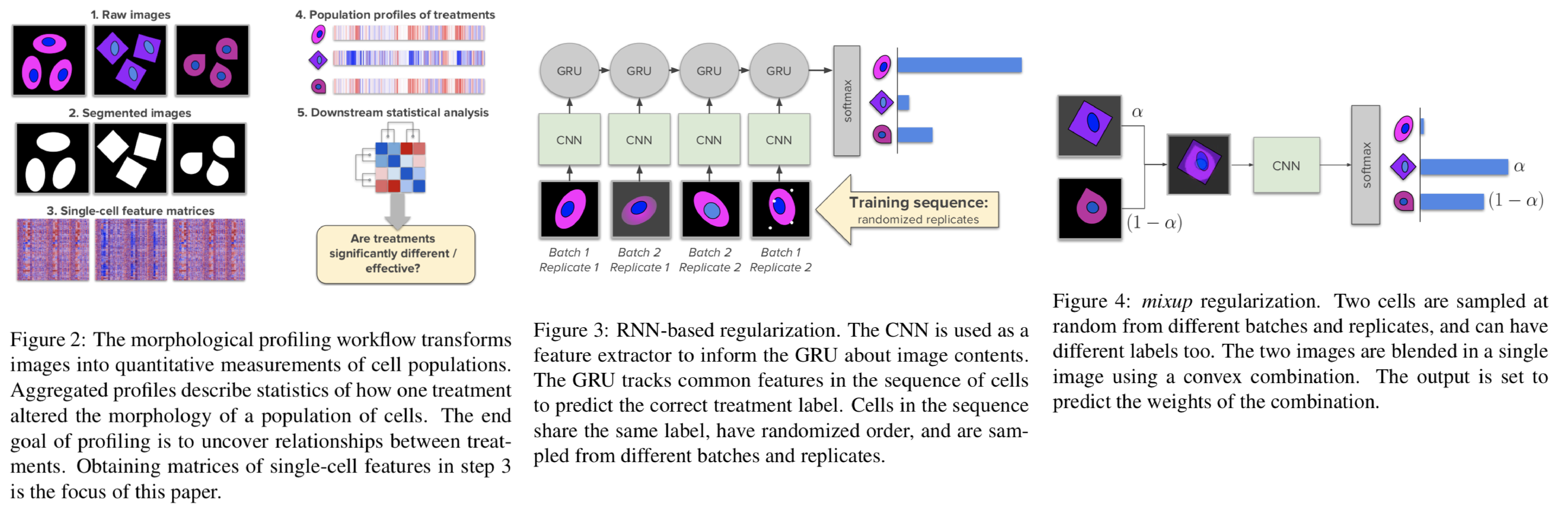

顕微鏡で撮影された細胞に対して画像的な見た目と生物学的な関係性を推定するために、CNNに対して半教師学習を行う。論文中に行われる実験では変異肺がん細胞の画像から遺伝子を推定するために、化学処理された変異肺がん細胞の画像を用いた化学処理のラベル推定をCNNで学習する。しかし化学処理は対象となる細胞が異なる場合には反応しないこともあるなど、ラベルとしてはかなりノイジーである。そこでRNN-based regularizationとmixup regularizationという2つの正則化を行う。RNN-based regularizationでは同じ化学処理や同じ細胞からは似たような特徴量を得るように学習し、mixup regularizationでは2つの画像をアルファブレンディングした時に、そのソース画像の識別とブレンド率の推定を行う。

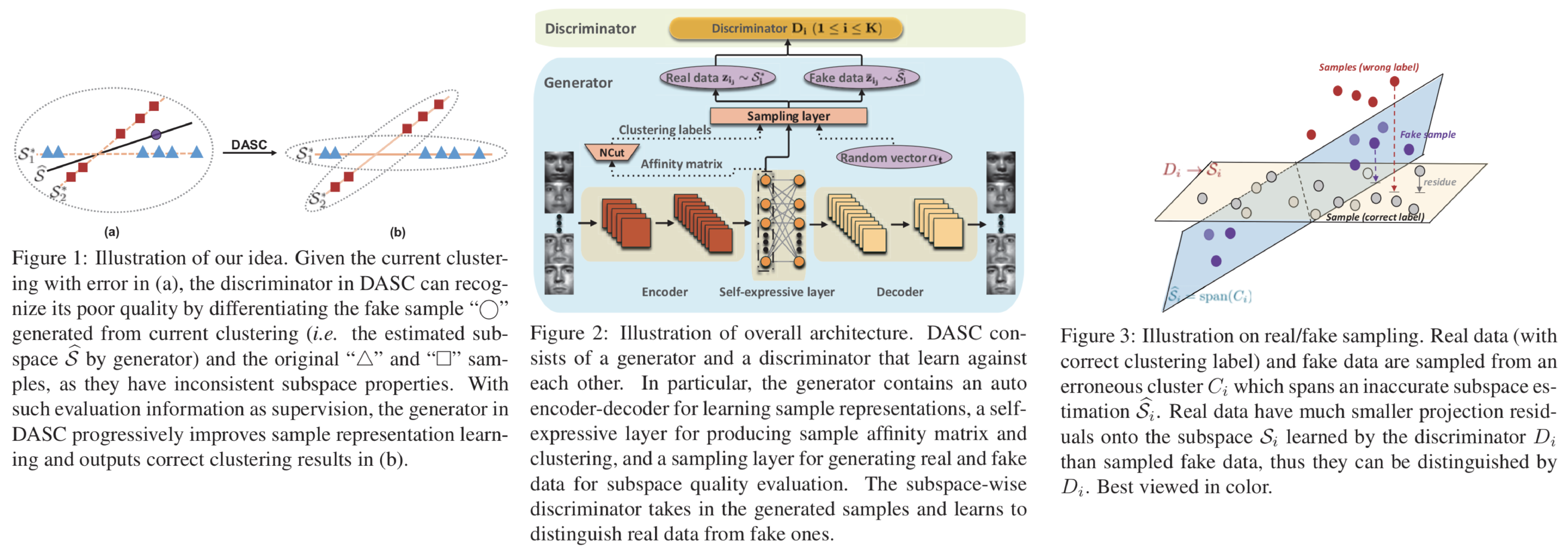

サブスペースクラスタリングを敵対的学習によって行うdeep adversarial subspace clustering (DASC) modelを提案。多くの既存手法ではハンドクラフトな特徴量を使用していたが、提案手法では初めて敵対的学習を教師無しの手法を提案。ネットワークは特徴量を抽出するencoder、画像のリコンストラクションを行うdecoder、sampling layerから得られたfakeデータと実際のデータ(real)を識別するdiscriminatorからなる。discriminatorはデータの識別を行う際に、realを超平面状に射影するような行列を作成しつつ、realは射影するエネルギーが小さいが、fakeは射影するエネルギーが大きいという過程のもとデータを識別。より良い射影行列を作成することでサブスペースクラスタリングを行う。

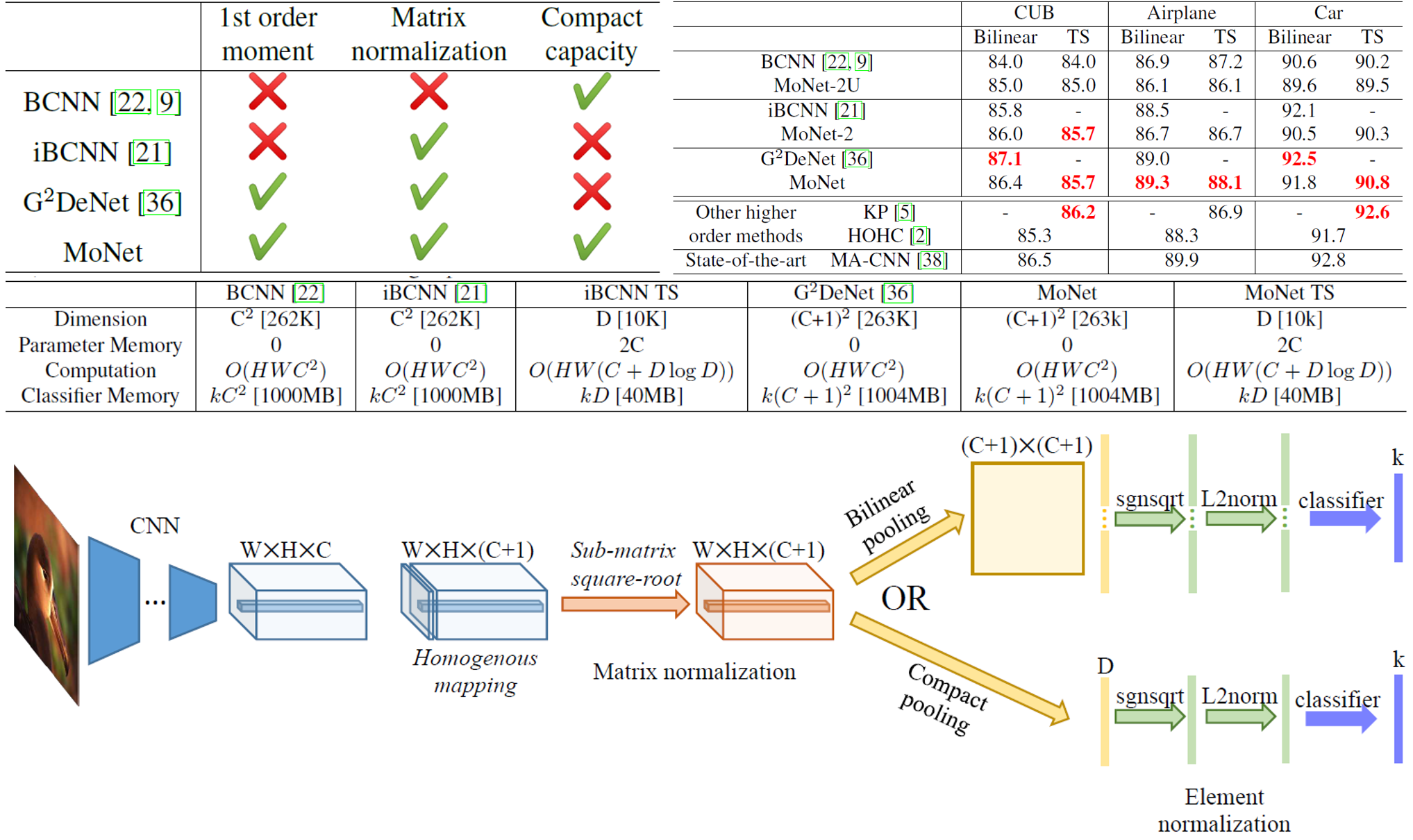

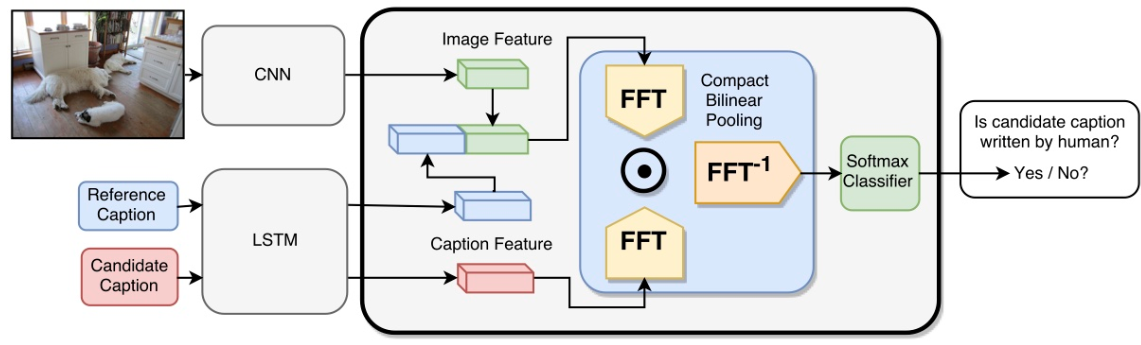

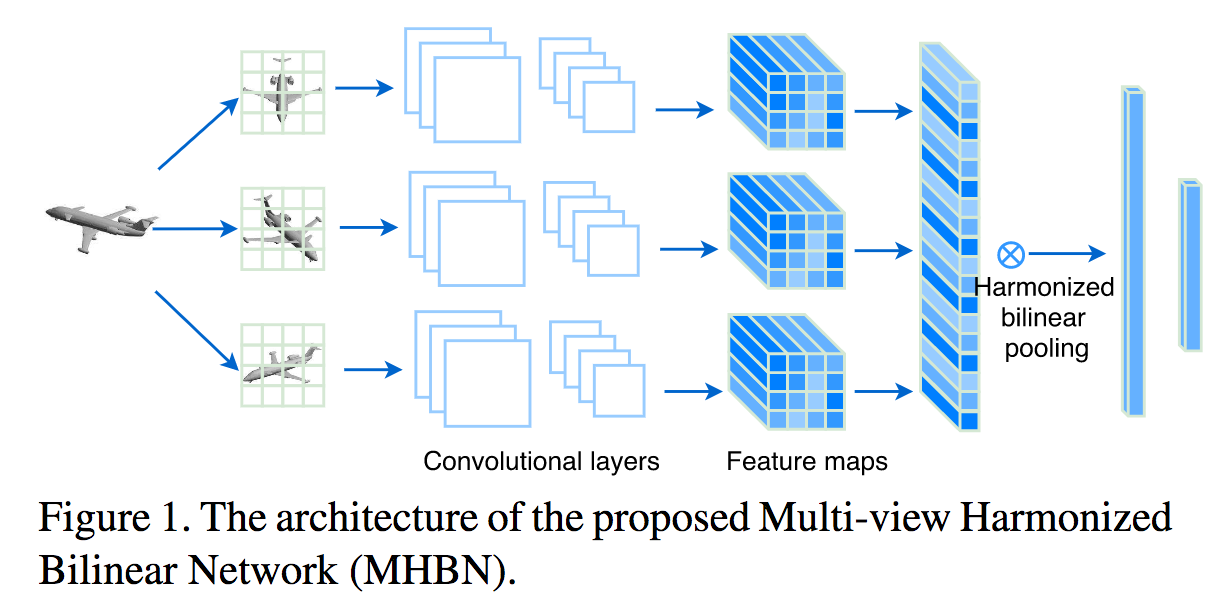

Bilinear Poolingは2次の統計量を用いているため非常に良い精度を出す一方で、出力の特徴量の次元数が膨大になるといった問題点がある。本論文はBilinear Poolingの次元数をコンパクトにしたネットワークMoNetを提案した。MoNetはSoTAと同等の精度を保ちながら、特徴量の次元を4%にまで落とすことに成功した。

Bilinear Poolingの次元数を減らすためCompact Poolingが提案されたが、通常のBilinear Poolingをさらに拡張したiBCNNやG2DeNetに対しては、Gaussian EmbeddingとBlinear Poolingが絡んでいること点と行列の正規化が必要な点から適用することができない。そこでMoment Matrixを用いてGaussian EmbeddingとBilinear Poolingを別にし、sub-matrix square root layerを追加してBilinear Poolingの前に正規化を行うことでCompact Poolingを適用可能にした。

そもそも要約動画として1つの最適解が存在するわけではないことを主張し、それぞれの視点に合わせて要約動画を行った研究。本研究では、動画間の類似度に着目し、フィッシャー判別から着想を得て、inner-summary variance、inner-group variance、between-group varianceに関して最適化を行うことで要約映像を生成した。また評価のためのデータセットを構築し、質的評価・量的評価を行った。

要約動画として満たすべき条件として(1)要約動画内で分散があること、(2)同一グループ内の動画を代表することができること、(3)他のグループの動画と識別できることを挙げている。これらに対応する要素がフィッシャー判別から着想を得たinner-summary variance、inner-group variance、between-group varainceである。これらをC3Dで抽出した特徴量に対して計算し、最適化することで解を得る。

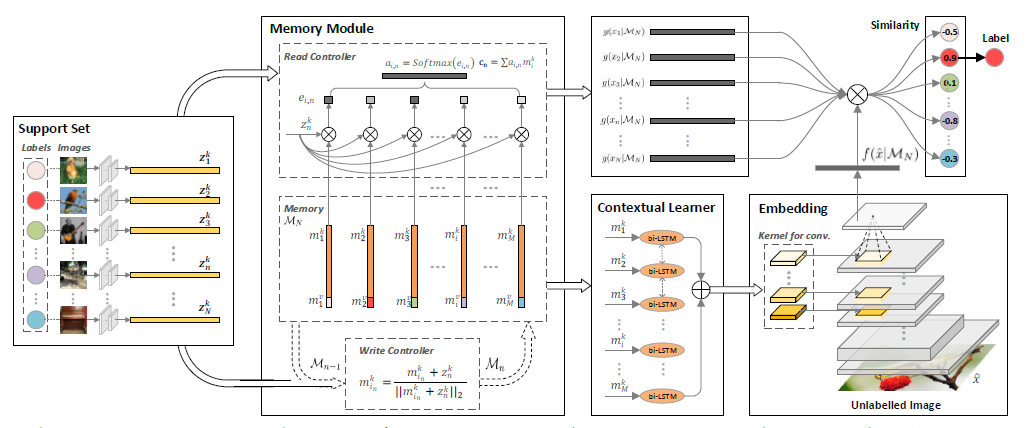

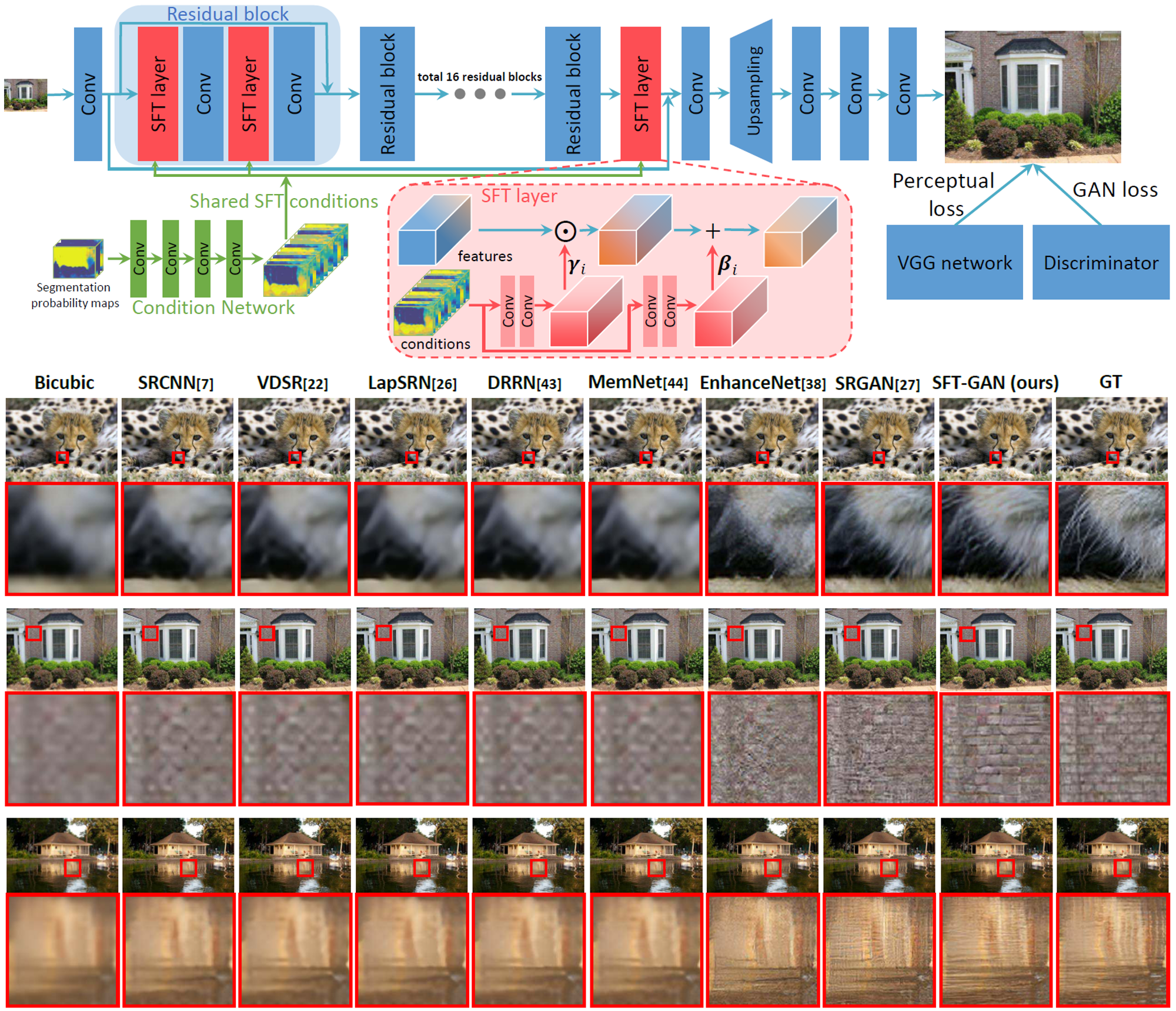

高解像度化タスクはill-posed problemであるため取りうる解が複数あり、GANを用いてもリアルなテクスチャを生成できていないが、特定のカテゴリに特化して学習させたネットワークを用いればリアルなテクスチャが生成できるという事実から、セマンティックセグメンテーションを利用した高解像度化に着目した。しかし、すべてのカテゴリごとに学習したネットワークを用意することは非現実的であるため、Spatial Feature Transform(SFT)層を導入することで、単一のネットワークでカテゴリ情報を考慮した高解像度化を行った。

SFT層は特徴量をアフィン変換をする層である。そのアフィン変換はスケールとシフトのパラメータで定義され、これらは各カテゴリごとの確率マップから与えられる。SFT層は従来のネットワークに導入することが可能であり、さらにセマンティックセグメンテーションに限らず、あらゆる事前知識(デプス情報など)に対しても適用可能である。

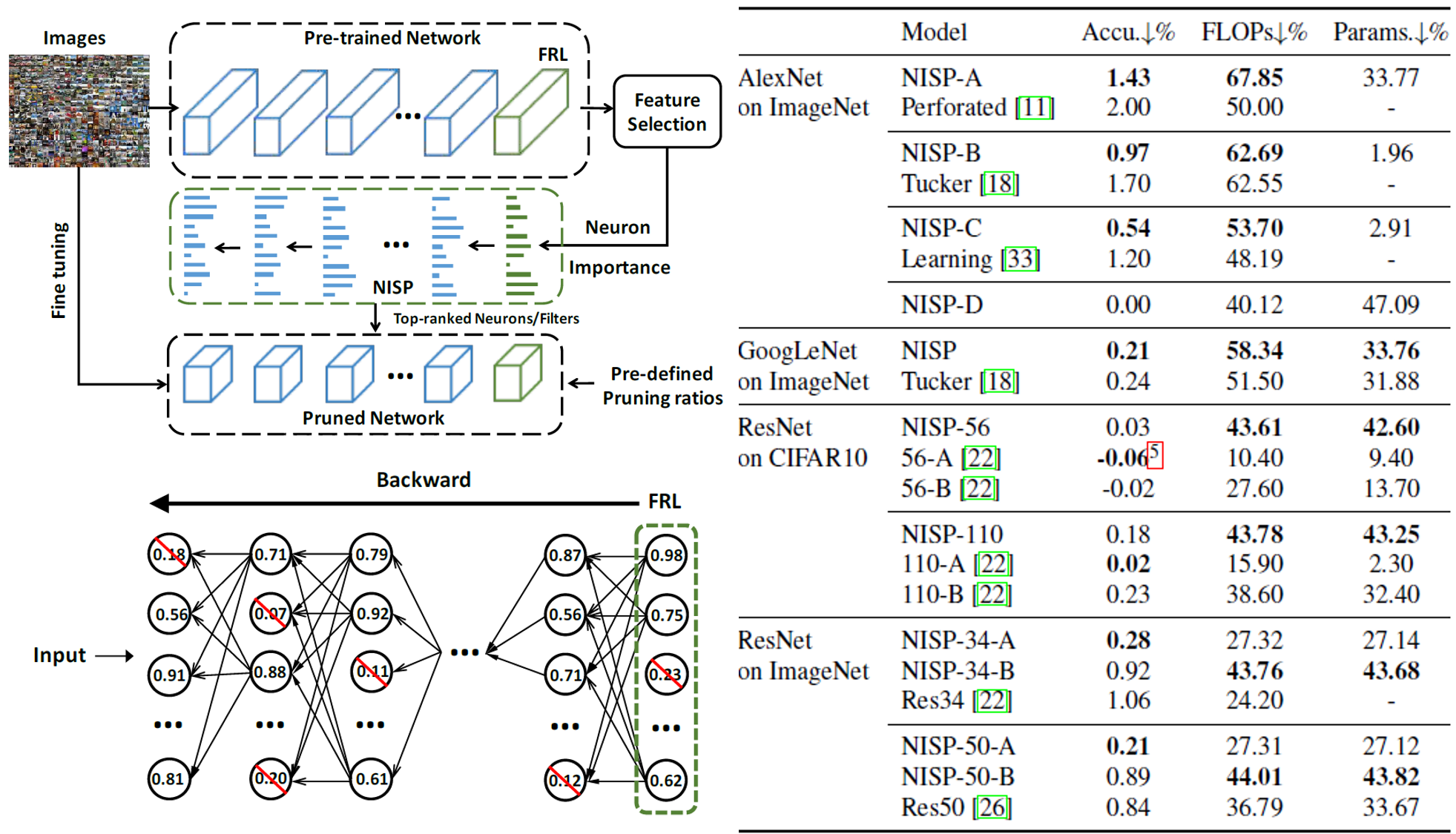

CNNのニューロンの冗長性を軽減するため、分類タスクにおいて分類する直前の層(FRL: Final Response Layer)の復元誤差を最小化するようなPruning(特定のニューロンを削除)するアルゴリズムNeural Importance Score Propagation(NISP)を提案した。如何に精度を落とさず、ネットワークに必要なFLOP数を減らせるかの実験を行い、AlexNetにおいては67.85%のFLOP数を削減したネットワークが1.43%しか精度を落とさないようにすることに成功した。

従来手法のほとんどは層ごとに独立して考えるか、次の層までを考慮にいれてPruningをする問題を解いていたが、重要なのは最後の層に与える影響であり、提案手法はそれを直接的に考慮している。提案手法はネットワークのPruning問題を、各ニューロンを削除すべきかいなかの0-1整数計画問題として定式化し、FRLの復元誤差を最小化する最適化問題を解く。実際には、目的関数を解析的に解くことはできないため、最適上限を求める問題に帰着させることで、閉経式で解くことが可能となった。

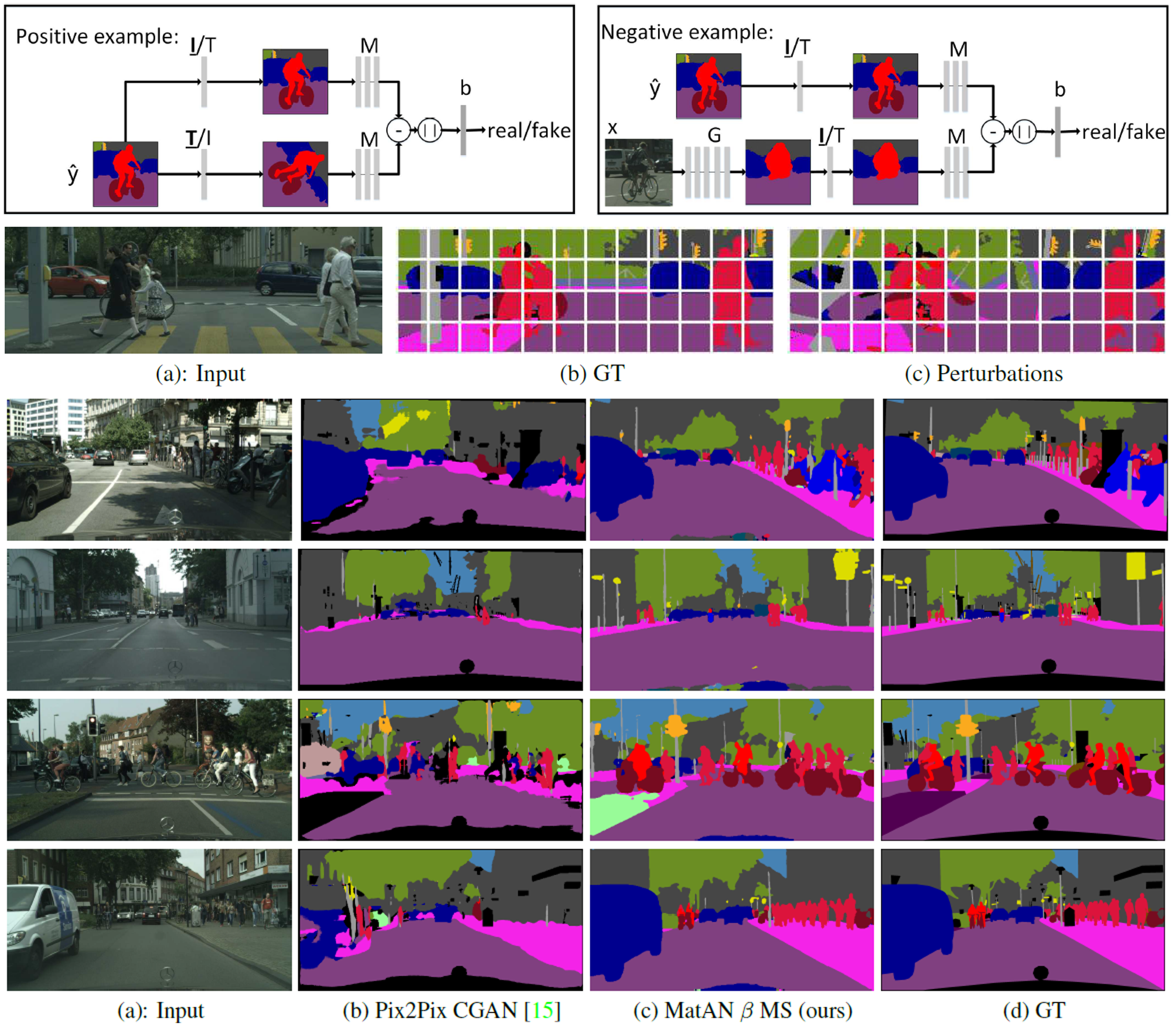

GANで教師あり学習をするタスクにおいて、DiscriminatorにSiamese Networkを適用することで直接教師データを損失関数に導入することが可能なMatching Adversarial Network(MatAN)を提案した。MatANは様々なGANで行う教師あり学習のタスクに適用することが可能であり、実験においてはsemantic segmentation、road network centerline extraction、instance segmentationのタスクに適用し、良い精度を出した。

DiscriminatorをSiamese Networkにする。2枚の画像ペアのうち、1枚はground truthであり、もう1枚はnegative sampleはGeneratorによって生成された画像もしくはground truthに摂動を加えた画像である。学習の方法自体は、通常のGANと同様に、Discriminatorはrealかfakeかを識別できるように学習し、GeneratorはDiscriminatorの識別率を下げるように学習する。

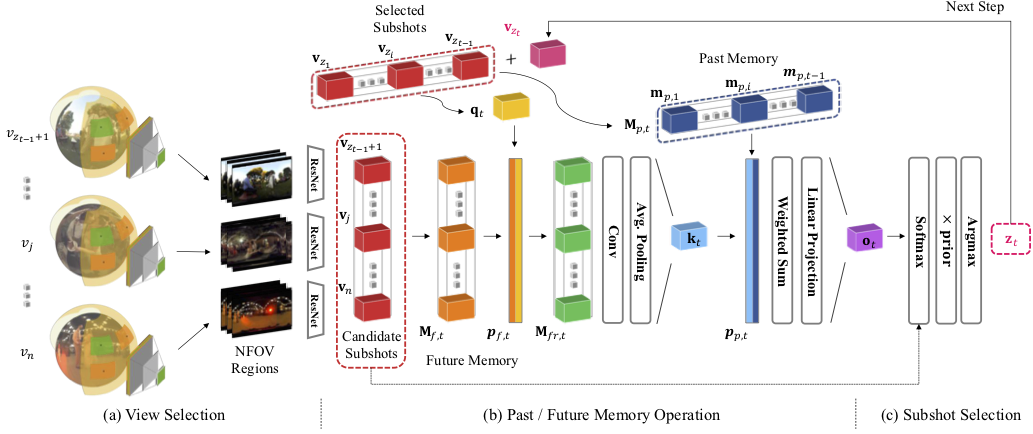

動的に映像内容が変化する360°動画における視線推定を行った論文。まず動的に映像内容が変化する360°動画の大規模データセットを構築し、そこから視線推定には過去の視線のパスと映像内容が重要であると分析し、その上でCNNとLSTMを組み合わせて顕著性と過去の視線のパスの両方を考慮した視線推定手法を提案した。

論文で対象としている動画と従来研究が使用している動画の違いとして、1) 通常の映像では受動的に動画を視聴しがちであるが、360°動画では能動的に視聴しようとする点。2) 従来の360°動画は静的な映像内容のものを扱っていた点。3) 提案手法ではHMD内に搭載可能な7invensu a-Glassを用いており、頭部の動きに加えて注視点の情報を取得している点を挙げている。データセットには音声情報もついており、360°動画における音声情報を考慮した研究も今後行っていくとのこと。

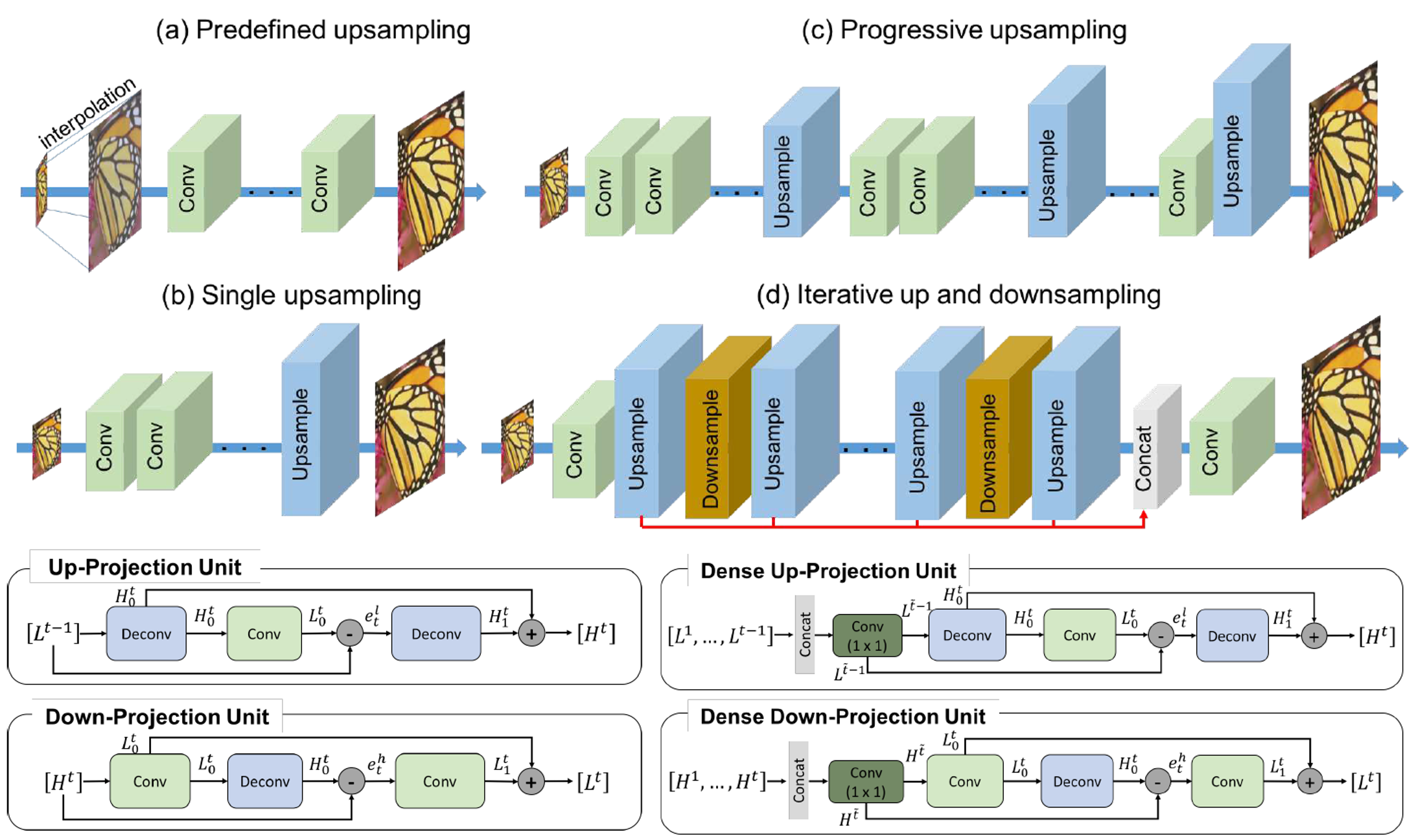

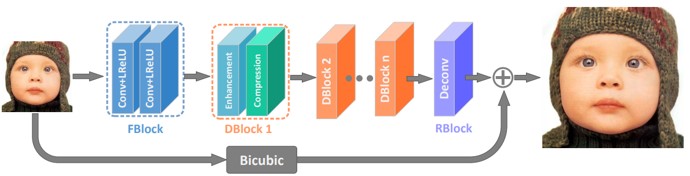

高解像のタスクに対して、アップサンプリングとダウンサンプリングを交互に繰り返す構造を持つDeep Back-Projection Networks(DBPN)を提案した。従来のネットワークはアップサンプリングを行う方向(feed-forward connection)しか考えておらず、それをダウンサンプリングする方向(feedback connection)を考えていなかったため、大きなスケール変化に対応できていなかった。本論文は1991年のCVGIPで発表された論文に発想を得て、アップサンプリングとダウンサンプリングを交互に繰り返す構造を取り、SoTAを達成した。

DBPNはup-projection unitとdown-projection unitからなる。up-projection unitの手順は、1) 一つ前の状態の低解像度画像(LR)をスケールアップし高解像度画像(HR)を生成し、2) 次にHRをスケールダウンさせたLRを得る、3) スケールアップとスケールダウンを経て得られたLRと入力のLRの差分を計算した後、4) その差分を元に再度スケールアップをすることでHRを得る、5) 最後にこのHRと最初にスケールアップで得られたHRを足し合わせたものを最終的なHRの出力とする。down-projection unitはこの反対の操作を行う。

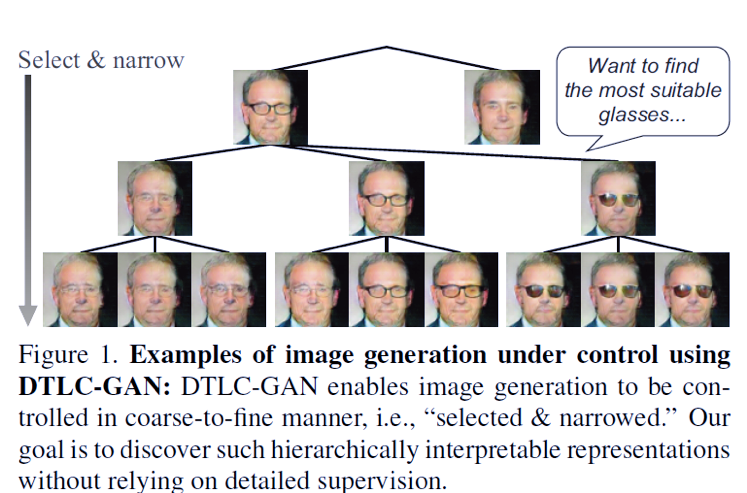

属性を階層的に選びながら画像生成できるDTLC-GANを提案.階層的な構造を課すために,我々はDTLCと呼ばれる新しいアーキテクチャを生成器入力に組み込む.DTLCとは,教師データなしまたは,最上位層の教師データだけで改装の表現を自動で発見できるアルゴリズムである.DTLC-GANをMNIST,CIFAR-10,Tiny ImageNet,3D Faces,CelebAなどのさまざまなデータセットで画像生成や画像検索のタスクの有効性を確認した.

アウトライヤのあるデータについての部分空間クラスタリングでは,正則化最適化による従来法によればデータサイズに対して計算複雑性が多項式スケールで伸びる. また,手動チューニングが必要.

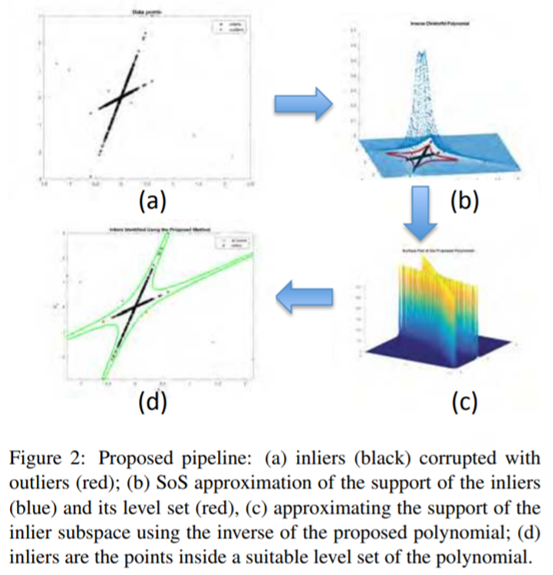

本稿では,データから直に計算できる二乗和の多項式の評価に基づく外れ値除去アルゴリズムを提案する. 計算量がデータサイズに依存しない特異値分解は2回だけ求めればよく,効率的に計算できる. インライヤ・アウトライヤ分類の誤り率を出力する枠組みも提供.

外れ値除去について,理論的な枠組み,効率的な計算を提供.

種々のデータセットにおいてSoTA性能を確認.その時の計算時間は従来法より10~50倍速い.

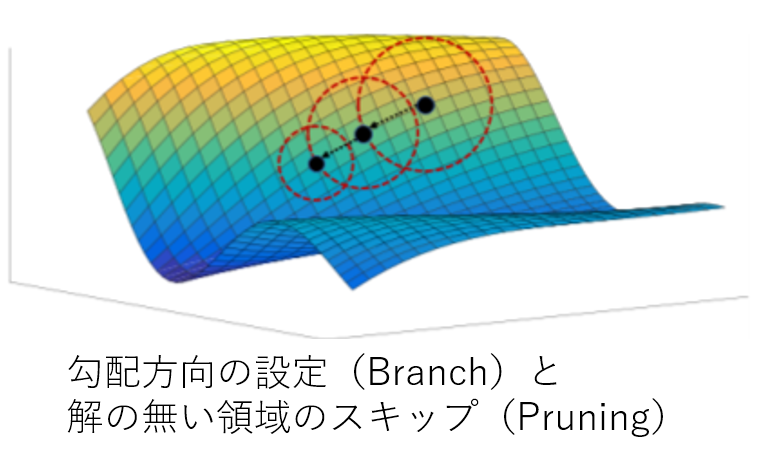

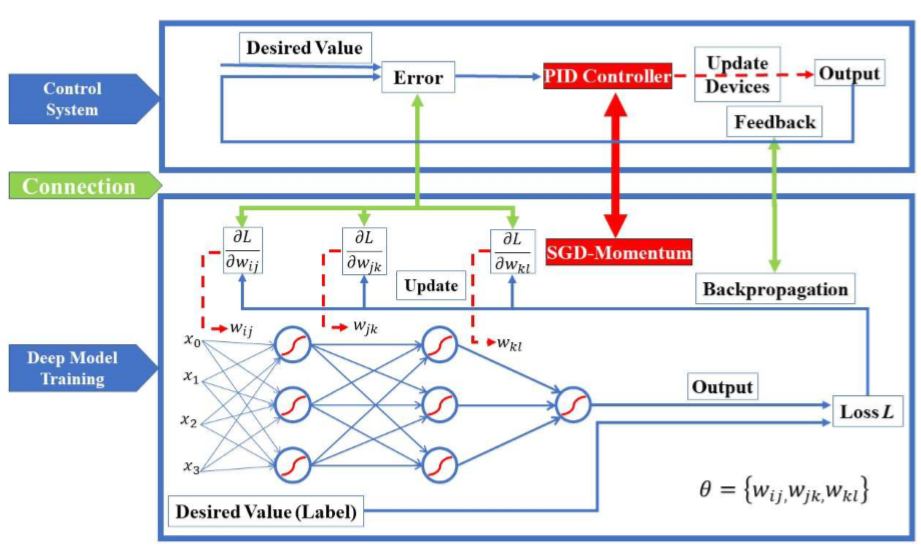

深層学習において大域最適解に導くソルバー(BPGrad)の提案.Branch & Pruning(分枝限定法)を導入している.

リプシッツ連続性の概念で説明している.DLの関数がリプシッツ連続になっている,あるいはリプシッツ連続になるように 近似して滑らかにすると,小さくて急峻な崖に陥るのを防げると説明している. リプシッツ連続を考えると,大域最適解の上限・下限がうかがい知れ,かつ 滑らかにできてよいらしい.

Branch(枝分け):次に移動すべき勾配方向を提案,Pruning(枝刈り): 理論的に大域的最適解が無いと分かっている領域には行かない.

理論的に大域最適解にアプローチする手法として初出,と主張.(本当?)

認識,検出,セグメンテーションのタスクにおいて,従来のソルバーより性能が良いことを確認.

画像中の(曲)線の構造理解(delineation)において,常習的に用いられているピクセルワイズのロス(バイナリクロスエントロピー)では行われていない, 穴あきや隣接線の数などの,トポロジカルな構造を考慮したロス(Topology-aware loss)を提案する. Imagenetで学習済みのVGG19を特徴記述子に使い,それと推定されたdelineationの差を見る. このペナルティ項をバイナリクロスエントロピーに追加してロス関数を設計する.

また,計算の複雑さを維持したまま,同モデルにおいて反復的に適用するリファインメントのパイプラインも提案.

![]()

いくつかのケースではバイナリクロスエントロピーの2倍の性能が出せた.顕微鏡画像から空撮画像までの幅広いレンジにおいてSoTA性能が出る.

確かにトポロジカルな構造を見るべきだろうと思うが,その特徴はImagenetで学習済みなのでそれを使うというのが注目すべきと感じる.

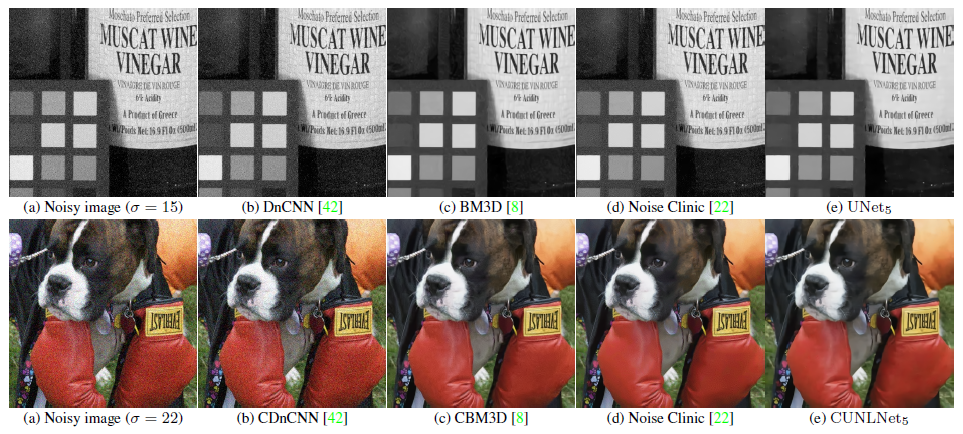

画像のノイズ除去のためのネットワークを提案。ネットワークはlocalな情報を見るものとnon-localな情報を見るものの2つを提案した。 ネットワークの評価関数としてはPSNRを用いた。

従来手法と異なり、ノイズのレベルに依らない手法である。CNNベースの従来手法よりも浅いネットワークにもかかわらず、PSNRの平均は最も高いという結果が得られた。

Person Re-identificationのラベル付けを最小化する手法を提案した。教師有りの手法は最も頑健であるが、カメラの数が増えるにつれてアノテーションの負担が増える。 そこで、少ないアノテーションからアノテーションのないペアの関係を推定することで問題を解決する。 例えば、カメラ1と2、カメラ1と3の間で同一人物と判定されたペアは2と3でも同一人物と推測される。 頂点を人物画像、エッジを同一人物であるかのスコアとしたグラフを考えることでアノテーションの補完を行う。 解くべき問題はNP困難であるため、計算量削減のための手法を2つ提案した。

2つの計算量削減手法はいずれも1/10にすることに成功した。WARD,RAID,Market1501の3つのデータセットにて数値評価し、ベースラインよりも少ないラベルでも全てラベルが存在する場合と同等の精度を出せることを確認した。

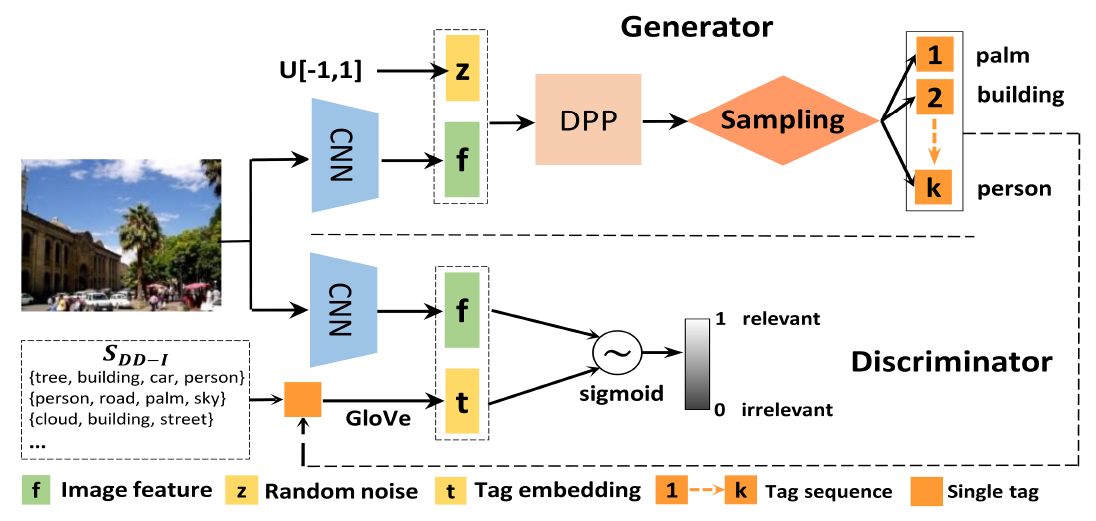

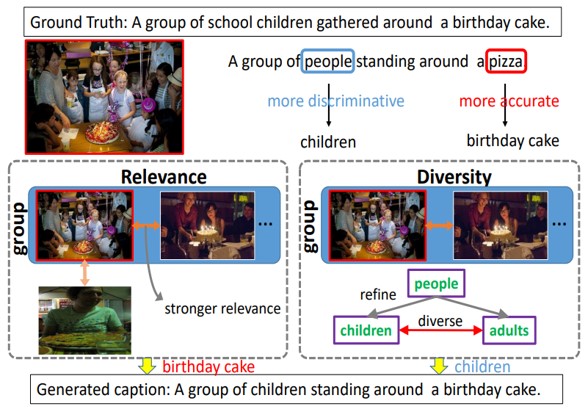

画像に対するアノテーションを自動で生成するdiverse and distinct image annotation(D2IA)を提案した。クラウドソーシングなどで人間の手によってアノテーションをする場合、人によって基準が異なる。 例えば、同じものを対象にしてもある人は教会と具体的にアノテーションするのに対して別の人には建物とより抽象的にアノテーションする。 他にも、ある人は建物の色に着目をするが別の人は写っている人の持ち物に着目する。 このように、人間のアノテーションの特徴を反映したモデルの構築を目指す。 アノテーションの生成はGANベースのモデルにより学習する。 Generatorは画像からアノテーションを出力し、Discriminatorは画像とアノテーションのペアから適切なアノテーションかを判定する。

Precision, Recall, F1で評価し、RecallとF1は従来手法と比べ最も良く、Precisionも最も良いものと比べ差が1%以内だった。ユーザースタディにおいても提案手法の方がいいと答えた人の方が多かった。

人間の判断に基づいた新たな画像キャプショニングの評価指標を提案した。画像、正解となるキャプション、生成したキャプションの3つを入力とし、生成キャプションが人間の作ったものであるかを判定することで学習を行う。 これにより評価時にはキャプションに対するスコアを出力する。 また、data augmentationの方法として他の画像のキャプションを使う、単語の一部を並び替える、単語の一部を置き換えるの3つを提案した。

従来提案されてきた評価指標と比べ人間の評価と相関が高く、Pearson's correlationが0.9を超えた。(従来のものの最大は0.75程度)

画像(orテキスト)からそれに対応するテキスト(or画像)を検索する手法を提案した。学習の過程はLook, Imagine, Matchの三つのステップに分けられる。 Lookでは、queryとして与えられた画像(orテキスト)から特徴量抽出を行う。 Imagineでは、得られた特徴量からテキスト(or画像)を合成する。 Matchでは、合成したテキスト(or画像)との類似度によってテキスト(or画像)の検索を行う。

従来手法では画像とテキストの特徴を共通の空間にマッピングしていたのに対し、それぞれを別に扱うことで画像の詳細を考慮することを可能にした。上位1位、10位のどちらの検索においてもベースラインよりも高い精度での検索を実現した。

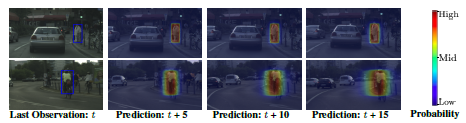

車の車載カメラから、人間(歩行者や自転車)の動きを予測する手法を提案した。人間の動きを予測するBayesian Bounding Box Prediction Streamと、車自体の動きを予測するOdometry Prediction Streamの2つにより構築されたモデルにより長期的な予測を実現する。 人間のBounding Box(BB)は、過去のBB、過去及び予測される車の動きから推定する。 車の動きは、過去の車の動き及び車載カメラの画像特徴から予測する。

人間の動きの不確かさを含めて予測することが可能となった。Kalman Filterと比べ、提案法はBB、車の動きどちらも高い精度で予測することが可能である。

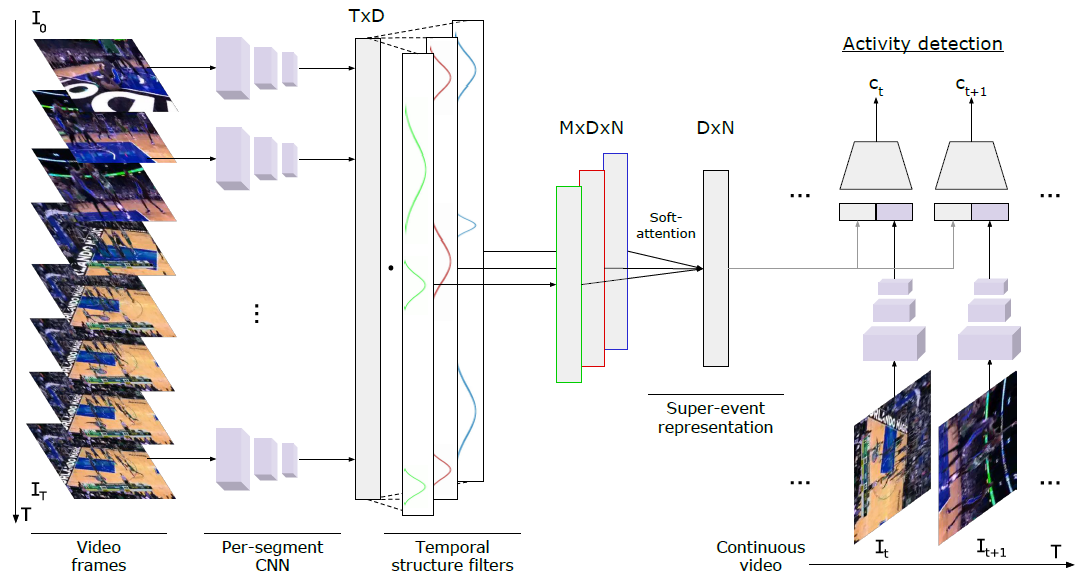

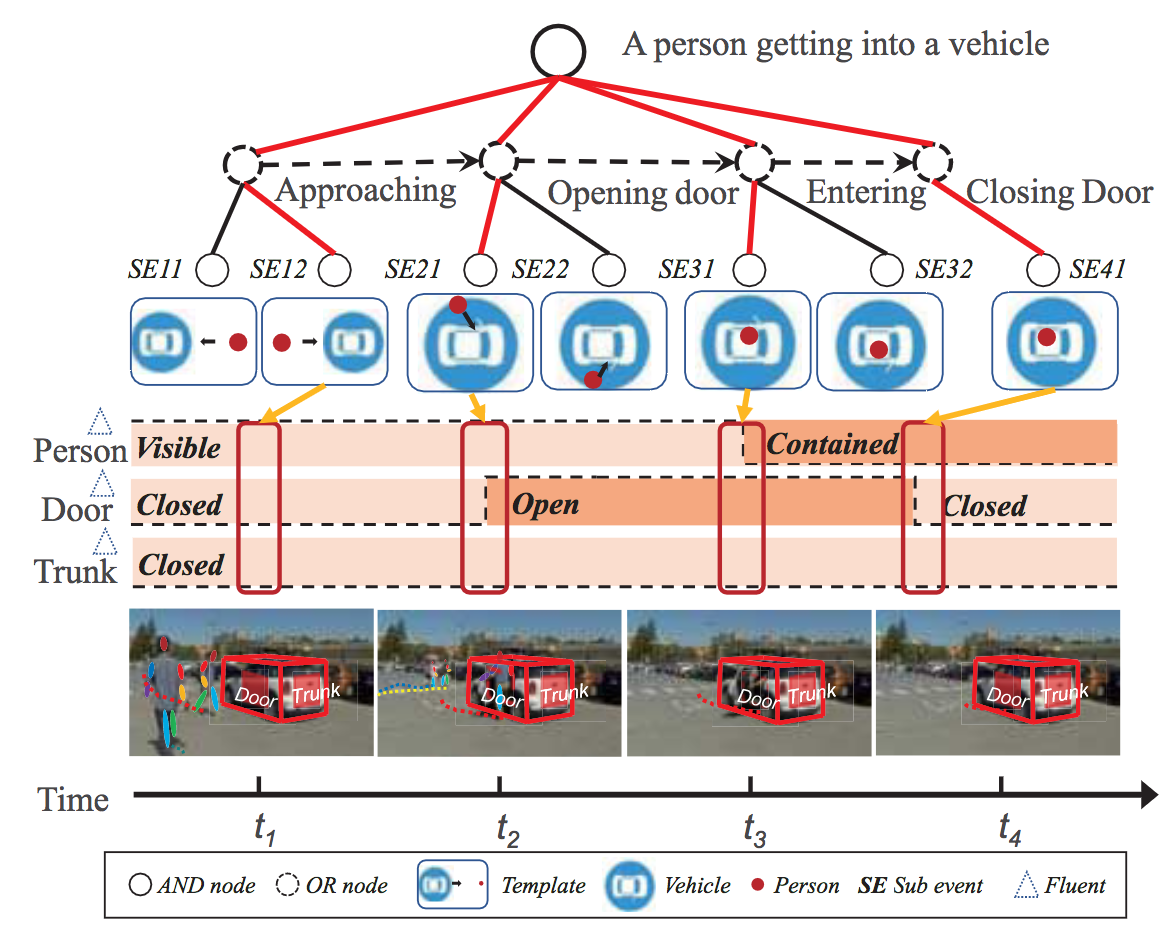

動画中に映る関連した一連のeventの集まりであるsuper-eventsという概念を導入し、Super-eventsに含まれる検出する方法を提案した。例えば、バスケの試合においてシュートを打つという行動とブロックするという行動は連続して起こる行動であり、関連しあっている。 このような一連の行動(シュートを打つ、ブロックする)をsuper-eventsと呼ぶ。 始めに、動画の各フレーム(or segment)からCNNにより特徴抽出を行う。 得られたCNN特徴から、context情報を考慮するためのTemporal Structure Filterというものを導入することでsuper-eventsを表す特徴を得る。 最後に、各フレームのCNN特徴とsuper-events特徴を用いてフレームごとのイベントを検出する。

MultiTHUMOS、Charades、AVAの3つの動画データセットにより実験を行った。Super-eventsを抽出することで、ベースラインでは検出されないイベントが検出することができるようになった。 I3Dにsuper-eventsを導入したものが最もmAPが高いという結果が得られた。

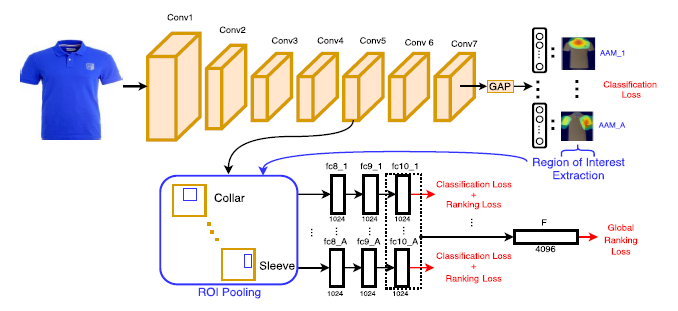

ファッションアイテムを検索するネットワークとしてFashionSearchNetを提案した。 FashionSearchNetは、クエリ画像に対して、襟の色のみ変えたものなど局所的なattributeを変えたものを検索することを実現する。 入力のファッション画像に対して、各attributeが画像中のどの領域に存在するかを示すAttribute Activation Maps(AAMs)を得る。 次に、AAMsより推定したROI内のconv5層の特徴を取得し、全結合層により各attributeを表す特徴量を得る。 最後に各attributeの特徴を結合して4096次元の特徴ベクトルを得る。

ベースラインの手法と比べ、FashionSearchNetは16%正確度が向上した。GPU計算の場合、60秒で1万枚の画像を処理することが可能である。

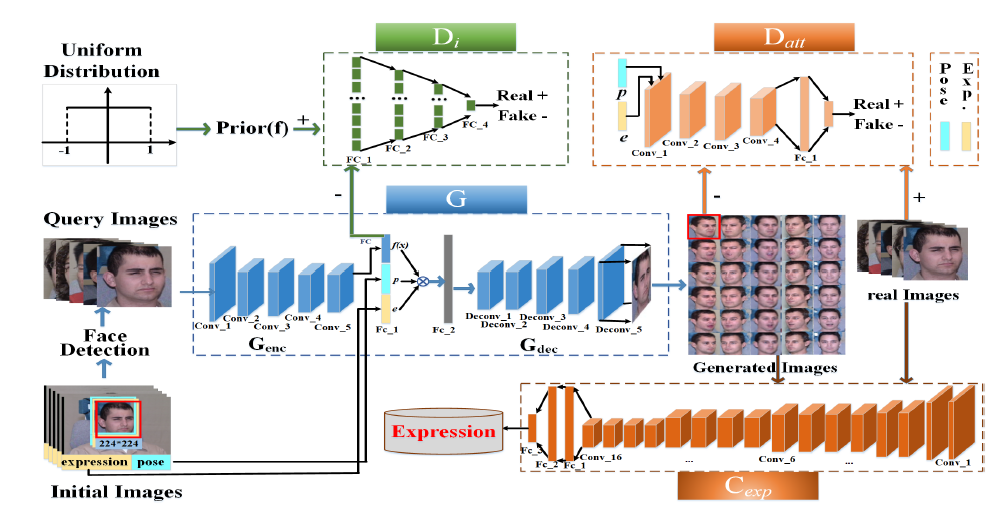

顔向きの違いを含めて学習するGANベースの表情認識手法を提案した。顔画像から、個性、表情、顔向きをそれぞれ表す特徴量を抽出する。 Generatorによってこれらの特徴量から表情、顔向きを変化させた画像を生成する。 Discriminatorは、個性とアトリビュートを判定する2つを用意する。 個性を判定するものは、顔画像から抽出した個性特徴によって判定を行う。 アトリビュートを判定するものは、顔画像及び表情・顔向き特徴によって判定を行う。 表情の識別器は、学習データに加えGeneratorによって生成した画像を用いて学習する。

Generatorによって表情、顔向きを変化させた画像を生成することによって、少ない学習データでも表情識別器の学習が可能となった。Multi-PIE、BU-3DFE、SFEWの3つのデータセット全てにおいて平均の識別率は従来手法と比べ最もよい数値を記録した。

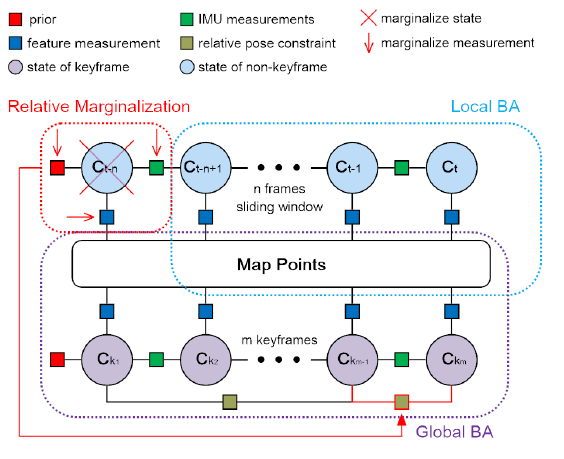

Visual-Inertial SLAM(VI-SLAM)の最適化計算に関する研究。画像情報と慣性情報を用いたポーズ推定は、VI-SLAMの計算時間を大きく左右する。 SLAMはその応用先ゆえにリアルタイムで動くことが求められるため、高速化にはポーズ推定の高速化が求められる。 そこで、従来手法と比べより効率よく最適化する手法を提案した。

従来法では短期間の情報しか最適化に用いることができなかったのに対し、計算効率を10倍に向上することでより長期的な情報を使用して精度を向上することに成功した。

他の人種や性別(source)による学習結果を用いることで、学習データが少ないグループ(target)に対しても適用可能な年齢推定手法Deep Cross-Pupulation(DCP) age estimationを提案した。始めに、データが多いグループ(source)を用いてranking problemとして学習することでグループに依らない共通の特徴(low-level aging features)を取得する。 次に、得られたパラメータからsource, targetそれぞれのネットワークを更新していく。 ここでは、source, targetそれぞれの顔画像を入力として2枚の画像が年齢が同じか異なるかを学習していく。 これにより、グループごとの年齢特徴(high-level aging features)を得る。

従来手法はグループごとに学習していたため、データが少ない人種などには適用が難しかったが、提案手法によりデータが少ない人種への適用が可能になった。Morph Ⅱ,WebFaceで実験をしてMAEがベースラインと比べ最も小さく(3.1~4.6程度)なった。 targetのデータ数が10%程度の場合でもMAEが5.3となった。

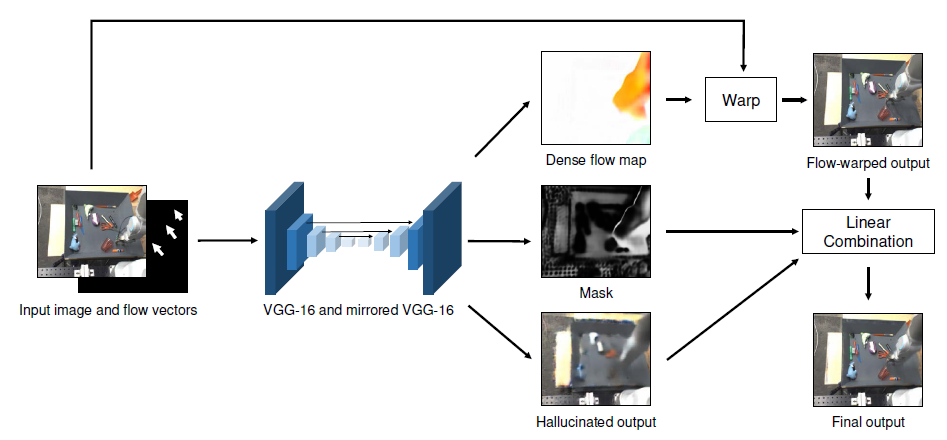

動画の初期フレームと、モーションの軌跡を入力することで動画を生成する手法を提案した。入力画像とフローベクトルから、Flow、Hallucinated output、Maskの3つを予測するネットワークにより実現する。 予測フレームの情報が、入力画像に含まれている場合はFlowによる変形によりピクセル値を取得する。 一方で、初期フレームに映っていない情報や、色の変化についてはFlowによる変形では実現できないため、Hallucinated outputにより取得する。 上記2つの画像のうち、どちらの情報を用いるかをマスクによって指定することで出力を取得する。

KITTI、Robotic Pushing、UCF-101の3つのデータセットにより実験を行った。各データセット中の動画から得られるFlowを入力として実際の動画中のフレームと予測フレームを比較したところ、PSNR、SSIMいずれの手法も提案手法が最も良いことを確認した。 ユーザースタディの結果、Flow、Hallucinated outputのいずれかがない場合よりも両方ある場合の方が圧倒的に高い評価を得られた。

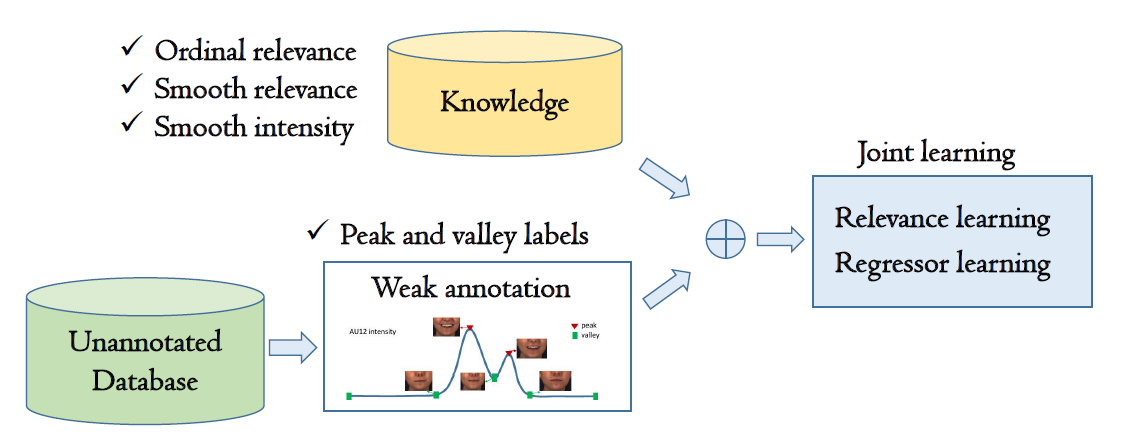

Action Unit(AU)の強度を推定するための弱教師学習手法を提案。表情認識の分野でAUは広く研究されているが、アノテーションの難しさから強度のラベルが付いた大規模データベースは存在しない。 そこで、比較的アノテーションが容易であるピークと谷のアノテーションのみから学習する弱教師つき学習手法を提案する。 アノテーションのついていないフレームについては、ピークと谷とのrelevalenceを考える。 その際、時系列的に近いフレームはrelevalence及びAUの強度は近い値になるようにすることで平滑化する。

FERA 2015, DISFA, PAINの3つのデータベースにより実験を行い、PCC, ICC, MAEの3つの指標を評価した。FERAは、1つのAUを除いて全ての指標がベースラインよりも良いという結果が得られた。 DISFAについてはPCC, ICCは多くのAUで最も良い数値となったがMAEは12のAUのうち4つのみが最も良い数値となった。 PAINについては、弱教師つきの従来手法よりはPCC, ICCが良いという結果が得られた。

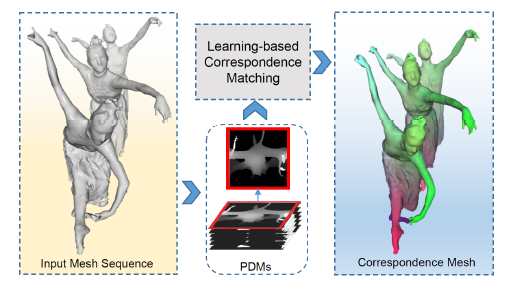

人間の3次元モデルの時間変化を、頂点の対応付けを行うことによってデータ量を圧縮する手法を提案した。多視点のdepthマップから作成した、Panoramic Depth Mapsを入力とすることで、3次元モデルの頂点の対応付けを行うネットワークを構築する。 得られた対応付けに基づき、頂点の時間変化を考える。 この時間変化に対するAuto Encoderを考え、中間層の出力を3次元モデルの時間変化として取り扱う。

従来手法と比較して、対応付けの誤差が小さく高い圧縮率を実現することに成功した。PCAベースの圧縮手法と比べ、圧縮の際の誤差を小さくすることに成功した。

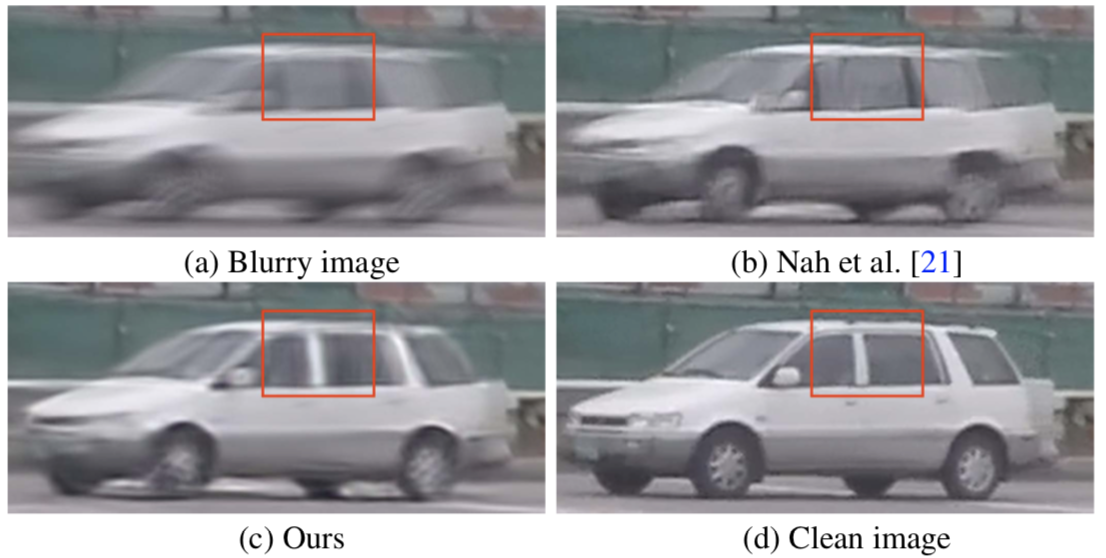

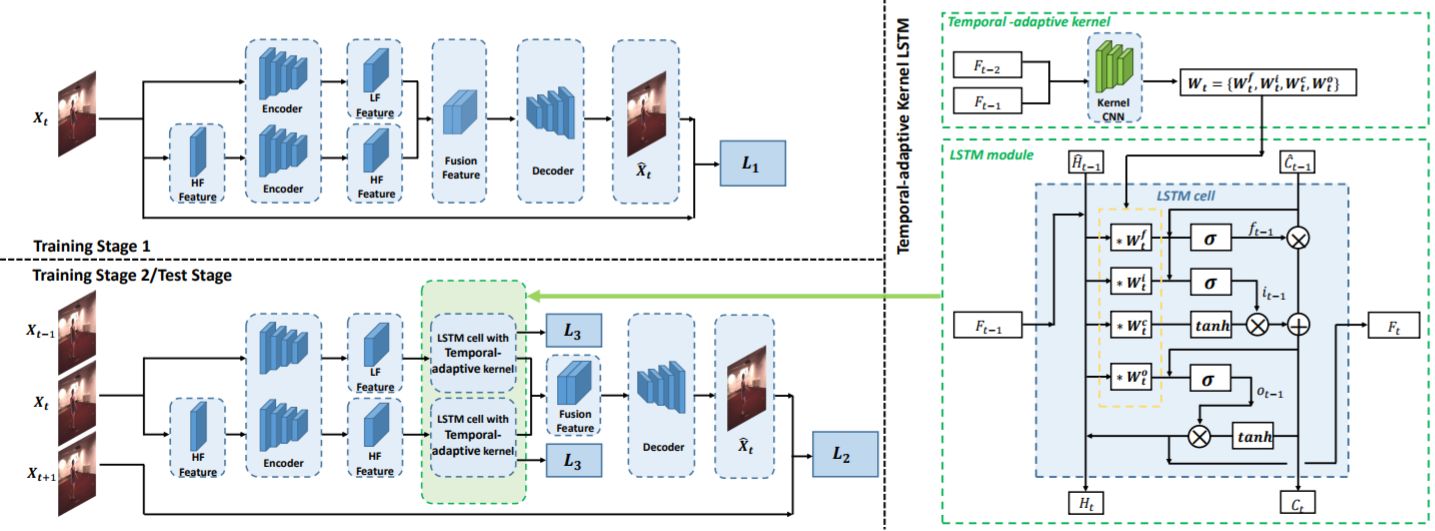

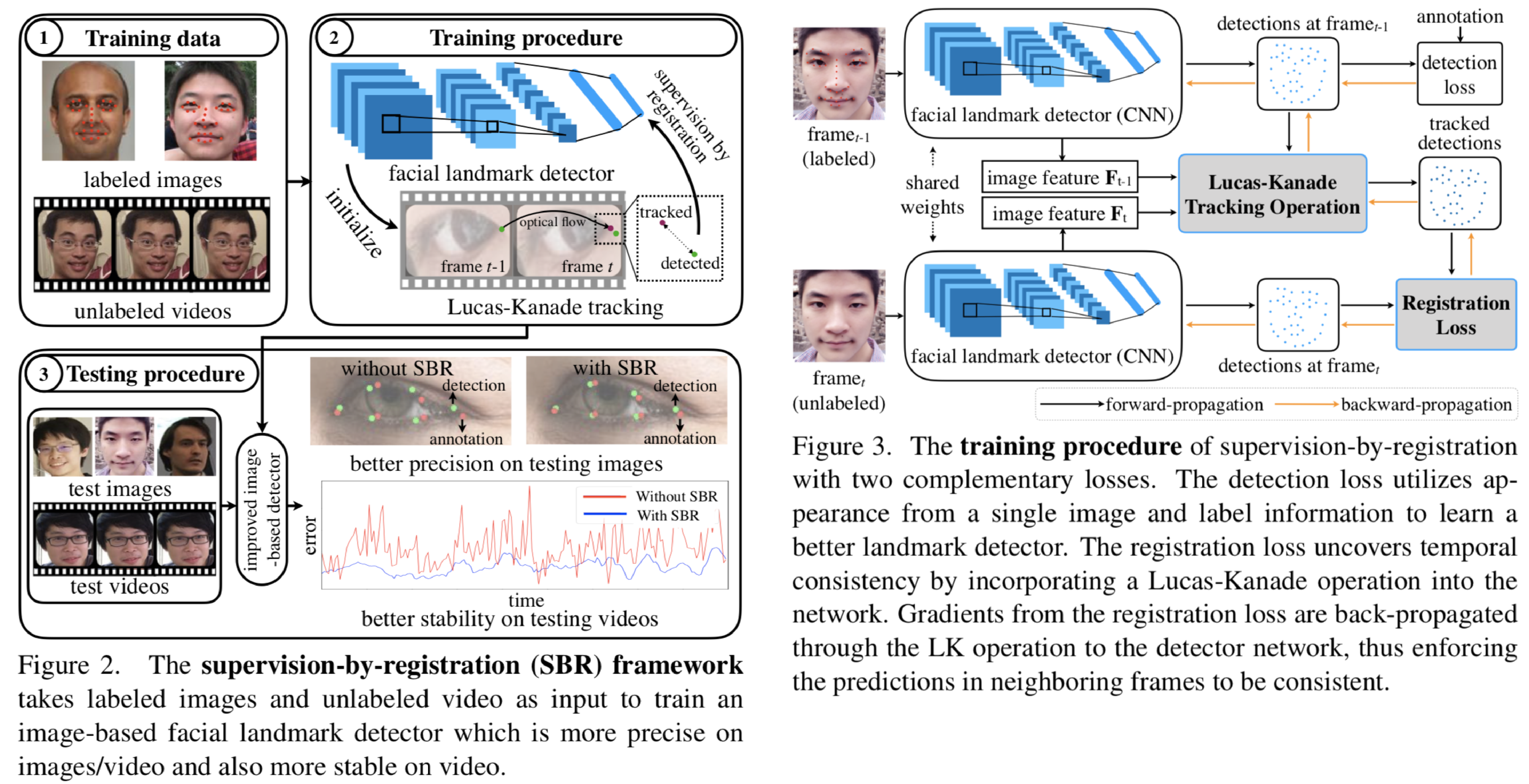

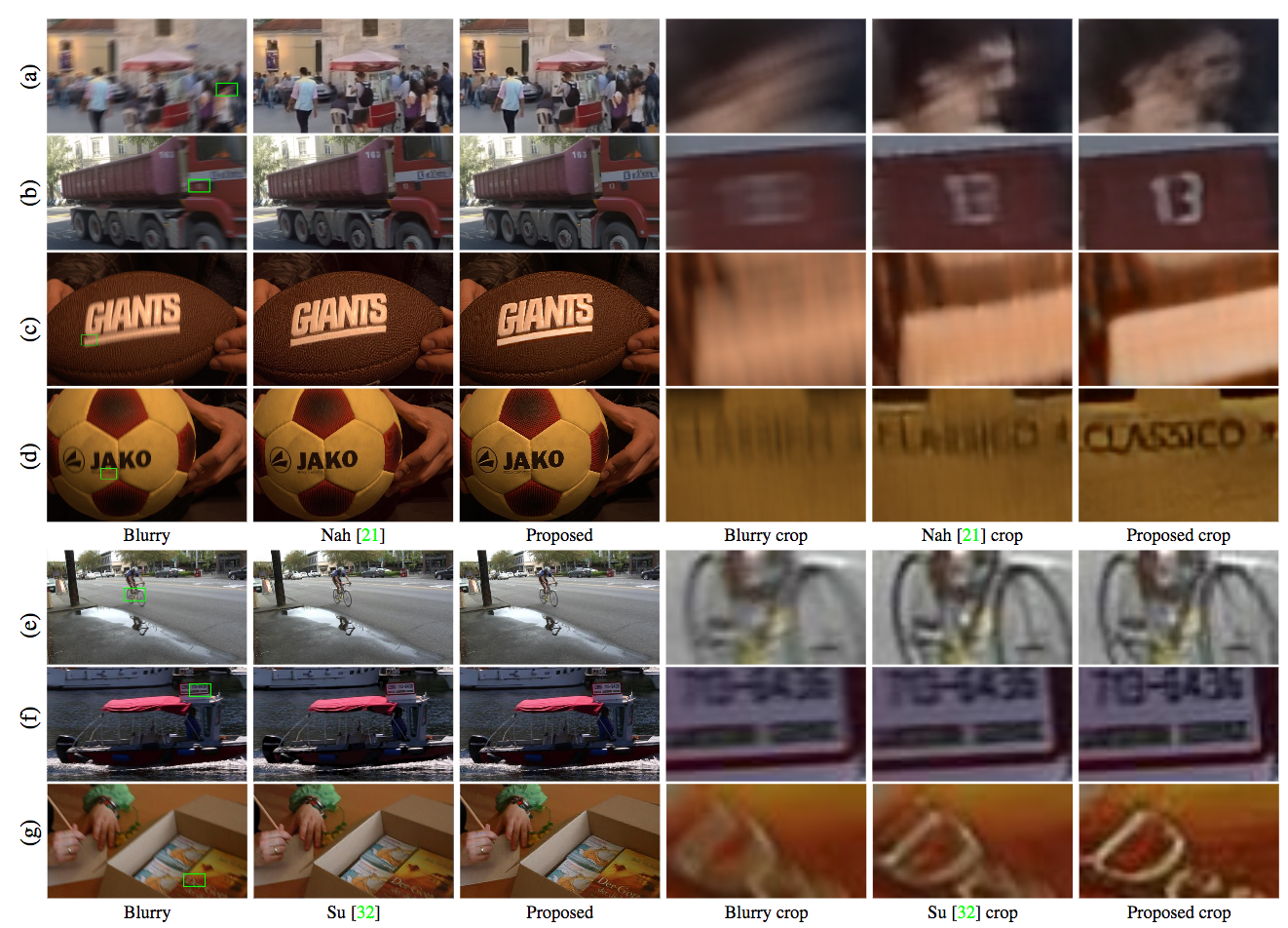

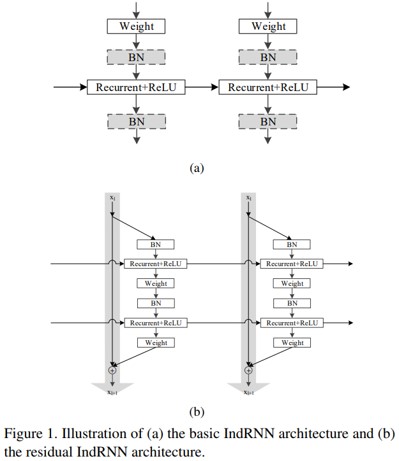

この研究で行われたことは以下に示す3つである.

GOPRO datasetを用い提案ネットワークを定量的(SSIM, PSNR)に評価した.また,定性的評価には参考文献のreal blurry imageを用いた. その結果,提案手法がSoTAアルゴリズムと比べ,精度,スピードとモデルサイズにおいて優れていることがわかった.

スプライン曲線あてはめにおいて,異なるタイプの残差のバランスがとれるような確率ベースの重みづけについて提案.スプライン曲線あてはめの近似誤差の推定を統合するところが新しい.

また,スプライン曲線あてはめの質の尺度を提案.スプライン曲線の中間点のスページングの自動化などに貢献できる.

ディープ系ではないが,先に行った推定結果を処理に使うというあたり,イマドキ感を感じる.

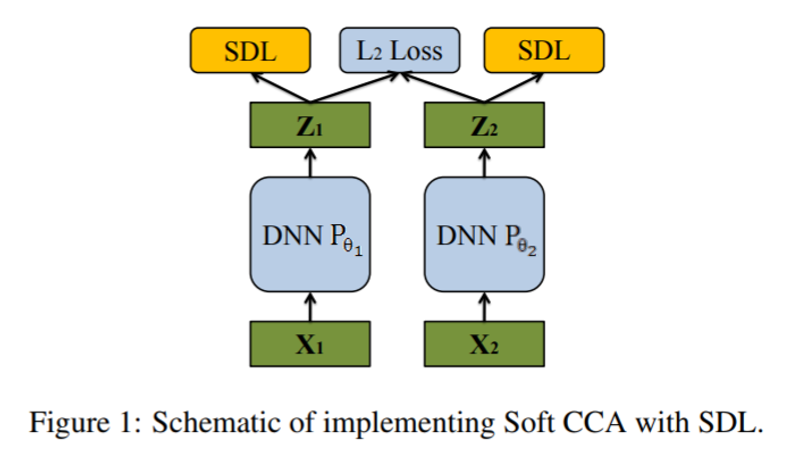

複数視点系の話題で,非線形の設定においては,Canonical Correlation Analysis (CCA) という手法が一般的になってきた.この既存のDeepなCCAにおいては,典型的には, 一般潜在空間における異なるアピアランスの相関が最大化される前に, 最初にそれぞれのアピアランスにおける特徴次元の間の相関除去を行っている. このCCAでは,学習イタレーション毎に,逆行列計算に依存する計算コストの高い相関除去の計算が求められる. しかも,この相関除去のステップは勾配効果最適化の枠組みからは離れており,その結果準最適解に落ち着いてしまう.

本稿では,Soft CCAを提案する.Softといっているのは,CCAの計算途中に直交性が求められるところの条件を,SGDで最適化されるソフトなコスト関数に置き換えるというところ. ミニバッチベースの確率的相関除去ロス(Stochastic Decorrelation Loss; SDL)を導入. これは,その他目的関数と結合的に最適化される.

このSDLはマルチビュー問題以外にも適用可能である.

流行の手法の確かな発展.

ネットワークの計算省力化に,ネットワークパラメータのデータビット数を下げるやり方がある.重み・活性化パラメータの分布をコードブックで近似表現することで行われるが, 1-8bitまで量子化すると,フォワード・バックワード関数の大きな勾配ミスマッチが起こるために著しい精度低下が起きていた.

本研究では,この損失を,特定の重みサブグループにおけるシンメトリックなコードブックの学習によって問題を解決する. サブグループは,重み行列の中での局所性に基づいて考慮される.

1-2 bitの重み,2-8 bitの活性化でもうまくいくことを示す.

ひどく量子化してデータ削減してももうまく行っちゃうというすばらしさ.

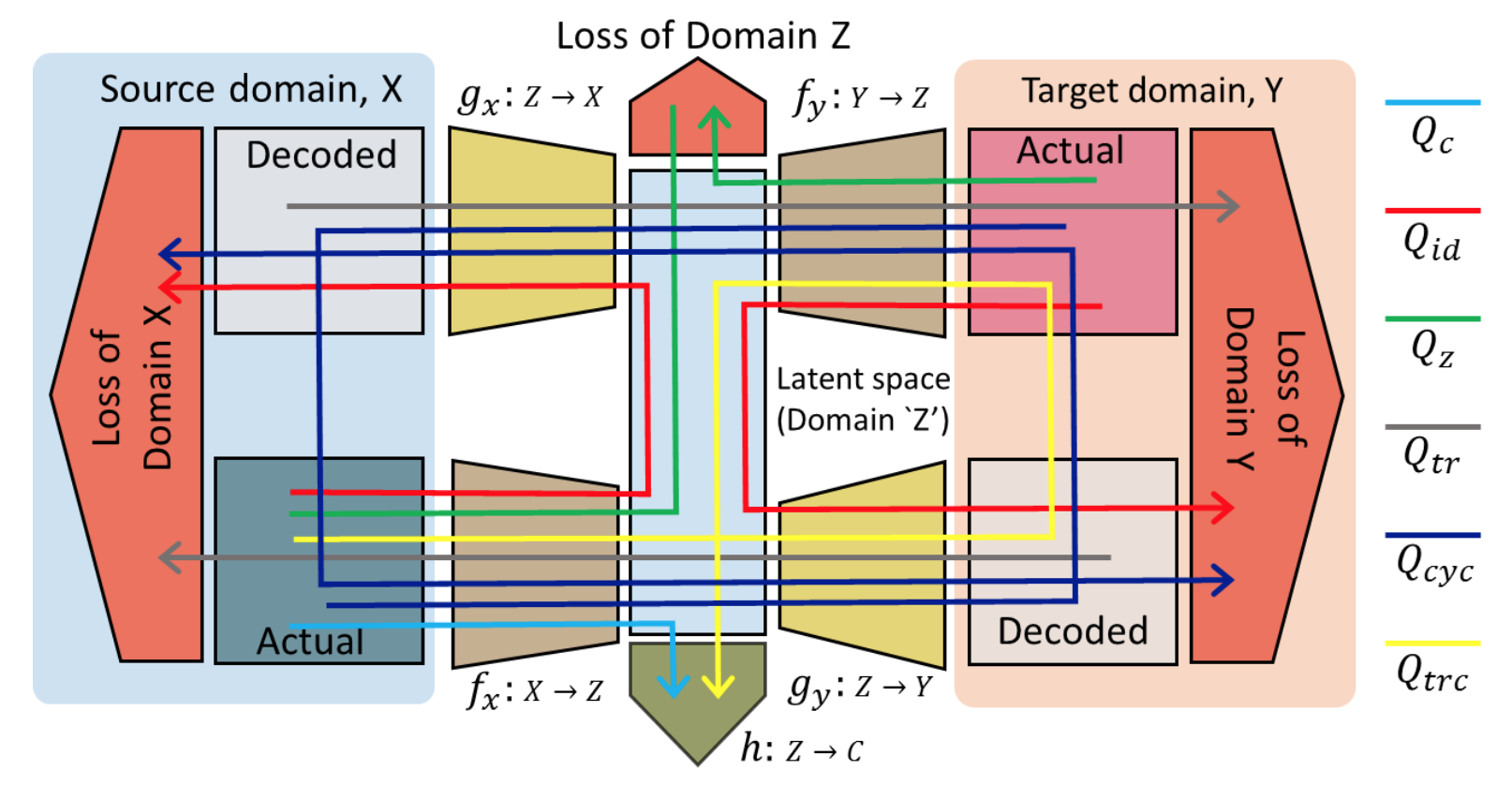

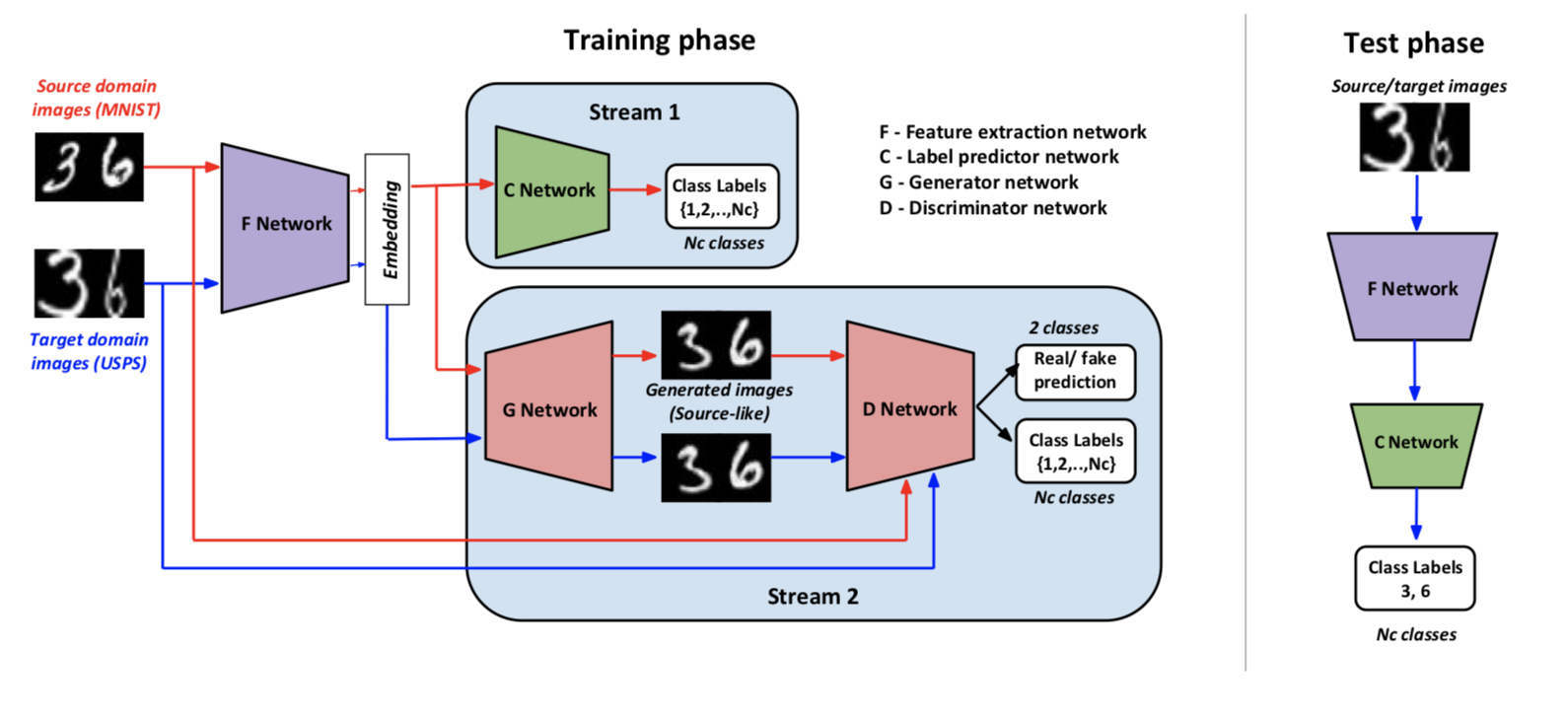

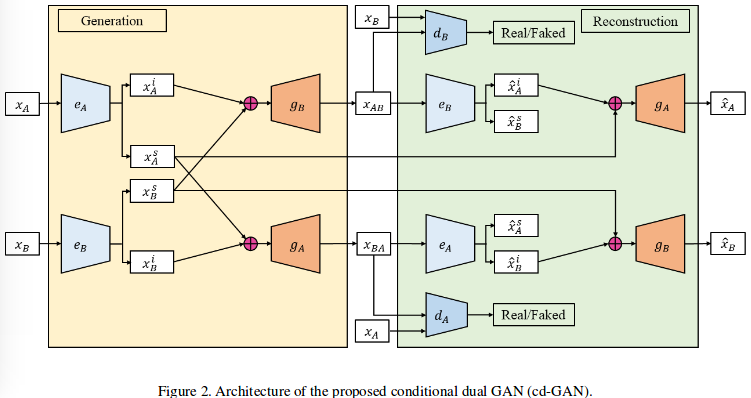

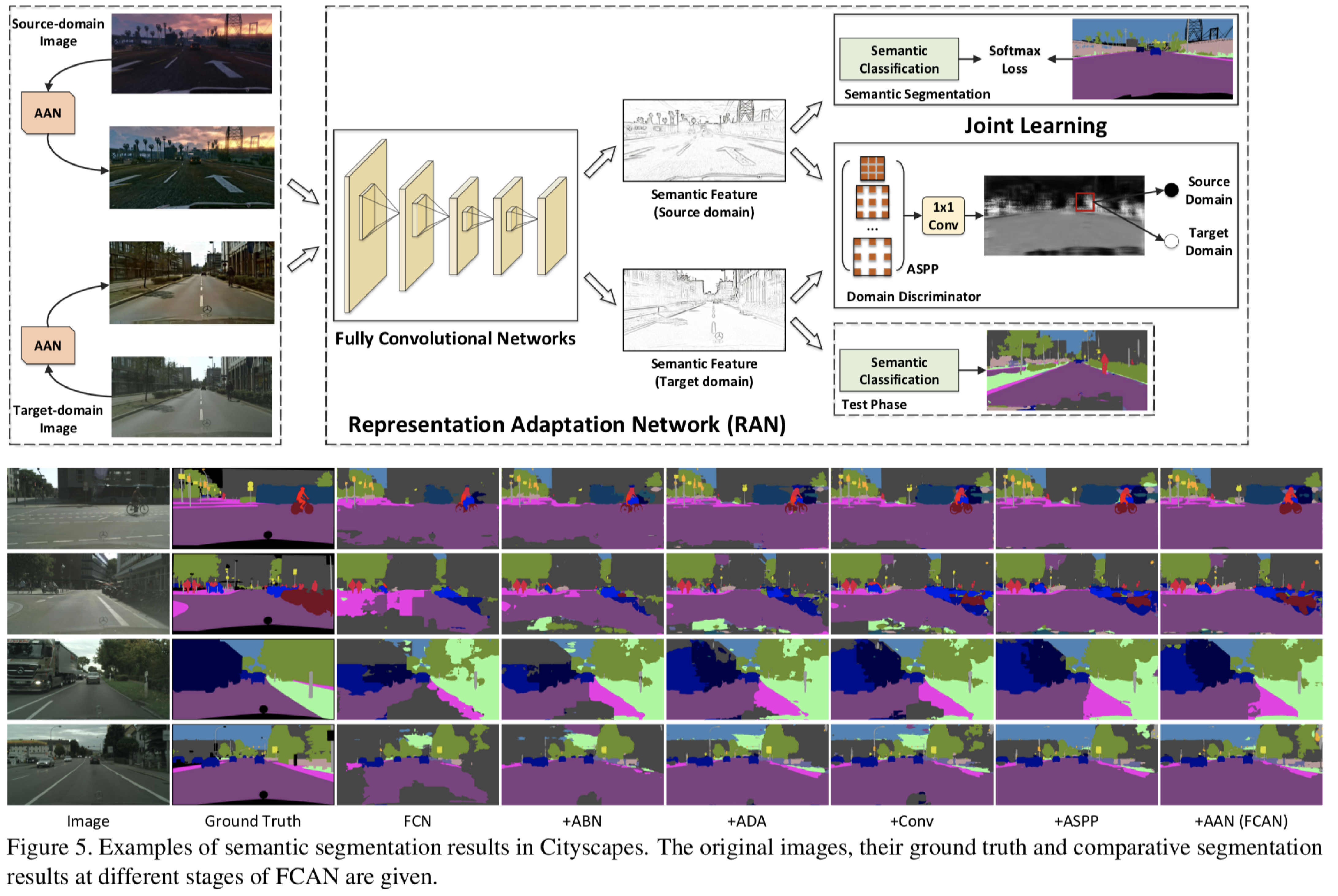

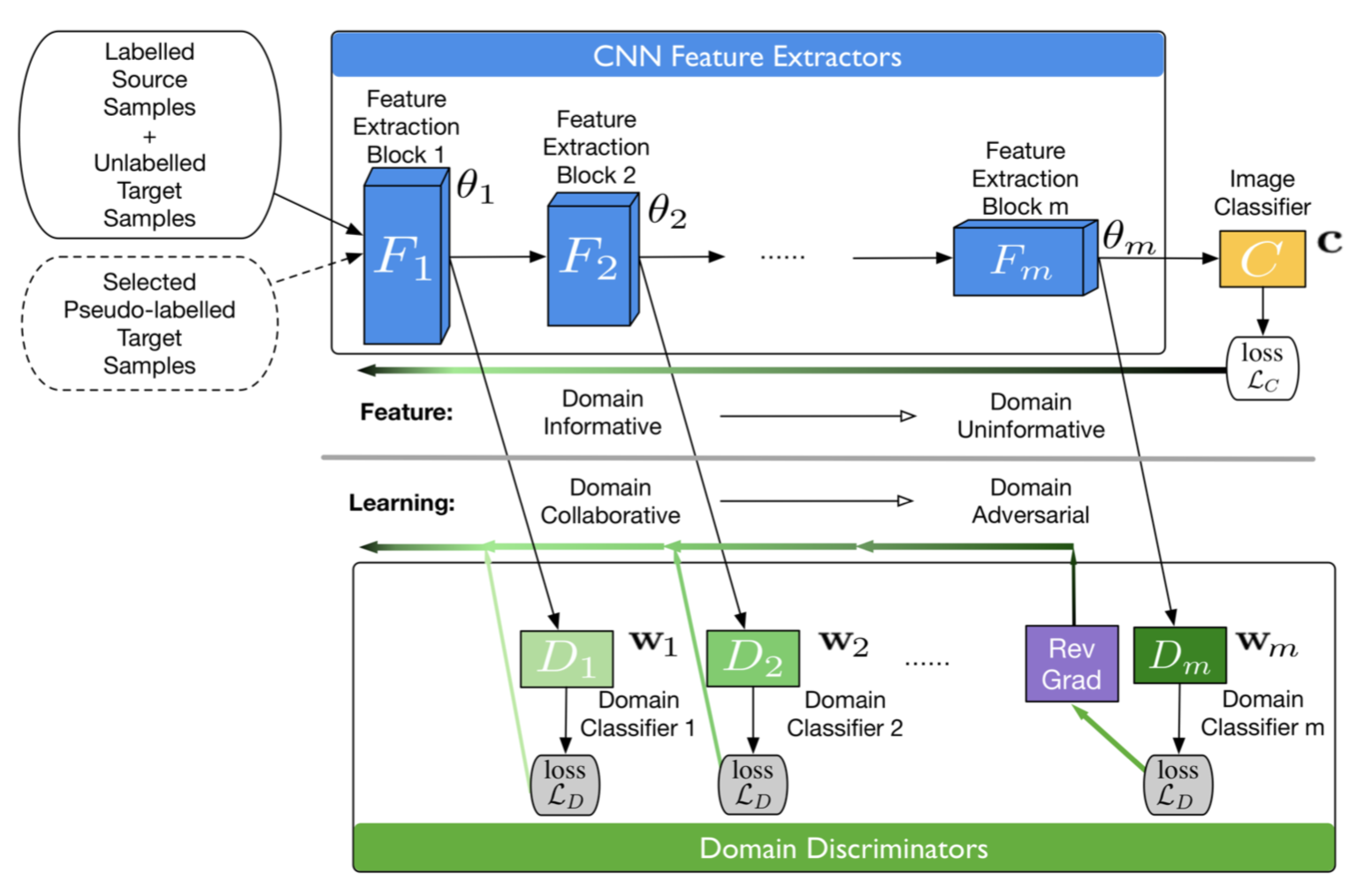

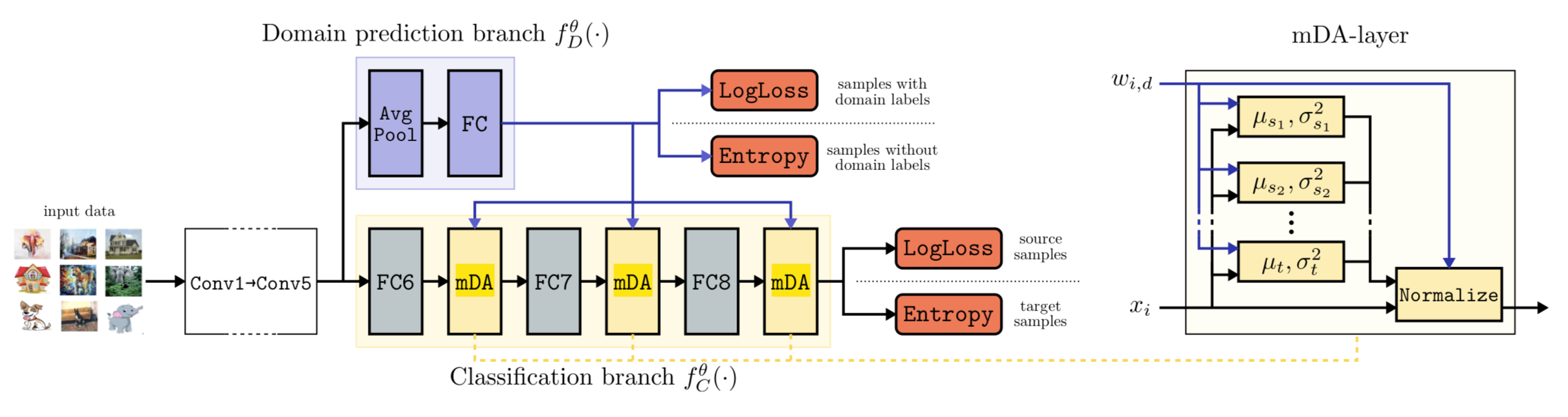

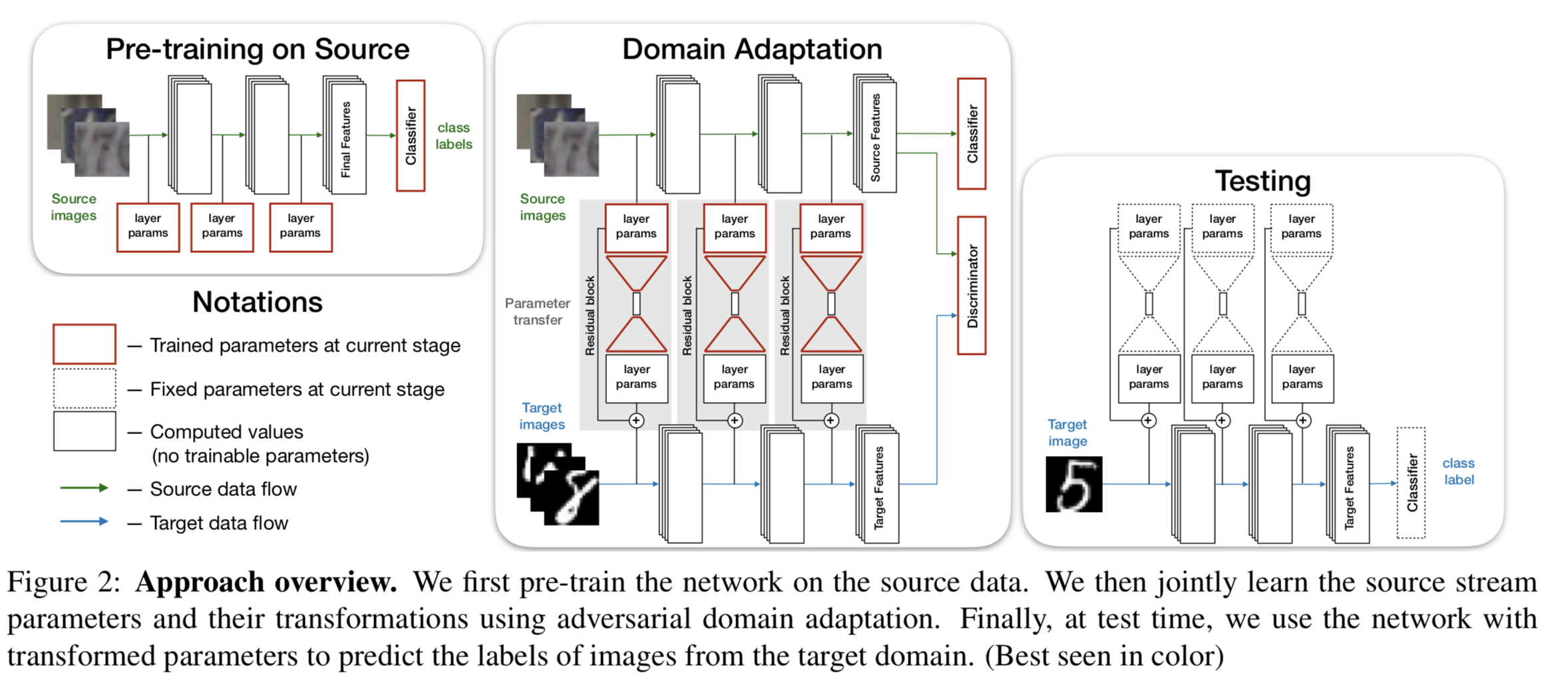

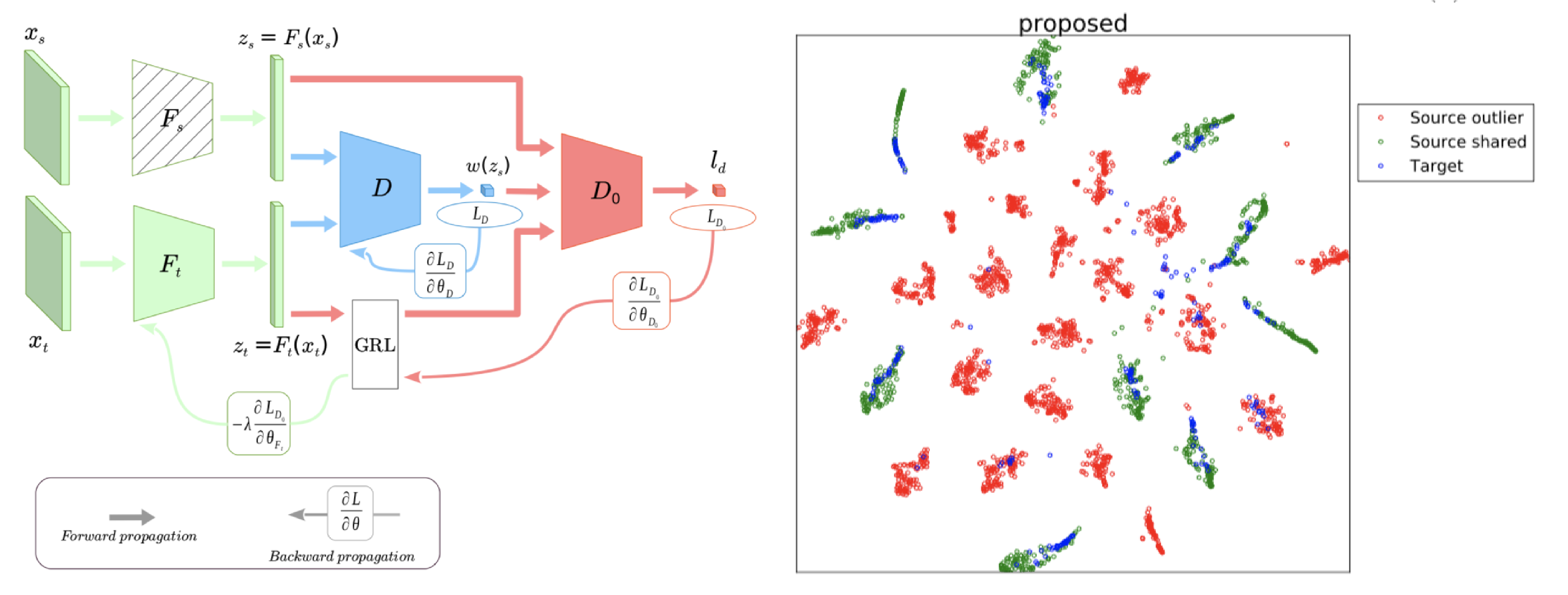

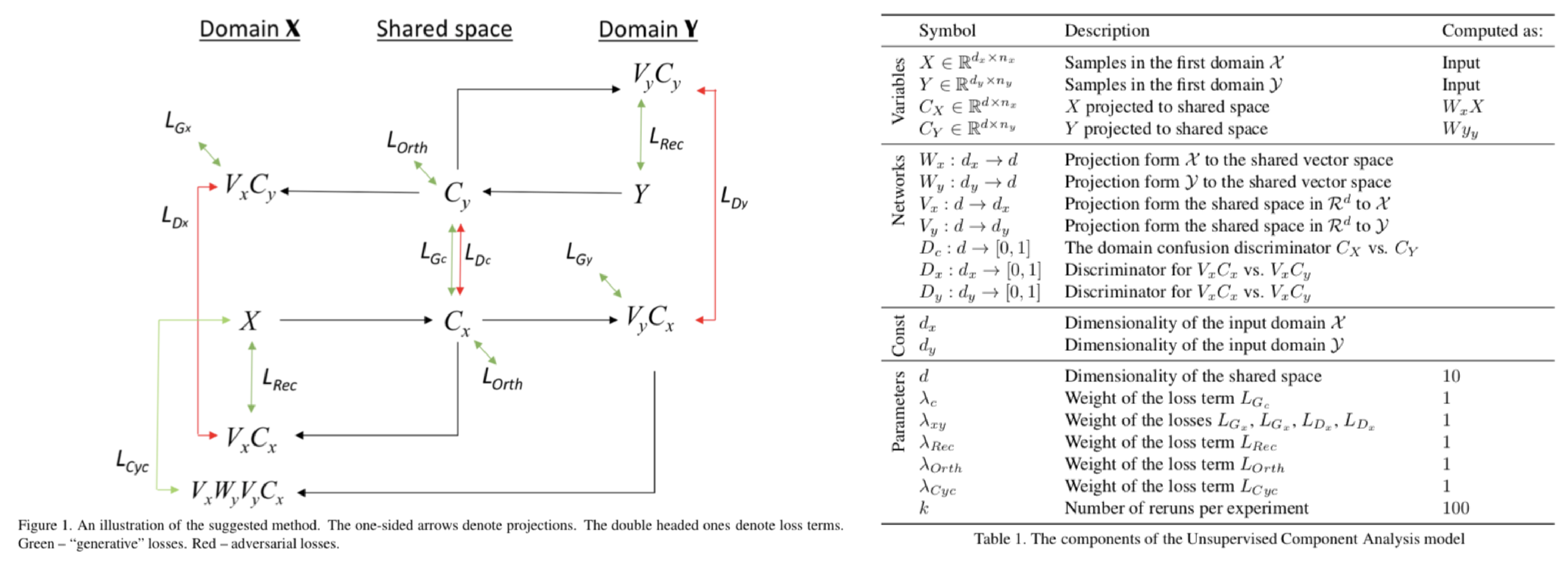

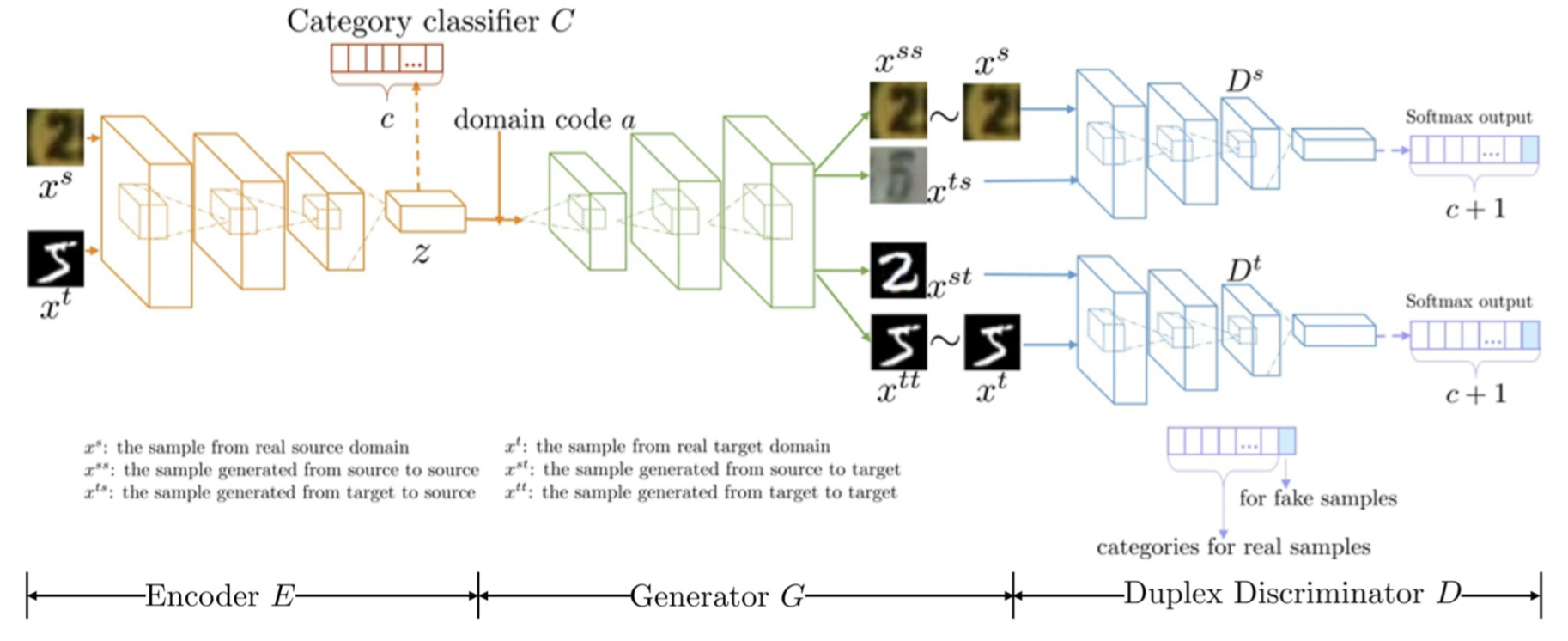

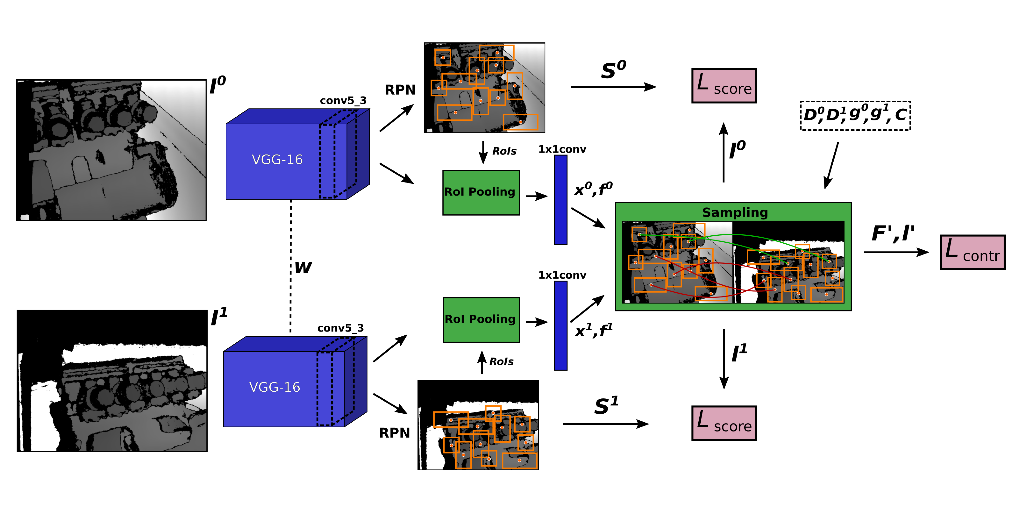

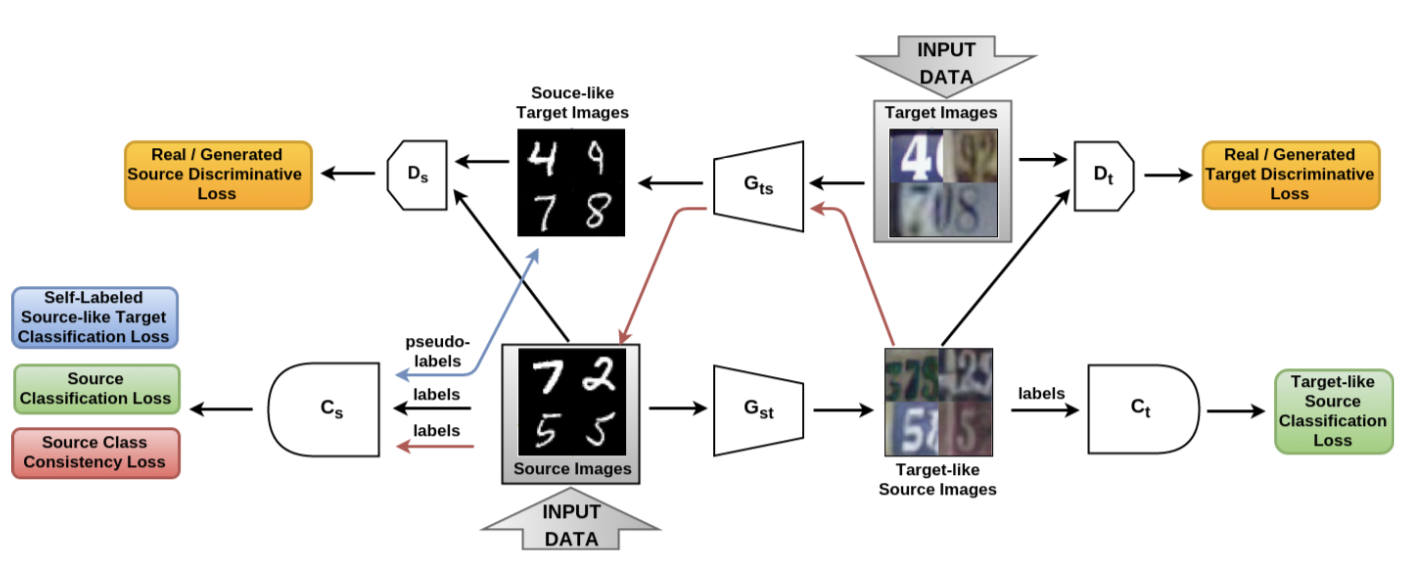

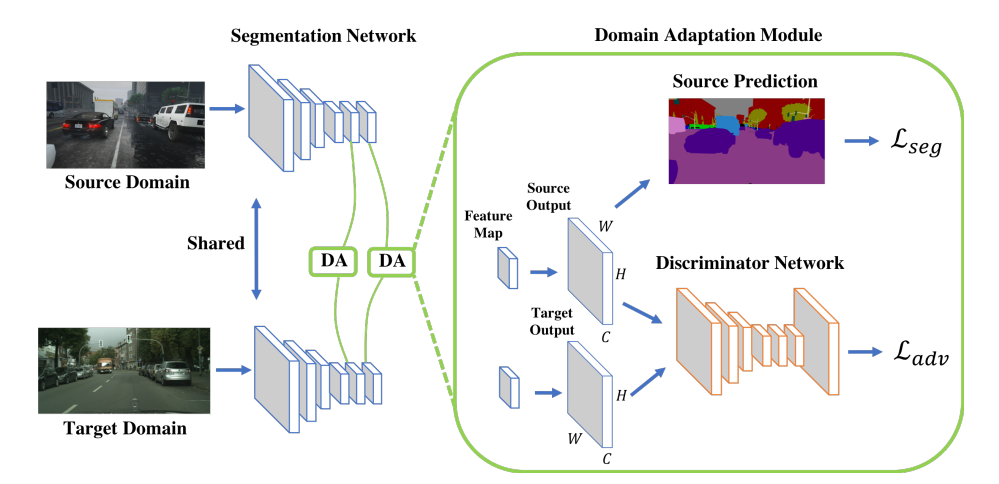

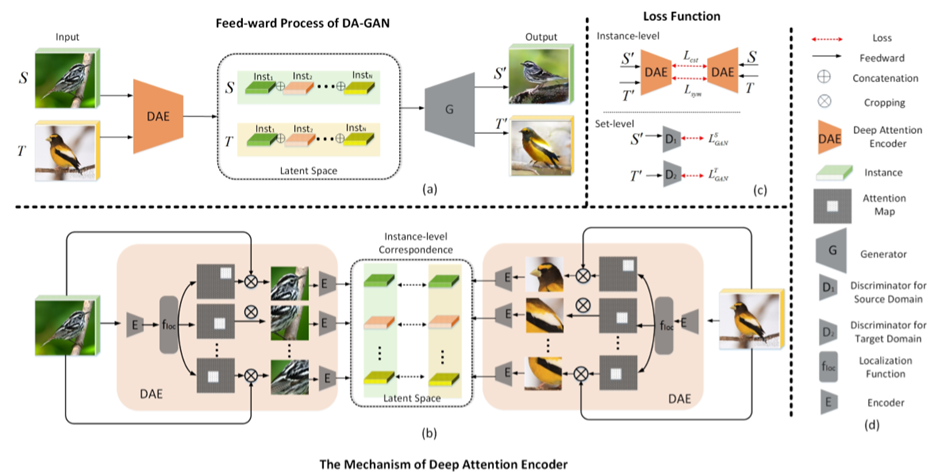

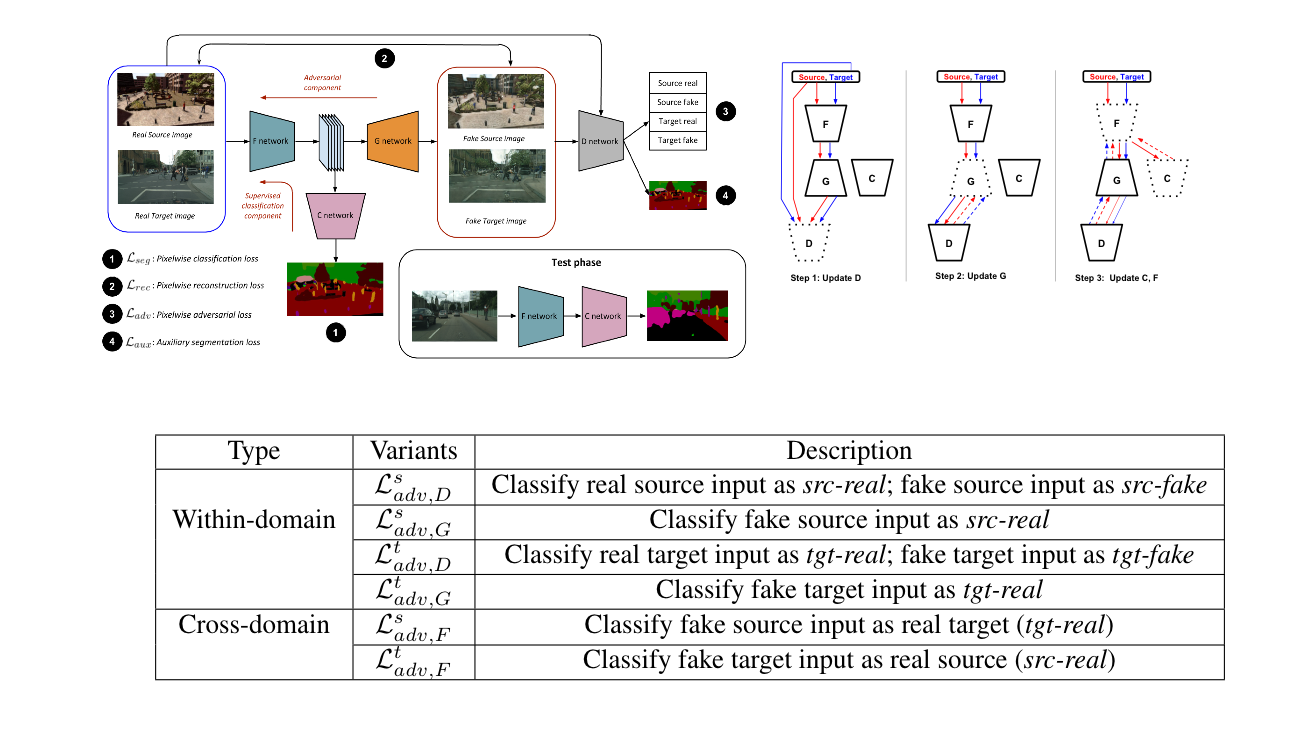

domain adaptationの一般的なフレームワークの提案.エンコーダーネットワークによって抽出される特徴に制約をかけるために,最近提案されたペアなしのimage-to-image変換に対する新しい利用方法を提案する. このように制約をかけて得たい特徴は以下のような性質を持つ ・抽出された特徴は2つのドメインでの画像に再び戻せる ・2つのドメイン画像から抽出された特徴の分布は区別できない(Dを騙せる) 実験では,domain adaptationの問題として数字の分類や車載動画のセマンティックセグメンテーションのタスクを取り上げ,state of the artを超えた.

一つのフレームワークの中で,image-to-imge変換とソース側の分類問題,そしてdomain adaptationを行なっている.

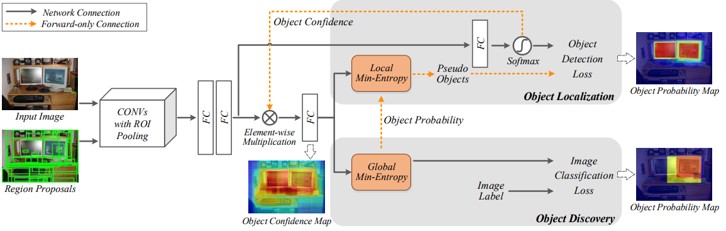

・学習画像群の中から物体検出の学習に有益な画像を探索する手法Self-Supervised Sample Miningを提案

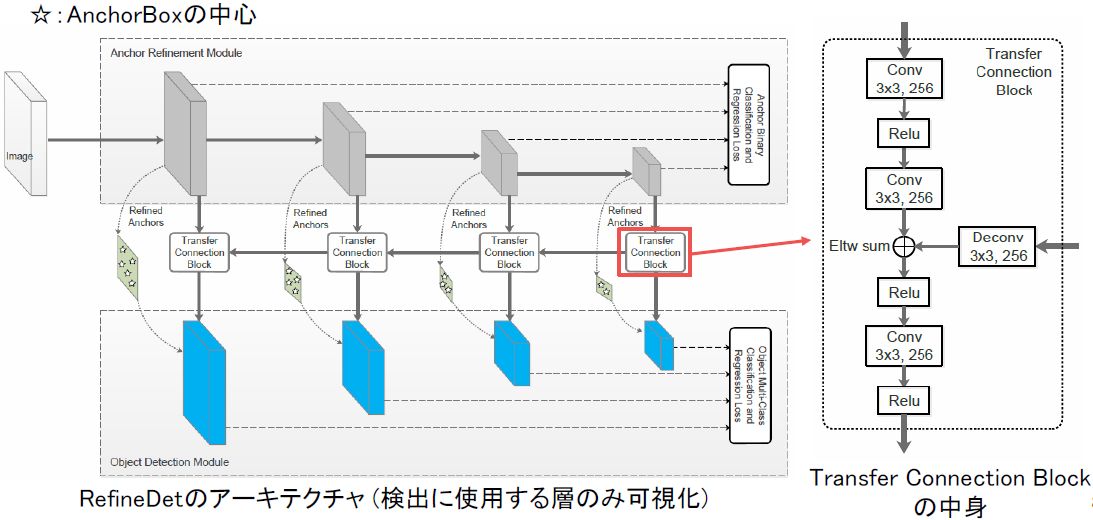

・ラベルのないデータを追加して精度向上させるだけでなく、アノテーションの数を大幅に減らしてstate-of-the-artの精度を実現

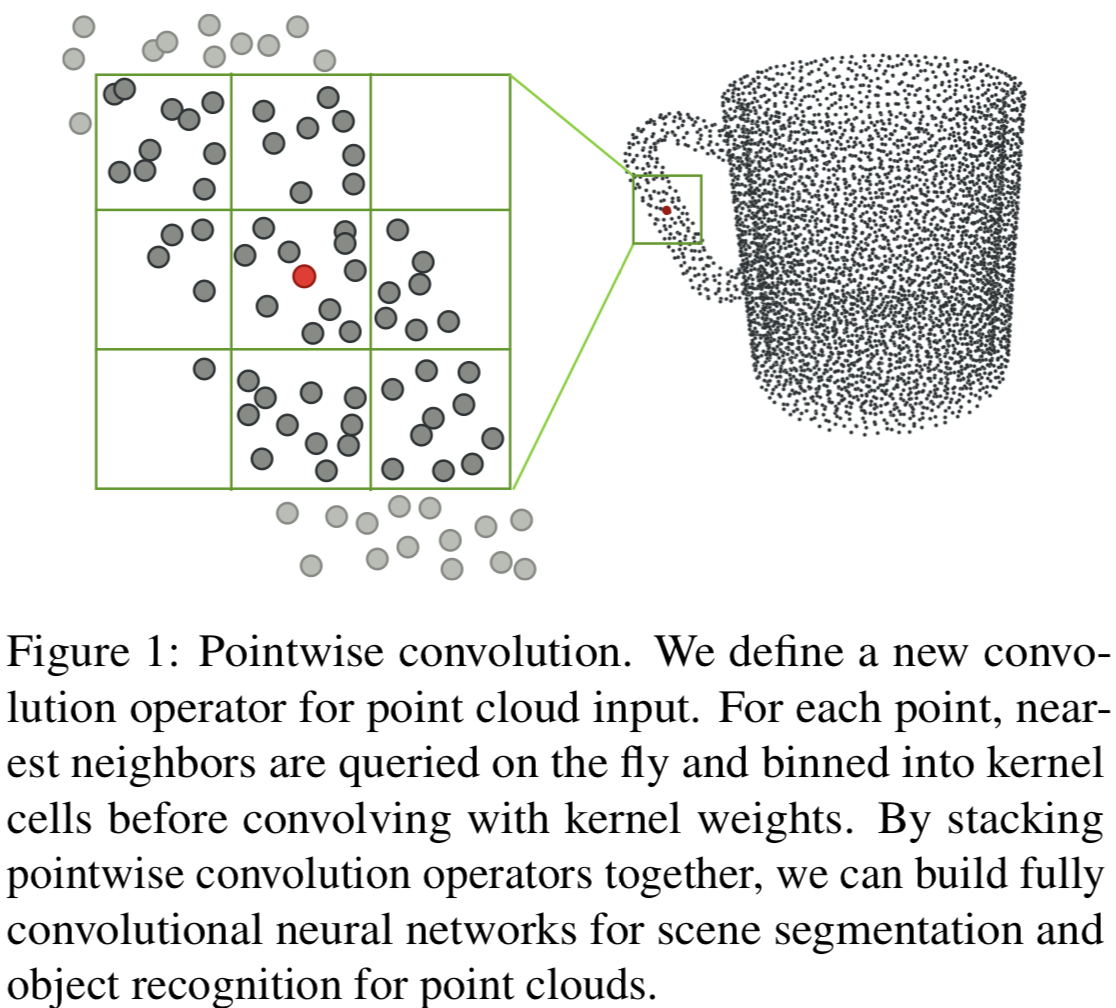

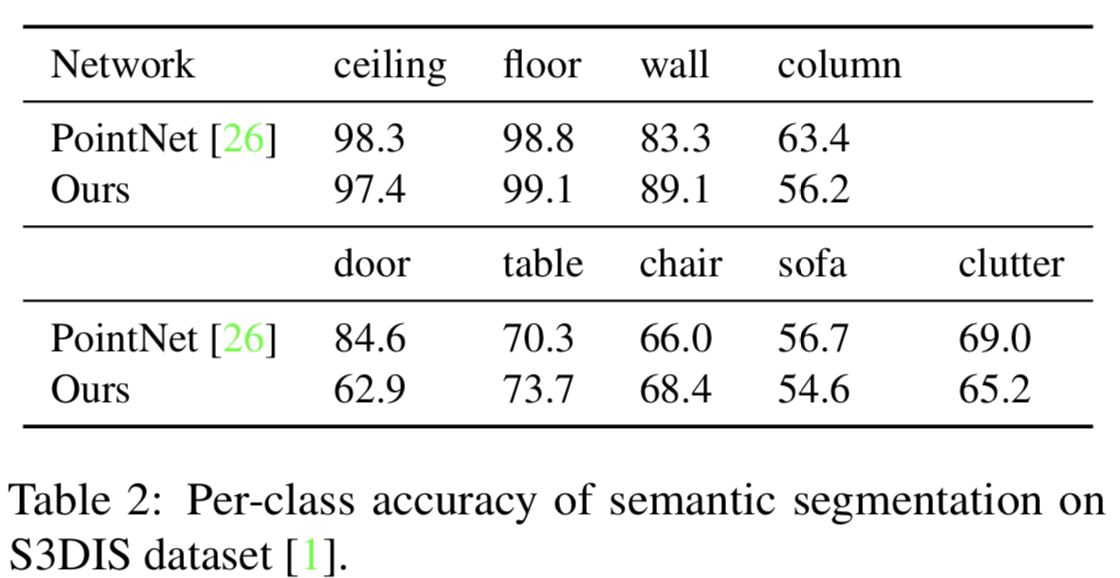

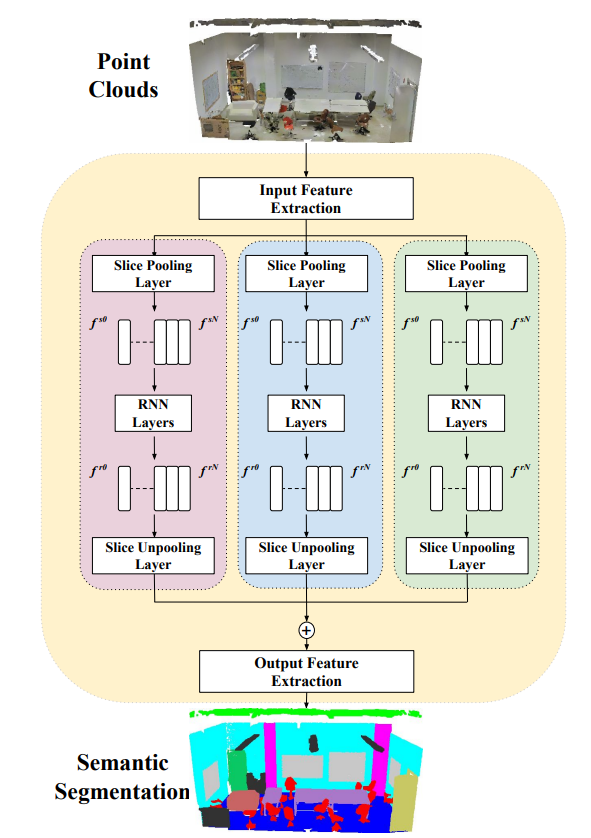

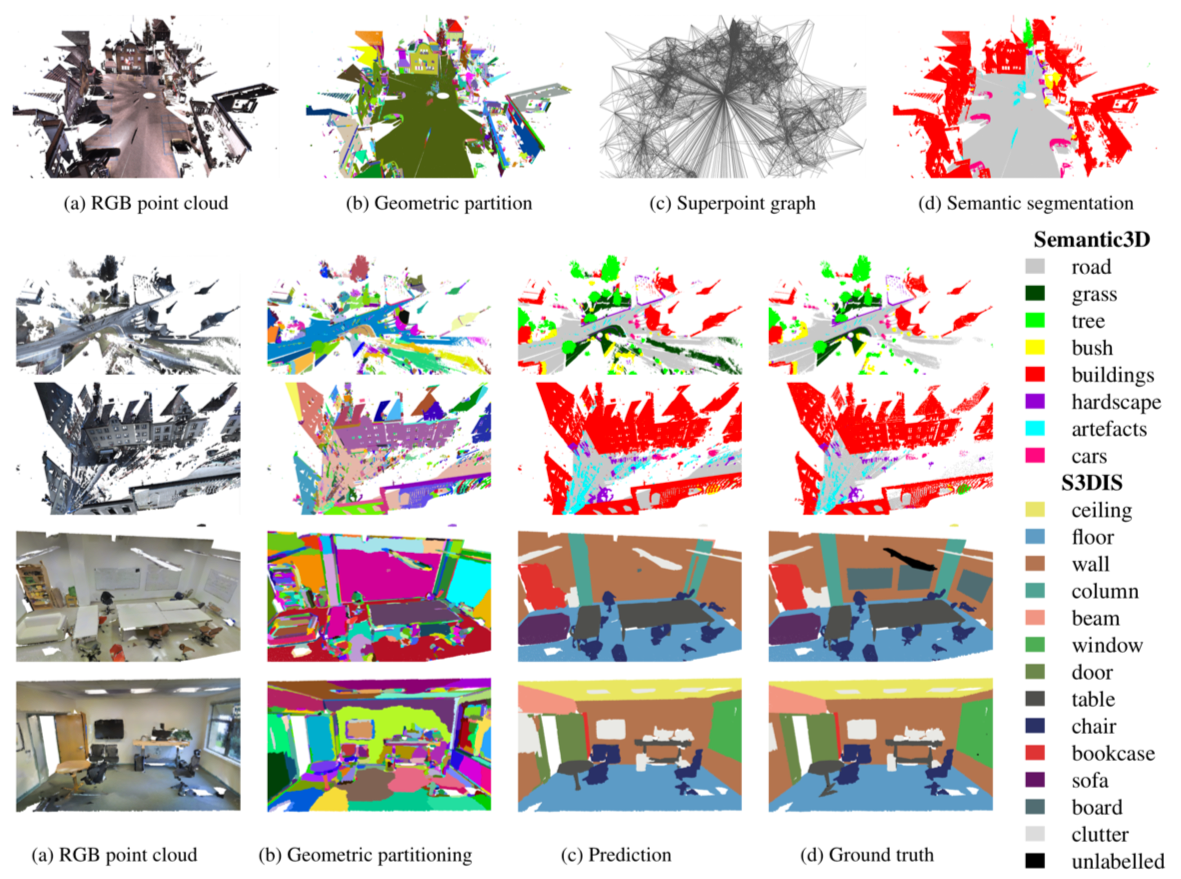

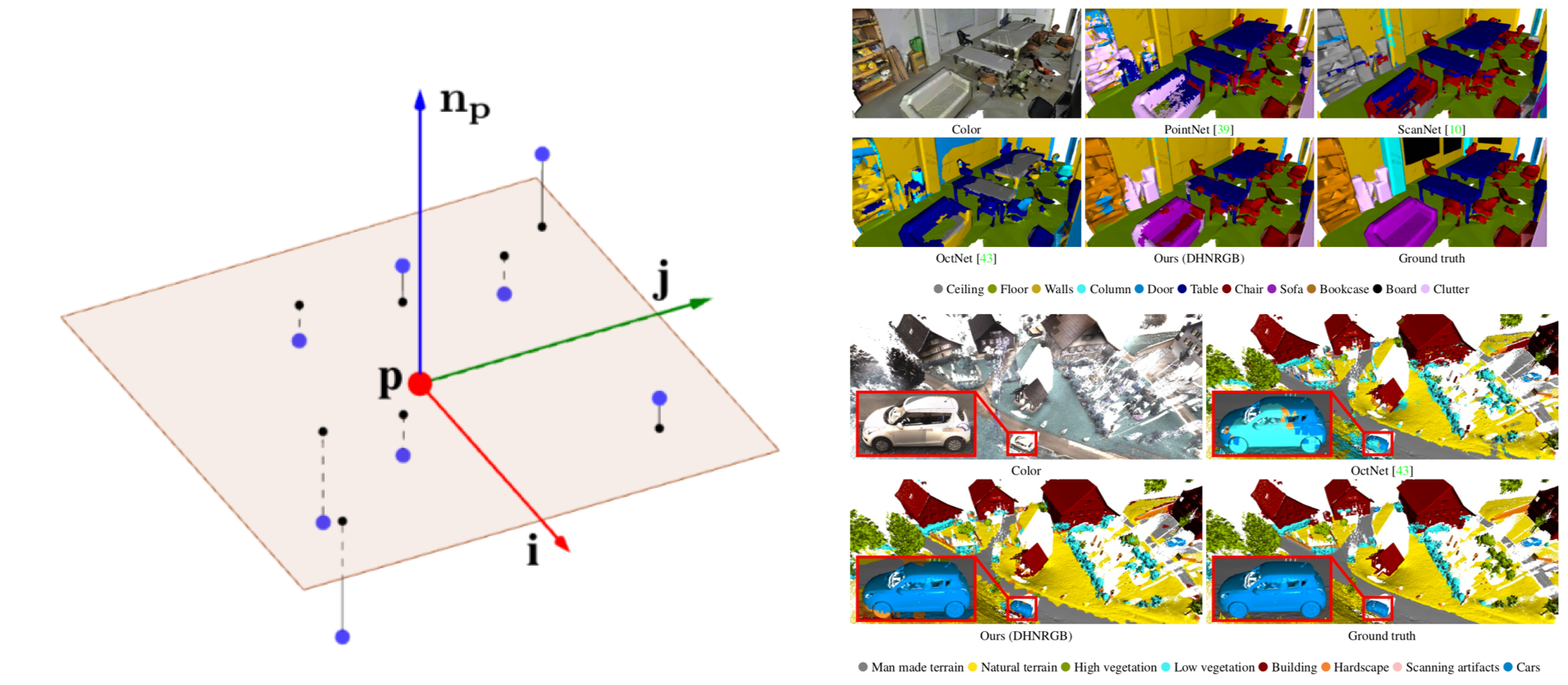

3次元点群のおけるセマンティックセグメンテーションや物体認識のための、新しい畳み込み操作を提案した論文。これはpointwise convolutionと呼ばれ、点群の各点々に適応可能である。この操作を用いることにより実装が簡単になり、他のネットワークと同程度の精度を実現できる。 Fig.1に示すように、注目点を中心としてカーネルを設置し、分割されたセル(Fig.1では3X3X3)ごとに平均を計算し、畳み込むという計算を行う。

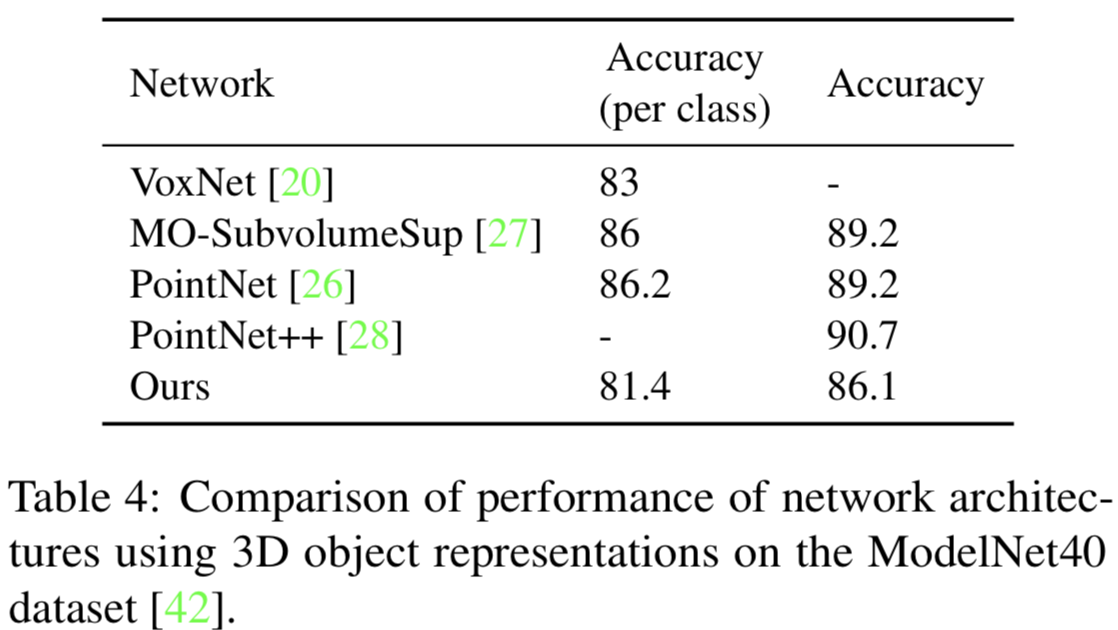

セマンティックセグメンテーションの結果をTabl2に示す。これより、PointNetと比べて同程度の精度を達成していることが分かる。ここで、評価用データセットにはS3DISを用いた。物体認識の結果をTable4に示す。これより、SoTAな手法と比べ同程度の精度を達成していることが分かる。ここで、評価用データセットにはModelNet40 datasetを用いた。

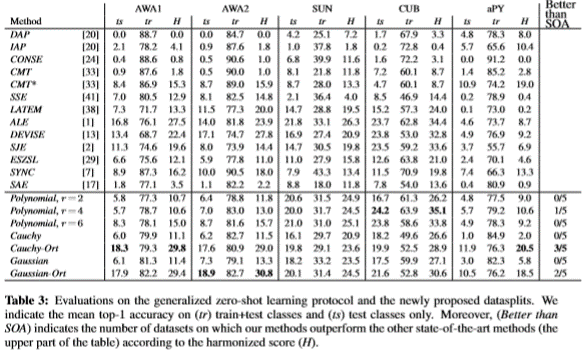

zero-shot learning(ZSL)で問題となっているソースデータとターゲットデータに対する識別精度のバイアスを緩和するための手法をtransductive ZSLの設定で新しいロス関数を提案。transductive ZSLとはトレーニング中にラベルをもつ画像から成るソースデータと、ラベルを持たない画像から成るターゲットデータを扱う設定である。提案手法では既存研究で用いられている、ソースデータに対するclassificationロス(+正則化項)に加えて、ターゲットデータに対するロス関数として、ターゲットデータがどのターゲットカテゴリに所属するのか、という確率を足しあげlogを取ったものを加える(正確には減算をする)。 実験ではターゲットデータに対する識別精度を算出するZSLの設定と、ソースデータとターゲットデータの両方に対す識別精度を算出するGZSLの設定を検証する。

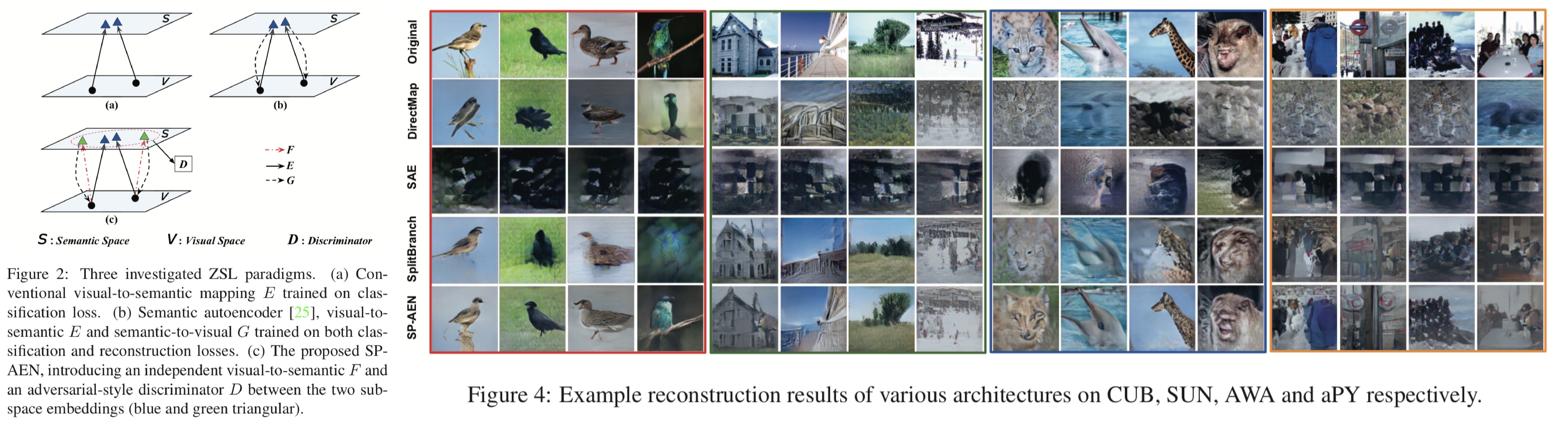

テスト時にトレーニングでは扱わなかったクラスのインスタンスを扱うzero shot learning(ZSL)において問題視されていたsemantic lossを解決するモデルSemantics-Preserving Adversarial Embedding Network (SP-AEN)を提案。semantic lossとはトレーニングで使用されたデータであるseen classesとテストで初めて扱うデータであるunseen classesにおける分布の違いから、トレーニングされたモデルがテスト時にうまく機能しない問題である。これに対して提案手法ではZSLでそれぞれ独立に提案されていた画像のリコンストラクションを行うencoder E, decoder Dとラベルの識別を行うclassifier C、EとCから得られる特徴量を識別するDを組み合わせたモデルを提案。EとCを用いることでリコンストラクションとラベル識別を独立に行い、かつDをGANベースに学習することで、Cはインスタンスごとの学習に重きを置くEの効力を得ることができるモデルとなっている。

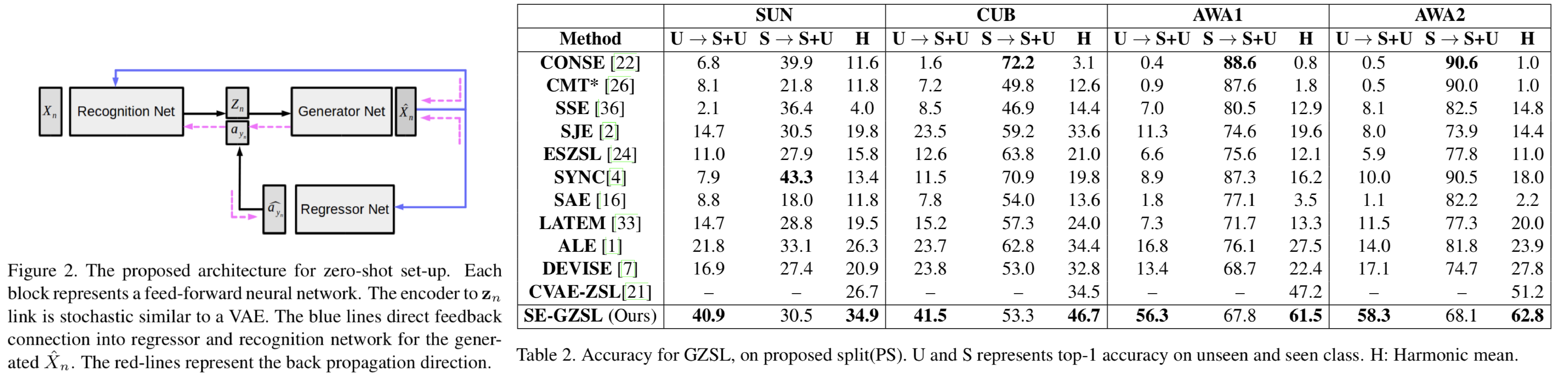

Generalized Zero-Shot Learning(GZSL)のバイアスを小さくするためのCVAEとクラスラベルのclassifierを組み合わせたモデルを提案。GZSLとは、テストの際にトレーニングで使用した(seen)クラスとトレーニングでは使用していない(unseen)クラスの両方を扱う問題を指す。既存手法ではトレーニングされたモデルを用いた識別などにおいて、seenクラスに対するバイアスが高いことが問題であった。提案手法ではclassifierのロスをdecoderに流し、かつdecoderによって合成された画像をラベルなし画像として扱い半教師学習を行う。テスト時にはseenクラスとunseenクラスの画像を合成し、合成された画像を用いてSVMを学習しその識別精度を比較する。

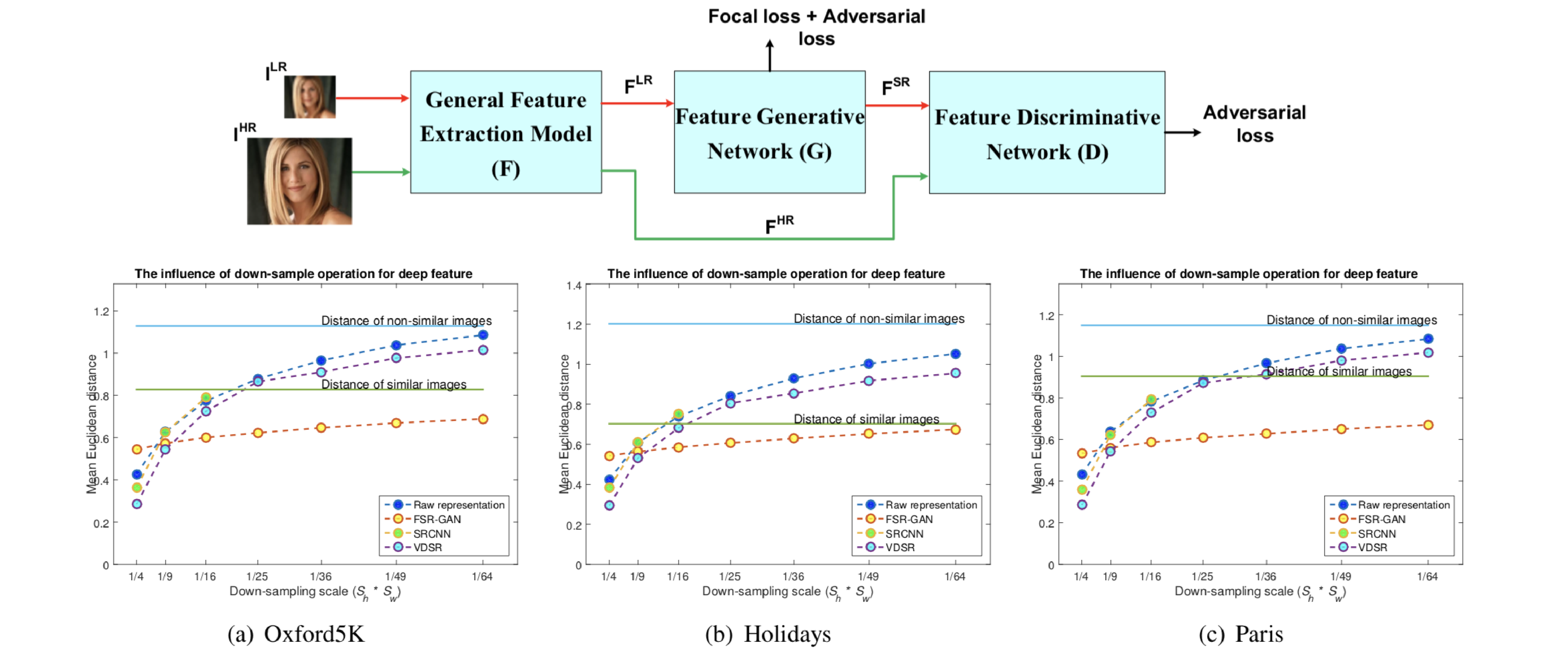

低解像度画像と高解像度画像で同じ特徴量を得るために新しいロス関数focal lossを導入したFeature Super-Resolution Generative Adversarial Network (FSR-GAN)を提案。提案ネットワークは図の通りfeature extractorと低解像度画像の特徴量を高解像度画像の特徴量に似せるgenerator、特徴量のドメインを識別するdiscriminatorからなる。focal lossとはインスタンスごとのL2距離をr乗するというもの。adversarial lossとしてWGANで導入されたEarth-Mover distanceを使用。

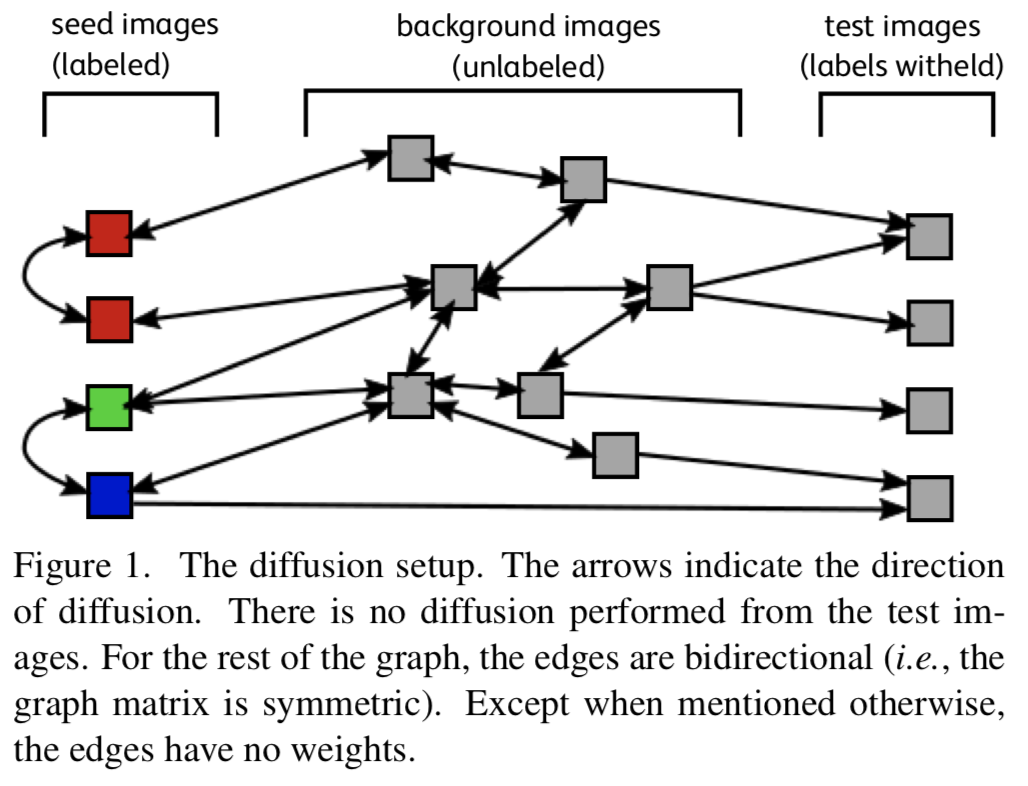

大規模データセットを用いた古典的な手法による半教師学習の有効性を調査。古典的な手法としてkNNグラフを用いた拡散アルゴリズムを使用し、半教師学習としてlow shot learningを扱った。low shot learningとはデータ中にクラスなどのアノテーションが施された画像がごく一部であり大半の画像にはアノテーションがないデータセットを扱う問題を指す。大規模データセットであるImageNetなどでlow shot learningを行い、low shot learningのSoTAと古典的な手法による精度の比較を行った。

大規模データセットに対する新しい解析方法であり、データセットの使用方法の知見を深めた論文。2003年の手法が2017年の手法に優っているケースはCVでは特に珍しいのではないか?

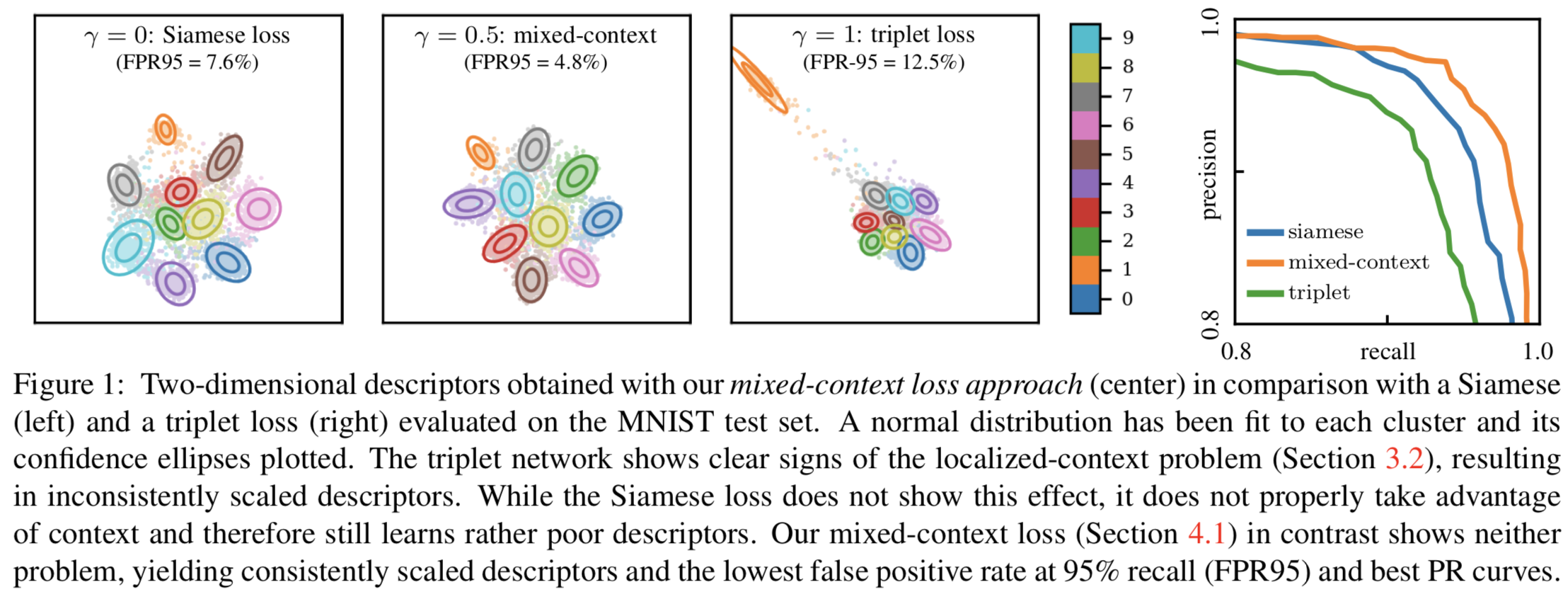

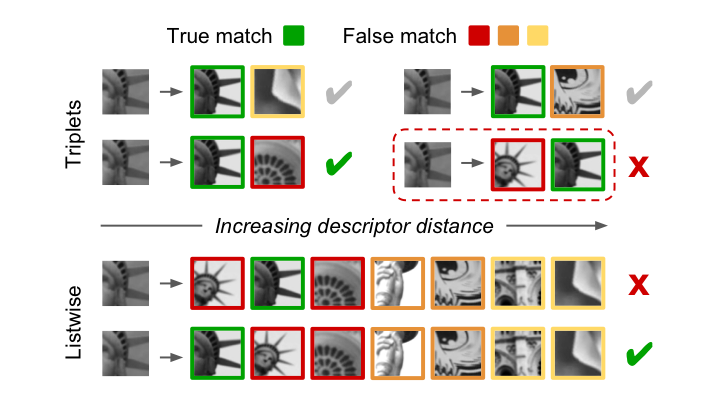

triplet lossをアップデートしたmixed-context lossとサンプリング手法であるscale-aware samplingを提案。triplet lossではサンプルに対するpositiveとnegativeの両方の特徴量距離を同時に学習するため、片方ずつ学習するsiamese lossよりも高い精度を出しやすいことがわかっている。しかしtriple lossで扱う特徴量距離はサンプルごとにローカルに決定されるため、場合によっては右図右から2番目の結果のように、特定クラスに対する結果が良く無い場合がある。提案するmixed-context lossでは、この測定される特徴量距離にバイアス項を加えたtriplet lossとsiamese lossの中間表現をとる。またscale-aware samplingは各バッチごとにpositiveとhard negativeをサンプリング手法であり、ロス関数のスケールを調整することが可能。

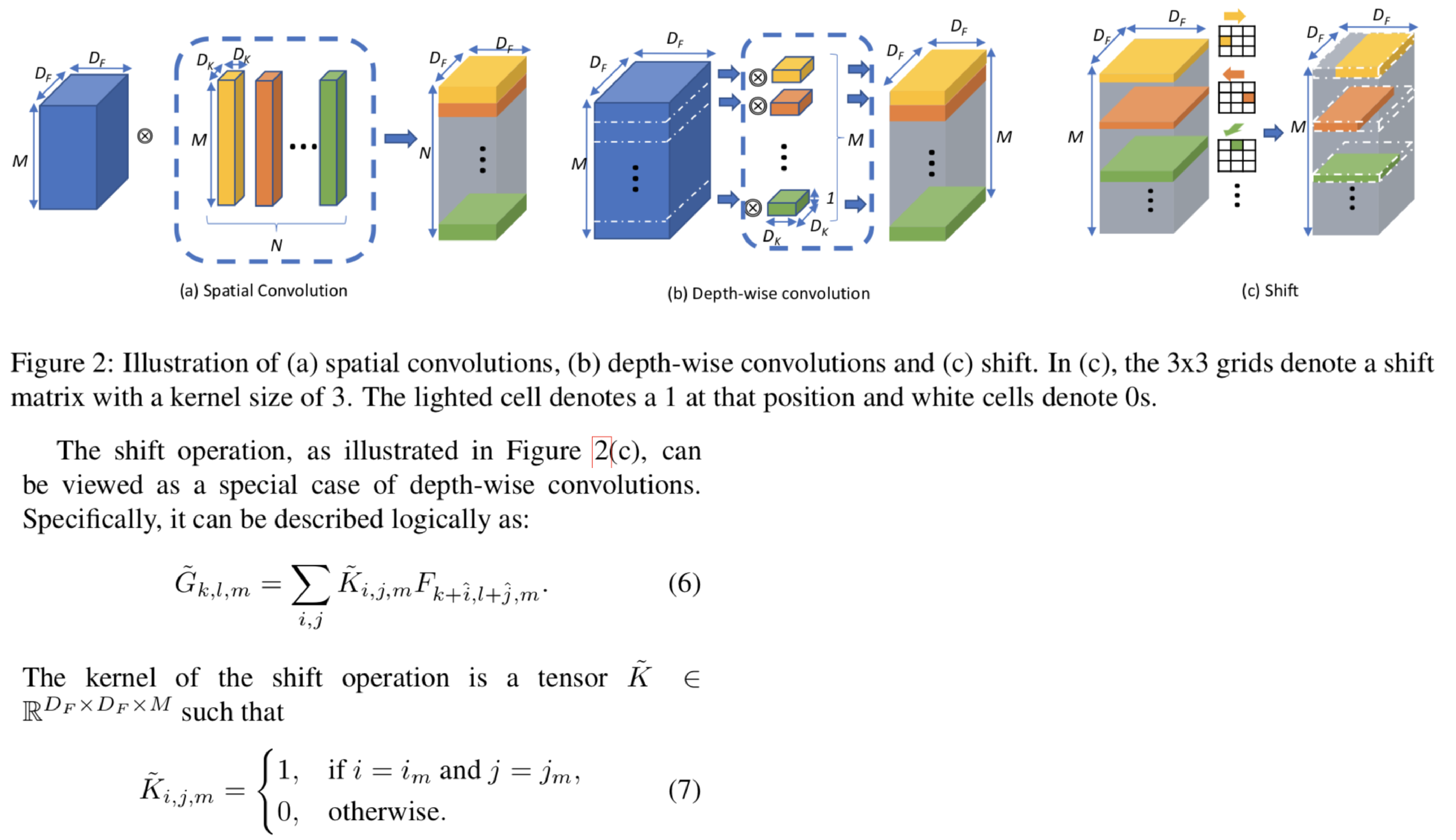

convolutionと同じ働きを持ち、パラメタやfloating point operation(FLOPS)が必要ないshift operationを提案。convolutionをshift operation に置き換えることでモデルサイズを小さくすることができる。Shift-operationはconvのようにカーネルをもち、どれか1ピクセルだけ値を1を格納し、それ以外は0を格納しており、1を格納している位置はチャンネルごとに異なる。またカーネルを動かす方向もチャンネルごとに異なる。これに対して1x1convを組み合わせることで、convolutionと同じ機能をもつ。Shift-operationと1x1convを組み合わせたものをshift moduleと呼び、実験では従来のCNNに対してshift moduleを組み込んだネットワークを用いてimage classification、face verification、style transferを行った。